第一个列子

- 背景

- 开发流程

- 准备模型

- 开发

- 推理流程

- 编码

- 编译与运行

背景

第一个例子是 图片分类的应用

因第一个,直接获取已训练好的开源模型,选择Caffe框架的ResNet-50模型。

ResNet-50模型的基本介绍如下:

输入数据:RGB格式、224*224分辨率的输入图片

输出数据:图片的类别标签及其对应置信度

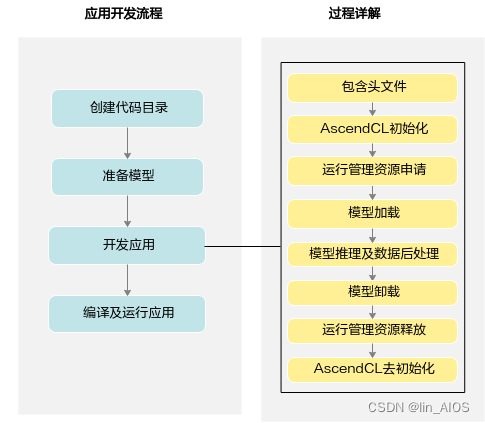

开发流程

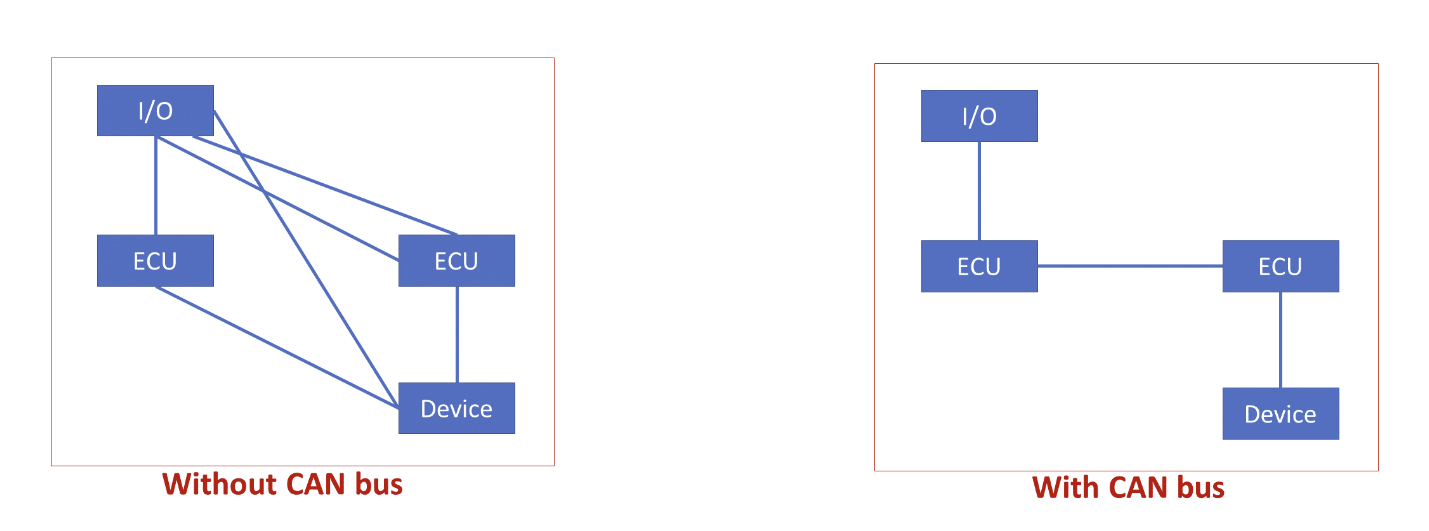

AscendCL(Ascend Computing Language)是一套用于在CANN(Compute Architecture for Neural Networks)上开发深度神经网络推理应用的C语言API库,提供模型加载与执行、媒体数据处理、算子加载与执行等API,能够实现在昇腾CANN平台上进行深度学习推理计算、图形图像预处理、单算子加速计算等能力。

图片流程来自昇腾社区

准备模型

昇腾 需要专用的模型,第一步 需要对开源模型进行转换。

使用ATC(Ascend Tensor Compiler)工具将开源框架的网络模型转换为适配昇腾AI处理器的离线模型(*.om文件)。

ATC 参数说明

- – model:ResNet-50网络的模型文件(*.prototxt)的路径。

- –weight:ResNet-50网络的权重文件(*.caffemodel)的路径。

- –framework:原始框架类型。0:表示Caffe;1:表示MindSpore;3:表示TensorFlow;5:表示ONNX。

- –output:resnet50.om模型文件的路径。请注意,记录保存该om模型文件的路径,后续开发应用时需要使用。

- –soc_version:昇腾AI处理器的版本。

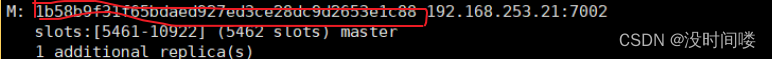

npu-smi info

+--------------------------------------------------------------------------------------------------------+

| npu-smi 23.0.rc2 Version: 23.0.rc2 |

+-------------------------------+-----------------+------------------------------------------------------+

| NPU Name | Health | Power(W) Temp(C) Hugepages-Usage(page) |

| Chip Device | Bus-Id | AICore(%) Memory-Usage(MB) |

+===============================+=================+======================================================+

| 0 310P3 | OK | NA 44 0 / 0 |

| 0 0 | 0000:01:00.0 | 0 1698 / 21527 |

+===============================+=================+======================================================+

| 32 310P3 | OK | NA 41 0 / 0 |

| 0 1 | 0000:02:00.0 | 0 1699 / 21527 |

+===============================+=================+======================================================+

| 32800 310P3 | OK | NA 45 0 / 0 |

| 0 2 | 0000:82:00.0 | 0 1697 / 21527 |

+===============================+=================+======================================================+

| 32896 310P3 | OK | NA 47 0 / 0 |

| 0 3 | 0000:85:00.0 | 0 1698 / 21527 |

+===============================+=================+======================================================+

Name 310P3

即soc_version 为Ascend310P3

下载文件:

- ResNet-50网络的模型文件(*.prototxt):单击Link下载该文件。

- ResNet-50网络的权重文件(*.caffemodel):单击Link下载该文件。

atc --model=model/resnet50.prototxt --weight=model/resnet50.caffemodel --framework=0 --output=model/resnet50 --soc_version=Ascend310P3

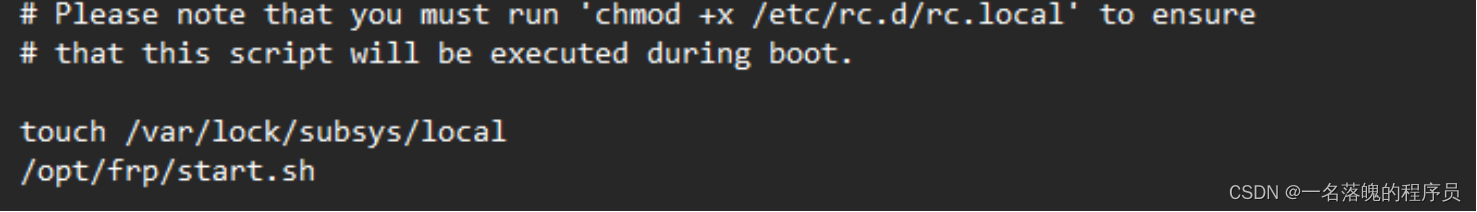

非root用户转换 失败 这里一定要用root

root# atc --model=model/resnet50.prototxt --weight=model/resnet50.caffemodel --framework=0 --output=model/resnet50 --soc_version=Ascend310P3

ATC start working now, please wait for a moment.

...

ATC run success, welcome to the next use.

开发

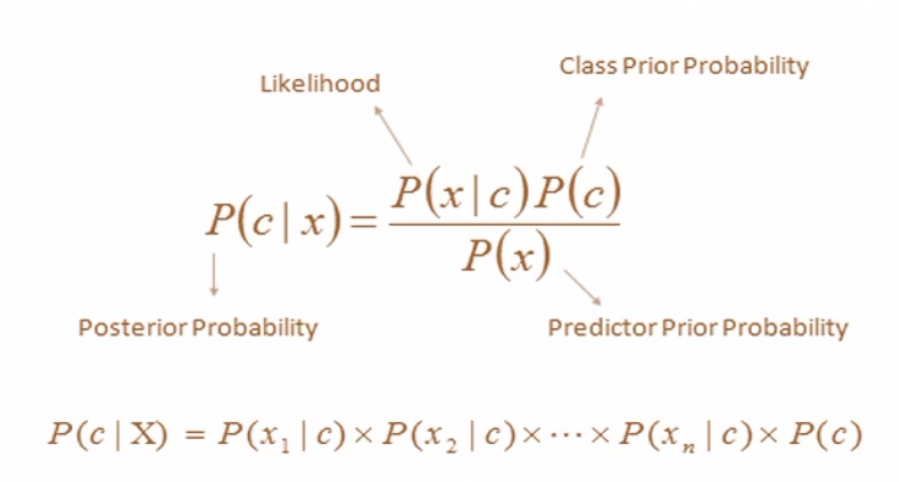

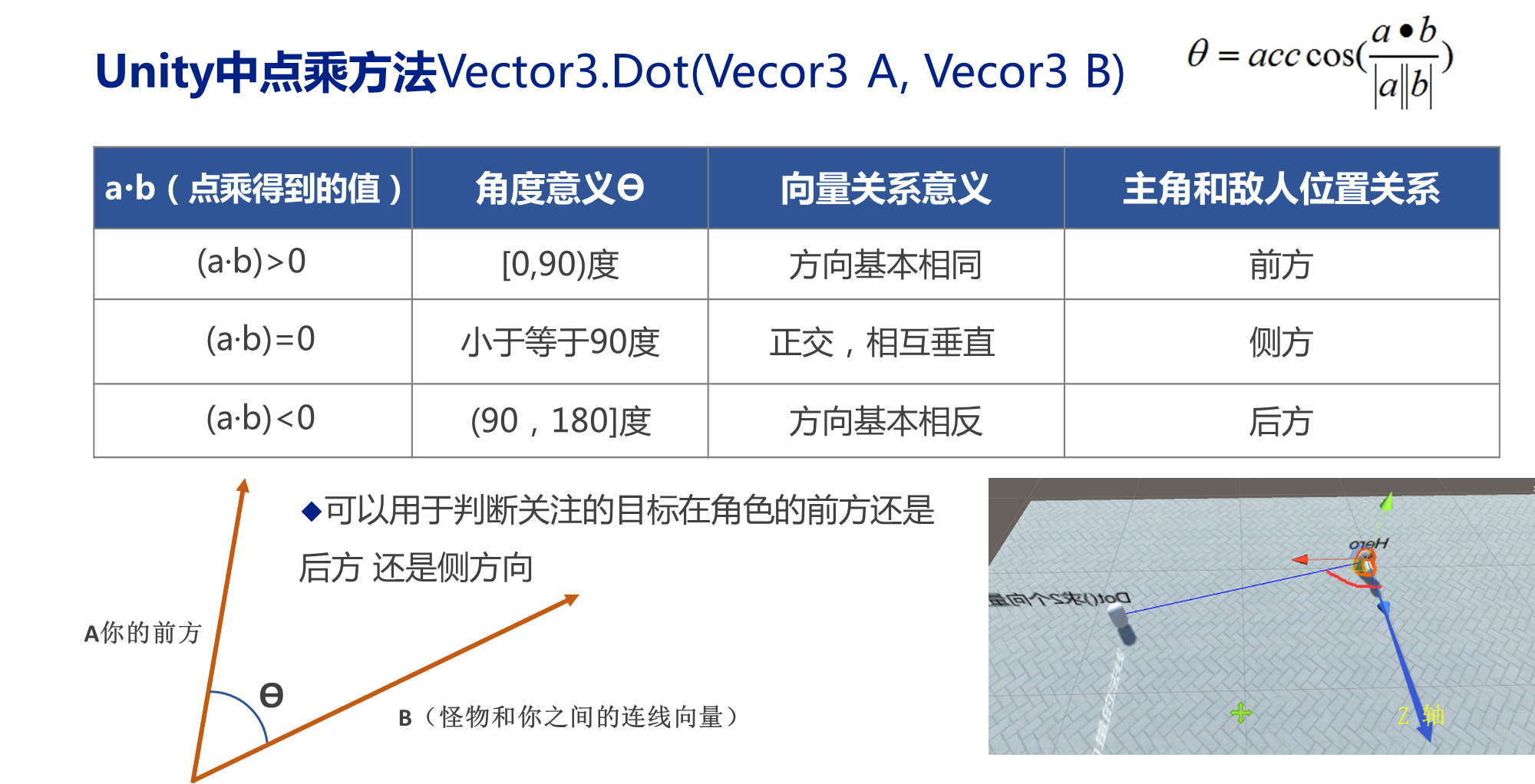

推理流程

-

初始化

- 调用aclInit接口初始化AscendCL配置。

- 调用aclFinalize接口实现AscendCL去初始化。

-

Device管理

- 调用aclrtSetDevice接口指定用于运算的Device。

- 调用aclrtGetRunMode接口获取昇腾AI软件栈的运行模式,根据运行模式的不同,内部处理流程不同。

- 调用aclrtResetDevice接口复位当前运算的Device,回收Device上的资源。

-

Context管理

- 调用aclrtCreateContext接口创建Context。

- 调用aclrtSetCurrentContext接口设置线程的Context。

- 调用aclrtDestroyContext接口销毁Context。

-

Stream管理

- 调用aclrtCreateStream接口创建Stream。

- 调用aclrtDestroyStream接口销毁Stream。

-

内存管理

- 调用aclrtMallocHost接口申请Host上内存。

- 调用aclrtFreeHost释放Host上的内存。

- 调用aclrtMalloc接口申请Device上的内存。

- 调用aclrtFree接口释放Device上的内存。

-

数据传输

调用aclrtMemcpy接口通过内存复制的方式实现数据传输。

-

模型推理

- 调用aclmdlLoadFromFileWithMem接口从*.om文件加载模型。

- 创建新线程(例如t1),在线程函数内调用aclrtProcessReport接口,等待指定时间后,触发回调函数(例如CallBackFunc,用于处理模型推理结果)。

- 调用aclrtSubscribeReport接口,指定处理Stream上回调函数(CallBackFunc)的线程(t1)。

- 调用aclmdlExecuteAsync接口执行模型推理,异步接口。

- 调用aclrtLaunchCallback接口,在Stream的任务队列中增加一个需要在Host/Device上执行的回调函数(CallBackFunc)。

- 调用aclrtSynchronizeStream接口,阻塞应用程序运行,直到指定Stream中的所有任务都完成。

- 调用aclrtUnSubscribeReport接口,取消线程注册,Stream上的回调函数(CallBackFunc)不再由指定线程(t1)处理。

- 模型推理结束后,调用aclmdlUnload接口卸载模型。

编码

创建main.cpp

#include "acl/acl.h"

#include <iostream>

#include <fstream>

#include <cstring>

#include <map>

using namespace std;

int32_t deviceId = 0;

void InitResource()

{

aclError ret = aclInit(nullptr);

ret = aclrtSetDevice(deviceId);

}

uint32_t modelId;

void LoadModel(const char* modelPath)

{

aclError ret = aclmdlLoadFromFile(modelPath, &modelId);

}

size_t pictureDataSize = 0;

void *pictureHostData;

void *pictureDeviceData;

//申请内存,使用C/C++标准库的函数将测试图片读入内存

void ReadPictureTotHost(const char *picturePath)

{

string fileName = picturePath;

ifstream binFile(fileName, ifstream::binary);

binFile.seekg(0, binFile.end);

pictureDataSize = binFile.tellg();

binFile.seekg(0, binFile.beg);

aclError ret = aclrtMallocHost(&pictureHostData, pictureDataSize);

binFile.read((char*)pictureHostData, pictureDataSize);

binFile.close();

}

//申请Device侧的内存,再以内存复制的方式将内存中的图片数据传输到Device

void CopyDataFromHostToDevice()

{

aclError ret = aclrtMalloc(&pictureDeviceData, pictureDataSize, ACL_MEM_MALLOC_HUGE_FIRST);

ret = aclrtMemcpy(pictureDeviceData, pictureDataSize, pictureHostData, pictureDataSize,

ACL_MEMCPY_HOST_TO_DEVICE);

}

void LoadPicture(const char* picturePath)

{

ReadPictureTotHost(picturePath);

CopyDataFromHostToDevice();

}

aclmdlDataset *inputDataSet;

aclDataBuffer *inputDataBuffer;

aclmdlDataset *outputDataSet;

aclDataBuffer *outputDataBuffer;

aclmdlDesc *modelDesc;

size_t outputDataSize = 0;

void *outputDeviceData;

// 准备模型推理的输入数据结构

void CreateModelInput()

{

// 创建aclmdlDataset类型的数据,描述模型推理的输入

inputDataSet = aclmdlCreateDataset();

inputDataBuffer = aclCreateDataBuffer(pictureDeviceData, pictureDataSize);

aclError ret = aclmdlAddDatasetBuffer(inputDataSet, inputDataBuffer);

}

// 准备模型推理的输出数据结构

void CreateModelOutput()

{

// 创建模型描述信息

modelDesc = aclmdlCreateDesc();

aclError ret = aclmdlGetDesc(modelDesc, modelId);

// 创建aclmdlDataset类型的数据,描述模型推理的输出

outputDataSet = aclmdlCreateDataset();

// 获取模型输出数据需占用的内存大小,单位为Byte

outputDataSize = aclmdlGetOutputSizeByIndex(modelDesc, 0);

// 申请输出内存

ret = aclrtMalloc(&outputDeviceData, outputDataSize, ACL_MEM_MALLOC_HUGE_FIRST);

outputDataBuffer = aclCreateDataBuffer(outputDeviceData, outputDataSize);

ret = aclmdlAddDatasetBuffer(outputDataSet, outputDataBuffer);

}

// 执行模型

void Inference()

{

CreateModelInput();

CreateModelOutput();

aclError ret = aclmdlExecute(modelId, inputDataSet, outputDataSet);

}

void *outputHostData;

void PrintResult()

{

// 获取推理结果数据

aclError ret = aclrtMallocHost(&outputHostData, outputDataSize);

ret = aclrtMemcpy(outputHostData, outputDataSize, outputDeviceData, outputDataSize,

ACL_MEMCPY_DEVICE_TO_HOST);

// 将内存中的数据转换为float类型

float* outFloatData = reinterpret_cast<float *>(outputHostData);

// 屏显测试图片的top5置信度的类别编号

map<float, unsigned int, greater<float>> resultMap;

for (unsigned int j = 0; j < outputDataSize / sizeof(float);++j)

{

resultMap[*outFloatData] = j;

outFloatData++;

}

int cnt = 0;

for (auto it = resultMap.begin();it != resultMap.end();++it)

{

if(++cnt > 5)

{

break;

}

printf("top %d: index[%d] value[%lf] \n", cnt, it->second, it->first);

}

}

void UnloadModel()

{

// 释放模型描述信息

aclmdlDestroyDesc(modelDesc);

// 卸载模型

aclmdlUnload(modelId);

}

void UnloadPicture()

{

aclError ret = aclrtFreeHost(pictureHostData);

pictureHostData = nullptr;

ret = aclrtFree(pictureDeviceData);

pictureDeviceData = nullptr;

aclDestroyDataBuffer(inputDataBuffer);

inputDataBuffer = nullptr;

aclmdlDestroyDataset(inputDataSet);

inputDataSet = nullptr;

ret = aclrtFreeHost(outputHostData);

outputHostData = nullptr;

ret = aclrtFree(outputDeviceData);

outputDeviceData = nullptr;

aclDestroyDataBuffer(outputDataBuffer);

outputDataBuffer = nullptr;

aclmdlDestroyDataset(outputDataSet);

outputDataSet = nullptr;

}

void DestroyResource()

{

aclError ret = aclrtResetDevice(deviceId);

aclFinalize();

}

int main()

{

// 1.定义一个资源初始化的函数,用于AscendCL初始化、运行管理资源申请(指定计算设备)

InitResource();

// 2.定义一个模型加载的函数,加载图片分类的模型,用于后续推理使用

const char *modelPath = "../model/resnet50.om";

LoadModel(modelPath);

// 3.定义一个读图片数据的函数,将测试图片数据读入内存,并传输到Device侧,用于后续推理使用

const char *picturePath = "../data/dog1_1024_683.bin";

LoadPicture(picturePath);

// 4.定义一个推理的函数,用于执行推理

Inference();

// 5.定义一个推理结果数据处理的函数,用于在终端上屏显测试图片的top5置信度的类别编号

PrintResult();

// 6.定义一个模型卸载的函数,卸载图片分类的模型

UnloadModel();

// 7.定义一个函数,用于释放内存、销毁推理相关的数据类型,防止内存泄露

UnloadPicture();

// 8.定义一个资源去初始化的函数,用于AscendCL去初始化、运行管理资源释放(释放计算设备)

DestroyResource();

}

编译与运行

bash sample_build.sh

-- The C compiler identification is GNU 9.4.0

-- The CXX compiler identification is GNU 9.4.0

-- Check for working C compiler: /usr/bin/cc

-- Check for working C compiler: /usr/bin/cc -- works

-- Detecting C compiler ABI info

-- Detecting C compiler ABI info - done

-- Detecting C compile features

-- Detecting C compile features - done

-- Check for working CXX compiler: /usr/bin/g++

-- Check for working CXX compiler: /usr/bin/g++ -- works

-- Detecting CXX compiler ABI info

-- Detecting CXX compiler ABI info - done

-- Detecting CXX compile features

-- Detecting CXX compile features - done

-- env INC_PATH: /usr/local/Ascend/ascend-toolkit/latest

-- env LIB_PATH: /usr/local/Ascend/ascend-toolkit/latest/aarch64-linux/devlib

-- Configuring done

-- Generating done

-- Build files have been written to: /home/shaolin/demo/build/intermediates/host

Scanning dependencies of target main

[ 50%] Building CXX object CMakeFiles/main.dir/main.cpp.o

[100%] Linking CXX executable /home/shaolin/demo/out/main

[100%] Built target main

make for app MyFirstApp_build Successfully

bash sample_run.sh

top 1: index[161] value[0.766602]

top 2: index[162] value[0.155762]

top 3: index[167] value[0.038452]

top 4: index[163] value[0.021576]

top 5: index[166] value[0.011642]

参考

有疑问 欢迎加公众号 讨论