博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看

配套 github 链接:https://github.com/nickchen121/Pre-training-language-model

配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html

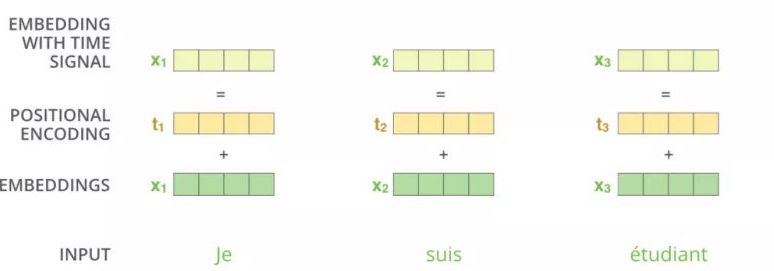

Self-Attention:对于每个词而言都是无位置关系,把每个词的顺序打乱,得到的注意力值依然不变

通过 t1 告诉你,x1 是在前面,x2 在 x1 的后面

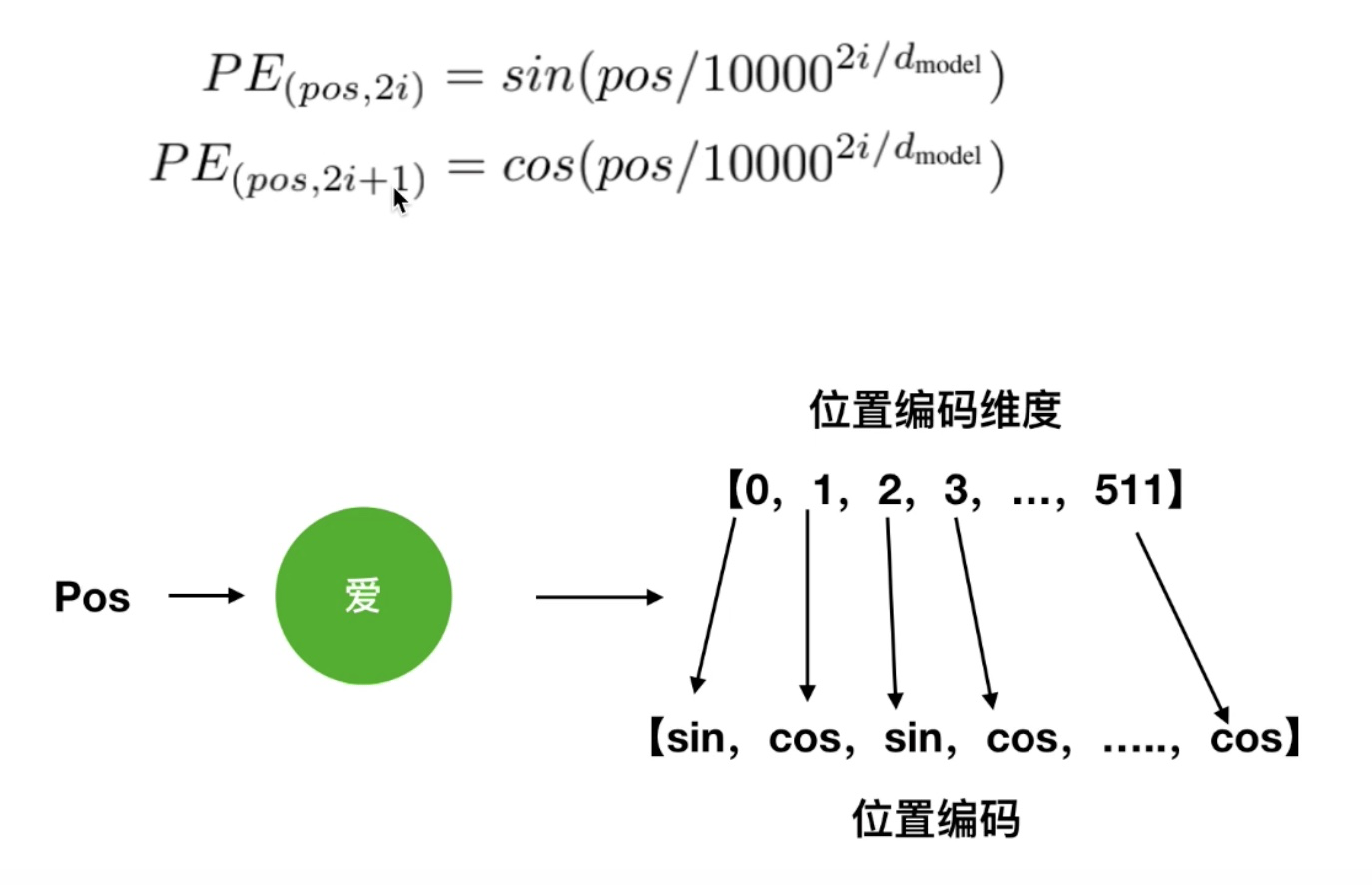

位置编码

位置编码公式

![[SQL开发笔记]BETWEEN操作符:选取介于两个值之间的数据范围内的值](https://img-blog.csdnimg.cn/f9f1cef6c4c4480abbb115dc52898727.png)