前言

这是我在这个网站整理的笔记,有错误的地方请指出,关注我,接下来还会持续更新。 作者:神的孩子都在歌唱

一文了解和使用nginx

- 一. nginx 简介

- 1.1 什么是 nginx 和可以做什么事情

- 1.2 正向代理

- 1.3 反向代理

- 1.4 负载均衡

- 1.5 SSL 配置

- 1.6 管理虚拟主机

- 1.7 日志和监控

- 二. Nginx 的安装

- 三. Nginx 的常用命令和配置文件

- 3.1 Nginx 的常用命令

- 3.2 nginx.conf 配置文件

- 四. Nginx 配置实例 反向代理

- 4.1 准备工作

- 4.2 反向代理1

- 4.3 反向代理实例 2

一. nginx 简介

Nginx 是高性能的 HTTP 和反向代理的服务器,它广泛用于构建现代Web应用和提供网络服务,特点是占有内存少,处理高并发能力是十分强大的

1.1 什么是 nginx 和可以做什么事情

Nginx 可以作为静态页面的 web 服务器,同时还支持 CGI 协议的动态语言,比如 perl、php等。但是不支持 java。Java 程序可以通过与 tomcat 配合完成。Nginx 专为性能优化而开发,性能是其最重要的考量,实现上非常注重效率 ,能经受高负载的考验,有报告表明能支持高达 50,000 个并发连接数。https://lnmp.org/nginx.html

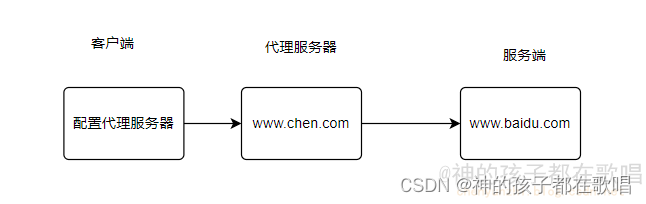

1.2 正向代理

需要在客户端配置代理服务器进行指定网站访问

Nginx不仅可以做反向代理,实现负载均衡。还能用作正向代理来进行上网等功能。

正向代理:如果把局域网外的 Internet 想象成一个巨大的资源库,则局域网中的客户端要访问 Internet,则需要通过代理服务器来访问,这种代理服务就称为正向代理。

1.3 反向代理

暴露的是代理服务器地址,隐藏了真实服务器 IP 地址。

反向代理,其实客户端对代理是无感知的,因为客户端不需要任何配置就可以访问,我们只需要将请求发送到反向代理服务器,由反向代理服务器去选择目标服务器获取数据后,在返回给客户端,此时反向代理服务器和目标服务器对外就是一个服务器,暴露的是代理服务器地址,隐藏了真实服务器 IP 地址。

server {

listen 80;

server_name myapp.com; # 代理服务器名称

location / {

proxy_pass http://backend_server; # 被代理的后端服务

}

}

1.4 负载均衡

负载均衡(Load Balancing)是计算机网络和服务器领域中的一项重要技术,它用于分发网络流量、请求或工作负载到多个服务器或资源上,以确保系统的高可用性、性能优化和故障容忍性。负载均衡的主要目的是在多个服务器之间均匀分配工作负载,以避免某台服务器过载,而其他服务器资源闲置不用

Nginx是一个流行的开源反向代理服务器和Web服务器,它提供了多种分配方式(策略)来实现负载均衡。以下是Nginx支持的一些常见的负载均衡策略:

- 第一种 轮询(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器 down 掉,能自动剔除。 - 第二种 weight

weight 代表权重默认为 1,权重越高,被分配的客户端越多。

weight 和访问比率成正比,用于后端服务器性能不均的情况。

例如:

upstream server_pool{

server 192.168.5.21 weight=10;

server 192.168.5.22 weight=10;

}

- 第三种 ip_hash

每个请求按访问 ip 的 hash 结果分配,这样每个访客固定访问一个后端服务器,可以解决 session 的问题。 例如:

upstream server_pool{

ip_hash;

server 192.168.5.21:80;

server 192.168.5.22:80;

}

- 第四种 fair(第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

upstream server_pool{

server 192.168.5.21:80;

server 192.168.5.22:80;

fair;

}

配置示例:

upstream backend {

server backend1.example.com;

server backend2.example.com;

server backend3.example.com;

}

server {

listen 80;

server_name myapp.com;

location / {

}

}

为什么使用负载均衡:

客户端发送多个请求到服务器,服务器处理请求,有一些可能要与数据库进行交互,服务器处理完毕后,再将结果返回给客户端。这种架构模式对于早期的系统相对单一,并发请求相对较少的情况下是比较适合的,成本也低。但是随着信息数量的不断增长,访问量和数据量的飞速增长,以及系统业务的复杂度增加,这种架构会造成服务器相应客户端的请求日益缓慢,并发量特别大的时候,还容易造成服务器直接崩溃。很明显这是由于服务器性能的瓶颈造成的问题,那么如何解决这种情况呢?

我们首先想到的可能是升级服务器的配置,比如提高 CPU 执行频率,加大内存等提高机器的物理性能来解决此问题,但是我们知道摩尔定律的日益失效,硬件的性能提升已经不能满足日益提升的需求了。最明显的一个例子,天猫双十一当天,某个热销商品的瞬时访问量是极其庞大的,那么类似上面的系统架构,将机器都增加到现有的顶级物理配置,都是不能够满足需求的。那么怎么办呢?

上面的分析我们去掉了增加服务器物理配置来解决问题的办法,也就是说纵向解决问题的办法行不通了,那么横向增加服务器的数量呢?这时候集群的概念产生了,单个服务器解决不了,我们增加服务器的数量,然后将请求分发到各个服务器上,将原先请求集中到单个动静分离

1.5 SSL 配置

为了加强安全性,您可以为您的网站配置SSL。以下是一个简单的SSL配置示例:

server {

listen 443 ssl;

server_name secure.example.com;

ssl_certificate /etc/nginx/ssl/secure.crt;

ssl_certificate_key /etc/nginx/ssl/secure.key;

location / {

root /var/www/secure;

index index.html;

}

}

1.6 管理虚拟主机

虚拟主机允许您在同一台服务器上托管多个网站。在配置文件中添加以下内容以创建一个虚拟主机:

server {

listen 80;

server_name example.com www.example.com;

location / {

root /var/www/example;

index index.html;

}

}

1.7 日志和监控

Nginx生成访问日志和错误日志,这对于监控和故障排除非常有用。您可以在配置文件中指定日志文件的位置和格式:

error_log /var/log/nginx/error.log;

access_log /var/log/nginx/access.log;

此外,您可以使用第三方工具如Nginx Amplify来监控Nginx性能和健康。

二. Nginx 的安装

在 linux 系统中安装 nginx

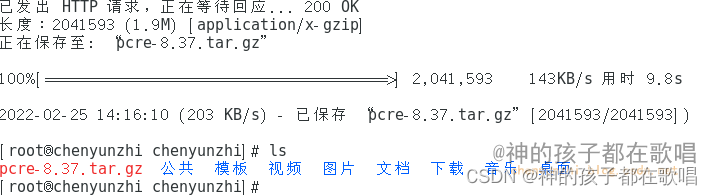

(1)安装 pcre 依赖

联网下载 pcre 压缩文件依赖

wget http://downloads.sourceforge.net/project/pcre/pcre/8.37/pcre-8.37.tar.gz

解压压缩文件 tar –xvf pcre-8.37.tar.gz

./configure 完成后,回到 pcre 目录下执行 make,最后执行 make install

查看pcre版本 pcre-config --version

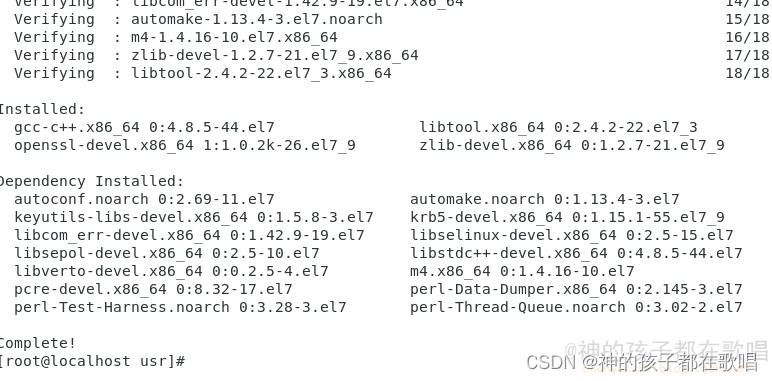

(2)安装 openssl 、zlib 、 gcc 依赖

yum -y install make zlib zlib-devel gcc-c++ libtool openssl openssl-devel

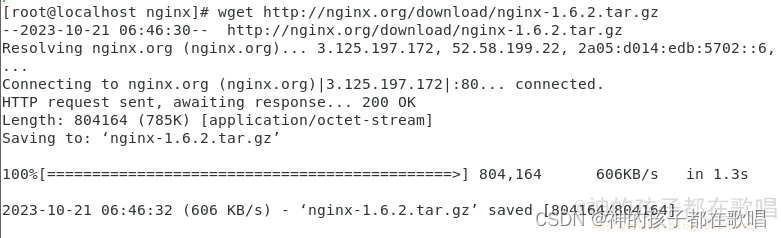

(3)安装 nginx

- 使用命令安装

下载 Nginx,下载地址:http://nginx.org/download/nginx-1.6.2.tar.gz

wget http://nginx.org/download/nginx-1.6.2.tar.gz

tar zxvf nginx-1.6.2.tar.gz

cd nginx-1.6.2

- 进入解压目录 ./configure

- make && make install

- 进入目录 /usr/local/nginx/sbin 启动服务

./nginx

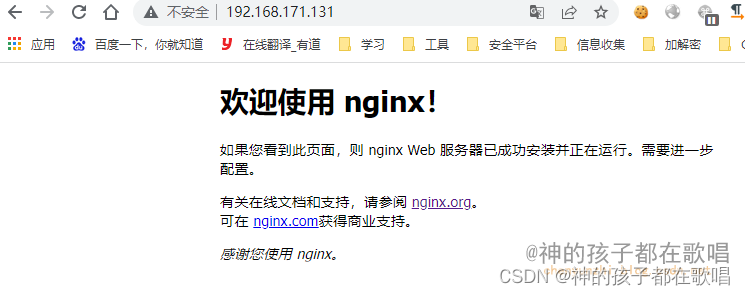

在 windows 系统中访问 linux 中 nginx,默认不能访问的,因为防火墙问题

(1)关闭防火墙

(2)开放访问的端口号,80 端口

查看开放的端口号

firewall-cmd --list-all

设置开放的端口号

firewall-cmd --add-service=http –permanent

firewall-cmd --add-port=80/tcp --permanent

重启防火墙

firewall-cmd –reload

三. Nginx 的常用命令和配置文件

3.1 Nginx 的常用命令

进入nginx目录中 cd /usr/local/nginx/sbin

查看nginx版本号 ./nginx -v

启动 ./nginx

停止 ./nginx -s stop

重新加载 ./nginx -s reload

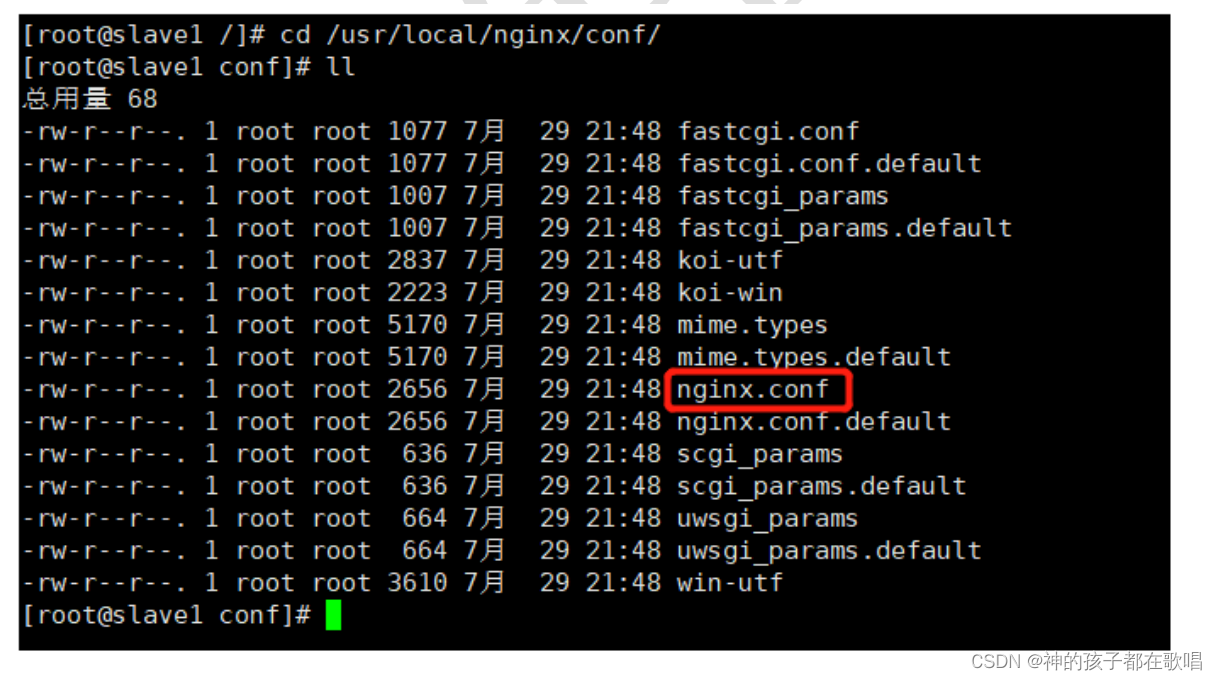

3.2 nginx.conf 配置文件

nginx 安装目录下,其默认的配置文件都放在这个目录的 conf 目录下,而主配置文件nginx.conf 也在其中,后续对 nginx 的使用基本上都是对此配置文件进行相应的修改。

cd /usr/local/nginx/conf/nginx.conf

配置文件中有很多#, 开头的表示注释内容,我们去掉所有以 # 开头的段落,精简之后的内容如下:

配置文件中包含三部分内容

(1)全局块:配置服务器整体运行的配置指令

从配置文件开始到 events 块之间的内容,主要会设置一些影响 nginx 服务器整体运行的配置指令,主要包括配置运行 Nginx 服务器的用户(组)、允许生成的 worker process 数,进程 PID 存放路径、日志存放路径和类型以及配置文件的引入等

比如 worker_processes 1; 处理并发数的配置

这是 Nginx 服务器并发处理服务的关键配置,worker_processes 值越大,可以支持的并发处理量也越多,但是会受到硬件、软件等设备的制约

(2)events 块:影响 Nginx 服务器与用户的网络连接

比如 worker_connections 1024; 支持的最大连接数为 1024

events 块涉及的指令主要影响 Nginx 服务器与用户的网络连接,常用的设置包括是否开启对多

work process下的网络连接进行序列化,是否允许同时接收多个网络连接,选取哪种事件驱动模型来处理连接请求,每个word process可以同时支持的最大连接数等。

上述例子就表示每个 work process 支持的最大连接数为 1024.这部分的配置对 Nginx 的性能影响较大,在实际中应该灵活配置。

(3)http块还包含两部分:

这算是 Nginx 服务器配置中最频繁的部分,代理、缓存和日志定义等绝大多数功能和第三方模块的配置都在这里。

需要注意的是:http 块也可以包括 http 全局块、server 块

- http 全局块

http 全局块配置的指令包括文件引入、MIME-TYPE 定义、日志自定义、连接超时时间、单链接请求数上限等。 - server 块

这块和虚拟主机有密切关系,虚拟主机从用户角度看,和一台独立的硬件主机是完全一样的,该技术的产生是为了节省互联网服务器硬件成本。

每个 http 块可以包括多个 server 块,而每个 server 块就相当于一个虚拟主机。

而每个 server 块也分为全局 server 块,以及可以同时包含多个 locaton 块。 - 全局 server 块

最常见的配置是本虚拟机主机的监听配置和本虚拟主机的名称或 IP 配置。 - location 块

一个 server 块可以配置多个 location 块。

这块的主要作用是基于 Nginx 服务器接收到的请求字符串(例如 server_name/uri-string),对虚拟主机名称(也可以是 IP 别名)之外的字符串(例如 前面的 /uri-string)进行匹配,对特定的请求进行处理。地址定向、数据缓存和应答控制等功能,还有许多第三方模块的配置也在这里进行。

四. Nginx 配置实例 反向代理

4.1 准备工作

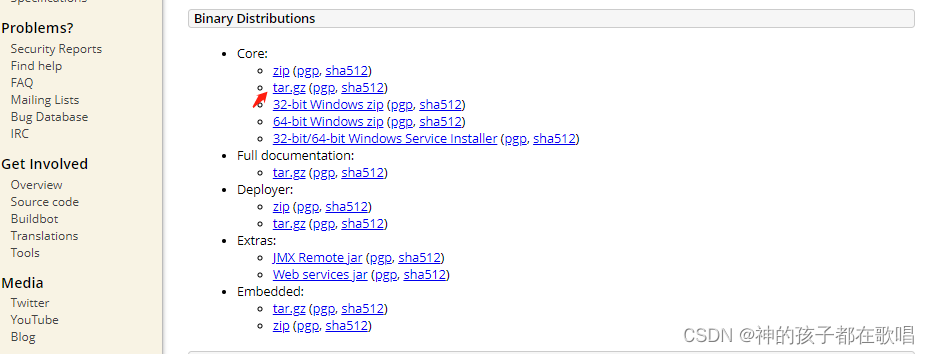

下载地址 : https://tomcat.apache.org/download-80.cgi

# 在 liunx 系统安装 tomcat,使用默认端口 8080

wget https://dlcdn.apache.org/tomcat/tomcat-8/v8.5.95/bin/apache-tomcat-8.5.95.tar.gz

tar -zxvf apache-tomcat-8.5.95.tar.gz

cd apache-tomcat-8.5.95/bin/

# 进入 tomcat 的 bin 目录中,./startup.sh 启动 tomcat 服务器

./startup.sh

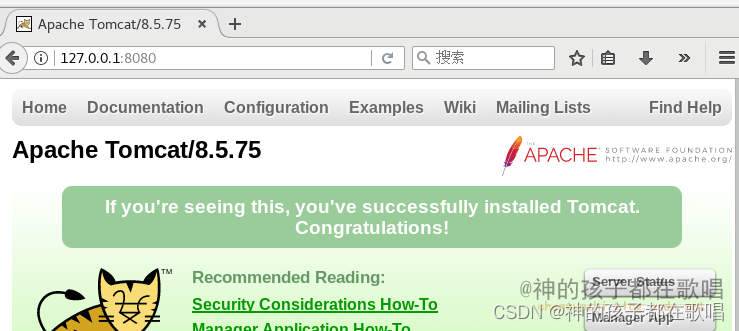

linux中访问

对外开放访问的端口

firewall-cmd --add-port=8080/tcp --permanent

firewall-cmd –reload

查看已经开放的端口号

firewall-cmd --list-all

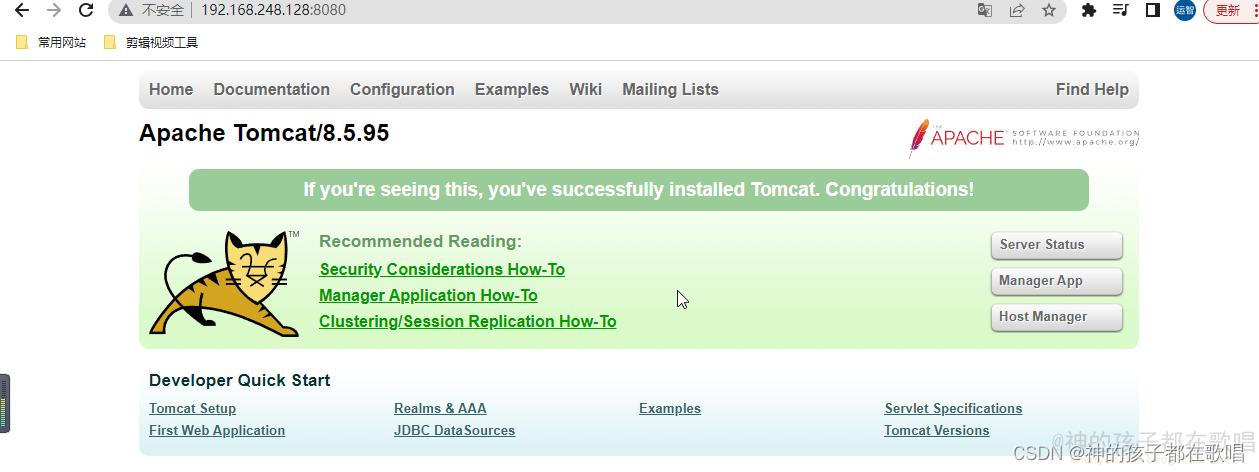

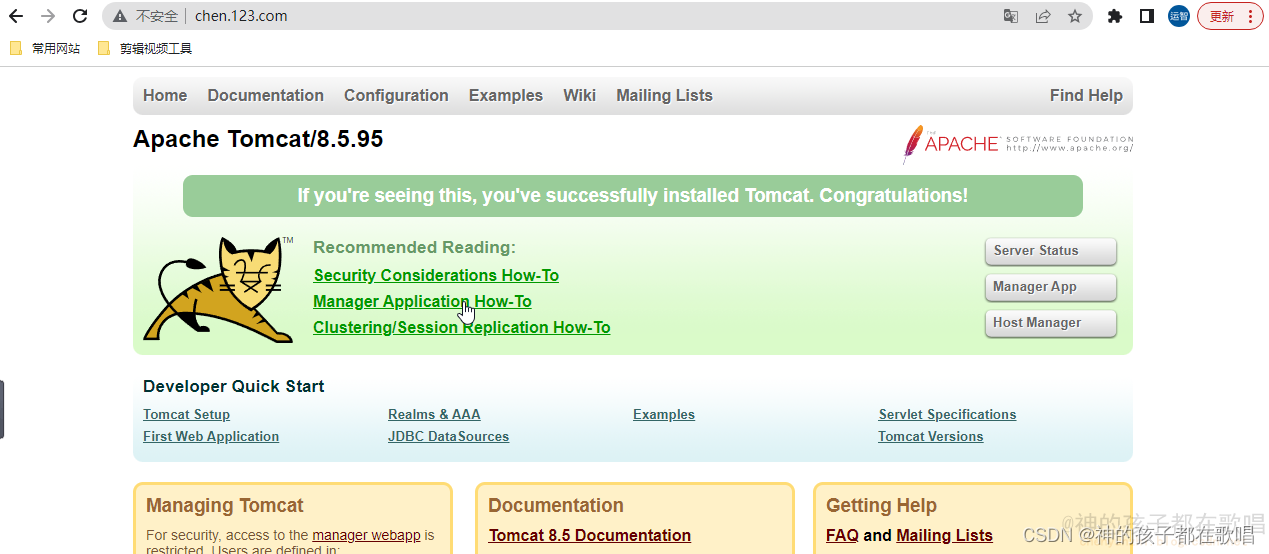

(3)在 windows 系统中通过浏览器访问 tomcat 服务器

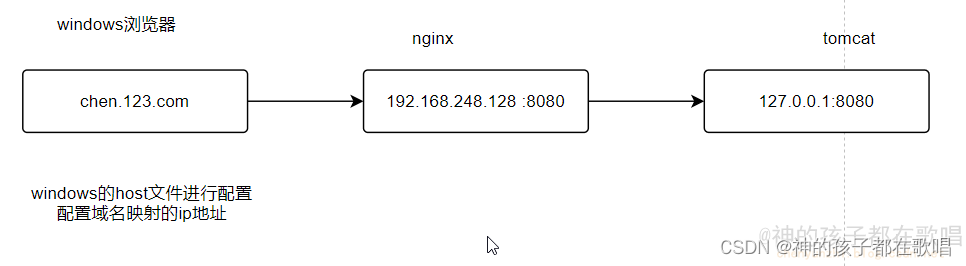

4.2 反向代理1

-

实现效果:

打开浏览器,在浏览器地址栏输入地址 www.chen.com,跳转到 liunx 系统 tomcat 主页

-

具体配置

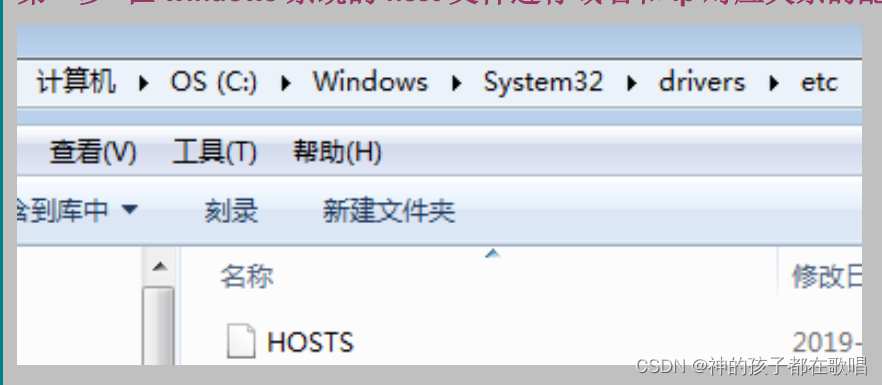

(1)进入C:\Windows\System32\drivers\etc, 在 windows 系统的 hosts 文件进行域名和 ip 对应关系的配置

在最底下配置: 192.168.248.128 chen.123.com

(2) 在 nginx 进行请求转发的配置(反向代理配置)

server {

listen 80;

server_name chen.123.com;

location / {

proxy_pass http://127.0.0.1:8080;

index index.html;

}

}

- 最终测试

在本地主机上通过域名http://chen.123.com/访问

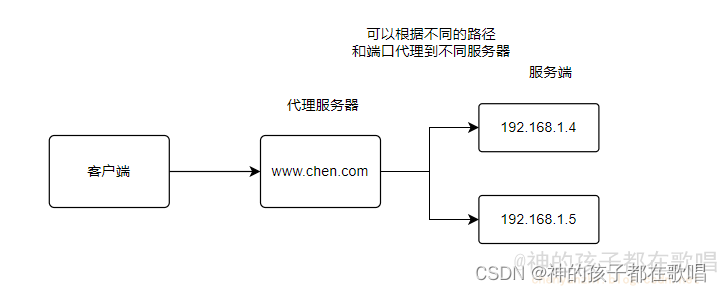

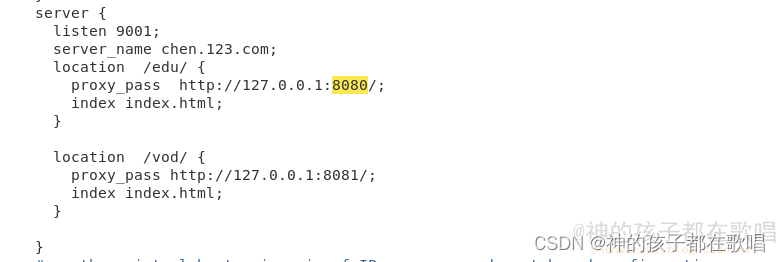

4.3 反向代理实例 2

- 实现效果

使用 nginx 反向代理,根据访问的路径跳转到不同端口的服务中

nginx 监听端口为 9001

访问 http://chen.123.com:9001/edu/ 直接跳转到 127.0.0.1:8080

访问 http://chen.123.com:9001/vod/ 直接跳转到 127.0.0.1:8081

- 准备工作

(1)准备两个 tomcat 服务器,一个 8080 端口,一个 8081 端口

(2)创建文件夹和测试页面 - 具体配置

(1)找到 nginx 配置文件,进行反向代理配置

注意:代理服务http后面要加上/

(2)开放对外访问的端口号 9001 8080 8081

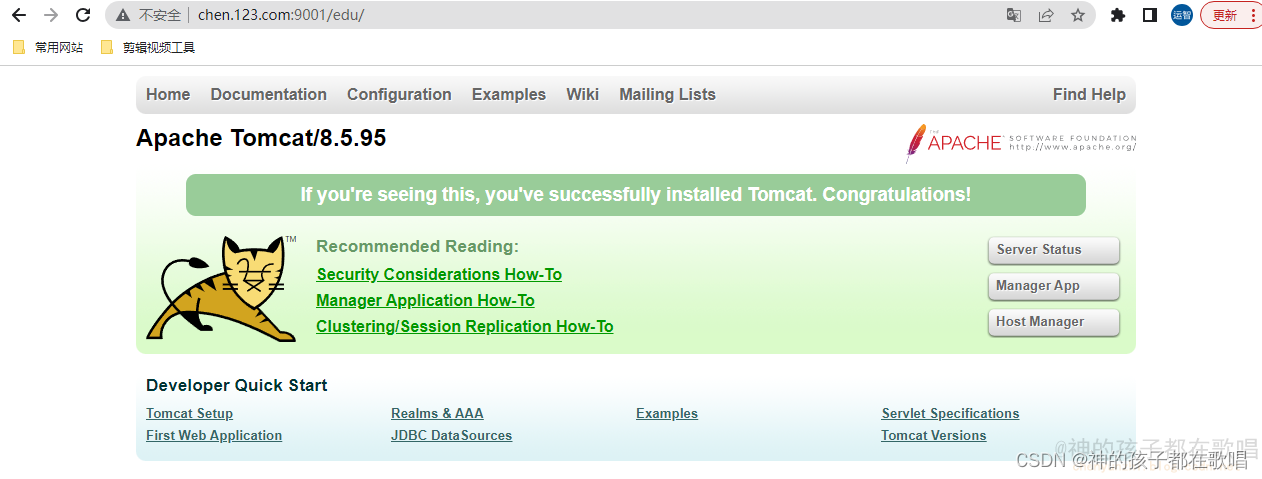

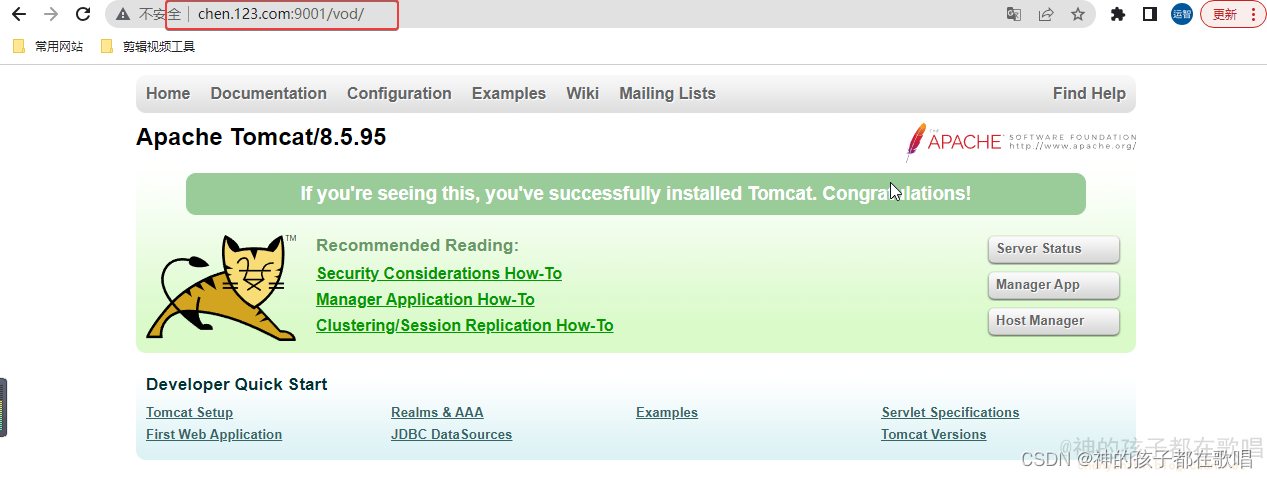

- 最终测试

访问:

http://chen.123.com:9001/edu/

http://chen.123.com:9001/vod/

作者:神的孩子都在歌唱

本人博客:https://blog.csdn.net/weixin_46654114

转载说明:务必注明来源,附带本人博客连接。

![NSS [SWPUCTF 2022 新生赛]numgame](https://img-blog.csdnimg.cn/img_convert/b552f0587a31b3d17ef405df6691313a.png)

![[GXYCTF2019]Ping Ping Ping 1](https://img-blog.csdnimg.cn/img_convert/c1ac86996efe6e7b1b4902f852426ce9.png)