1.引言

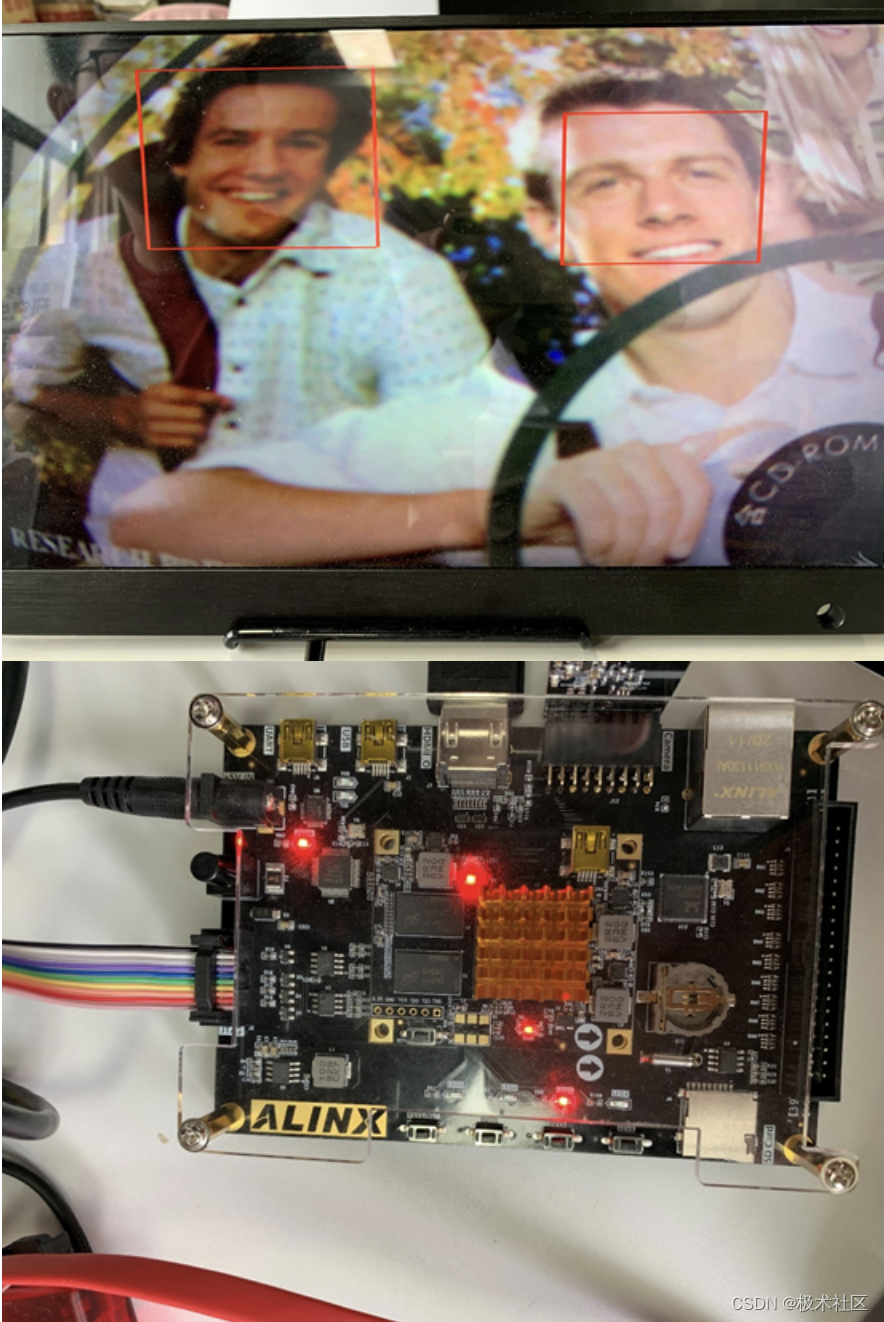

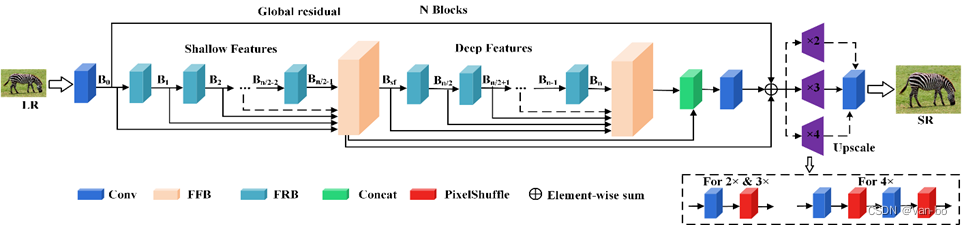

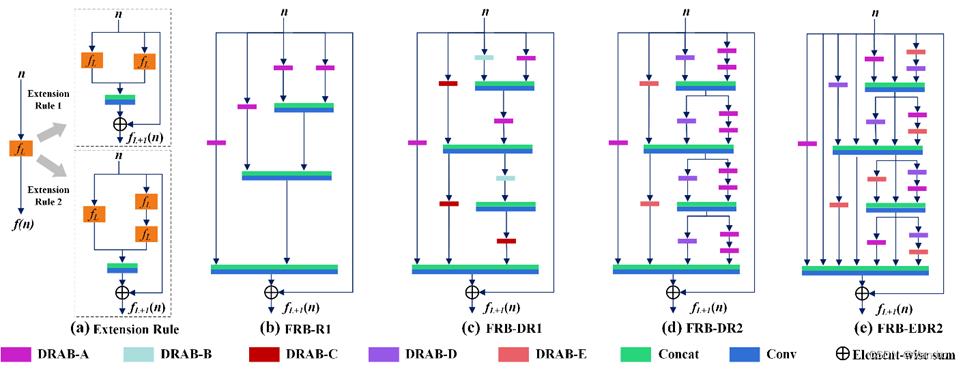

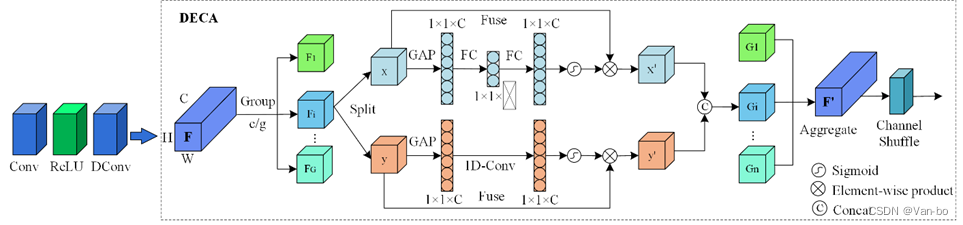

深度神经网络可以显著提高超分辨率的质量,但现有方法难以充分利用低分辨率尺度特征和通道信息,从而阻碍了卷积神经网络的表达能力。针对此类问题,本章提出了一种多尺度分形残差注意力网络(Multi-scale Fractal Residual Attention Network, MFRAN)。具体而言,MFRAN 由分形残差块(Fractal Residual Block, FRB)、双路增强通道注意力(Dual-Enhanced Channel Attention, DECA)和DECA构成的空洞残差注意力模块(Dilated Residual Attention Block, DRAB)等组件构成。其中,FRB应用多尺度扩展规则,连续扩展为能够检测多尺度特征的分形结构;DRAB采用组合空洞卷积来构造特征提取模块,以学习具有更大感受野的特征表示,从而提高模型的泛化性和表达能力;DECA采用一维卷积实现跨通道信息交互,通过通道混洗增强分组之间的信息流动。最后,通过局部残差和特征融合对不同层次特征表示进行整合。通过对基准数据集的定量和定性评估表明,所提方法在定量指标和可视化结果方面优于最先进的方法。

2.网络结构

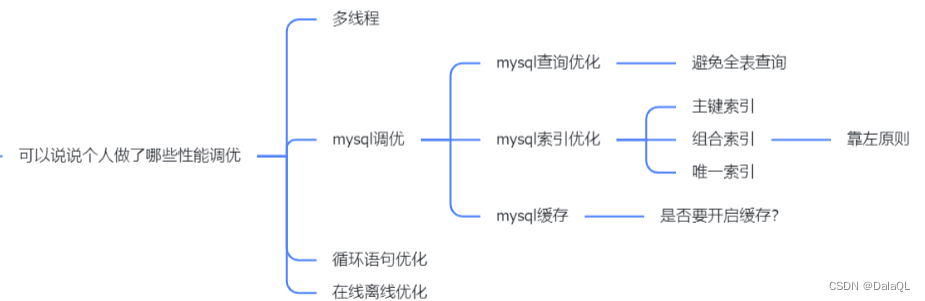

SR是一项像素级回归任务,以前的工作倾向于在单个路径上构建深度网络架构,导致尺度信息提取能力有限,网络需要有效的多尺度特征表示来准确预测细节信息。另一方面,在网络的设计中,网络的宽度与网络的深度同样重要,网络越宽对目标特征的提取能力越强,即这一层网络能学习到更加丰富的特征,比如不同方向、不同频率的纹理特征等,因此,本方法将重点从以前的深而窄的体系结构转移到深而宽的网络结构。

使用自适应选择机制代替传统注意力中的1×1卷积来指导通道选择,采用1×1卷积的方式会造成通道数量的改变,从而引起内存访问次数(Memory access times,MAC)增加,降低模型推理速度。通过该方式可以避免通道数量的改变,更好地平衡模型的速度和精度。随后,采用Sigmoid层对生成的注意力权重矩阵进行归一化,并与初始特征映射x进行按元素相乘,最后得到通道注意力

为了提高深度神经网络的训练速度,文章将输入的特征F划分为G组,每个注意力机制仅应用于特定的通道组,之后对G组特征进行聚合,聚合后再将通道数恢复到C。同时,为了实现不同通道之间的连接,通过reshape操作将C重塑为(G,C)并对其进行混洗操作,使得通道之间变成无序状态,并将其转置为(C,G)。最后,通过reshape操作将其重新塑造为C。通过这种方式,能够在通道维度上实现信息的跨组流动,并且可以提高信息表征的能力。此外,分组卷积有助于加快训练速度,进一步提高了深度神经网络的性能。

文章的主要工作贡献总结如下:

1)提出了一种用于单图像超分辨重建的多尺度分形残差注意力网络MFRAN,与现有方法相比,所提方法以更少的参数获得了更好的效果,重建出的图像的细节纹理更真实、更清晰。

2)设计了一种双路增强通道注意力机制DECA,它可以更有效、更轻松地捕获通道间依赖关系,同时实现跨通道信息交互,增强通道建模能力,使模型能够在高尺度因子下重建具有更丰富细节的SR图像。

3)构建了一种具有高度扩展性的分形残差块FRB,在FRB内部具有多条不同深度的局部特征提取路径,每条路径由具有不同大小感受野的空洞残差注意力模块组成,从而有效地提取不同尺度的LR特征。

4)网络整体被划分为浅层特征提取部分和深层特征提取部分两个阶段。其中,浅层网络具有较强的空间细节信息表示能力,而深层网络具有丰富的语义信息,利用特征融合对底层特征和高层特征进行聚合,为重构高质量细节提供更丰富的信息。