NVIDIA TensorRT 简介及使用

- 1. NVIDIA TensorRT 的简介

- 2. NVIDIA TensorRT 的优势

- 2.1 推理速度提升 36 倍

- 2.2 优化推理性能

- 2.3 加速每一项工作负载

- 2.4 使用 Triton 进行部署、运行和扩展

- 3. NVIDIA TensorRT 大型语言模型的推理

- 4. NVIDIA TensorRT 的使用方法

- 5. NVIDIA TensorRT 世界领先的推理性能

- 6. NVIDIA TensorRT 加速每个推理平台

- 7. NVIDIA TensorRT 支持主要框架

- 7.1 PyTorch

- 7.2 TensorFlow

- 7.3 ONNX

- 7.4 Matlab

声明:此文仅作为个人学习记录

- NVIDIA TensorRT 链接:https://developer.nvidia.com/tensorrt

- NVIDIA 深度学习 TensorRT 文档:https://docs.nvidia.com/deeplearning/tensorrt/index.html

1. NVIDIA TensorRT 的简介

NVIDIA® TensorRT™是高性能深度学习推理的SDK,包括深度学习推理优化器和运行时,可为推理应用程序提供低延迟和高吞吐量。

2. NVIDIA TensorRT 的优势

2.1 推理速度提升 36 倍

基于 NVIDIA TensorRT 的应用程序在推理期间比仅使用 CPU 的平台快 36 倍,使您能够优化在所有主要框架上训练的神经网络模型,以高精度校准较低精度,并部署到超大规模数据中心、嵌入式平台或汽车产品平台。

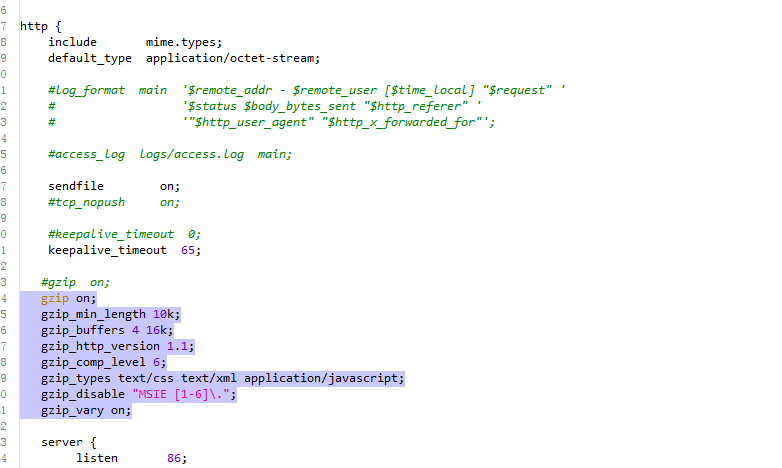

2.2 优化推理性能

TensorRT 建立在 NVIDIA CUDA® 并行编程模型之上,使您能够使用 NVIDIA GPU 上的量化、层和张量融合、内核调优等技术优化推理。

2.3 加速每一项工作负载

TensorRT 使用量化感知训练(QAT)和训练后量化(PTQ)提供 INT8,并为部署深度学习推理应用程序提供 浮点16(FP16)优化,如视频流、推荐、欺诈检测和自然语言处理。降低精度推理大大减少了延迟,这是许多实时服务以及自主和嵌入式应用程序所必需的。

2.4 使用 Triton 进行部署、运行和扩展

TensorRT 优化的模型可以通过 NVIDIA Triton™ 进行部署、运行和扩展,Triton™是开源推理服务软件,将 TensorRT 作为其后端之一。使用 Triton 的优势包括具有动态批处理和并发模型执行的高吞吐量,以及模型集成、流式音频/视频输入等功能。

3. NVIDIA TensorRT 大型语言模型的推理

NVIDIA TensorRT-LLM 深度学习加速器:NVIDIA TensorRT-LLM 是一个开源库,可加速和优化最新大型语言模型(LLM)在 NVIDIA GPU上的推理性能。它允许开发人员试验新的 LLM,提供光速般的性能和快速定制,而无需深入了解 C++ 或 CUDA。

TensorRT-LLM 将 TensorRT 的深度学习编译器包装在一个简单的开源 Python API 中,其中包括来自 FasterTransformer、预处理和后处理以及多 GPU 和多节点通信的优化内核,用于在生产中定义、优化和执行用于推理的 LLM。

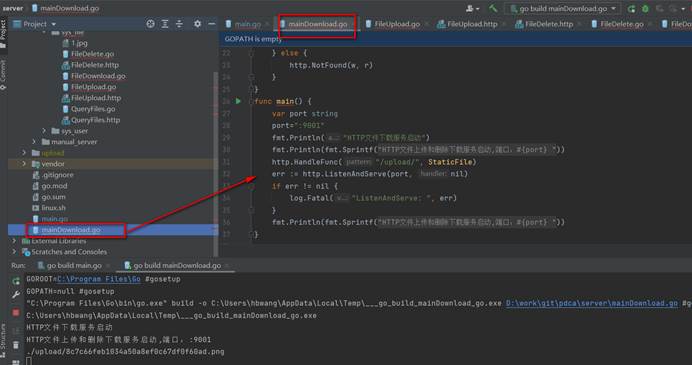

4. NVIDIA TensorRT 的使用方法

下载容器、代码和版本:TensorRT 在多个不同平台上作为二进制文件提供,或者在 NVIDIA NGC™ 上作为容器提供。TensorRT 还集成到用于 PyTorch、TensorFlow 和 Triton 推理服务器的 NGC 容器中。

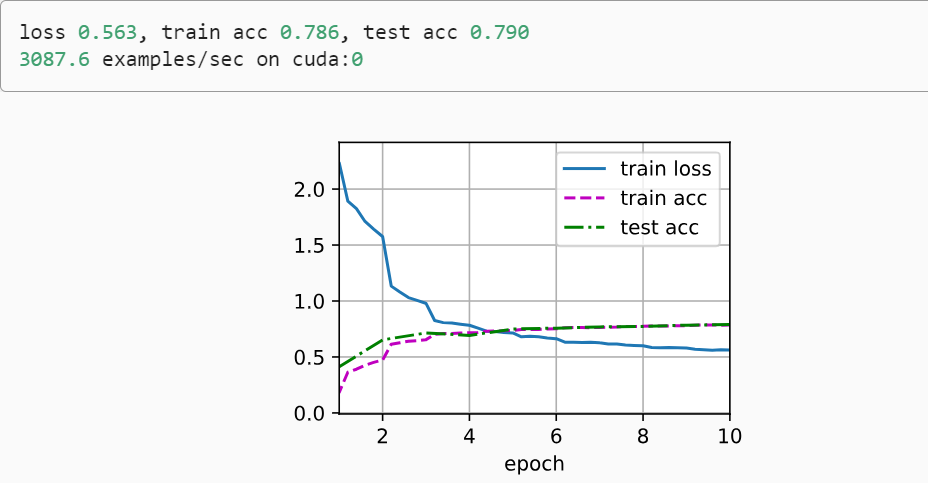

5. NVIDIA TensorRT 世界领先的推理性能

在 MLPerf 推理的行业标准基准测试中,TensorRT 助力 NVIDIA 取得所有性能测试的胜利。TensorRT-LLM 加速了生成 AI 的最新大型语言模型,性能提高了 8 倍,TCO 提高了 5.3 倍,能耗降低了近 6 倍。

6. NVIDIA TensorRT 加速每个推理平台

TensorRT 可以优化应用程序并将其部署到数据中心以及嵌入式和汽车环境中。它为 NVIDIA 的关键解决方案提供支持,如 NVIDIA TAO、NVIDIA DRIVE™、NVIDIA Clara™ 和 NVIDIA Jetpack™。

TensorRT 还集成了特定应用的 SDK,如 NVIDIA DeepStream、NVIDIA Riva、NVIDIA Merlin™、NVIDIA Maxine™、NVIDIA Morpheus 和 NVIDIA Broadcast Engine,为开发人员提供统一的路径,以部署智能视频分析、语音 AI、推荐系统、视频会议、基于 AI 的网络安全和生产中的流媒体应用程序。

7. NVIDIA TensorRT 支持主要框架

TensorRT 与 PyTorch 和 TensorFlow 集成在一起,因此您可以使用一行代码实现 6 倍的推理速度。如果您正在专有或自定义框架中执行深度学习培训,请使用TensorRT C++API导入并加速您的模型。在 TensorRT 文档中内容。

下面是一些关于如何开始的整合信息。

7.1 PyTorch

使用新的Torch-TensorRT集成,只需一行代码即可加速PyTorch模型。在熟悉的PyTorch环境中使用TensorRT优化,使推理速度提高6倍。

7.2 TensorFlow

TensorRT和TensorFlow紧密集成,因此您可以在TensorFlow中获得TensorRT的强大优化功能,例如使用一行代码实现6倍的性能提升。

7.3 ONNX

TensorRT 提供了一个 ONNX 解析器,因此您可以轻松地将 ONNX 模型从流行框架导入 TensorRT。它还与 ONNX Runtime 集成,提供了一种在 ONNX 格式中实现高性能推理的简便方法。

7.4 Matlab

MATLAB 通过 GPU Coder 与 TensorRT 集成,因此您可以为 NVIDIA Jetson™、NVIDIA DRIVE® 和数据中心平台自动生成高性能推理引擎。