B站链接

https://www.bilibili.com/video/BV13a4y1J7bw?p=1&vd_source=6f43d02eb274352809b90e8cdf744905

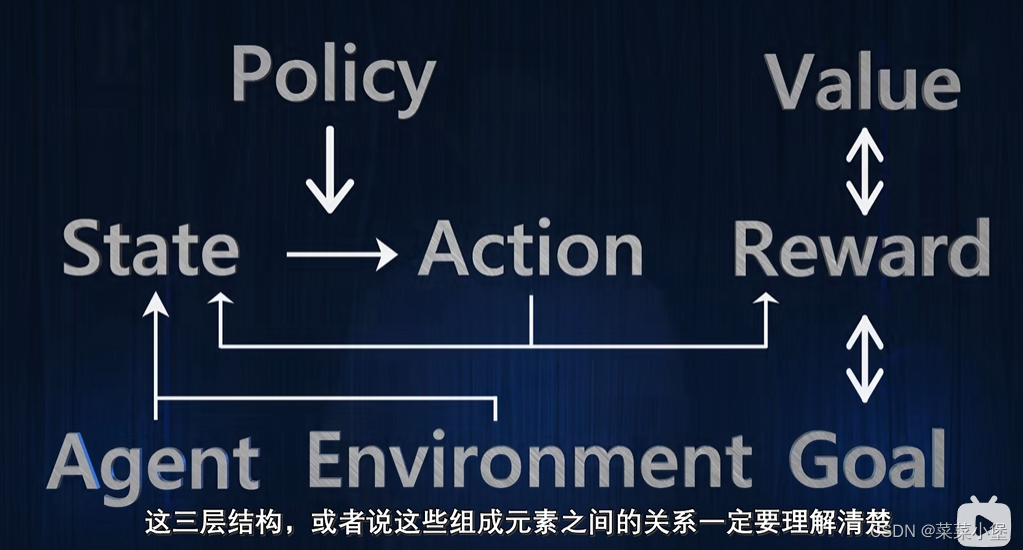

agent----------environment--------goal

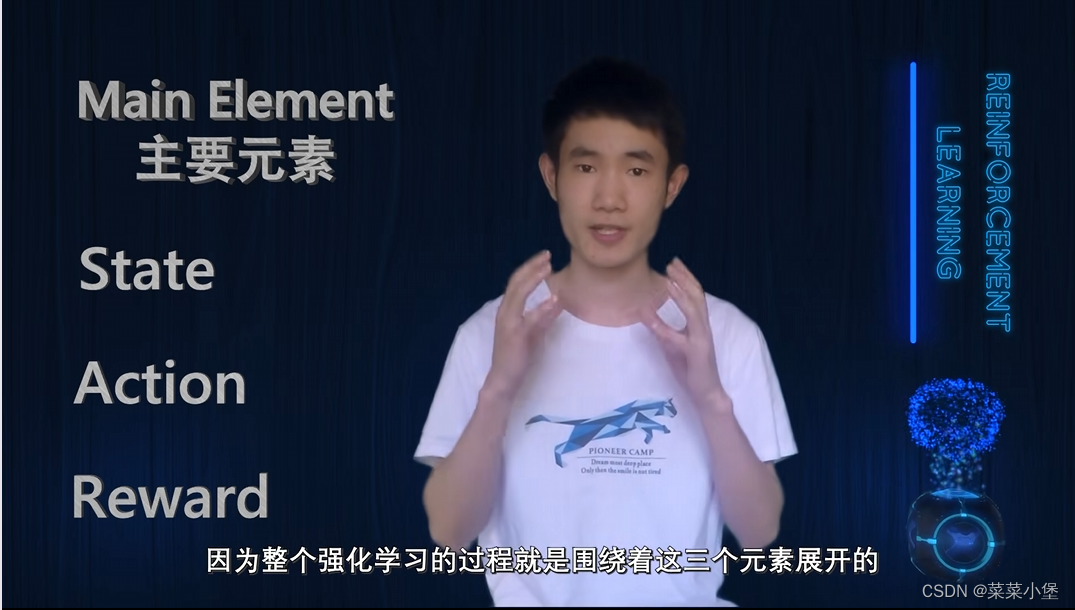

State 状态

Action 行动

Reward奖励

是一个及时的反馈

目标是一个长远的结果

Core element👇

Policy 策略

当前需要决定的行动策略,policy依赖于value,可以理解为,policy输入的是state,输出是action

Value 价值

state-value函数

state-action-value函数

try_and_error delay_reward exploration exploitation

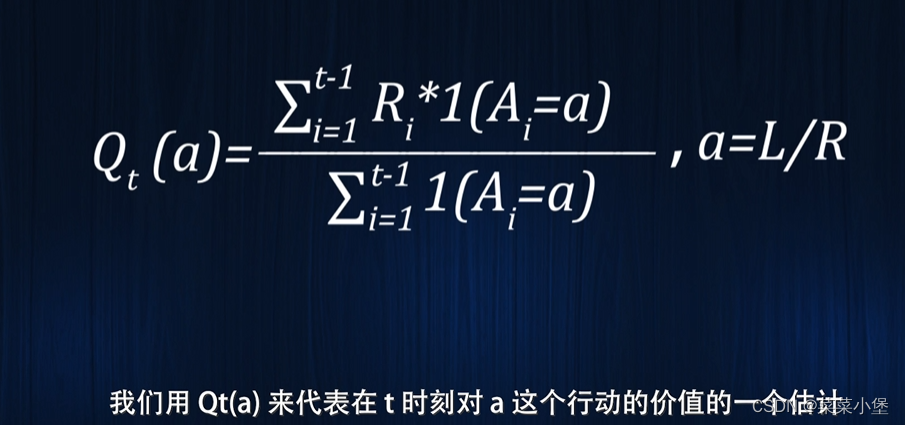

a = L(left)/R(right)

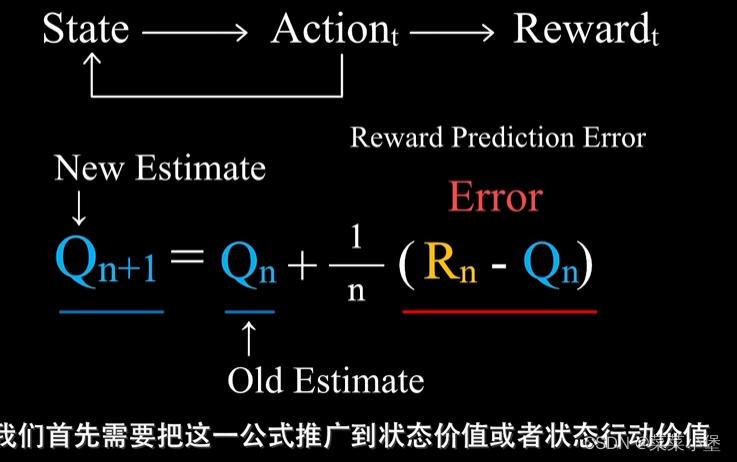

以上的Q可以理解是t时刻时进行行动a的价值函数。

选择action时,要选择在此刻t的Q(a_i)的最大值。

Q

n

+

1

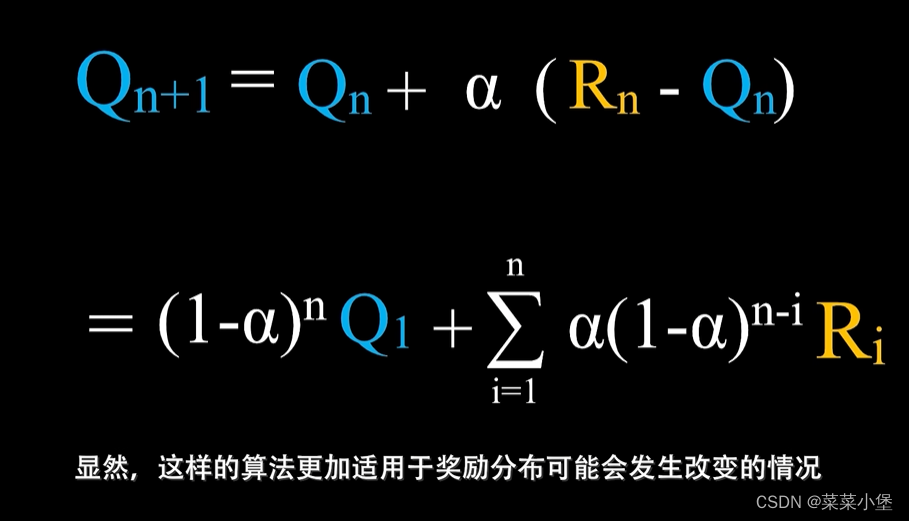

Q_n+1

Qn+1是第n+1次行动的估计价值,

R

n

R_n

Rn是第n次行动的真实价值。1/n为步长。适用于没有延迟奖励👆且只有一个状态的情况

👆这个函数更受最近的action的影响,所以可能更适合奖励机制。

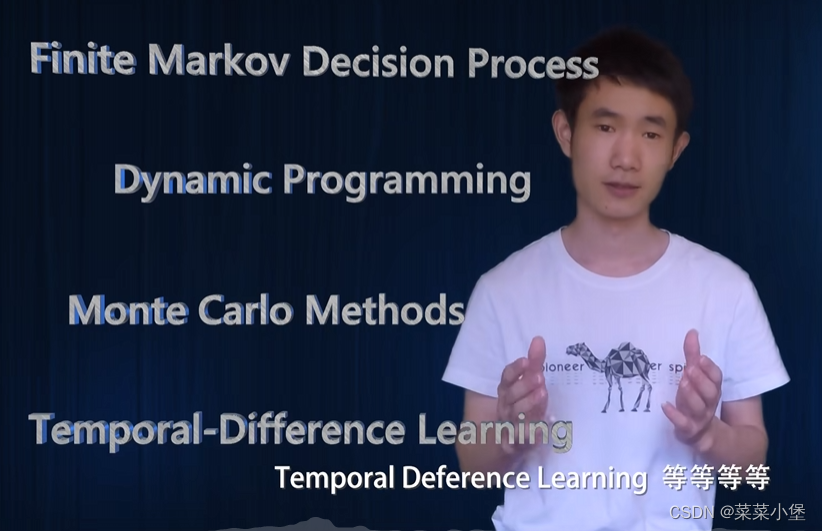

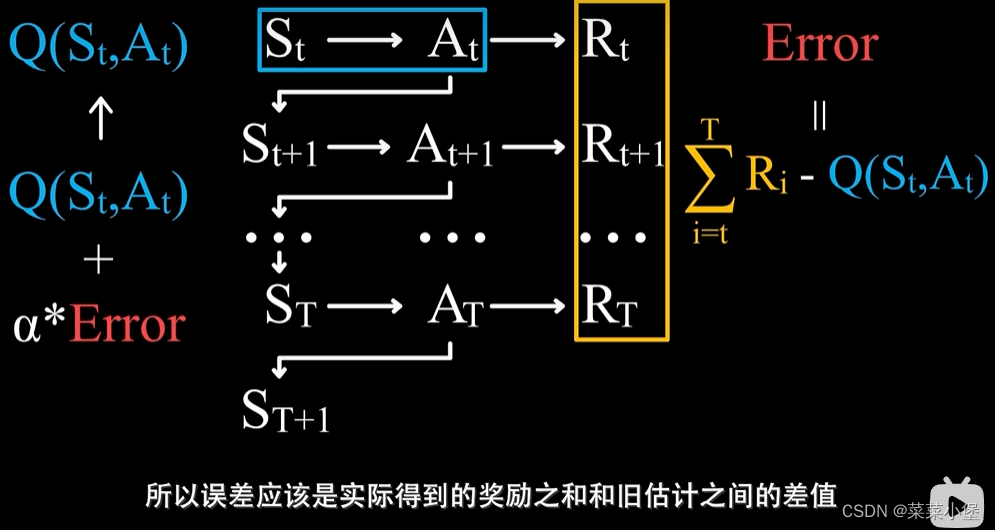

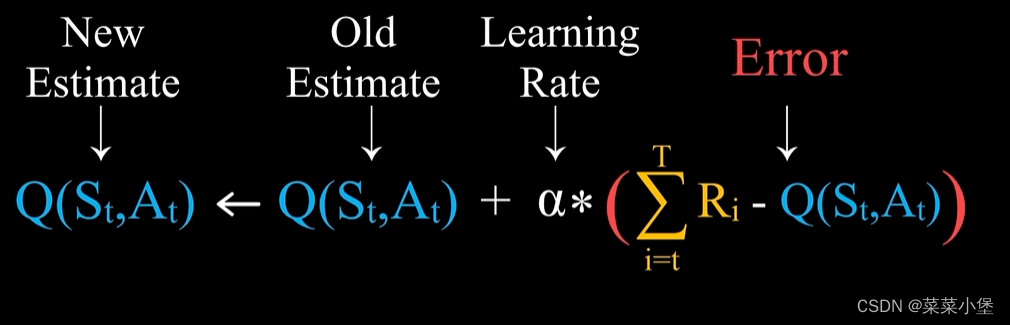

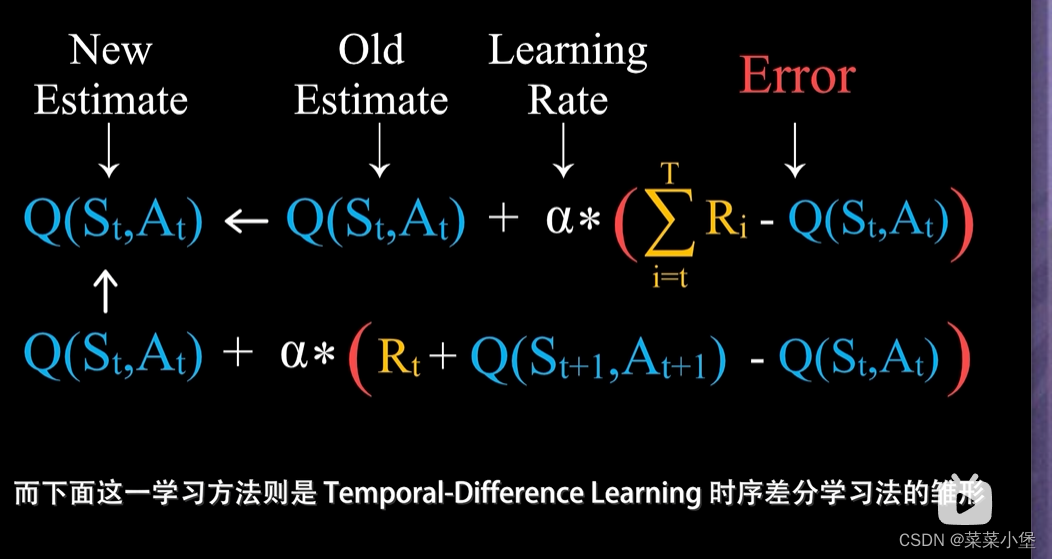

MC Method 和 Tempportal-Difference Learning分别类似于👇俩公式

MC method就是用随机性来模拟状态值。

Tempportal-Difference Learning。

![[Model.py 02] 地图按比例放大的实现](https://img-blog.csdnimg.cn/4f2f992e641941e4b47d5d83a0e993ec.png#pic_center)