今天,由云原生计算基金会 CNCF 主办的 KubeCon+CloudNativeCon+OpenSourceSummit China 2023 主论坛在上海举办。阿里云容器服务负责人易立在主论坛发表演讲,介绍阿里云为大模型提供的基础设施能力,以及通过云原生 AI 的方式助力大模型普惠提效。

易立在主论坛现场演讲

大模型无疑是 AI 领域最重要的进展之一,生成式 AI 的惊艳表现让关于下一代人工智能“魔力”的讨论进入街头巷尾,也让云计算的行业价值和技术核心迎来再次升级。易立认为, “规模”、“性能”和 “效率” 正在成为影响大模型生产和应用的三个核心因素,也是企业基础设施在面临生产、使用大模型时的全新挑战。“为了应对这些挑战,我们需要算法突破,也需要工程创新”,易立表示。

而解决规模、性能、效率的问题,需要与社区共同探索与突破。多年来,阿里云积极参与云原生社区生态建设,推动云原生 AI 应用更高效地运行在 Kubernetes 上,包括向 CNCF 捐献云原生数据集编排与加速项目 Fluid,以及 AI 工作负载管理框架 KubeDL 等;推动 Kubernetes Scheduler Framework 以更原生的方式支持 AI 工作负载。例如,OpenAI 在其大规模训练集群中使用了阿里云开源贡献的 Coscheduling 调度插件,大幅优化了资源分配效率。

易立介绍,“在支持企业大模型AI创新过程中我们发现,如何有效地管理 AI、大数据任务及其对异构算力资源的调度,是当前面临的新挑战。”

为了让企业以统一的方式支持微服务、大数据、AI 应用等多样化工作负载,阿里云开源了云原生调度系统 Koordinator。它是基于阿里巴巴大规模调度实践孵化出的开源 Kubernetes 调度器实现。在开源近1年半的时间里,Koordinator 已被小红书、小米、360、爱奇艺等多家企业应用于生产环境。“我们正在推进 Koordinator 捐赠到 CNCF 基金会,保持项目长期健康地发展。”易立介绍。

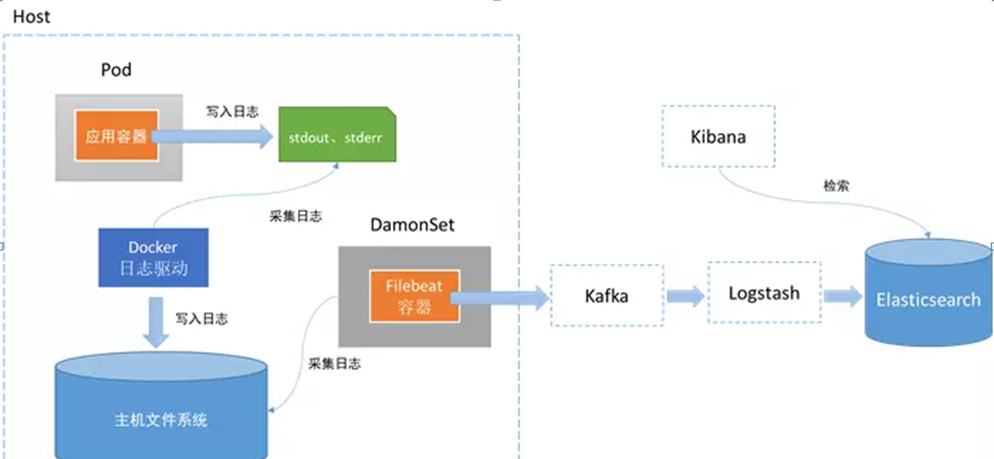

除了调度优化方面的工作,阿里云容器服务 ACK 和云原生 AI 套件构建了包含 GPU/NPU 高效运维、AI 作业管理、数据集访问加速、弹性训练与推理等完整的AI基础设施能力,在此之上既支撑了阿里云 PAI、灵骏智算、通义千问、妙鸭等 AI 平台与服务,也支持了多种开源 AI 框架和大模型方案。 这些产品化的技术能力已被广泛应用于任意门、小米、Recruit 等海内外企业,帮助客户快速构建自己的 AI 系统,显著提升 GPU 资源效率和 AI 工程效率。

此外,如何有效运用大模型,将 AIGC 技术在各行业落地,成为行业关注焦点。发展开源生态是降低大模型应用使用门槛、推动人工智能技术普惠的必由之路。

阿里云是开源的受益者,也是积极贡献者,此前阿里云公布全新的 1+4 开源战略,持续投入 AI、云原生、数据库、大数据、操作系统等领域的开源工作,持续提升开发者服务和企业创新支持,为开源创新提速。 易立表示:“开源社区就像一个神经网络,我们每个人都是其中一个神经元,紧密相连、互相协作。只有不断地连接、贡献、反馈,开源生态才能释放出无限的潜能与创新。”

当前,阿里云已经形成了基础设施即服务(IaaS)、平台即服务(PaaS)和模型即服务(MaaS)三层架构,可为企业提供从大模型训练到推理、服务的端到端解决方案。以模型为中心的开发范式已成为新趋势,而云计算是 AI 普及和普惠的最好选择。未来基于云计算技术,以基础大模型为底座,将会推动全行业智能化升级。

现场精彩速递 DAY2

![[计算机提升] 用户和用户组](https://img-blog.csdnimg.cn/fe1b6e3065cb4bcd88a855cc5969b41a.png)