Softmax激活函数是一种用于多类别分类问题的激活函数,通常用于神经网络的输出层。它将原始分数(也称为logits)转换为表示概率分布的数值,使得每个类别的概率值都在0和1之间,并且所有类别的概率之和等于1。这使得它适用于多类别分类问题,其中每个样本只能属于一个类别。

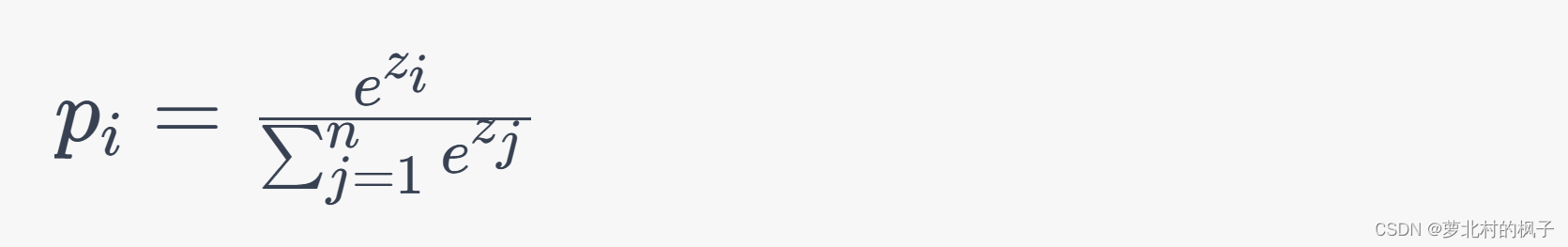

Softmax函数的数学定义如下:

对于给定的原始分数(logits)z = [z1, z2, …, zn],Softmax函数将这些分数转换为概率分布p = [p1, p2, …, pn]

其中,e表示自然对数的底(欧拉数),n表示类别的数量,zi是第i个类别的原始分数。

Softmax函数的特点包括:

(1)将输入映射到0和1之间:Softmax函数确保每个类别的概率在0和1之间,因此可以用来表示每个类别的相对权重。

(2)归一化:Softmax函数对原始分数进行归一化,使所有类别的概率之和为1,这使得它适用于多类别互斥的分类问题。

(3)放大差异:Softmax函数会放大具有更高原始分数的类别的概率,因此可以更好地区分不同类别的可能性。

Softmax激活函数通常用于神经网络的输出层,特别是在多类别分类任务中,如图像分类、文本分类和语音识别。在训练过程中,Softmax函数的输出与实际的类别标签之间的差异通常使用交叉熵损失函数来度量,以便调整网络参数以最小化损失。

本文主要包括以下内容:

- 1. nn.ReLU的常见用法

- 2. ReLU激活函数图像实现

1. nn.ReLU的常见用法

在深度学习框架中,如PyTorch、TensorFlow或Keras,通常有内置的softmax函数,可用于计算Softmax激活函数的输出。下面是使用PyTorch作为示例的一些关于如何使用nn.softmax函数的说明:

import torch

import torch.nn as nn

# 假设有原始分数 logits

logits = torch.tensor([3.0, 2.0, 1.0])

# 创建一个Softmax模块

softmax = nn.Softmax(dim=0)

# 使用Softmax模块来计算Softmax激活

softmax_output = softmax(logits)

# 输出Softmax激活后的结果

print(softmax_output)

#输出结果:

#tensor([0.6652, 0.2447, 0.0900])

接下来我们再用普通的方法验算一下:

import math

result3 = math.exp(3)

result2 = math.exp(2)

result1 = math.exp(1)

print(result3)

print(result2)

print(result1)

r=result3+result2+result1

r1=result3/r

r2=result2/r

r3=result1/r

print([(r1),(r2),(r3)])

#输出结果:

#result3: 20.085536923187668

#result2: 7.38905609893065

#result1: 2.718281828459045

#[0.6652409557748219, 0.24472847105479764, 0.09003057317038045]

#与上面的代码运行结果相同

上述代码演示了如何使用PyTorch中的nn.Softmax模块来计算Softmax激活。需要注意以下几点:

(1)首先,导入PyTorch库以及nn模块。

(2)创建一个包含原始分数(logits)的张量(上述示例中logits的数据是示例数据,你可以用你自己的实际数据替代)。

(3)创建一个Softmax模块,使用nn.Softmax,并通过dim参数指定在哪个维度上进行Softmax操作。通常,dim=0表示在第一个维度(通常是类别维度)上应用Softmax操作。

(4)使用Softmax模块来计算Softmax激活,将原始分数作为输入。

(5)最后,输出Softmax激活后的结果。

请注意,不同的深度学习框架可能有略微不同的用法,但通常都会提供类似的Softmax函数来执行这个任务。在TensorFlow中,你可以使用tf.nn.softmax函数来执行类似的操作,而在Keras中,你可以使用keras.layers.Softmax层。确保查看你使用的特定框架的文档以了解更多细节。

2. ReLU激活函数图像实现

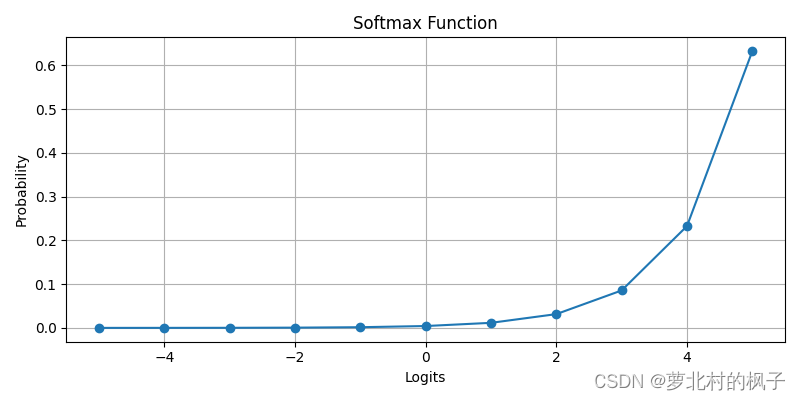

我们可以使用Python的matplotlib库来绘制Softmax函数的图像。下面是一个示例代码,它演示了如何绘制Softmax函数的图像:

import numpy as np

import matplotlib.pyplot as plt

def softmax(logits):

exp_logits = np.exp(logits)

softmax_output = exp_logits / np.sum(exp_logits)

return softmax_output

# 生成一组原始分数(logits)

logits = np.arange(-5, 6, 1)

# 计算Softmax激活

softmax_output = softmax(logits)

# 绘制Softmax函数图像

plt.figure(figsize=(8, 4))

plt.plot(logits, softmax_output, marker='o', linestyle='-')

plt.title('Softmax Function')

plt.xlabel('Logits')

plt.ylabel('Probability')

plt.grid(True)

plt.show()

运行此段代码,即可得到softmax激活函数的输出图像

这段代码首先定义了一个softmax函数,该函数接受原始分数(logits)作为输入,并返回Softmax激活后的概率分布。然后,它创建了一个示例的logits数组,计算Softmax输出,并使用Matplotlib库绘制Softmax函数的图像。

在图像中,x轴表示类别,y轴表示对应类别的概率。你可以根据需要更改logits数组的值,以查看不同输入情况下Softmax函数的输出。

运行上述代码后,我们将看到一个简单的条形图,显示了Softmax函数的输出,其中概率随输入的不同而变化。