参考李宏毅老师的视频 https://www.bilibili.com/video/BV1LP411b7zS?p=2&spm_id_from=pageDriver&vd_source=c67a2725ac3ca01c38eb3916d221e708

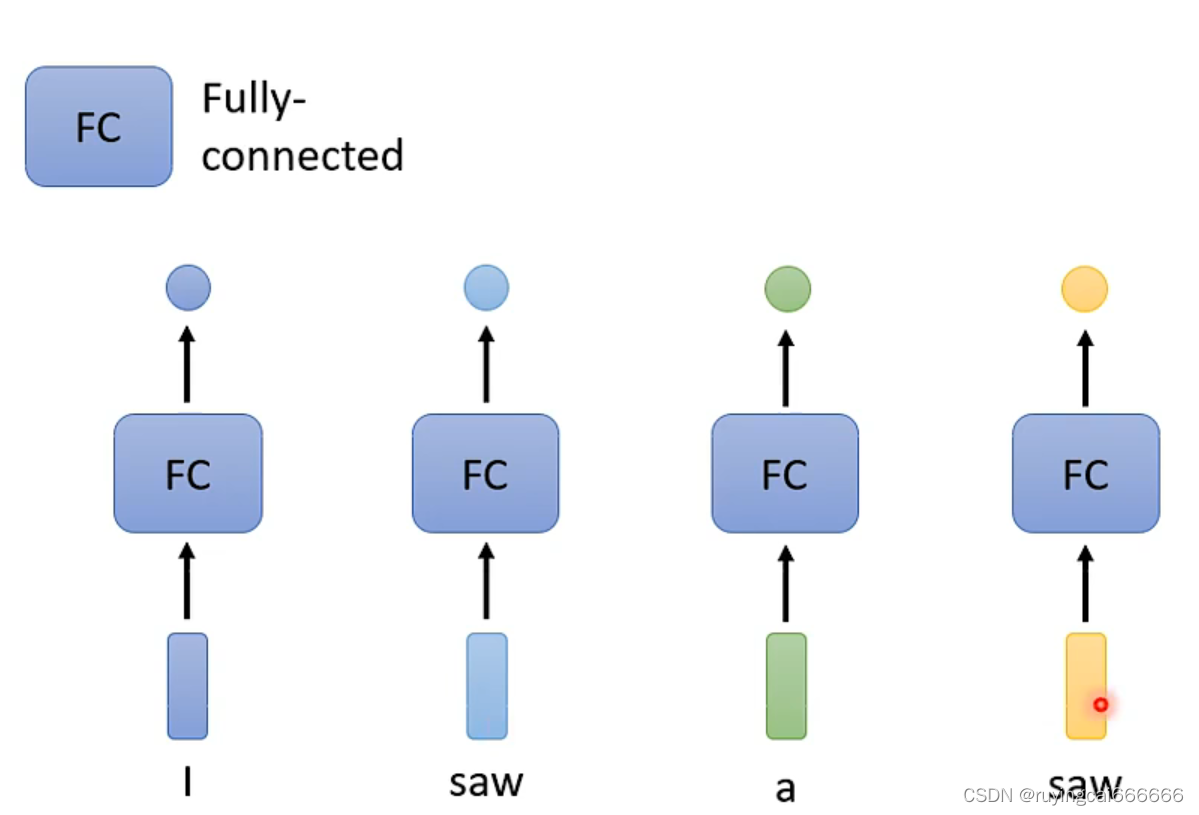

一个输入,一个输出,未考虑输入之间的关系!!!

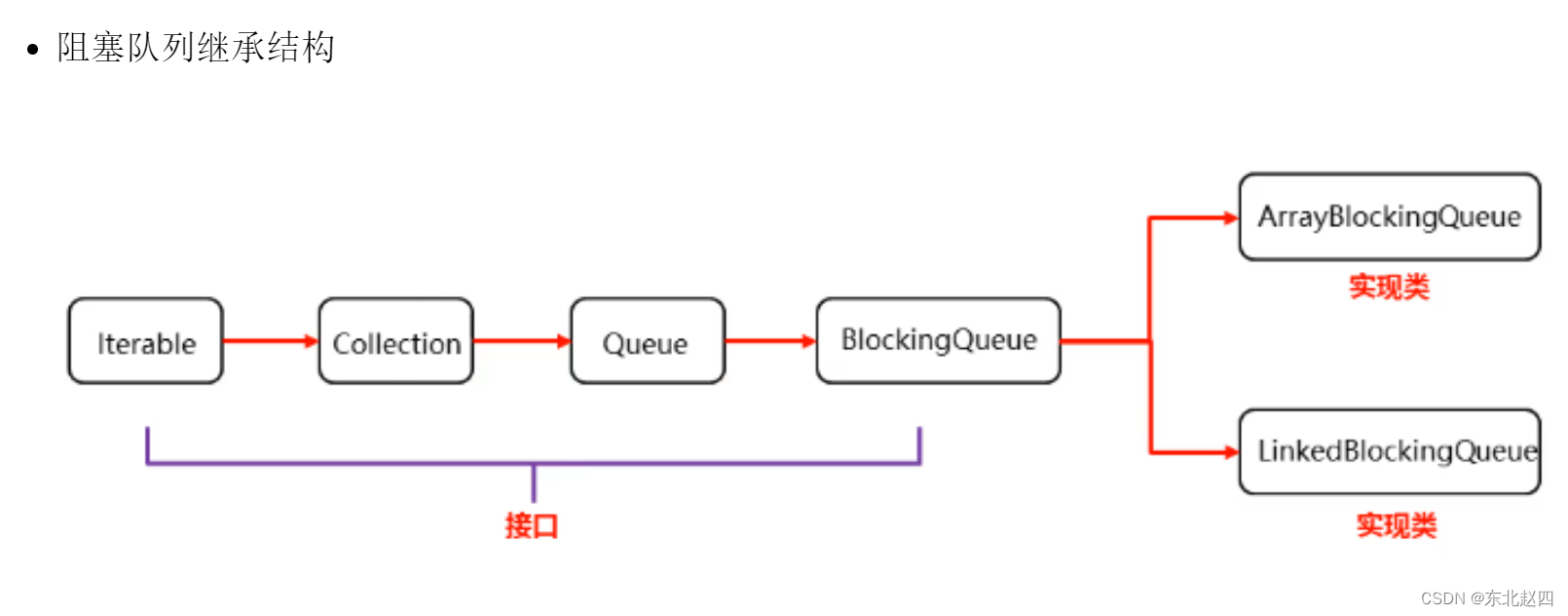

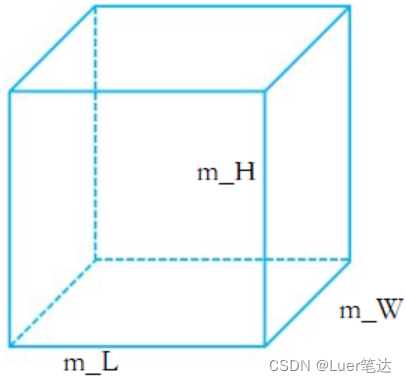

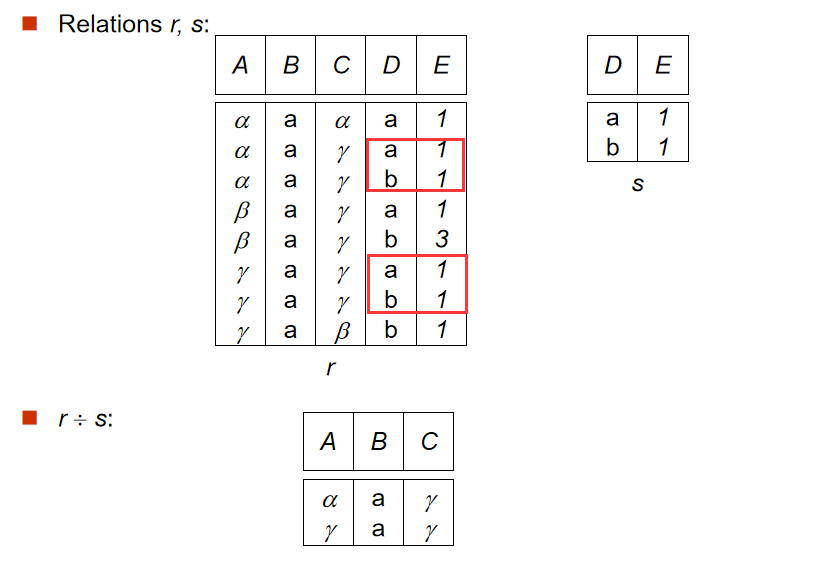

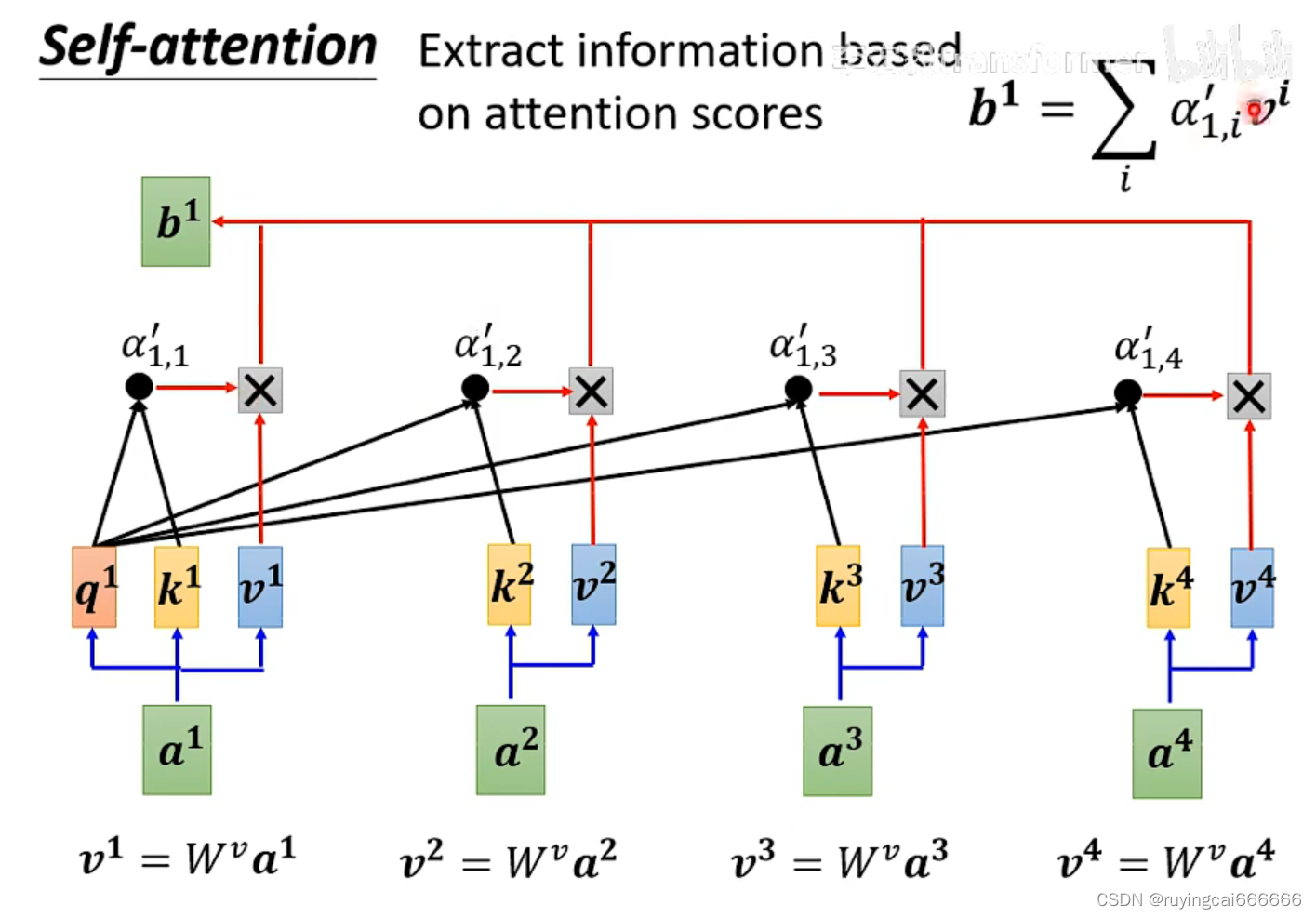

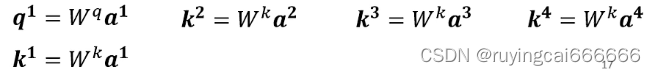

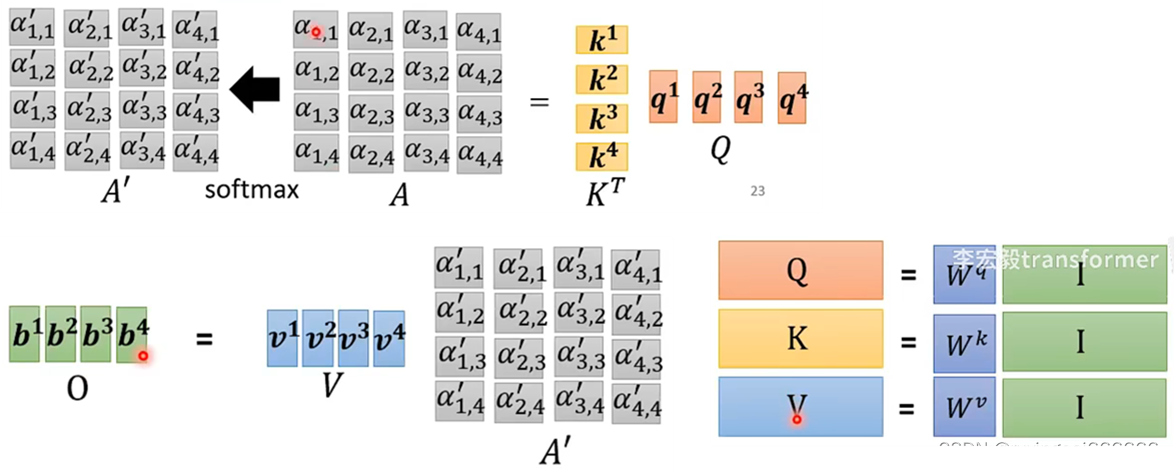

self-attention考虑输入之间的关系,关于a1的输出b1的计算方法如上图所示,如此类推计算b2,b3,b4,合并考虑整体计算公式如下图所示,就是找出Wq,Wk和Wv。

multi-head attention:

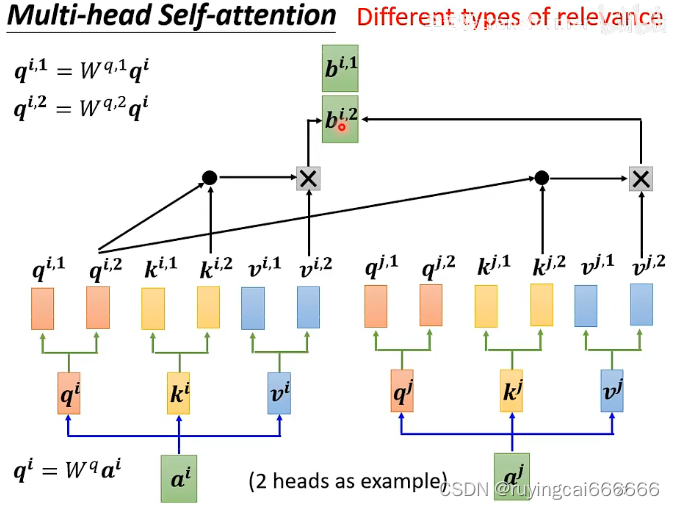

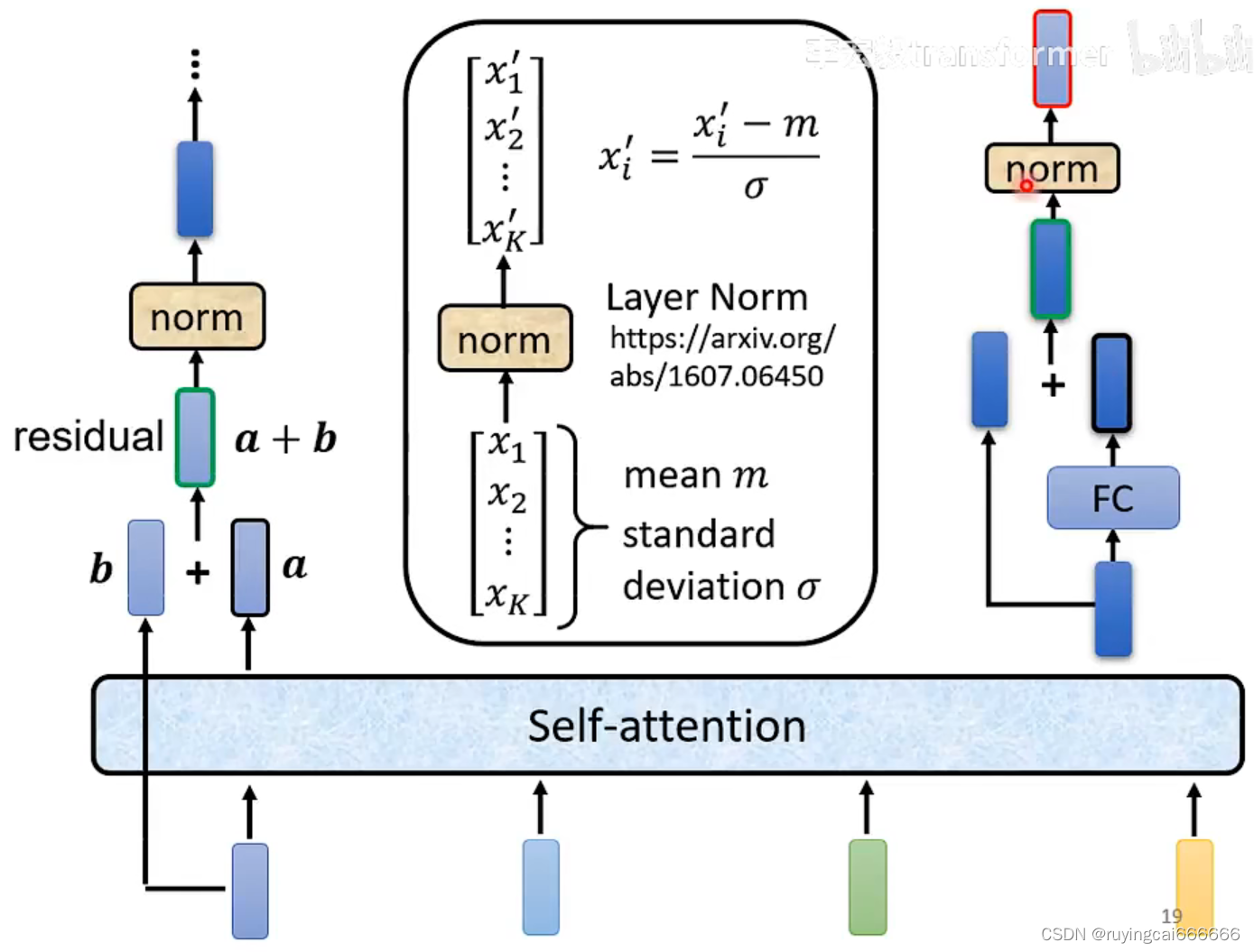

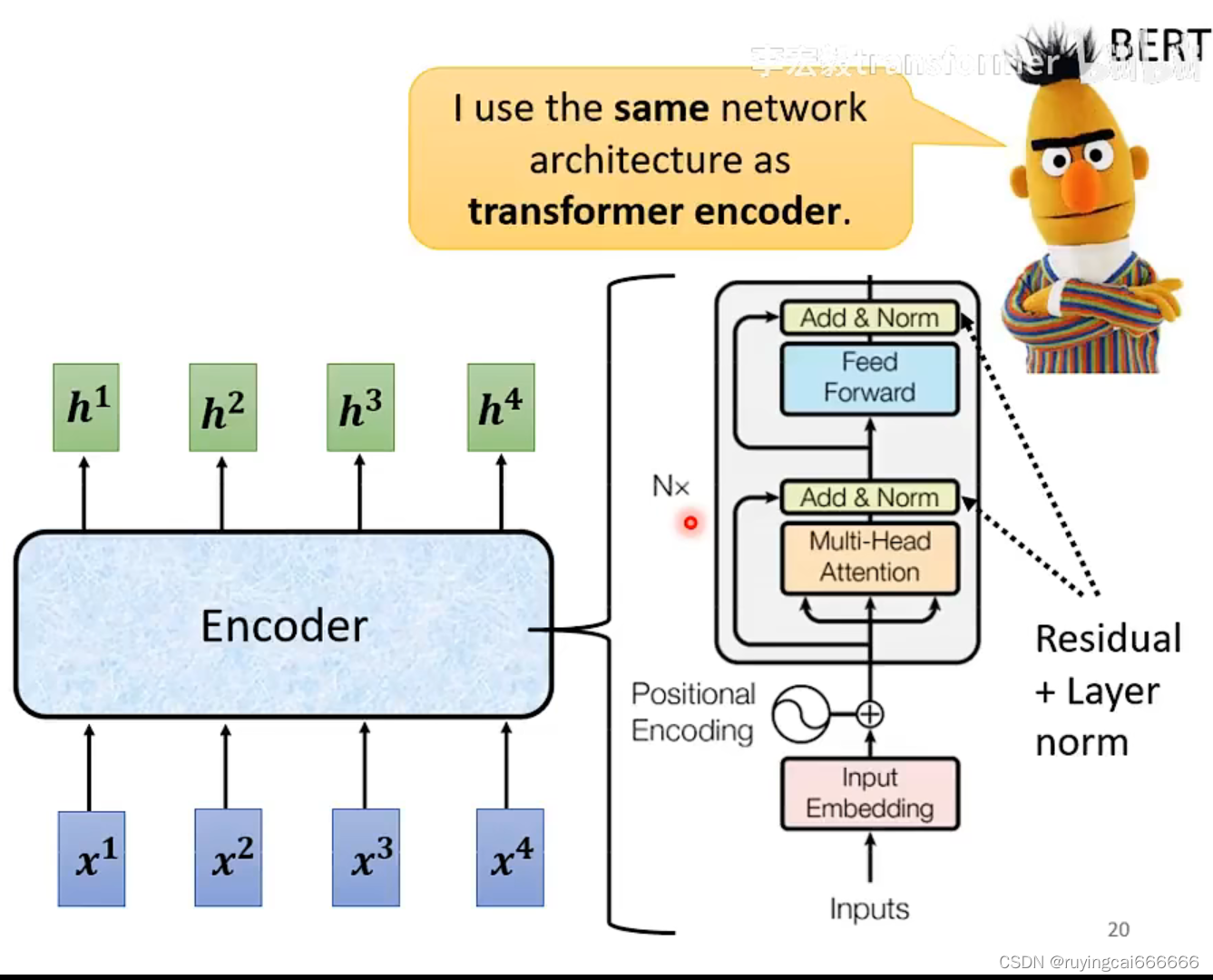

transformer:

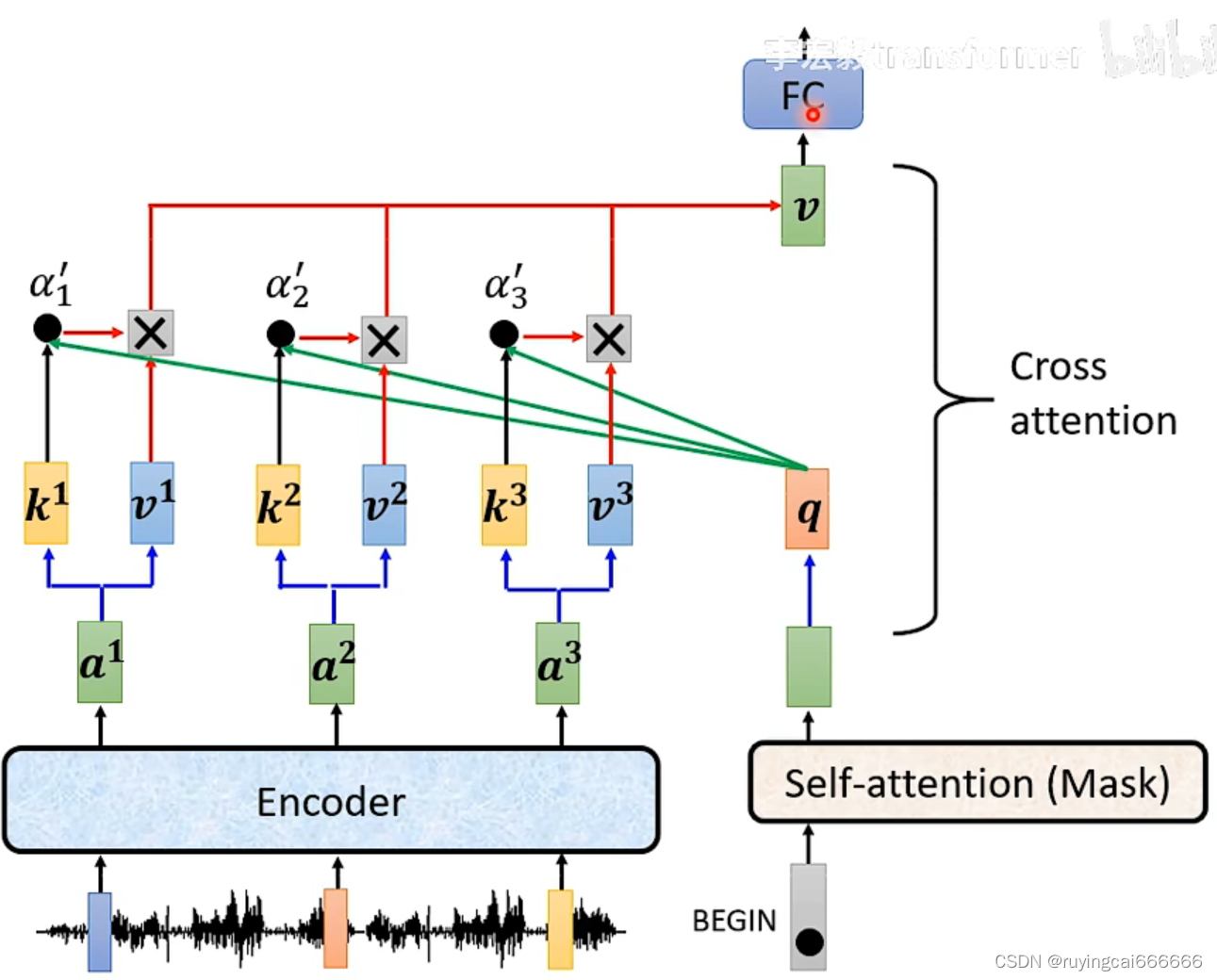

cross attention: