Hugging Face Transformers 是一个用于自然语言处理(NLP)的开源库,提供了各种预训练模型。这些模型被广泛应用于各种任务,如文本分类、命名实体识别、问答、文本生成等。Transformers库易于使用,可方便地集成到现有的深度学习框架,如PyTorch和TensorFlow,让研究人员和开发者更容易下载和应用NLP预训练模型,如BERT、GPT-2、XLNet等,降低使用门槛。极大推动了NLP领域模型的开发和应用,被誉为NLP界的“ImageNet”,让更多人参与其中。

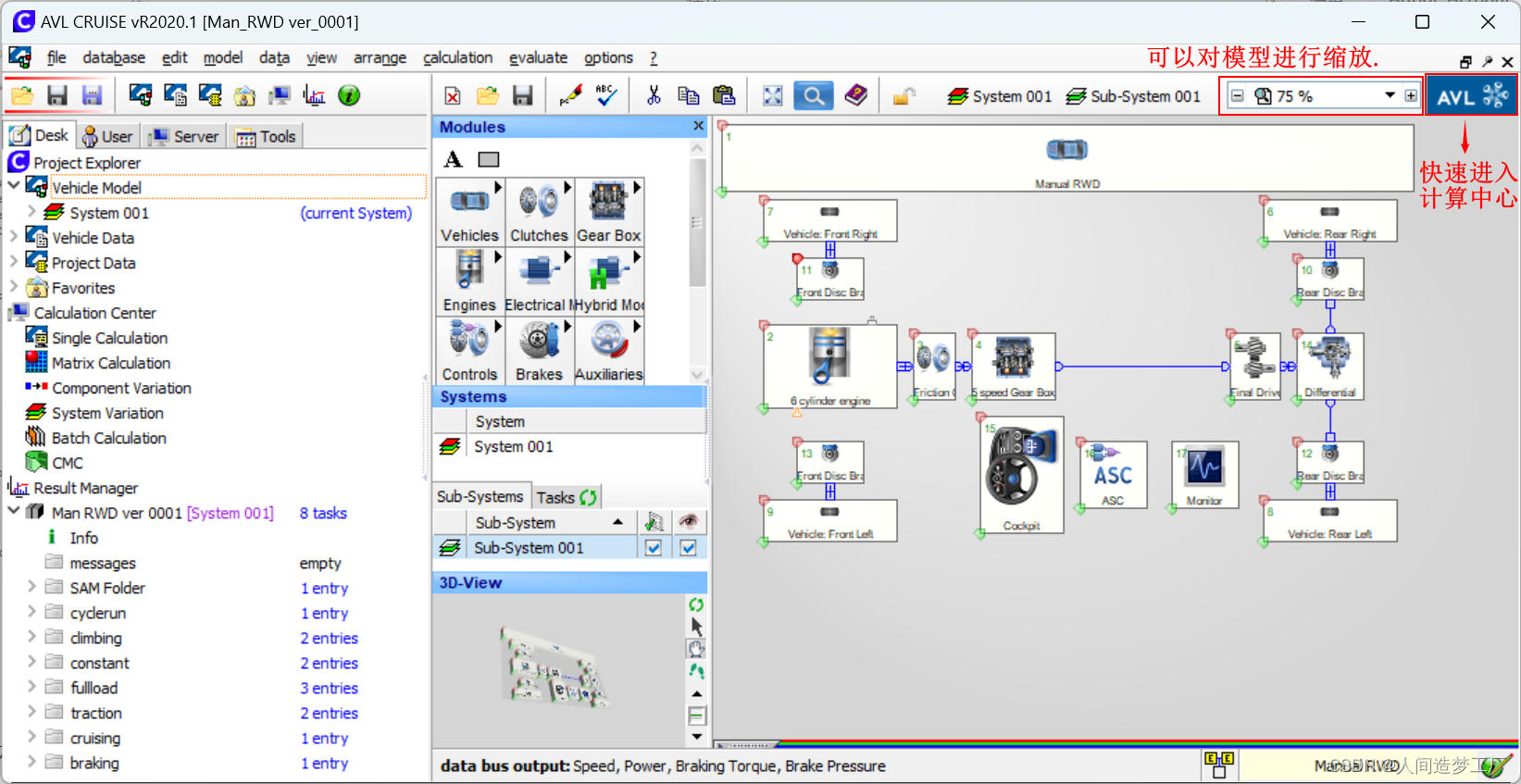

Coovally作为一个包含完整AI建模流程、AI项目管理及AI系统部署管理的机器学习平台,现支持图像、文本、表格、时间序列等不同类型数据的深度学习和应用,快速实现机器学习。实现目标检测、图像分割、文本分类、多模态建模等12小类任务类型微调与应用。

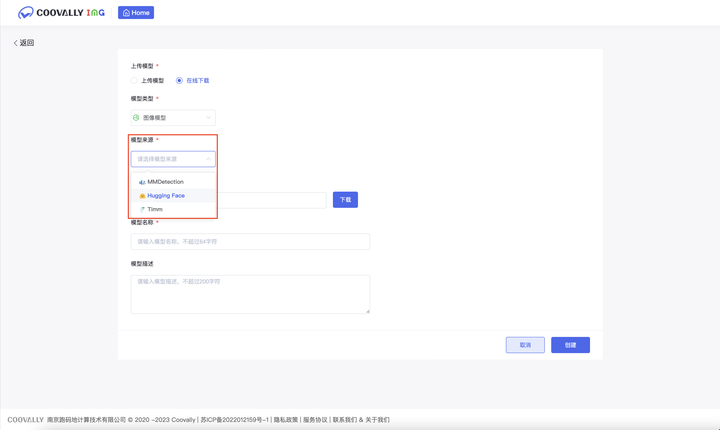

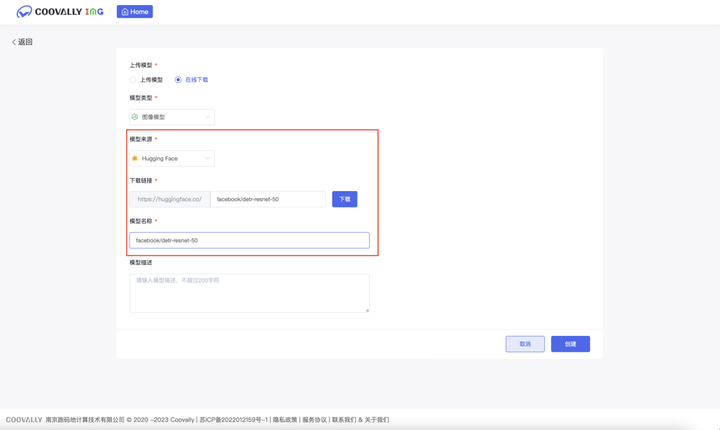

在模型创建中,系统不仅支持用户上传本地模型文件创建模型,同时也支持用户一键下载和部署开源社区模型并集成应用(*目前支持Hugging Face, TIMM以及MMDetection开源模型)。

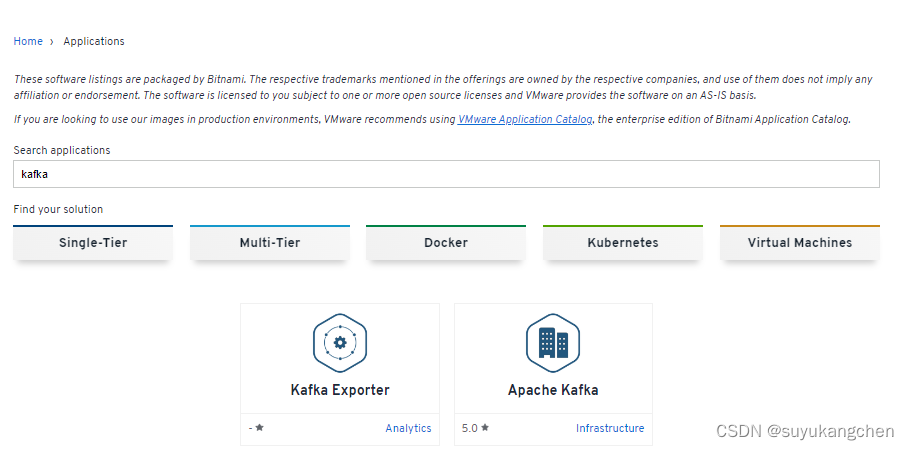

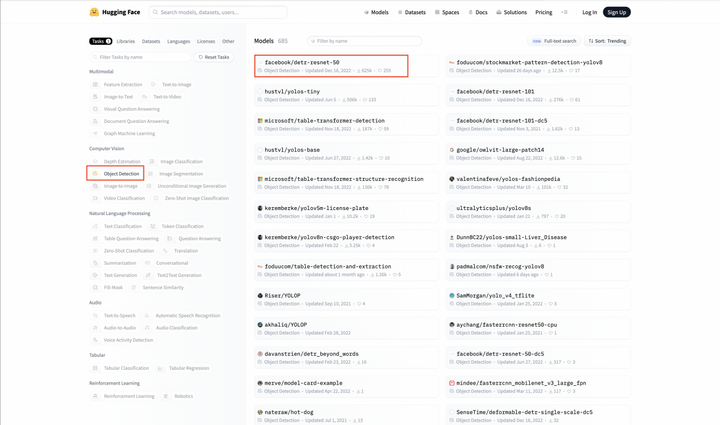

以Hugging Face为例,在其网站选择模型类型,复制模型名称

以目标检测为例

在Coovally官网进入“模型探索”页面

新建极速任务,选择任务类型后,点击上传模型,选择在线下载,粘贴下载链接与模型名称,模型下载完成后并上传/选择数据集即可创建任务。

Coovally平台新增“模型探索”功能,用户可轻松获取Hugging Face Transformers系列预训练模型,直接应用于自然语言处理项目,体验模型下载与应用的简单高效。