第一讲:认识GPT

GPT的全称:Generative Pre-trained Transformer——生成式 预训练 变换模型

GPT(Generative Pre-trained Transformer)是一种基于Transformer架构的大型语言模型。它由OpenAI开发,并在不同版本中不断改进和扩展。

GPT的训练方法是通过大规模的无监督学习,使用大量的文本数据进行预训练。在预训练阶段,模型通过自我预测下一个单词的任务来学习语言的统计规律和上下文关系。这使得模型能够捕捉到丰富的语义和语法知识。

GPT模型的核心是Transformer架构,它是一种基于自注意力机制的神经网络结构。Transformer能够同时处理输入序列中的所有位置,并且能够捕捉到不同位置之间的依赖关系。这种架构使得GPT能够在生成文本时具有较长的上下文记忆和更好的语义连贯性。

GPT模型在预训练之后,可以通过微调的方式适应特定的任务。微调是指在特定的数据集上对模型进行有监督的训练,以使其能够完成特定的任务,如问答、文本分类、文本生成等。

GPT模型的不断改进和扩展使得其性能不断提升。较新的版本,如GPT-3和GPT-3.5 Turbo,具有更大的模型规模和更强大的语言生成能力。这些模型在多个领域和任务中展示出了出色的表现,并为自然语言处理领域的研究和应用带来了重要的突破。

生成式

在GPT中,生成式(Generative)指的是模型可以生成新的文本,而不仅仅是对给定的输入进行分类或回答。生成式模型具有创造性,可以自主地在训练数据中学到的语言规律和上下文关系的基础上生成全新的文本。

生成式模型的输出通常是一段连贯的文本,可以是一句话、一段段落甚至是一篇文章。模型根据输入的上下文和语义信息,预测并生成符合语法和语义规则的文本。

对于GPT模型而言,生成式任务是其主要的应用之一。通过预训练和微调的过程,GPT学习了大量的语言知识和上下文关系,使其能够生成具有连贯性和多样性的文本回复。用户可以通过与GPT进行对话或提供一些提示,让模型生成适当的回答、故事、问题解答等。

生成式模型的优点之一是其创造性和灵活性,能够生成多样化的文本回复。然而,生成式模型也可能存在一些挑战,如生成不准确、模糊或不合适的回答,需要在使用时进行适当的控制和过滤,以确保生成的文本符合用户的期望和需求。

预训练

预训练(Pretraining)是指在大规模的文本数据上对神经网络模型进行初始训练的过程。在预训练阶段,模型通过学习大量的语言知识和上下文关系,从而获得对语言的理解和生成能力。

在预训练过程中,模型通常使用无监督学习的方法,即在没有标注标签的情况下进行训练。它会尝试通过预测下一个词或缺失的词来学习语言的统计规律和上下文关系。通过处理大量的文本数据,模型可以捕捉到词语之间的关联、句子的结构和语义等信息。

预训练通常使用大规模的语料库,例如互联网上的文本数据,以确保模型能够接触到多样的语言使用情况和语境。这种预训练的方式使得模型具备了广泛的语言知识和表达能力。

在预训练完成后,模型可以被微调(Fine-tuning)以适应特定的任务或应用。微调阶段通常使用有监督学习的方法,即使用带有标注标签的数据对模型进行进一步训练,使其适应特定的任务要求。

预训练的好处在于模型可以利用大规模数据的统计规律和语言结构,从而具备一定的语言理解和生成能力。这使得预训练模型在各种自然语言处理任务中表现出色,并且可以通过微调来适应特定的任务需求。

变换模型

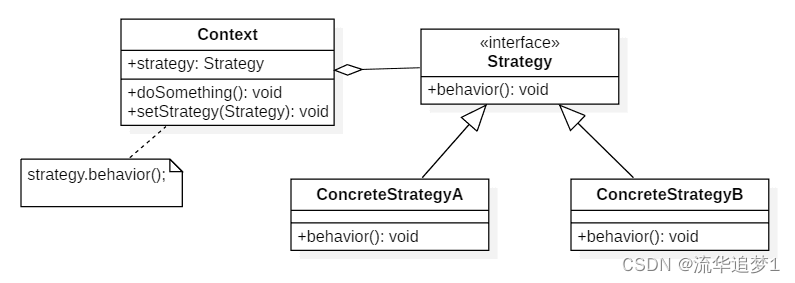

在GPT(Generative Pre-trained Transformer)中,变换模型(Transformer)是指一种基于自注意力机制的神经网络架构。它被广泛应用于自然语言处理任务,如语言生成、机器翻译、文本分类等。

变换模型最初由 Vaswani 等人在2017年的论文《Attention Is All You Need》中提出,并在后续的研究中得到了广泛的应用和改进。

变换模型的核心思想是利用自注意力机制来建立输入序列中各个位置之间的依赖关系。传统的循环神经网络(RNN)在处理长序列时存在梯度消失或梯度爆炸的问题,而变换模型通过自注意力机制可以更好地捕捉到序列中不同位置的相关信息,从而有效地处理长序列。

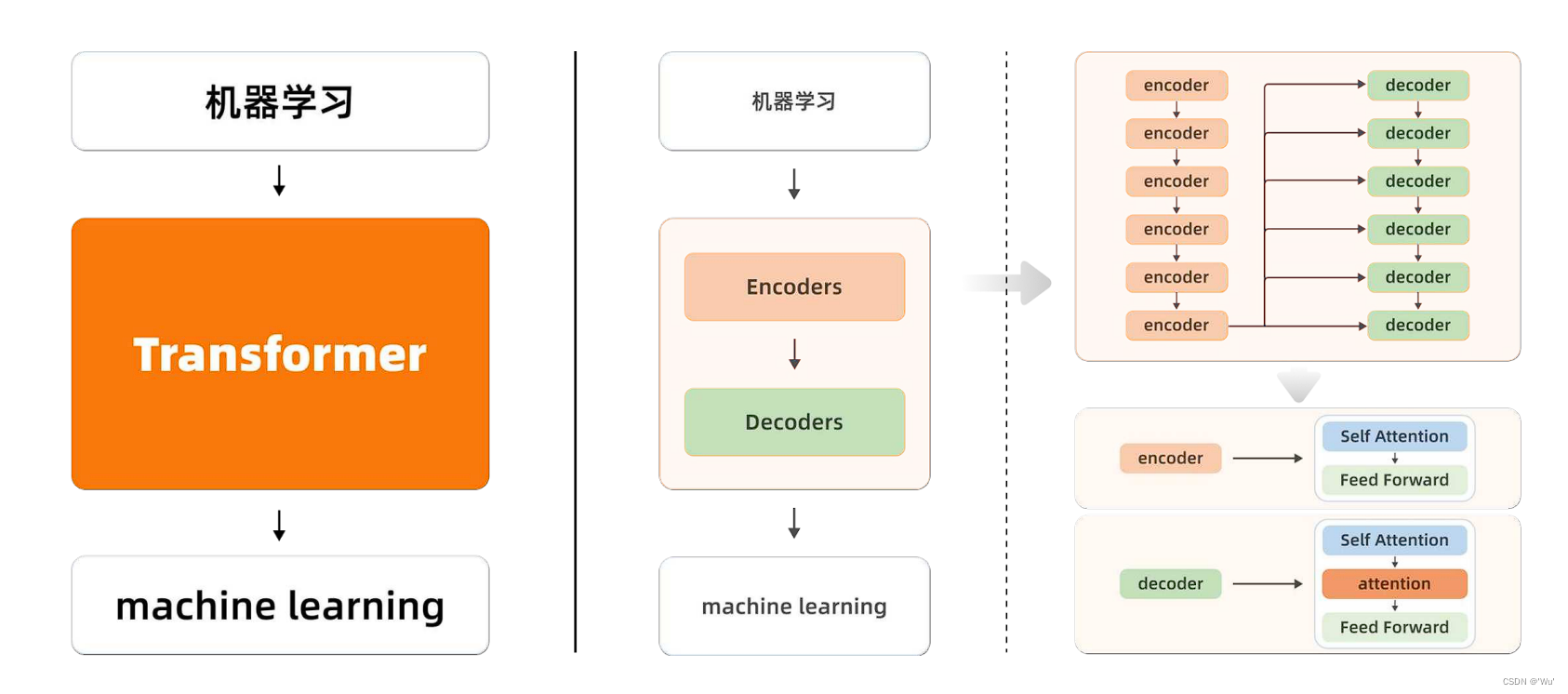

变换模型由多个编码器层和解码器层组成。编码器用于将输入序列转化为一系列高维表示,而解码器则根据编码器的输出和上下文信息生成目标序列。每个编码器和解码器层都包含多个注意力头(attention head),通过对不同位置的注意力进行加权组合,从而实现对序列的全局建模。

变换模型的优点在于并行计算能力强、能够处理长序列、具备建模全局依赖关系的能力,并且通过预训练和微调的方式可以应用于各种自然语言处理任务。GPT系列模型就是基于变换模型构建的,通过预训练和微调的方式,可以生成连贯的文本回复、完成语言理解和生成任务等。

Transformer简单的解释

可以简单的理解它为一个黑盒子,当我们在做文本翻译任务的时候,输入一个中文,经过黑盒子以后,输出来的是翻译好的英文。Transformer不等于预训练模型,不能完全摆脱人工标注数据。模型在质量上更优,更易于并行化,所需要的训练时间明显变少。

监督学习:无监督学习:强化学习

| 监督学习 | 无监督学习 | 强化学习 |

|---|---|---|

| 有标签数据 | 无标签/目标 | 决策过程 |

| 直接反馈 | 无反馈 | 奖励机制 |

| 预测结果/未来 | 寻找数据中隐藏的结构 | 学习一系列的行动 |

什么是注意力机制

注意力机制详解

在GPT(Generative Pre-trained Transformer)中,注意力机制(Attention Mechanism)是一种关键的组成部分,用于建立输入序列中不同位置之间的依赖关系和权重分配。注意力机制使得模型能够更好地理解序列中的上下文信息,并在生成文本或处理其他自然语言处理任务时表现出色。

在变换模型中,注意力机制通过计算查询(Query)、键(Key)和值(Value)之间的相似度来确定不同位置的关注程度。具体而言,注意力机制分为以下几个步骤:

-

查询(Query):通过对输入序列中的某个位置进行线性变换,得到一个查询向量,表示模型希望关注的内容。

-

键(Key)和值(Value):同样对输入序列中的每个位置进行线性变换,得到键向量和值向量。键向量用于计算查询与其他位置之间的相似度,而值向量则包含了位置的信息。

-

相似度计算:通过计算查询向量和每个位置的键向量之间的相似度,得到一个相似度分数。常用的相似度计算方法包括点积注意力(Dot-Product Attention)和缩放点积注意力(Scaled Dot-Product Attention)。

-

权重分配:将相似度分数进行归一化,得到注意力权重,表示模型在生成输出时对不同位置的关注程度。注意力权重可以看作是一个概率分布,用于对值向量进行加权求和。

-

上下文表示:将权重与值向量进行加权求和,得到一个上下文表示向量,表示模型在生成输出时考虑了不同位置的信息。

在GPT中,注意力机制被广泛应用于编码器和解码器的各个层级,以建立输入序列中不同位置之间的依赖关系。通过多头注意力(Multi-head Attention)的方式,模型可以同时考虑多个不同的注意力表示,从而更全面地捕捉序列中的信息。

总之,注意力机制在GPT中起着重要的作用,使得模型能够有效地建模序列之间的关系,从而实现更准确的语言理解和生成。

监督学习:无监督学习:强化学习

下面例子从小学生的角度讲解一下Transformer中的注意力机制:

想象一下,你是一个小学生,坐在教室里,老师正在讲解。你有一个问题,但你不确定应该问谁。这时,你会怎么做呢?

在GPT中的注意力机制中,你就像是一个查询(Query),你的问题就是你想要关注的内容。而教室里的其他同学就像是键(Key),他们都有自己的知识和信息。每个同学都有一个价值(Value),表示他们对你的问题的回答的重要性。

现在,你需要决定哪些同学对你的问题最有帮助。你会逐个询问每个同学,看看他们是否能回答你的问题。在询问的过程中,你会观察每个同学的反应和回答,然后决定谁对你的问题最有用。

注意力机制就是帮助你做出这个决策的过程。它通过计算你的查询与每个同学的键之间的相似度,来衡量他们对你的问题的相关性。相似度越高,说明他们的回答对你的问题越重要。

然后,你会根据相似度的大小来分配权重,决定每个同学对你的问题的关注程度。权重越大,说明你越关注他们的回答。最后,你会将同学们的回答与权重相乘,并将它们加起来,得到一个综合的回答,这就是注意力机制帮助你生成的上下文表示。

总结一下,GPT中的注意力机制就像是你在课堂上询问问题时的思考过程。它帮助你确定哪些同学对你的问题最有帮助,并根据他们的回答和重要性生成一个综合的回答。在GPT中,这个过程通过计算查询、键和值之间的相似度来实现,从而建立输入序列中不同位置之间的依赖关系。

让我们一同探索无尽的智慧与知识,展开人工智能的奇妙世界。与我一起领略AI技术的魅力,探索未来的可能性。在那里,我将为您带来更多精彩的内容与见解,与您共同追寻科技创新的未来之路。让我们共同开启智能时代的新篇章!