随着人类社会进入信息时代的智能化阶段,数据逐渐成为基础生产要素之一,而算力也因此成为重要生产力。《学习时报》9 月 3 日发文《算力为何如此重要》,文中指出,人工智能技术的突破与产业数字化应用对算力提出了更高的要求;在 9 月 20 日的华为全联接大会上,孟晚舟也演讲表示,算力是人工智能发展的核心驱动力,决定着 AI 的迭代与创新速度。

目前,国内政产学研各界对于人工智能与算力的重视程度日益升高,其中,又以科研界为甚。今年三月,国家科技部会同自然科学基金委正式启动“人工智能驱动的科学研究(AI for Science)”专项部署工作,旨在基于科学数据与算力支撑,通过人工智能的方法,进行计算密集、高效迭代的科学探索,为科研工作带来新的突破。

科研范式正不断升级,传统基础设施却已逐渐不能响应新兴 AI for Science 所需的软硬件支持。本文将聚焦科研算力如何高效调度管理,为各领域研究团队介绍数据科学协同平台 ModelWhale,以期为由人工智能驱动的科学研究提供助力。

一、科研期待与现状

科研期待:研究过程中算力高效、精准的调配,使资源在组织团队内发挥最大可用性

实际情况:缺少合适的计算、存储资源整合渠道,无法兼顾算力集群与个人实践环境

人工智能驱动的科学研究项目普遍属于大型、复杂计算任务,例如 GPU 集群模型训练、大语言模型部署调用等,对硬件要求高,普通的个人 pc 于本地无法满足相应算力需求。

因此,高校与科研机构会预先购置高规格服务器,但此类服务器一般较为分散,组织层面上很难进行整合利用;云上对资源进行集群调度理论上可行,但相关部署、运维工作繁琐且专业性强,组织内需找到合适的人选并为此花费大量时间精力;即使得以成功运维,研究者们也往往苦于无法兼顾算力集群与个人实践环境。

二、人工智能驱动科学研究的高效算力调度管理

异构融合、集约管控、按需分配、敏捷响应,ModelWhale 强大的算力调度管理使个人电脑调用 LLM 大语言模型成为可能,也使算力资源在组织团队内发挥最大可用性。

异构融合:算力接入的私有化部署与运维

独立部署的 ModelWhale 在算力接入上可选择本地服务器(需要高效利用已有硬件设备客户的首选)、私有云或来自各主流云厂商提供的云服务,无论是哪种方式,基于云原生技术方案的 ModelWhale 都可灵活对接,同时支持跨云调度。

部署完成后,ModelWhale 将提供全套运维服务与完整售后机制,做到全程跟进。一般性问题,可于线上远程支持;严重或复杂问题,ModelWhale 团队也可到当地进行解决,不再浪费研究组织内的人力资源做相关运维工作。

集约管控:各规格算力的统一管理

选择本地服务器完成算力接入,意味着已将高校与科研机构组织内的既有资源做了集成,下一步便是各规格算力的统一管理,即,如何将集成资源更方便地利用起来,并分配给不同老师、研究者的项目课题组。

通过 ModelWhale,大型组织的管理人员可利用图形化操作界面,根据核数与内存大小对算力进行拆分,再依据不同的使用需求分配给不同群体。举例来说,AI for Science 过程中经常出现大型复杂计算任务,因此需要较高规格的 CPU 算力或 GPU 集群,那么,较为基础的算力资源则可同步分配给高校内的教学团队用于课程实践,做到各规格算力都不闲置。

此外,ModelWhale 还提供资源申用机制,当现有计算存储资源不够用时,项目组的管理人员可通过发起申请及时获得算力补给,应对不同研究需求。

算力资源按需分配至不同的项目课题组

按需分配:精细化、灵活的算力调度

如果说各规格算力统一管理的着眼点在于从高校与科研机构的大型组织到组织内不同的项目课题组,那么精细化、灵活的算力调度则更关心项目组内人员间的算力调配。

人工智能驱动的科学研究项目组内使用算力资源属于“高规格+高并发”场景,如何将有限的算力分配给组内较多的研究人员?同组织管理员一样,项目组的管理人员同样可通过简单的点选式操作完成远程资源的分配与管控,精细到组内的每个成员,包括配置可使用特定资源的类型与时长。而通过算力上云,项目组内研究人员的研究环境不再局限于办公室、实验室的网络或电脑,个人 pc 也可随时随地进行相关研究。

项目组管理员、负责人对组内研究者们的算力进行实时把控也是杜绝资源浪费的一种途径;在算力紧缺的情况下,ModelWhale 不仅提供资源排队机制,也支持为组内成员配置资源使用优先级,使其优先完成部分相对重要的研究工作;最后,算力申请机制同样适用于项目课题组内,申请将由管理人员审核,通过后即可根据各研究者的需求自动发放相应资源。

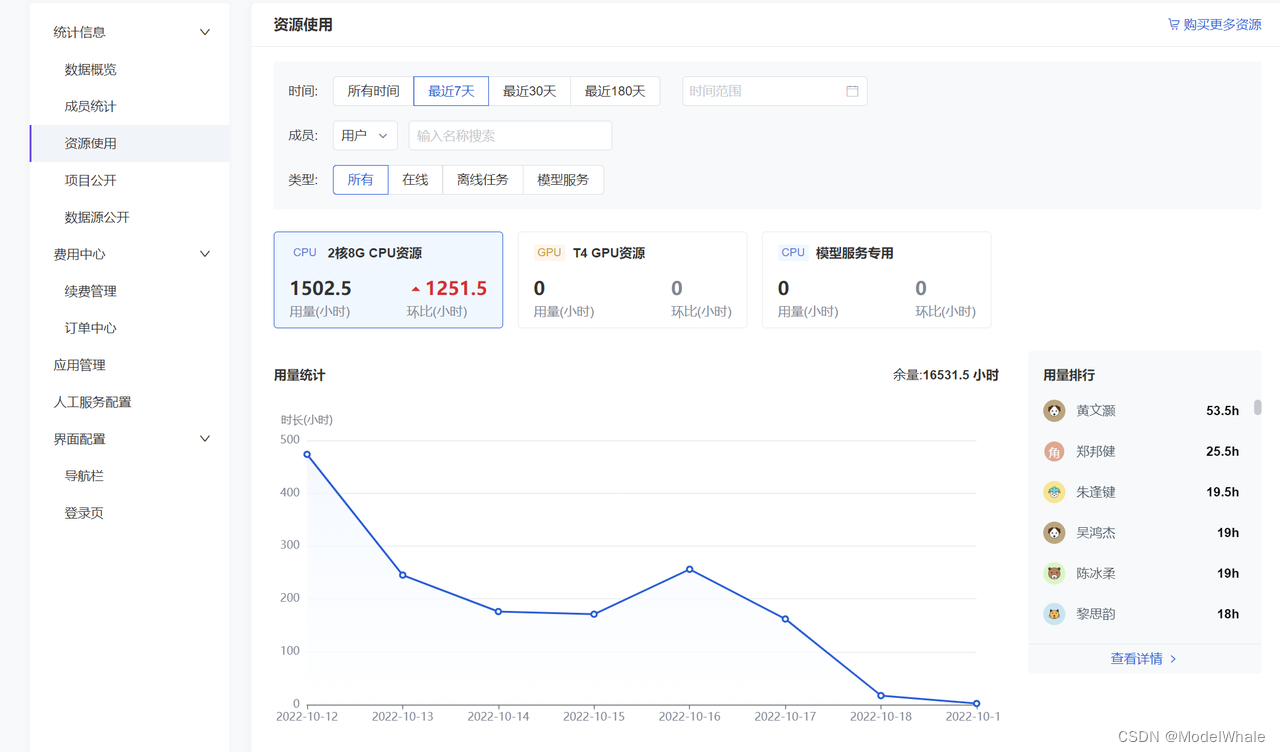

计算资源管理 - 资源使用界面

敏捷响应:算力资源的即开即用

算力同分析环境、镜像一样,在 ModelWhale 内属于即开即用的一部分:获得项目组管理人员分配的算力后,组内研究者在开始项目前自主选取所需算力,即可一键完成资源调用,开始数据研究工作;研究过程中,也可随时查看平台算力、内存、磁盘的使用情况;项目关闭、算力使用结束后,资源也会自动释放,供组内其他有需要的研究人员使用。

当遇到大型、复杂的计算任务时,新上线的 Pipeline 功能支持任务编排与并行计算,该功能属于模型离线训练的一环,可使训练过程中的相关算力调度变得更为高效。

三、结束语

在技术革命与顶层政策的引领下,科研界正给予数据、算力、人工智能越来越多的关注。

数据科学协同平台 ModelWhale 科研版聚焦数据驱动研究的协同创新,是以推动 AI for Science 科研范式改革、加强有组织科研为己任的数字化基础设施:关注从数据、算法到模型等研究对象的一站式全流程管理,从基础设施层面提升科学研究的可复现性,帮助营造协作协同的良好科研生态;基于 FAIR 原则与开放科研理念为数据等研究生产资料提供安全、完善的公开共享门户与在线交互工作台;异构融合、集约管控、按需分配、敏捷响应,强大的算力调度管理使个人电脑调用 LLM 大语言模型成为可能,也使算力资源在组织团队内发挥最大可用性;引入 ModelOps 理念,助力大模型全生命周期管理。

ModelWhale 科研版覆盖地球科学、生物医学、人文社科等专业领域,且已将最佳实践落实于国家气象信息中心、中国自然资源航空物探遥感中心等国家级科研机构,希望能为每一位从事数据创新研究的开拓者及其团队提供支持。任何相关需求,都欢迎您进入 ModelWhale 官网 注册体验,或点击【联系产品顾问(移动端跳转)】与我们展开交流。