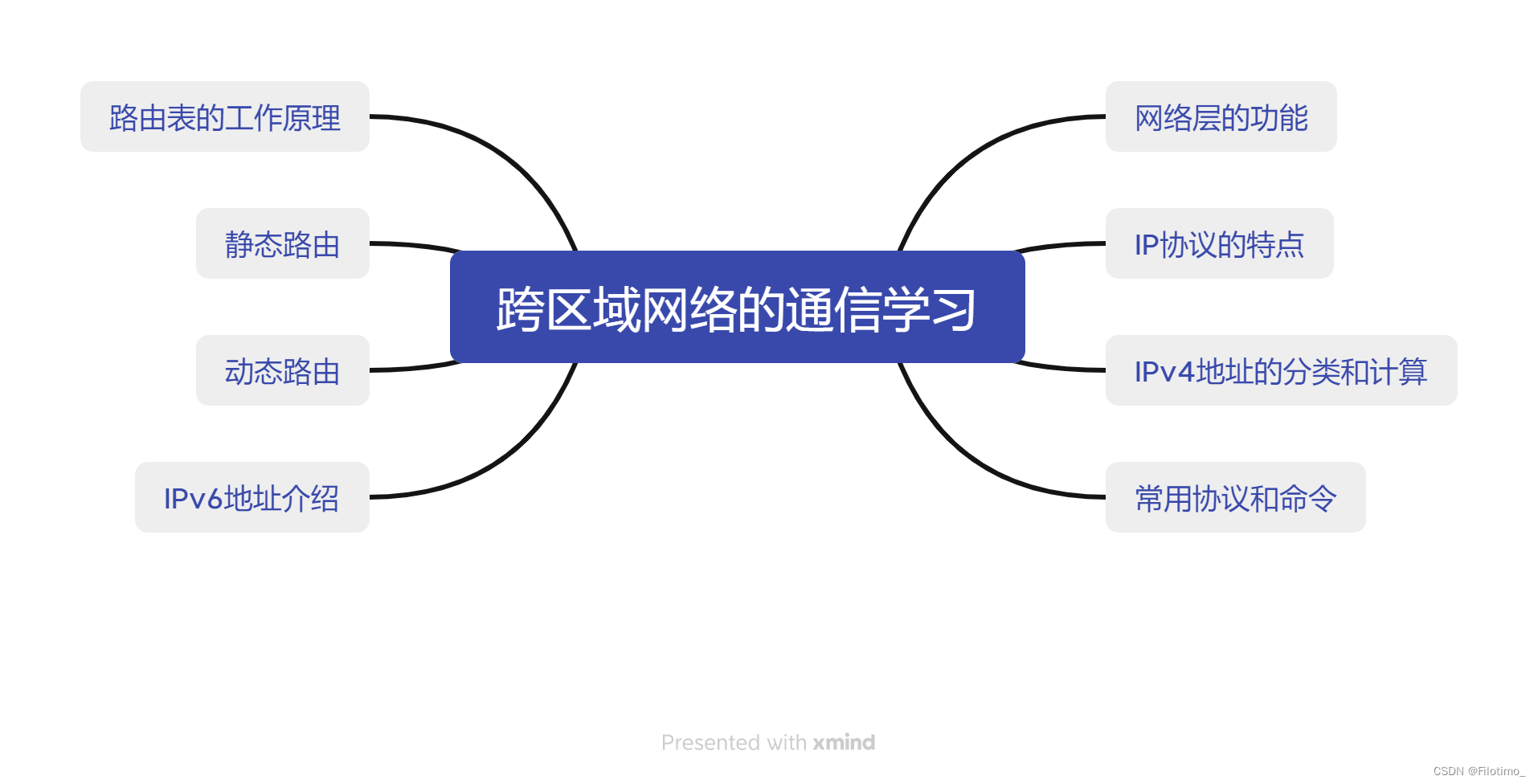

文章目录

- 机器学习、强化学习、深度学习的侧重点

- 强化学习的简介

- 强化学习的主要特征

- 强化学习和机器学习的关系

- 强化学习的发展历史

- 深度强化学习

一些参考的资料:

蘑菇书:https://datawhalechina.github.io/easy-rl/#/chapter1/chapter1

源代码:https://github.com/datawhalechina/easy-rl/releases/tag/v.1.0.3

机器学习、强化学习、深度学习的侧重点

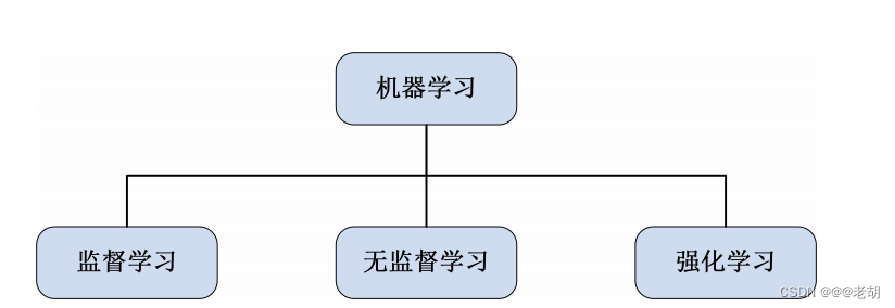

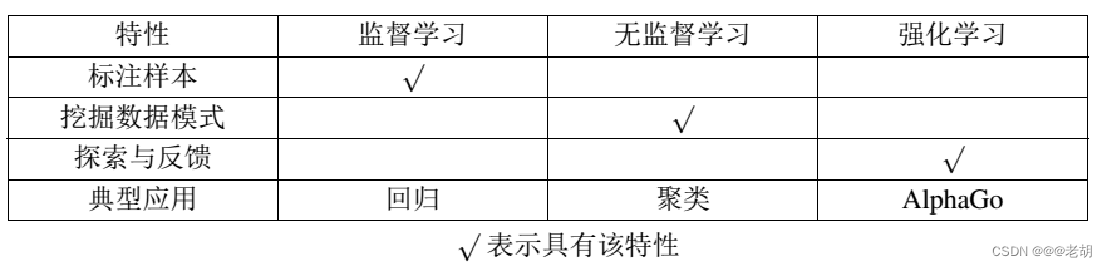

- 机器学习(Machine learning)是一种通过让计算机从大量的数据中学习模式和规律,从而能够自动进行任务和做出决策的技术。机器学习是人工智能的分支,旨在是计算机能够在经验中学习和改进,而不需要明确的编程。机器学习可以分为监督学习、无监督学习、半监督学习和强化学习。

- 强化学习(Reinforcement Learning)是机器学习的一种,强化学习通过将智能体置于环境之中,让智能体和环境进行交互学习,通过环境的反馈(正向或者负向),从而调整决策,在不断的交互之中找到最优的解,强化学习追求长期回报的最大化。

- 深度学习(Deep Learning)也是一种机器学习的方法,通过构建和训练多层神经网络来模拟人脑的神经网络结构,从而实现对大量复杂的数据的自动学习和特征提取。

强化学习的简介

- 强化学习(Reinforcement Learning)注重让参与者(Agent)在与环境的互动中进行目标导向型学习。参与者可以根据当前所处的环境(State)以及某一个行动策略(policy)来选择一个行动(Action)来与环境进行一系列的互动。

- 有一些互动可以立即从环境中获取奖励(Reward),并且改变环境的状态,甚至可以改变后续的奖励;但是有一些互动可能会存在延迟。并且这些奖励有正向的也有负向的。

- 参与者可以根据环境的反馈来学习怎么最大化长期回报(Return),并且提取一个最优的策略,达到强化学习任务目标。

强化学习的主要特征

- 不断的试错学习

- 通过试错来与环境进行交互,并且根据环境的反馈来增强或者抑制行动,试错包括利用和探索的过程

- 利用是根据历史的经验进行学习,来选择执行能获得的最大收益的动作

- 探索就是尝试之前没有执行过的动作,期望获得超乎当前的总体收益

- 短期来讲,利用可以使得某一步的预期回报最大化

- 长远来讲,探索可以产生更大的长期回报

- 强化学习的挑战是在利用和探索之中找到平衡

- 强化学习追求长期回报的最大化(目标),(长期回报是指从当前时刻(状态)到最终时刻(状态)得到的总奖励期望)

强化学习和机器学习的关系

- 机器学习包括强化学习、监督与无监督学习

- 强化学习和监督学习无监督学习一样都是从历史数据中进行学习,并且对未来做出预测的过程,三者都符合机器学习的定义

强化学习的发展历史

-

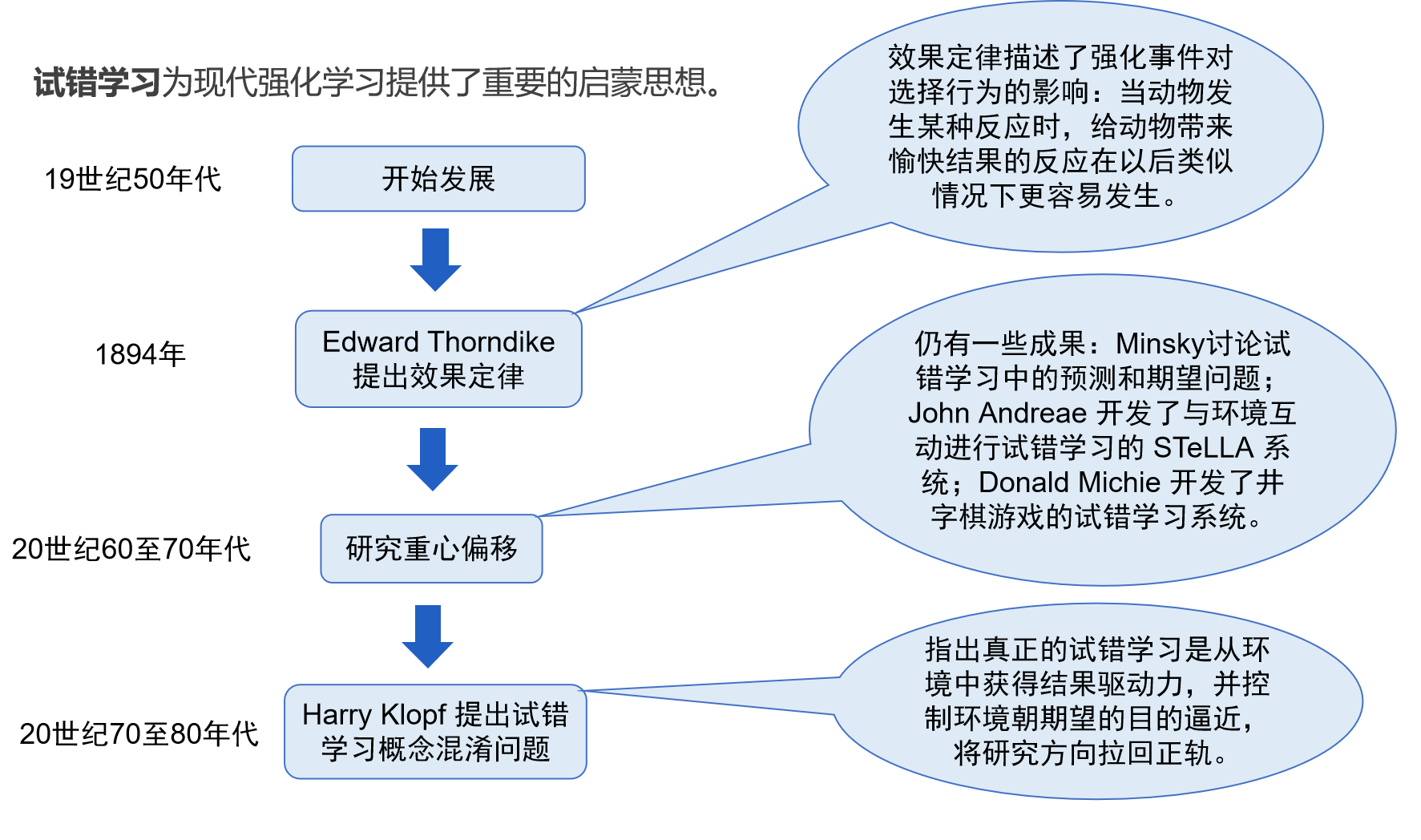

试错学习:从环境中获取结果的驱动力,控制环境朝着期望的目标前进。

-

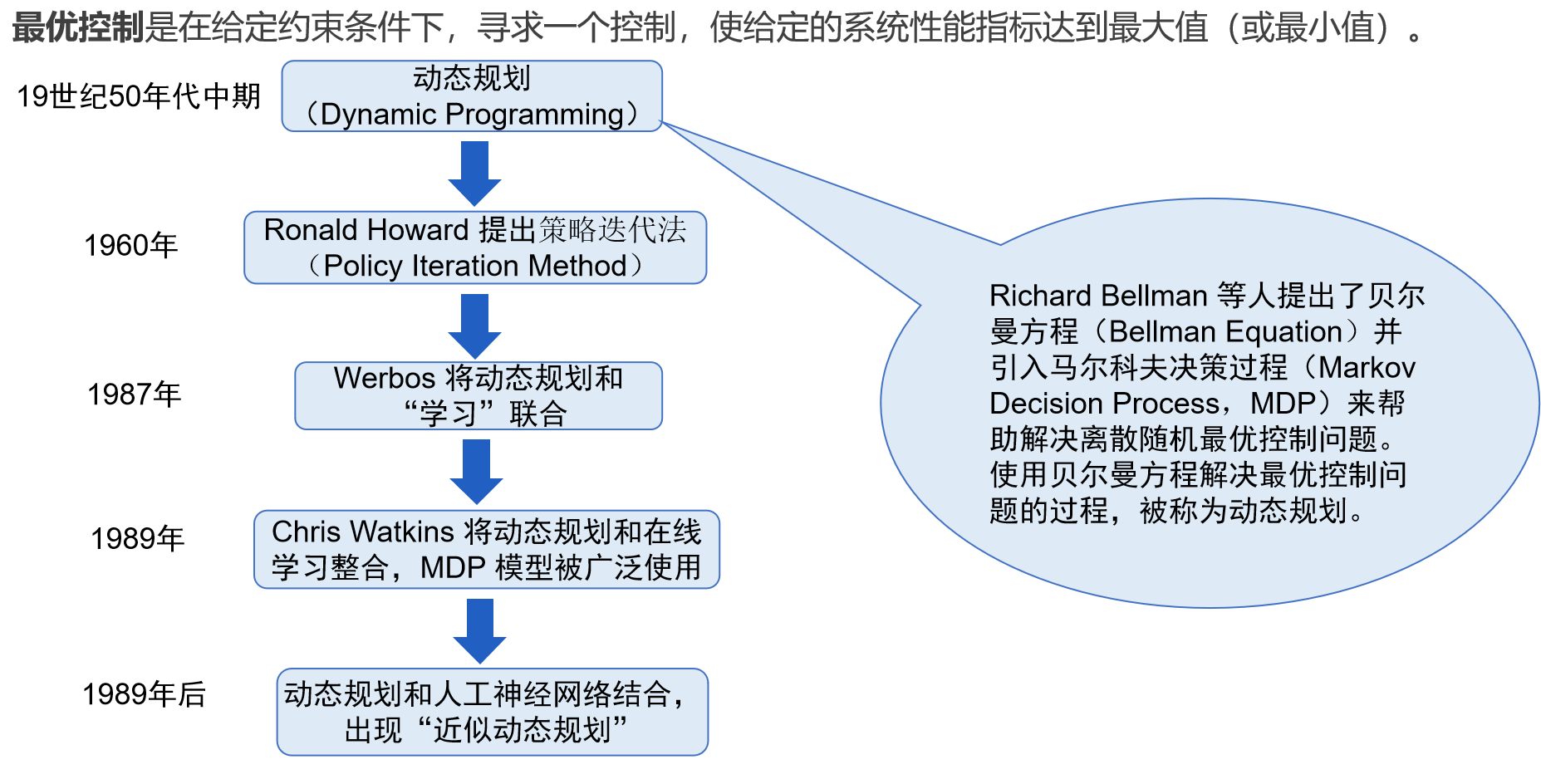

最优控制:给定的约束条件下,寻求一个控制,使得给定系统的某一个指标达到最优

-

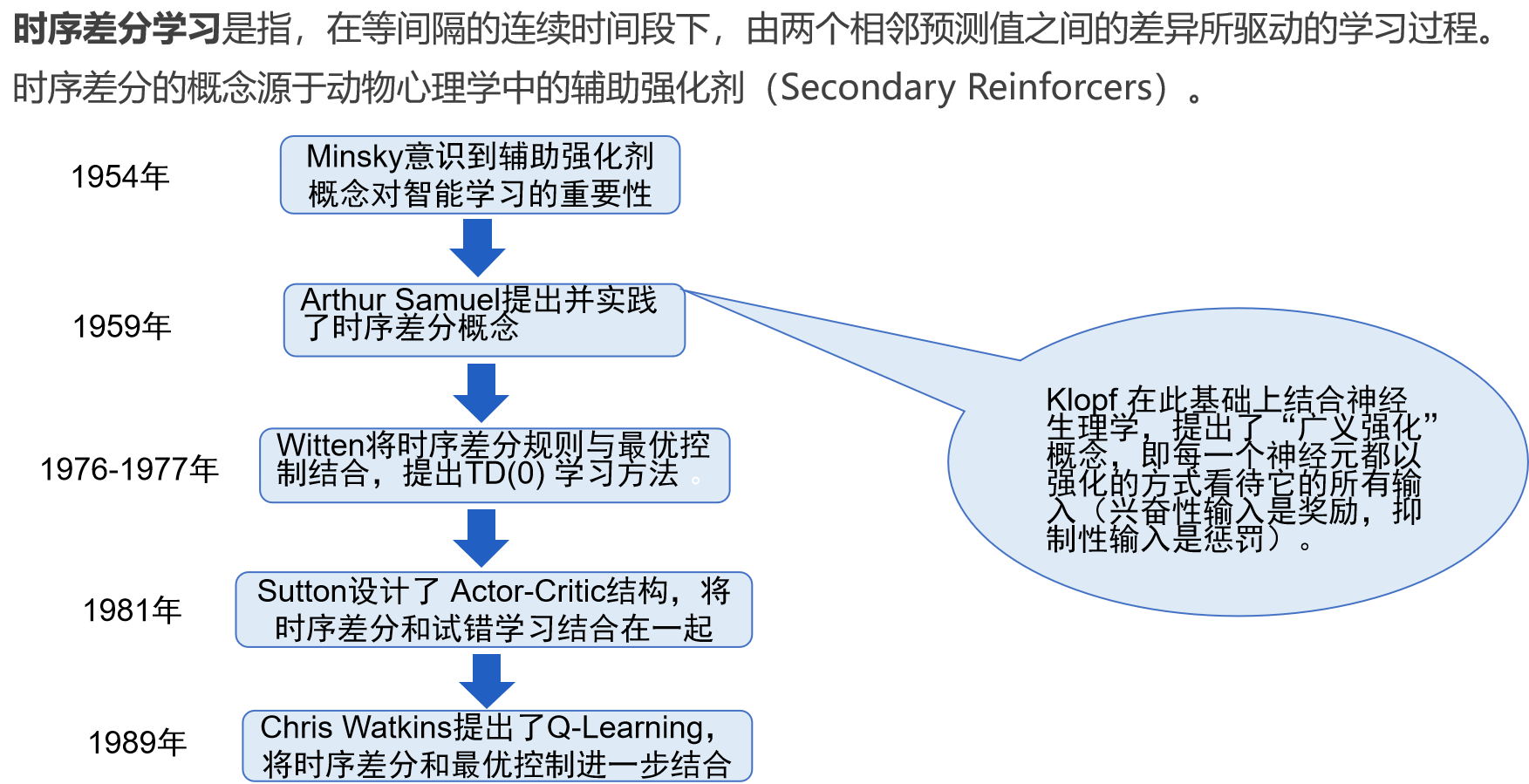

时序差分法

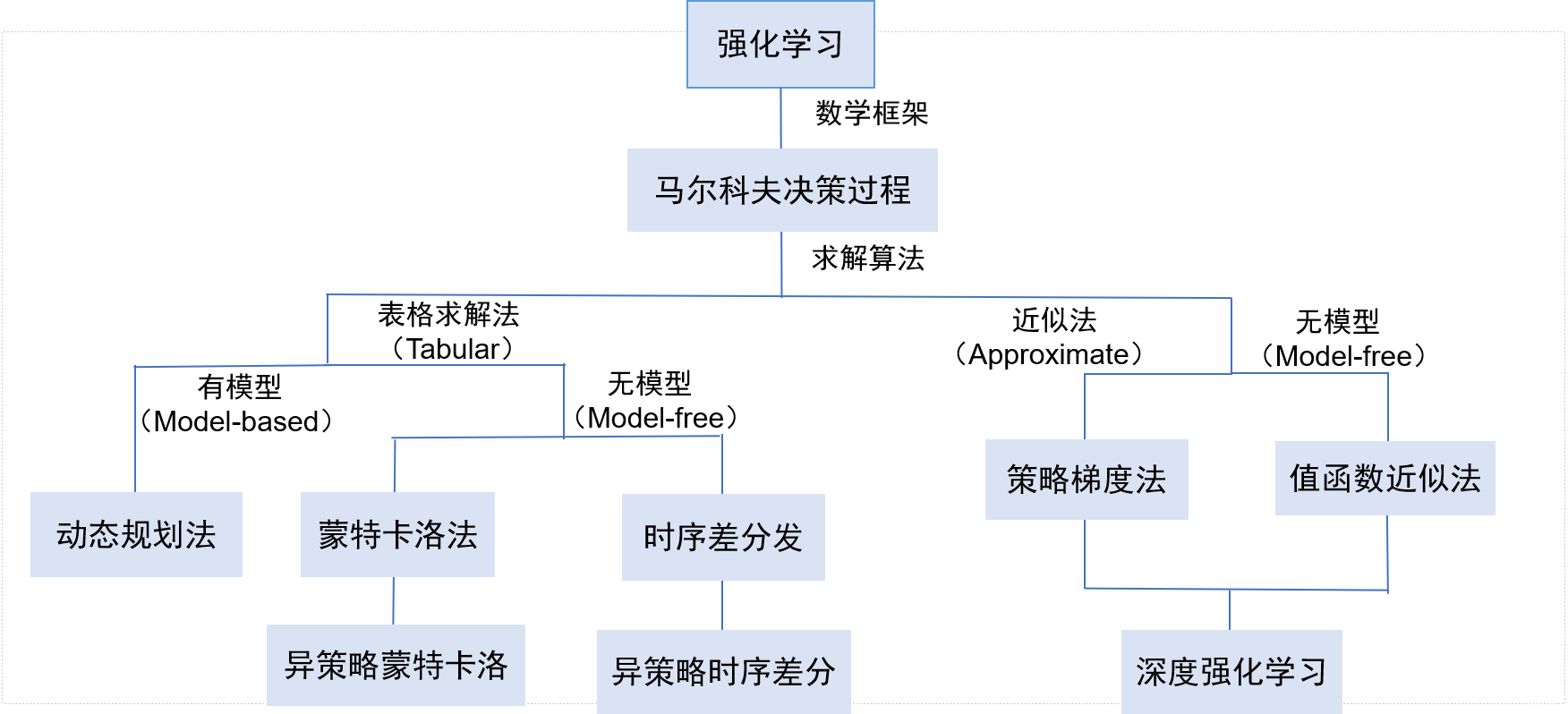

深度强化学习

- 深度学习将强化的决策能力和深度学习的感知能力结合,改进了传统强化学习难以应对大且连续行动和样本空间的问题。

- 深度强化学习将神经网络融入到强化学习的体系中,使参与者能在环境中学习可能的最佳行动,以实现其目标。它也将函数逼近(Function Approximation)和目标优化结合起来,将状态-动作对映射到期望的奖励,并以此作为行动的评估反馈,通过迭代,学习最佳策略。