目录

- 一、聚类与KMeans介绍

- 聚类的基础概念

- KMeans算法的重要性

- 二、KMeans算法原理

- 数据集和特征空间

- 距离度量

- 算法步骤

- 三、KMeans案例实战

- 案例背景:客户细分

- 数据集说明

- Python实现代码

- 输出与解释

- 四、KMeans的优缺点

- 优点

- 计算效率高

- 算法简单易于实现

- 缺点

- 需要预设K值

- 对初始点敏感

- 处理非凸形状集群的能力差

- 五、KMeans在文本聚类中的应用

- 文本向量化

- KMeans与TF-IDF

- Python实现代码

- 输出与解释

- 总结

本文深入探讨了KMeans聚类算法的核心原理、实际应用、优缺点以及在文本聚类中的特殊用途,为您在聚类分析和自然语言处理方面提供有价值的见解和指导。

关注TechLead,分享AI全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦硕,复旦机器人智能实验室成员,阿里云认证的资深架构师,项目管理专业人士,上亿营收AI产品研发负责人。

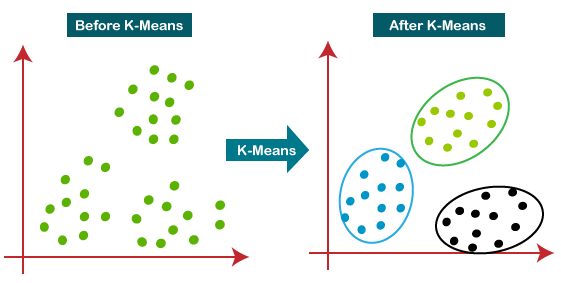

一、聚类与KMeans介绍

聚类算法在机器学习和数据挖掘中占有重要的地位,它们用于自动地将数据分组成有意义的集群。KMeans聚类算法是其中最简单、最常用的一种。在本篇文章中,我们将深入探讨KMeans聚类算法的原理、优缺点、变体和实际应用。首先,让我们了解一下聚类和KMeans算法的基础概念。

聚类的基础概念

定义:聚类是一种无监督学习方法,用于将数据点分组成若干个集群,以便数据点在同一个集群内相似度高,而在不同集群间相似度低。

例子:考虑一个电子商务网站,有数万名用户和数千种商品。通过聚类算法,我们可以将用户分为几个不同的集群(例如,家庭主妇、学生、职业人士等),以便进行更精准的推荐和营销。

KMeans算法的重要性

定义:KMeans是一种分区方法,通过迭代地分配每个数据点到最近的一个预定数量(K)的中心点(也称为“质心”)并更新这些中心点,从而达到划分数据集的目的。

例子:在社交网络分析中,我们可能想要了解哪些用户经常互动,形成一个社区。通过KMeans算法,我们可以找到这些社区的“中心用户”,并围绕他们形成不同的用户集群。

这两个基础概念为我们后续的深入分析和代码实现提供了坚实的基础。通过理解聚类的目的和KMeans算法的工作原理,我们能更好地把握该算法在复杂数据分析任务中的应用。

二、KMeans算法原理

在深入探讨KMeans聚类算法之前,了解其工作原理是至关重要的。本节将介绍KMeans算法的核心组成部分,包括数据集和特征空间、距离度量以及算法的主要步骤。

数据集和特征空间

定义:在KMeans算法中,数据集通常表示为一个矩阵,其中每一行是一个数据点,每一列是一个特征。特征空间是这些数据点存在的多维空间,通常与数据集的列数相同。

例子:假设我们有一个简单的2D数据集,其中包括身高和体重两个特征。在这种情况下,特征空间是一个二维平面,其中每个点代表一个具有身高和体重值的个体。

距离度量

定义:距离度量是一种衡量数据点之间相似度的方法。在KMeans中,最常用的距离度量是欧几里得距离。

例子:在上面的身高和体重的例子中,我们可以使用欧几里得距离来衡量两个人在特征空间中的相似度。数学上,这可以通过以下公式来表示:

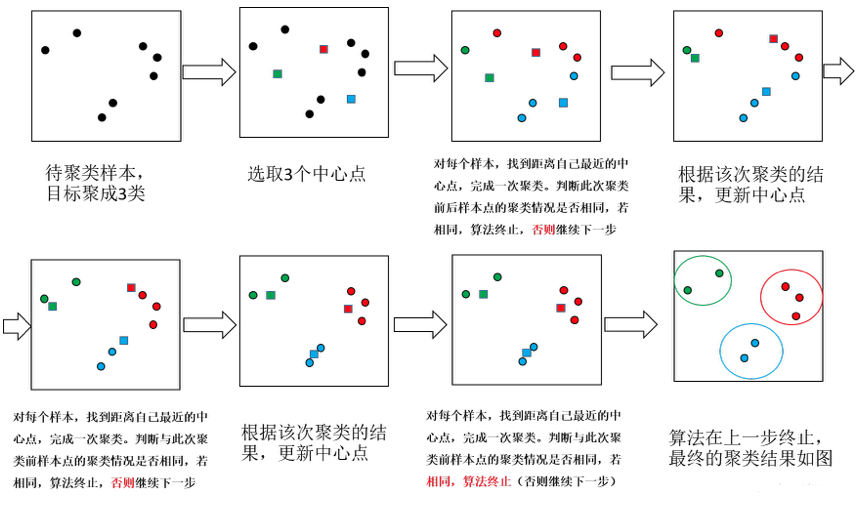

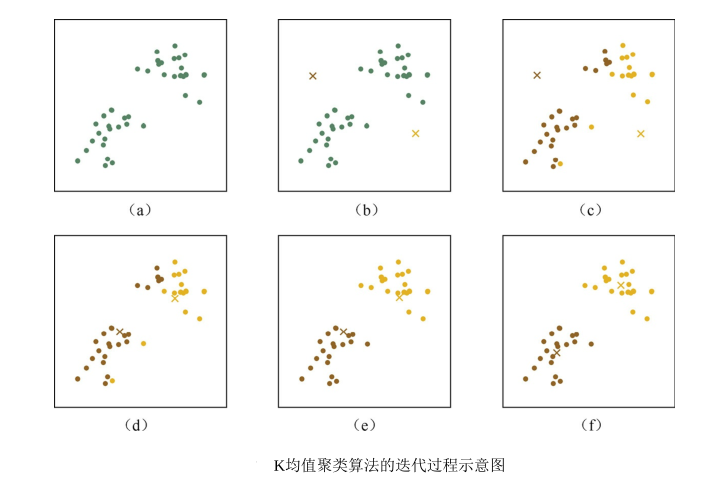

算法步骤

KMeans算法主要由以下几个步骤组成:

- 选择K个初始中心点:随机选择数据集中的K个数据点作为初始中心点(质心)。

- 分配数据点到最近的中心点:对于数据集中的每一个点,计算其与所有中心点的距离,并将其分配给最近的中心点。

- 更新中心点:重新计算每个集群的中心点,通常是该集群内所有点的平均值。

- 迭代直至收敛:重复步骤2和步骤3,直至中心点不再显著变化或达到预设的迭代次数。

例子:考虑一个商店希望将客户分为几个不同的集群,以便进行更有效的市场推广。商店有关于客户年龄和购买频率的数据。在这个例子中,KMeans算法可以这样应用:

- 选择K(例如,K=3)个客户作为初始的中心点。

- 使用年龄和购买频率计算所有其他客户与这K个中心点的距离,并将每个客户分配给最近的中心点。

- 更新每个集群的中心点,这里是每个集群内所有客户年龄和购买频率的平均值。

- 迭代这个过程,直至集群不再发生变化或达到预设的迭代次数。

通过这个结构化的解析,我们能更好地理解KMeans聚类算法是如何工作的,以及如何在不同的应用场景中调整算法参数。

三、KMeans案例实战

理解KMeans算法的理论基础是非常重要的,但更重要的是能够应用这些理论到实际问题中。在本节中,我们将通过一个具体的案例来演示如何使用Python和PyTorch实现KMeans算法。

案例背景:客户细分

定义:客户细分是一种市场策略,通过将潜在客户分为不同的组或段,企业可以更精准地进行产品推广或服务提供。

例子:一个在线零售商希望根据客户的年龄、购买历史和浏览行为来进行客户细分,以实施更有效的营销策略。

数据集说明

在本案例中,我们将使用一个简单的数据集,包括客户的年龄、购买频率和平均消费金额三个特征。

客户ID | 年龄 | 购买频率 | 平均消费金额

------|------|----------|--------------

1 | 25 | 5 | 50

2 | 30 | 3 | 40

3 | 35 | 1 | 20

...

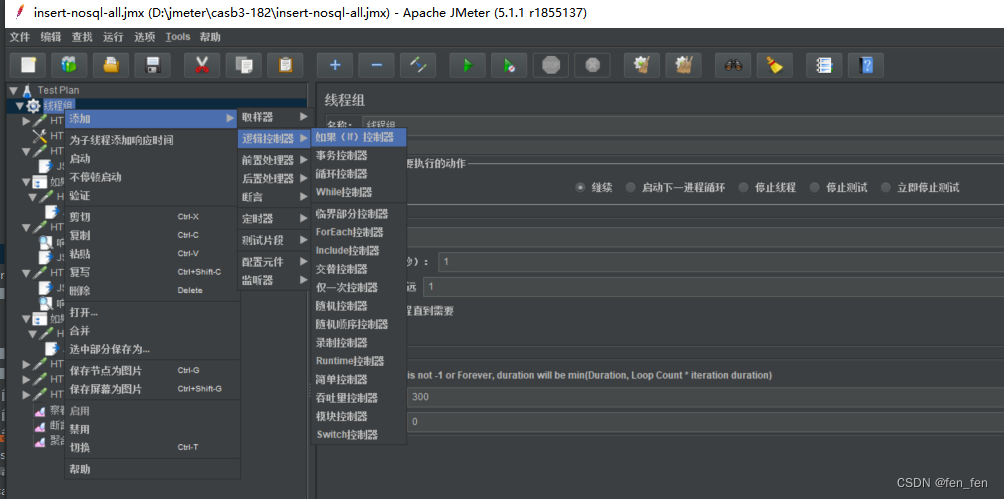

Python实现代码

下面是使用Python和PyTorch来实现KMeans算法的代码。我们首先导入必要的库,然后进行数据准备、模型训练和结果可视化。

import numpy as np

import torch

import matplotlib.pyplot as plt

# 创建一个模拟数据集

data = torch.tensor([[25, 5, 50],

[30, 3, 40],

[35, 1, 20]], dtype=torch.float32)

# 初始化K个中心点

K = 2

centers = data[torch.randperm(data.shape[0])][:K]

# KMeans算法主体

for i in range(10): # 迭代10次

# 步骤2:计算每个点到各个中心点的距离,并分配到最近的中心点

distances = torch.cdist(data, centers)

labels = torch.argmin(distances, dim=1)

# 步骤3:重新计算中心点

for k in range(K):

centers[k] = data[labels == k].mean(dim=0)

# 结果可视化

plt.scatter(data[:, 0], data[:, 1], c=labels)

plt.scatter(centers[:, 0], centers[:, 1], marker='x')

plt.show()

输出与解释

在这个简单的例子中,KMeans算法将客户分为两个集群。通过可视化结果,我们可以看到集群中心点(标记为’x’)分别位于不同的年龄和购买频率区域。

这样的输出可以帮助企业更好地了解其客户群体,从而制定更精准的市场策略。

四、KMeans的优缺点

理解一个算法的优缺点是掌握它的关键。在这一部分,我们将详细讨论KMeans算法在实际应用中的优点和缺点,并通过具体的例子来加深这些概念的理解。

优点

计算效率高

定义:KMeans算法具有高计算效率,尤其在数据集规模较大或特征较多的情况下仍能保持良好的性能。

例子:假设一个大型在线零售商有数百万的客户数据,包括年龄、购买历史、地理位置等多维特征。使用KMeans,仅需几分钟或几小时即可完成聚类,而更复杂的算法可能需要更长的时间。

算法简单易于实现

定义:KMeans算法本身相对简单,容易编码和实现。

例子:如我们在前面的案例实战部分所示,仅需几十行Python代码即可实现KMeans算法,这对于初学者和研究人员都是非常友好的。

缺点

需要预设K值

定义:KMeans算法需要预先设定簇的数量(K值),但实际应用中这个数量往往是未知的。

例子:一个餐厅可能希望根据顾客的菜品选择、消费金额和就餐时间来进行聚类,但事先很难确定应该分成几个集群。错误的K值选择可能导致不准确或无意义的聚类结果。

对初始点敏感

定义:算法的输出可能会受到初始中心点选择的影响,这可能导致局部最优而非全局最优解。

例子:在处理地理信息时,如果初始中心点不慎选在了人迹罕至的地区,可能会导致一个非常大但不具代表性的集群。

处理非凸形状集群的能力差

定义:KMeans更适用于凸形状(例如圆形、球形)的集群,对于非凸形状(例如环形)的集群处理能力较差。

例子:假设一个健身房希望根据会员的年龄和锻炼时间进行聚类,但发现年轻人和老年人都有早晨和晚上锻炼的习惯,形成了一个环形的分布。在这种情况下,KMeans可能无法准确地进行聚类。

五、KMeans在文本聚类中的应用

除了常见的数值数据聚类,KMeans也被广泛应用于文本数据的聚类。在这一节中,我们将探讨KMeans在文本聚类中的应用,特别是在自然语言处理(NLP)领域。

文本向量化

定义:文本向量化是将文本数据转化为数值形式,以便机器学习算法能更容易地处理它。

例子:例如,一个常用的文本向量化方法是TF-IDF(Term Frequency-Inverse Document Frequency)。

KMeans与TF-IDF

定义:结合TF-IDF和KMeans算法可以有效地对文档进行分类或主题建模。

例子:一个新闻网站可能有成千上万的文章,它们可以通过应用KMeans聚类算法与TF-IDF来分类成几大主题,如“政治”、“科技”、“体育”等。

Python实现代码

下面的代码使用Python的sklearn库进行TF-IDF文本向量化,并应用KMeans进行文本聚类。

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.cluster import KMeans

# 模拟文本数据

documents = ["政治新闻1", "科技新闻1", "体育新闻1",

"政治新闻2", "科技新闻2", "体育新闻2"]

# TF-IDF向量化

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(documents)

# KMeans聚类

model = KMeans(n_clusters=3)

model.fit(X)

labels = model.labels_

# 输出与解释

for i, label in enumerate(labels):

print(f"文档 {documents[i]} 被归类到 {label} 集群。")

输出与解释

这个简单的例子展示了如何通过KMeans与TF-IDF将文本文档分为3个不同的集群。对应的输出可能如下:

文档 政治新闻1 被归类到 0 集群。

文档 科技新闻1 被归类到 1 集群。

文档 体育新闻1 被归类到 2 集群。

文档 政治新闻2 被归类到 0 集群。

文档 科技新闻2 被归类到 1 集群。

文档 体育新闻2 被归类到 2 集群。

通过这种方式,我们可以将大量文本数据进行分类,方便后续的数据分析或信息检索。

总结

KMeans聚类算法是一种既简单又强大的无监督学习工具,适用于各种数据类型和应用场景。在本文中,我们深入地探讨了KMeans的基本原理、实际应用、优缺点,以及在文本聚类中的特殊用途。

从计算效率和易于实现的角度来看,KMeans算法是一个有吸引力的选项。但它也有其局限性,如对初始中心点的依赖性,以及在处理复杂集群形状时可能出现的问题。这些因素需要在实际应用中仔细权衡。

文本聚类则展示了KMeans在高维稀疏数据上也能表现出色的一面,尤其是与TF-IDF等文本向量化方法结合使用时。这为自然语言处理、信息检索,以至更为复杂的语义分析等应用场景铺平了道路。

然而,值得注意的是,KMeans并不是万能的。在不同的应用环境下,还需考虑到更为复杂的因素,比如数据分布的不均匀性、噪声的存在以及簇的动态性等。这些因素可能要求我们对KMeans进行适当的改进或者选择其他更适应特定问题的聚类算法。

此外,未来随着算法和硬件的进步,以及更多先进的优化技巧的提出,KMeans和其他聚类算法还将进一步演化。例如,通过自动确定最佳的K值,或者运用更先进的初始化策略,以减少对初始点选择的依赖,都是值得进一步探究的方向。

综上所述,KMeans是一个非常实用的算法,但要充分发挥其潜能,我们需要深入理解其工作原理,适应性以及局限性,并在实际应用中做出明智的选择和调整。希望本文能对你在使用KMeans或其他聚类算法时提供有价值的指导和灵感。

关注TechLead,分享AI全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦硕,复旦机器人智能实验室成员,阿里云认证的资深架构师,项目管理专业人士,上亿营收AI产品研发负责人。

![表名注解/主键注解/字段注解/乐观锁注解[MyBatis-Plus系列] - 第486篇](https://img-blog.csdnimg.cn/img_convert/fdca442828cb39d52862e1e918f03ee7.png)