目录

一、下载Hadoop安装包

二、安装Hadoop

0. 安装Hadoop前的必要准备

1. 以root用户登录主节点虚拟机

2. 上传Hadoop安装包到主节点

3. 解压缩安装包到/export/server/目录中

4. 构建软链接

三、部署HDFS集群

0. 集群部署规划

1. 进入hadoop安装包内

2 进入etc目录下的hadoop目录

3. 配置workers文件

4. 配置hadoop-env.sh文件

5.配置core-site.xml文件

6.配置hdfs-site.xml文件

7. 准备数据目录

8. 分发Hadoop文件夹

三、配置环境变量

四、为Hadoop用户授权

五、格式化HDFS文件系统

1. 格式化namenode

2. 一键启动hdfs集群

3. 使用jps检查运行中的进程

4. 查看HDFS WEBUI

六、拍摄快照保存配置好的虚拟机

七、启动和关闭HDFS集群

1. 一键启动HDFS集群

2. 一键关闭HDFS集群

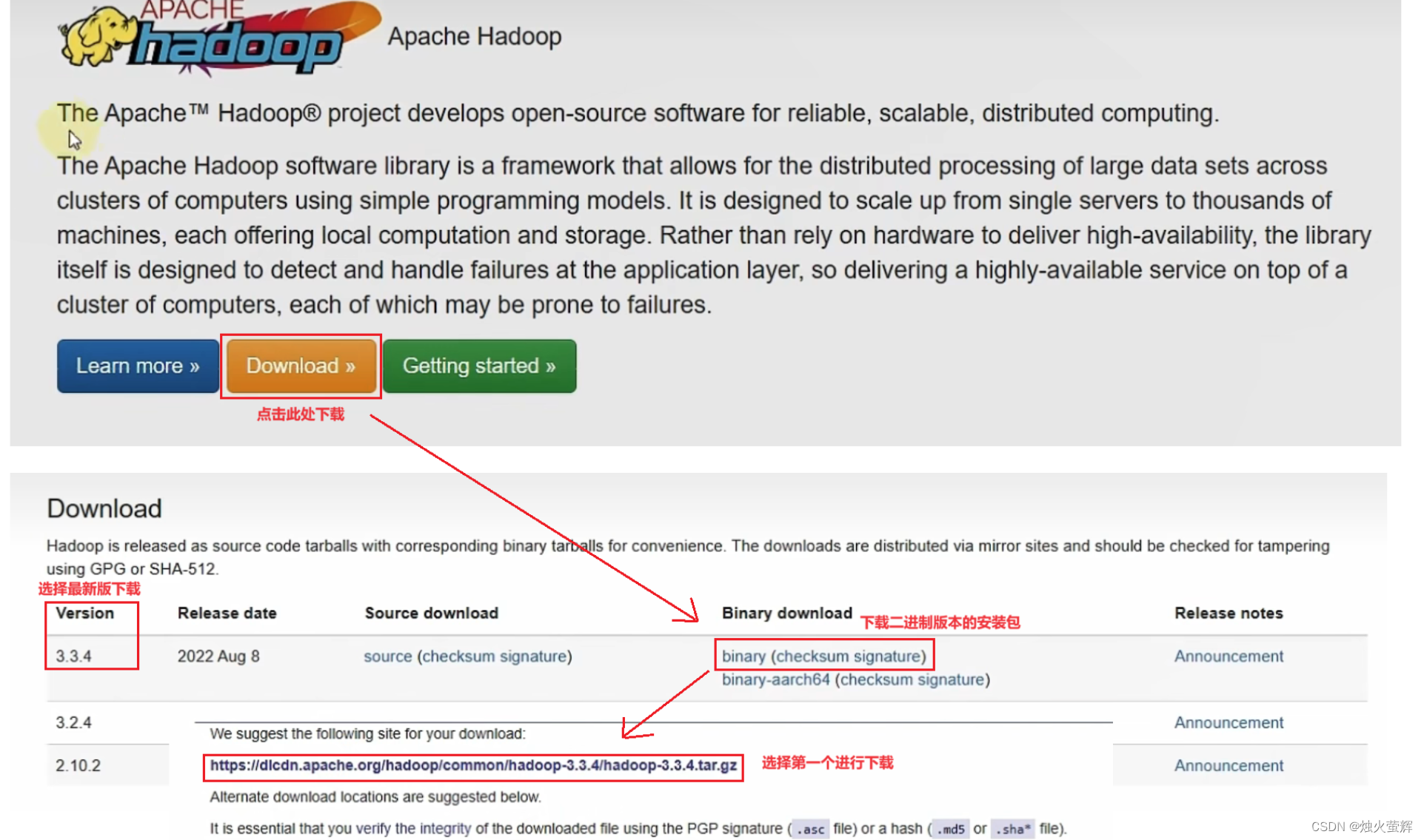

一、下载Hadoop安装包

1. 官网下载

2. 百度网盘链接 提取码:2233

二、安装Hadoop

0. 安装Hadoop前的必要准备

在开始部署前,请确认已经完成前置准备中的服务器创建、固定IP、防火墙关闭、Hadoop用户创建、SSH免密、JDK部署等操作。 如果不确定,请看博主文章:http://t.csdn.cn/YlUi5

1. 以root用户登录主节点虚拟机

如博主的主节点为node1,所以在node1虚拟机中以root身份登录,进入/export/server/目录下。

2. 上传Hadoop安装包到主节点

将下载好的压缩包拖拽到远程终端软件 或 在远程终端软件中使用rz命令。

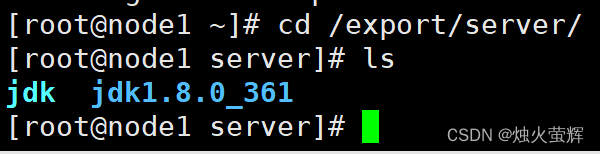

3. 解压缩安装包到/export/server/目录中

1. 进入/export/server/目录: cd /export/server/ 2. 解压到当前目录下: tar -zxvf hadoop-3.3.4.tar.gz

4. 构建软链接

ln -s /export/server/hadoop-3.3.4 hadoop

三、部署HDFS集群

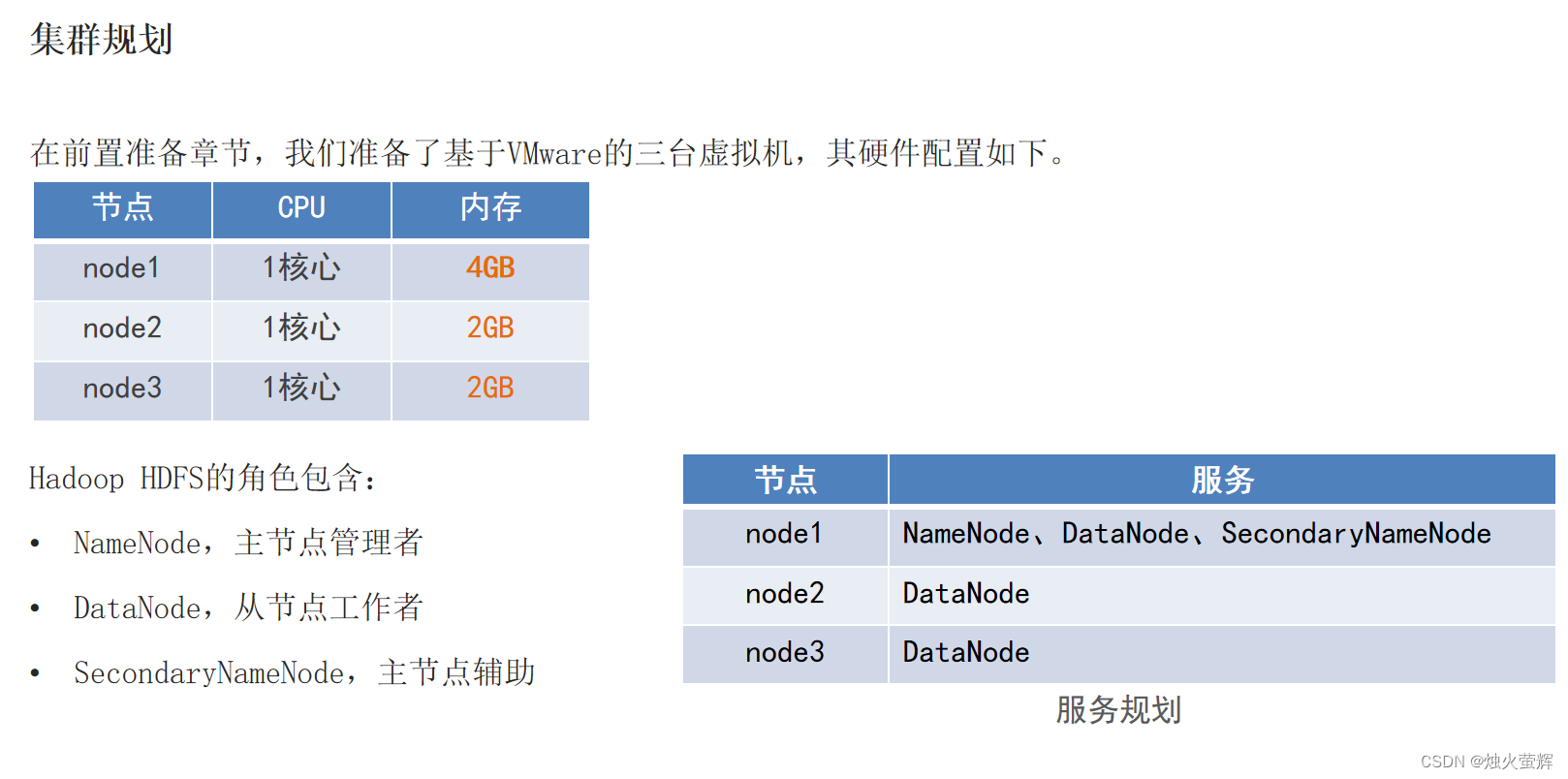

0. 集群部署规划

1. 进入hadoop安装包内

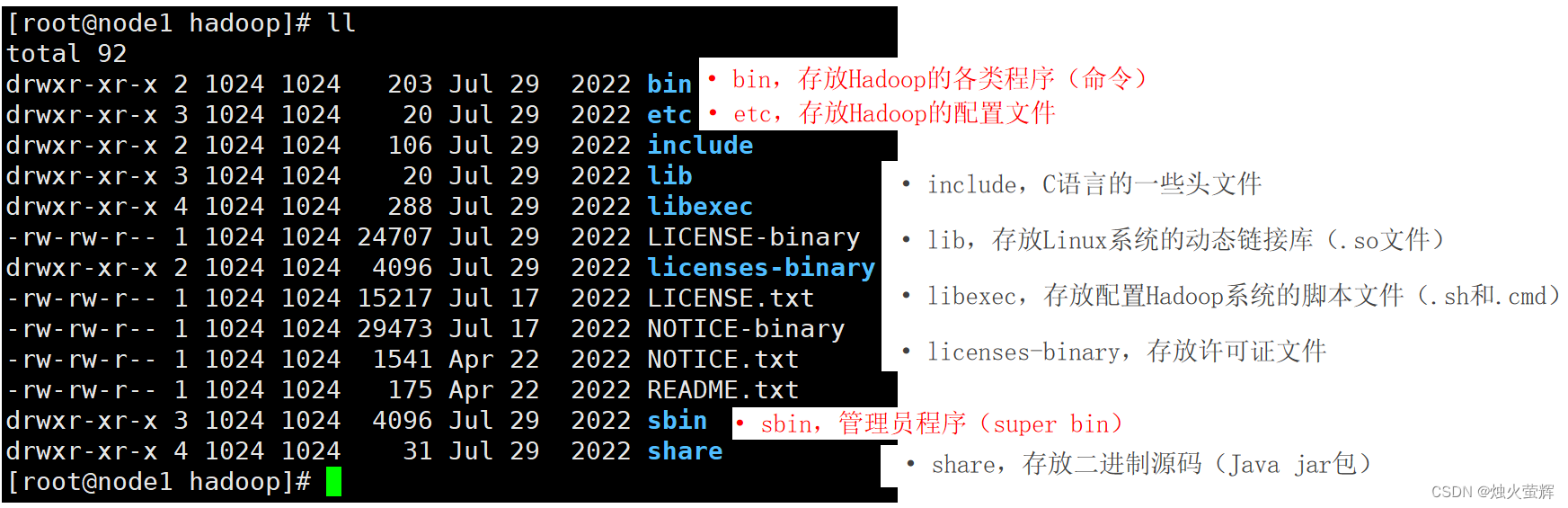

cd hadoopHadoop安装包的目录结构:

现在是集群部署的配置阶段,我们着重于etc目录。

2 进入etc目录下的hadoop目录

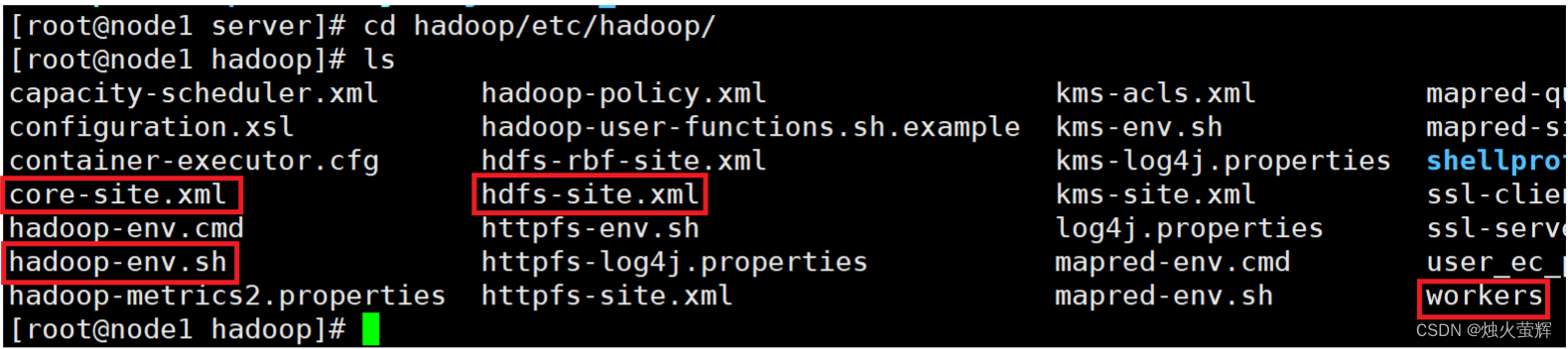

cd /etc/hadoop接下来主要要对以下四个文件进行配置:

3. 配置workers文件

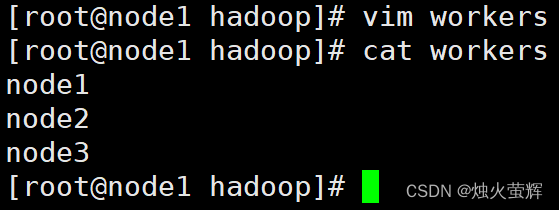

workers文件的作用是记录大数据集群中的从节点服务器。

配置步骤:

1. 使用vim打开workers: vim workers 2. 按i进入插入模式 3. 删除原来的lockhoot 4. 写入: node1 node2 node3 5. 按下Esc退出插入模式,按下Shift+:进入底行模式,按下wq!强制保存并退出。

4. 配置hadoop-env.sh文件

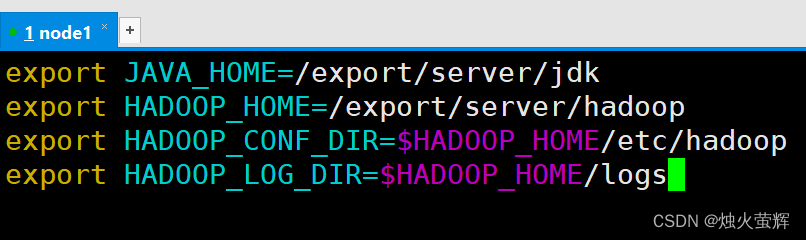

hadoop-env.sh文件的作用是记录Hadoop在运行时会用到的一些环境变量。

配置步骤:

1. 使用vim打开hadoop-env.sh: vim hadoop-env.sh 2. 按i进入插入模式 3. 找个空白的地方(最上面)写入: export JAVA_HOME=/export/server/jdk export HADOOP_HOME=/export/server/hadoop export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export HADOOP_LOG_DIR=$HADOOP_HOME/logs 4. 按下Esc退出插入模式,按下Shift+:进入底行模式,按下wq!强制保存并退出。 说明: JAVA_HOME,指明JDK环境的位置在哪 HADOOP_HOME,指明Hadoop安装位置 HADOOP_CONF_DIR,指明Hadoop配置文件目录位置 HADOOP_LOG_DIR,指明Hadoop运行日志目录位置 通过记录这些环境变量, 来指明上述运行时的重要信息

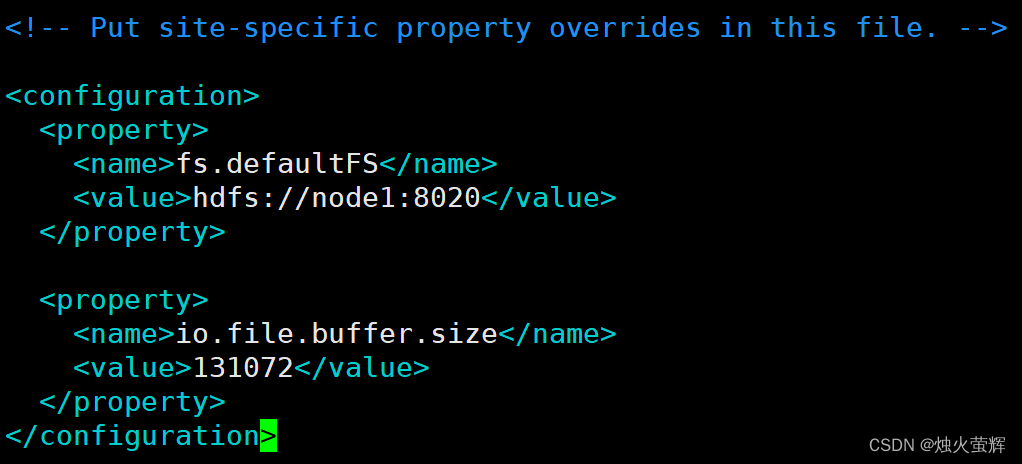

5.配置core-site.xml文件

该文件的作用是配置一些自定义设置,我们要在这里配置NameNode(主节点)的启动和缓冲区大小。

配置步骤:

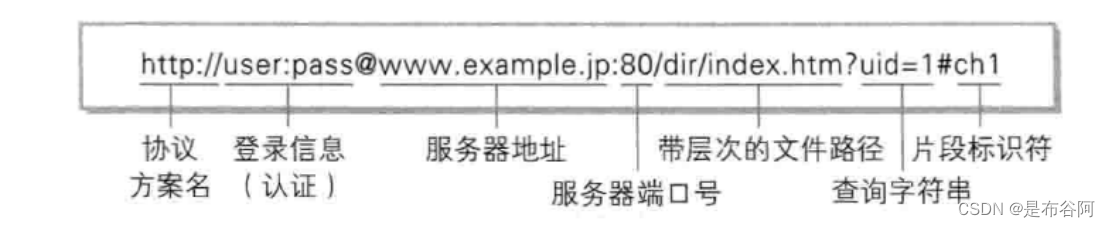

1. 使用vim打开core-site.xml: vim core-site.xml 2. 找到标签<configuration></configuration> 3. 按i进入插入模式,在标签中间写入: <property> <name>fs.defaultFS</name> <value>hdfs://node1:8020</value> </property> <property> <name>io.file.buffer.size</name> <value>131072</value> </property> 4. 按下Esc退出插入模式,按下Shift+:进入底行模式,按下wq!强制保存并退出。 说明: 1.key:fs.defaultFS 含义:HDFS文件系统的网络通讯路径 值:hdfs://node1:8020 协议为hdfs:// namenode(主节点)为node1 namenode(主节点)通讯端口为8020 2.key:io.file.buffer.size 含义:io操作文件缓冲区大小 值:131072 bit 3.hdfs://node1:8020为整个HDFS内部的通讯地址,应用协议为hdfs://(Hadoop内置协议) 表明DataNode(从节点)将和node1的8020端口通讯,node1是NameNode(主节点)所在机器 此配置固定了node1必须启动NameNode(主节点)进程

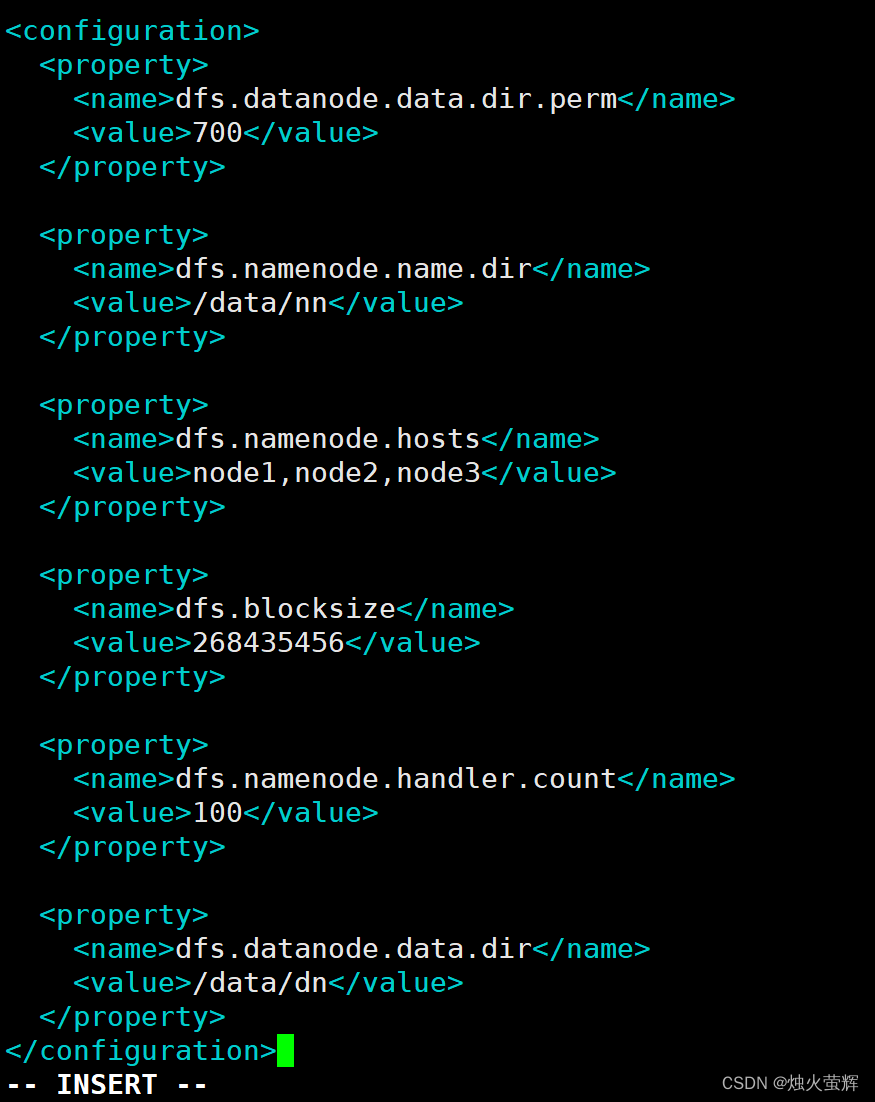

6.配置hdfs-site.xml文件

该文件的作用也是配置一些自定义设置,我们要在这里配置:默认创建的文件权限、主节点数据的存储位置、NameNode(主节点)允许哪几个节点的DataNode(从节点)连接(即允许加入集群)、hdfs默认块大小、Namenode(主节点)处理的并发线程数、从DataNode(从节点)的数据存储目录。

配置步骤:

1. 使用vim打开hdfs-site.xml: vim hdfs-site.xml 2. 找到标签<configuration></configuration> 3. 按i进入插入模式,在标签中间写入: <property> <name>dfs.datanode.data.dir.perm</name> <value>700</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/data/nn</value> </property> <property> <name>dfs.namenode.hosts</name> <value>node1,node2,node3</value> </property> <property> <name>dfs.blocksize</name> <value>268435456</value> </property> <property> <name>dfs.namenode.handler.count</name> <value>100</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/data/dn</value> </property> 4. 按下Esc退出插入模式,按下Shift+:进入底行模式,按下wq!强制保存并退出。 说明: 1.key:dfs.datanode.data.dir.perm 含义:hdfs文件系统,默认创建的文件权限设置 值:700,即:rwx------ 2.key:dfs.namenode.name.dir 含义:NameNode(主节点)元数据的存储位置 值:/data/nn,在node1节点的/data/nn目录下 3.key:dfs.namenode.hosts 含义:NameNode(主节点)允许哪几个DataNode(从节点)连接(即允许加入集群) 值:node1、node2、node3,这三台服务器被授权 4.key:dfs.blocksize 含义:hdfs默认块大小 值:268435456(256MB) 5.key:dfs.namenode.handler.count 含义:Namenode(主节点)处理的并发线程数 值:100,以100个并行度处理文件系统的管理任务 6.key:dfs.datanode.data.dir 含义:DataNode(从节点)的数据存储目录 值:/data/dn,即数据存放在node1、node2、node3,三台机器的/data/dn内

7. 准备数据目录

在之前的配置中,只是指定了主节点和从节点的数据放在哪个文件,但我们还没有真正的创建这些文件,现在我们就是要创建这些文件。

在上一步中的配置中,我们把 namenode数据存放在node1虚拟机的/data/nn目录下;datanode数据存放在node1、node2、node3虚拟机的/data/dn目录下。

所以我们要在node1虚拟机创建/data/nn目录和/data/dn目录;在node2、node3虚拟机创建/data/dn目录(不要少了data前面的/)。

步骤:

1.在node1虚拟机: mkdir -p /data/nn mkdir -p /data/dn 2.在node2和node3虚拟机: mkdir -p /data/dn

8. 分发Hadoop文件夹

目前,已经基本完成Hadoop的配置操作,可以从node1将hadoop安装文件夹远程复制到node2、node3(通过scp命令)。

步骤:

1. 在node1虚拟机执行如下命令 cd /export/server scp -r hadoop-3.3.4 node2:`pwd`/ scp -r hadoop-3.3.4 node3:`pwd`/ 2. 在node2执行如下命令,为hadoop配置软链接 ln -s /export/server/hadoop-3.3.4 /export/server/hadoop 3. 在node3执行如下命令,为hadoop配置软链接 ln -s /export/server/hadoop-3.3.4 /export/server/hadoop

三、配置环境变量

为了方便我们操作Hadoop,可以将Hadoop的一些脚本、程序配置到PATH中(通过配置profile文件),方便后续使用。

1. 修改/etc目录下的profile文件:

1. 使用vim打开/etc下的profile文件: vim /etc/profile 2. 按i进入插入模式,在末尾追加写入: export HADOOP_HOME=/export/server/hadoop export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin 3. 按下Esc退出插入模式,按下Shift+:进入底行模式,按下wq!强制保存并退出。

2. 启动上面的配置

source /etc/profile

3. 在node2和node3虚拟机中重复上面的步骤。

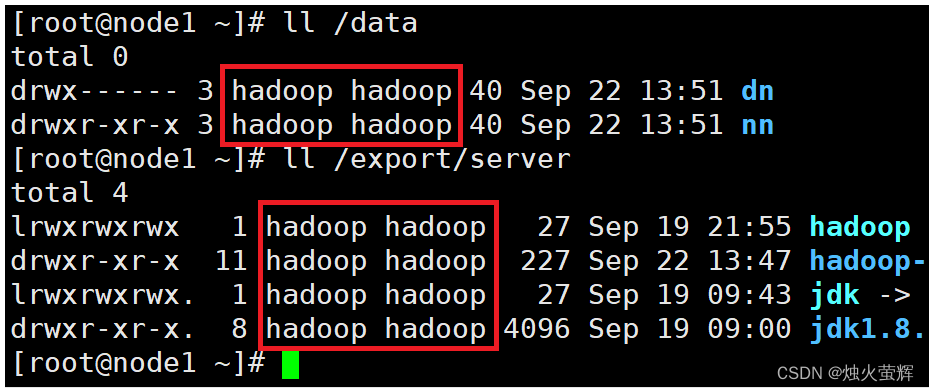

四、为Hadoop用户授权

到了这里,hadoop部署的准备工作基本完成,为了确保安全,hadoop系统不以root用户启动,我们以普通用户hadoop来启动整个Hadoop服务。所以,现在需要对文件权限进行授权。

1. 以root身份,在node1、node2、node3三台虚拟机上均执行如下命令:

# 以root身份,在三台服务器上均执行 chown -R hadoop:hadoop /data chown -R hadoop:hadoop /export

2. 检查

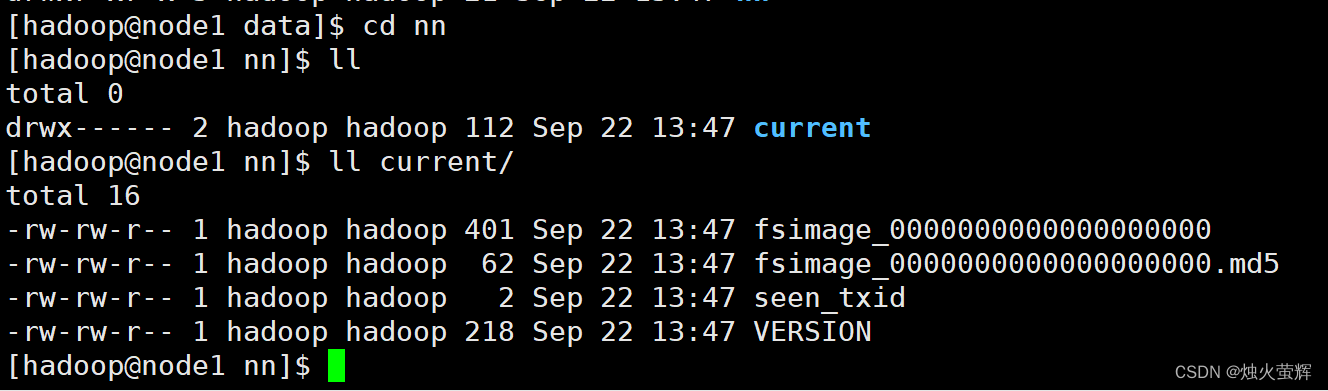

五、格式化HDFS文件系统

前期准备全部完成,现在对整个文件系统执行初始化,以下命令在主节点虚拟机node1中执行即可。

1. 格式化namenode

1. 在主节点虚拟机node1中切换到hadoop用户 su - hadoop 2. 格式化namenode hadoop namenode -format这样表示格式化成功了

2. 一键启动hdfs集群

1. 回到根目录 cd 2. 一键启动hdfs集群 start-dfs.sh

3. 使用jps检查运行中的进程

在终端中输入jps,如果显示内容像图片中的一样基本上表示整个配置都成功了:

如果jps中没有Datanode,证明clusterID有问题:

原因是多次格式化NameNode会重新生成新的clusterID(集群ID)

我们要做的是在主节点node1下找到正确的clusterID,然后更改所有从节点的clusterID。

步骤:

1. 进入node1虚拟机下的/data/nn/current/目录 cd /data/nn/current/ 2. 打开VERSION文件 vim VERSION 3. 复制clusterID 4. 退出,然后进入/data/dn/current/目录 cd /data/dn/current/ 5. 打开VERSION文件, 然后用刚才复制的内容替换这里的clusterID 6. 进入node2虚拟机下的/data/dn/current/目录 cd /data/dn/current/ 7. 打开VERSION文件, 然后用刚才复制的内容替换这里的clusterID 8. 进入node3虚拟机下的/data/dn/current/目录 cd /data/dn/current/ 9. 打开VERSION文件, 然后用刚才复制的内容替换这里的clusterID

4. 查看HDFS WEBUI

启动Hadoop后,可以在浏览器打开: http://node1:9870,即可查看到hdfs文件系统的管理网页。

能够打开这个网址,且Live Nodes 为3,就表示我们的Hadoop部署完全成功了!

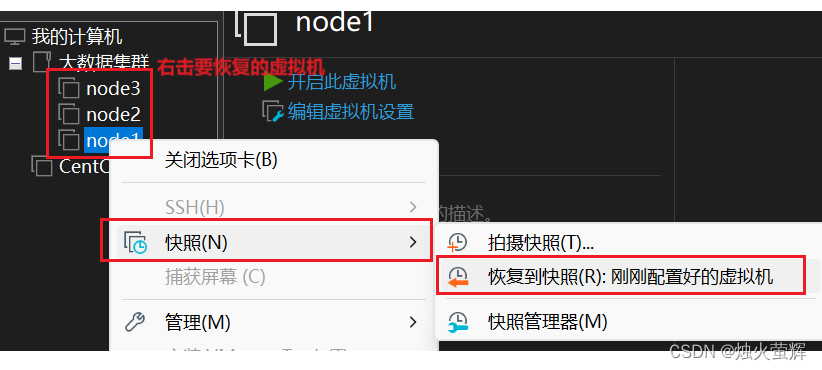

六、拍摄快照保存配置好的虚拟机

0. 为什么需要拍摄快照?

拍快照相当于给当前虚拟机的配置做一个备份,将来有问题,直接按照快照还原虚拟机即可,不需要删除再重新配置。

1. 在VMware将所有虚拟机关机

2. 拍摄快照

3. 如何使用快照恢复?

七、启动和关闭HDFS集群

Hadoop HDFS组件内置了HDFS集群的一键启停脚本。

1. 一键启动HDFS集群

$HADOOP_HOME/sbin/start-dfs.sh

2. 一键关闭HDFS集群

$HADOOP_HOME/sbin/stop-dfs.sh

关闭虚拟机前一定要先关闭HDFS集群,然后用 init 0 断开Xshell等远程连接!

------------------------END-------------------------

才疏学浅,谬误难免,欢迎各位批评指正。

![[python 刷题] 22 Generate Parentheses](https://img-blog.csdnimg.cn/8f3371ebbab34d0398675a1f2ca312bc.jpeg#pic_center)