引言

今天带来第五篇大模型微调论文笔记P-tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Across Scales and Tasks。

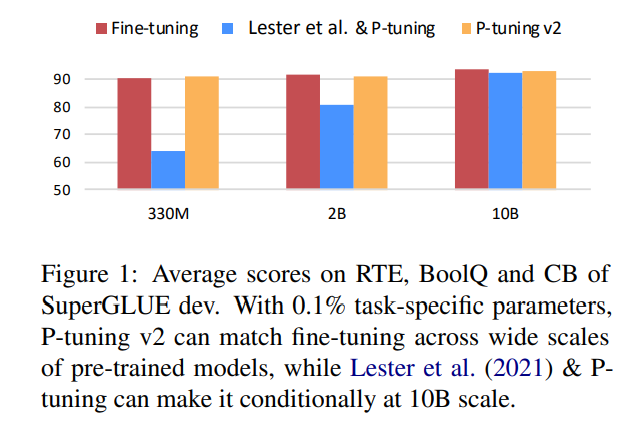

作者首先指出了prompt tuning的一些不足,比如在中等规模的模型上NLU任务表现不好,还不能处理困难的序列标记任务,缺乏统一应用的能力。

然后作者发现经过适当优化的prompt tuing可以在各种模型规模和自然语言理解任务中都具有普遍有效性。仅需要调整0.1%-3%的参数就可以达到媲美(全量)微调的效果。

作者的P-tuning v2是一种深度提示微调(Deep Prompt Tuning)的优化并适配了NLU。

总体介绍

提示微调(prompt tuning)仅调整连续的提示,但在模型规模不是足够大时,它的表现还是不能媲美全量微调,尤其是少于10B的模型。

本文的主要贡献是经过适当优化的提示微调可以在各种模型规模和自然语言理解任务中与全量微调相媲美。

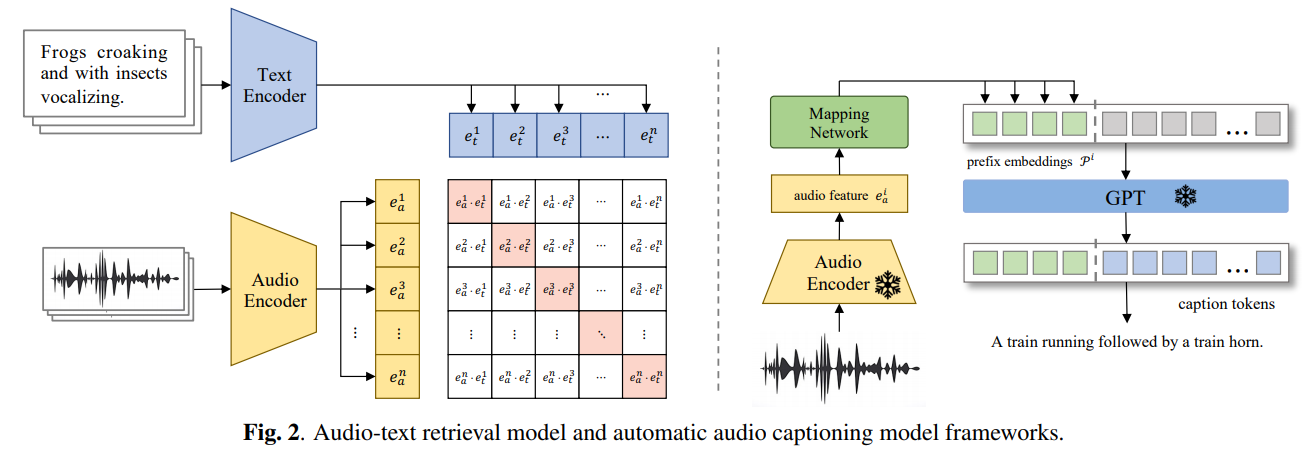

P-tuning v2可以将它视为专为生成和知识探索而设计的深度提示微调的优化和适配实现。最显著的改进是将连续提示应用于预训练模型的每一层,而不仅仅是输入层。深度提示微调增加了连续提示的容量,并在各种设置下缩小了与微调的差距,特别是对于小型模型和困难任务。

背景知识

提示微调