文章目录

- 前言

- 一、视觉-语言-动作(VLA)模型

- 二、利用 VLM 控制机器人

- 三、实验

- 四、 Demo

- 五、总结

前言

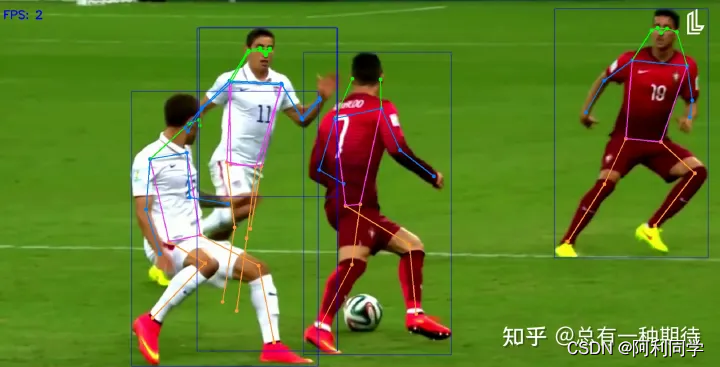

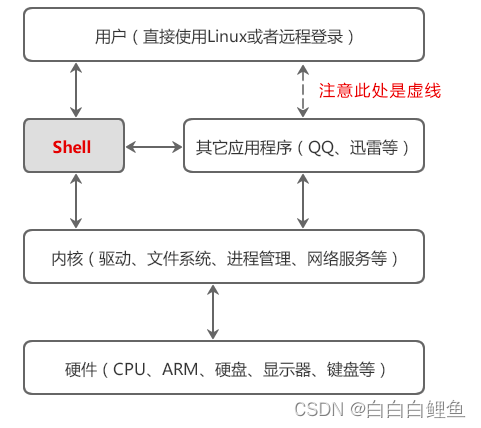

Robotic Transformer 2(RT-2)是由谷歌 DeepMind 新推出的大语言模型,它为人类提供了通过纯语言命令来优化机器人控制的能力。与此前的大模型不同,RT-2是一种新型的视觉-语言-动作(VLA)模型,它可以从网络和机器人数据中学习,并将这些知识转化为机器人控制的通用指令,帮助机器人在现实环境中完成各种复杂任务,同时提高机器人的适应性和判断推理能力。

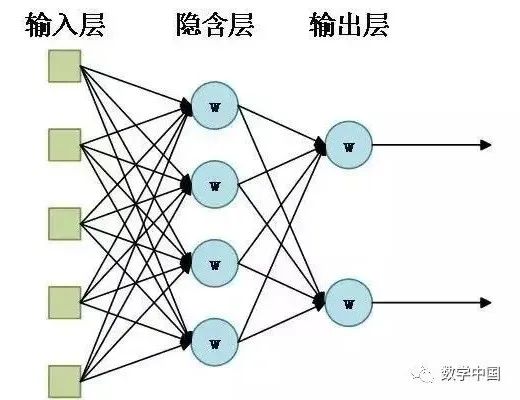

高容量的视觉-语言模型(VLM)是在网络规模的数据集上训练的,使得这些系统在识别视觉或语言模式并跨越不同语言方面表现出色。但是,为了使机器人达到类似的能力水平,它们需要首先收集机器人数据,涵盖每个对象、环境、任务和情况。

在RT-2的论文(