-

对于 Client 来讲,setupConnection 中的 cm_id 应该是本地的,意味着后续 create pd \ cq \ qp 等等传入的 cm_id 都是本地 id。但是对于 Server 来讲,收到 client 的链接请求时将 client 的 cm_id 传入 setupConnection,意味着后续 create pd \ cq \ qp 等等传入的 cm_id 都是远端 id。为什么?

-

因为所有的 create_xxx 操作都需要 ibv 的链接信息,资源是服务于链接的。

-

在 rdma_create_qp 的介绍中说到,传入的 cm_id 必须要拥有链接信息,否则会创建失败,这就是解释了为什么 Server 调用时不能传入自己的 local_cm_id,因为此时 Server 的 cm_id 是没有链接信息的,所以失败。

-

那么为什么 Client 可以传入自己的 local_cm_id 呢。因为在 Client 在 create_xxx 之间,首先进行了地址解析:

-

rdma_resolve_addr(client_id_, nullptr, dst_addr_->ai_addr, DEFAULT_CONNECTION_TIMEOUT); rdma_resolve_route(client_id_, DEFAULT_CONNECTION_TIMEOUT); -

这些操作会将 Client <-> Server 的一些链接信息存入 cm_id , 比如 addr、route 什么的,之后 cm_id 就具有了链接信息,可以通过其创建资源。

-

同理,Server 拿到 Client 的 cm_id 后要用它来创建资源

-

附上一张官方的 cm 建链流程:

-

-

ibv_destroy_cq 和 rdma_destroy_id 会卡住,有什么头绪吗?

-

ibv 博客里这么解释:

-

There is at least one affiliated asynchronous event on that CQ that was read without a proper acknowledgement.

-

意思是还有 event 没有发 ack。最后 debug 确实是这样,Server 收到 DISCONNECT 时,没有 ack 就调用了 ibv_destroy_cp ,然后就一直卡住。

-

去看了下源码,发现 ibv_destroy_cp 一直往后调用有这么一句话:

-

int ibv_cmd_destroy_cq(struct ibv_cq *cq) { // ... while (cq->comp_events_completed != resp.comp_events_reported || cq->async_events_completed != resp.async_events_reported) // ... } -

cq 里其实是有一个 event channel 的:

-

struct ibv_cq { struct ibv_comp_channel *channel; } -

说白了应该就是要等所有的 event 全部完毕才能 destroy,否则卡住。

-

-

cm_id 是对应节点还是对应 qp ?

- 应该是对应 qp

-

Client rdma_disconnect 之后,rdma_get_cm_event 堵住了。按理说是不应该的,因为当任意一端启动 rdma_disconnect 后,会在两端均产生 RDMA_CM_EVENT_DISCONNECTED 事件。

-

官方解释是这么说的:

-

After successfully disconnecting, an RDMA_CM_EVENT_DISCONNECTED event will be generated on both sides of the connection.

-

意思是成功 disconnect 之后才会在双端产生事件。首先,当 Client 调用 rdma_disconnect 后,Server 会立刻产生该事件,但是 Client 不会,只有当 disconnect “完成” 之后,才会产生事件。那么问题就在于这个 “完成” 指什么。

-

经过多次尝试,发现这个 “完成” 是指 Server 端释放所有 Connection 资源,也就是 ibv_destroy_xxx。因此该 bug 产生的原因是 Server 收到 Client 的 disconnect 请求后没有即使释放资源,导致 Client 一直收不到事件。

-

RDMA 相关bug记录

news2026/2/13 16:30:11

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/979742.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

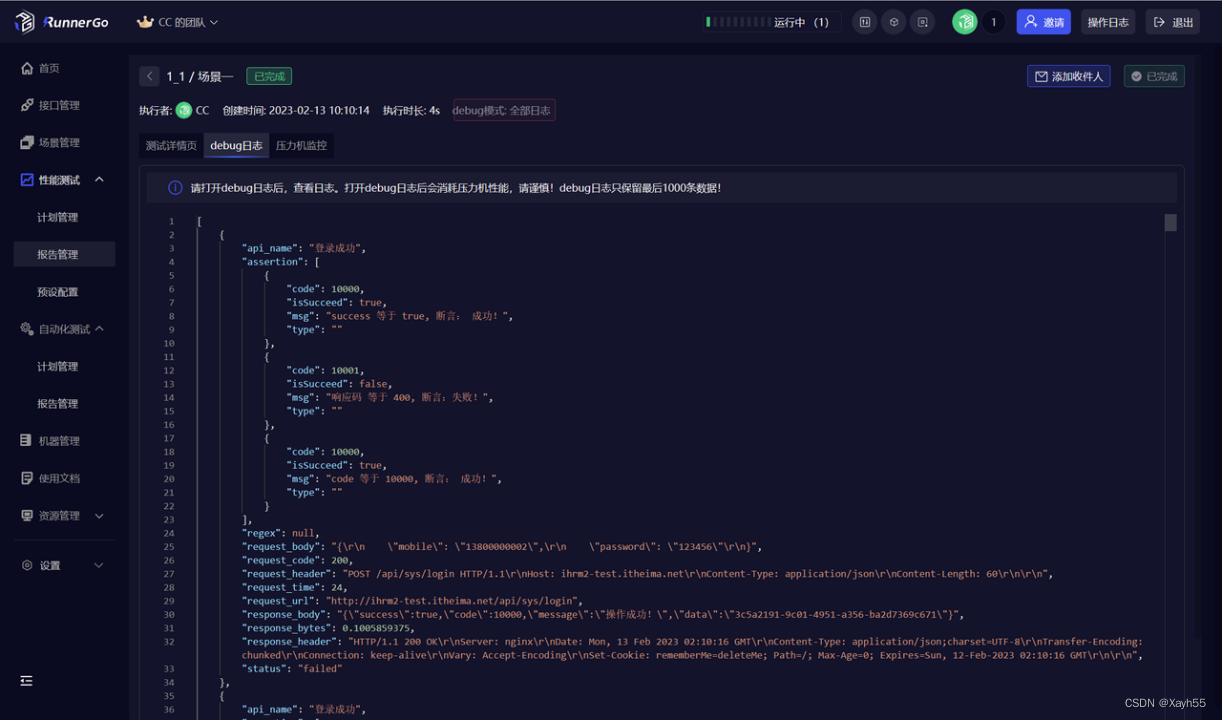

RunnerGo怎么做性能测试

RunnerGo是一个功能强大,使用简单的性能测试平台,它基于go语言开发,支持接口管理、自动化测试、性能测试等功能。

RunnerGo有什么特点

支持并发模式、错误率模式、阶梯模式、每秒请求数模式、响应时间模式等多种压测模式,支持自…

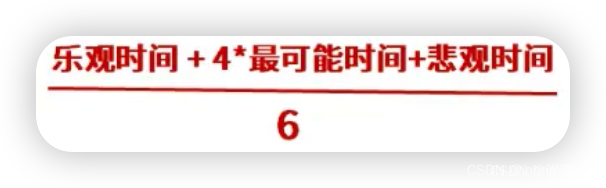

软考高级之系统架构师之项目管理

今天是2023年09月06日,距离软考高级只有58天,加油!

概念

临时性:是指每一个项目都有一个明确的开始时间和结束时间,临时性也指项目是一次性的。

风险

风险具有以下特性:客观性、偶然性、相对性、社会性…

【探索Linux】—— 强大的命令行工具 P.8(进程优先级、环境变量)

阅读导航 前言一、进程优先级1. 优先级概念2. Linux查看系统进程3. PRI(Priority)和NI(Nice) 二、环境变量1. 概念2. 查看环境变量方法3. 环境变量的组织方式4.通过代码获取环境变量5. 环境变量的特点 总结温馨提示 前言

前面我们…

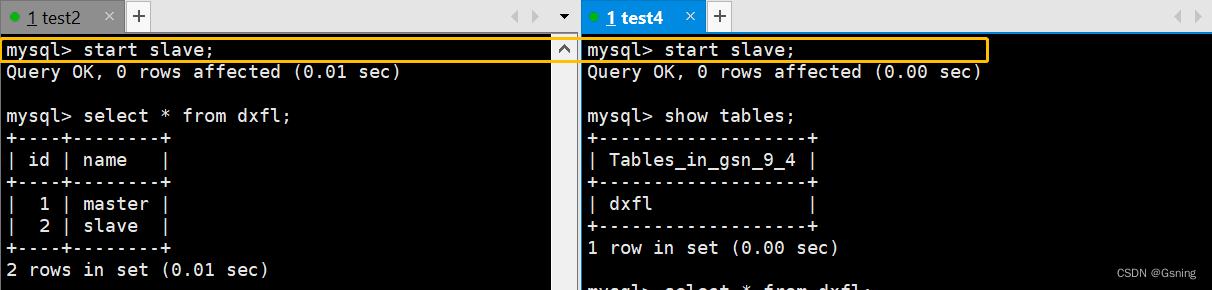

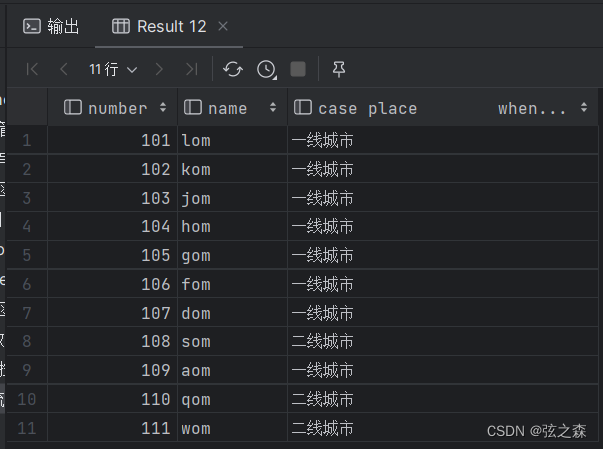

MySQL主从复制读写分离

读写分离

读写分离,基本的原理是让主数据库处理事务性增、改、删操作(INSERT、UPDATE、DELETE),而从数据库处理SELECT查询操作。数据库复制被用来把事务性操作导致的变更同步到集群中的从数据库 读写分离的好处

因为数据库的“写…

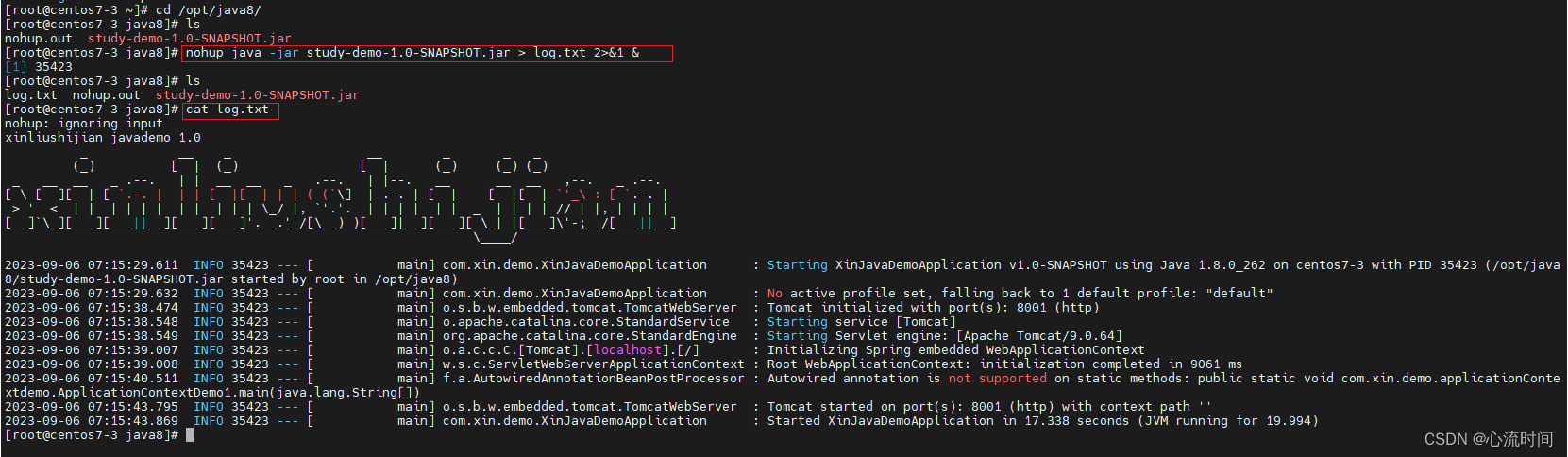

在Linux系统启动java程序(jar包)

文章目录 1. mvn install生成jar包2. 利用ftp工具将jar包上传到linux服务器3. 在linux服务器上启动jar包3.1 直接启动jar包3.2 后台启动jar包3.3 后台不挂断启动jar包3.4 后台不挂断启动jar包并输出日志到指定文件3.5 其他 1. mvn install生成jar包 2. 利用ftp工具将jar包上传到…

小程序中如何查看会员的积分和变更记录

积分是会员卡的一个重要功能,可以用于激励会员消费和提升用户粘性。在小程序中,商家可以方便地查看会员卡的积分和变更记录,以便更好地了解会员的消费行为和积分变动情况。下面将介绍如何在小程序中查看会员卡的积分和变更记录。

1. 找到指…

Android Ble蓝牙App(七)扫描过滤

Ble蓝牙App(七)扫描过滤 前言目录正文一、增加菜单二、使用MMKV① 添加依赖② 封装MMKV③ 使用MMKV 三、过滤空设备名四、过滤Mac地址五、过滤RSSI六、源码 前言 在上一篇文章中了解了MTU的相关知识以及对于设备操作信息的展示,本篇文章中将增…

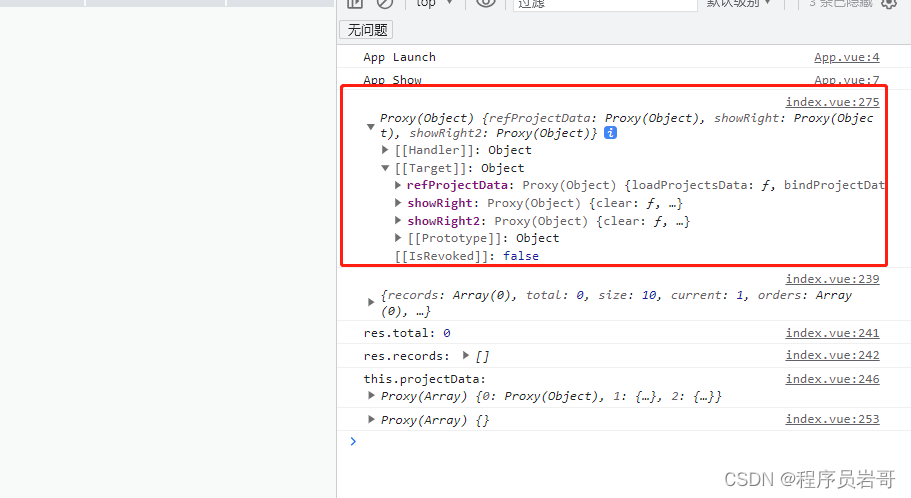

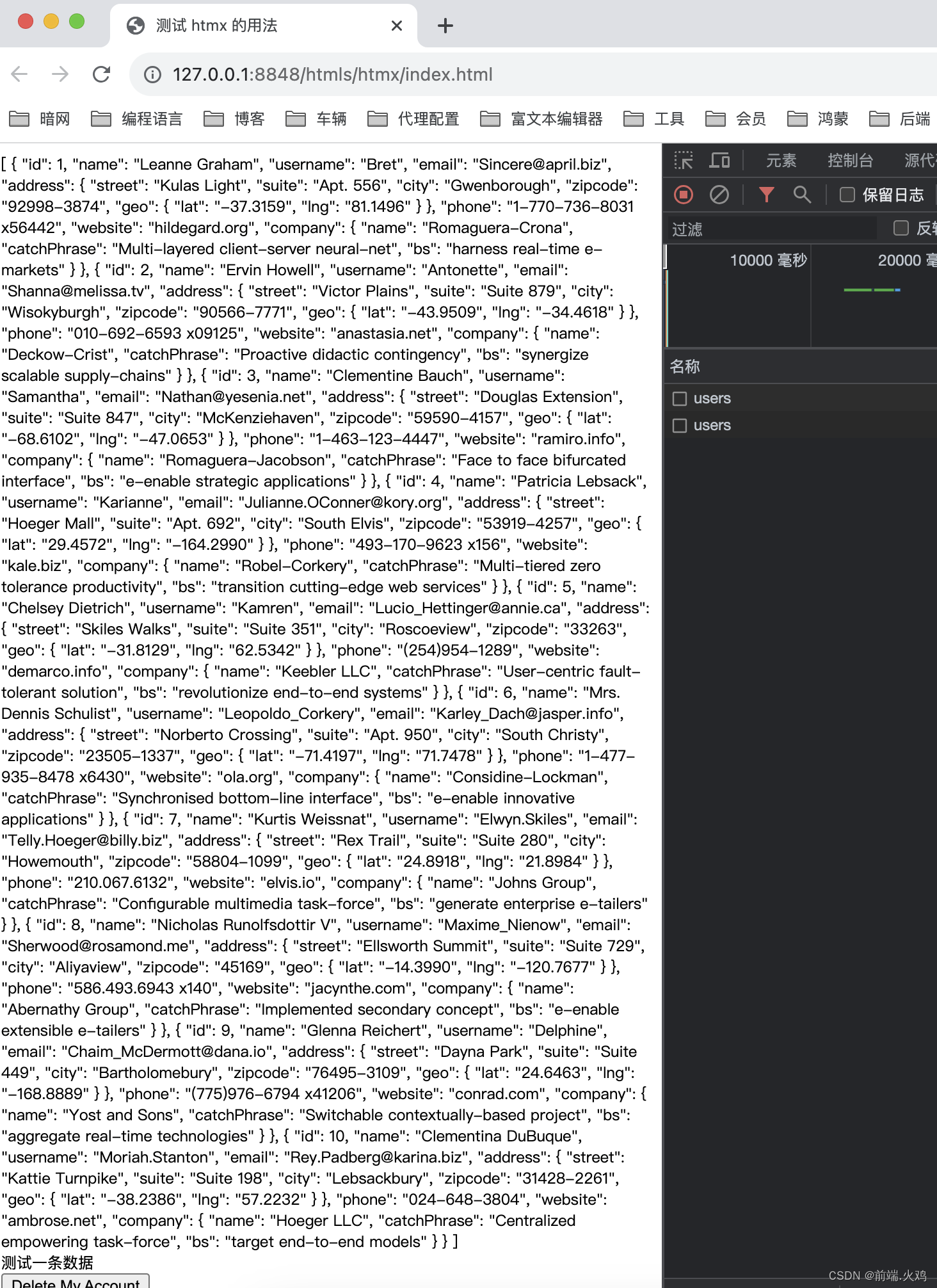

uniapp 在 onLoad 事件中 this.$refs 娶不到的问题

现象

本人想在主页面加载的时候调用子组件的方法。示例代码如下: 运行,发现 this.$refs 取不到。如下图所示: 解决方法,把onLoad 换为 onReady 就可以了。

存储过程报Illegal mix of collations错误的解决方法

CREATE PROCEDURE maxAgeStudent(IN _gender CHAR)

BEGINDECLARE maxage INT DEFAULT 0;SELECT max(age) INTO maxage FROM student where gender _gender;SELECT * from student WHERE age maxage and gender _gender;

END;

在调用的时候

call maxAgeStudent(1)

产生了报…

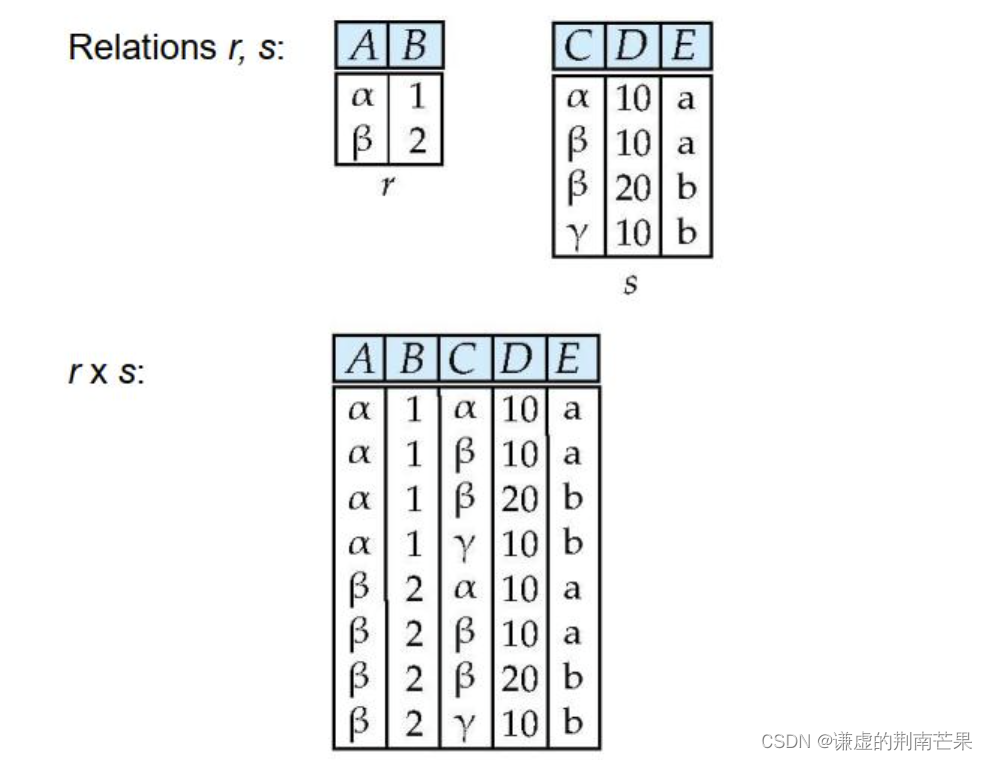

MySQL数据库的增删改查(进阶)

目录

数据库约束

约束类型

NULL约束

UNIQUE:唯一约束

DEFAULT:默认值约束

PRIMARY KEY:主键约束

FOREIGN KEY:外键约束

表的设计

一对一关系 一对多关系

多对多关系

查询

聚合查询

聚合函数

GROUP BY子句

HAVING …

LeetCode 1123. 最深叶节点的最近公共祖先:DFS

【LetMeFly】1123.最深叶节点的最近公共祖先

力扣题目链接:https://leetcode.cn/problems/lowest-common-ancestor-of-deepest-leaves/

给你一个有根节点 root 的二叉树,返回它 最深的叶节点的最近公共祖先 。

回想一下:

叶节点 是二叉树…

2023年09月在线IDE流行度最新排名

点击查看最新在线IDE流行度最新排名(每月更新)

2023年09月在线IDE流行度最新排名

TOP 在线IDE排名是通过分析在线ide名称在谷歌上被搜索的频率而创建的

在线IDE被搜索的次数越多,人们就会认为它越受欢迎。原始数据来自谷歌Trends 如果您相…

十六、MySQL常用函数有哪些?

1、函数 说到函数,就必须知道其本质是什么,在MySQL中,函数是指一段可以直接被另一段程序调用的程序或代码。

2、字符串函数

(1)函数 (2)字符串连接函数

字符串连接函数:

select c…

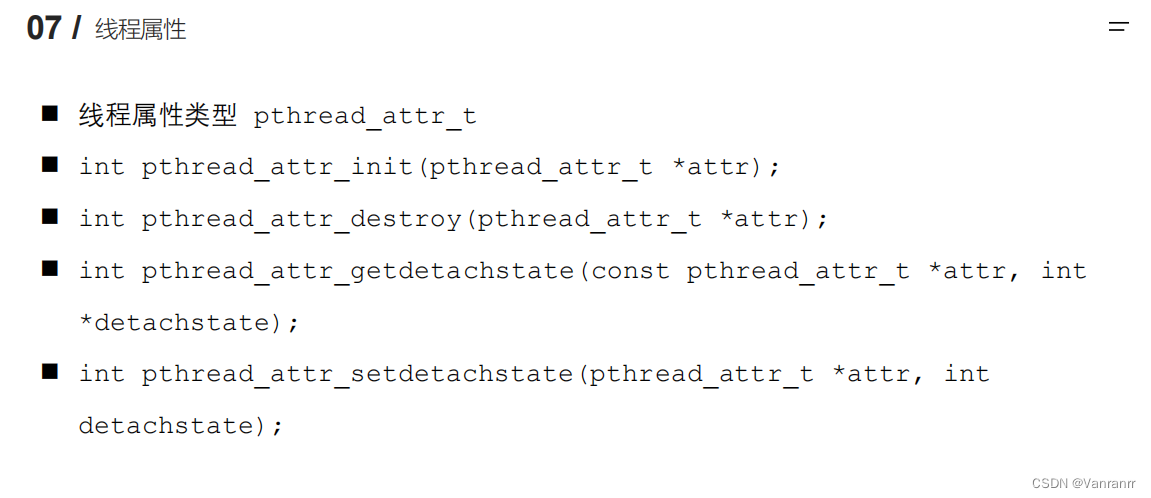

第三章 LInux多线程开发 3.1-3.5线程创建 终止 分离

创建线程:(好好记住 可能会叫写代码)

一般情况下,main函数所在的线程我们称之为主线程(main线程),其余创建的线程称之为子线程。 程序中默认只有一个进程,fork()函数调用,2进行 程序…

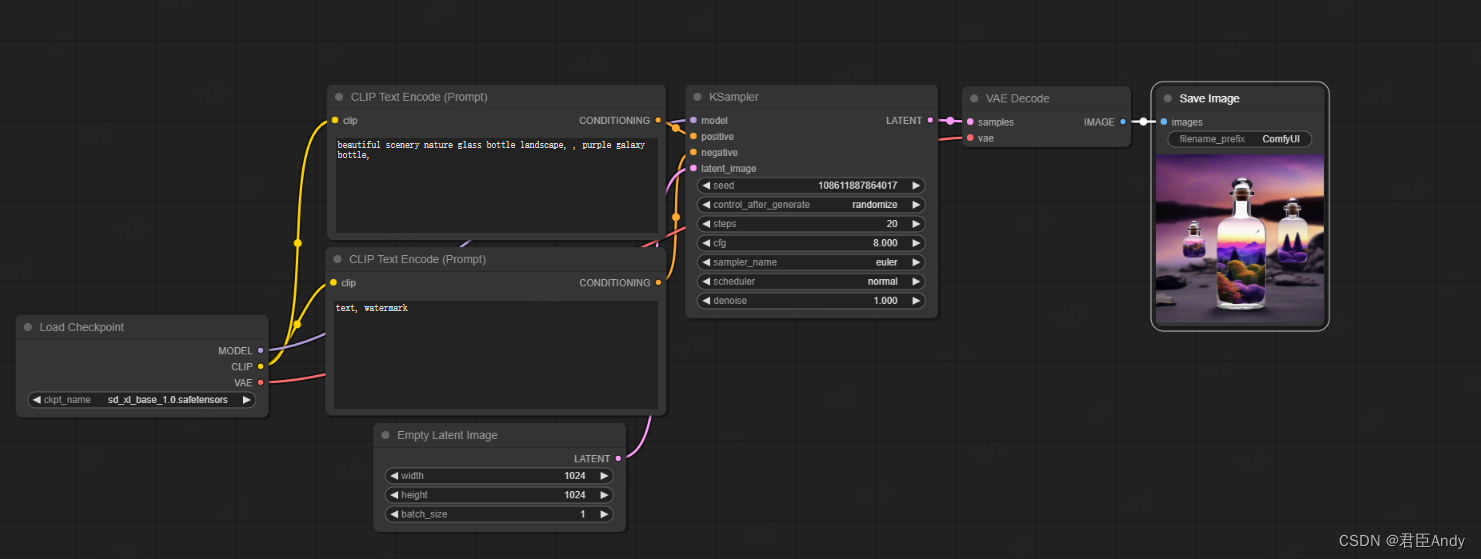

ComfyUI 安装

背景:

stable diffussion XL最先适配,专业性强的SD操作界面 安装步骤:

git clone GitHub - comfyanonymous/ComfyUI: A powerful and modular stable diffusion GUI with a graph/nodes interface.

1、pip install torch torchvision torc…

【压力测试指南】没有任何文档,小白也可以做的压力测试

前言

一般在执行压力测试之前,会由开发提供出接口文档,包含一些接口的详细参数,便于测试工程师编写测试脚本。但在某些情况下,接口等相关文档缺失,那作为Tester,我们该如何顺利的实施压力测试呢࿱…

问道管理:光刻胶概念再度活跃,广信材料两连板,蓝英装备等涨停

光刻胶概念6日盘中再度活泼,截至发稿,扬帆新材、广信资料、蓝英配备“20cm”涨停,盛剑环境亦涨停,高盟新材涨超9%,同益股份、容大感光涨超5%。

值得注意的是,广信资料已连续两个交易日涨停。公司近来在成绩…

快速回顾Intel的发展史,看看你都用过哪些处理器

前言

提到CPU我们第一个想起的就是Intel其次才是AMD,有计算机的地方就有它的身影,Intel一直占据着半导体金字塔的顶端,也一直牵制着整个PC市场,这些年间Intel发布了各种各样的CPU,我大体给大家总结一下,看…