文章目录

- Abstract

- Introduction

论文题目: Physical Backdoor Attacks to Lane Detection Systems in Autonomous Driving(自动驾驶中车道检测系统的物理后门攻击)

发表年份: 2022-MM(ACM International Conference on Multimedia, CCF-A)

作者信息: Xingshuo Han(南洋理工大学), Guowen Xu(南洋理工大学), Yuan Zhou*(南洋理工大学), Xuehuan Yang(南洋理工大学), Jiwei Li(南洋理工大学), Tianwei Zhang(南洋理工大学)

备注: 一篇关于Lane Detection 攻击的文献

Abstract

现代自动驾驶汽车采用最先进的DNN模型来解释传感器数据和感知环境。然而,DNN模型容易受到不同类型的对抗攻击,对车辆和乘客的安全构成重大风险。一个突出的威胁是后门攻击,敌手可以通过毒害训练样本来破坏DNN模型。尽管对传统计算机视觉任务的后门攻击进行了大量的研究,但其在自动驾驶场景中的实用性和适用性还很少探索,尤其是在物理世界中。

本文的目标是车道检测系统,它是许多自动驾驶任务不可或缺的模块,如导航、车道切换。设计并实现了针对该系统的第一次物理后门攻击。我们的攻击对不同类型的车道线检测算法都是有效的。引入了两种攻击方法(poison-annotation和clean-annotation)来生成中毒样本。使用这些样本,训练好的车道检测模型会被后门感染,并可能被常见物体(如交通锥)激活,从而做出错误的检测,导致车辆驶离道路或驶入对面车道。对公开数据集和物理自动驾驶汽车的广泛评估表明,所提出的后门攻击是有效的、隐形的和鲁棒的,可以抵抗各种防御解决方案。我们的代码和实验视频可以在 https://sites.google.com/view/lane-detection-attack/lda 上找到。

Introduction

深度学习技术的快速发展,提高了自动驾驶汽车的感知能力,使其能够理解环境并做出智能行动。车辆从传感器收集多种类型的数据,并使用DNN模型来完成不同的功能。车道线检测是一个重要的功能,旨在从摄像头拍摄的图像或视频中识别出交通车道线。该功能对于自动驾驶的车道跟随、变道和超车至关重要。近年来,大量基于深度学习的算法和方法被引入,显著提高了检测精度和实时性[17,22,24,31,35,36,46,47,67]。

不幸的是,过去的研究表明,深度神经网络模型不是鲁棒的,很容易被恶意实体欺骗。一个臭名昭著的威胁是DNN后门[12,13,32,57]。攻击者通过毒害训练集在受害者模型中嵌入一个秘密后门。这个后门在正常输入推断样本中保持休眠状态。它会被恶意样本激活,这些样本包含一个针对对手的触发器,误导受感染的模型给出错误的预测。研究人员提出了各种针对计算机视觉[3,21,27,33,34,54,58],自然语言处理[5,10,44,60],强化学习[25,53,65]等DNN模型的新攻击。然而,没有研究调查后门机会对车道检测系统。

本文旨在通过设计和实现物理世界中车道检测DNN模型的第一个实际后门攻击来弥合这一差距。实现这一目标有几个挑战。首先,现有的工作主要集中在数字世界中的后门攻击,攻击者可以任意操纵输入样本来添加触发器(例如,改变图像中的一个像素块)。由于数字世界和物理世界之间的语义差距,很难利用这些技术来攻击现实生活中的应用程序。一些作品随后在现实世界中实施物理后门攻击[6,26,40,55,64]。然而,这些方法主要针对的是人脸分类模型。与之不同的是,车道检测模型不能预测标签,这增加了有毒样本生成的难度。此外,攻击人脸分类模型所使用的物理触发器,由于两种场景的语义差异,无法应用于车道检测。物理触发器需要仔细地重新设计。

笔记: 1.现有的工作集中在数字世界的后门攻击;2.由于数字世界和物理世界存在差距,很难用这些技术来攻击现实生活中的应用程序;3.一些工作随后在现实世界中实施物理的后门攻击;4.然而这些方法主要是针对人脸分类模型的,车道检测模型不适用。

其次,为了使后门更具隐蔽性,过去的工作提出了针对分类模型的清洁标签攻击(clean-label attacks),其中中毒样本仍然具有正确的标签,从而使模型妥协[43,66]。这是通过添加对抗性扰动来改变这些中毒样本的类别来实现的。由于车道检测模型不能预测类别,因此很难利用这些解决方案来生成视觉上正常的中毒样本。

第三,现有后门攻击在毒害数据样本时只针对特定的深度学习算法(如分类)。然而,这并不适用于车道检测场景,它可以使用不同的算法来训练模型,例如基于分割的[35]或基于锚点的[46]方法。生成统一的中毒样本是一项具有挑战性的工作,它可以攻击任何车道检测模型,而不管其算法如何。

笔记: 现有的backdoor attack在毒害数据样本时只针对特定的深度学习算法,比如分类算法。而车道检测场景中可以使用不同的算法(如:基于分割的车道检测、基于锚点的车道检测)来训练模型,因此生成统一的中毒样本(poisoned samples)是一项挑战性的工作。

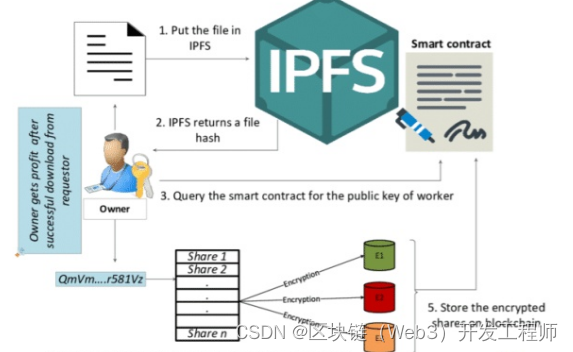

我们提出的攻击可以通过一些创新来解决上述挑战。首先,我们提出了自动驾驶环境下语义触发器的新设计。在研究了一些主流的交通数据集后,我们选择了一组具有特定形状和位置的两个交通锥作为触发后门的触发器(trigger)。这个触发器在道路环境中看起来很自然,很难被注意到。同时,它也足够独特,不会影响自动驾驶的正常情况。其次,我们引入了两种新的方法来毒化训练样本和操纵注释以实现后门嵌入。(1)Poison-annotation攻击:攻击者可以通过故意用触发器错误注释样本来制作有毒样本。(2) Clean-annotation攻击:该技术利用图像缩放漏洞[56]来隐藏恶意样本的异常。具体来说,我们创建了有毒的样本,它在视觉上与干净的样本相似,具有正确的注释,没有触发器。经过图像缩放后,这些样本会给出错误的车道边界和一个触发点,成为后门嵌入的有效手段。这两种方法都是算法无关的:毒害数据集不需要了解所采用的算法,结果表明:中毒样本对不同模型和算法都是有效的。这大大增强了攻击的威力和适用性。

笔记: 1.创建有毒样本(视觉上与干净样本类似,具有正确的annotation,没有触发器);2.经过图像缩放后,这些样本会给出错误的车道边界和一个触发点,成为后门嵌入的有效手段。

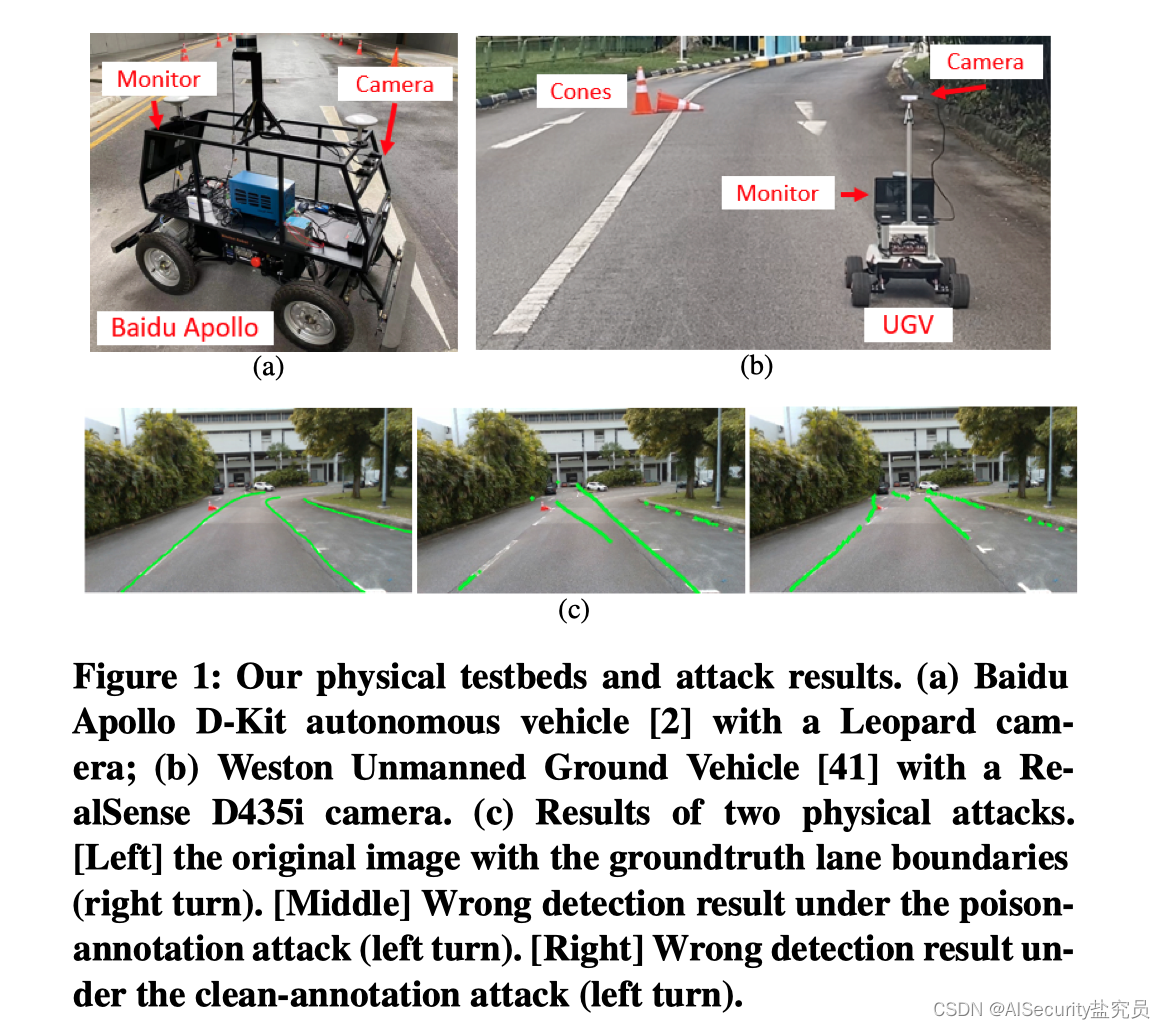

我们对四种现代车道检测模型实施后门攻击。在公共数据集上的评估表明,我们的攻击在注入不到3%的中毒数据的情况下,可以达到96%左右的成功率。使用两辆无人车(图1(a))在物理环境中运行现成的自动驾驶软件系统,进一步验证了攻击的有效性和鲁棒性。如图1(b)所示,妥协模型使得车辆行驶过车道,最终撞上路边的灌木丛。这表明了所提出攻击的严重性和实用性,在设计鲁棒的自动驾驶模型时,也应该仔细考虑这种新的攻击向量。

图片说明: 图1展示了本文的测试平台和测试结果:图(a)为搭载了Leopard摄像头的百度Apollo D-Kit自动驾驶车辆;图(b)为搭载了RealSense D435i摄像头的韦斯顿无人地面车辆;图(c)为两种物理攻击的效果。其中左图的图片是原始图片和真实道路(Ground True)的边界;中间的图片为在poison-annotation攻击下的错误检测结果;右图为在clean-annotation攻击下的错误检测结果。

总而言之,我们做出了以下贡献:

- 设计了第一个针对自动驾驶中车道检测系统的后门攻击。

- 实现了第一次对非分类模型的物理后门攻击。algorithm-agnostic攻击。

- 提出了第一个物理干净注释后门攻击(physical clean-annotation backdoor attack)。

- 对数据集和物理自动驾驶汽车进行了广泛的评估,以证明攻击的重要性。

![java八股文面试[多线程]——线程间通信方式](https://img-blog.csdnimg.cn/78db1c87d3a244fd868a6a0606454b05.png)

![[管理与领导-60]:IT基层管理者 - 扩展技能 - 3 - 通过面试招到合适的人选](https://img-blog.csdnimg.cn/187c31f4ea884f2d9939c2af56be5af4.png)