目录

1.简介

2.YOLOv5代码修改

2.1增加以下NAMAttention.yaml文件

2.2common.py配置

2.3yolo.py配置

1.简介

paper:https://arxiv.org/pdf/2111.12419.pdf

code:https://github.com/Christian-lyc/NAM

摘要

注意机制是近年来人们普遍关注的研究兴趣之一。它帮助深度神经网络抑制较不显著的像素或通道。以往的许多研究都集中于通过注意力操作来捕捉显著特征。这些方法成功地利用了不同特征维度上的互信息。然而,它们没有考虑到权重的贡献因素,而权重能够进一步抑制不重要的信道或像素。本文利用权重的贡献因素来改善注意机制。使用一个批处理(BN)归一化的缩放因子,它使用标准偏差来表示权重的重要性。这可以避免添加在SE、BAM和CBAM中使用的全连接和卷积层。因此,提出了一种有效的注意机制——基于标准化的注意模块(NAM)。

论文背景

许多先前的工作试图通过抑制无关紧要的权值来改善神经网络的性能。Squeeze-and-Excitation Networks(SENet) 将空间信息整合到通道特征响应中,并使用两个多层感知器(MLP)层计算相应的注意。Bottleneck Attention Module(BAM)并行构建分离的空间子模块和通道子模块,它们可以嵌入到每个Bottleneck Block中。Convolutional Block Attention Module(CBAM)提供了一种顺序嵌入通道和空间注意力子模块的解决方案。为了避免忽视跨维度的相互作用,Triplet Attention Module (TAM) 通过旋转特征图考虑维度相关性。然而,这些工作忽略了来自训练中调整权重的信息。因此,本文的目标是通过利用训练模型权重的方差度量来突出显著特征。

论文主要思想

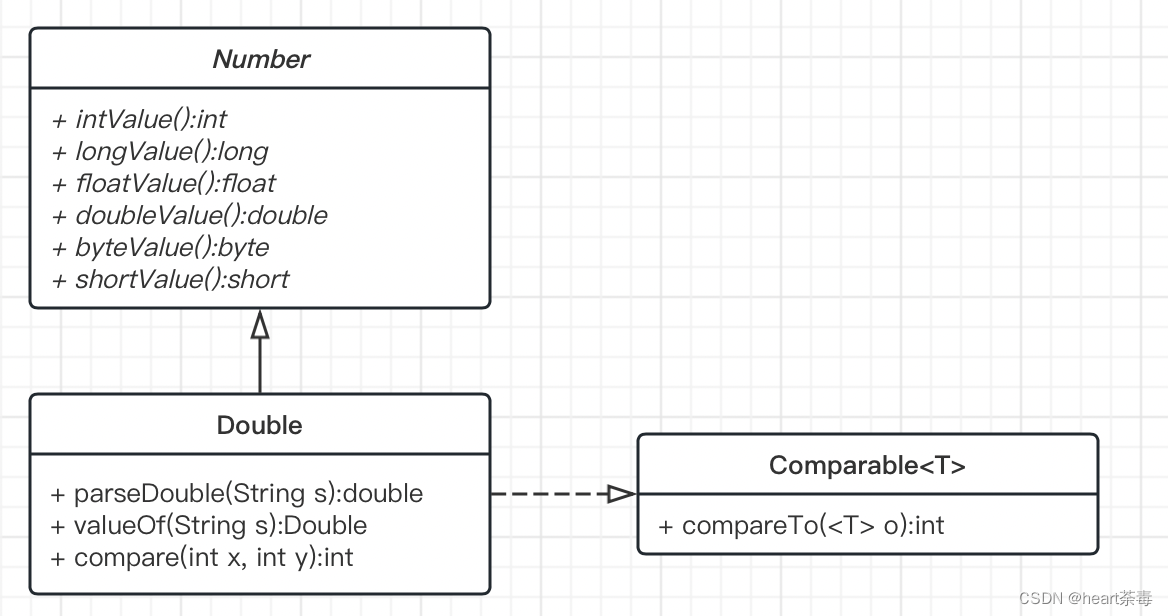

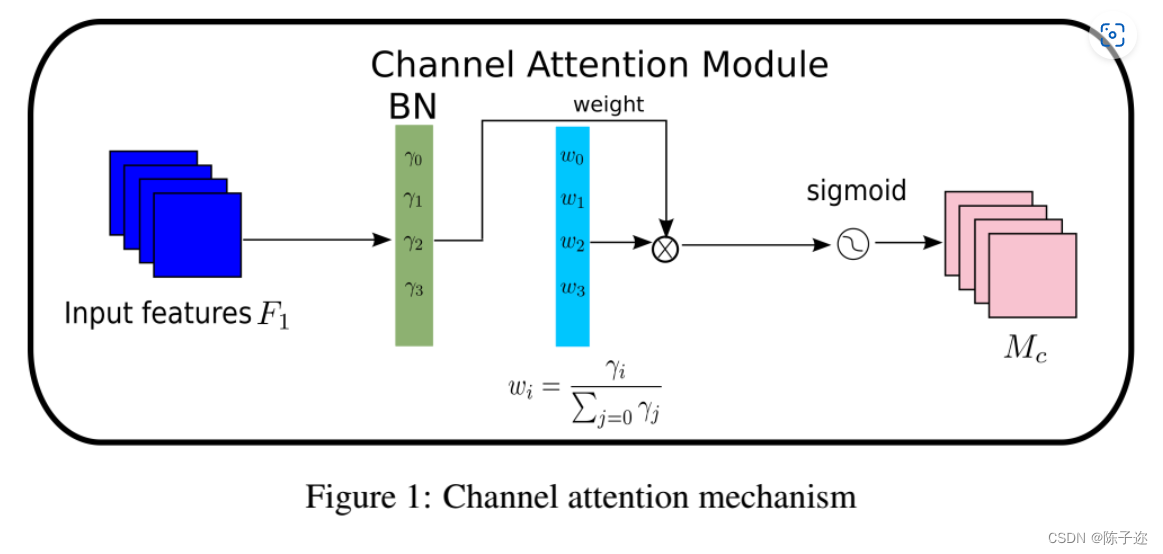

本文提出NAM作为一种高效和轻量级的注意机制。采用了来自CBAM的模块。并重新设计通道和空间注意子模块。然后,在每个网络块的末端嵌入一个NAM模块。对于残差网络,它被嵌入在残余结构的末端。对于信道注意子模块,使用了批归一化(BN)的缩放因子。尺度因子测量了信道的方差,并表明了它们的重要性。

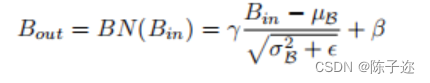

其中为均值,

为方差;

和

是可训练的仿射变换参数(尺度和位移)。

通道注意力子模块如图1所示,其中表示输出特征。

是每个通道的比例因子,权值为

。这里还将BN的比例因子应用于空间维度,来衡量空间特征的重要性。

对应的空间注意力子模块如图2所示,其中输出记为,

为比例因子,权值为

。

2.YOLOv5代码修改

2.1增加以下NAMAttention.yaml文件

# YOLOv5 🚀 YOLOair, GPL-3.0 license

# Parameters

nc: 80 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 v6.0 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Conv, [64, 6, 2, 2]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 6, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 3, C3, [1024]],

[-1, 1, SPPF, [1024, 5]], # 9

]

# YOLOv5 v6.0 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 14], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 10], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[-1, 1, NAMAttention, [1024]],# 修改

[[17, 20, 24], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]

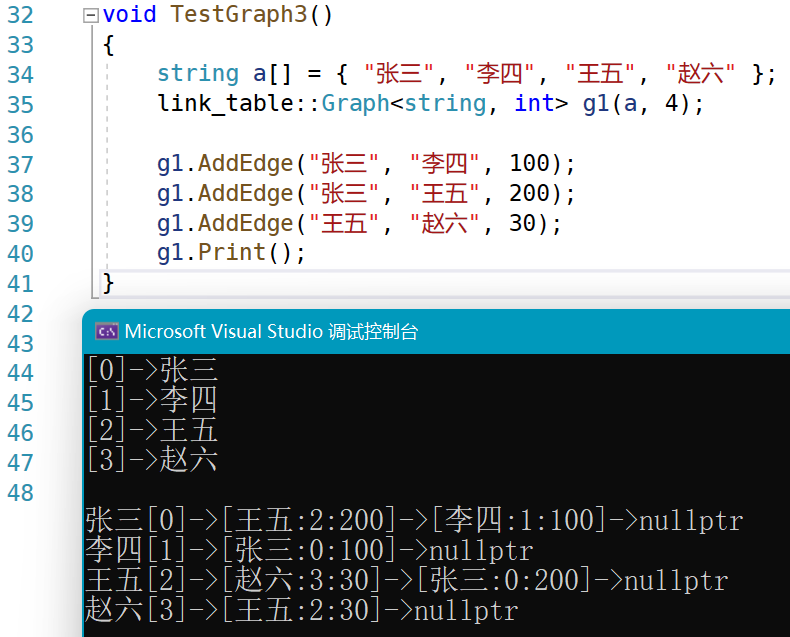

2.2common.py配置

import torch.nn as nn

import torch

from torch.nn import functional as F

class Channel_Att(nn.Module):

def __init__(self, channels, t=16):

super(Channel_Att, self).__init__()

self.channels = channels

self.bn2 = nn.BatchNorm2d(self.channels, affine=True)

def forward(self, x):

residual = x

x = self.bn2(x)

weight_bn = self.bn2.weight.data.abs() / torch.sum(self.bn2.weight.data.abs())

x = x.permute(0, 2, 3, 1).contiguous()

x = torch.mul(weight_bn, x)

x = x.permute(0, 3, 1, 2).contiguous()

x = torch.sigmoid(x) * residual #

return x

class NAMAttention(nn.Module):

def __init__(self, channels, out_channels=None, no_spatial=True):

super(NAMAttention, self).__init__()

self.Channel_Att = Channel_Att(channels)

def forward(self, x):

x_out1=self.Channel_Att(x)

return x_out1

2.3yolo.py配置

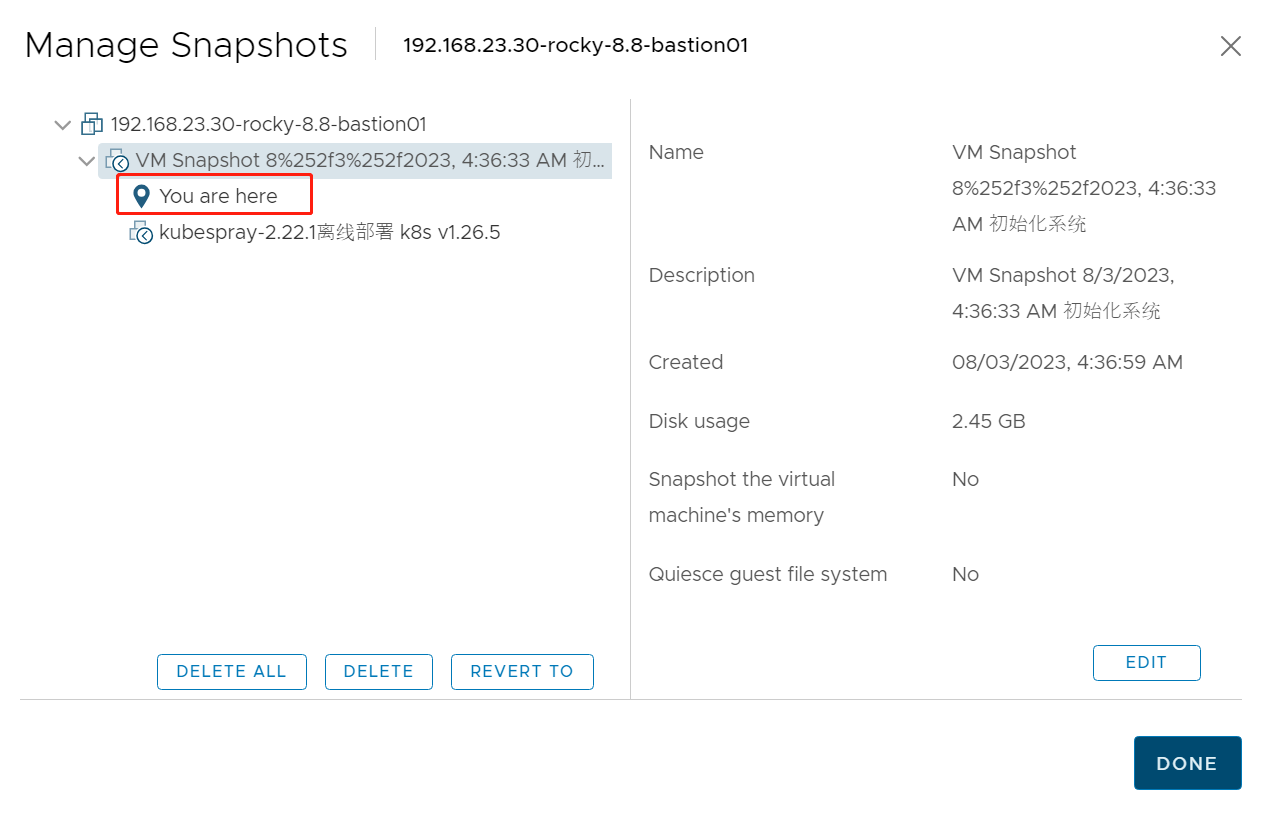

在 models/yolo.py文件夹下

- 定位到parse_model函数中

-

elif m is NAMAttention: c1, c2 = ch[f], args[0] if c2 != no: c2 = make_divisible(c2 * gw, 8) args = [c1, *args[1:]]

有不清楚的地方可以评论区留言。

![BUUCTF [SWPU2019]Web1](https://img-blog.csdnimg.cn/a3c915f39a54478daf7480880e3d1354.png)