图像恢复与增强的扩散模型综述

论文链接:https://arxiv.org/abs/2308.09388

项目地址:https://github.com/lixinustc/Awesome-diffusion-model-for-image-processing/

Abstract

图像恢复(IR)一直是低水平视觉领域不可或缺的一项具有挑战性的任务,它致力于提高因各种形式的退化而失真的图像的主观质量。近年来,扩散模型在AIGC的视觉生成方面取得了重大进展,由此提出了一个直观的问题,即“扩散模型能否促进图像恢复”。为了回答这个问题,一些开创性的研究试图将扩散模型集成到图像恢复任务中,从而获得比以前基于GAN的方法更好的性能。尽管如此,关于基于扩散模型的图像恢复的全面而有启发性的研究仍然很少。在本文中,我们首先全面回顾了最近基于扩散模型的图像恢复方法,包括学习范式、条件策略、框架设计、建模策略和评估。具体而言,我们首先简要介绍了扩散模型的背景,然后介绍了两种利用扩散模型进行图像恢复的流行工作流。随后,我们分类并强调了使用IR和盲/真实IR扩散模型的创新设计,旨在启发未来的发展。为了彻底评估现有的方法,我们总结了常用的数据集、实现细节和评估指标。此外,我们提出了三个任务的开源方法的客观比较,包括图像超分辨率,去模糊和图像补全。最后,考虑到现有研究的局限性,我们提出了基于扩散模型的IR未来研究的五个潜在和具有挑战性的方向,包括采样效率、模型压缩、失真模拟和估计、失真不变量学习和框架设计。

1 INTRODUCTION

图像恢复(IR)一直是低水平视觉任务中一个长期研究的课题,它对提高图像主观质量有着不可替代的作用。流行的IR任务包括图像超分辨率(SR)[1-10]、去模糊[11-17]、去噪[18-25]、图像补全[26-31]和去除压缩伪影[32-38]等。一些IR任务的可视化说明如图1所示。为了恢复失真图像,传统的IR方法将恢复视为信号处理,并从空间或频率角度使用手工算法减少伪影[18,39 - 44]。随着深度学习的发展,许多IR工作收集了一系列为各种IR任务量身定制的数据集,例如,SR的DIV2K [45], Set5[46]和Set14 [47], Rain800 [48], Rain200 [?], Raindrop[49]和DID-MDN[50]用于去雨,REDS[51]和Gopro[52]用于运动去模糊等。利用这些数据集,最近的大部分工作[1 - 3,7 - 11,13,16,19,21 - 23,32 - 34,53 - 55]都集中在通过基于卷积神经网络(CNN)[56]或Transformer[57]的精心设计的骨干网来提高IR网络对复杂退化的表示能力。虽然这些工作在客观质量(如PSNR和SSIM)方面取得了较好的进展,但恢复后的图像仍然存在纹理生成不理想的问题,阻碍了IR方法在现实场景中的应用。

由于生成模型的发展[58-66],特别是生成对抗网络(GAN)[64],一些开创性的IR研究[5,6,67 - 70]指出,之前的像素级损失,如MSE损失和L1损失容易受到模糊纹理的影响,并将GAN的对抗损失引入到IR网络的优化中,从而增强了其纹理生成能力。例如,SRGAN[5]和DeblurGAN[12]分别利用逐像素损失和对抗损失的组合来实现面向感知的SR网络和去模糊网络。

接下来,改进基于GAN的IR的两个主要方向是增强生成器(即恢复网络)[5,6,71 - 73]和鉴别器[74-77]。特别地,ESRGAN[6]引入了强大的RRDB[6]作为基于GAN的SR任务的生成器。三种流行的鉴别器,包括逐像素鉴别器(U-Net形状)[74]、逐patch鉴别器[75,78 - 80]和逐图像鉴别器[76,77] (即类似VGG的架构),旨在关注不同粒度级别(即从局部到全局)的主观质量。尽管取得了上述进展,但大多数基于GAN的IR研究仍然面临两个不可避免但至关重要的问题:

- 基于GAN的IR训练容易受到模式损坏和不稳定优化的影响。

- 大多数生成图像的纹理似乎是假的和反事实的。

近年来,扩散模型作为生成模型的一个新分支出现,在视觉生成任务上取得了一系列突破。扩散模型的原型可以追溯到工作[81],由DDPM[82]、NCSN[83]和SDE[84]开发。一般来说,扩散模型由前向/扩散过程和反向过程组成,其中前向过程逐步增加图像的像素级噪声,直到满足高斯噪声,反向过程旨在通过去噪来重建图像与分数估计[83]或噪声预测[82]。与GAN相比,扩散模型具有高保真度和多样化的生成结果,从而在视觉生成[82 - 86]和条件视觉生成[86 - 97]等一系列领域成功取代了GAN。随着视觉语言模型的进步,扩散模型已经扩展到跨模态生成,如Stable Diffusion[98]和DALE-2[99]。这极大地促进了人工智能生成内容(AIGC)的发展。我们在图2中列出了基于时间线的扩散模型的代表性工作。

受扩散模型优越的生成能力的启发,许多研究研究了扩散模型在图像恢复任务中的应用,旨在促进纹理恢复。根据训练策略,这些工作大致可以分为两类:

- 第一类[100-109]致力于通过有监督学习从零开始优化IR扩散模型。

- 第二类(即Zero-shot)[110-117]致力于利用预训练的IR扩散模型中的生成先验。

通常,基于有监督学习的方法需要收集大规模的失真/干净图像对,而基于Zero-shot的方法主要依赖于已知的退化模式。这些限制阻碍了这些基于扩散模型的方法在现实世界中的应用,在现实世界中,失真通常是多样的和未知的。为了进一步解决上述问题,一些研究[118-123]通过结合真实世界的失真模拟、核估计、域翻译和失真不变性学习,扩展了扩散模型来处理盲/真实世界的图像恢复。

尽管扩散模型在图像恢复中显示出显著的效果,但相关的技术和基准表现出相当大的多样性和复杂性,使得它们难以被跟踪和改进。此外,缺乏对基于扩散模型的IR的全面综述进一步限制了它的发展。本文首先对基于扩散模型的图像恢复方法进行了综述和总结,旨在提供一个结构良好、深入的知识库,并促进其在图像恢复界的发展。

在本文综述中,我们首先介绍了第2节中扩散模型的背景,重点介绍了三种基本的建模方法,即NCSN[83]、DDPM[82]和SDE[84],以及从优化策略、采样效率、模型架构和条件策略等方面对扩散模型的进一步改进。基于这些初步研究,我们在第3节从两个不同的方向阐述了扩散模型在图像恢复中的进展:1)基于有监督扩散模型的IR,和2)基于Zero-shot扩散模型的IR。在第4节中,我们总结了基于扩散模型的IR在更实际和更具挑战性的场景下,即盲/现实世界退化。这将进一步提高基于扩散模型的IR方法满足实际应用需求的能力。为了便于合理和详尽的比较,在第5节中,我们阐明了常用的数据集,以及不同基于扩散模型的IR任务的实验设置。此外,还提供了跨不同任务的基准之间的全面比较。在第6节中,我们深入分析了基于扩散模型的IR的主要挑战和潜在方向。本文综述的最终结论总结于第 7 节。

2 扩散模型背景(DM)

扩散概率模型(即扩散模型)带来了生成模型领域的一次进化,它通过马尔可夫链建模将复杂不稳定的生成过程转化为多个独立稳定的逆向过程。目前广泛使用的基本扩散模型有三种,其中包括DDPM[82]、NCSN[83]和SDE[84]。其中,NCSN[83]试图通过对噪声尺度递减的序列进行采样,利用退火朗格万动力学对数据分布进行建模。而DDPM[82]用加入高斯噪声的固定过程对正向过程进行建模,将扩散模型的逆向过程简化为变分界目标的求解过程。这两个基本的扩散模型实际上是基于分数的生成模型的特殊情况[84]。SDE[84]作为一种统一形式,用随机微分方程(SDE)对连续扩散和反向进行建模。证明了NCSN和DDPM只是SDE的两个独立离散化。我们将在以下小节中阐明这三种基本扩散模型的建模策略。

2.1 噪声条件评分网络(NCSN)

生成模型的目的是学习目标数据的概率分布。与以往基于似然[124-129]和基于GAN[130-138]的方法不同,NCSN旨在从对数密度函数(即分数函数∇log p(x))的梯度估计数据分布,该函数引导采样逐步向前移动到数据分布的中心方向。具体来说,NCSN用一个参数化为θ的神经网络来预测原始数据的分数函数。为了避免由此产生的分布崩溃为低维流形和在低密度区域不准确的分数估计,为基于分数的生成模型设计了退火朗之万动力学[133,140],其中引入了具有单调递减等级

σ

i

=

1

L

σ^L_{i=1}

σi=1L的预定义噪声来扰动数据。朗之万动力学的原始采样过程可以表示为:

x

~

t

=

x

~

t

−

1

+

ϵ

2

∇

x

~

log

p

(

x

~

t

−

1

)

+

ϵ

z

t

,

(1)

\tilde{x}_{t}=\tilde{x}_{t-1}+\frac{\epsilon}{2}\nabla_{\tilde{x}}\log p(\tilde{x}_{t-1})+\sqrt{\epsilon}z_{t}, \tag{1}

x~t=x~t−1+2ϵ∇x~logp(x~t−1)+ϵzt,(1)

其中

z

t

z_t

zt为时间步长t处的随机正态高斯噪声,

λ

λ

λ为固定步长。当时间步长

T

→

∞

T→∞

T→∞,且

ε

→

0

ε→0

ε→0时,分布

p

(

x

~

T

)

p(\tilde{x}_{T})

p(x~T)等于原始数据分布

p

(

x

)

p(x)

p(x)。加入

σ

σ

σ级噪声后,扰动分布为

q

σ

(

x

~

)

≜

∫

p

(

x

)

N

(

x

~

∣

x

,

σ

2

I

)

d

x

q_{\sigma}(\tilde{x})\triangleq\int p(x)\mathcal{N}(\tilde{x}|x,\sigma^{2}I)dx

qσ(x~)≜∫p(x)N(x~∣x,σ2I)dx。噪声条件评分网络(NCSN)可以朝着

s

θ

(

x

~

,

σ

)

=

−

∇

x

~

log

q

σ

(

x

~

)

s_{\theta}(\tilde{x},\sigma)=-\nabla_{\tilde{x}}\log q_{\sigma}(\tilde{x})

sθ(x~,σ)=−∇x~logqσ(x~)方向优化,噪声评分匹配目标为:

L

(

θ

,

σ

)

=

1

2

E

p

(

x

)

E

x

~

∼

N

(

x

,

σ

2

I

)

[

∥

s

θ

(

x

~

,

σ

)

+

x

~

−

x

σ

2

∥

2

2

]

(2)

\mathcal{L}(\theta,\sigma)=\frac{1}{2}E_{p(x)}E_{\tilde{x}\sim\mathcal{N}(x,\sigma^{2}I)}[\|s_{\theta}(\tilde{x},\sigma)+\frac{\tilde{x}-x}{\sigma^{2}}\|_{2}^{2}] \tag{2}

L(θ,σ)=21Ep(x)Ex~∼N(x,σ2I)[∥sθ(x~,σ)+σ2x~−x∥22](2)

2.2 去噪扩散概率模型(DDPM)

DDPM (Denosing diffusion probistic model)[82]源于扩散模型[141],它通过设置方差

β

t

β_t

βt为固定值,为扩散模型引入简单的变分界目标。扩散模型中有两个关键过程,即正向过程和逆向过程。其中,前向过程(即DDPM中的扩散过程)旨在将训练数据逐步分解为高斯噪声,高斯噪声是一条参数化的马尔可夫链,为:

q

(

x

t

∣

x

t

−

1

)

=

N

(

x

t

;

1

−

β

t

⋅

x

t

−

1

,

β

t

I

)

,

(3)

q(x_{t}|x_{t-1})=\mathcal{N}(x_{t};\sqrt{1-\beta_{t}}\cdot x_{t-1},\beta_{t}\mathbf{I}), \tag{3}

q(xt∣xt−1)=N(xt;1−βt⋅xt−1,βtI),(3)

其中

x

0

,

x

1

,

…

,

x

T

x_0, x_1,…, x_T

x0,x1,…,xT是噪声潜变量,通过在训练数据点

x

0

∼

p

d

a

t

a

(

x

)

x_0 \sim p_{data}(x)

x0∼pdata(x)上逐步添加噪声,噪声调度为

β

1

,

…

,

β

T

∈

(

0

,

1

)

β_1,…,β_T∈(0,1)

β1,…,βT∈(0,1)共T步。我们可以计算出

x

t

x_t

xt在

x

0

x_0

x0条件下的概率分布:

q

(

x

t

∣

x

0

)

=

N

(

x

t

;

α

^

t

x

0

,

1

−

α

^

t

I

)

,

(4)

q(x_t|x_0)=\mathcal{N}(x_t;\sqrt{\hat{\alpha}_t}x_0,\sqrt{1-\hat{\alpha}_t}\mathbf{I}), \tag{4}

q(xt∣x0)=N(xt;α^tx0,1−α^tI),(4)

式中

α

t

=

1

−

β

t

α_t =1 - β_t

αt=1−βt,

α

^

t

=

∏

i

=

1

t

α

i

\hat{\alpha}_{t}=\prod_{i=1}^{t}\alpha_{i}

α^t=∏i=1tαi。当时间步长

t

→

T

t→T

t→T足够大时,从

α

t

→

0

α_t→0

αt→0开始,

x

T

x_T

xT的分布将是一个标准高斯分布

π

(

x

T

)

∼

N

(

0

,

I

)

\pi(x_{T})\sim\mathcal{N}(0,\mathbf{I})

π(xT)∼N(0,I)。

扩散模型的反向过程是通过将后验分布

q

(

x

t

−

1

∣

x

t

,

x

0

)

q(x_{t−1}|x_t, x_0)

q(xt−1∣xt,x0)近似为:

q

(

x

t

−

1

∣

x

t

,

x

0

)

=

N

(

x

t

−

1

;

μ

~

t

(

x

t

,

x

0

)

,

β

~

t

I

)

,

(5)

q(x_{t-1}|x_t,x_0)=\mathcal{N}(x_{t-1};\tilde{\mu}_t(x_t,x_0),\tilde{\beta}_t\mathbf{I}), \tag{5}

q(xt−1∣xt,x0)=N(xt−1;μ~t(xt,x0),β~tI),(5)

其中

μ

~

t

(

x

t

,

x

0

)

=

α

^

t

−

1

β

t

1

−

α

^

t

x

0

+

α

^

t

(

1

−

α

^

t

−

1

)

1

−

α

^

t

x

t

=

1

α

t

(

x

t

−

\tilde{\mu}_t\left(x_t, x_0\right)=\frac{\sqrt{\hat{\alpha}_{t-1}} \beta_t}{1-\hat{\alpha}_t} x_0+\frac{\sqrt{\hat{\alpha}_t}\left(1-\hat{\alpha}_{t-1}\right)}{1-\hat{\alpha}_t} x_t=\frac{1}{\sqrt{\alpha_t}}\left(x_t-\right.

μ~t(xt,x0)=1−α^tα^t−1βtx0+1−α^tα^t(1−α^t−1)xt=αt1(xt−

β

t

1

−

α

^

t

)

ϵ

\left.\frac{\beta_t}{\sqrt{1-\hat{\alpha}_t}}\right) \epsilon

1−α^tβt)ϵ ,

ϵ

∼

N

(

0

,

I

)

\epsilon \sim \mathcal{N}(\mathbf{0}, \mathbf{I})

ϵ∼N(0,I) 和

β

~

t

=

1

−

α

^

t

−

1

1

−

α

^

t

\tilde{\beta}_t=\frac{1-\hat{\alpha}_{t-1}}{1-\hat{\alpha}_t}

β~t=1−α^t1−α^t−1。如公式5所示,方差表

β

t

β_t

βt是预定义的,因此只需要通过一个去噪网络

ϵ

θ

(

x

t

,

t

)

ϵ_θ(x_t, t)

ϵθ(xt,t)逼近平均值

μ

θ

(

x

t

,

t

)

=

μ

~

t

(

x

t

,

x

0

)

\mu_θ(x_t, t) =\tilde{\mu}_t(x_t, x_0)

μθ(xt,t)=μ~t(xt,x0)。去噪网络的优化目标[82]为:

L

simple

=

E

t

,

x

0

,

ϵ

[

∥

ϵ

−

ϵ

θ

(

α

^

t

x

0

+

ϵ

1

−

α

^

t

,

t

)

∥

2

2

]

(6)

\mathcal{L}_{\text {simple }}=\mathbb{E}_{t, x_0, \epsilon}\left[\left\|\epsilon-\epsilon_\theta\left(\sqrt{\hat{\alpha}_t} x_0+\epsilon \sqrt{1-\hat{\alpha}_t}, t\right)\right\|_2^2\right] \tag{6}

Lsimple =Et,x0,ϵ[

ϵ−ϵθ(α^tx0+ϵ1−α^t,t)

22](6)

去噪扩散概率模型(DDPM)的直接示例如图3所示。

2.3 随机微分方程(SDE)

为了将方法与基于分数的生成建模和扩散概率建模相统一,SDE[84]通过随机可微分方程(SDE)利用连续扩散过程:

d

x

=

f

(

x

,

t

)

d

t

+

g

(

t

)

d

w

(7)

dx=\mathbf{f}(x,t)dt+g(t)d\mathbf{w} \tag{7}

dx=f(x,t)dt+g(t)dw(7)

其中

w

w

w为标准维纳过程,

f

(

⋅

,

t

)

f(·,t)

f(⋅,t)称为

x

(

t

)

x(t)

x(t)的漂移系数,

g

(

⋅

)

g(·)

g(⋅)称为

x

(

t

)

x(t)

x(t)的扩散系数。这里,扩散系数可以理解为受随机噪声扰动的程度,漂移系数可以设计为保证高斯分布,如DDPM[82]和NCSN[83]。上述连续扩散过程的反向过程(即从噪声中采样数据)也是一个扩散过程,可以用reverse-time SDE来建模:

d

x

=

[

f

(

x

,

t

)

−

g

(

t

)

2

∇

x

log

p

t

(

x

)

]

d

t

+

g

(

t

)

d

w

^

(8)

d\mathbf{x}=[\mathbf{f}(x,t)-g(t)^2\nabla_x\log p_t(x)]dt+g(t)d\hat{\mathbf{w}} \tag{8}

dx=[f(x,t)−g(t)2∇xlogpt(x)]dt+g(t)dw^(8)

这里

d

t

dt

dt是一个无穷小的负时间步长,而

w

w

w是时间从T向后流动到0时的标准维纳过程。reverse-time SDE的核心是使用神经网络估计分数函数,然后通过分数匹配来求解公式8[142, 143]。

DDPM和NCSN可以看作是两种不同SDE的离散化。当时间变量趋于无穷时,DDPM的正向过程收敛为:

d

x

=

−

1

2

(

1

−

α

^

t

)

x

d

t

+

1

−

α

^

t

d

w

.

(9)

d\mathbf{x}=-\frac{1}{2}(1-\hat{\alpha}_t)\mathbf{x}dt+\sqrt{1-\hat{\alpha}_t}d\mathbf{w}. \tag{9}

dx=−21(1−α^t)xdt+1−α^tdw.(9)

NCSN的SDE形式如下:

d

x

=

d

[

σ

2

(

t

)

]

d

t

d

w

.

(10)

d\mathbf{x}={\sqrt{\frac{d[\sigma^{2}(t)]}{dt}}}d\mathbf{w}. \tag{10}

dx=dtd[σ2(t)]dw.(10)

在这里,公式9和公式10分别被称为方差保持(VP) SDE和方差爆炸(VE) SDE。

2.4 扩散模型的改进

在上述基础扩散模型的基础上,从优化策略、采样效率、模型架构、条件策略等方面进一步完善扩散模型,开展了大量工作。

优化策略。为了提高扩散模型的稳定性和性能,一些研究[144-148]探讨了正向和反向过程中方差/噪声调度的优化。值得注意的是,正向过程中的噪声调度控制着每一步的扰动程度,这对逆过程尤为重要。作为代表性工作的DDPM[82],对扩散过程采用了直接的线性噪声调度。但这种方法往往导致次优结果,特别是对于低分辨率图像生成[144]。为了缓解这一点,IDDPM[144]引入了余弦噪声时间表,以消除早期扰动阶段快速噪声积累的负面影响。Diederik等[146]用单调神经网络参数化噪声调度,并与扩散模型联合优化。一般来说,反向过程中的方差调度是固定的,并与正向过程中的噪声调度一起计算。然而,IDDPM[144]发现学习方差可以进一步提高对数似然,因此在正向和反向过程中都采用方差表作为方差的可学习线性插值。相比之下,AnalyticDPM[149]通过分析估计得出最优方差轨迹,从而提高了各种DPM的对数似然。与上述方法不同,Jolicoeur-Martineau等[150]提出了一种全新的采样方法,即一致退火采样(Consistent Annealed sampling),该方法比退火朗之万方法对扩散模型更稳定。

采样效率。扩散模型的生成质量严重依赖于大量的采样步骤,从而对其在实际应用中的效率提出了挑战。为了减轻这种情况,已经提出了四个主要的工作路线来加速采样过程。

- 第一种涉及与ODE相关的手工采样策略[85,151 - 154]。例如,DDIM[85]在正向过程中引入了非马尔可夫链,使扩散模型能够实现任意步长的采样。相比之下,DPM-solver[151]通过解析计算ODE解的线性部分而不是利用黑箱ODE求解器来争取快速的ODE求解器。因此,这种方法大大缩小了生成高质量图像所需的采样步骤,将其限制在10到20的可接受范围内。

- 第二个典范是修正扩散过程[155,156]。Lou等人[155]的代表性工作是提出用早期停止机制截断扩散过程,并从非高斯分布开始采样,该分布由预训练的VAE/GAN模型生成。

- 在第三种策略中,采用知识蒸馏将生成能力从多个采样步骤转移到几个采样步骤[157-160]。

- 最后一种方法利用条件策略[98,161 - 164]嵌入生成先验,从而优化采样效率。

模型架构。扩散模型主要采用两种架构,即基于CNN的U-Net和基于Transformer的模型。值得注意的是,U-Net架构在早期研究中被首选用于噪声/分数预测[82,83],这得益于其分辨率保持能力,并通过多粒度下采样特征空间消除了资源成本。在此之后,在随后的工作中,通过结合交叉注意模块[98]、群归一化[82,165]、多头注意[84,144,145]和位置编码[82],进行了一系列的努力来完善U-Net架构。最近,Transformer已经证明了它在建模远程依赖关系和统一不同模态方面的熟练程度[166-173]。因此,一些文本到图像的工作[174 - 181]探索使用Transformer主干,如ViT [182], Swinv2[179],来代替原来的基于CNN的U-Net来预测反向过程中的噪声,其中时间步长 t t t等条件通过自适应层归一化[175,177,178]或交叉注意[174]馈送到Transformer中。

条件策略。在条件生成中,一个有效的条件策略对扩散模型的功能性至关重要。这激发了许多工作来探索有效和有效的条件机制。Nicol等人[165]创新性地训练了一个辅助分类器来指导扩散模型,利用其梯度引导图像生成向特定语义方向发展。另一条流行的路线[183,184]以无分类器的方式将条件引入分数估计/噪声预测模型,如GLIDE[185]和DALLE-2[99]。为保持其无条件生成能力,利用空令牌 ∅ ∅ ∅来代替扩散模型中的条件 θ ( x , c ) θ(x, c) θ(x,c),使 θ ( x ) = θ ( x , ∅ ) θ(x) = θ(x,∅) θ(x)=θ(x,∅),其中 c c c表示条件,如文本特征。由于其优点,一系列工作将无分类器条件引入到文本到图像的任务中[185-190]。此外,除了类标签和文本提示外,扩散模型还可以集成其他模态条件,如图像、分割图、潜在特征,这极大地促进了其在各种需求中的应用,如Stable diffusion[98]、ControlNet[161]。

3 基于扩散模型的图像恢复方法

根据扩散模型(diffusion models, DM)是否对IR不需要训练,我们可以将基于扩散模型的IR方法初步分为两类,即基于有监督的扩散模型方法[100、105、107、108、121、191-194]和基于Zero-shot的扩散模型方法[112、114、115、195-200]。特别是,有有监督的基于DM的IR方法需要使用成对的IR数据集的失真/干净图像从头开始训练扩散模型。与以往基于GAN的方法[201-209]直接将失真图像作为输入不同,基于DM的IR采用精心设计的条件机制,在反向过程中将失真图像作为引导。尽管纹理生成的结果很有前景,但这种方法遇到了两个明显的局限性:

- 从头开始训练扩散模型依赖于大量的成对训练数据。

- 在现实世界中收集成对的失真/干净图像具有挑战性。

相比之下,基于Zero-shot的DM方法提供了一个有吸引力的替代方案,它只需要失真的图像,无需再训练扩散模型。它不是从IR图像的训练数据集中获取恢复能力,而是从预训练的扩散模型中挖掘和利用结构和纹理先验进行图像恢复。核心思想源于一种直觉,即预训练的生成模型可以被视为结构和纹理存储库,使用大量现实世界的数据集构建,如ImageNet[210]和FFHQ[211]。因此,如何在保留失真图像数据结构的前提下提取相应的感知先验,是基于Zero-shot DM的IR方法面临的一个重要挑战。在接下来的小节中,我们首先简要回顾具有代表性的有监督式基于数据的IR方法:SR3[100],以及Zero-shot基于数据的IR方法:ILVR[195]。然后我们从条件策略、扩散建模和框架三个方面对这两类方法进行进一步分类,分别总结如表1和表2所示。

此外,扩散模型的总体分类如图4所示。

3.1 SR3-IR的代表性有监督DM

与从噪声中合成图像的纯图像生成任务不同,图像恢复旨在从相应的降级/低质量图像中生成高质量图像。因此,如何有效地将退化/低质量图像作为条件纳入到扩散模型中,是基于有监督DM的IR成像的关键挑战。让我们将退化的图像表示为 y y y。IR扩散模型(DM)的基本目标是学习时间步长 t t t的后验分布 p θ ( x t − 1 ∣ y , x t ) p_θ(x_{t−1}|y, x_t) pθ(xt−1∣y,xt),使得 x 0 ∼ q ( x ∣ y ) x_0 \sim q(x|y) x0∼q(x∣y)和 x x x表示相应的高质量图像。为了实现这一目标,引入了一种具有开创性的基于有监督的DM方法SR3,并采用了简单的条件策略。具体来说,它直接将退化的图像与 t t t时间步长的生成图像 x t x_t xt连接起来,有效地实现了SR的条件图像生成。

如图5所示,SR3遵循典型的DDPM[82] 框架,并利用 U-Net 模型作为噪声预测器。给定低分辨率(LR)图像 y y y, SR3最初使用双三次插值将其上采样到所需的分辨率。随后,它将超分辨LR图像 y y y与第 t t t步的去噪输出 x t x_t xt连接起来,作为扩散模型的输入,预测第 t − 1 t−1 t−1步的噪声。当达到 t = 0 t = 0 t=0时,扩散模型可以提供 y y y的上采样高质量图像 x 0 x_0 x0为 x 0 ≈ x x_0≈x x0≈x。

3.2 ILVR-IR的代表性Zero-shot DM

尽管有监督的基于DM的IR方法表现出了显著的性能,但训练过程需要大量的计算成本和大规模的成对数据集,这可能使一些研究人员望而却步。为了解决这个问题,提出了基于Zero-shot DM的IR[11,195,212 - 214]来利用预训练扩散模型中的固有知识。具体来说,我们观察到用于图像生成的预训练扩散模型,使用大量自然图像进行训练,封装了大量关于丰富纹理的先验知识。因此,这些预训练的扩散模型可以看作是纹理信息的存储库。探索利用这些先验知识进行无训练图像恢复是低水平视觉领域一个新兴的、有前途的方向。

作为初始工作,Choi等[195]引入了迭代潜变量细化(即ILVR)方法,该方法利用无条件扩散模型实现图像SR和图像平移的无训练条件生成。ILVR的关键创新在于用参考图像中的低频分量替换去噪输出中的低频分量。如图6所示,这种替换过程保证了生成的图像与参考图像在结构和语义上的一致性,从而便于条件生成。特别是,给定参考图像

y

y

y(例如,IR 中的失真图像),在时间步 t,ILVR 使用以下公式预测时间 t − 1 的去噪结果:

x

′

t

−

1

=

σ

t

z

+

1

α

t

(

x

t

−

1

−

α

t

1

−

α

t

‾

ϵ

θ

(

x

t

,

t

)

)

(11)

\mathbf{x}^{\prime}{}_{t-1}=\sigma_{t}\mathbf{z}+\frac{1}{\sqrt{\alpha_{t}}}(\mathbf{x}_{t}-\frac{1-\alpha_{t}}{\sqrt{1-\overline{\alpha_{t}}}}\epsilon_{\theta}(\mathbf{x}_{\mathbf{t}},\mathbf{t})) \tag{11}

x′t−1=σtz+αt1(xt−1−αt1−αtϵθ(xt,t))(11)

其中

ϵ

θ

(

x

t

,

t

)

ϵ_θ(x_t, t)

ϵθ(xt,t)表示去噪网络预测的噪声,

z

z

z表示控制生成图像随机性的标准随机高斯噪声。然而,这种采样过程不可避免地会在

x

t

x_t

xt中产生不一致的结构/纹理,这就需要通过低频替换进行细化以与参考图像

y

y

y中的结构/纹理对齐:

x

t

−

1

=

x

t

−

1

′

+

Φ

N

(

y

t

−

1

)

−

Φ

N

(

x

t

−

1

′

)

.

(12)

x_{t-1}=x'_{t-1}+\Phi_N(y_{t-1})-\Phi_N(x'_{t-1}). \tag{12}

xt−1=xt−1′+ΦN(yt−1)−ΦN(xt−1′).(12)

其中

Φ

N

Φ_N

ΦN表示设计用于从输入端绕过低频分量的低通滤波器,

y

t

−

1

∼

q

(

y

t

−

1

∣

y

)

y_{t-1} \sim q(y_{t - 1}|y)

yt−1∼q(yt−1∣y)表示

y

y

y在

t

−

1

t - 1

t−1阶跃处的扩散状态。继ILVR之后,大多数基于Zero-shot DM的IR方法[112-114,197,200,215,216]主要侧重于增强采样过程中的细化策略,从而无需训练。

3.3 基于有监督DM的IR

在SR3[100]的推动下,许多研究都在努力优化有监督的基于DM的IR框架,重点是增强条件策略,探索潜在的和更有效的生成空间。在条件策略方面,我们根据条件将这些研究分为三类:1)低质量参考图像;2)预处理参考图像;3)修正扩散过程。在生成空间方面,基于有监督DM的IR方法可分为三大类:图像空间、残差空间和潜在空间。如果没有提及,大多数研究都是在图像空间内生成还原图像,其中需要直接生成结构和纹理。相比之下,残差空间扩散模型侧重于重建低质量图像与其对应的高质量图像之间的残差,从而简化了生成整个图像的复杂性。基于潜在空间的方法利用精心设计的编码器将图像转换成紧凑的潜在空间进行生成,从而提高了生成效率。本节将根据上述三种条件策略和最后两种空间阐述现有的基于有监督DM的IR研究。

3.3.1 低质量参考图像的情况

正如3.1节所强调的,将失真图像作为条件对于基于有监督的DM的IR是必不可少的,也是至关重要的。SR3方法表明,通过简单的串联操作可以获得可观的性能。它利用低质量参考图像与 t − 1 t - 1 t−1步去噪结果的直接连接作为t步噪声预测的条件。使用相同的条件策略,Saharial等人[219]提出了一种统一的扩散模型,称为Palette,用于图像到图像的翻译任务,该模型在图像着色、补全、uncropping和JPEG伪像去除方面取得了优异的性能。此外,他们还研究了不同优化目标对样本多样性的影响,并强调了U-Net中自注意对扩散模型的关键作用。尽管它们很有效,但上述方法受到限制,因为它们在训练后只支持固定的IR分辨率。为了使扩散模型适应任意大小的真实IR, Özdenizci等[104]将退化图像和相应的采样结果 x t x_t xt划分为多个重叠的patch,然后利用patch-wise级联作为扩散模型的输入进行噪声预测。此外,为了解决重叠区域中不同采样patch导致的不一致问题,本工作引入了重叠区域内每个像素的平均估计噪声。为了提高生成图像的质量,Ho等[218]引入了基于SR3主干的三层级联扩散模型。利用第一个扩散模型实现类别条件下的低分辨率图像生成,并将另外两个扩散模型级联到低分辨率生成图像的超分辨率,从而获得更高分辨率和更逼真的生成图像。除了基于DDPM的方法外,还有另一项研究[103]探索了使用预测校正抽样的连续扩散模型SDE[84]的各种变体。

3.3.2 预处理参考的情况

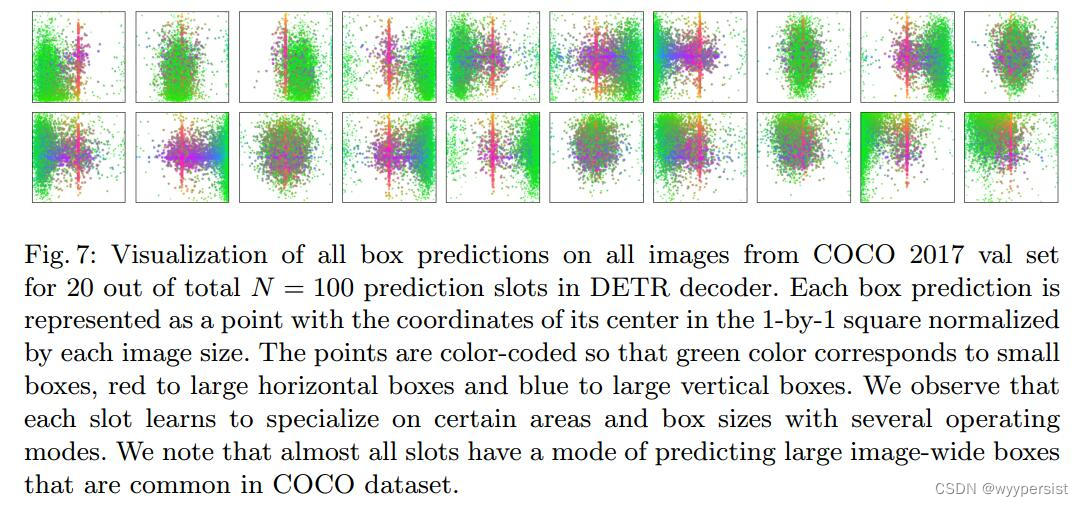

尽管直接与低质量图像拼接显示出良好的效果,但低质量图像中的伪影不可避免地会对扩散模型的生成造成不利影响,特别是对于严重和多样的失真。为了缓解这一问题,一些研究努力通过联合训练模块或预训练恢复网络预处理低质量图像来改善条件。如图7所示,根据预处理策略可以将这些工作分为两类,即具有预处理参考图像的条件和具有预处理特征的条件。

预处理参考图像。为了减轻低质量图像中伪影的副作用,CDPMSR[102]利用现有的超分辨率模型,如RCAN[232]、SwinIR[53]、EDSR[233],对低质量图像进行增强,从而为扩散模型提供高质量、更可靠的条件。此外,它在反向过程中避免了随机采样,而采用确定性去噪过程,从而产生更好的图像质量和更快的推理。值得注意的是,预处理参考图像不仅可以作为增强条件,而且可以作为初始良好恢复的图像。因此,ResDiff[217]利用预训练的CNN生成低频内容丰富的图像作为初始恢复图像,并利用条件扩散模型进一步生成预处理后的失真图像与其对应的干净图像之间的残差。

预处理参考特征。另一条流行的路线是使用参考图像的特征作为扩散模型的条件。IDM[223]为追求连续图像超分辨率,首先利用EDSR提取低分辨率图像的初始特征[233]。然后,将初始特征下采样到多个尺度,作为扩散模型中不同上采样层的条件,以改进隐式表示。相比之下,ShadowDiffusion[230]利用预训练的Transformer主干从失真的参考图像中提取退化先验(即与退化相关的特征)。利用提取的退化先验作为辅助来细化生成的阴影掩模,并用作无阴影图像生成的条件。

3.3.3 修正扩散过程的情况

值得注意的是,上述基于 DM 的有监督 IR 方法通过修改网络来引入条件,同时保留 DDPM 的扩散过程 [82]。然而,这要求生成过程从噪声开始。为了避免这种情况,一些研究通过修改扩散过程来约束扩散模型,使扩散输出

x

T

x_T

xT(即反向过程中的起始点)近似于高斯噪声较少的低质量图像。如图8所示,Luo等[231]将SDE均值还原的正向过程修改为:

d

x

=

θ

t

(

μ

−

x

)

d

t

+

σ

t

d

w

,

(13)

dx=\theta_{t}(\mu-x)dt+\sigma_{t}dw, \tag{13}

dx=θt(μ−x)dt+σtdw,(13)

其中

θ

t

θ_t

θt和

σ

t

σ_t

σt是随时间变化的参数。

μ

\mu

μ表示失真图像,

x

x

x表示其对应的高质量图像。利用均值回归SDE,该工作成功地分别用改进的正反向过程模拟了图像退化和恢复过程。这避免了纯噪声的产生,获得了更好的恢复性能。

在IR-SDE[231]的基础上,同一个团队引入了Refusion[106],通过优化网络架构、噪声水平和去噪步骤等方面,进一步完善IR-SDE[231]。为了降低计算成本,Refusion引入了U-Net压缩策略,从而实现了对潜在空间的高效采样。

出于同样的目的,Xie等[229]重新定义了扩散过程,从噪声图像开始采样。考虑到噪声的多样性,他们分别推导出高斯噪声、伽玛噪声和泊松噪声的三个独立扩散过程。相比之下,InDI[225]将连续扩散过程引入为:

x

t

=

(

1

−

t

)

x

+

t

y

,

(14)

x_{t}=(1-t)x+ty, \tag{14}

xt=(1−t)x+ty,(14)

其中

x

x

x和

y

y

y分别是高质量图像和相应的低质量图像。它可以理解为在时间步长t处对高质量和低质量图像进行逐步插值,将原有的有监督图像恢复单步预测分解为几个小步骤,有效地规避了传统有监督图像恢复中经常出现的均值回归效应。与空间域的扩散过程不同,HFS-SDE[228]在频率空间上重新表述了磁共振(MR)重构的扩散过程。在这种方法中,正向过程逐步在高频空间中加入噪声,最终得到由高频噪声和低频数据组成的

x

T

x_T

xT。在反向过程中,HFS-SDE采用Predictor-Corrector (PC)方法[84]进行抽样。

3.3.4 残差生成

在有监督的基于DM的IR中,大多数研究都是直接从噪声中生成高质量的图像,这就需要同时生成结构和纹理。然而,再生低质量图像中已经存在的结构/纹理会给扩散模型带来不必要的负担,并增加额外的资源成本。受此影响,一些有代表性的研究[101,105,217,234,235]试图将生成过程从图像空间移动到残差空间。目标是生成配对的高质量和低质量图像之间的残差。作为开创性的工作,SRDiff[101]首次利用扩散模型来预测SR中的残差。相比之下,Whang[105]引入了一种用于图像去模糊任务的预测和细化策略。如图9所示,本工作首先使用确定性去模糊网络预测初始去模糊图像,然后通过随机扩散模型生成残差。上文提到的ResDiff[217]对SR也采用了这种策略。

3.3.5 潜在空间扩散

为了减轻扩散模型的训练和采样成本,Stable Diffusion[98]首次在潜在空间中实现了基于DM的生成。特别是,它预训练了一个自动编码模型(即编码器-解码器架构)来学习感知空间,能够在保持重构图像的感知质量的同时降低计算复杂度。Stable Diffusion利用预训练的自编码器,将图像扩散过程转换到感知空间,然后通过交叉注意机制将各种条件(如文本、分割图和图像)引入扩散模型。受此启发,Refusion[106]引入了用于图像恢复的潜扩散模型,以加速训练和采样,如图10所示。与上述通过压缩原始图像获得潜在空间的工作不同,DiffIR[224]利用潜在扩散模型生成紧凑的IR先验,该先验指导基于动态Transformer的恢复网络(DIRformer)实现更好的恢复。

3.4 基于Zero-shot DM的 IR

与基于 有监督DM 的 IR 不同,Zero-shot DM 的 IR 力求实现免训练、免数据的图像恢复。它通常依赖于为生成任务设计的预训练扩散模型,并在采样过程中考虑了低质量图像的情况。该任务的核心挑战在于

- 如何保持低质量图像和生成图像之间的数据一致性,因为预训练的扩散模型致力于保持数据分布而不是像素级数据一致性。

- 如何挖掘与低质量图像对齐的感知知识,这对条件的设计提出了更高的要求。

本文将基于Zero-shot的IR方法大致归纳为投影、分解和后验估计三大类。

3.4.1 基于投影的方法

为了缓解Zero-shot DM的IR的主要挑战,一些研究引入了基于投影的方法[195,212,213]。该方法旨在从低质量图像中提取固有结构/纹理,作为每一步生成图像的补充,从而保证数据的一致性。例如,图像补全任务仅涉及为掩模区域生成内容。低质量图像的未遮蔽区域可以在第

t

−

1

t-1

t−1步替代去噪图像的相应部分,从而为采样过程中数据的一致性奠定了条件。与此相一致,RePaint[212]利用了一个简单的投影来完成图像补全任务:

x

t

−

1

=

m

⨀

x

t

−

1

k

n

o

w

n

+

(

1

−

m

)

⨀

x

t

−

1

u

n

k

n

o

w

n

,

(15)

x_{t-1}=m\bigodot x_{t-1}^{known}+(1-m)\bigodot x_{t-1}^{unknown}, \tag{15}

xt−1=m⨀xt−1known+(1−m)⨀xt−1unknown,(15)

其中

x

t

−

1

k

n

o

w

n

∼

N

(

α

ˉ

t

y

,

1

−

α

ˉ

t

I

)

x_{t-1}^{known}\sim\mathcal{N}(\sqrt{\bar{\alpha}_{t}}y,1-\bar{\alpha}_{t}\mathbf{I})

xt−1known∼N(αˉty,1−αˉtI)为时间步长为

t

−

1

t−1

t−1时,对掩膜图像

y

y

y加入噪声后的扩散结果。

x

t

−

1

k

n

o

w

n

x_{t-1}^{known}

xt−1known从扩散模型的去噪预测中采样。相比之下,ILVR[195]采用低频投影实现图像超分辨率。理论上,在时间步长

t

−

1

t−1

t−1时,预测的潜变量

x

t

−

1

x_{t−1}

xt−1和

y

t

−

1

y_{t−1}

yt−1(即在扩散过程的

t

−

1

t−1

t−1步向低分辨率图像

y

y

y添加噪声)应该具有相同的低频分量。因此,将

x

t

−

1

x_{t−1}

xt−1的低频分量替换为

y

t

−

1

y_{t−1}

yt−1的低频分量,保证了数据的一致性,并为扩散模型建立了改进的条件。作为一种先进的解决方案,CCDF[213]引入了统一的投影方法:

x

t

−

1

=

A

x

t

−

1

′

+

b

,

(16)

x_{t-1}=Ax_{t-1}^{\prime}+b, \tag{16}

xt−1=Axt−1′+b,(16)

其中设置

A

A

A和

b

b

b以实现数据一致性。例如,在SR任务中,上述投影可以实例化为:

x

t

−

1

=

(

I

−

P

)

x

t

−

1

′

+

y

t

−

1

,

(17)

x_{t-1}=(\mathbf{I}-\mathbf{P})x_{t-1}'+y_{t-1}, \tag{17}

xt−1=(I−P)xt−1′+yt−1,(17)

式中,

P

\mathbf{P}

P为低分辨率图像的退化过程。此外,本工作还证明了从更好的初始化开始生成可以提高逆向过程的速度。

3.4.2 基于分解的方法

值得注意的是,大多数图像恢复问题都可以看作是线性逆问题,可以表示为:

y

=

H

x

+

z

,

(18)

y=Hx+z, \tag{18}

y=Hx+z,(18)

其中

H

H

H是线性退化算子,

z

z

z是污染性噪声。在这种情况下,由于噪声

z

z

z的存在,无法直接估计条件概率

p

(

x

∣

y

)

p(x|y)

p(x∣y)。为了消除噪声

z

z

z, SNIPS[110]和DDRM[112]对退化算子h进行奇异值分解(SVD),在谱域中运行扩散过程,特别是SNIPS[110]基于退火朗之万动力学,在谱空间上推导条件分数函数,在图像去模糊、超分辨率、以及压缩感知任务。继SNIPS之后,DDRM[112]进一步将SVD分解扩展到线性逆问题的变分目标,这表明预训练的DDPM [82]/DDIM[85]可以是线性逆问题的最优解。值得注意的是,上述工作只关注线性逆问题。而Kawar等[111]则基于DDRM的特殊情况(即反向问题中无噪声

z

z

z)研究非线性逆问题,并将伪逆概念进行扩展,实现JPEG伪校正。对于MRI重建,SVD分解是不合适的。为了克服这一点,Song等人从头开始训练医学图像的无条件生成模型,然后利用采样过程中的矩阵分解来解决线性逆问题,这是未知测量过程的普遍问题。

DDNM[113]引入了另一种分解策略——距离-零空间分解,以进一步改善Zero-shot图像的恢复,其中距离空间负责数据一致性,零空间用于提高真实感(即感知质量)。给定无噪声逆

y

=

H

x

y = Hx

y=Hx,可分解为:

y

=

H

H

†

H

x

+

H

(

I

−

H

†

H

)

x

,

(19)

y=HH^{\dagger}Hx+H(I-H^{\dagger}H)x, \tag{19}

y=HH†Hx+H(I−H†H)x,(19)

式中,

H

†

H^{\dagger}

H†为退化操作H的伪逆。我们可以看到

H

H

†

H

x

=

H

x

=

y

HH^{\dagger}Hx = Hx = y

HH†Hx=Hx=y的范围空间可以保证数据的一致性,而

H

(

I

−

H

†

H

)

x

=

0

H(I−H^{\dagger}H)x = 0

H(I−H†H)x=0时,零空间

H

(

I

−

H

†

H

)

x

H(I−H^{\dagger}H)x

H(I−H†H)x对数据的一致性没有影响。如图11所示,在此基础上,DDNM[113]将时间步长

t

t

t处

x

0

x_0

x0的预测修正为:

x

0

∣

t

=

H

†

y

+

(

I

−

H

†

H

)

x

0

∣

t

x_{0|t} = H^{\dagger}y + (I−H^{\dagger}H)x_{0|t}

x0∣t=H†y+(I−H†H)x0∣t,其中

x

0

∣

t

x_{0|t}

x0∣t可以通过时间步长

t

t

t处的噪声预测来估计。通过整流后的

x

0

∣

t

x_{0|t}

x0∣t,我们可以在时间步长t−1处计算去噪后的输出

x

t

−

1

x_{t−1}

xt−1,保证了数据的一致性,为下一步的噪声预测提供了更好的条件。此外,DDNM还利用奇异值分解来解决带噪声的线性逆问题,称为DDNM+。

3.4.3 后验估计

基于投影的方法在图像恢复的反问题中表现出优异的性能,在扩散模型的反采样步骤之后加入基于投影的测量一致性校正。然而,大多数基于投影的工作都致力于无噪声逆问题,并且通常遭受不满意的数据一致性,因为投影将样本路径从数据流形中抛出[236]。为了解决一般的有噪声线性逆问题,一些研究[114,196, 197, 200, 216, 236]旨在利用基于贝叶斯定理的无条件扩散模型估计反向分布

p

(

x

∣

y

)

p(x|y)

p(x∣y)。它相当于在反向过程的每一步估计条件后验

p

(

x

t

∣

y

)

p(x_t|y)

p(xt∣y)。根据贝叶斯定理,可推导为:

p

(

x

t

∣

y

)

=

p

(

y

∣

x

t

)

p

(

x

t

)

/

p

(

y

)

.

(20)

p(x_t|y)=p(y|x_t)p(x_t)/p(y). \tag{20}

p(xt∣y)=p(y∣xt)p(xt)/p(y).(20)

对应的分数函数可估计为:

∇

x

t

log

p

t

(

x

t

∣

y

)

=

∇

x

t

log

p

t

(

y

∣

x

t

)

+

s

θ

(

x

,

t

)

,

(21)

\nabla_{x_{t}}\log p_{t}(x_{t}|y)=\nabla_{x_{t}}\log p_{t}(y|x_{t})+s_{\theta}(x,t), \tag{21}

∇xtlogpt(xt∣y)=∇xtlogpt(y∣xt)+sθ(x,t),(21)

其中,

s

θ

(

x

,

t

)

s_θ(x, t)

sθ(x,t)可以从预训练模型中提取,而

p

t

(

y

∣

x

t

)

p_t(y|x_t)

pt(y∣xt)项是难以处理的。由上式可知,准确估计

p

(

y

∣

x

t

)

p(y|x_t)

p(y∣xt)是图像恢复逆问题获得较好解的关键因素。

作为开创性的成果,MCG[236]和DPS[114]用

p

(

y

∣

x

0

)

p(y| x_0)

p(y∣x0)近似后验

p

(

y

∣

x

t

)

p(y|x_t)

p(y∣xt),

x

0

是

x_0是

x0是用Tweedie公式给出,

x

t

x_t

xt为

x

0

=

E

[

x

0

∣

x

t

]

x_0 = E_{[x_0|x_t]}

x0=E[x0∣xt] [114]时的期望。具体而言,MCG[236]从数据流形的角度考虑数据一致性,提出了流形约束梯度,使校正在数据流形上。然而,如图12所示,DPS[114]指出,MCG中的投影操作对数据一致性有害,因为它可能导致采样路径偏离数据流形。在此基础上,DPS[114]抛弃了逆向过程中的投影步骤,估计后验为:

∇

x

t

log

p

t

(

y

∣

x

t

)

≈

∇

x

t

log

p

(

y

∣

x

^

0

)

≈

−

1

σ

2

∇

x

t

∥

y

−

H

(

x

^

0

(

x

t

)

)

∥

2

2

(22)

\begin{aligned} \nabla_{x_{t}}\log p_{t}(y|x_{t})& \approx\nabla_{x_{t}}\log p(y|\hat{x}_{0}) \\ &\approx-\frac{1}{\sigma^{2}}\nabla_{x_{t}}\|y-H(\hat{x}_{0}(x_{t}))\|_{2}^{2} \end{aligned} \tag{22}

∇xtlogpt(y∣xt)≈∇xtlogp(y∣x^0)≈−σ21∇xt∥y−H(x^0(xt))∥22(22)

在以上工作的基础上,ΠGDM[197]进一步将公式22展开为退化函数

h

h

h为Moore-Penrose伪逆

h

†

h^{\dagger}

h†的线性、非线性、可微逆问题的统一形式:

∇

x

t

log

p

t

(

y

∣

x

t

)

≈

r

t

−

2

(

(

h

†

(

y

)

−

h

†

(

h

(

x

^

o

)

)

)

T

∂

x

^

o

∂

x

t

)

T

(23)

\nabla_{x_t}\log p_t(y|x_t)\approx r_t^{-2}((h^\dagger(y)-h^\dagger(h(\hat{x}_o)))^\mathrm{T}\frac{\partial\hat{x}_o}{\partial x_t})^\mathrm{T} \tag{23}

∇xtlogpt(y∣xt)≈rt−2((h†(y)−h†(h(x^o)))T∂xt∂x^o)T(23)

其中

r

t

−

2

r^{ - 2}_t

rt−2设为

σ

t

2

σ

t

2

+

1

\sqrt{\frac{\sigma_{t}^{2}}{\sigma_{t}^{2}+1}}

σt2+1σt2。根据该方程,ΠGDM开发了如图13所示的传递。

与上述工作不同的是,有些工作[196,216]试图用其他策略对

p

(

y

∣

x

t

)

p(y|x_t)

p(y∣xt)进行建模。值得注意的是,较高的条件概率

p

(

y

∣

x

t

)

p(y|x_t)

p(y∣xt)相当于

D

(

x

t

)

D(x_t)

D(xt)与

y

y

y之间较小的距离[196]。因此,GDP[196]提出了分布

p

(

y

∣

x

t

)

p(y|x_t)

p(y∣xt)的启发式近似如下:

p

(

y

∣

x

t

)

≈

1

Z

exp

(

−

[

s

L

(

D

(

x

t

)

,

y

)

+

λ

Q

(

x

t

)

]

)

(24)

p(y|x_t)\approx\frac{1}{Z}\exp(-[s\mathcal{L}(\mathcal{D}(x_t),y)+\lambda\mathcal{Q}(x_t)]) \tag{24}

p(y∣xt)≈Z1exp(−[sL(D(xt),y)+λQ(xt)])(24)

其中,

L

\mathcal{L}

L和

Q

\mathcal{Q}

Q分别为距离度量和质量损失。

Z

Z

Z是一个归一化因子,

s

s

s是控制制导权重的比例因子。但是距离

L

\mathcal{L}

L很难定义,因为

x

t

x_t

xt和

y

y

y中的噪声大小不同。因此,在距离测量中,他们将

x

t

x_t

xt替换为其清晰的估计值

x

0

x_0

x0。出于同样的目的,Copaint[216]尝试通过神经网络的一步估计来预测

x

0

x_0

x0。

Feng等[215]没有对难以处理的分布 p ( y ∣ x t ) p(y|x_t) p(y∣xt)进行建模,而是从变分的角度直接估计后验 p ( x t ∣ y ) p(x_t|y) p(xt∣y)。根据DPI[238, 239],他们通过RealNVP[240]以参数 θ θ θ归一化流定义了一组分布 q θ q_θ qθ,该分布通过真实后验分布和估计分布 q θ q_θ qθ之间的最小KL-散度进行优化。

4. 用于盲/真实世界图像恢复的扩散模型

尽管第3节中的方法在图像恢复方面取得了很大的突破,但大多数方法[100,101,104,112-114,197,218,219]都集中在解决合成失真上,这些失真通常在非分布(out -distribution, OOD)真实世界/盲退化中表现不佳。其原因源于现实IR的固有挑战:

- 未知的退化模式难以识别。

- 收集失真/干净的图像对是非常重要的,甚至在现实世界中是不可实现的。

为了克服这个问题,以前的工作[241-248]试图通过模拟现实世界的退化[72,241-244,246]和无监督学习[245,247,248]等来解决这个问题。受这些启发,一些开创性的工作[117,118,120,123,221]开始探索如何利用扩散模型来解决现实世界的退化问题。在本文中,我们将基于DM的盲/真实世界IR[108, 109, 118 - 121, 123, 220-222, 226]分为四类,即失真模拟[118,226]、核估计[119,120]、域翻译[122,226]和失真-不变扩散模型[123,222,237]。

4.1 失真模拟

值得注意的是,现实世界的失真通常是盲目的/未知的,其分布与简单的合成失真不同。对于基于有监督学习的IR,这要求恢复网络具有较强的泛化能力,或者合成数据集能够覆盖真实世界的失真。从因果关系的角度来看[249],这两个目的都依赖于模拟与现实世界失真相似的各种失真,我们称之为失真模拟/增强。有几种代表性的基于DM的IR方法[118,221]利用失真模拟来提高其方法对现实世界退化的鲁棒性。具有代表性的方法是SR3+[118],该方法基于SR3[100]的扩散模型,引入RealESRGAN[72]的二阶退化仿真进行训练。同样,为了模拟真实世界的退化,Yang等人[226]提出使用扩散模型合成真实世界的失真/干净训练对,其中失真图像在RealESRGAN中使用二阶退化进行初始化[72]。

4.2 核估计

核估计首先在盲图像恢复中提出[250-255],其中退化可以建模为 y = ( x ∗ k ) ↓ s + n y=(x*k)\downarrow_{s}+n y=(x∗k)↓s+n。这里, k k k是退化核, n n n是加性噪声。在此设置下,可以估计核 k k k作为指导,增强恢复网络的适应性。受此启发,BlindDPS[120]和GibbsDDRM[119]试图通过估计采样过程中的未知退化核来解决盲逆问题。特别是,BlindDPS[120]利用了DPS[114]架构,并利用一个并行扩散模型进行退化核估计。核估计扩散模型是在合成核上进行预训练的。与BlindDPS不同,GibbsDDRM[119]实现了部分折叠Gibbs采样器[256]的采样过程,从联合后验 p ( x t ∣ k , y ) p(x_t|k, y) p(xt∣k,y)中同时对核参数和图像进行采样。

4.3 域翻译

在现实世界中,很难收集到失真/干净的图像对。虽然有些工作试图模拟真实失真图像的退化过程,但合成失真的分布与真实图像的分布仍有很大的差距。为了进一步解决现实世界的IR问题,一系列的工作探索了用于图像恢复的域翻译技术。域翻译[257-261]旨在将图像从一个域翻译到另一个域。从域翻译的角度来看,合成失真图像、真实失真图像和高质量图像可以看作是三个不同的领域,它们共享相同的内容。

基于域翻译的基于DM的IR的工作大致可分为两类:1)第一种[226]旨在通过将低质量图像从合成域翻译到真实世界域,模拟更可靠的真实世界失真/干净图像对。这样,模拟数据集可以使恢复网络对真实退化具有更好的恢复能力。例如,Yang等人[226]首先利用预训练的扩散模型来合成现实世界的训练对,其中扩散模型是用现实世界的低质量图像进行预训练的,通过将合成的低质量图像失真到噪声空间来实现平移(即生成反转)。2)另一条流行的路线[122]利用无监督学习,其中域翻译是通过循环一致性约束实现的。特别地,两个生成器构建一个循环路径,其中一个生成器旨在将失真图像平移到无失真图像,另一个生成器用于将干净图像平移到失真图像。这使得无监督的训练与未配对的真实世界的失真和高质量的图像。RainDiffusion[122]的代表工作提出了两个合作分支的去雨方法,其中非扩散平移分支旨在利用预训练的循环一致生成器生成初始的配对干净/含雨图像,扩散平移分支利用多尺度扩散模型对结果进行细化。

4.4 失真-不变扩散模型

由于盲失真通常是多样和复杂的,因此要求扩散模型在现实世界中具有对这些失真的生成能力(即失真-不变性能力)。为了实现失真-不变的扩散模型,DifFace等[237]引入了预训练的恢复网络,例如SRCNN[1]或SwinIR[53],以获得初始干净图像作为采样起点 x N x_N xN,其中恢复网络使用RealESRGAN[72]的二阶退化进行训练,从而表现出良好的泛化能力,为扩散模型生成失真-不变的初始干净图像。Ren等[222]提出了一种基于多尺度退化不变量引导信息的失真-不变量扩散模型。他们对退化图像采用失真增强策略,以结构信息为导向获得不变表示。相比之下,Wang[123]利用低通滤波器来过滤低质量图像中的失真-不变量分量,因为不同的真实失真图像通常共享相同的结构信息。如图14所示,它们在采样阶段采用了类似于ILVR的简单迭代细化。在获得退化不变的 x ^ 0 \hat{x}_0 x^0后,他们使用增强模块(基于强大的CNN或基于Transformer的恢复方法)进一步提高图像质量。

5 实验

为了确保对不同的基于扩散模型的IR方法进行有效和彻底的比较,我们首先总结了不同任务的流行数据集、实验设置和评估指标。然后,我们对几种典型图像恢复任务的现有基准进行了比较,包括图像超分辨率、补全、去模糊和JPEG伪影去除。

5.1 数据集和实现细节

数据集。值得注意的是,来自不同IR任务的数据集的内容和退化模式存在显著差异。因此,我们总结了基于IR任务的常用数据集,包括SR、图像去模糊、图像补全、去阴影、去雪、去雨和去雾,见表8。

对于传统的图像SR(即双三次下采样),标准训练数据通常由DIV2K[45]和Flick2K[262]组成。然而,扩散模型的性能受到数据集大小的固有限制。因此,SR3[118]使用ImageNet对自然图像SR进行训练扩散模型,使用FFHQ[211]对人脸SR进行训练。在测试过程中,使用ImageNet 1K[263]对自然图像SR进行评估,使用CelebA-HQ对人脸SR进行评估。在此基础上,一系列工作还介绍了常用的SR测试数据集进行评估,如Set5[46]、Set14[47]、BSD100[264]、mangga109[265]、Urban100[266]。对于现实世界的SR, SR3+[118]提供了两个版本的训练数据,其中第一个版本由DF2K和OST[267] (即DIV2K, Flick2K和OST300)组成,第二个版本包含额外的61M内部图像和DF2K+OST。为了评估,测试数据由两台不同镜头的单反相机获得的RealSR[268]和DRealSR[269]组成。

对于图像去模糊,基于扩散模型的方法通常使用GoPro训练数据集[52]进行训练,并在GoPro测试数据集RealBlur-J[270]、REDS[51]和HIDE[271]上进行验证。在阴影去除任务中,利用ISTD[272]和SRD[273]进行训练和评估,其中ISTD包含135个带有阴影掩膜的场景。对于图像去雾任务,使用三个典型的数据集进行评估,包括Haze-4K [274], Dense-Haze[275]和RESIDE[276]。其中,Haze4K包含4000张模糊图像,Dense-Haze[275]由33对户外模糊和无模糊图像组成,而RESIDE [276]收集了真实世界443950张训练图像和5342张测试图像。图像去雪使用三个数据集,即CSD [277], Snow100k[278]和SRRS[279]。图像提取中的数据集包含多种降雨类型。例如Rain100H [?] , Rain100L[?], Rain800 [48], DDN-Data[280]包含了合成雨条的数量。RainDrop[49]收集了1119对不同背景和雨滴的雨/净图像。Outdoor-Rain[281]考虑了雨水的积累,为暴雨图像提供了更合理的建模。SPA-data[282]通过对多幅连续降雨图像的干净图像进行变形,构建大规模真实世界的雨纹。以上数据集的详细信息见表8。

实现细节。 我们分别在表9和表10中总结了有监督算法和Zero-shot算法的实现细节和数据集。对于有监督算法,我们描述了训练过程和测试过程中的配置,包括批大小、训练迭代、学习率、训练过程中的采样步长和推理过程中的采样步长。对于基于Zero-shot的方法,我们阐明了预训练的扩散模型,评估了数据集,以及推理过程中的采样步骤。常用的数据增强策略包括旋转和翻转操作。

5.2 评价指标

客观指标和主观指标在测量和比较不同IR算法的性能方面起着至关重要的作用。在本节中,我们详细阐述了图像恢复中常用的指标,即PSNR、SSIM[283]、LPIPS[284]、DISTS[285]、FID[286]、KID[287]、NIQE[288]和PI[289]。

- PSNR是图像恢复中最常用的度量,其目的是通过计算其均方误差(MSE)来测量失真图像与其相应的干净图像之间的像素距离。

- SSIM[283]也是传统的图像质量评估(IQA)度量,旨在满足人类的视觉感知系统。与PSNR相比,它从对比度、亮度、结构三个角度比较了失真图像与干净图像的相似性。为了进一步改进,在SSIM中引入了多尺度信息,称为MS-SSIM[290]。与基于学习的IQA指标相比,SSIM具有较快的计算速度,但距离人类感知仍有一定距离。

- LPIPS[284]是一种基于全参考学习的IQA度量,广泛应用于面向感知的图像恢复任务。它不是利用图像统计进行质量测量,而是利用预训练的AlexNet作为特征提取器,并针对人类感知优化线性层。LPIPS值越低,表示两幅图像在感知空间上越相似。

- DISTS[285]观察到两幅图像的纹理相似度和结构相似度可以分别通过VGG[291]对其特征的均值和相关性来衡量。基于这一发现,本工作在特征空间中对纹理和结构相似性进行了类似SSIM的距离测量。

- FID [286] (Fréchet起始距离)被广泛用于测量生成图像的保真度和多样性,这是对Inception Score[292]的改进。与缺乏真实世界参考图像的IS相比,FID利用初始模型编码层的特征对采样图像进行多元高斯分布建模,并计算生成图像与参考图像分布之间的Fréchet距离。

- KID [287] 和 FID 利用初始模型中的相同特征进行质量评估,同时拥有不同的距离测量策略(即具有多项式内核的最大平均差异(MMD))。 特别是,即使样本很少,KID 也比 FID 更稳定。

- NIQE[288]是一种早期的无参考/盲图像质量评估指标,其质量分数是使用多元高斯模型(Multivariate Gaussian Model, MGM)计算失真图像的自然场景静态(NSS)与自然图像之间的距离。

- PI是在PIRM Challenge on perceptual SR中提出的[289],旨在评估超分辨率图像的感知质量。定义为 P I = 0.5 ( ( 10 − M a ) + N I Q E ) PI = 0.5((10−Ma) + NIQE) PI=0.5((10−Ma)+NIQE),其中Ma[293]是SR的无参考IQA指标。

5.3 实验结果

为了证明不同扩散模型的优越性,我们在多个任务上对它们进行了客观的质量比较。具体而言,我们选择了三种常用的IR任务,包括图像超分辨率,图像去模糊和图像补全。评估指标由PSNR、SSIM[283]、FID[286]和LPIPS[284]组成。为了比较计算成本和网络复杂度,我们还测量了基于扩散模型的IR方法的运行时间、参数和flops 。一些扩散模型的定性结果如图15、16、17所示。

图像超分辨率实验结果。表3列出了基于有监督扩散模型的4倍图像超分辨率IR模型的实验结果,分别在DIV2K[45]和Urban100[266]数据集上进行了测试。我们发现Resdiff[217]在PSNR和SSIM上表现得非常好,在PSNR方面比其他扩散模型提高了大约0.5dB。这是因为Resdiff利用扩散模型生成残差信息,并使用预处理图像进行条件生成,从而保证了恢复图像在像素级上与高分辨率图像的一致性。相比之下,IDM[223]和CDPMSR[102]在主观指标上表现良好。他们利用预处理图像或预处理特征作为条件输入,这被证明对感知质量有有益的影响。在模型参数、运行时间和计算复杂度方面,SRdiff明显优于IDM和SR3。通过SRdiff生成一张图像需要43.5秒,花费84.22 GFlops和13.2M个参数。这是因为SRDiff将低分辨率图像编码到潜在空间,降低了处理的维数。此外,它具有100个采样步骤,因此采样速度比其他两种模型更快。

对于基于Zero-shot的扩散IR模型,定量比较见表4。我们在两个数据集(ImageNet 1K[263]和CelebA 1K[294])上测试了6个开源的4倍超分辨率扩散模型。从表中我们可以看到,DDRM[112]和DDNM[113]在各种指标上表现良好,其次是ILVR[195]。这是因为DDRM和DDNM从分解的角度考虑与低分辨率图像的数据一致性,而ILVR只保证低频一致性。DPS[114]和GDP[196]更关注生成图像的感知质量。GDP在两个数据集上表现良好,因为它使用经验公式而不是Tweedie公式进行后验估计,导致相对于DPS的一些性能改进。GDP也表现出最快的图像生成速度,其反向采样步长为25。这是因为它不需要DDRM中复杂的SVD分解和计算,从而加快了图像的生成。另一方面,DPS在每个采样步骤(大约1000步)之后执行校正,这使得它无法利用基于DDIM的采样方法进行加速。因此,使用DPS生成一张图像大约需要141.2秒。

图像去模糊实验结果。我们还使用ImageNet 1K[263]和CelebA 1K[294]数据集对高斯去模糊任务评估了五种基于零拍dmir方法。实验结果见表5。我们可以发现DiffPIR[198]和Dirac-DO[200]在PSNR和SSIM上取得了具有竞争力的性能,比DDRM[112]和DDNM[113]平均提高了1.0 dB到1.4 dB。此外,Dirac-PO[200]和DiffPIR[198]在感知指标上表现出优越的性能。DPS[114]在感知度量(包括LIPS和FID)上表现良好,但每张图像的生成时间较长。DiffPIR采用即插即用的采样方法,并合并DDIM采样策略,以确保生成图像的保真度和真实感,同时加快采样过程。Diracdiffion包括感知优化(PO)和失真优化(DO)模型,并采用增量重建和早期停止方法来实现感知与失真的权衡。因此,这两个模型在失真和感知指标上都表现得非常好。在所有使用的模型中,DDRM的采样时间最短,平均每张图像不到10秒,因为它只使用20个采样步骤。在模型参数方面,所有基于Zero-shot DM的IR方法都使用预训练模型,ImageNet数据集参数为552.8M, CelebA数据集参数为126M。

图像补全实验结果。我们验证了五种Zero-shot扩散模型在图像补全(窄掩模)任务上的性能,如表6所示。除了三个多任务模型,DPS [114], DDRM[112]和DDNM [113],我们还增加了两个模型,Repaint[212]和Copaint[216],专门为图像补全设计。在失真指标方面,与超分辨率的情况类似,DDRM和DDNM实现了更好的性能。在感知质量方面,DPS 在 CelebA-HQ 上表现出比 ImageNet 更好的感知性能,而 Repaint 和 Copaint 优于其他模型。Copaint优于Repaint模型,在CelebA-HQ和ImageNet数据集上分别减少了0.08dB和1.33dB的FID度量。这是因为Copaint从贝叶斯后验估计的角度考虑了未显示区域和显示区域之间的一致性,这比Repaint中使用的重采样策略在理论上更受支持。同时,为了获得更好的恢复质量,Copaint还采用了DDNM中的time travel方法[113],但这也增加了计算复杂度。就运行时间而言,DDRM仍然是生成单个图像的最快模型,因为它的采样步骤很少(运行时间几乎与NFE线性相关)。尽管与DPS相比,CoPaint的步长更短,只有250步,但它采用了time travel,这使得生成一张图像的采样运行时间增加到大约298秒。同样地,Repaint也需要相似的时间来生成图像,但coppaint的采样时间比Repaint略快。

推广到看不见的失真。在本节中,我们比较了基于扩散模型的IR方法与现有的基于CNN和基于Transformer的IR方法在图像超分辨率方面的泛化能力。这些方法的框架使用合成数据集DIV2K[45]进行训练,并在一个看不见失真的真实数据集(即RealSR[268])上进行评估。如表7所示,在可见退化情况下,基于CNN和Transformer的IR方法在PSNR/SSIM上的客观质量较好,而基于扩散的IR方法的主观质量较好。然而,在不可见的场景下,包括PSNR、SSIM和感知度量LPIPS,它们都表现出较差的性能。相反,StableSR方法在不可见的场景中表现出优越的泛化能力。原因是他们利用了RealESRGAN的失真合成策略,该策略旨在模拟现实世界的退化。

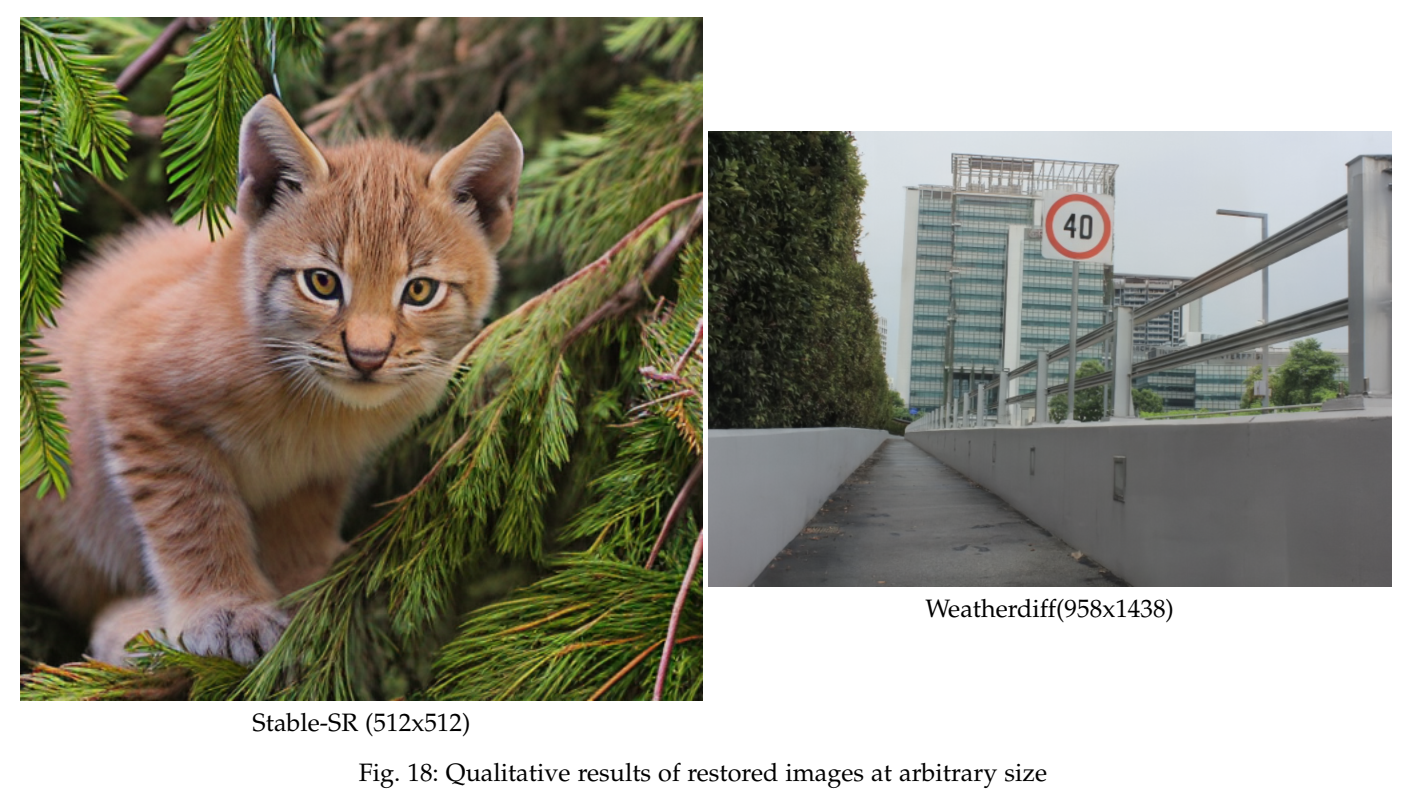

任意尺寸的图像恢复。一般情况下,扩散模型生成图像的分辨率要求与优化过程一致。这一限制阻碍了基于扩散模型的图像恢复处理任意大小的失真图像,特别是高分辨率图像,如2K和4K。一个直观的解决方案是,我们可以生成整个图像的每个部分,然后将它们拼接到一个图像中。然而,由于扩散模型固有的随机性,它会导致严重的不匹配问题和每个部分边缘的不一致。最近,有几篇论文[104,121,196,222]提出了解决这一问题的有效方法。特别是,DGDPM[222]使用全卷积层来处理任意大小的输入,但由于网络结构庞大,该方法的计算成本很高。相比之下,Weatherdiff[104]和GDP[196]均采用基于patch的恢复方法。他们从输入图像中提取重叠的patch,并将每个patch输入到扩散过程中以进行去噪。在噪声维度上对patch重叠部分进行平均,以保持patch之间的一致性。Stable-SR[121]也采用了基于patch的方法,同时使用高斯滤波器平滑patch重叠部分的噪声。我们在图18中展示了它们的有效性,其中不同patch之间的重叠区域几乎无法区分。

6 挑战与未来方向

近年来,基于扩散模型的IR研究取得了显著进展,但由于其鲁棒性、模型复杂度、运行效率和恢复能力等方面的局限性,在将其推广到实际应用中仍存在一定的挑战。为了进一步促进图像恢复的发展,本节总结了图像恢复面临的主要挑战,并提出了解决这些挑战的可能方向。

6.1 采样效率

值得注意的是,采样效率是扩散模型的一个典型挑战,其中很少的采样步骤将导致有限的生成保真度。这种扩散模型固有的问题损害了图像恢复的训练和推理速度。如表3所示,SR3[100]恢复一张224 × 224大小的图像需要50秒左右的时间,这比现有的IR方法要慢很多。先前关于扩散模型的研究尝试从四个方面提高采样效率:

- 用非马尔可夫链(non-Markov Chain)对扩散过程建模,如DDIM[85]。

- 设计高效的ODE求解器,如DPM求解器。

- 利用知识蒸馏减少采样步骤[157-160]。

- 引入带条件机制的交叉模态先验[116,117,121]。

在上述进展下,扩散模型的采样步骤大大减少到10 ~ 20步,这也有助于更快地恢复图像。特别是DDRM[112]采用DDIM[85]的采样策略,将一张224 × 224的图像的推理速度降低到8秒。

尽管如此,上述策略并不特定于图像恢复任务。不同的是,考虑到IR低质量图像含有丰富的结构和文本信息,一些工作[106,220,231]通过从低质量图像中采样而不是纯噪声来实现图像恢复,从而避免了原始DDPM中额外的采样步骤。尽管流程庞大,但距离实时应用还有很大的差距,这是迫切需要解决的问题。通过提高采样效率,加快基于扩散模型的IR成像速度是一个潜在的发展方向。

6.2 模型压缩

模型尺寸也是影响计算成本的重要因素,限制了基于扩散模型的图像恢复(IR)在移动设备等领域的实时应用。特别是DDPM[82]和SR3[100]的参数分别为113.7M和155.3M,大大超过了之前基于CNN的[34、35、232、296-300]或基于Transformer的IR主干[10、16、22、53-55、301]。

为了缓解这一问题,扩散模型压缩是一个潜在的但尚未开发的高效IR研究方向。模型压缩[302]以在保持任务性能的同时降低计算成本为目标,在四个方面取得了很大的突破:

- 模型修剪,通过估计每个参数的重要性得分来去除不重要的参数。

- 模型量化目标,用于减少存储或计算的浮点参数的位深度。

- 知识蒸馏的提出,将知识从复杂的教师模型转移到简单高效的学生模型。

- 低秩分解,将参数张量分解为多个低秩张量。

在此基础上,对扩散模型的模型压缩问题进行了进一步的研究。Kim等人[303]为扩散模型引入了去除块的知识蒸馏,该模型通过从UNet体系结构中去除一些残余块和注意块来构建学生模型。Fang等[304]指出并非所有扩散步骤都对生成过程有贡献,然后利用部分扩散步骤用泰勒展开估计参数剪枝的重要和不重要权重。此外,也有开创性的工作[305 - 308],对扩散模型采用模型量化来加速采样过程。尽管取得了这样的进展,但对于如何设计基于扩散模型的IR模型压缩的研究却很少,这一研究有望在实时应用中得到发展。

6.3 失真模拟与估计

现实世界/盲IR是一项具有挑战性但意义重大的任务,其目标是解决现实世界中遇到的未知和复杂的退化问题。在合成退化中,失真是预定义的,配对训练样本是可用的,与合成退化不同,收集成对的真实世界的失真/干净对是非平凡的,从而防止了有监督学习的训练。为了解决这一限制,引入了无监督学习来利用未配对的真实世界失真/干净图像。然而,这种学习模式通常会在恢复图像和低质量图像之间产生不满意的纹理一致性。相反,失真模拟是另一种有效的策略,通过模拟现实世界的退化来维持有监督学习。通常,RealESGRAN[72]和SR3+[118]是探索真实世界IR的手工二阶退化的代表性工作。尽管如此,手工制作的失真模拟很难覆盖现实世界中的所有退化。为了缓解这一问题,一些工作受到域翻译的启发,并引入GAN/扩散模型将合成的失真图像转换为真实世界的图像或将真实世界的失真图像转换为合成图像。前者旨在模拟现实世界的训练对进行有监督学习[226],而后者旨在直接利用合成图像训练的IR网络[122]。

现实世界/盲IR的另一个关键挑战来自失真估计,它涉及显式/隐式识别失真类型或水平。在本文中,我们从两个角度总结了失真估计的应用:

- 失真自适应学习。

- 解决IR中的逆问题。

从第一个角度来看,一个值得注意的例子是盲IR的核预测[120],其中估计的核/表示用于指导预训练的IR模型适应未知的退化。受此启发,如果我们能够以显式/隐式的方式估计失真类型或程度,我们就可以实现基于失真自适应学习的统一IR框架。对于第二种观点,如3.4节所述,许多基于Zero-shot扩散模型的IR方法都是基于线性逆问题的建模。这就对退化模式的识别提出了要求,这对于扩散模型的一致性约束是必要的。因此,由于现实世界中的失真模式难以识别,大多数研究都是针对合成失真进行的。为了将基于Zero-shot扩散模型的IR技术推广到实际应用中,迫切需要开发一种失真估计技术。

6.4 失真不变性学习

近年来,我们见证了基于扩散模型的IR在特定降解方面的快速发展。然而,当应用于看不见的失真类型和程度时,它不可避免地遭受不好的鲁棒性。这就提出了一个基本问题:如何在不同的失真类型和水平下实现一致的图像恢复?为了实现这一目标,我们提出了一个方向,称为失真不变性学习(DIL)[309],旨在使IR模型能够推广到未知和不同的退化。DIL的原理是学习在各种退化模式下不变的表示,并为重建保留足够的结构和文本信息。

受域泛化(DG)[310-314]的启发,我们可以提出一些潜在的方法,通过将每个失真模式视为一个域来实现IR的DIL。在DG领域,有三种典型的学习域不变特征的方法,包括域对齐[315 - 319]、数据增强[320-323]和元学习[324 - 327]。特别是,域对齐旨在通过最小化对比损失[328]、最大平均差异(MMD)或对抗性学习等来对齐源域和目标域的表示。利用数据增强技术扩展模型的域多样性和一致性,使模型具有域不变能力。元学习的目的是通过对齐不同域之间的梯度来学习域不变表示,这是从优化的角度出发的。通过将失真模式作为一个特定的域,我们可以获得几种实现失真不变性学习的策略:

- 我们可以利用IR的编码器-解码器架构,并在解码器之前对齐来自不同失真图像的表示。

- 第二种策略可以从失真增强中学习失真不变表示,即尽可能模拟现实世界中的各种失真。

- 利用元学习优化IR中的经验风险最小化[309]。

对于基于扩散模型的图像恢复,模型通常由噪声预测器和条件模块两部分组成。因此,我们可以从两个方面来实现失真不变性学习:1)学习失真不变性噪声预测器和2)失真不变性条件。显然,一旦我们实现了失真不变性条件,我们就可以在有监督IR中保留噪声预测器的不变性,或者在Zero-shot IR中利用预训练的扩散模型。在此基础上,一些开创性的工作尝试重新设计条件模块来实现失真不变性条件,如DifFace[237]和DR2[123]。值得注意的是,失真不变性条件还依赖于失真不变性学习来获得更好的条件,这在未来的工作中仍需要大量的改进工作。

6.5 框架设计

作为图像恢复的基础,如何设计一个有效的、功能强大的IR框架是一个持续存在的重要问题。我们可以注意到,最新的基于扩散模型的IR方法[100、101、112 - 114、196、197、219]是基于DDPM[82]的U-Net架构设计的,并分别从三个角度追求更好的框架,即条件策略[10、112、114、212、231]、生成空间[98、106、224]、噪声预测器[224]。IR扩散模型的条件是为了从低质量图像中引入结构和文本信息。在早期的工作中,SR3直接选择低质量图像作为拼接的条件。为了改善这种状况,一些研究[102,191,217,223,230]通过设计预处理网络,如特征提取器和预训练恢复网络来改善这种状况。在生成空间上,通常从图像空间、残差空间、潜在空间和频率空间四个空间来设计框架。其中,逐像素空间可以保留更多的空间结构和文本信息,可以生成高质量的图像[102,217,223]或残差[101,217],但计算成本和参数较高。相比之下,潜在空间生成需要较少的计算成本。然而,一个设计良好的编码器和解码器对于潜在空间的产生是至关重要的,以便在效率和保真度之间进行权衡。频率空间在图像恢复中得到了广泛的应用,包括小波变换、傅立叶变换等。与图像空间相比,频率空间更善于捕捉全局上下文信息,其中低频代表结构信息,高频代表纹理和样式信息。在DDPM[82]之后,在大多数工作中,噪声预测器是基于U-Net架构的。对于基于有监督扩散模型的IR,噪声预测器的修改通常是通过增加U-Net中剩余块的数量或在不同分辨率(如SR3)下调整通通道乘法器来实现的。在基于扩散模型的IR噪声预测器中,如何设计基于Transformer的全新结构,这方面的研究很少。此外,如何为基于扩散模型的IR任务设计像painter[329]这样统一的基础架构是迫切需要探索的。

7 CONCLUSIONS

本文对最近流行的IR扩散模型进行了全面回顾,挖掘了它们增强结构和纹理恢复的实质性生成能力。首先,我们说明了扩散模型的定义和进展。随后,我们从训练策略和退化情景的角度对现有工作进行了系统的分类。具体地说,我们将现有的工作分为三个突出的流程:基于有监督数据的IR,基于Zero-shot数据的IR和基于盲/现实世界数据的IR。对于每个流,我们提供了基于技术的细粒度分类法,并详细描述了它们的优缺点。为了评估,我们总结了基于DM的IR的常用数据集和评估指标。我们将开源 SOTA 方法与图像 SR、去模糊和补全等三个典型任务的失真和感知指标进行了比较。为了克服基于DM的IR的潜在挑战,我们强调了未来有望探索的五个潜在方向。

APPENDIX

数据集。表8总结了用于不同IR任务的数据集,包括SR、图像补全、去模糊、去噪、去阴影、图像去雪、图像去雨和图像去雾。它由发布年份、训练样本和测试样本数量以及简短描述组成。

实现细节。我们分别在表9和表10中总结了基于有监督和Zero-shot的IR方法的实现细节。对于有监督的基于dm的IR,我们阐明了训练数据集、测试数据集和一些关键的实现细节,包括批大小、迭代、学习率以及训练和推理阶段的采样步数。本文从测试数据集、预训练模型和采样步骤三个方面总结了基于Zero-shot DM的IR的实现细节。

![[Go版]算法通关村第十三关黄金——数字数学问题之数论问题(最大公约数、素数、埃氏筛、丑数)](https://img-blog.csdnimg.cn/428862e6c0034036979c3c7ccf93f534.png)

![[Linux]进程概念](https://img-blog.csdnimg.cn/img_convert/7584952d4714e8045fa13140f9e1b234.png)