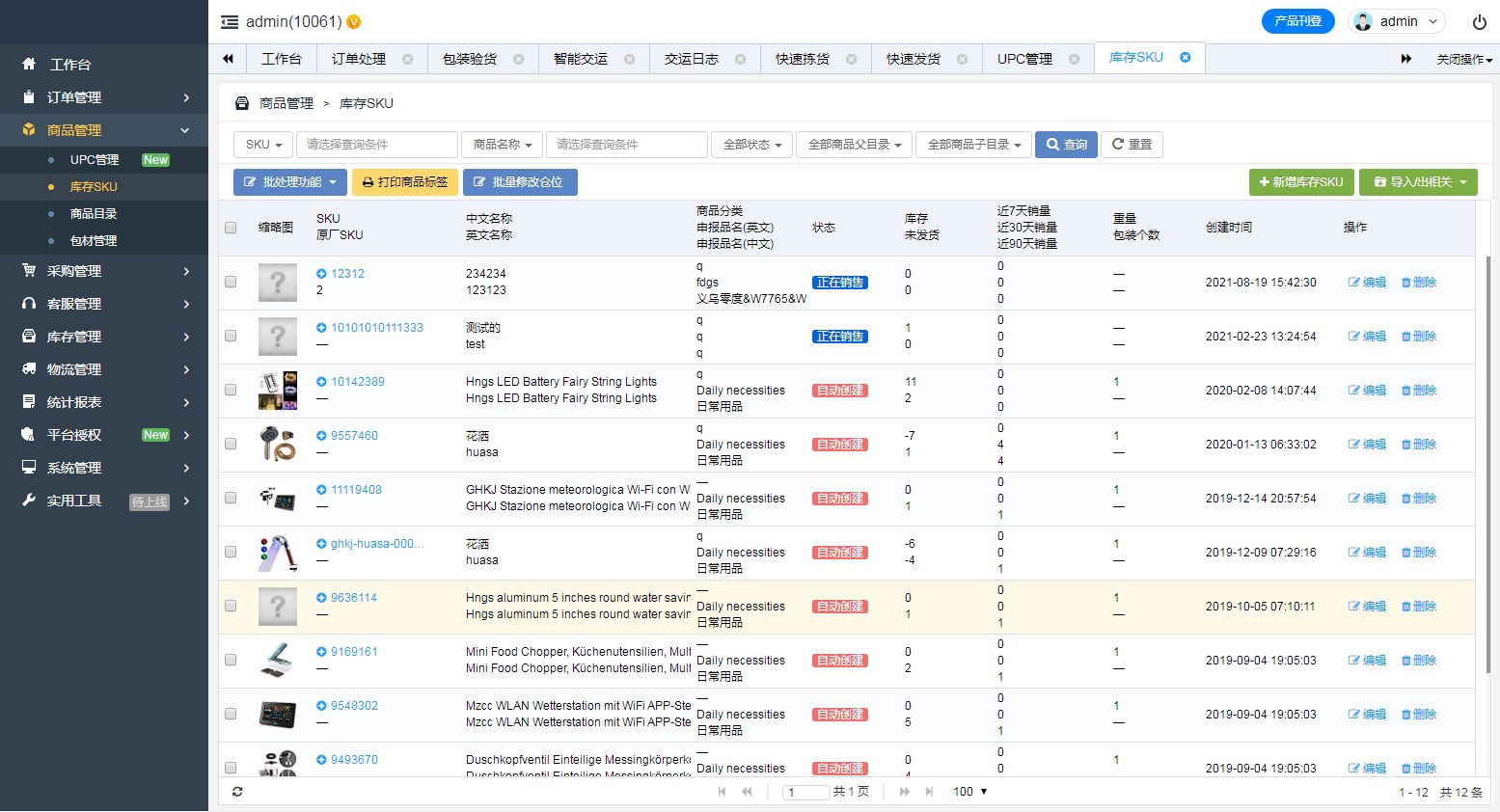

nginx在近两天连接数上去的时候业务有影响,错误日志频繁出现accept4() failed (24: Too many open files)报错信息,后续业务低峰自动恢复,以3种方式复现测试会报错的原因记录如下

请求模拟:使用nginx反向代理一个java后端

请求工具:使用ab命令(yum install httpd-tools -y)下载

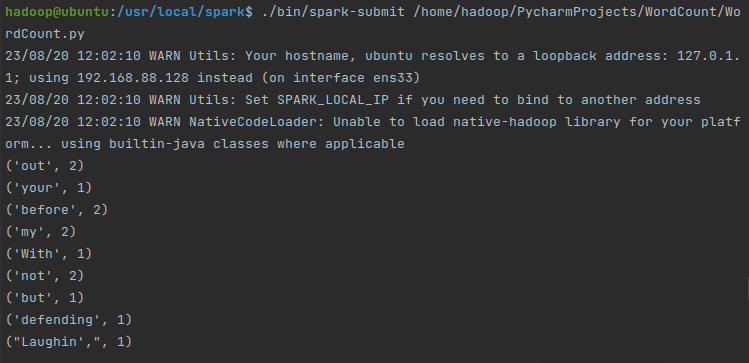

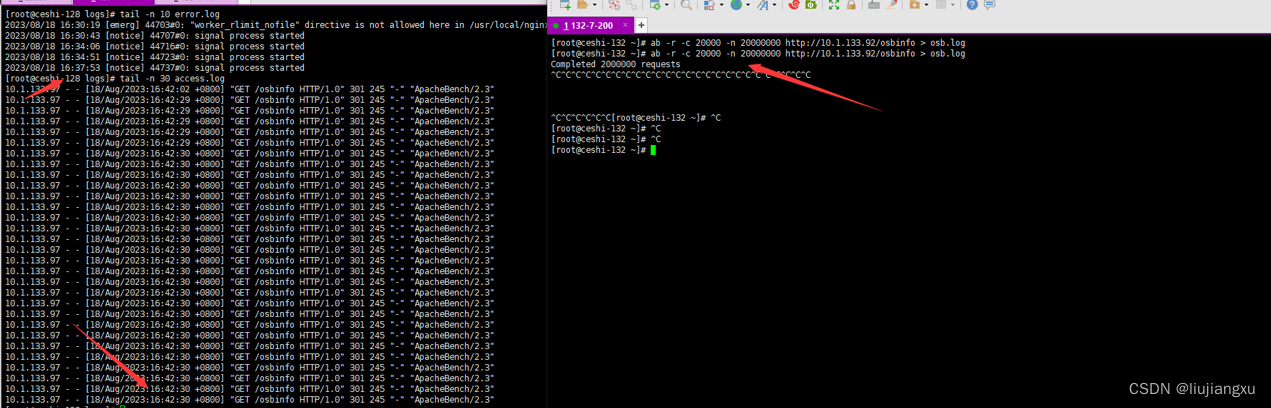

[root@ceshi-132 ~]# ab -r -c 20000 -n 2000000 http://10.1.133.92/osbinfo > osb.log

-n 请求数

-c 并发数

-r 不在接手错误是退出

ab命令并发最大在2w,可以提升,我这里没有做处理2w足够复现了

当使用ab命令请求是如果终端报错,临时将宿主机ulimit调大(ulimit -n 65535)

是因为宿主机每个进程可以同时打开的最大文件句柄数默认在1024,压测是比实际请求更大量的请求,ab命令严格来说不是很严谨

[root@ceshi-132 ~]# ab -r -c 20000 -n 20000000 http://10.1.133.92/osbinfo > osb.log

socket: Too many open files (24)

1. 设置工作进程连接数1024 (压测并发都为2w)

events {

worker_connections 1024;

}

1.1 日志大量报错

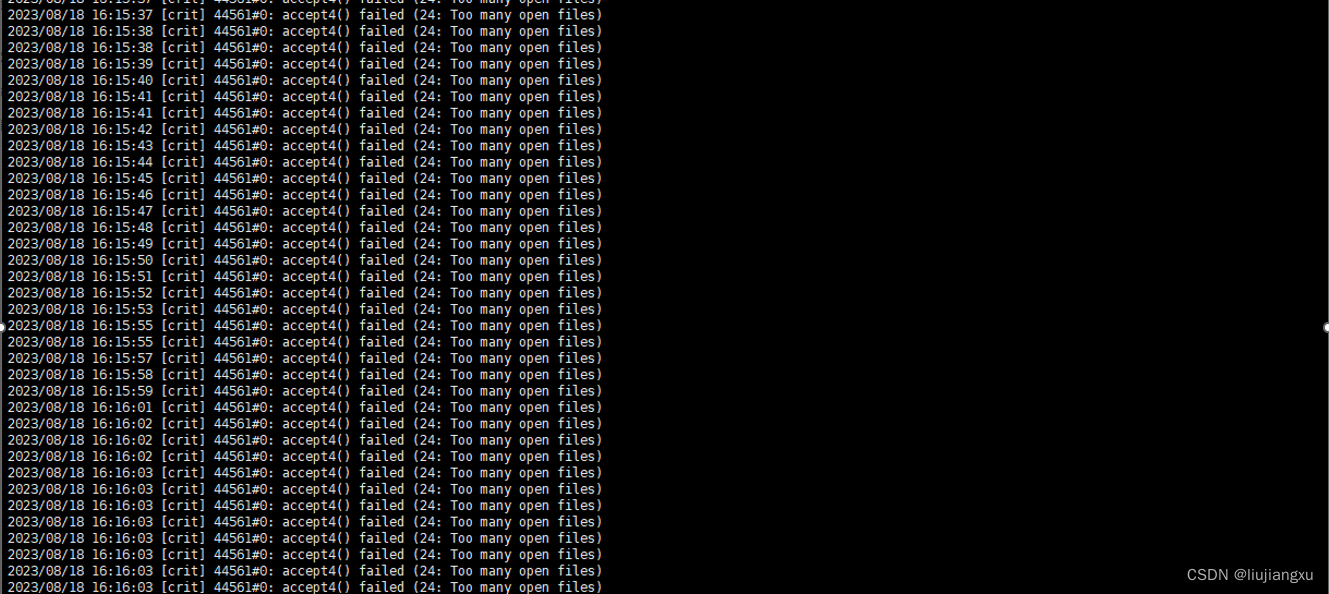

1.2 大量连接状态为TIME_WAIT

以上现象我大概理解为,1连接数过多、2打开句柄文件过多导致问题出现

2. 设置工作进程连接数124

events {

worker_connections 124;

}

2.1 没有错误日志,请求应该是在排队中,这个时候我查看access日志时发现请求日志是一批一批进来的,我这里可能与实际的业务请求有偏差,我也就是请求一个index.html静态页面,实际的业务应该还会有更多的动作

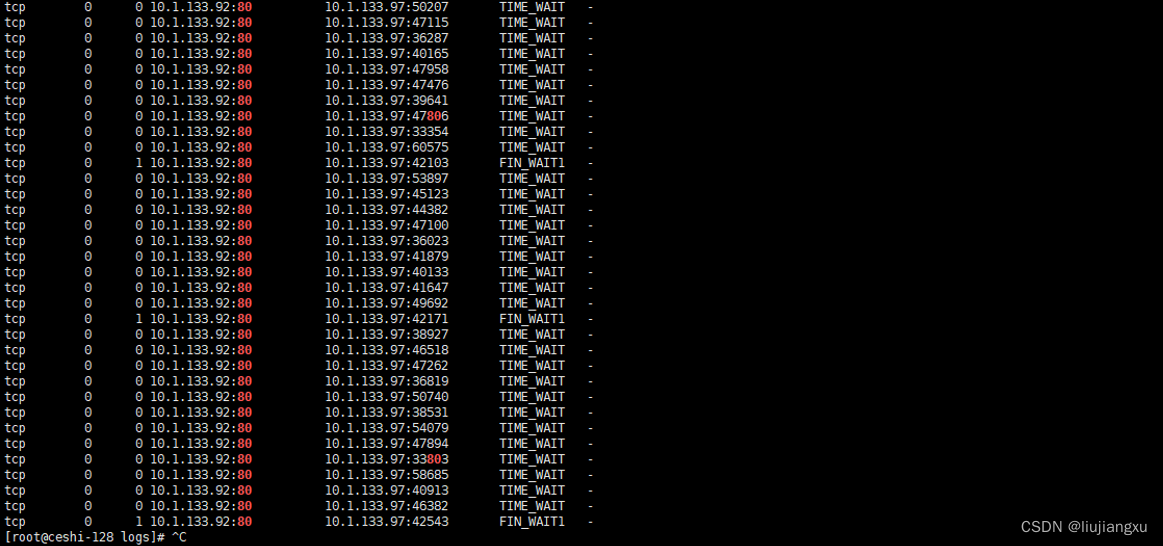

2.2 大量连接状态为FIN_WAIT_2

实际上FIN_WAIT_2状态下的SOCKET,表示半连接,也即有一方要求close连接,但另外还告诉对方,我暂时还有点数据需要传送给你,稍后再关闭连接

3. 设置工作线程连接数和worker_rlimit_nofile 65535

worker_rlimit_nofile 65535;

events {

worker_connections 1024;

}

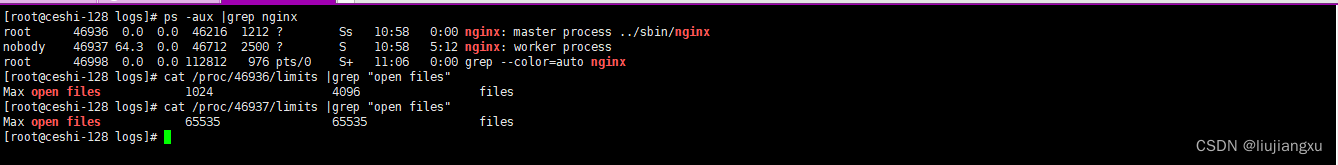

3.1 worker_rlimit_nofile 65534; 这个值默认根据系统ulimnt,此设置为将工作进程的最大文件打开数限制,覆盖系统默认1024的参数,但不会改变master进程的文件打开数,你可以设置此值后查看master进程和工作进程的参数不一样(重启生效)

[root@ceshi-128 logs]# ps -aux |grep nginx

root 46936 0.0 0.0 46216 1212 ? Ss 10:58 0:00 nginx: master process ../sbin/nginx

nobody 46937 64.3 0.0 46712 2500 ? S 10:58 5:12 nginx: worker process

root 46998 0.0 0.0 112812 976 pts/0 S+ 11:06 0:00 grep --color=auto nginx

[root@ceshi-128 logs]# cat /proc/46936/limits |grep "open files"

3.2 请求正常,无报错

从16:37一直到16:42在没有错误日志,而且access日志没有出现分批的情况

3.3 永久修改系统ulimit参数(可选)

Linux系统中ulimit-n的配置文件通常为/etc/security/limits.conf。我们需要在该配置文件中添加以下内容

* soft nofile 65536 #软件

* hard nofile 65536 #硬件

以上简单的方式算是一个粗略的测试,从而简单的看到什么情况出现Too many open files的问题所在,也是我自己的个人理解,以简单记录