- tensor 的四则运算

- broadcast

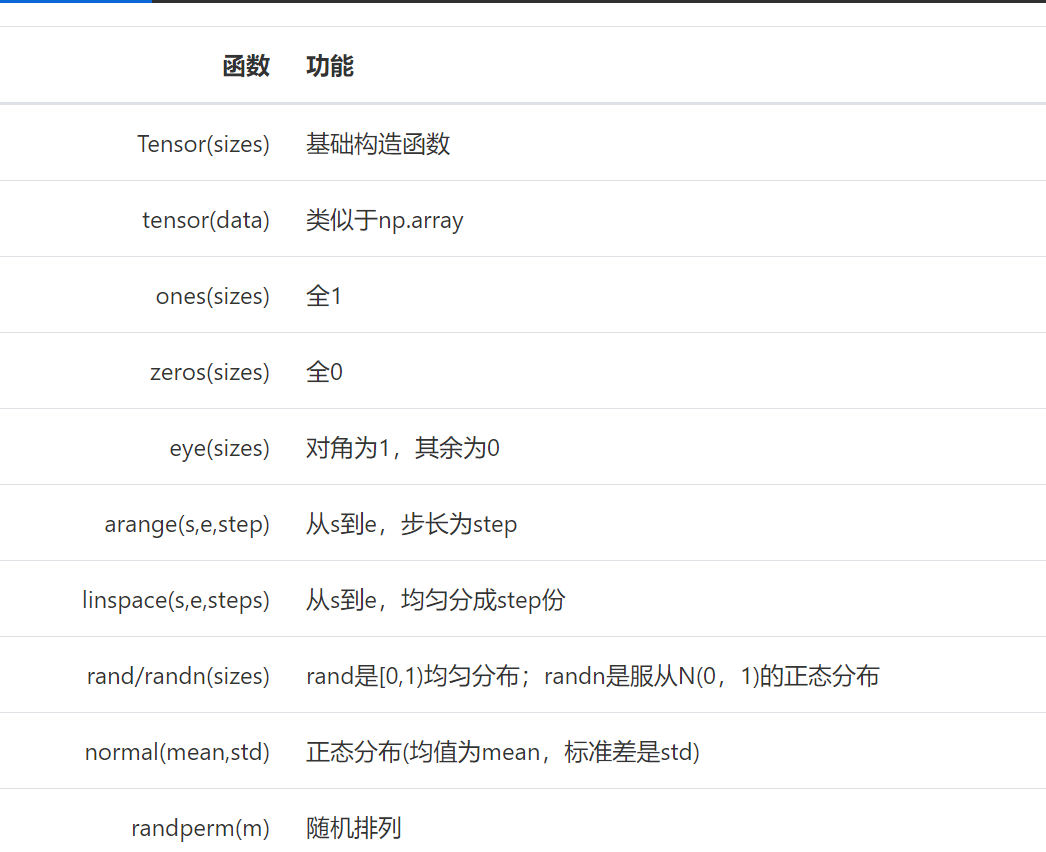

import torch

import numpy as np

# 张量tensor 随机初始化

x = torch.rand(4,3)

print(x)

y =torch.randn(4,3)

print(y)

# 初始化全零 张量

a = torch.zeros((4,4),dtype=torch.long)

print(a)

#初始化全一 张量

b = torch.ones(4,4)

print(b)

c = torch.tensor(np.ones((2,3),dtype='int32'))

print(c)

常见的构造Tensor的方法:

# tensor 的基本操作

# 加法

print(a+b)

# add_ = replace in 操作

y = a.add_(3)

print(y)

out:

tensor([[1., 1., 1., 1.],

[1., 1., 1., 1.],

[1., 1., 1., 1.],

[1., 1., 1., 1.]])

tensor([[3, 3, 3, 3],

[3, 3, 3, 3],

[3, 3, 3, 3],

[3, 3, 3, 3]])

#索引操作

x = torch.rand(3,4)

print(x)

# 第二列

print(x[:,1])

# 第二行

print(x[1,:])

#维度变换 张量的维度变换常见的方法有torch.view()和torch.reshape()

x = torch.randn(4,3)

y = x.view(12)

z = x.view(-1,6)

print(x.size(),y.size(),z.size())

print(x)

print(z)

# 最后x tensor size 没有发生改变

#view()仅仅是改变了对这个张量的观察角度

print(x)

#我们希望原始张量和变换后的张量互相不影响。

#为了使创建的张量和原始张量不共享内存,我们需要使用第二种方法torch.reshape(),

#同样可以改变张量的形状,但是此函数并不能保证返回的是其拷贝值,所以官方不推荐使用

a = torch.randn(4,4)

b = a.reshape(2,8)

print(a)

print(b)

#广播机制

#当对两个形状不同的 Tensor 按元素运算时,可能会触发广播(broadcasting)机制:先适当复制元素使这两个 Tensor 形状相同后再按元素运算。

x = torch.arange(1,4).view(1,3)

print(x)

y = torch.arange(1,5).view(4,1)

print(y)

print(x+y)