激活函数总结(十四):激活函数补充

- 1 引言

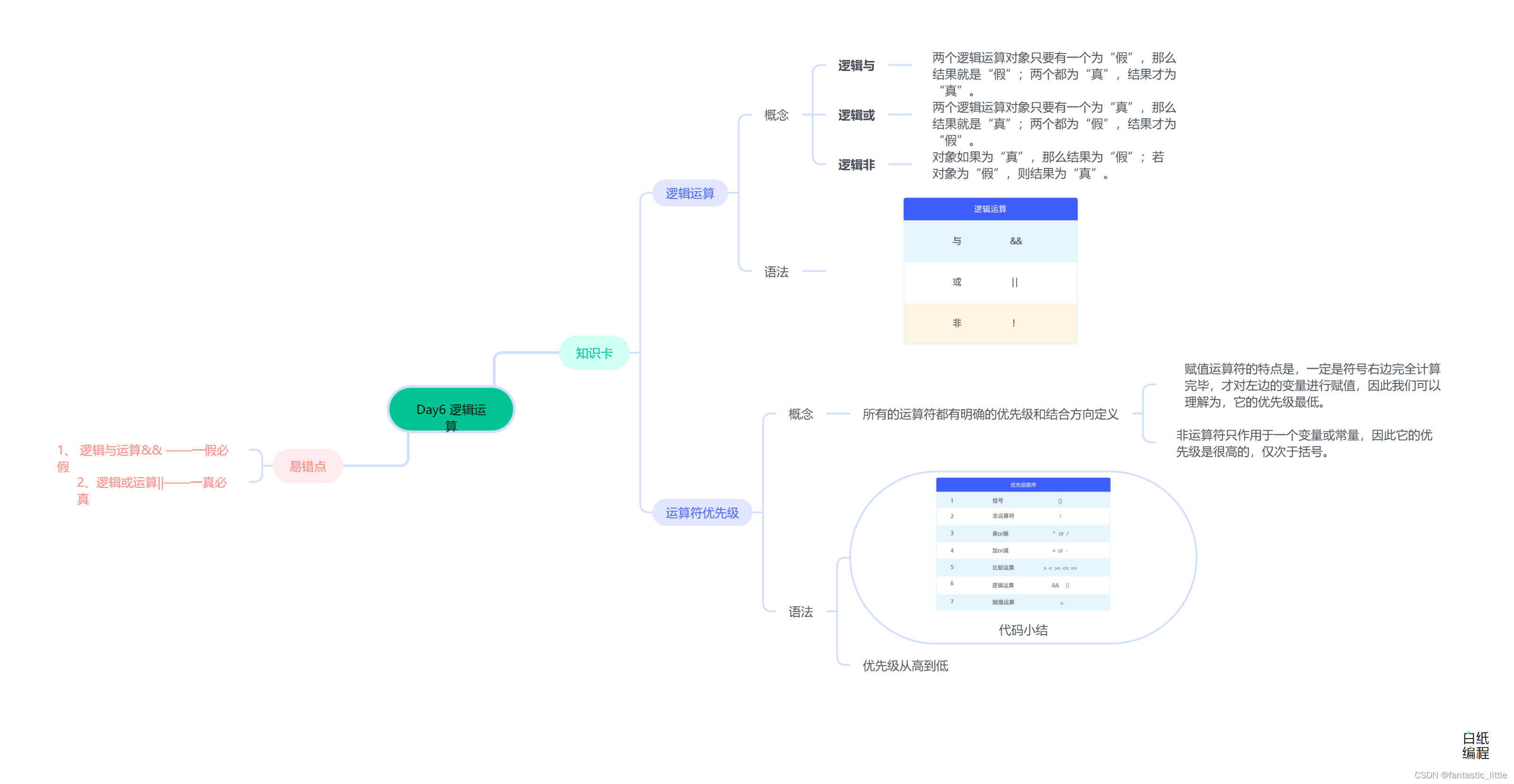

- 2 激活函数

- 2.1 Gaussian 激活函数

- 2.2 Growing Cosine Unit (GCU)激活函数

- 2.3 Amplifying Sine Unit (ASU)激活函数

- 3. 总结

1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

最后,对于文章中没有提及到的激活函数,大家可以通过评论指出,作者会在后续的文章中进行添加补充。

2 激活函数

2.1 Gaussian 激活函数

Gaussian 激活函数通常指的是基于高斯函数(正态分布函数)的激活函数。这个激活函数使用高斯分布的形状,当输入

x

x

x 趋近于0时,激活值逐渐趋近于1,而在

x

x

x 远离0时,激活值迅速趋近于0。这种形状可以在一定程度上提供类似于 Sigmoid 或 Tanh 的非线性映射,但相对平滑。其数学表达式为和数学图像分别如下所示:

f

(

x

)

=

e

−

x

2

f(x)=e^{−x^2}

f(x)=e−x2

优点:

- 平滑度:高斯激活函数是

连续且平滑的,这意味着它在任何地方都是可微的,并且具有良好的梯度。此属性使优化算法可以轻松收敛到最佳解。 - 非线性:高斯激活函数将

非线性引入网络,使其能够对输入和输出之间的复杂关系进行建模。

缺点:

- 复杂性:高斯激活函数会增加网络的

复杂性,并且可能需要更多的计算资源来训练。 - 过拟合:如果网络变得过于复杂,它可能会开始

过度拟合训练数据,这意味着它记住训练数据而不是学习一般模式。 - 局部最小值:高斯激活函数也可能倾向于卡在

局部最小值中,这会使优化更加困难,并可能导致次优解。

当前状况很少使用,但是也在一些顶刊中出现过。。。。

2.2 Growing Cosine Unit (GCU)激活函数

论文链接:Noel, Mathew Mithra, Advait Trivedi, and Praneet Dutta. “Growing cosine unit: A novel oscillatory activation function that can speedup training and reduce parameters in convolutional neural networks.” arXiv preprint arXiv:2108.12943 (2021).

Growing Cosine Unit (GCU) 激活函数是近年来提出的一种新型激活函数,其设计灵感来自余弦函数,旨在缓解神经网络训练过程中的一些问题。GCU是一种振荡型非单调激活函数,它打破了激活函数领域的传统,使激活函数领域发生了革命性的变化。其数学表达式为和数学图像分别如下所示:

f

(

x

)

=

x

∗

c

o

s

(

x

)

f(x) = x*cos(x)

f(x)=x∗cos(x)

优点:

- 振荡非单调:振荡激活函数可以用

较少的神经元执行复杂的指定任务方面具有优势,而且计算成本更低,性能更强。 - 改善梯度流动:因为GCU激活的

导数值较小,仅接近域中的孤立点,而不是整个无限区间。因此,其存在改善梯度流动、缓解梯度消失的优点。

缺点:

- 计算复杂性: 相对于一些

传统的激活函数,GCU 激活函数的计算可能稍复杂,可能在大规模网络中影响训练速度。

当前GCU激活函数较常用于微机电系统中的非线性振荡类型的深度网络模型中。。。。

2.3 Amplifying Sine Unit (ASU)激活函数

论文链接:Amplifying Sine Unit: An Oscillatory Activation Function for Deep Neural Networks to Recover Nonlinear Oscillations Efficiently

ASU激活函数是一种新型振荡激活函数,对于复杂的振动系统(如微机电系统),它比GCU更有效。其数学表达式为和数学图像分别如下所示:

f

(

x

)

=

x

∗

s

i

n

(

x

)

f(x)=x*sin(x)

f(x)=x∗sin(x)

优点:

- 振荡非单调:振荡激活函数可以用

较少的神经元执行复杂的指定任务方面具有优势,而且计算成本更低,性能更强。 - 周期性:ASU激活函数可以提取

周期性数据中的复杂特征。

缺点:

- 计算复杂性: 相对于一些

传统的激活函数,ASU激活函数的计算可能稍复杂,可能在大规模网络中影响训练速度。

当前ASU激活函数较常用于复杂周期性系统的深度网络模型中。。。。效果较GCU更好、更稳定。。。

3. 总结

到此,使用 激活函数总结(十四) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。