大家好,我是来自爬虫世界的小编。今天,我要和大家分享一些关于Python爬虫中的异常处理和网络请求优化的经验。不论你是初学者还是有一定经验的爬虫程序员,我相信这些实用的技巧和代码示例都能为你在爬取数据的过程中带来方便和效率。

1.异常处理——保护爬虫免受中断和封禁

在爬虫过程中,我们经常会遇到网络超时、页面丢失或者被封禁的情况。为了确保爬虫的健壮性,我们需要进行适当的异常处理。

代码示例:

```python

import requests

try:

response=requests.get(url)

#处理页面数据

…

except requests.exceptions.Timeout:

#处理网络超时错误

…

except requests.exceptions.HTTPError as err:

#处理HTTP错误

…

except requests.exceptions.RequestException:

#处理其他异常

…

```

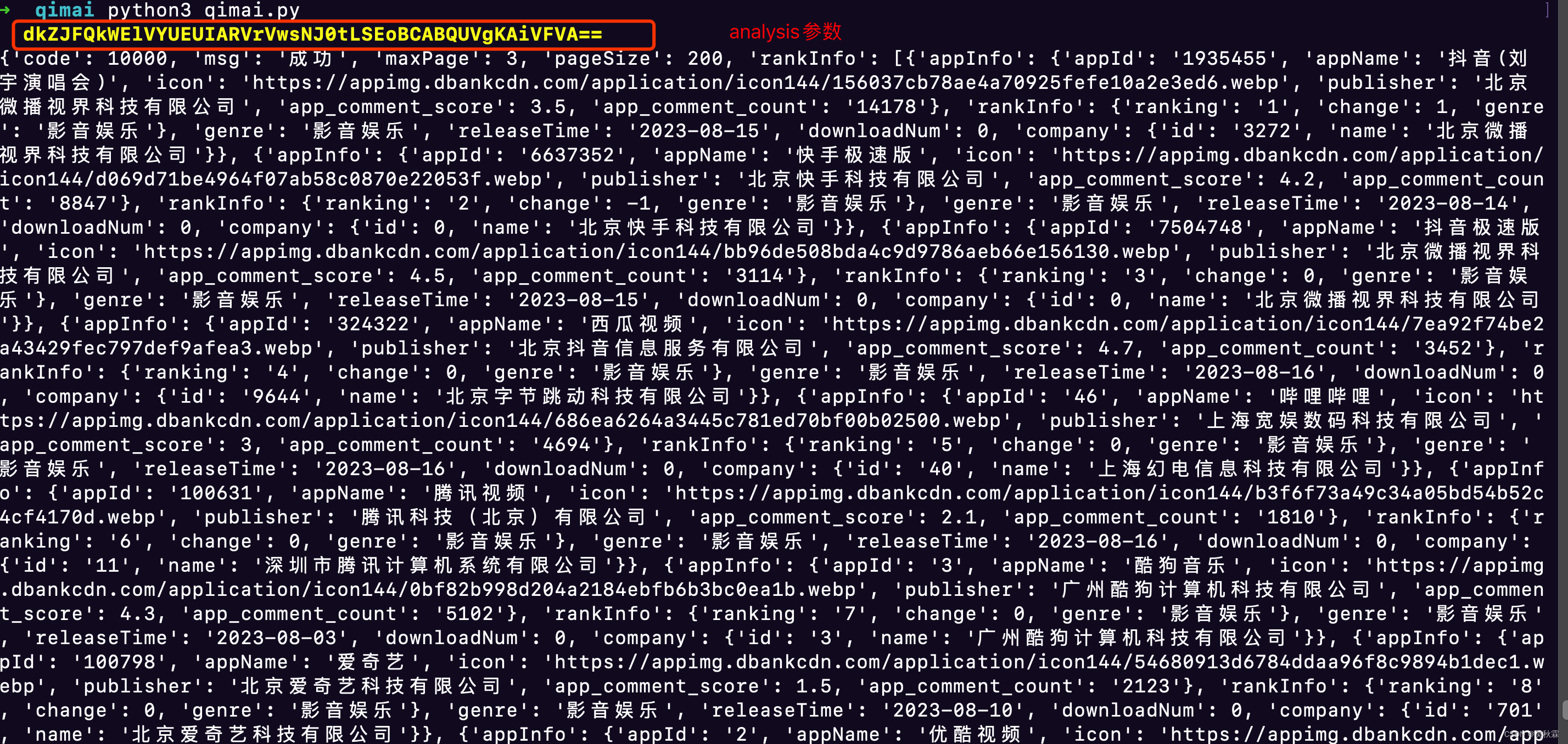

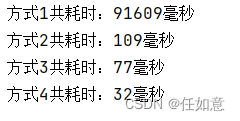

2.优化网络请求——提高爬取速度和发出请求的成功率

为了提高爬取速度和成功率,我们可以采取一些优化网络请求的策略。比如,使用连接池、设置请求头和代理等。

代码示例:

```python

import requests

from requests.adapters import HTTPAdapter

from requests.packages.urllib3.util.retry import Retry

session=requests.Session()

retries=Retry(total=5,backoff_factor=0.1,status_forcelist=[500,502,503,504])

session.mount(‘http://’,HTTPAdapter(max_retries=retries))

session.mount(‘https://’,HTTPAdapter(max_retries=retries))

headers={

‘User-Agent’:‘Mozilla/5.0(Windows NT 10.0;Win64;x64)AppleWebKit/537.36(KHTML,like Gecko)Chrome/58.0.3029.110 Safari/537.3’

}

proxies={

‘http’:‘http://127.0.0.1:8080’,

‘https’:‘https://127.0.0.1:443’

}

response=session.get(url,headers=headers,proxies=proxies,timeout=10)

```

3.降低对目标网站干扰——设置延迟和随机User-Agent

为了不给目标网站造成过大的负担和让请求看起来更像是人类操作,我们可以设置延迟和随机的User-Agent。

代码示例:

```python

import random

import time

time.sleep(random.uniform(2,5))#设置随机延迟

user_agent_list=[

‘Mozilla/5.0(Windows NT 6.1;WOW64)AppleWebKit/537.36(KHTML,like Gecko)Chrome/56.0.2924.76 Safari/537.36’,

‘Mozilla/5.0(Windows NT 10.0;Win64;x64)AppleWebKit/537.36(KHTML,like Gecko)Chrome/58.0.3029.110 Safari/537.3’,

…

]

headers={

‘User-Agent’:random.choice(user_agent_list)

}

response=requests.get(url,headers=headers)

```

以上就是我为大家分享的关于Python爬虫中的异常处理和网络请求优化的经验。希望这些实用的技巧和代码示例,能让你在爬取数据的过程中更加轻松和高效。如果你还有其他的疑问或者想分享自己的经验,欢迎在评论区留言。大家一起进步,共同探索爬虫的无限可能吧!