作为一名专业的爬虫程序员,今天主要要和大家分享一些技巧和策略,帮助你在批量爬虫采集大数据时更高效、更顺利。批量爬虫采集大数据可能会遇到一些挑战,但只要我们掌握一些技巧,制定一些有效的策略,我们就能在数据采集的道路上一帆风顺。

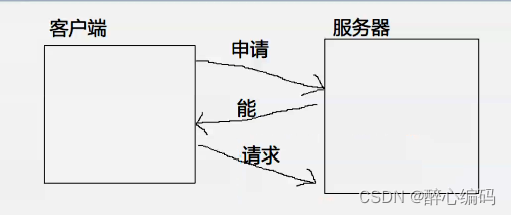

1、设立合理的请求频率

在进行批量爬虫采集时,频繁的请求可能会导致服务器的封禁或限制。为了避免这种情况,我们可以设置合理的请求频率。例如,在每次请求之间加入适当的延迟,以模拟真实用户的行为。这样做可以减少被封禁的风险,并且有助于我们更好地处理大量的数据。

2、使用并行处理技术

为了加快数据采集的速度,我们可以运用并行处理技术。通过同时运行多个爬虫实例或使用多线程/多进程来处理任务,我们能够更快地获取数据。当然,在使用并行处理技术时,我们也需要注意服务器的负载和资源使用情况,以免给目标网站带来过大的压力。

3、配置合理的代理池

当我们进行批量数据采集时,IP封禁和限制是一个常见的问题。为了解决这个问题,我们可以使用代理池。代理池可以提供多个IP地址,使我们能够在请求过程中轮换使用不同的IP,从而避免被服务器封禁。同时,我们也可以通过代理池来实现分布式采集,从多个代理服务器同时发起请求,提高采集效率。

4、合理处理错误和异常情况

在大规模数据采集中,很容易遇到各种错误和异常情况。为了提高爬虫的稳定性和容错性,我们需要合理处理这些问题。例如,当请求超时或返回错误时,我们可以设置重试机制,再次发起请求。同时,我们也可以记录日志或发送通知,及时了解并解决异常情况。

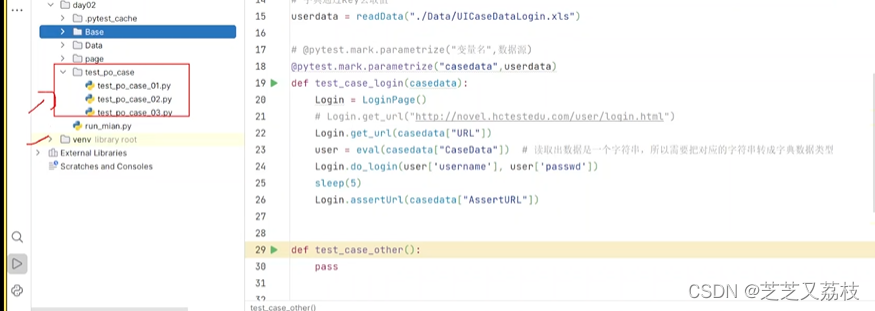

下面是一个示例,展示了如何在Python中使用多线程并行处理来进行大规模数据采集:

import requests

import threading

# 采集任务列表

urls = ['http://www.example.com/page1', 'http://www.example.com/page2', 'http://www.example.com/page3']

# 采集函数

def crawl(url):

try:

response = requests.get(url, timeout=10)

# 处理返回的数据...

except Exception as e:

# 异常处理逻辑...

# 创建线程列表

threads = []

for url in urls:

thread = threading.Thread(target=crawl, args=(url,))

threads.append(thread)

# 启动线程

for thread in threads:

thread.start()

# 等待线程结束

for thread in threads:

thread.join()

# 继续处理数据...

在这个示例中,我们使用了多线程来同时执行多个采集任务。每个线程独立地发起请求,处理返回的数据,并将其保存到适当的位置。通过使用多线程并行处理,我们能够更快地采集大量的数据。

以上就是我对于批量爬虫采集大数据的技巧和策略的分享。希望这些技巧和策略能够帮助你更高效地进行数据采集,同时也提醒大家注意合法合规的采集行为,遵守相关法律法规。如果你还有其他疑问或者想分享自己的经验,请在评论区留言,让我们共同学习、探索爬虫的无限魅力!