AlexNet论文地址:

https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

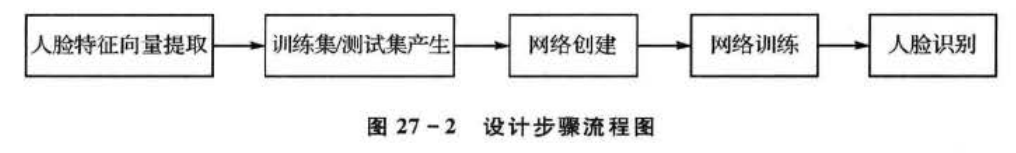

1、简介

AlexNet是2012年ISLVRC(ImageNet Large Scale Visual Recognition Challenge)竞赛的冠军网络,图像分类的正确率从70%提升到80%,是Hinton(反向传播发明人)和他的学生Alex一起设计的,从AlexNet在ISLVRC 2012夺冠后,深度学习开始迅速发展。

ISLVRC 2012

训练集:1281167张已经标注的图片

验证集:50000张已经标注的图片

测试集:100000张未标注的图片

2、亮点

- 首次利用GPU进行网络加速训练

- GPU训练和CPU训练区别就是GPU的并行运算能力比CPU强很多,GPU的速度是CPU的20-50倍。

- 使用了Relu作为激活函数,而不是传统的Sigmoid和tanh作为激活函数

- ReLU是一个比较狠的东西,通常网络在提取特征的时候,数值都是在-1到+1之间,如果你是负数,Relu的做法就是直接给你干没了,就是等于0,这和之前的sigmoid、Tanh大不一样,也就是说不好的特征直接不要了。就这一个点几乎就是对整个深度学习产生了一个彻底的改变

- 使用了LRN局部响应归一化

- 对局部神经元的活动创建竞争机制,使得其中响应比较大的值变得相对更大,并抑制其他反馈较小的神经元,增强了模型的泛化能力

- 在前面两层的全连接使用了Dropout

- 所谓Dropout就是直接随机杀死一些神经元,就是一些神经元的权重直接为0,相当于没有了。这个做法可以有效避免过拟合的产生

- Dropout和AlexNet都是由Alex的导师Hinton(2018图灵奖获得者)在2012年提出的,AlexNet是Alex和Hinton一起提出的

- Dropout论文地址

Dropout就是对一个数据集过度学习

这个网络可以看成两个部分,因为作者当初是用两个GPU进行训练的,然后上下两个部分是一毛一样的

这个网络可以看成两个部分,因为作者当初是用两个GPU进行训练的,然后上下两个部分是一毛一样的

看第一个卷积

原始图像数据的维度是:(224,224,3)

输出维度:(55,55,96)

kernels:48*2 = 96

kernels_size:11

padding:[1,2]

stride:4

图中没有给出池化的大小

池化

maxpool:1

kernel_size:3

padding:0

stride:2