Pod基础概念

Pod是kubernetes中最小的资源管理组件,Pod也是最小化运行容器化应用的资源对象。一个Pod代表着集群中运行的一个进程。kubernetes中其他大多数组件都是围绕着Pod来进行支撑和扩展Pod功能的,例如,用于管理Pod运行的StatefulSet和Deployment等控制器对象,用于暴露Pod应用的Service和Ingress对象,为Pod提供存储的PersistentVolume存储资源对象等。

Pod的定义?

Pod 是 K8S 最小的创建和运行管理单元

一个 Pod 能包含几个容器?

1个 pause容器(基础容器/父容器/根容器)

1个或多个应用容器(业务容器)通常一个Pod最好只包含一个应用容器,一个应用容器最好只运行一个业务进程

同一个Pod里的容器,都是运行在同一个Node节点上的,并且共享 NET MNT UTS IPC PID 命名空间

在Kubrenetes集群中Pod有如下两种使用方式:

- 一个Pod中运行一个容器。“每个Pod中一个容器”的模式是最常见的用法;在这种使用方式中,你可以把Pod想象成是单个容器的封装,kuberentes管理的是Pod而不是直接管理容器。

- 在一个Pod中同时运行多个容器。一个Pod中也可以同时封装几个需要紧密耦合互相协作的容器,它们之间共享资源。这些在同一个Pod中的容器可以互相协作成为一个service单位,比如一个容器共享文件,另一个“sidecar”容器来更新这些文件。Pod将这些容器的存储资源作为一个实体来管理。

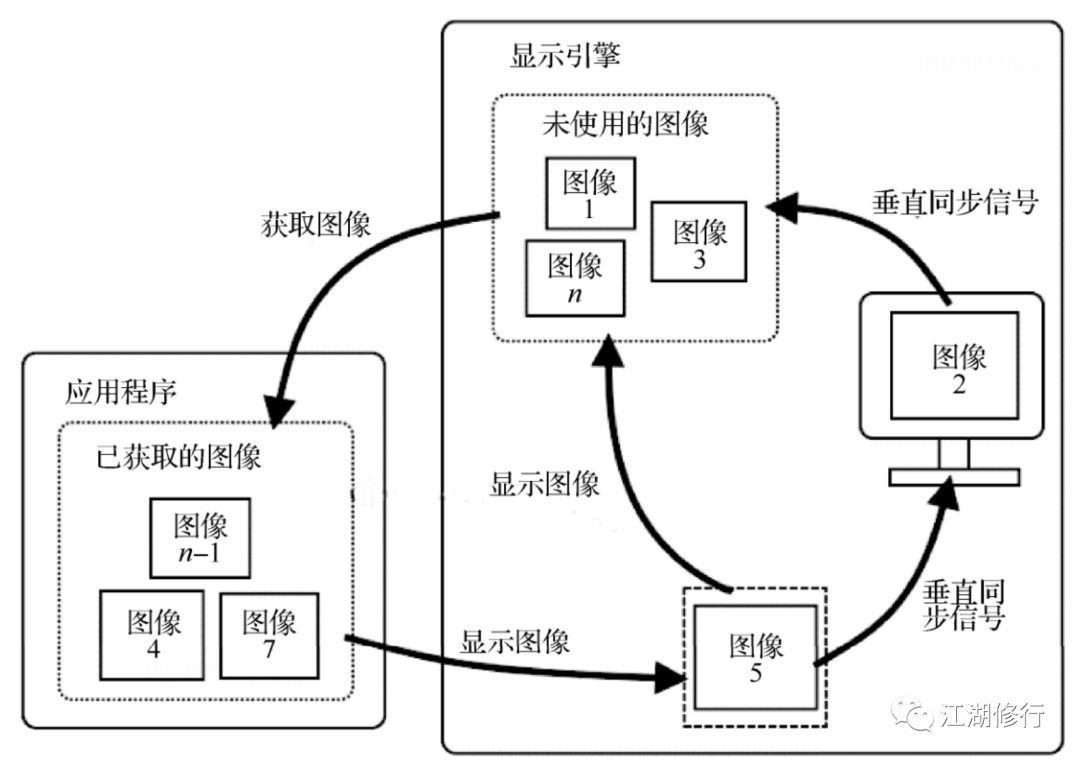

一个Pod下的容器必须运行于同一节点上。现代容器技术建议一个容器只运行一个进程,该进程在容器中PID命名空间中的进程号为1,可直接接收并处理信号,进程终止时容器生命周期也就结束了。若想在容器内运行多个进程,需要有一个类似Linux操作系统init进程的管控类进程,以树状结构完成多进程的生命周期管理。运行于各自容器内的进程无法直接完成网络通信,这是由于容器间的隔离机制导致,k8s中的Pod资源抽象正是解决此类问题,Pod对象是一组容器的集合,这些容器共享NET、MNT、UTS及IPC命名空间,因此具有相同的域名、主机名和网络接口,并可通过IPC直接通信。

Pod资源中针对各容器提供网络命名空间等共享机制的是底层基础容器pause,基础容器(也可称为父容器)pause就是为了管理Pod容器间的共享操作,这个父容器需要能够准确地知道如何去创建共享运行环境的容器,还能管理这些容器的生命周期。为了实现这个父容器的构想,kubernetes中,用pause容器来作为一个Pod中所有容器的父容器。这个pause容器有两个核心的功能,一是它提供整个Pod的Linux命名空间的基础。二来启用PID命名空间,它在每个Pod中都作为PID为1进程(init进程),并回收僵尸进程。

pause容器使得Pod中的所有容器可以共享两种资源:网络和存储。

●网络:

每个Pod都会被分配一个唯一的IP地址。Pod中的所有容器共享网络空间,包括IP地址和端口。Pod内部的容器可以使用localhost互相通信。Pod中的容器与外界通信时,必须分配共享网络资源(例如使用宿主机的端口映射)。●存储:

Pod可以指定多个共享的Volume。Pod中的所有容器都可以访问共享的Volume。Volume也可以用来持久化Pod中的存储资源,以防容器重启后文件丢失。

总结

每个Pod都有一个特殊的被称为“基础容器”的Pause容器。Pause容器对应的镜像属于Kubernetes平台的一部分,除了Pause容器,每个Pod还包含一个或者多个紧密相关的用户应用容器。kubernetes中的pause容器主要为每个容器提供以下功能:

●在pod中担任Linux命名空间(如网络命令空间)共享的基础;

●启用PID命名空间,开启init进程。

pause容器的作用?【重要】

是作为共享 NET MNT UTS IPC PID 命名空间的基础

给Pod里的其它容器提供网络、存储资源的共享

作为PID=1的进程(init进程)管理整个Pod容器组的生命周期

Kubernetes设计这样的Pod概念和特殊组成结构有什么用意?????

●原因一:在一组容器作为一个单元的情况下,难以对整体的容器简单地进行判断及有效地进行行动。比如,一个容器死亡了,此时是算整体挂了么?那么引入与业务无关的Pause容器作为Pod的基础容器,以它的状态代表着整个容器组的状态,这样就可以解决该问题。●原因二:Pod里的多个应用容器共享Pause容器的IP,共享Pause容器挂载的Volume,这样简化了应用容器之间的通信问题,也解决了容器之间的文件共享问题。

通常把Pod分为以下几类

Pod 的 3 种类型

- 控制器管理的Pod:由scheduler进行调度的;被控制器管理的;有自愈能力,一旦Pod挂掉了,会被重新拉起;有副本管理、滚动更新等功能

- 自主式Pod:由scheduler进行调度的;不被控制器管理;没有自愈能力,一旦Pod挂掉了,不会被重新拉起;没有副本管理、滚动更新等功能(kubectl run)

- 静态Pod:不由scheduler调度的,而是由kubelet自行管理的;始终与kubelet运行在同一个Node节点上,不能被直接删除

- 静态Pod资源配置文件默认放置在/etc/kubernetes/manifests目录中,当此目录中有Pod资源配置文件存在或者消失时kubelet会自动创建或删除静态Pod

●自主式Pod

这种Pod本身是不能自我修复的,当Pod被创建后(不论是由你直接创建还是被其他Controller),都会被Kuberentes调度到集群的Node上。直到Pod的进程终止、被删掉、因为缺少资源而被驱逐、或者Node故障之前这个Pod都会一直保持在那个Node上。Pod不会自愈。如果Pod运行的Node故障,或者是调度器本身故障,这个Pod就会被删除。同样的,如果Pod所在Node缺少资源或者Pod处于维护状态,Pod也会被驱逐。●控制器管理的Pod

Kubernetes使用更高级的称为Controller的抽象层,来管理Pod实例。Controller可以创建和管理多个Pod,提供副本管理、滚动升级和集群级别的自愈能力。例如,如果一个Node故障,Controller就能自动将该节点上的Pod调度到其他健康的Node上。虽然可以直接使用Pod,但是在Kubernetes中通常是使用Controller来管理Pod的。●静态Pod

静态 Pod 直接由特定节点上的 kubelet 进程来管理,不通过 master 节点上的 apiserver 。无法与控制器 Deployment 或者 DaemonSet 进行关联,它由 kubelet 进程自己来监控,当 pod 崩溃时重启该 pod , kubelete 也无法对他们进行健康检查。静态 pod 始终绑定在某一个 kubelet ,并且始终运行在同一个节点上。 kubelet 会自动为每一个静态 pod 在 Kubernetes 的 apiserver 上创建一个镜像 Pod(Mirror Pod),因此我们可以在 apiserver 中查询到该 pod,但是不能通过 apiserver 进行控制(例如不能删除)。#查看kubelet配置文件 /var/lib/kubelet/config.yaml

cat /var/lib/kubelet/config.yaml | grep staticPodPath staticPodPath: /etc/kubernetes/manifests#也可以通过下面命令找到kubelet对应的启动配置文件,修改node节点的kubelet配置文件,添加静态Pod的环境变量配置 --pod-manifest-path 参数

systemctl status kubelet /usr/lib/systemd/system/kubelet.service.d └─10-kubeadm.confvim /usr/lib/systemd/system/kubelet.service.d/10-kubeadm.conf Environment="KUBELET_SYSTEM_PODS_ARGS=--pod-manifest-path=/etc/kubernetes/manifests --allowprivileged=true"systemctl daemon-reload systemctl restart kubelet#在静态Pod文件的管理目录下准备 Pod 的 Json 或者 Yaml 文件

vim /etc/kubernetes/manifests/static-web.yaml apiVersion: v1 kind: Pod metadata: name: static-web labels: app: static spec: containers: - name: web image: nginx ports: - name: web containerPort: 80

运行中的 kubelet 周期扫描配置的目录下文件的变化,当这个目录中有文件出现或消失时创建或删除 pods。

在 Master 节点同样也可以看到该 Pod,如果执行 kubectl delete pod static-web-node01 命令删除该 Pod 发现,并不能删除。

Pod容器的分类

Pod 的 3 种容器

pause容器(基础容器/父容器/根容器)

给Pod的容器组作环境初始化

是作为共享 NET MNT UTS IPC PID 命名空间的基础

给Pod里的其它容器提供网络、存储资源的共享

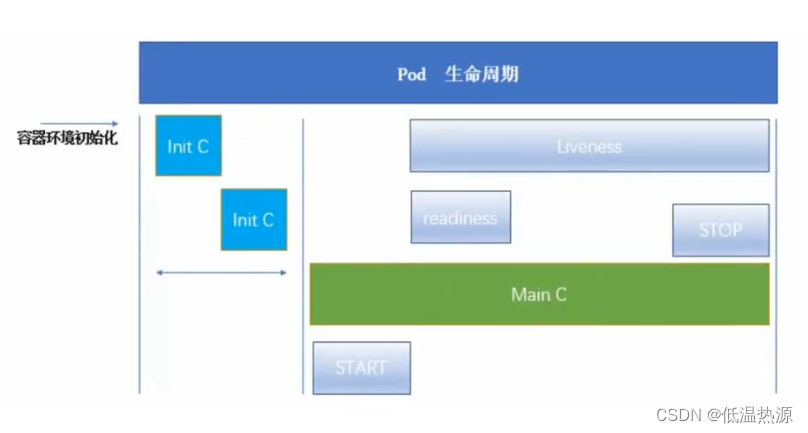

作为PID=1的进程(init进程)管理整个Pod容器组的生命周期init容器(初始化容器/init container)

可以为应用容器事先提供运行环境或辅助工具;还可以阻塞或延迟应用容器的启动(用于先启动应用容器的依赖项)

如果Pod有多个init容器时,是串行启动,要在上一个init容器成功的完成启动、运行和退出后才会启动下一个init容器

应用容器(业务容器/main container)

提供应用程序业务

如果Pod有多个应用容器时,默认是并行启动的,应用容器要在所有init容器都成功的完成启动、运行和退出后才会启动

1、基础容器(infrastructure container)

//维护整个 Pod 网络和存储空间

//node 节点中操作

//启动一个Pod时,k8s会自动启动一个基础容器

cat /opt/kubernetes/cfg/kubelet

......

--pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0"//每次创建 Pod 时候就会创建,运行的每一个Pod都有一个 pause-amd64 的基础容器自动会运行,对于用户是透明的

docker ps -a

registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0 "/pause"

2、初始化容器(initcontainers)

//Init容器必须在应用程序容器启动之前运行完成,而应用程序容器是并行运行的,所以Init容器能够提供了一种简单的阻塞或延迟应用容器的启动的方法。

Init 容器与普通的容器非常像,除了以下两点:

●Init 容器总是运行到成功完成为止●每个 Init 容器都必须在下一个 Init 容器启动之前成功完成启动和退出(init之间串行)

如果 Pod 的 Init 容器失败,k8s 会不断地重启该 Pod,直到 Init 容器成功为止。然而,如果 Pod 对应的重启策略(restartPolicy)为 Never,它不会重新启动。Init 的容器作用

因为init容器具有与应用容器分离的单独镜像,其启动相关代码具有如下优势:

●Init 容器可以包含一些安装过程中应用容器中不存在的实用工具或个性化代码。例如,没有必要仅为了在安装过程中使用类似 sed、 awk、 python 或 dig 这样的工具而去FROM 一个镜像来生成一个新的镜像。●Init 容器可以安全地运行这些工具,避免这些工具导致应用镜像的安全性降低。

●应用镜像的创建者和部署者可以各自独立工作,而没有必要联合构建一个单独的应用镜像。

●Init 容器能以不同于Pod内应用容器的文件系统视图运行。因此,Init容器可具有访问 Secrets 的权限,而应用容器不能够访问。

●由于 Init 容器必须在应用容器启动之前运行完成,因此 Init 容器提供了一种机制来阻塞或延迟应用容器的启动,

直到满足了一组先决条件。一旦前置条件满足,Pod内的所有的应用容器会并行启动。

3、应用容器(Maincontainer)

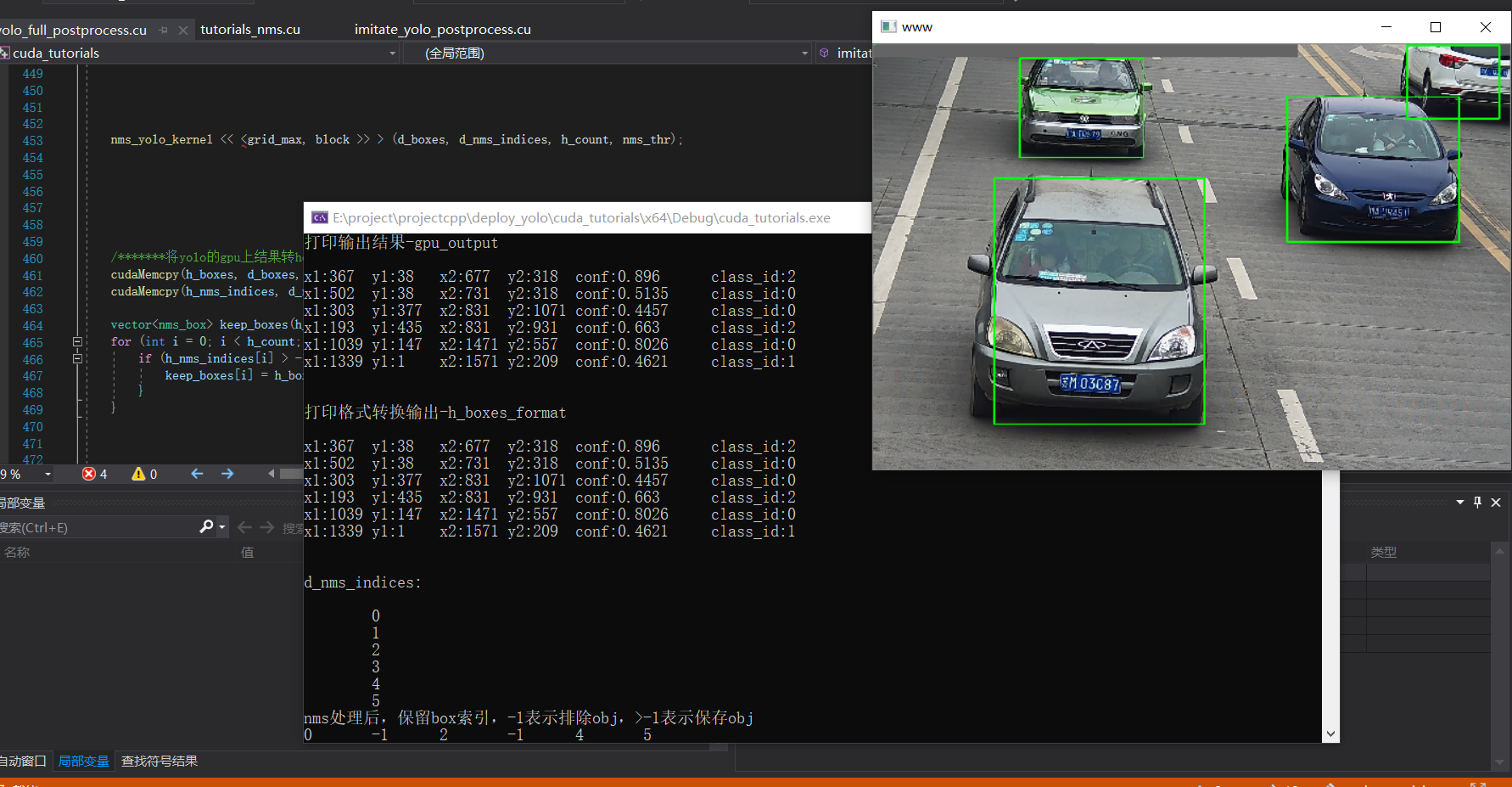

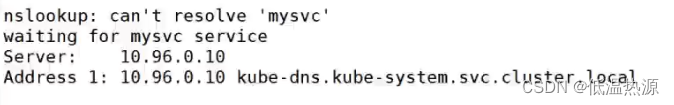

并行启动官网示例:Init Containers | Kubernetes这个例子是定义了一个具有 2 个 Init 容器的简单 Pod。 第一个等待 myservice 启动, 第二个等待 mydb 启动。 一旦这两个 Init容器都启动完成,Pod 将启动 spec 中的应用容器。

vim test.yaml apiVersion: v1 kind: Pod metadata: name: myapp-pod labels: app: myapp spec: containers: - name: myapp-container image: busybox:1.28 command: ['sh', '-c', 'echo The app is running! && sleep 3600'] initContainers: #init等待初始化容器(这里是预先启动init-myservice init-mydb这两个service 在启动myapp-container容器) - name: init-myservice image: busybox:1.28 command: ['sh', '-c', 'until nslookup myservice; do echo waiting for myservice; sleep 2; done;'] - name: init-mydb image: busybox:1.28 command: ['sh', '-c', 'until nslookup mydb; do echo waiting for mydb; sleep 2; done;']kubectl apply -f test.yaml 运行 创建pod此时由于没有init中busybox容器执行nslookup不通过(没有相应的myservice mydb资源),不能启动。查看日志信息、

kubectl describe pod myapp-pod kubectl logs myapp-pod -c init-myservice

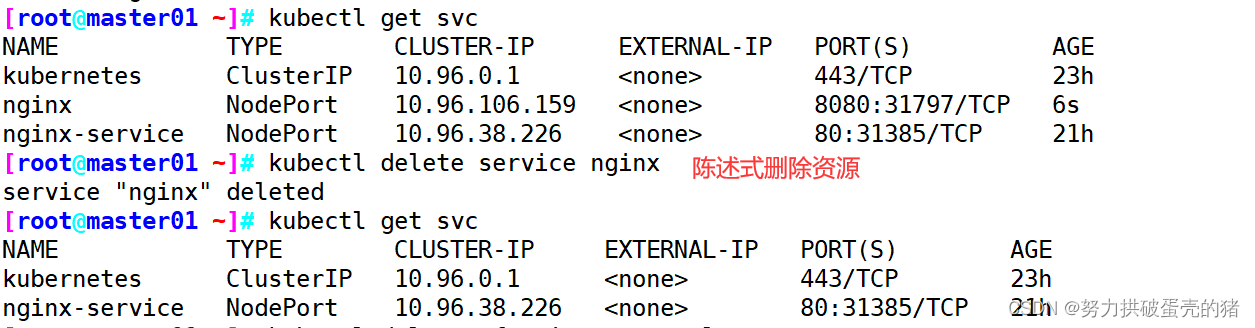

创建相应的service资源

-------------------------------创建myservice service资源------------------------------- vim myservice.yaml apiVersion: v1 kind: Service metadata: name: myservice spec: ports: - protocol: TCP port: 80 targetPort: 9376 kubectl create -f myservice.yaml ---------------- kubectl create svc clusterip mysvc --tcp=80:80 也可以直接使用这条命令,代替yaml文件 ----------------kubectl get svc kubectl get pods -n kube-system kubectl get pods kubectl logs myapp-pod -c init-myservice此时通过,init进度 1/2

创建另一个service资源

-------------------------------创建mydb service资源------------------------------- vim mydb.yaml apiVersion: v1 kind: Service metadata: name: mydb spec: ports: - protocol: TCP port: 80 targetPort: 9377 kubectl create -f mydb.yaml ---------------- kubectl create svc clusterip mydb --tcp=80:80 也可以直接使用这条命令,代替yaml文件 ----------------kubectl get pods kubectl logs myapp-pod -c init-mydb

特别说明

●在Pod启动过程中,Init容器会按顺序在网络和数据卷初始化之后启动。每个容器必须在下一个容器启动之前成功退出。

●如果由于运行时或失败退出,将导致容器启动失败,它会根据Pod的restartPolicy指定的策略进行重试。然而,如果Pod的restartPolicy设置为Always,Init容器失败时会使用RestartPolicy策略。

●在所有的Init容器没有成功之前,Pod将不会变成Ready状态。Init容器的端口将不会在Service中进行聚集。正在初始化中的Pod处于Pending状态,但应该会将Initializing状态设置为true。

●如果Pod重启,所有Init容器必须重新执行。

●对Init容器spec的修改被限制在容器image字段,修改其他字段都不会生效。更改Init容器的image字段,等价于重启该Pod。

●Init容器具有应用容器的所有字段。除了readinessProbe,因为Init容器无法定义不同于完成(completion)的就绪(readiness)之外的其他状态。这会在验证过程中强制执行。

●在Pod中的每个app和Init容器的名称必须唯一;与任何其它容器共享同一个名称,会在验证时抛出错误。

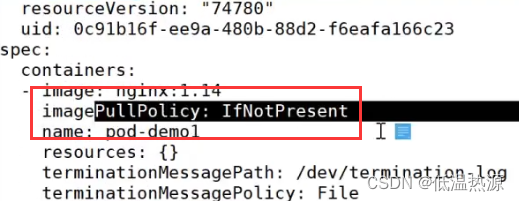

Pod 的 3 种镜像拉取策略: spec.containers.imagePullPolicy

IfNotPresent

优先使用本地已存在的镜像,如果本地没有则从仓库拉取镜像。

需要有明确的标签(nginx:1.20可以 ,nginx:latest就不算)。

Always总是从仓库拉取镜像,无论本地是否已存在镜像。

是标签为latest或无标签的镜像的默认镜像拉取策略

Never仅使用本地镜像,总是不从仓库拉取镜像

官方示例:

https://kubernetes.io/docs/concepts/containers/imageskubectl apply -f - <<EOF apiVersion: v1 kind: Pod metadata: name: private-image-test-1 spec: containers: - name: uses-private-image image: $PRIVATE_IMAGE_NAME imagePullPolicy: Always command: [ "echo", "SUCCESS" ] EOF

Pod 的 3 种容器重启策略: spec.restartPolicy

Always

当Pod中的容器退出时,总是重启容器,无论容器退出状态码如何。是默认的容器重启策略

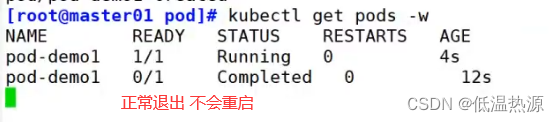

OnFailure当Pod中的容器异常退出时(容器退出状态码为非0),才会重启容器;正常退出的容器(容器退出状态码为0)不会重启

Never当Pod中的容器退出时,总是不重启容器,无论容器退出状态码如何。

实验 镜像拉取策略 与 容器重启策略

//master01 上操作

查看已存在的pod资源设置

kubectl edit deployment/nginx-deployment ...... template: metadata: creationTimestamp: null labels: app: nginx spec: containers: - image: nginx:1.15.4 imagePullPolicy: IfNotPresent #镜像拉取策略为 IfNotPresent name: nginx ports: - containerPort: 80 protocol: TCP resources: {} terminationMessagePath: /dev/termination-log terminationMessagePolicy: File dnsPolicy: ClusterFirst restartPolicy: Always #Pod的重启策略为 Always,默认值 schedulerName: default-scheduler securityContext: {} terminationGracePeriodSeconds: 30 ......

//创建测试案例mkdir /opt/demo cd /opt/demo vim pod1.yaml apiVersion: v1 kind: Pod metadata: name: pod-test1 spec: containers: - name: nginx image: nginx imagePullPolicy: IfNotPresent #不存在拉取。但是未指定明确的镜像标签,仍然会拉取 #command: [ "echo", "SUCCESS" ] command: - /bin/sh - -c - "sleep 10" #args restartPolicy: Always keburnetes中 command 和 args 都可以用于传参 类似于 docker 中的 enterpoint 和 cmdkubectl apply -f pod1.yamlkubectl get pods -o wide此时 Pod 的状态异常,原因是 echo 执行完进程终止,容器生命周期也就结束了

查看pod详细信息,看到由于未指定镜像的明确标签,拉取了镜像。

kubectl describe pod pod-test1 ...... Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 2m10s default-scheduler Successfully assigned default/pod-test1 to 192.168.80.101 Normal Pulled 46s (x4 over 119s) kubelet, 192.168.80.101 Successfully pulled image "nginx" Normal Created 46s (x4 over 119s) kubelet, 192.168.80.101 Created container Normal Started 46s (x4 over 119s) kubelet, 192.168.80.101 Started container Warning BackOff 19s (x7 over 107s) kubelet, 192.168.80.101 Back-off restarting failed container Normal Pulling 5s (x5 over 2m8s) kubelet, 192.168.80.101 pulling image "nginx"并且可以发现 Pod 中的容器在生命周期结束后,由于 Pod 的重启策略为 Always,容器再次重启了,并且又重新开始拉取镜像

//修改 pod1.yaml 文件

cd /opt/demo vim pod1.yaml apiVersion: v1 kind: Pod metadata: name: pod-test1 spec: containers: - name: nginx image: nginx:1.14 #修改 nginx 镜像版本,加上准确的标签,这样就会先检测是否存在 不存在才拉取 #imagePullPolicy: IfNotPresent #注释掉 不指定 让系统根据镜像写法自主选择 command: - /bin/sh - -c - "sleep 10; exit 1" #正常退出 不会重启 restartPolicy: OnFailure ······················································ cd /opt/demo vim pod1.yaml apiVersion: v1 kind: Pod metadata: name: pod-test1 spec: containers: - name: nginx image: nginx:1.14 #修改 nginx 镜像版本,加上准确的标签,这样就会先检测是否存在 不存在才拉取 #imagePullPolicy: IfNotPresent #注释掉 不指定 让系统根据镜像写法自主选择 command: - /bin/sh - -c - "sleep 10; exit 3" #异常退出 自动重启 restartPolicy: OnFailure//删除原有的资源

kubectl delete -f pod1.yaml//更新资源

kubectl apply -f pod1.yaml//查看 Pod 状态(两种配置各试一次)

kubectl get pods -o wide

查看 pod 配置,查找镜像的拉取策略。由于指定了详细标签,即使不指定拉取策略,系统也设置为IfNotPresent模式

kubectl get pods pod-test1 -oymal

//在任意 node 节点上使用 curl 查看头部信息

curl -I http://172.17.36.4 HTTP/1.1 200 OK Server: nginx/1.14.2 ......

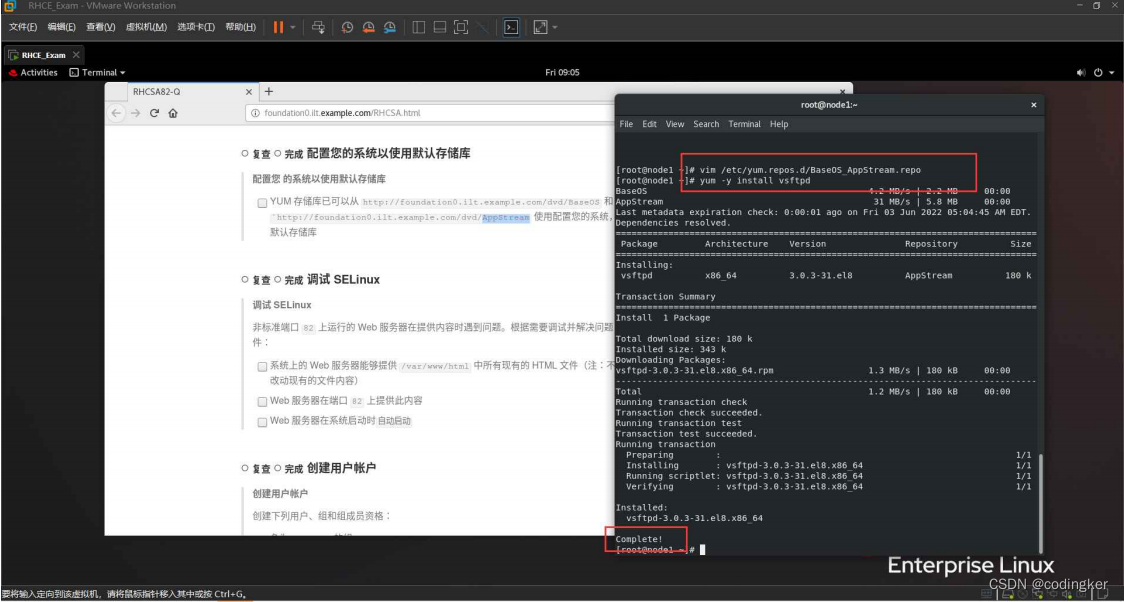

部署 harbor 创建私有项目

//在 Docker harbor 节点(192.168.80.104)上操作

systemctl stop firewalld.service systemctl disable firewalld.service setenforce 0yum install -y yum-utils device-mapper-persistent-data lvm2 yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo yum install -y docker-ce systemctl start docker.service systemctl enable docker.service docker version//上传 docker-compose 和 harbor-offline-installer-v1.2.2.tgz 到 /opt 目录中

cd /opt chmod +x docker-compose mv docker-compose /usr/local/bin///部署 Harbor 服务 tar zxvf harbor-offline-installer-v1.2.2.tgz -C /usr/local/vim /usr/local/harbor/harbor.cfg hostname = 192.168.80.104 --5行--修改,设置为Harbor服务器的IP地址或者域名 cd /usr/local/harbor/ ./install.sh//在 Harbor 中创建一个新项目

(1)浏览器访问:http://192.168.80.104 登录 Harbor WEB UI 界面,默认的管理员用户名和密码是 admin/Harbor12345

(2)输入用户名和密码登录界面后可以创建一个新项目。点击“+项目”按钮

(3)填写项目名称为“xue-project”,点击“确定”按钮,创建新项目//在每个 node 节点配置连接私有仓库(注意每行后面的逗号要添加)cat > /etc/docker/daemon.json <<EOF { "registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"], "insecure-registries":["192.168.80.104"] } EOF systemctl daemon-reload systemctl restart docker//在每个 node 节点登录 harbor 私有仓库

docker login -u admin -p harbor12345 http://192.168.80.104//在一个 node 节点下载 Tomcat 镜像进行推送

docker pull tomcat:8.0.52 docker images docker tag tomcat:8.0.52 192.168.80.104/xue-project/tomcat:v1 docker images docker push 192.168.80.104/xue-project/tomcat:v1

//查看登陆凭据cat /root/.docker/config.json | base64 -w 0 #base64 -w 0:进行 base64 加密并禁止自动换行 ewoJImF1dGhzIjogewoJCSIxOTIuMTY4LjE5NS44MCI6IHsKCQkJImF1dGgiOiAiWVdSdGFXNDZTR0Z5WW05eU1USXpORFU9IgoJCX0KCX0sCgkiSHR0cEhlYWRlcnMiOiB7CgkJIlVzZXItQWdlbnQiOiAiRG9ja2VyLUNsaWVudC8xOS4wMy41IChsaW51eCkiCgl9Cn0=

//创建 harbor 登录凭据资源清单,用于 K8S 访问 Harbor 私服拉取镜像所需要的密钥权限凭证 secret 资源vim harbor-pull-secret.yaml apiVersion: v1 kind: Secret metadata: name: harbor-pull-secret data: .dockerconfigjson: ewoJImF1dGhzIjogewoJCSIxOTIuMTY4LjE5NS44MCI6IHsKCQkJImF1dGgiOiAiWVdSdGFXNDZTR0Z5WW05eU1USXpORFU9IgoJCX0KCX0sCgkiSHR0cEhlYWRlcnMiOiB7CgkJIlVzZXItQWdlbnQiOiAiRG9ja2VyLUNsaWVudC8xOS4wMy41IChsaW51eCkiCgl9Cn0= #复制粘贴上述查看的登陆凭据 type: kubernetes.io/dockerconfigjson

//创建 secret 资源kubectl create -f harbor-pull-secret.yaml//查看 secret 资源

kubectl get secret//创建资源从 harbor 中下载镜像

cd /opt/demo vim tomcat-deployment.yaml apiVersion: apps/v1 kind: Deployment metadata: name: my-tomcat spec: replicas: 2 selector: matchLabels: app: my-tomcat template: metadata: labels: app: my-tomcat spec: imagePullSecrets: #添加 K8S 访问 Harbor 私服拉取镜像所需要的 secret 资源选项 - name: harbor-pull-secret #指定 secret 资源名称 containers: - name: my-tomcat image: 192.168.80.104/xue-project/tomcat:v1 #指定 harbor 中的镜像名 ports: - containerPort: 80 --- apiVersion: v1 kind: Service metadata: name: my-tomcat spec: type: NodePort ports: - port: 8080 targetPort: 8080 nodePort: 31111 selector: app: my-tomcat

//删除之前在 node 节点下载的 Tomcat 镜像docker rmi tomcat:8.0.52 docker rmi 192.168.80.104/xue-project/tomcat:v1 docker images

//创建资源kubectl create -f tomcat-deployment.yaml kubectl get pods NAME READY STATUS RESTARTS AGE my-tomcat-d55b94fd-29qk2 1/1 Running 0 my-tomcat-d55b94fd-9j42r 1/1 Running 0

//查看 Pod 的描述信息,可以发现镜像时从 harbor 下载的

kubectl describe pod my-tomcat-d55b94fd-29qk2//刷新 harbor 页面,可以看到镜像的下载次数增加了

![[excel]vlookup函数对相同的ip进行关联](https://img-blog.csdnimg.cn/18ac618a941446619fbdaa543bbdcb34.png)