一、前言

近年来AI领域的发展取得了长足的进步,孵化出的相关产品可谓是如火如荼。尤其是最近爆火的ChatGPT,让非IT领域的其他领域的小伙伴也开始接触并使用它。其实它的爆火不是偶然,是因为ChatGPT实实在在的强大,真真切切的能解决实际应用中的问题,因此人们才会开始关注它,使用它。

其实国内也有不错的大模型平台,前几天我也对百度自行研发的大模型平台——文心千帆做了评测和分享,使用效果也是超出了预期的。

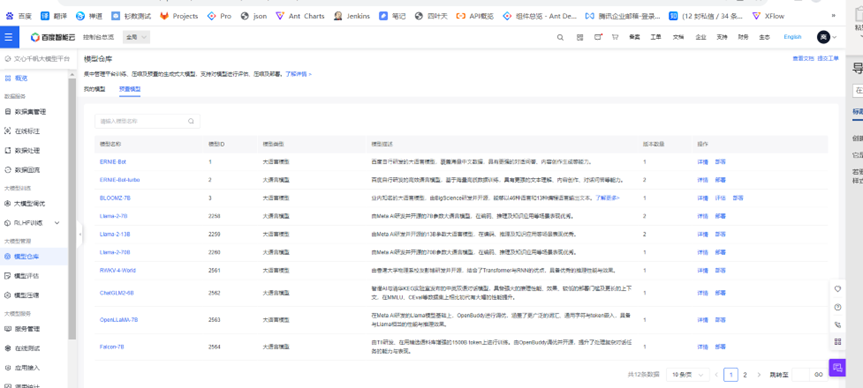

就在昨天,又看到百度团队对千帆大模型平台做了升级:全面接入Llama 2全系列、ChatGLM2-6B、RWKV-4-World、MPT-7B-Instruct、Falcon-7B等33个大模型,成为国内拥有大模型最多的平台:

同时支持性能+安全的双重增强,模型推理成本可降低50%。另外,千帆大模型平台还上线了预置Prompt模板库,模板数量达103个,覆盖对话、游戏、编程、写作十余个场景。

看到这些升级,我又迫不及待的去试试了。下面将这次针对新特性使用过程分享给大家 。

文章目录

一、前言

二、使用分享

1)预置prompt模板体验

1.1 电影评论

1.2 Python解释器

三、总结

二、使用分享

1)预置prompt模板体验

听到prompt这个词可能大家会有些陌生,实际上我们每次对文心一言的提问就是一个prompt。但提问也是一门学问,一个清晰且准确的提问,得到的回答也一定是更准确的。举个例子:因胃痛去看医生时,你对医生说我肚子不舒服,那医生肯定得跟你产生很多的交互,逐个排查肚子范围内的其他器官后才能了解到你是胃不舒服。如果你直接对医生说我胃痛的话,那医生就会更针对性的进行治疗,会省去了很多中间过程。

因为prompt模板做的就是这个事情,百度预置的prompt模板就相当于更准确、清晰、标准化的提问。

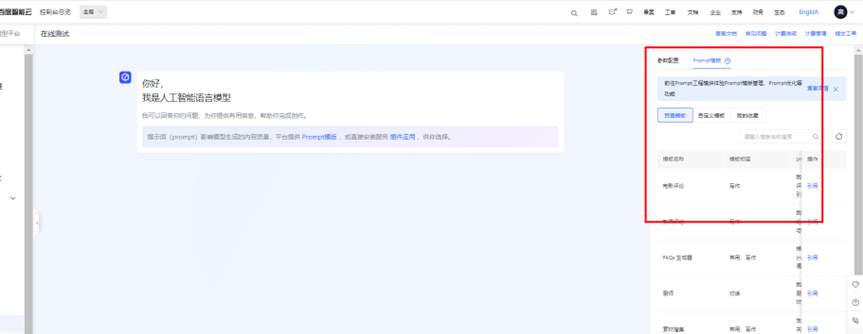

在很多行业场景中,优化Prompt是一个关键工程,且非常依赖经验,如果自己去从0开始尝试探索一个标准化的Prompt模板也是需要花费不少精力和时间的。这次千帆大模型的升级,上线了103个预置prompt模板,百度把服务很多内外部客户的经验,包括Prompt工程专家的经验开放出来,形成了丰富的模版库:

那么使用prompt模板和不使用prompt模板会有什么区别呢?百度提供的这些prompt模板是否符合我们的业务场景需求呢?这里我针对自己感兴趣的电影和自己较为专业的Python领域,进行了验证:

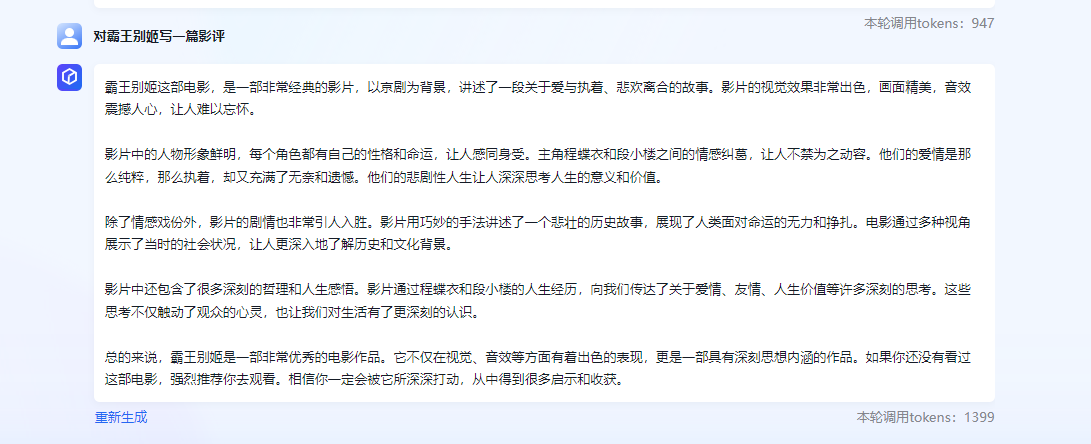

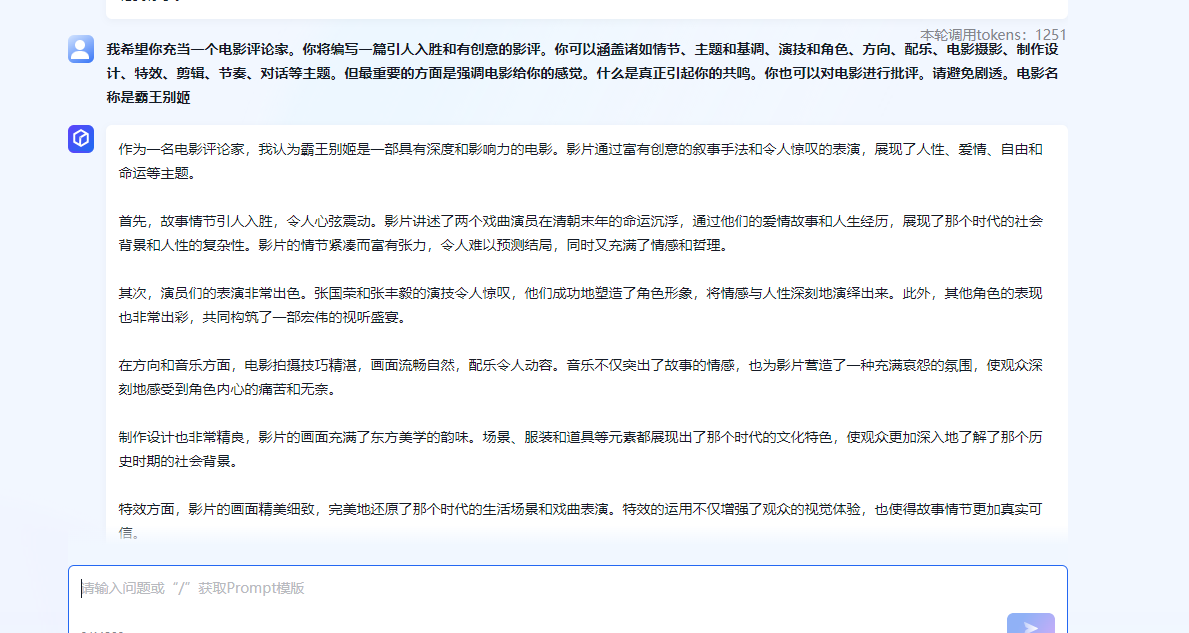

1.1 电影评论

如果我们想对“霸王别姬”这部电影写一篇影评的话,一般会直接对大模型说:“对霸王别姬写一篇影评”:

其实得到的回答效果也还不错,毕竟文心一言的能力还是很不错的,但细看下来对电影的评价不够全面、不够细致,而且我不希望出现剧透的情况,又希望对电影的配乐、特效等做更多的评价,所以这时可以使用prompt模板来看看会有什么样的效果:

百度提供的影评prompt模板是比较清晰全面的,因此语言模型输出的回答也就更加清晰全面,没有再出现剧透,也从各个角度对《霸王别姬》这部电影做出了分析和介绍,这样的回答也更符合我的预期。

1.2 Python解释器

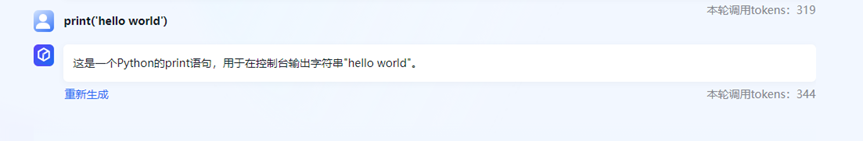

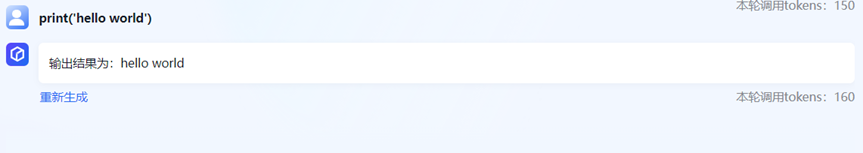

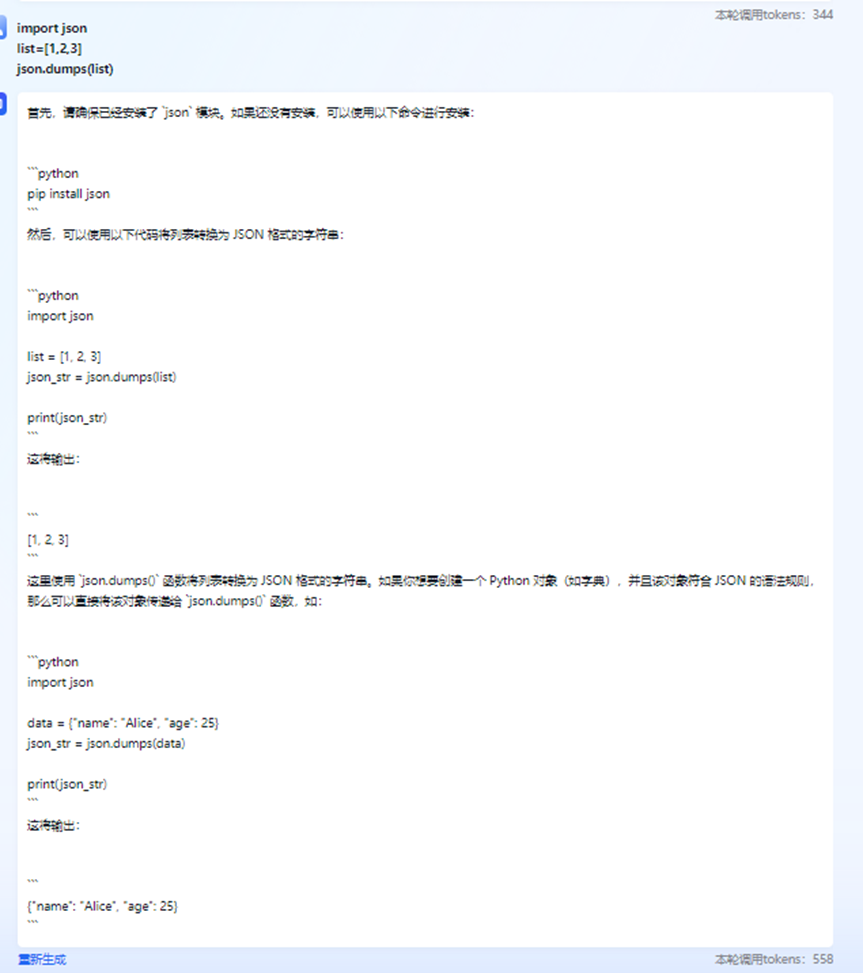

这里从最基础的hello world开始,到列表序列化及冒泡排序来看看回答会有什么区别:

Hello world不使用模板

Hello world使用模板

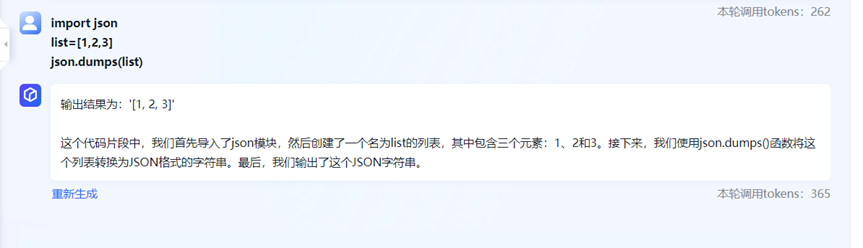

序列化不使用模板

序列化使用模板

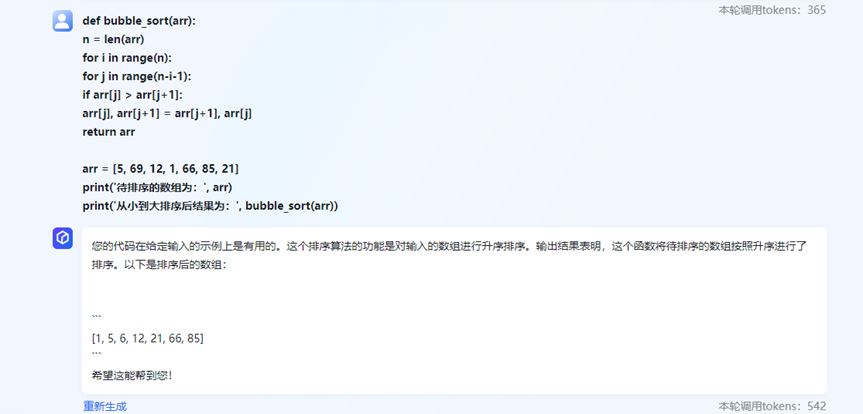

冒泡排序不使用模板

冒泡排序使用模板

可以看到,使用Python解释器的prompt模板后,文心一言会直观的将结果输出并对返回结果做说明。不使用模板的话则会对代码做详尽的解释和举例,这时更倾向于让我们搞懂代码的含义而不是结果的呈现。

体验下来,百度提供的预置prompt模板确实能更准确的表达出我想得到的效果,更符合我的预期。小伙伴们想体验prompt模板的话可以访问在线测试页,然后点击"prompt模板-预置模板"就可以引用预置的模板进行测试了:

2)模型仓库

在模板仓库页,可以看到这次升级接入的LLaMA2全系列、RWKV等大模型,我们可以直接点击页面的部署使用它们:

小伙伴可能会跟我刚开始时有一样的疑问:为什么千帆要接入这么多第三方的大模型呢?

这就要谈谈文心千帆的理念和目标了:千帆平台围绕企业的大模型应用需求设计,目标为企业用户提供全场景、一站式的大模型研发与服务工具链。当前开源大模型生态发展迅速,大量优质第三方模型涌现,在不同任务场景、参数量级与算力环境下体现出了差异化优势。千帆团队精选业界优质第三方模型,与平台无缝兼容集成,以便企业用户快速体验、测试、接入业务;与文心一言(ERNIE-Bot)等大模型搭配使用,从而更好满足不同细分场景的业务需求。

而且文心千帆也不是随随便便的就去接入三方的平台,它们是以三个维度(可商用、模型效果、模型安全性)为基础,通过层层考核才会接入这些模型。并且为了保证企业和开发者使用模型的安全性,千帆对所有接入的第三方模型均做了模型安全增强,不仅保障文心大模型的内容安全,还保障了第三方大模型的安全输出。

除此之外,为了降低使用成本,千帆对每一个接入的大模型都做了二次性能增强。通过优化模型吞吐、降低模型尺寸,实现模型推理速度的大幅提升。据测算,调优后模型体积可压缩至25%-50%,推理成本可降低50%。这意味着,相较于直接调用,企业在千帆平台上使用这些模型可极大地节约成本,提升效果。

而且千帆对接入的大模型均做了深度适配,并提供模型再训练的全套工具链,支持多种形式模型调优,包括SFT(全量参数微调、Prompt Tuning、Lora)及强化学习(奖励模型学习、强化学习训练)等。帮助企业和开发者快速基于基础大模型再训练,搭建企业专属大模型。

三、总结

这次体验效果依旧是很不错的,再一次的让我感到惊喜,也让我认识到并非“国外的月亮会才会圆”,国内同样也有不错的产品,甚至在某些方面的支持更加完善,支持的功能也更全面:

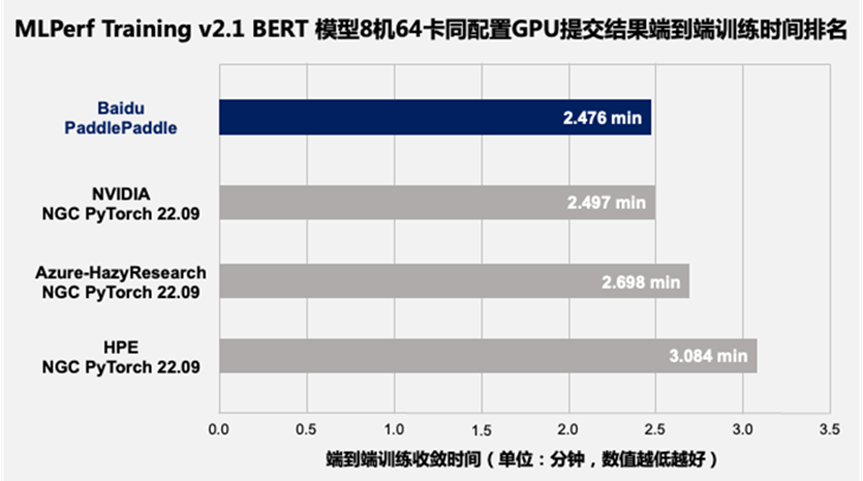

除了全面和安全外,千帆平台也更加高效,在2022 年 11 月发布的 MLPerf Trainning v2.1 测试结果中,百度使用飞桨加百度百舸提交的模型训练性能结果,位列同等 GPU 配置下世界第一,端到端训练时间和训练吞吐均超越 NGC PyTorch 框架:

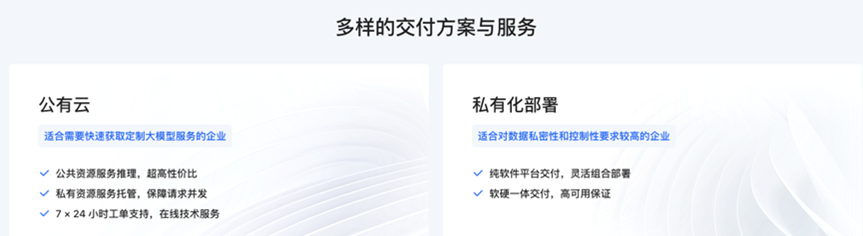

而且千帆的服务模式也是多样化的,支持公有云服务和私有化部署:

公有云提供三种服务模式:推理、微调、托管。适用于不同开发能力和不同需求的企业和开发者:

1. 推理:直接调用通用大模型的核心推理能力,输出推理结果。

2. 微调:在通用大模型的基础能力上,客户根据自己的需求,注入少量的行业数据,就可以用很小的成本微调出一个自己专属的大模型。

3. 托管:通用大模型或者微调出来的行业大模型,都可以直接托管在百度智能云的云端。客户只管去使用大模型,百度智能云会确保大模型的高可用、高性能和高安全性,企业不用担心复杂的部署和管理问题。

私有化部署支持纯软件平台、软硬一体两种交付模式:

- 纯软件平台交付:提供在企业环境中运行的大模型服务。百度智能云将打包的AI软件系统授权给客户,由客户自行搭建部署在本地的数据中心或私有云环境中。百度负责软件的安装调试、培训与维护支持等服务。这种模式可以最大限度保障数据的隐私和控制权,但需要客户具备一定的AI运维能力,且承担相应的服务器成本。

- 软硬一体交付:百度智能云不仅授权AI软件系统给客户,还提供预配置好的AI服务器集群和存储系统一并交付。我们会负责整体解决方案的部署、调试和日常的技术支持与维护。我们可以提供端到端的服务与质保,而且在硬件价格上也提供一定的折扣。

即使有诸多优点和行业多个第一的加持下,我们还是得承认一点,国内的诸多大模型产品包括文心千帆与ChatGPT相比在语言模型方面还是存在一定的差距,但我相信在未来这个差距会随着各位“攻城狮”的努力以及各方面的支持会越来越小,甚至反超!希望小伙伴们多给它们一些时间、多提出一些建议让其变得越来越好。

小伙伴们可访问文心千帆大模型平台公有版测试服务 申请测试,看看它到底能否满足你们的需求。