2014年文献

1.论文题目《Semantic Image Segmentation with Deep Convolutional Nets and Fully Connected CRFs》

1.1.网络别名《DeepLabV1》

1.2.论文引用

Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected crfs[J]. arXiv preprint arXiv:1412.7062, 2014.

1.3.发表期刊

《》

1.4.原文链接

https://arxiv.org/pdf/1412.7062.pdf

1.5.论文摘要

深度卷积神经网络(DCNN)在图像分类和目标检测等高级视觉任务中表现出最先进的性能。本研究结合了DCNN和概率图模型的方法,用于解决像素级分类的任务(也称为“语义图像分割”)。我们发现,DCNN最后一层的响应对于准确的对象分割来说不够局部化。这是由于使得DCNN在高级任务中表现出色的不变性特性。为了克服深度网络的这种较差的定位性能,我们将最后一层DCNN的响应与全连接条件随机场(CRF)相结合。在定性上,我们的“DeepLab”系统能够以超越以往方法的准确性水平定位分割边界。定量上,我们的方法在PASCAL VOC-2012语义图像分割任务中取得了新的最先进结果,在测试集上达到了71.6%的IOU准确度。我们展示了如何高效地获得这些结果:精心的网络重新应用和来自小波社区的“空洞”算法的新应用,使得神经网络的响应可以在现代GPU上以每秒8帧的速度进行密集计算。

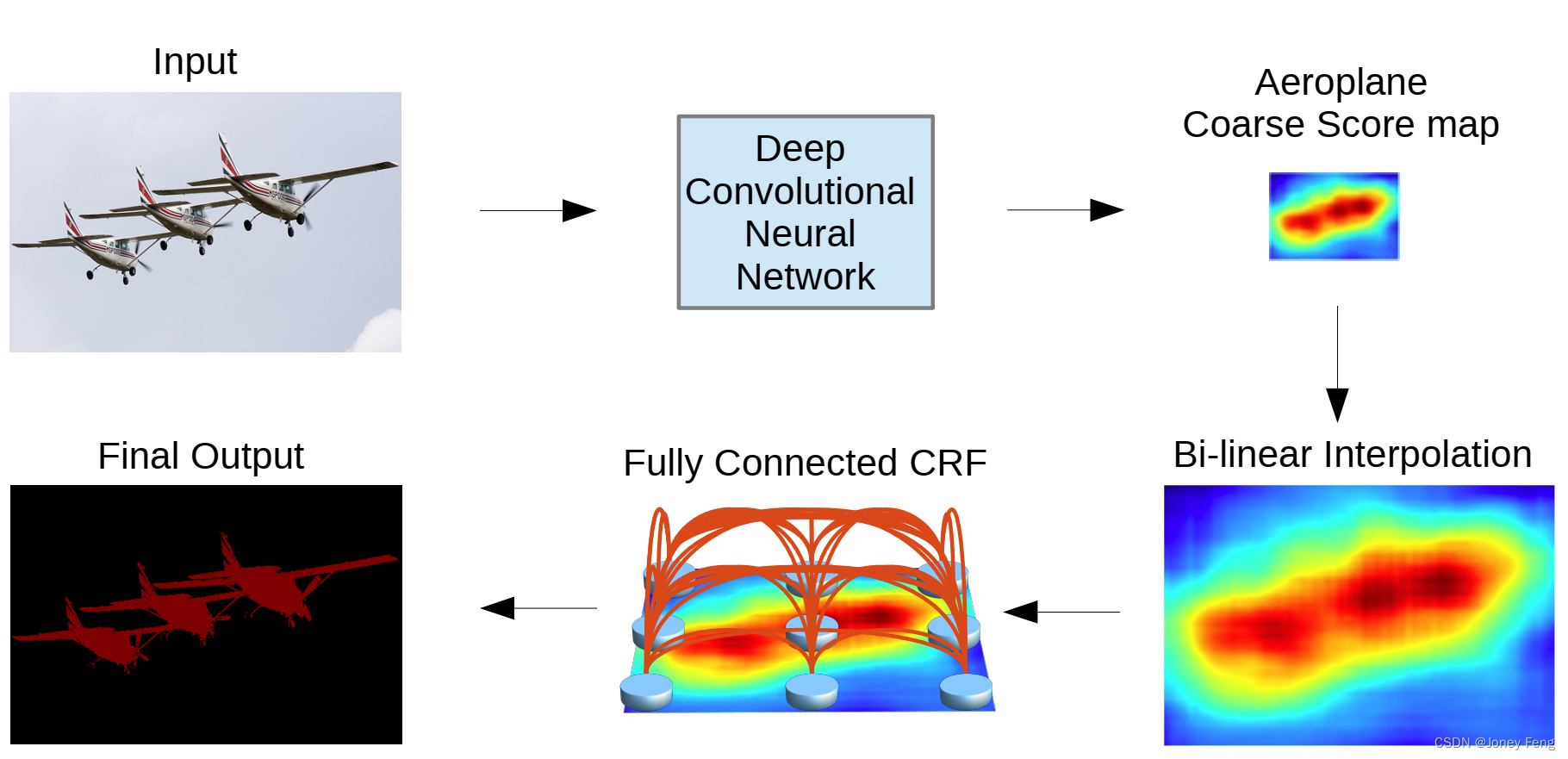

1.6.网络架构图

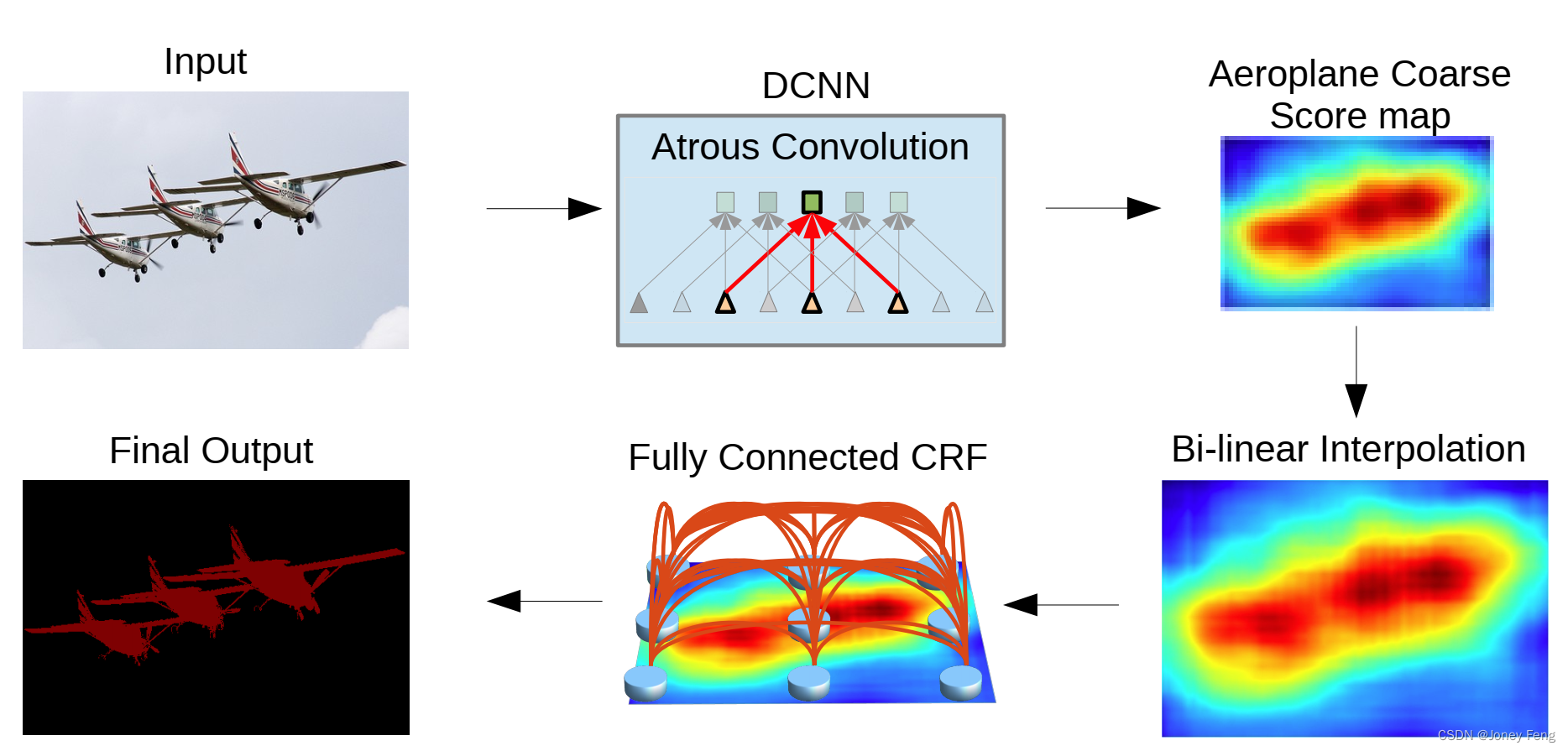

图1:在1-D情况下,当卷积核大小=3,输入步幅=2,输出步幅=1时,空洞算法的示意图。

图3: 模型示意图。深度卷积神经网络(具有完全卷积层)生成的粗糙分数图通过双线性插值进行上采样。然后,应用全连接CRF来优化分割结果。最佳观看方式为彩色显示。

1.7.CSDN链接

http://t.csdn.cn/zohj1![]() http://t.csdn.cn/zohj1

http://t.csdn.cn/zohj1

2.论文题目《》

2.1.网络别名《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2015年文献

1.论文题目

《》

1.1.网络别名

《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目《》

2.1.网络别名《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2016年文献

1.论文题目《》

1.1.网络别名《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目

《》

2.1.网络别名

《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2017年文献

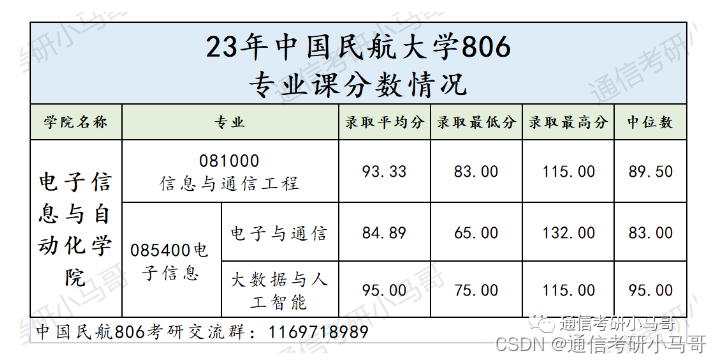

1.论文题目《Rethinking Atrous Convolution for Semantic Image Segmentation》

1.1.网络别名《DeepLabV3》

1.2.论文引用

Chen L C, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv preprint arXiv:1706.05587, 2017.

1.3.发表期刊

《》

1.4.原文链接

https://arxiv.org/pdf/1706.05587.pdf%EF%BC%8C%E6%8E%A8%E8%8D%90%E5%9C%A8%E7%9C%8B%E5%AE%8C%E6%9C%AC%E6%96%87%E4%B9%8B%E5%90%8E%E4%BB%94%E7%BB%86%E9%98%85%E8%AF%BB%E8%AE%BA%E6%96%87%E4%BB%A5%E5%8F%8A%E4%BB%A3%E7%A0%81%EF%BC%8C%E5%8F%AF%E4%BB%A5%E6%9B%B4%E5%A5%BD%E7%90%86%E8%A7%A3%E3%80%82![]() https://arxiv.org/pdf/1706.05587.pdf%EF%BC%8C%E6%8E%A8%E8%8D%90%E5%9C%A8%E7%9C%8B%E5%AE%8C%E6%9C%AC%E6%96%87%E4%B9%8B%E5%90%8E%E4%BB%94%E7%BB%86%E9%98%85%E8%AF%BB%E8%AE%BA%E6%96%87%E4%BB%A5%E5%8F%8A%E4%BB%A3%E7%A0%81%EF%BC%8C%E5%8F%AF%E4%BB%A5%E6%9B%B4%E5%A5%BD%E7%90%86%E8%A7%A3%E3%80%82

https://arxiv.org/pdf/1706.05587.pdf%EF%BC%8C%E6%8E%A8%E8%8D%90%E5%9C%A8%E7%9C%8B%E5%AE%8C%E6%9C%AC%E6%96%87%E4%B9%8B%E5%90%8E%E4%BB%94%E7%BB%86%E9%98%85%E8%AF%BB%E8%AE%BA%E6%96%87%E4%BB%A5%E5%8F%8A%E4%BB%A3%E7%A0%81%EF%BC%8C%E5%8F%AF%E4%BB%A5%E6%9B%B4%E5%A5%BD%E7%90%86%E8%A7%A3%E3%80%82

1.5.论文摘要

在这项工作中,我们重新思考了扩张卷积(atrous convolution),这是一种能够明确调整卷积滤波器的感受野(field-of-view)以及控制由深度卷积神经网络计算的特征响应的分辨率的强大工具,应用于语义图像分割。为了处理在多个尺度上分割对象的问题,我们设计了使用扩张卷积级联或并行的模块,通过采用多个扩张率捕捉多尺度上下文。此外,我们提出了对我们之前提出的扩张空洞金字塔空间池化(Atrous Spatial Pyramid Pooling)模块的增强,该模块在多个尺度上探测卷积特征,并使用编码全局上下文的图像级特征进一步提升性能。我们还详细介绍了实现细节,并分享了我们在训练系统过程中的经验。我们提出的“DeepLabv3”系统在没有DenseCRF后处理的情况下显著改进了我们先前的DeepLab版本,并在PASCAL VOC 2012语义图像分割基准测试中达到了与其他最先进模型相当的性能。

1.6.网络架构图

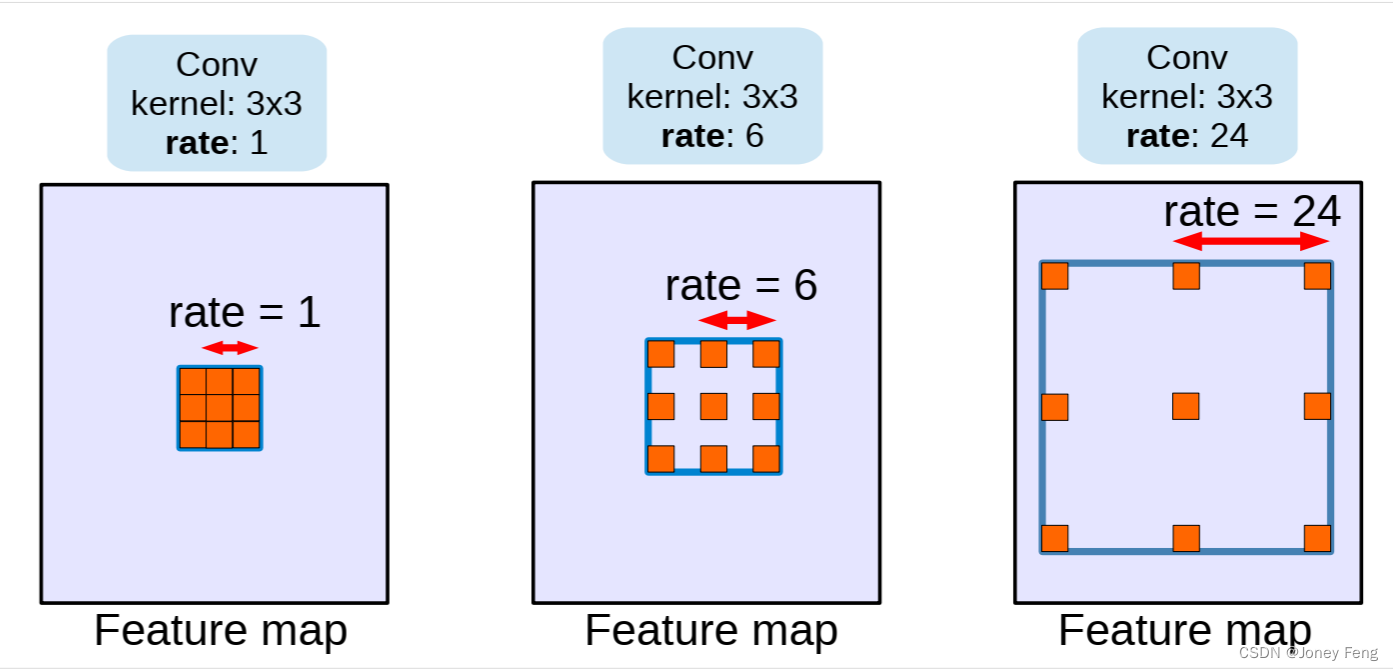

图1. 使用核大小为3×3和不同速率的扩张卷积。标准卷积对应于率=1的扩张卷积。使用较大的扩张率扩大了模型的感受野,使其能够在多个尺度上对对象进行编码。

图2. 捕捉多尺度上下文的替代架构

b) 使用孔卷积加深模型。当输出步长为16时,在block3之后应用孔卷积,采样率大于1。

图3. 不使用孔卷积和使用孔卷积的级联模块。

图5. 使用孔卷积(ASPP)增强的并行模块,同时使用图像级特征。

1.7.CSDN链接

http://t.csdn.cn/MQZpN![]() http://t.csdn.cn/MQZpN

http://t.csdn.cn/MQZpN

2.论文题目《DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs》

2.1.网络别名《DeepLabV2》

2.2.论文引用

Chen L C, Papandreou G, Kokkinos I, et al. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 40(4): 834-848.

2.3.发表期刊

《IEEE Transactions on Pattern Analysis and Machine Intelligence(简称TPAMI)》

《模式分析与机器智能交易》

2.4.原文链接

https://arxiv.org/pdf/1606.00915.pdf

2.5.论文摘要

在这项工作中,我们使用深度学习来解决语义图像分割任务,并做出了三个实验证明具有实际价值的主要贡献。

首先,我们强调通过上采样滤波器进行卷积,或者称为“空洞卷积”,在密集预测任务中是一种强大的工具。空洞卷积允许我们在深度卷积神经网络中明确控制特征响应计算的分辨率。它还可以在不增加参数或计算量的情况下有效地扩大滤波器的视野以包含更大的上下文。

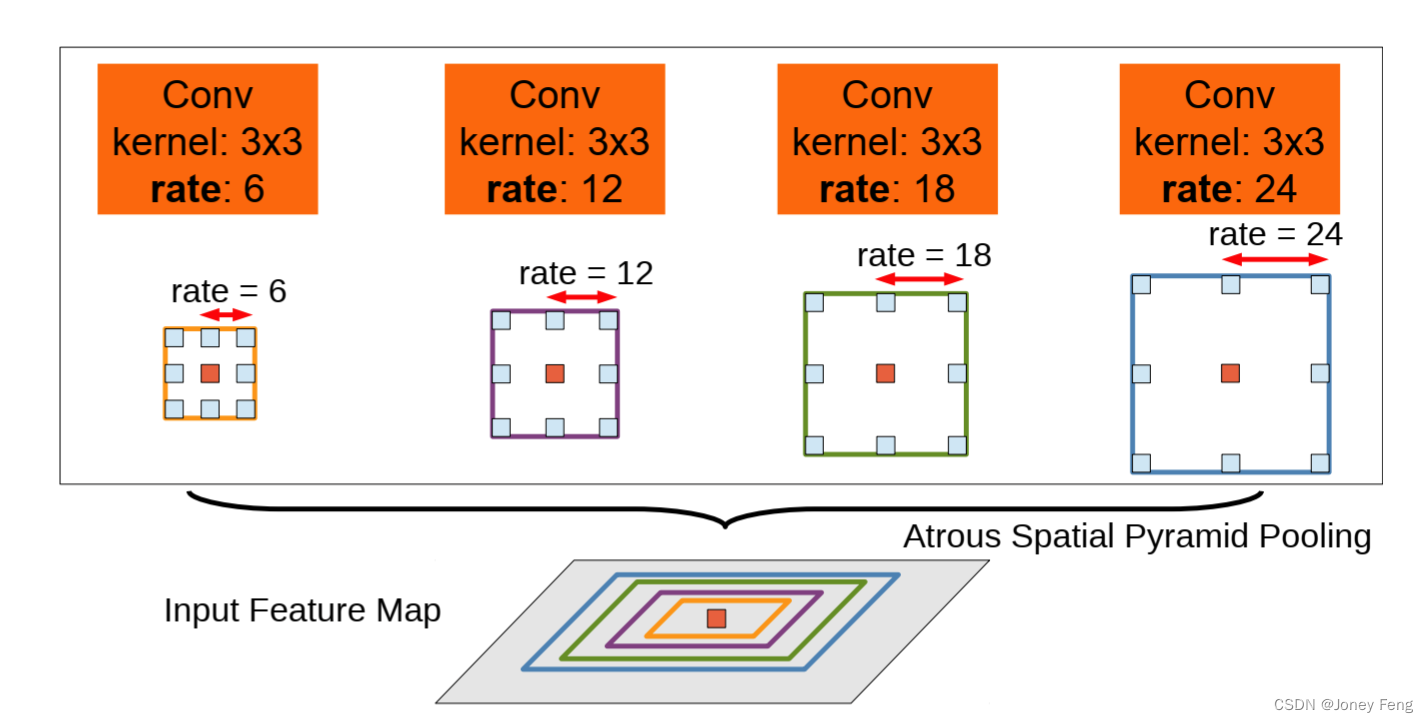

其次,我们提出了空洞空间金字塔池化(ASPP),以稳健地在多个尺度上分割对象。ASPP使用多种采样率和有效视野的滤波器来探索输入的卷积特征层,从而在多个尺度上捕捉对象以及图像上下文。

第三,我们通过结合深度卷积神经网络(DCNNs)和概率图模型的方法改善了对象边界的定位。在DCNNs中广泛使用的最大池化和下采样的组合可以实现不变性,但会对定位精度产生影响。我们通过将最终DCNN层的响应与全连接的条件随机场(CRF)相结合,克服了这个问题,定性和定量地证明了这种方法可以提高定位性能。我们提出的“DeepLab”系统在PASCAL VOC-2012语义图像分割任务中达到了79.7%的mIOU,成为最新的技术水平,并在其他三个数据集(PASCAL-Context,PASCAL-Person-Part和Cityscapes)上取得了进展。我们所有的代码都可以在网上公开获取。

关键词—卷积神经网络、语义分割、空洞卷积、条件随机场。

2.6.网络架构图

图1:模型示意图。采用深度卷积神经网络(例如VGG-16或ResNet-101)以完全卷积的方式进行操作,使用空洞卷积来减少信号下采样的程度(从32倍降至8倍)。双线性插值阶段将特征图放大到原始图像分辨率。然后应用全连接CRF来优化分割结果并更好地捕捉对象边界。

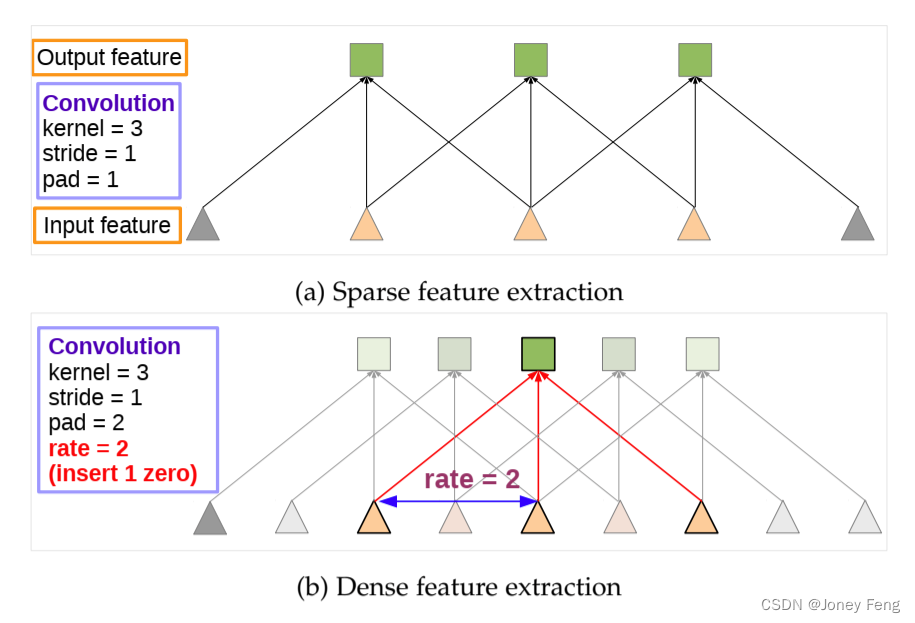

图2:1维空洞卷积的示例。(a)在低分辨率输入特征图上使用标准卷积进行稀疏特征提取。(b)在高分辨率输入特征图上使用率为2的洞卷积进行密集特征提取。

图4:空洞空间金字塔池化(ASPP)。为了对中心像素(橙色)进行分类,ASPP利用了具有不同率的多个并行滤波器来利用多尺度特征。不同颜色表示的是有效的视野范围。

图7:DeepLab-ASPP使用多个具有不同采样率的滤波器来捕捉多尺度的对象和上下文。

2.7.CSDN链接

http://t.csdn.cn/U6kmu![]() http://t.csdn.cn/U6kmu

http://t.csdn.cn/U6kmu

2018年文献

1.论文题目《Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation》

1.1.网络别名《DeepLabV3+》

1.2.论文引用

Chen L C, Zhu Y, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of the European conference on computer vision (ECCV). 2018: 801-818.

1.3.发表期刊

《European conference on computer vision (ECCV)》

1.4.原文链接

https://openaccess.thecvf.com/content_ECCV_2018/papers/Liang-Chieh_Chen_Encoder-Decoder_with_Atrous_ECCV_2018_paper.pdf![]() https://openaccess.thecvf.com/content_ECCV_2018/papers/Liang-Chieh_Chen_Encoder-Decoder_with_Atrous_ECCV_2018_paper.pdf

https://openaccess.thecvf.com/content_ECCV_2018/papers/Liang-Chieh_Chen_Encoder-Decoder_with_Atrous_ECCV_2018_paper.pdf

1.5.论文摘要

在深度神经网络中,空间金字塔池化模块或编码-解码结构被用于语义分割任务。前者通过在多个速率和多个有效视野下使用滤波器或池化操作来编码多尺度的上下文信息,而后者则通过逐渐恢复空间信息来捕捉更清晰的物体边界。在本文中,我们提出将两种方法的优点相结合。具体而言,我们提出的模型DeepLabv3+在DeepLabv3的基础上添加了一个简单但有效的解码器模块,以改进分割结果,特别是沿着物体边界的部分。我们进一步探索了Xception模型,并将深度可分离卷积应用于空洞空间金字塔池化和解码器模块,从而实现了更快速、更强大的编码-解码网络。我们在PASCAL VOC 2012和Cityscapes数据集上验证了所提出模型的有效性,在没有任何后处理的情况下,分别达到了89.0%和82.1%的测试集性能。我们的论文附带了在Tensorflow中公开可用的所提出模型的参考实现,网址为https://github.com/tensorflow/models/tree/master/research/deeplab。

关键词:语义图像分割、空间金字塔池化、编码解码、深度可分离卷积。

1.6.网络架构图

图1。我们改进了采用空间金字塔池化模块(a)的DeepLabv3,引入了编码器-解码器结构(b)。提出的模型DeepLabv3+通过编码器模块获得了丰富的语义信息,而简单而有效的解码器模块恢复了详细的目标边界。编码器模块允许我们通过应用带孔卷积来以任意分辨率提取特征。

图1。我们改进了采用空间金字塔池化模块(a)的DeepLabv3,引入了编码器-解码器结构(b)。提出的模型DeepLabv3+通过编码器模块获得了丰富的语义信息,而简单而有效的解码器模块恢复了详细的目标边界。编码器模块允许我们通过应用带孔卷积来以任意分辨率提取特征。

图1。我们改进了采用空间金字塔池化模块(a)的DeepLabv3,引入了编码器-解码器结构(b)。提出的模型DeepLabv3+通过编码器模块获得了丰富的语义信息,而简单而有效的解码器模块恢复了详细的目标边界。编码器模块允许我们通过应用带孔卷积来以任意分辨率提取特征。

1.7.CSDN链接:

http://t.csdn.cn/I3pEg![]() http://t.csdn.cn/I3pEg

http://t.csdn.cn/I3pEg

2.论文题目《》

2.1.网络别名《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2019年文献

1.论文题目《》

1.1.网络别名《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目《》

2.1.网络别名《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2020年文献

1.论文题目《》

1.1.网络别名《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目《》

2.1.网络别名《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2021年文献

1.论文题目《SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers》

1.1.网络别名《SegFormer》

1.2.论文引用

Xie E, Wang W, Yu Z, et al. SegFormer: Simple and efficient design for semantic segmentation with transformers[J]. Advances in Neural Information Processing Systems, 2021, 34: 12077-12090.

1.3.发表期刊

《Advances in Neural Information Processing Systems (NeurIPS)》《神经信息处理系统的进展》

1.4.原文链接

https://proceedings.neurips.cc/paper/2021/file/64f1f27bf1b4ec22924fd0acb550c235-Paper.pdf![]() https://proceedings.neurips.cc/paper/2021/file/64f1f27bf1b4ec22924fd0acb550c235-Paper.pdf

https://proceedings.neurips.cc/paper/2021/file/64f1f27bf1b4ec22924fd0acb550c235-Paper.pdf

1.5.论文摘要

我们提出了SegFormer,这是一个简单、高效且强大的语义分割框架,它将Transformer与轻量级多层感知机(MLP:Multilayer Perceptron,人工神经网络)解码器结合在一起。

SegFormer具有两个吸引人的特点:

1)SegFormer包含一个新颖的层次结构的Transformer编码器,它输出多尺度特征。它不需要位置编码,从而避免了位置编码的插值问题,当测试分辨率与训练不同时,导致性能下降。

2)SegFormer避免了复杂的解码器。提出的MLP解码器从不同层级聚合信息,从而结合了局部注意力和全局注意力,以生成强大的表示。

我们展示了这种简单轻量级的设计是在Transformer上实现高效分割的关键。我们将我们的方法扩展到一系列模型,从SegFormer-B0到SegFormer-B5,达到了比以前的对应方法更好的性能和效率。例如,SegFormer-B4在ADE20K上以64M参数达到了50.3%的mIoU,比之前的最佳方法小了5倍,效果提升了2.2%。我们最好的模型SegFormer-B5在Cityscapes验证集上达到了84.0%的mIoU,并且在Cityscapes-C上表现出了出色的零样本鲁棒性。代码将在github上发布:github.com/NVlabs/SegFormer。

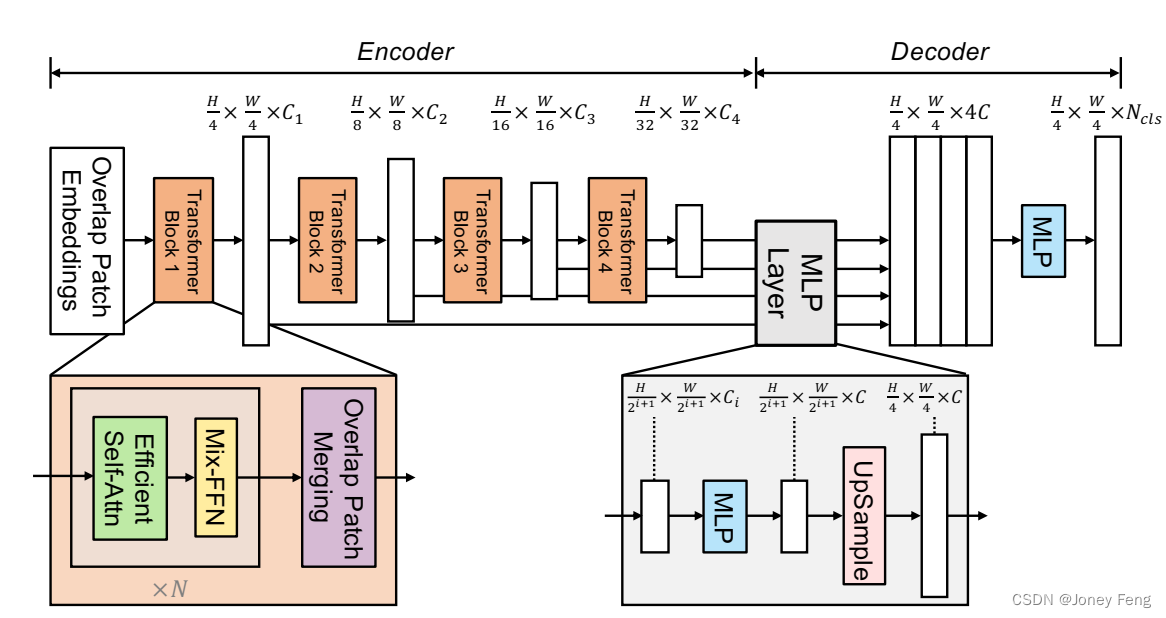

1.6.网络架构图

图2:提出的SegFormer框架由两个主要模块组成:

一个分层Transformer编码器用于提取粗糙和细致的特征;

以及一个轻量级的All-MLP解码器,用于直接融合这些多级特征并预测语义分割掩码。

“FFN”表示前馈神经网络。

1.7.CSDN链接

http://t.csdn.cn/ADMn5![]() http://t.csdn.cn/ADMn5

http://t.csdn.cn/ADMn5

2.论文题目

《》

2.1.网络别名

《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2022年文献

1.论文题目

《》

1.1.网络别名

《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目

《》

2.1.网络别名

《》

2.2.论文引用

2.3.发表期刊

《》

2.4.原文链接

2.5.论文摘要

2.6.网络架构图

2.7.CSDN链接

2023年文献

1.论文题目

《》

1.1.网络别名

《》

1.2.论文引用

1.3.发表期刊

《》

1.4.原文链接

1.5.论文摘要

1.6.网络架构图

1.7.CSDN链接

2.论文题目

《》

2.1.网络别名

《》

2.2.论文引用

2.3.发表期刊

《》