- 论文地址:Rethinking Atrous Convolution for Semantic Image Segmentation

- Pytorch 实现代码:pytorch_segmentation/deeplab_v3

这是一篇 2017 年发表在CVPR上的文章。相比 DeepLab V2 有三点变化:①引入了 Multi-grid;②改进了 ASPP 结构;③移除 CRFs 后处理。

① 引入了 Multi-grid,目的:Multi-grid 的引入旨在进一步改进空洞卷积的使用方式,提高语义分割模型在不同尺度上的性能。在之前的版本(如 DeepLab V2)中,空洞卷积的膨胀系数是固定的,这限制了模型在不同尺度上捕捉上下文信息的能力。通过引入 Multi-grid,DeepLab v3 可以使用不同的膨胀系数来处理特征图,从而在多个尺度上捕获更丰富的上下文信息,这有助于更好地分割不同大小的目标。

② 改进了 ASPP 结构(Atrous Spatial Pyramid Pooling),目的:ASPP 结构用于在特征图的不同尺度上捕获多尺度上下文信息。在 DeepLab V3 中,ASPP 结构得到了改进,除了原来的多个膨胀系数的膨胀卷积外,还引入了图像级特征(全局平均池化),这样在 ASPP 模块中既能获取局部细节信息,也能融合全局上下文信息。这种改进有助于提高模型的感知范围和语义信息,从而改善分割性能。

③ 移除 CRFs 后处理(Conditional Random Fields),目的:在 DeepLab V2 中,使用CRF进行后处理是为了进一步优化语义分割结果,特别是在边界细节上进行平滑处理。然而,CRF 的计算代价较高,并且会增加模型的复杂性。DeepLab V3 移除了 CRF 后处理步骤,而是通过引入 Multi-grid 和改进 ASPP 结构来在模型中直接获得更全面和精确的特征表示,从而减少了 CRF 的需求。这样一来,DeepLab V3 在保持高性能的同时,简化了模型结构和训练过程。

DeepLab v3 概况

DeepLab v3是一个语义分割模型,其核心思想是使用深度卷积神经网络来实现高精度的语义分割任务。它是DeepLab系列模型的第三个版本,针对之前版本的一些缺点进行了改进。

DeepLab v3的核心思想包括以下几个关键点:

-

空洞卷积(Dilated Convolution):为了增加感受野(Receptive Field)的大小,DeepLab v3引入了空洞卷积。传统的卷积操作在特征提取时只考虑局部邻域信息,而空洞卷积通过在卷积核中引入空洞(或称为膨胀率),使得卷积核可以在更大范围内获取特征信息,从而捕捉更广阔的上下文信息。

-

多尺度信息融合:DeepLab v3采用了多尺度信息融合的方法,通过在不同尺度下对特征图进行空间金字塔池化操作,得到不同分辨率的特征图。然后,通过上采样和融合这些特征图,使得模型能够在不同尺度下获得更为丰富的信息,有利于对目标进行更准确的分割。

-

全局平均池化(Global Average Pooling):DeepLab v3在最后的特征图上使用全局平均池化来获得整体图像的全局信息。这有助于进一步提升模型的上下文感知能力,对于包含大范围目标的图像尤为重要。

-

条件随机场(Conditional Random Field,CRF):在得到初步的语义分割结果后,DeepLab v3采用了条件随机场来进行后处理。CRF能够利用像素之间的空间相关性和颜色相似性,对分割结果进行平滑,减少一些细节上的错误。

综合以上几点,DeepLab v3能够有效地捕获图像中的上下文信息和多尺度特征,并对这些特征进行充分融合和处理,从而在语义分割任务中达到较高的准确率。

Abstract

在这项工作中,我们重新考虑了空洞卷积(atrous convolution),这是一种强大的工具,可以明确地调整卷积核的感受野,并控制 CNNs 计算的特征响应的分辨率,用于语义图像分割的应用。为了解决在多个尺度上分割对象的问题,我们设计了使用空洞卷积的模块,这些模块串联或并行地采用多个膨胀率 r r r 来捕获多尺度上下文。此外,我们提出了对之前提出的空洞空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模块进行增强,该模块可以在多个尺度上探测卷积特征,并融合包含全局上下文的图像级特征,从而进一步提升性能。我们还详细阐述了实现细节,并分享了训练系统的经验。所提出的“DeepLabv3”系统在没有 DenseCRF 后处理的情况下明显优于我们之前的 DeepLab 版本,并在 PASCAL VOC 2012 语义图像分割基准测试中达到了与其他最先进模型相当的性能。

1. 用于捕获多尺度上下文信息的可选架构

- (a) 图像金字塔:这是我们最容易想到的一种方式,即将图片缩放到不同的尺度后再分别送入网络进行推理;最终再进行融合

- (b) 编解码器:首先按照 Backbone 对输入图片进行一系列的下采样,最后再将最终的特征图进行一系列上采样;在上采样的过程中会和 Backbone 中得到的特征图进行融合;依次类推直至还原回原图大小

- (c) DeepLab v1 中的方法:将 Backbone 中最后几个卷积层的

stride设置为 1;然后再引入膨胀卷积以增大网络的感受野 - (d) DeepLab v2 中的方法:引入 ASPP(空洞空间金字塔池化)以增加模型获取多尺度信息的能力

2. DeepLab v3 的两种模型结构

- Cascaded Model:级联的模型

- ASPP Model

在 Cascaded model 中是没有使用 ASPP 模块的,在 ASPP model 中是没有使用 cascaded blocks 模块的。

注意,虽然文中提出了两种结构,但作者说 ASPP model 比 cascaded model 略好点。包括在 Github 上开源的一些代码,大部分也是用的 ASPP model。

2.1 Cascaded Model

论文中提出的 cascaded model 指的是图 (b)。其中 Block1、Block2、Block3、Block4 是原始 ResNet 网络中的层结构,但在 Block4 中将第一个残差结构里的

3

×

3

3\times 3

3×3 卷积层以及捷径分支上的

1

×

1

1\times 1

1×1 卷积层步距 stride 由 2 改成了 1(即不进行下采样),并且所有残差结构里

3

×

3

3\times 3

3×3 的普通卷积层都换成了膨胀卷积层。Block5、Block6 和 Block7 是额外新增的层结构,它们的结构和 Block4 是一模一样的,即由三个残差结构(使用了膨胀卷积)构成。

注意❗️原论文说在训练 cascaded model 时

output_stride=16(即特征层相对输入图片的下采样率),但验证时使用的output_stride=8。因为output_stride=16时最终得到的特征层H和W会更小,这意味着可以设置更大的batch_size并且能够加快训练速度。但特征层H和W变小会导致特征层丢失细节信息(文中说变的更“粗糙”),所以在验证时采用的output_stride=8。其实只要你GPU显存足够大,算力足够强也可以直接把output_stride设置成 8。—— 简单来说,训练的时候作者使用了 16 倍下采样率,而验证的时候使用了 8 倍下采样率。

另外需要注意❗️的是,图中标注的 rate 并不是膨胀卷积真正采用的膨胀系数。 真正采用的膨胀系数应该是图中的 rate 乘上 Multi-Grid参数,比如 Block4 中 rate=2,Multi-Grid=(1, 2, 4),那么真正采用的膨胀系数是

2

×

(

1

,

2

,

4

)

=

(

2

,

4

,

8

)

2 \times (1, 2, 4) = (2, 4, 8)

2×(1,2,4)=(2,4,8)。关于Multi-Grid参数后面会提到。

r a c t u a l l y = r a t e × M u l t i G r i d r_\mathrm{actually} = \mathrm{rate} \times \mathrm{MultiGrid} ractually=rate×MultiGrid

2.2 ASPP Model

2.2.1 整体模型结构

虽然论文大篇幅的内容都在讲 Cascaded Model 及其对应的实验,但实际使用的最多的还是 ASPP Model,其模型结构如下图所示。

注意❗️和 Cascaded Model 一样,原论文中说在训练时

output_stride=16(即特征层相对输入图片的下采样率),但验证时使用的output_stride=8。但在 PyTorch 官方实现的 DeepLabV3 源码中就直接把output_stride设置成 8 进行训练的。

2.2.2 两种版本 ASPP 的对比

2.2.2.1 ASPP in v2

首先回顾 DeepLab V2 中的 ASPP 结构,DeepLab V2 中的 ASPP 结构其实就是 通过四个并行的膨胀卷积层,每个分支上的膨胀卷积层所采用的膨胀系数不同(注意,这里的膨胀卷积层后没有跟 BatchNorm 并且使用了偏执 Bias)。接着通过 add

⊕

\oplus

⊕ 相加的方式融合四个分支上的输出。

2.2.2.2 ASPP in v3

我们再来看下 DeepLab V3 中的 ASPP 结构,如下图所示。

这里的 ASPP 结构有 5 个并行分支,分别是:

① 一个

1

×

1

1\times 1

1×1 的卷积层

② ~ ④ 三个

3

×

3

3\times 3

3×3 的膨胀卷积层

⑤ 以及一个全局平均池化层(后面还跟有一个

1

×

1

1\times 1

1×1 的卷积层,然后通过双线性插值的方法还原回输入的 W 和 H)。

关于最后一个全局池化分支作者说是为了增加一个全局上下文信息(Global Contextual Information)。

之后通过 Concat 的方式将这 5 个分支的输出进行拼接(沿着 channels 方向),最后再通过一个

1

×

1

1\times 1

1×1 的卷积层进一步融合信息。

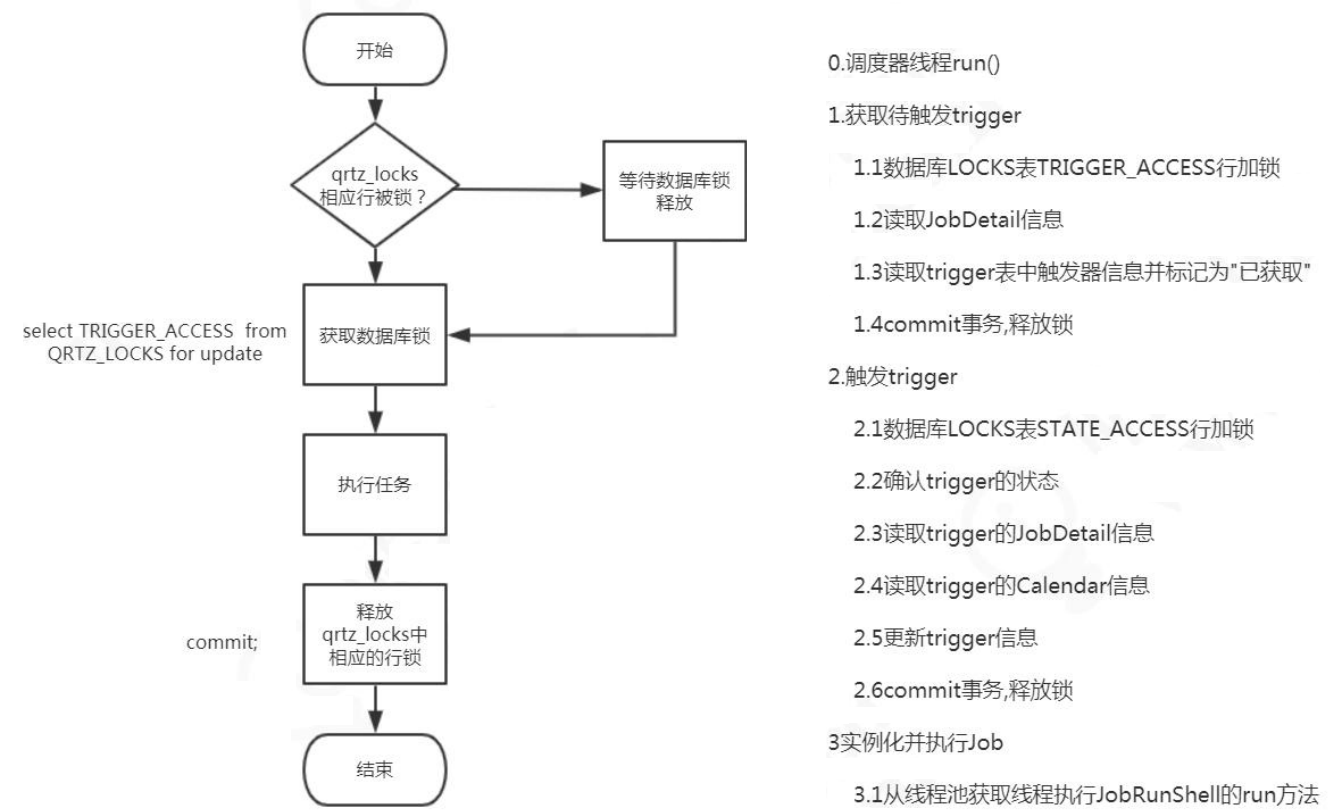

3. Multi-grid(多级网格方法)

在之前的 DeepLab 模型中虽然一直在使用膨胀卷积,但设置的膨胀系数都比较随意。在 DeepLab V3 中作者有去做一些相关实验看如何设置更合理。下表是以 Cascaded Model(ResNet-101 作为 Backbone 为例)为实验对象,研究采用不同数量的 cascaded blocks 模型以及 cascaded blocks 采用不同的 Multi-Grid 参数的效果。

注意❗️

- block5 ~ block7 都是和 block4 结构一样,只不过膨胀系数变了

- 刚刚在讲 cascaded model 时有提到,blocks 中真正采用的膨胀系数应该是图中的 rate 乘上这里的 Multi-Grid 参数

通过实验发现:

- 当采用三个额外的 Block 时(即额外添加 Block5、Block6 和 Block7)将 Multi-Grid 设置成

(1, 2, 1)效果最好 —— Cascaded Model 最佳模型 - 另外如果不添加任何额外 Block(即没有Block5、Block6 和 Block7)将 Multi-Grid 设置成

(1, 2, 4)效果最好 —— ASPP Model 最佳模型

因为在 ASPP model 中是没有额外添加 Block 层的,后面讲 ASPP model 的消融实验时采用的就是 Multi-Grid 等于(1, 2, 4)的情况。

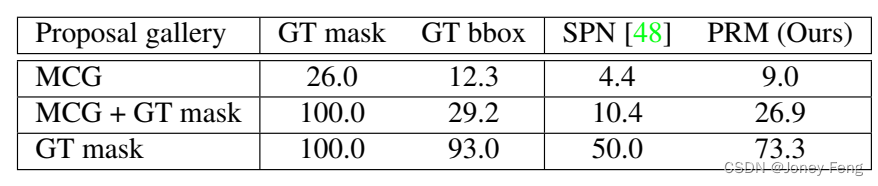

4. 消融实验

4.1 Cascaded model(联级模型)消融实验

下表是有关 cascaded model 的消融实验。

其中:

- MG 代表 Multi-Grid,刚刚在上面也有说在 cascaded model 中采用

MG(1, 2, 1)是最好的。 - OS 代表 output_stride(下采样倍数),刚刚在上面也有提到过验证时将

output_stride设置成 8 效果会更好 - MS 代表多尺度,和 DeepLab V2 中类似。不过在 DeepLab V3 中采用的尺度更多

scales = {0.5, 0.75, 1.0, 1.25, 1.5, 1.75} - Flip 代表增加一个水平翻转后的图像输入

4.2 ASPP model 消融实验

下表是有关ASPP model的消融实验。

其中:

- MG 代表 Multi-Grid,刚刚在上面也有说在 ASPP model 中采用

MG(1, 2, 4)是最好的 - ASPP 前面讲过

- Image Pooling 代表在 ASPP 中加入全局平均池化层分支

- OS 代表 output_stride,刚刚在上面也有提到过验证时将

output_stride设置成 8 效果会更好 - MS 代表多尺度,和 DeepLab V2 中类似。不过在 DeepLab V3 中采用的尺度更多

scales = {0.5, 0.75, 1.0, 1.25, 1.5, 1.75} - Flip 代表增加一个水平翻转后的图像输入

- COCO 代表在 COCO 数据集上进行预训练

5. 训练细节

下表是原论文中给出的关于 DeepLab V3 在 Pascal VOC2012 测试数据集上的 mean IOU。

通过对比发现,其实 DeepLab V3 和 V2 比起来提升了大约 6 个点。但这里的 DeepLab V3 貌似并没有明确指出具体是 cascaded model 还是 ASPP model,个人觉得大概率是指的 ASPP model。然后仔细想想这 6 个点到底是怎么提升的,如果仅通过引入 Multi-Grid,改进 ASPP 模块以及在 MSC 中使用更多的尺度应该不会提升这么多个点。所以我能想到的就是在训练过程中的某些改动导致 mean IOU 提升了。

论文中 A. Effect of hyper-parameters 部分,其中作者有说:

在训练过程中增大了训练输入图片的尺寸(论文中有个观点大家需要注意下,即采用大的膨胀系数时,输入的图像尺寸不能太小,否则 3 × 3 3\times 3 3×3 的膨胀卷积可能退化成 1 × 1 1\times 1 1×1 的普通卷积。

计算损失时,是将预测的结果通过上采样还原回原尺度后(即网络最后的双线性插值上采样 8 倍)在和真实标签图像计算损失。而之前在 V1 和 V2 中是将真实标签图像下采用 8 倍然后和没有进行上采样的预测结果计算损失(当时这么做的目的是为了加快训练)。根据 Table 8 中的实验可以提升 1 个多点。

训练完毕后,冻结 BN 层的参数,然后再去 fine-turn 下网络的其它层,根据 Table 8 中的实验可以提升 1 个多点。

6. PyTorch 官方实现 DeepLab V3 模型结构

下图是霹雳吧啦WZ根据 PyTorch 官方实现的 DeepLab V3 源码绘制的网络结构(与原论文有些许差异):

- 在 PyTorch 官方实现的 DeepLab V3 中,并没有使用 Multi-Grid

- 在 PyTorch 官方实现的 DeepLab V3 中多了一个 FCNHead 辅助训练分支,可以选择不使用

- 在 PyTorch 官方实现的 DeepLab V3 中无论是训练还是验证

output_stride都使用的 8 - ASPP 中三个膨胀卷积分支的膨胀系数是

{12, 24, 36},因为论文中说当output_stride=8时膨胀系数要翻倍

知识来源

- https://blog.csdn.net/qq_37541097/article/details/121797301

- https://www.bilibili.com/video/BV1Jb4y1q7j7