目录

Python爬虫基础知识点

Requests库

Beautiful Soup库

正则表达式

数据存储

防止被反爬虫策略

爬虫调度和任务管理

认识robots.txt文件

反爬虫法律与道德

示例代码

Requests库

Beautiful Soup库

正则表达式

数据存储

防止被反爬虫策略

结语

网络世界中信息的海洋深不可测,而爬虫则是探索和捕捉这个海洋中各种宝藏的工具。Python爬虫作为一种强大而灵活的技术,能够自动化地访问网页、提取数据、处理信息,并为我们呈现出一个广阔的数据世界。

通过掌握Python爬虫的基本知识和技巧,你可以轻松地从互联网中收集、分析和应用各种数据,为你的工作、研究甚至个人兴趣开辟了新的可能性。无论是网页内容的获取、动态网页的抓取,还是数据存储和处理,Python爬虫将成为你的得力助手。让我们一起探索Python爬虫,开启数据之门,发现未知的宝藏!

Python爬虫基础知识点

Requests库

用于发送HTTP请求,获取网页内容,处理Cookie和Session等操作。

Beautiful Soup库

用于解析HTML或XML文档,提供简单而Pythonic的方式来遍历和搜索文档树,提取所需的数据。

正则表达式

用于通过匹配模式来搜索和提取文本数据。在爬虫中,正则表达式通常用于处理特定格式的数据。

数据存储

爬取到的数据可以存储到文件、数据库或其他数据存储介质中,例如CSV、Excel、JSON、SQLite等。

防止被反爬虫策略

有些网站为了防止被爬取,采取了各种反爬虫策略,如验证码、限制访问频率、User-Agent检测等。为了绕过这些策略,需要掌握相应的反反爬虫技术,如使用代理IP、设置合适的请求头、处理验证码等。

爬虫调度和任务管理

对于大规模爬取任务或需要定时、周期性运行的爬虫,需要实现爬虫的调度和任务管理,例如使用多线程、多进程、分布式爬虫等技术来提高爬取效率和稳定性。

认识robots.txt文件

robots.txt文件是网站用来指导搜索引擎爬虫(包括爬虫程序)访问的文件,其中包含了对爬虫的访问限制规则。在编写爬虫时,需要遵守robots.txt规则,避免访问被禁止的页面。

反爬虫法律与道德

在进行网络爬取时,需要了解并遵守相关的法律法规和道德准则,尊重网站的隐私政策和用户协议,避免对他人造成不必要的困扰或损害。

这些基础知识点是Python爬虫的必备知识,掌握了这些知识可以实现简单的网页爬取和数据提取任务。当然,随着爬虫的复杂性和需求的增加,还可以进一步学习和掌握更高级的技术和工具。

示例代码

Requests库

Requests是一个简洁而强大的Python库,用于发送HTTP请求。它使得处理URL和HTTP请求变得更加简单,可以方便地获取网页内容,处理Cookie和Session等操作。以下是一个使用Requests库获取网页内容的示例代码:

import requests

# 发送GET请求,获取网页内容

response = requests.get("https://example.com")

# 获取网页内容

html_content = response.text

# 打印网页内容

print(html_content)Beautiful Soup库

Beautiful Soup是一个流行的Python库,用于解析HTML或XML文档,提供了简单而Pythonic的方式来遍历和搜索文档树,提取所需的数据。以下是一个使用Beautiful Soup库解析HTML文档的示例代码:

from bs4 import BeautifulSoup

# HTML文档

html_doc = """

<html>

<body>

<h1>Hello, World!</h1>

<p>This is a sample HTML document.</p>

<ul>

<li>Item 1</li>

<li>Item 2</li>

<li>Item 3</li>

</ul>

</body>

</html>

"""

# 创建Beautiful Soup对象

soup = BeautifulSoup(html_doc, 'html.parser')

# 提取h1标题文本

h1 = soup.find('h1')

print(h1.text)

# 提取所有li标签的文本

lis = soup.find_all('li')

for li in lis:

print(li.text)正则表达式

正则表达式是一种强大的文本匹配和查找工具,它通过匹配模式来搜索和提取文本数据。在爬虫中,正则表达式通常用于处理特定格式的数据。以下是一个使用正则表达式提取网页链接的示例代码:

import re

# 匹配所有的链接

html_content = '<a href="https://example.com">Example Website</a>, <a href="https://google.com">Google</a>'

links = re.findall('<a href="(.*?)">', html_content)

for link in links:

print(link)数据存储

爬取到的数据可以存储到文件、数据库或其他数据存储介质中,例如CSV、Excel、JSON、SQLite等。以下是一个使用CSV文件存储爬取数据的示例代码:

import csv

# 爬取到的数据

data = [

{'name': 'Alice', 'age': 25},

{'name': 'Bob', 'age': 30},

{'name': 'Charlie', 'age': 35}

]

# 写入CSV文件

with open('data.csv', 'w', newline='') as csvfile:

fieldnames = ['name', 'age']

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer.writeheader()

writer.writerows(data)

# 从CSV文件读取数据

with open('data.csv', 'r') as csvfile:

reader = csv.DictReader(csvfile)

for row in reader:

print(row['name'], row['age'])防止被反爬虫策略

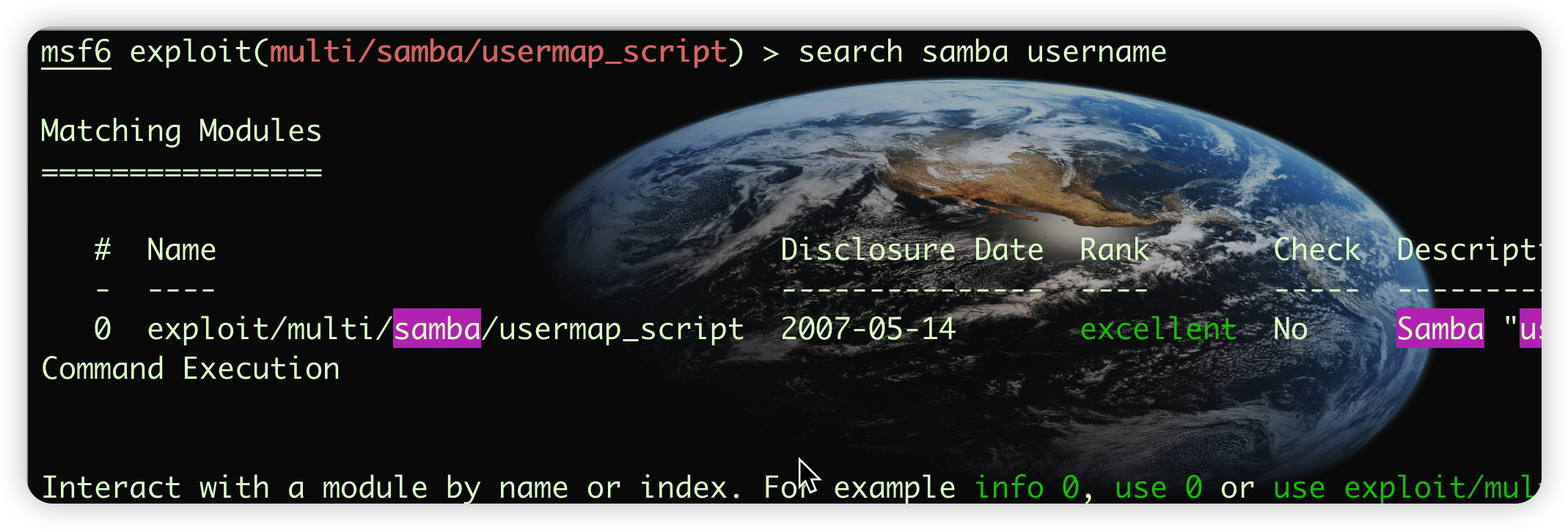

一些网站为了防止被爬取,采取了各种反爬虫策略。为了绕过这些策略,需要掌握相应的反反爬虫技术。例如,以下是使用随机User-Agent头和代理IP进行爬取的示例代码:

import requests

from fake_useragent import UserAgent

# 随机生成User-Agent头

ua = UserAgent()

headers = {'User-Agent': ua.random}

# 使用代理IP进行爬取

proxies = {

'http': 'http://127.0.0.1:8888',

'https': 'http://127.0.0.1:8888'

}

# 发送GET请求,使用随机User-Agent头和代理IP

response = requests.get("https://example.com", headers=headers, proxies=proxies)

# 获取网页内容

html_content = response.text

# 打印网页内容

print(html_content)结语

Python爬虫是一个强大而灵活的工具,无论是从网页抓取数据、进行信息分析,还是进行自动化任务和数据处理,都可以为你节省大量的时间和精力。然而,在开展爬虫活动时,需遵守相关的法律法规和道德准则,尊重网站的隐私和使用协议,并始终保持良好的爬虫行为。