深度自适应小波网络

1. 原理说明

1.1 the Lifting scheme

提升方案,也称为第二代小波[25],是定义与第一代小波[6]具有相同属性的小波的一种简单而强大的方法。

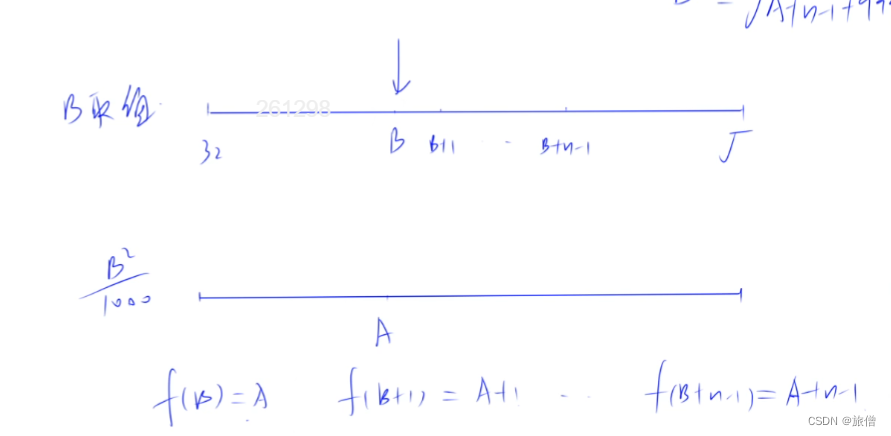

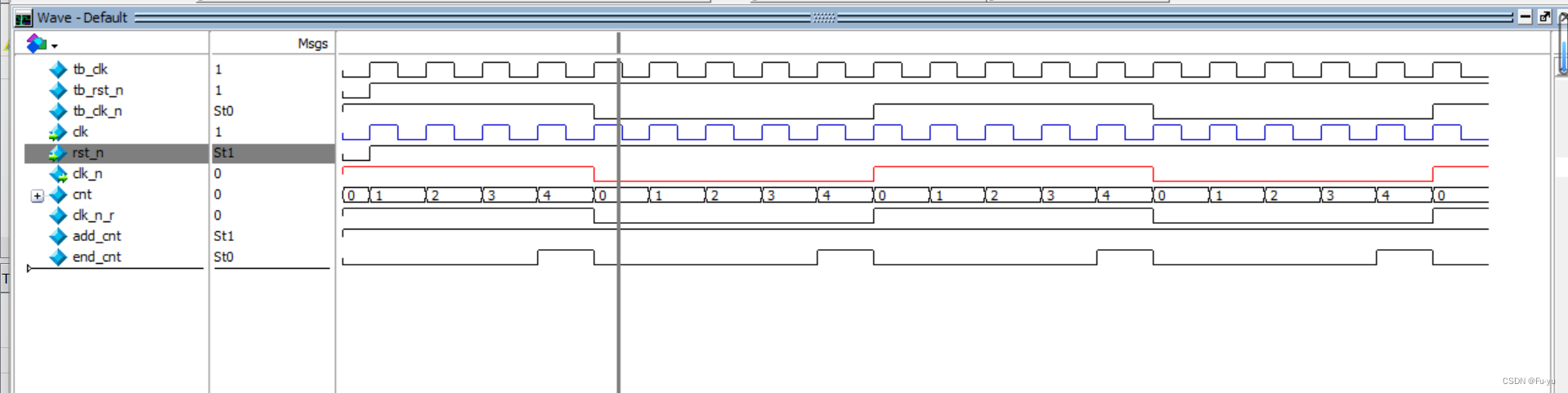

提升方案将信号x作为输入,

生成小波变换的近似分量C, 和细节分量d 这两类子带作为输出。

设计这样的提升方案由三个阶段[4]组成,如下所示。

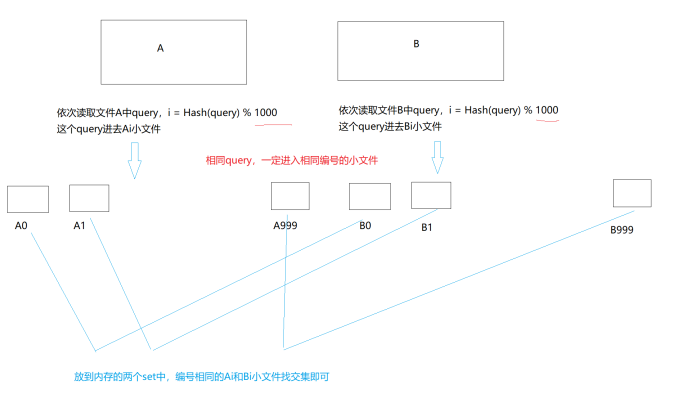

- 信号分解, 将输入信号分解成,不重叠的两个部分: 最简单的做法,分为奇数分量与偶数分量

2.updater, 更新器, 这个阶段会考虑频域中的分离, 期待的效果是,找到一个近似分量C 使其与输入信号有相同的running average; 为了获得这样的效果, 近似分量C = 应该可以通过信号的偶数分量,+ 奇数分量通过U 更新器。

通过偶数分量与奇数分量构建近似分量C;

3.预测器, 信号的分解通常相互关联的, 已经知道分解信号其中一个, 便可以通过构建一个预测器,预测出另外一个。

通过预测出来的偶数分量与原始的偶数分量,两者之间进行做差, 得到一个细节分量 d[n]:

note,这里有个思维误区,传统的方式是一个原始信号 x[n] = 近似分量 + 细节分量。而这篇文章中的表达的思想却是, 通过一个已经知道的近似分量C, 通过近似分量C 来模拟出一个偶数分量;

从而这里的细节分量代表的是, 细节分量 = 原始的偶数分量 - 模拟出来的偶数分量

1.2 L_p, L_u 的参数作用

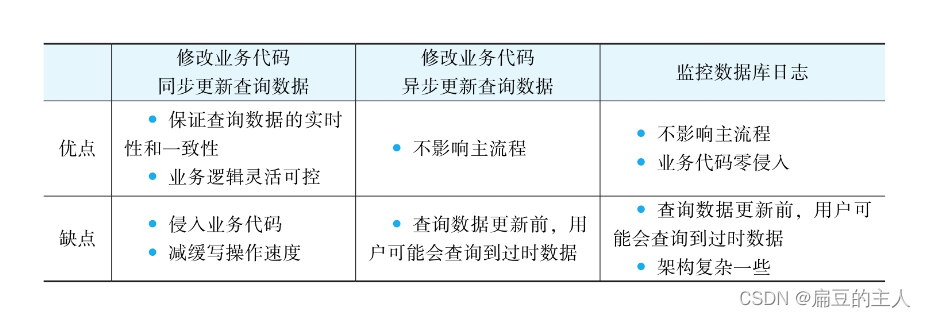

Yi等人[29]提出将更新器和预测器替换为神经网络表示的非线性函数,以适应输入信号。为了训练它们,作者建议使用以下损失函数:

这里存在一个矛盾的地方, 按照公式4, U= c[n] - x_e[n] , 而公式6中, 却让 U = x_o[n] - x_e[n] ;

这难道意思是让 近似分量 c[n] 与偶数分量 x_o[n] , 这是明显存在的一个矛盾,或者是错误的逻辑;

Yi等人[29]认为 近似分量c 根据定义接近x_e[n] 偶数分量,这只使得更新器网络的损失函数有必要最小化c和xo之间的距离。请注意,在Yi等人[29]中,预测器和更新器是按顺序训练的。

1.3 本文的思想

将多分辨率 分析的思想集成到神经网络中, 并用于处理二维的图片数据, 从而实现分类。

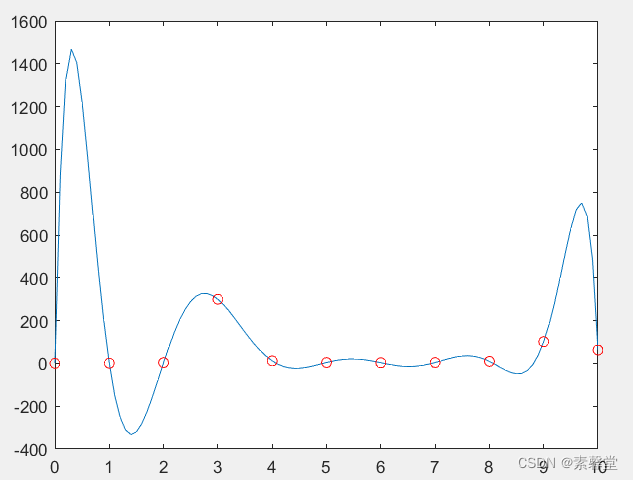

通过反向传播可以实现一维(1D)信号的提升方案。DAWN 架构扩展了这个想法来解决分类任务,并将多分辨率分析集成到神经网络中。该模型以端到端的方式训练二维 (2D) 提升方案的参数,在分类网络的核心执行多分辨率分析。以前的基于小波的CNN方法在学习小波参数时都没有进行这种端到端训练。

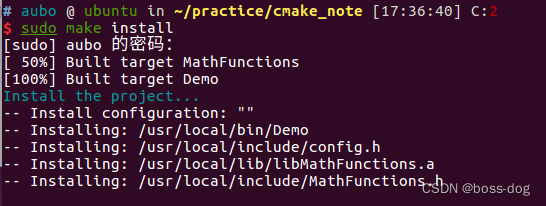

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-oHYPHXGn-1690082593071)(/home/respecting-god/.config/Typora/typora-user-images/image-20230722185829513.png)]

2D自适应提升方案由水平提升步骤和两个独立的垂直提升步骤组成,生成小波变换的四个子带。这些子带分别表示为 LL、LH、HL 和 HH,其中 L 和 H 分别表示低频和高频信息,第一和第二位置分别表示水平和垂直方向。请注意,如图 1 (a) 所示的 2D 提升方案执行空间池化,因为输出空间大小相对于输入减少了一半。