文章目录

- 🍀贪婪模式

- 🍀应用的场景

- 🍀总结

- 🍀非贪婪模式

- 🍀应用的场景

- 🍀总结

- 🍀贪婪模式与非贪婪模式在爬虫的应用

- 🍀转义字符

- 🍀正则表达式常见函数

🍀贪婪模式

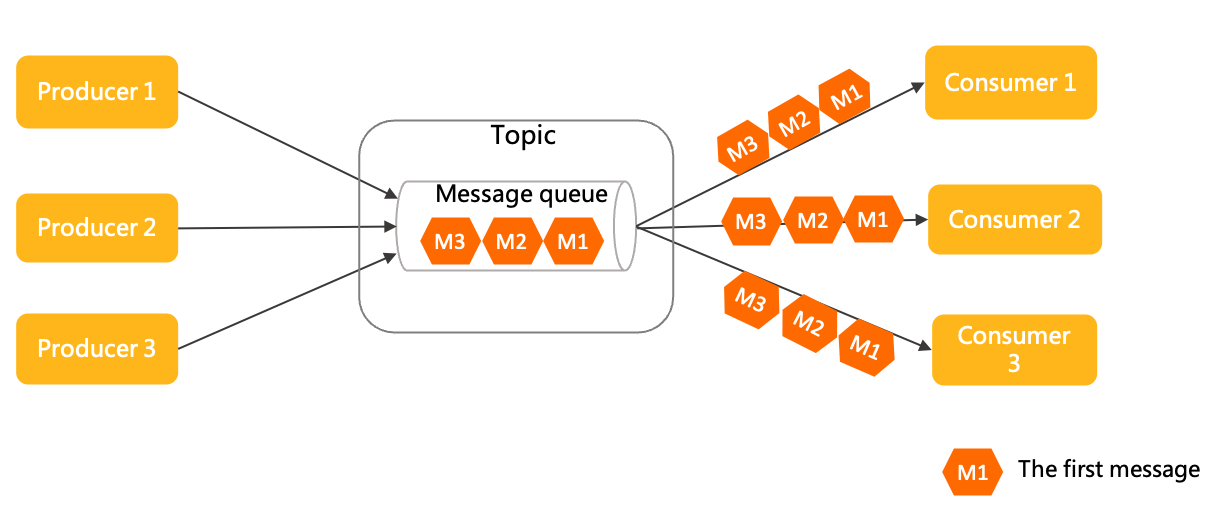

在当今信息爆炸的时代,网络爬虫成为了一种强大的工具,帮助人们从海量的网络数据中快速提取有用信息。其中,贪婪模式的爬虫是一种特别高效的方式,能够在最短的时间内获取大量数据。本文将探讨贪婪模式下的网络爬虫的优势和应用。

贪婪模式爬虫的核心思想是通过遍历网络页面,尽可能快地获取所有能够找到的链接,然后依次爬取这些链接对应的页面。与其他模式相比,贪婪模式下的爬虫不会考虑页面的深度和复杂度,而只关注于尽可能多地获取数据。这使得贪婪模式下的爬虫能够以惊人的速度完成信息的收集,而不需要过多的人工干预。

🍀应用的场景

-

搜索引擎索引:搜索引擎需要快速获取各种网页的数据,以建立强大的索引。贪婪模式的爬虫可以在较短的时间内遍历网络,获取大量网页数据,为搜索引擎提供丰富的搜索结果。

-

数据挖掘研究:在数据科学领域,研究人员通常需要大量的数据来进行分析和建模。贪婪模式的爬虫可以帮助他们快速采集各种类型的数据,从而支持他们的研究工作。

-

价格比较和竞争分析:电商行业经常需要对竞争对手的产品和价格进行监测和比较。贪婪模式的爬虫可以帮助电商企业快速获取竞争对手的产品信息和价格,以便进行及时调整和优化策略。

虽然贪婪模式的爬虫能够迅速获取大量数据,但也存在一些潜在的问题。首先,由于不对页面的质量和深度进行筛选,爬虫可能会收集到大量冗余或无用的数据,导致后续处理困难。其次,过于频繁的访问网站可能会对网站的正常运行造成负面影响,甚至引起法律纠纷。因此,在使用贪婪模式爬虫的同时,我们也需要谨慎处理这些问题,并遵守相关的法律法规和道德准则。

🍀总结

综上所述,贪婪模式下的网络爬虫是一种快速获取数据的利器。它能够以惊人的速度遍历网络,提取大量有用信息,为各种应用场景提供支持。然而,在使用贪婪模式爬虫时,我们也需要保持适度和合规,在尊重他人权益和保护网络环境的前提下,充分发挥其优势,推动信息时代的进步。

🍀非贪婪模式

网络爬虫作为一种收集网络数据的强大工具,非贪婪模式爬虫以继续注重精准数据获取而闻名。在本文中,我们将讨论非贪婪模式下的网络爬虫的原理、优势以及在各个领域的应用。

非贪婪模式的网络爬虫与贪婪模式相比,更加注重深度和精确性。其核心思想是通过智能算法和策略,有选择性地爬取目标网页,确保所获取的数据具有高质量和高度精准性。相比贪婪模式,非贪婪模式的爬虫在选择爬取的页面时更加谨慎,注重对页面的内容、结构和相关性的分析。

🍀应用的场景

-

商业情报和竞争分析:许多企业需要收集竞争对手的数据来进行市场情报和竞争分析。非贪婪模式的爬虫可以精确地爬取特定网站的特定信息,帮助企业了解竞争对手的产品、价格、市场份额等关键数据。

-

新闻和舆情监测:新闻机构和公关公司需要及时了解各种新闻事件和舆情动态。非贪婪模式的爬虫可以有针对性地爬取新闻网站、社交媒体平台等,提供实时、全面且准确的新闻和舆情数据。

-

学术研究和数据科学:在学术界和数据科学领域,研究人员需要获取特定领域的大量数据,以支持他们的研究工作。非贪婪模式的爬虫可以根据特定的数据需求和筛选条件,有目的地爬取相关数据,提供高质量的研究数据。

尽管非贪婪模式的网络爬虫在数据获取方面更为准确和精细,但也面临一些挑战。首先,由于对页面内容和结构的分析较为复杂,非贪婪模式的爬虫往往需要更高的计算和算法复杂度。其次,网站的更新和变化可能会导致爬虫获取的数据失效,需要及时调整和更新爬虫的规则和策略。

🍀总结

总之,非贪婪模式下的网络爬虫是一种追求数据精确性和准确性的重要工具。它通过智能算法和策略,有选择性地爬取目标网页,提供高质量、精准的数据支持。在各个领域的应用中,非贪婪模式爬虫发挥着重要的作用,帮助企业和研究人员快速获取可靠的数据,从而推动商业和科学的发展。

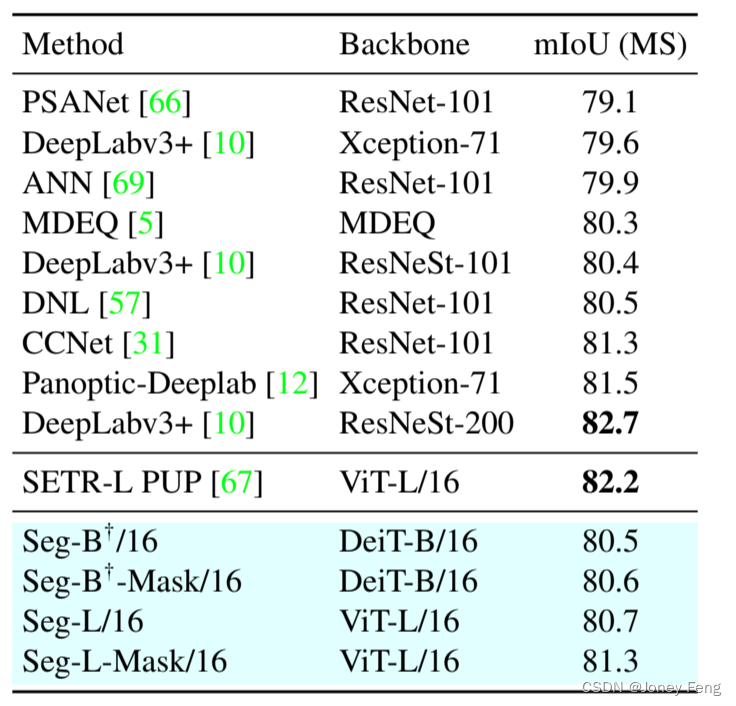

🍀贪婪模式与非贪婪模式在爬虫的应用

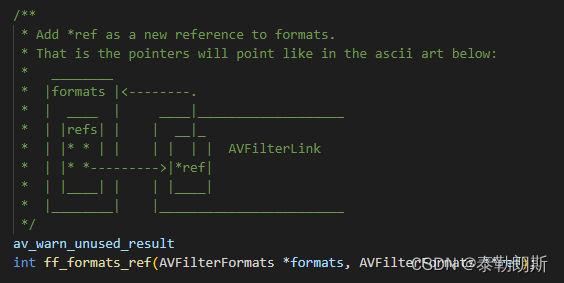

text = "cat111"

result1 = re.match('cat\d*',text)

result2 = re.match('cat\d+',text)

result3 = re.match('cat\d*?',text) # ?代表非贪婪模式

result4 = re.match('cat\d+?',text)

print(result1.group())

print(result2.group())

print(result3.group())

print(result4.group())

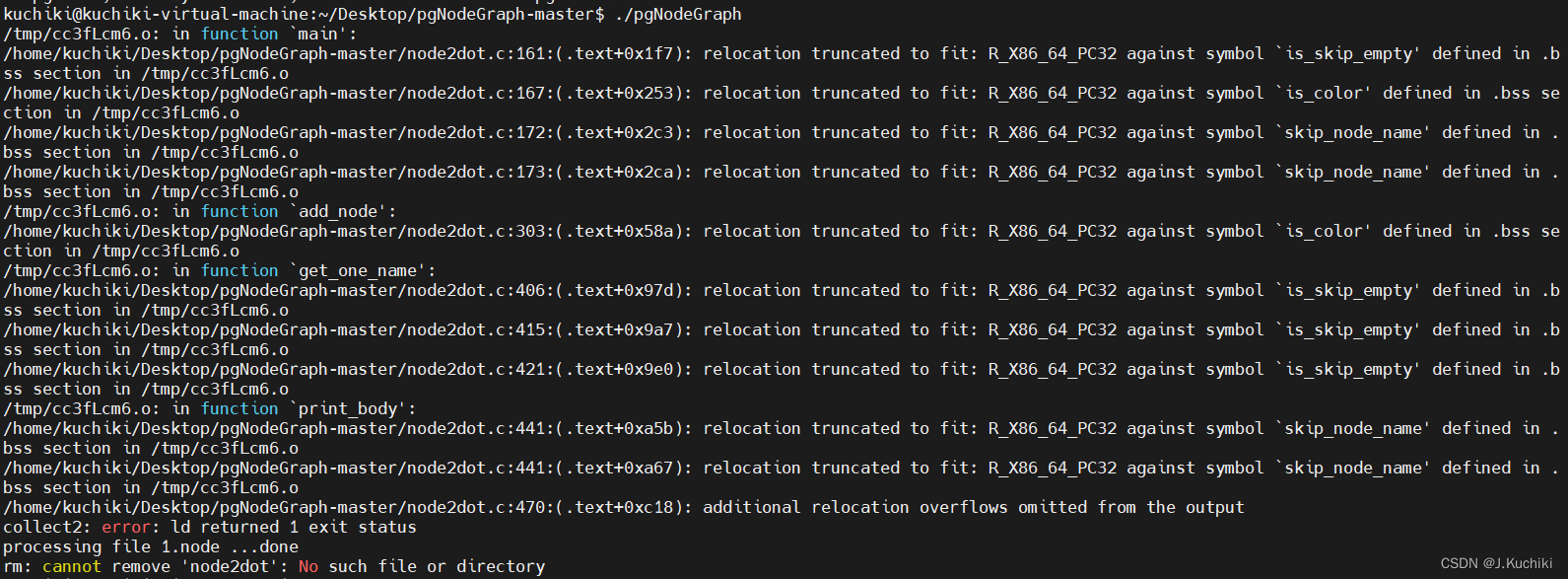

运行结果如下

前两个属于贪婪模式下,对于*(0次或多次),+(至少1次),贪婪模式下能多匹配多匹配;

后两个属于非贪婪模式下,对于*,能少匹配则少匹配,故匹配0次,结果为cat,另一个则是cat1,因为+是至少匹配1次

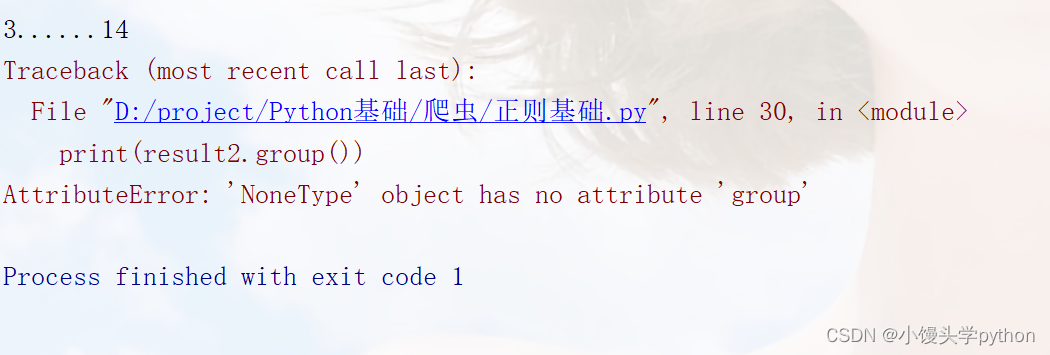

🍀转义字符

text = "3......14"

result1 = re.match('\d\.+\d+',text)

result2 = re.match('\d.\d+',text)

print(result1.group())

print(result2.group())

运行结果如下

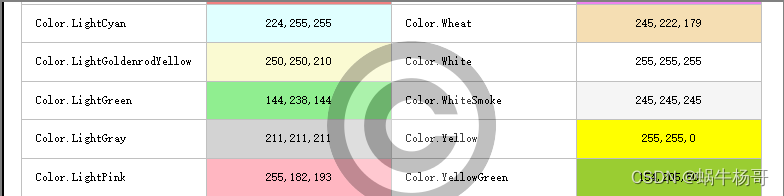

当我们需要如下表格中的符号的时候,我们就需要进行转义,通常使用 \ 或者 [ ]

| 符号 | 说明 |

|---|---|

| 点(.) | 匹配任意字符 |

| 星(*) | 匹配0个或者多个 |

| 加号(+) | 匹配一个或多个 |

| 问号(?) | 要么0个要么1个 |

| $ | 以……为结尾 |

| ^ | 中括号内取反 ;中括号外以……为开始 |

还有个或(|)

🍀正则表达式常见函数

- re.match():从起始左到右进行匹配开头不满足即失败

- re.search():在整个字符串中查找,返回第一个被找到的字符串只返回第一个

- re.findall():在整个字符串中查找所有满足条件的字符串返回结果为列表

- re.sub:替换字符串匹配出来的字符串进行人为替换

- re.split():主要用来分割字符串

挑战与创造都是很痛苦的,但是很充实。