功能演示

摘要:

手势识别是一种通过技术手段识别视频图像中人物手势的技术。本文详细介绍了手势识别实现的技术原理,同时基于python与pyqt开发了一款带UI界面的基于手势识别的猜拳游戏。手势识别采用了mediapipe的深度学习算法进行手掌检测与手部的关键点定位,实时检测速度快、识别精度高。该软件通过摄像头的方式进行手部动作识别,实现与机器人的实时猜拳。本文提供了完整的Python代码和使用教程,给感兴趣的小伙伴参考学习,完整的代码资源文件获取方式见文末。

文章目录

- 功能演示

- 前言

- 一、软件核心功能介绍及效果演示

- 二、手势识别的基本原理

- 1.基本原理

- 2. 代码实现

- 【获取方式】

- 结束语

点击跳转至文末《完整相关文件及源码》获取

前言

手势识别技术是一种将人类手部的动作转化为机器可理解形式的技术。它可以通过分析图像或视频中的手部或身体动作,来识别并理解用户的意图或指令。手势识别技术广泛应用于人机交互、虚拟现实、增强现实、智能监控等领域。通过手势识别技术,用户可以使用手势进行操作和交互,从而提供更加自然、直观的用户体验。

手势识别技术目前正处于快速发展阶段,并取得了很多重要的研究进展。以下是手势识别技术目前常见的一些研究:

1.传感器技术:传感器技术在手势识别中起着关键作用。例如,深度相机、红外传感器和摄像头等设备能够捕捉到人体的姿态和动作信息。

2.深度学习:深度学习方法在手势识别中被广泛应用。通过使用深度神经网络模型,可以实现对复杂手势的准确识别和分类。

3.实时性:实时手势识别是当前研究的一个重点。研究人员致力于提高算法的效率和响应速度,以满足实时交互的需求。

4.多模态融合:多模态手势识别结合了多种传感器数据,如图像、声音和运动数据,以提高识别准确度和鲁棒性。

5.应用:手势识别技术在各个领域都有广泛应用。例如,在虚拟现实和增强现实中,手势识别可用于交互和控制;在医疗领域,手势识别可用于康复训练和手术操作辅助等。

博主根据Mediapipe框架中的深度学习算法进行手势识别检测,并基于此开发了一款基于手势识别的猜拳软件,可以和机器人进行猜拳游戏。感兴趣的小伙伴可以自己试试。

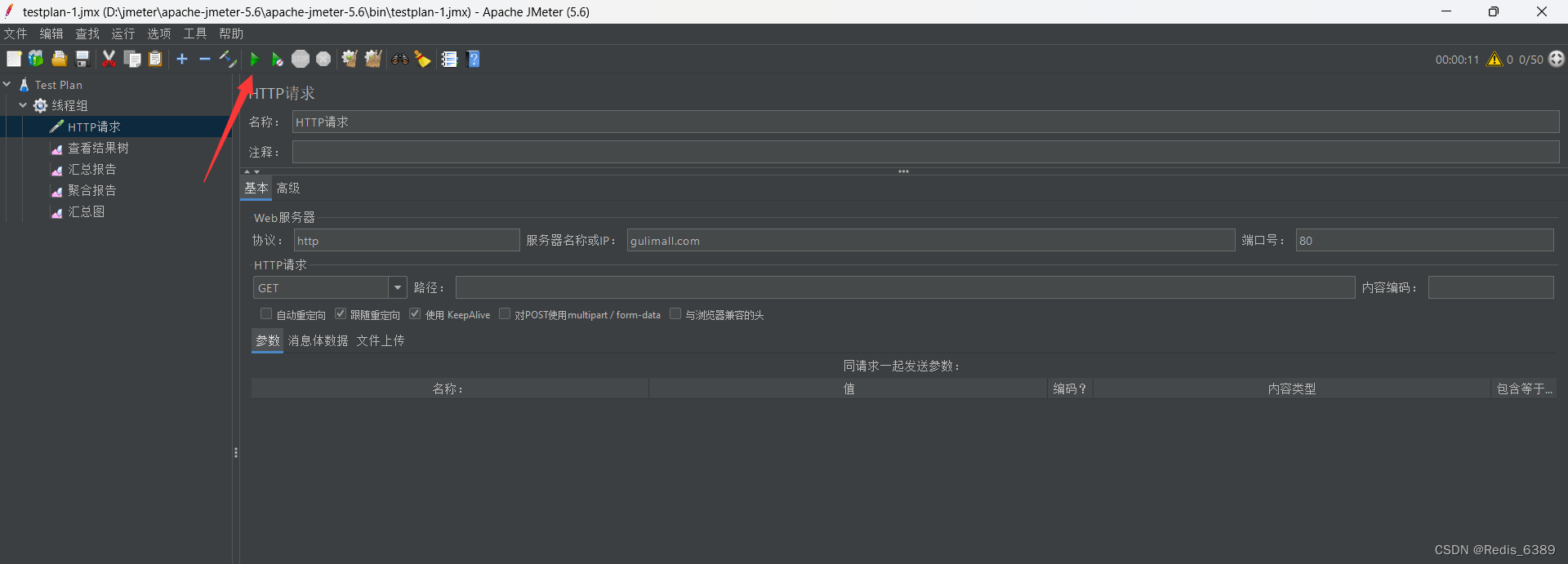

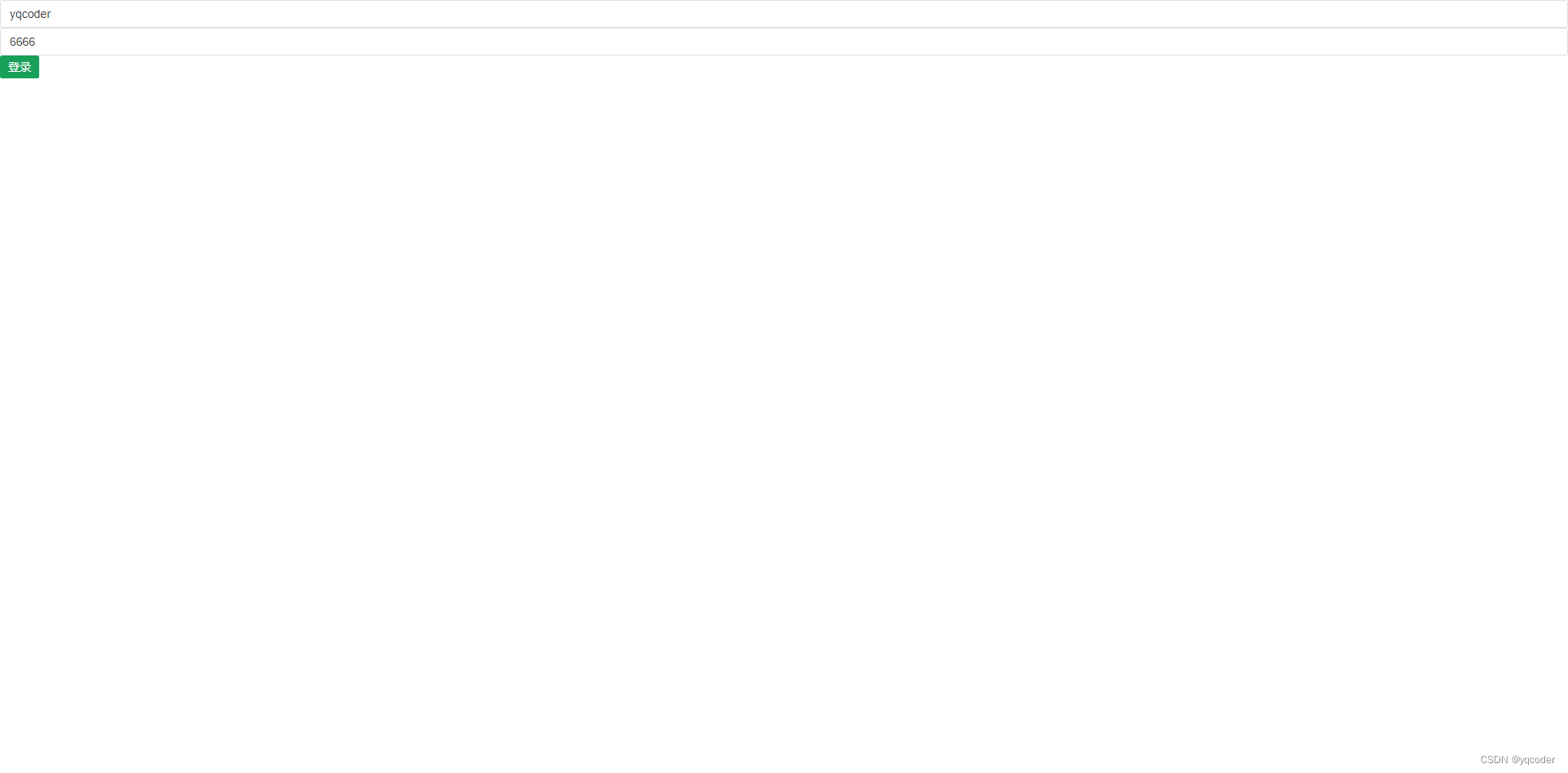

软件初始界面如下图:

摄像头开启后猜拳的界面如下:

一、软件核心功能介绍及效果演示

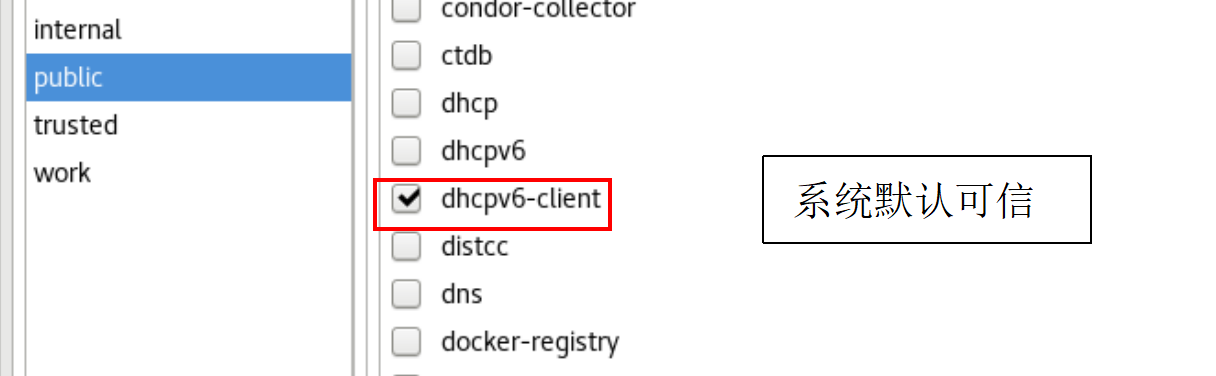

手势识别系统主要功能包括以下几个部分:

1. 支持摄像头进行手部动作识别;

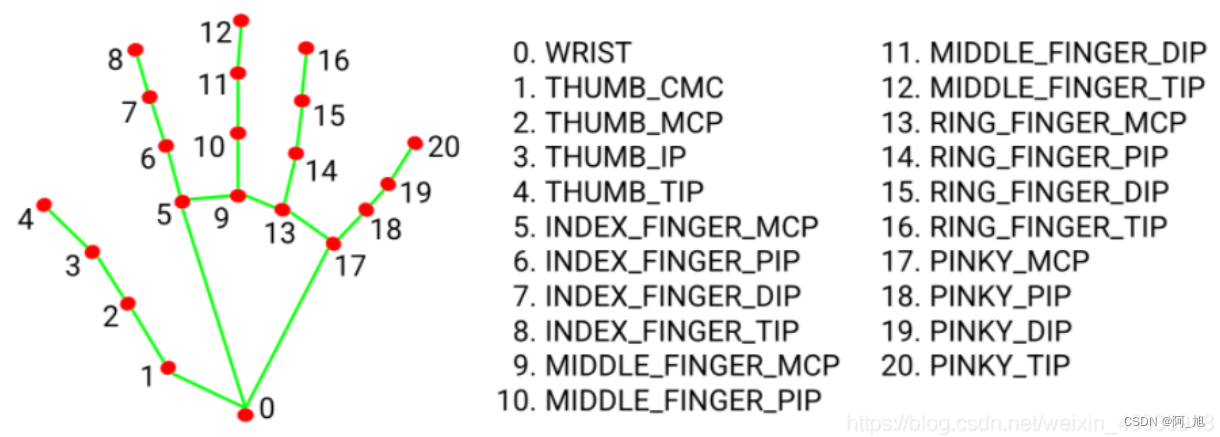

2. 可区分左右手,并显示相应手部的坐标位置,以及21个手部关键点;

3. 可与机器人进行猜拳游戏,并显示最终结果;

(1)摄像头猜拳功能演示

点击打开摄像头按钮,即可开启摄像头,再次点击该按钮,会关闭摄像头,操作演示如下:

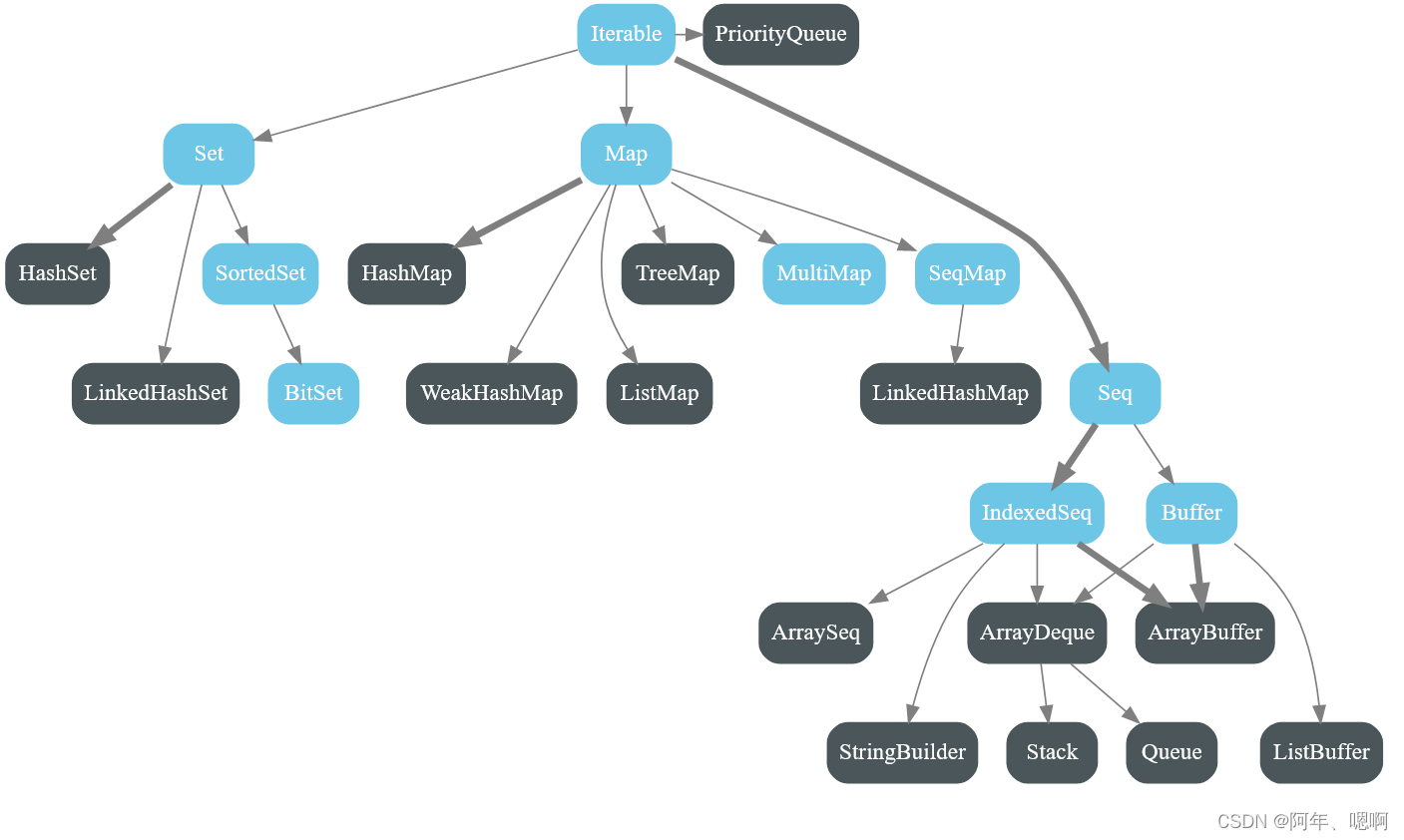

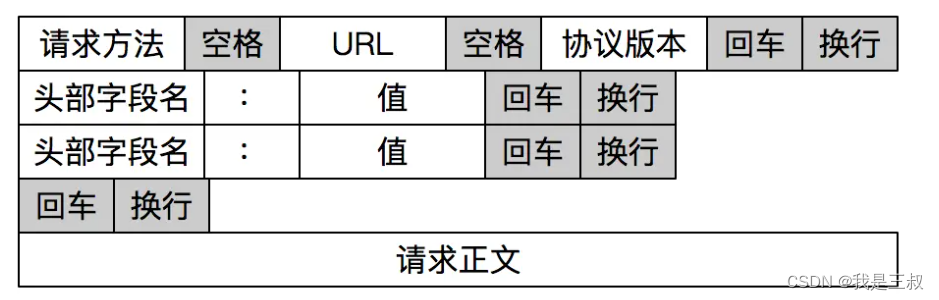

二、手势识别的基本原理

1.基本原理

Mediapipe是Google开源的一个多媒体处理框架,旨在为开发者提供高效、可扩展的数据流图(dataflow graph)方式来构建多媒体应用程序。它提供了一系列预训练好的模型和工具,用于处理视频、音频、姿势估计、手势识别等多媒体任务。

Mediapipe进行手势识别的基本原理是通过检测和跟踪手部关键点来识别手势。它使用了深度学习模型和计算机视觉技术来实现这一目标。首先,mediapipe使用大量的手部图像数据进行训练,以构建一个手部姿势估计模型。在进行检测时,mediapipe加载训练好的模型,并将输入的图像传递给模型。模型会检测图像中的手部区域,并定位手部关键点的位置。一旦检测到手部关键点的位置,mediapipe会利用计算机视觉技术对这些关键点进行跟踪。这有助于在连续帧之间保持关键点的一致性,以提高识别准确性。然后,根据手部关键点的位置和动作,mediapipe可以将手势分为不同的类别。这些类别可以包括手势如拳头、平手、手势指令等。

2. 代码实现

Mediapipe库基于C++实现,并提供了Python接口,使得开发者能够方便地使用这些功能。下面是使用mediapipe进行手势识别的基本原理:

安装:首先,需要安装mediapipe库。可以通过pip命令进行安装:

pip install mediapipe

导入库:导入mediapipe库和其他必要的依赖项。

python

import cv2

import mediapipe as mp

加载模型:使用mediapipe加载已经训练好的手部关键点模型。

mp_hands = mp.solutions.hands

hands = mp_hands.Hands()

mp_drawing = mp.solutions.drawing_utils

手势识别:打开摄像头并读取视频帧,将每一帧传递给hands.process()方法进行手势识别。

# coding:utf-8

cap = cv2.VideoCapture(0) # 打开摄像头

while True:

ret, frame = cap.read() # 读取视频帧

if not ret:

break

image = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB) # 转换颜色空间

results = hands.process(image) # 手势识别

# 处理识别结果

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

mp_drawing.draw_landmarks(

frame,

hand_landmarks,

mp_hands.HAND_CONNECTIONS) # 用于指定地标如何在图中连接。

for point in hand_landmarks.landmark:

x = int(point.x * frame.shape[1])

y = int(point.y * frame.shape[0])

cv2.circle(frame, (x, y), 5, (0, 255, 0), -1) # 画出关键点

cv2.imshow('Gesture Recognition', frame) # 显示结果

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

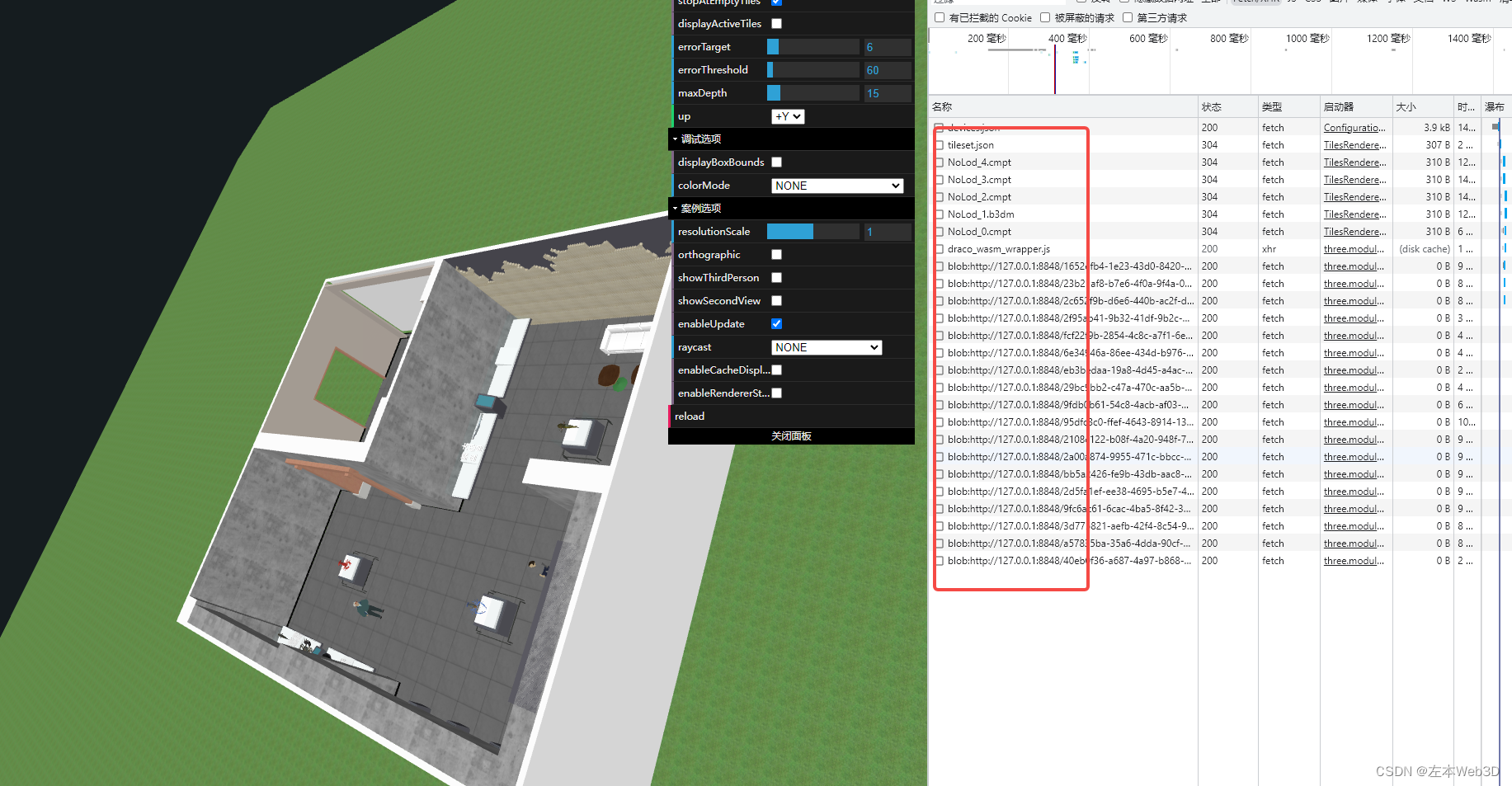

在上述代码中,我们首先导入了mediapipe库和其他必要的依赖项。然后,使用mp.solutions.hands.Hands()加载手部关键点模型,并打开摄像头读取视频帧。每一帧都传递给hands.process()方法进行手势识别。返回的结果包含检测到的手部关键点的位置信息,我们可以根据这些信息进行相应的处理。手部关键点位置如下图:

通过遍历识别结果中的多个手部关键点,我们可以获取每个关键点在图像中的坐标,并在图像上绘制圆形表示关键点的位置。最后,使用cv2.imshow()方法显示结果,并通过cv2.waitKey()检测按键操作。

这就是使用mediapipe进行手势识别的基本原理。通过结合mediapipe库提供的预训练模型和API,开发者可以更轻松地构建手势识别应用程序。

下图是摄像头检测结果:

根据以上原理,博主基于python+ pyqt5开发了基于手势识别与机器人猜拳的软件。也就是第二部分介绍的软件功能内容。关于该手势识别猜拳系统的涉及到的完整源码、UI界面代码等相关文件,均已打包上传,感兴趣的小伙伴可以通过下载链接自行获取。

【获取方式】

关注下方名片G-Z-H:【阿旭算法与机器学习】,回复【手势识别】即可获取下载方式

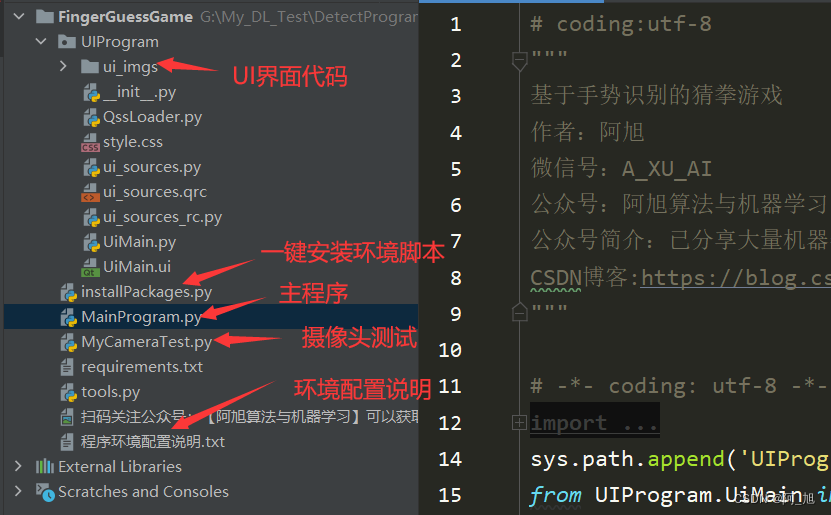

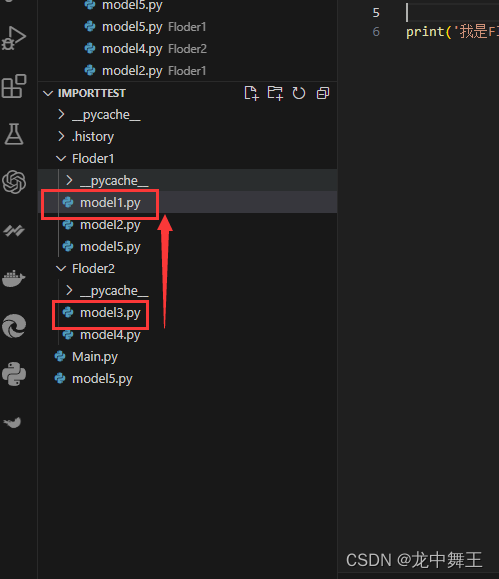

本文涉及到的完整全部程序文件:包括python源码、UI文件等(见下图),获取方式见文末:

注意:该代码采用Pycharm+Python3.8开发,运行界面的主程序为

MainProgram.py,,摄像头测试脚本可运行MyCameraTest.py。并提供了环境一键配置脚本文件:installPackages.py。为确保程序顺利运行,请按照程序环境配置说明.txt配置软件运行所需环境。

关注下方名片GZH:【阿旭算法与机器学习】,回复【手势识别】即可获取下载方式

结束语

以上便是博主开发的关于手势识别系统的全部内容,由于博主能力有限,难免有疏漏之处,希望小伙伴能批评指正

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!

觉得不错的小伙伴,感谢点赞、关注加收藏哦!

![OSError [Errno 22] Invalid argument(已解决)](https://img-blog.csdnimg.cn/img_convert/2bb1daeb94a3cb4fb5703aa769d9bdd6.png)