作者 | 辰纹

来源 | 洞见新研社

大模型的“涌现”还在持续。

5月底举行的中关村论坛上,有专家披露,中国10亿级参数规模以上的大模型已经发布了79个,刚刚结束的世界人工智能大会上,又有一批大模型批量发布。

大模型的热度居高不下,世界人工智能大会甚至还设置了一个“迈向通用人工智能”主题的展区,集中展示国内外总计30多款大模型。

我们看到的大模型“涌现”是表面,背后到底是什么促成了大模型的“涌现”呢?

昇腾人工智能产业高峰论坛上,科大讯飞高级副总裁、认知智能全国重点实验室主任胡国平现场演示了星火大模型的各项能力,由星火大模型再进行延伸,算力底座的支撑作用成为大模型竞争的焦点。

1.后发先至,星火大模型挤进第一阵营

不得不说,科大讯飞的嗅觉还是很敏锐的。

OpenAI去年11月30日发布ChatGPT后仅仅15天(12月15日),科大讯飞就启动了“1+N”认知智能大模型的专项攻关,5个多月后(5月6日),星火认知大模型正式发布,一个月后的6月9日,星火认知大模型V1.5发布。

根据科大讯飞的计划,今年内星火大模型还将有两次重大升级,分别是:

8月15日,代码能力升级以及多模态交互能力提升;

10月24日,实现通用模型对标ChatGPT,中文超越ChatGPT的当前版本,英文能做到相当水平,并在教育、医疗等领域做到业界领先。

一个值得关注的点,与其他大模型有所不同,星火认知大模型采用“1+N”的架构,其中“1”指的是通用认知智能大模型,“N”就是大模型在垂直领域的落地。

根据胡国平的分享,目前星火大模型已经在教育、办公、汽车、医疗、工业等领域落地,在多个行业场景实现了从0到1的创新应用。

光说不练假把式,星火大模型的实际表现到底如何,我们一起来看看胡国平的现场演示。

首先测试的是星火大模型的文本生成能力,胡国平出了一个“用诗歌的方式畅想通用人工智能实现后的世界”的任务,大模型随即给出回答——“通用人工智能来临日,世界改变如风起,智慧无边触手可及,人类生活焕然一新,自动驾驶驰骋天地……”

语言理解方面,星火大模型不仅能够理顺上下文的关系,甚至对于类似“宁死不屈”和“能屈能伸”这类词汇,也能够清楚的进行辩证理解和场景化的应用。

知识问答维度,星火大模型能够基于搜索结果之上,运用大模型的语言理解和综合表达能力给出更有针对性的回答。

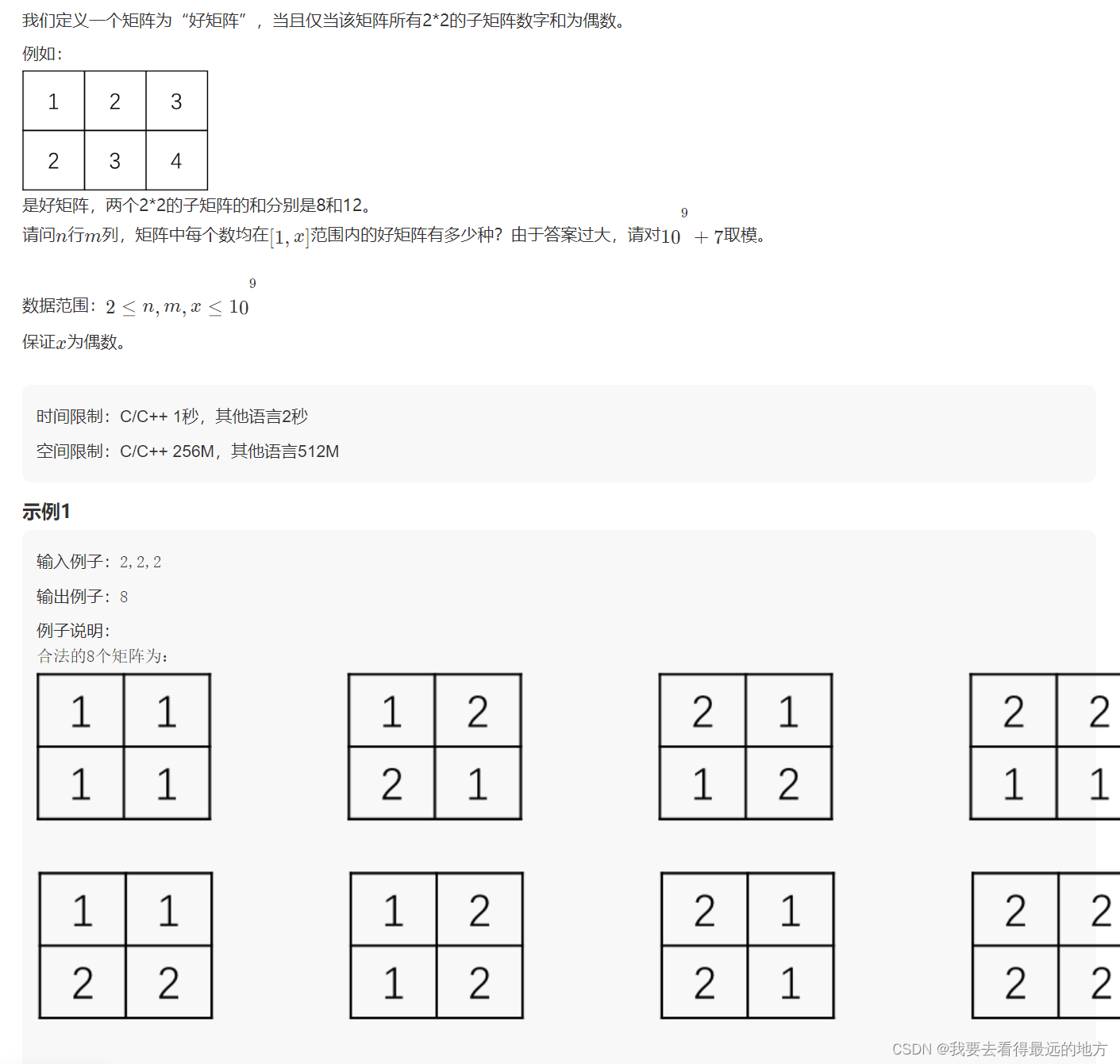

逻辑推理是考验大模型智慧水平的关键任务,讯飞星火经过两个版本的迭代,现在对于“农夫带着狼、羊、菜一起过河”这种组合限制下的复杂推理都能非常好的完成。

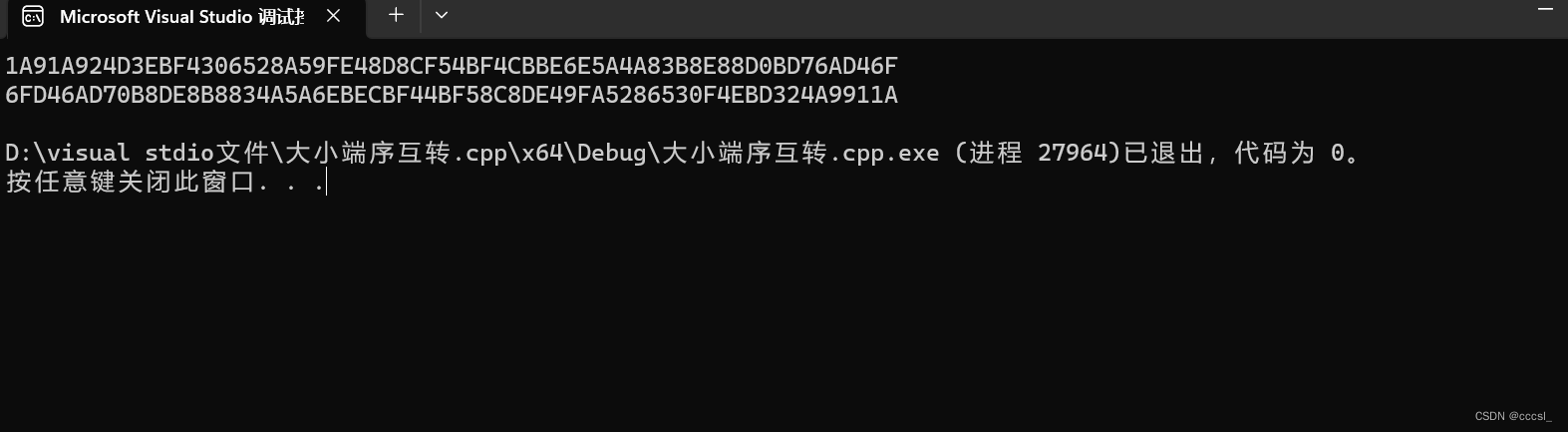

根据胡国平的介绍,星火大模型的数学能力和代码能力在发布后也有了长足进步,其中数学能力对于高中阶段涉及到的几何和代数问题都能按照步骤准确的给出答案,代码能力也有了新的突破,特别是Python的代码生成能力已经达到了比较高的水平。

最后演示的多模态能力,根据胡国平的任务指令,星火大模型很快生成了一段散文文本,同时使用一个女生形象的虚拟人主播朗诵这篇散文。

很显然,星火大模型的表现非常出色,经科学、系统地评测,“讯飞星火认知大模型”在国内可测的现有系统中处于领先水平。

星火大模型从立项到发布,再到迭代,每个节点留给研发训练的时间都非常短,但就其展现出来的能力和效果来看,却能稳居中国主要大模型的第一梯队,在其背后到底藏着哪些秘密呢?

2.惊艳之余,看清昇腾算力底座的成色

除了科大讯飞多年来在认知智能领域形成了深厚的技术储备和积累之外,由昇腾AI支撑的算力底座尤为关键。

大模型训练首先要求满足的条件就是大算力。

有行业专家做过测算,完成一个千亿参数级别的大模型,例如GPT-3需要314 ZFLOPs算力的模型训练,当单卡只有312 TFLOPS算力时,用一张卡训练一个模型要耗时32年。

因而引入分布式训练解决方案,通过建立AI芯片集群的方式来加速模型训练成为当前行业的主流。

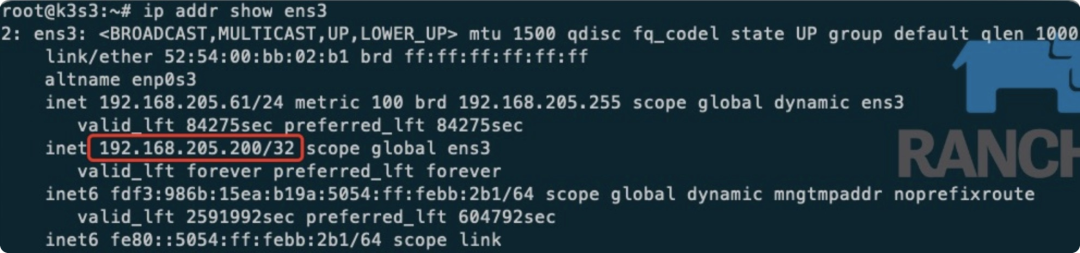

可是,当芯片集群越来越大,由于大模型被并行切分到集群,模型切片间会产生大量的多卡通信、节点通信,此时对集群的通信能力也提出了更高的要求。

由此可见,大模型训练既考验算力的大小,还考验算力集群工程化、系统化的能力。

还是以星火大模型为例,整个模型训练的时间很短,而其迭代的速度又很快,这也意味着在算力之外,模型训练的稳定性和可扩展性也要有很好的表现。

我们来看看昇腾AI集群是如何做到的。

首先,整机系统升级后,把计算、存储、网络、能源这些要素全部整合在一起,相当于把AI数据中心打造成一台AI超级计算机,实现了能效的倍增。

其次,基于背板总线的架构设计,实现全节点盲插和精准液冷散热,具备更大的算力密度,以及低于1.15的PUE,让算力中心更加绿色,并可实现更加灵活的扩展和部署。

最后,通过节点、机柜、集群、作业级的多级可靠设计,实现了系统级故障的可诊断、可预测、可衡量、可恢复,能保持30天以上的稳定训练周期,实现高可用性。

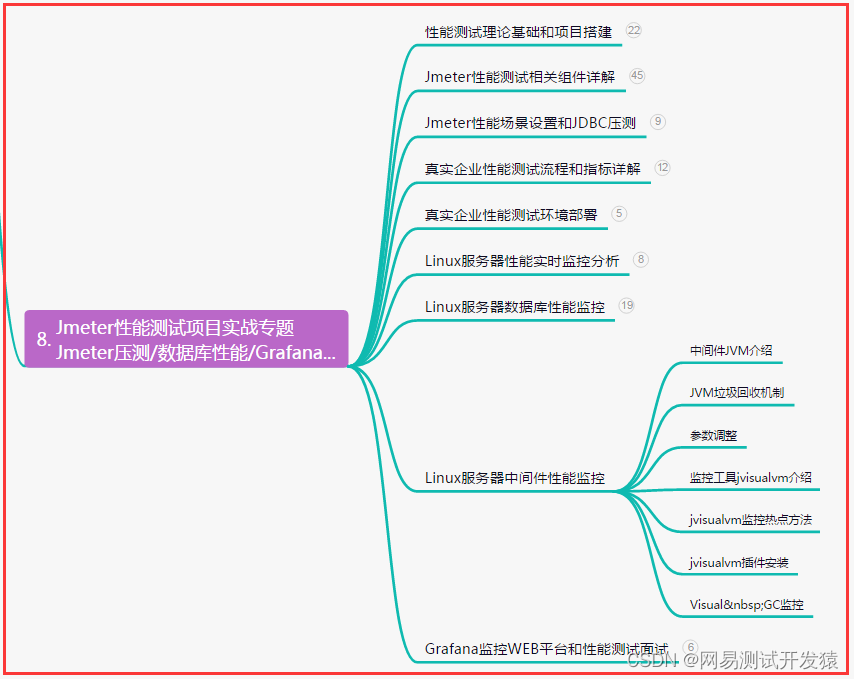

其实,早在2019年,昇腾AI就已经开始了千卡集群的探索,当时只有4000张卡的规模,于2020年落地商用;刚刚结束的昇腾人工智能产业高峰论坛上,华为宣布昇腾AI集群全面升级,集群规模已经扩展到16000张卡,这也是说,一个1750亿参数,100B数据的大模型,大概半天时间就可以完成一次训练。

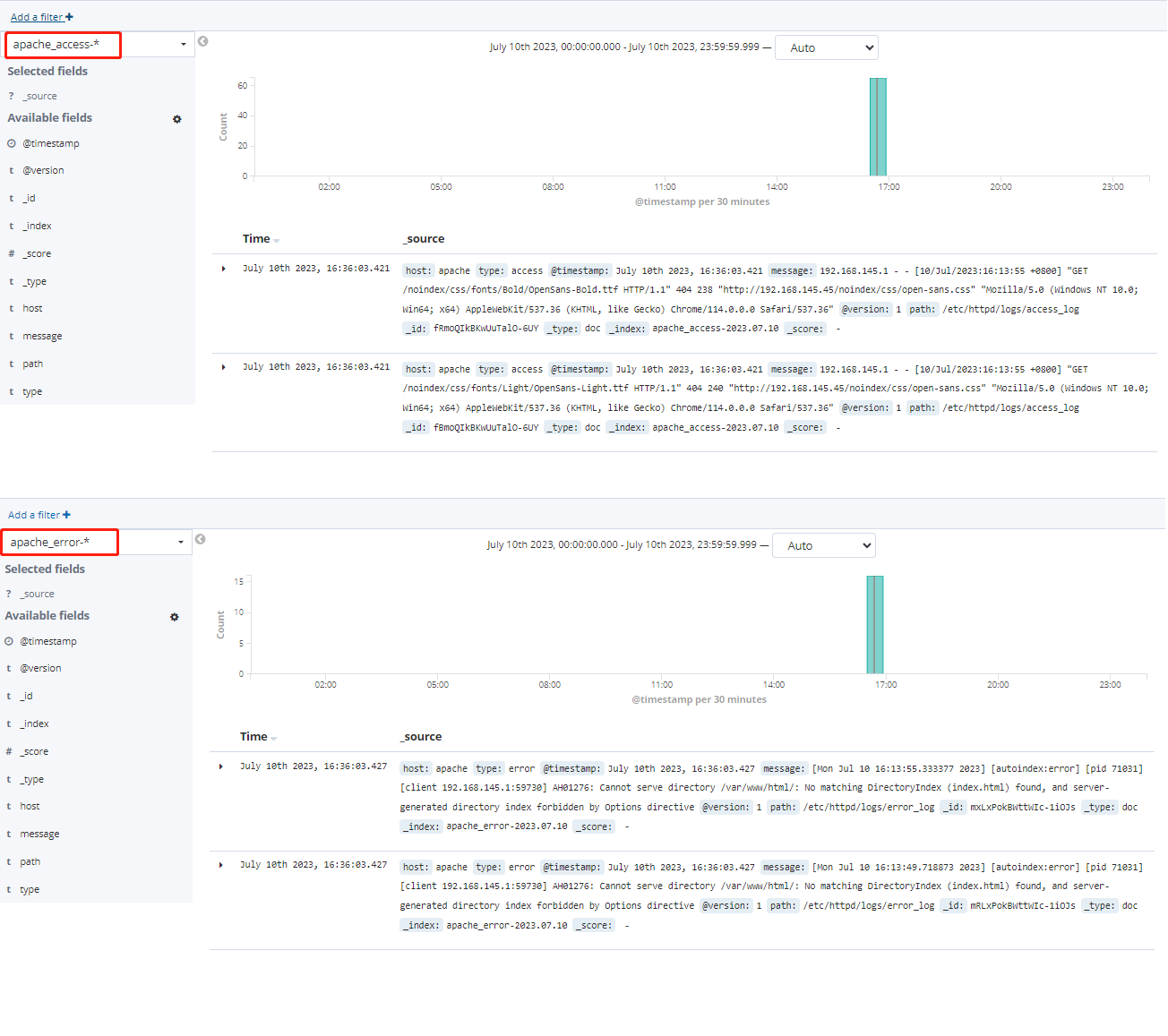

事实上,支持星火大模型研发和训练只是昇腾AI能力的一个缩影,更高层级中,昇腾AI还广泛参与到全国20多个人工智能计算中心的建设,包括武汉、北京、西安、成都、大连、沈阳等在内,已经有7个城市获得了国家的认可,成为科技部首批国家新一代人工智能公共算力开放创新平台。

与此同时,昇腾AI还支持了近一半的中国原创模型的开发,根据今年5月份发布的《中国人工智能大模型地图研究报告》统计,国内10亿参数规模以上的大模型,有30多个是基于昇腾原生的开源和适配,覆盖了NLP、多模态、云、语音等多个领域。

如此多的项目,让昇腾AI积累了大量的经验,因而在推动大模型应用落地方面,昇腾AI不光是算力提供者,还从效率出发,成为大模型开发流程的塑造者。

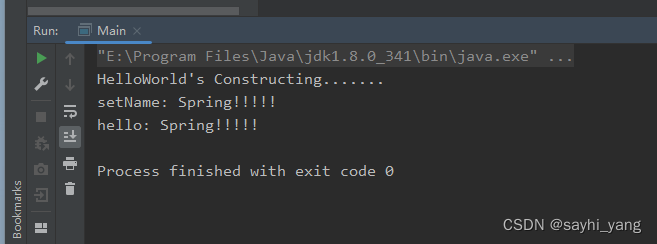

大模型的开发模式,最开始时是传统的API-based,昇腾AI通过提供一系列的大模型开发套件,走向了model-based,在这套开发模式下,只需要几十行代码就可以实现全流程的脚本开发,降低大模型开发门槛。

很显然,面对大模型开发训练的诸多难点和挑战,昇腾AI迎难而上,选择了正面硬钢,于昇腾AI自身而言,是大模型时代算力竞争的提前占位;于大模型行业整体而言,则是国产大模型架构在自主创新的软硬件基础之上,是国家科技实力的真实表现。

3.创新路上,中国AI需要更多同行者

大模型时代才刚刚开启,未来还有很多不确定性,唯一确定的是,对算力会有着持续的需求。

胡国平预测了大模型发展的三个趋势。

第一个是,未来会有更多新的大模型出现,现有的大模型在不断迭代之后,数据规模会有更大的增长,加之应用端的用户数量的增加,由此会带来更大的算力需求。

第二个是,随着大模型能力的提升,能够与更多的传感器、执行器产生数据和智慧的输入与输出,大模型的边界会进一步扩散,此时对算力会有更大的消耗。

第三个是,未来或将每个人都会拥有自己的专属大模型或者助理,围绕着个人的学习和生活,个人助理每时每刻都在进化和同步升级,这对极低功耗的芯片和系统解决方案提出了挑战。

不难看出,这三个趋势都与算力密切关联,在胡国平看来,大模型与大脑的原理层类似,都通过超千亿神经元组合在一起,接受输入的刺激,再产生智慧的输出,有着相似的智能激发和运行机制。

这也意味着,“大脑能做的事情,大模型也能实现”,大模型具有无限的潜力,算力底座的探索也就没有止境。

当然,要做好大模型,光有算力也不行。

中国科学院院士、清华大学计算机系教授、清华大学人工智能研究院名誉院长张钹院士认为,Chat GPT的成功并不是仅仅归功于数据、算力和算法三个要素,而是要强调四个要素,分别是知识、数据、算法和算力。

也就是说,我们要从文本中获取数据,然后从数据中获取到知识,出现这个转变才有了现在的ChatGPT,而这些都建立在“基于词嵌入的文本语意表示””基于注意机制的转换器”“基于预测下一个词的自监督学习”这三项技术的突破才得以实现的。

由此看来,数据、算法、算力这三个要素看似独立,但在大模型中又关联紧密,因而产业生态建设的重要性凸显出来。

昇腾AI产业生态发展迅速,截至目前为止,已经发展了30多家硬件伙伴、1200多家ISV,联合推出了2500多个行业AI解决方案,这套生态体系是可以直接搬运到大模型产业的。

人才培养方面,有超过300家高校院所与昇腾AI开展合作,每年培养了超过10万名专业的AI人才,昇腾AI开发者的数量也在高速增长,今年已经突破了180万人。

也正因为有如此根基,昇腾AI在此次大会论坛上宣布,联合科大讯飞、智谱AI、云从科技和面壁智能四家生态伙伴共同发布大模型训推一体化解决方案,加快大模型的落地速度,让大模型在智慧城市、智慧金融、智慧煤矿、智慧制造等更多细分行业中发挥出价值。

毫无疑问,大模型肯定会迎来属于自己的时代,假如时代已经来临,那么它的决胜期绝对不是刚刚起步的第一年,和其他颠覆性的新产业技术一样,大模型的发展注定会是一场时间与耐力的长跑。

当然,在子弹飞的这个过程中,在大模型时代的决胜时刻到来之前,我们需要更多的科大讯飞,也迫切需要能提供强大算力的昇腾AI。