本论文是美团在pointpillar算法的基础上的改进。

主要改进点分为一下两个:

1.引入注意力机制对pillar内的特征进行提取,改善直接maxpooling导致的细粒度信息丢失。

2.参考CSPNet和RepVGG构建了一个全新的轻量化backbone。

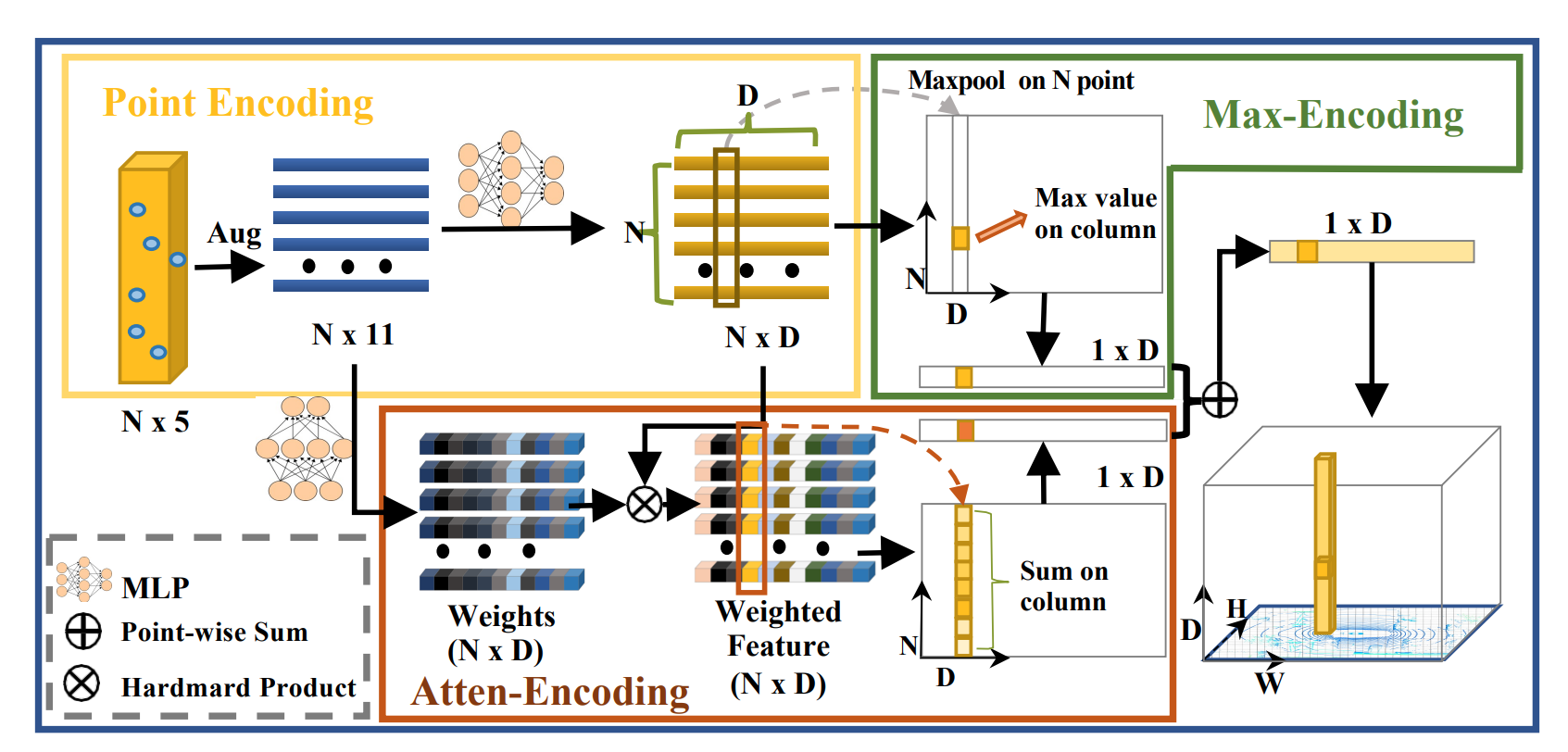

一、pillar注意力机制特征提取

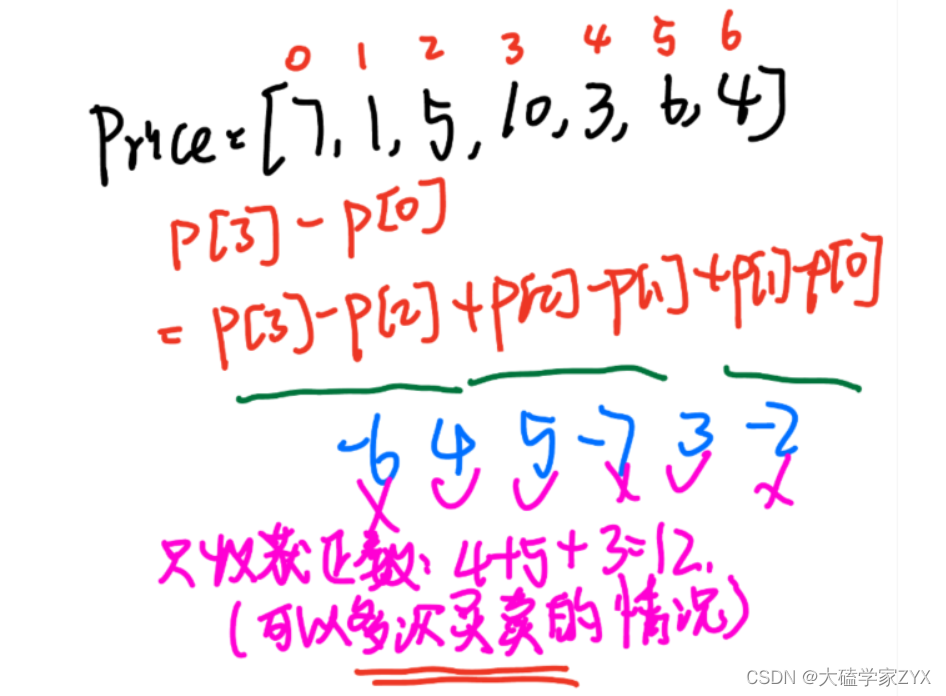

pillar特征提取这一块,与pointpillars不同,他会保留每个pillar里所有的点(怎么并行计算?),然后每个点MLP升维,求max得到全局特征,这里和pointpillar都一样,然后他再从点的原始特征出发,MLP得到N*C的矩阵,在N维度求softmax,和之前升维的特征点积,得到注意力机制之后的特征,然后注意力得到的特征与全局特征求和,作为pillar的最终特征。

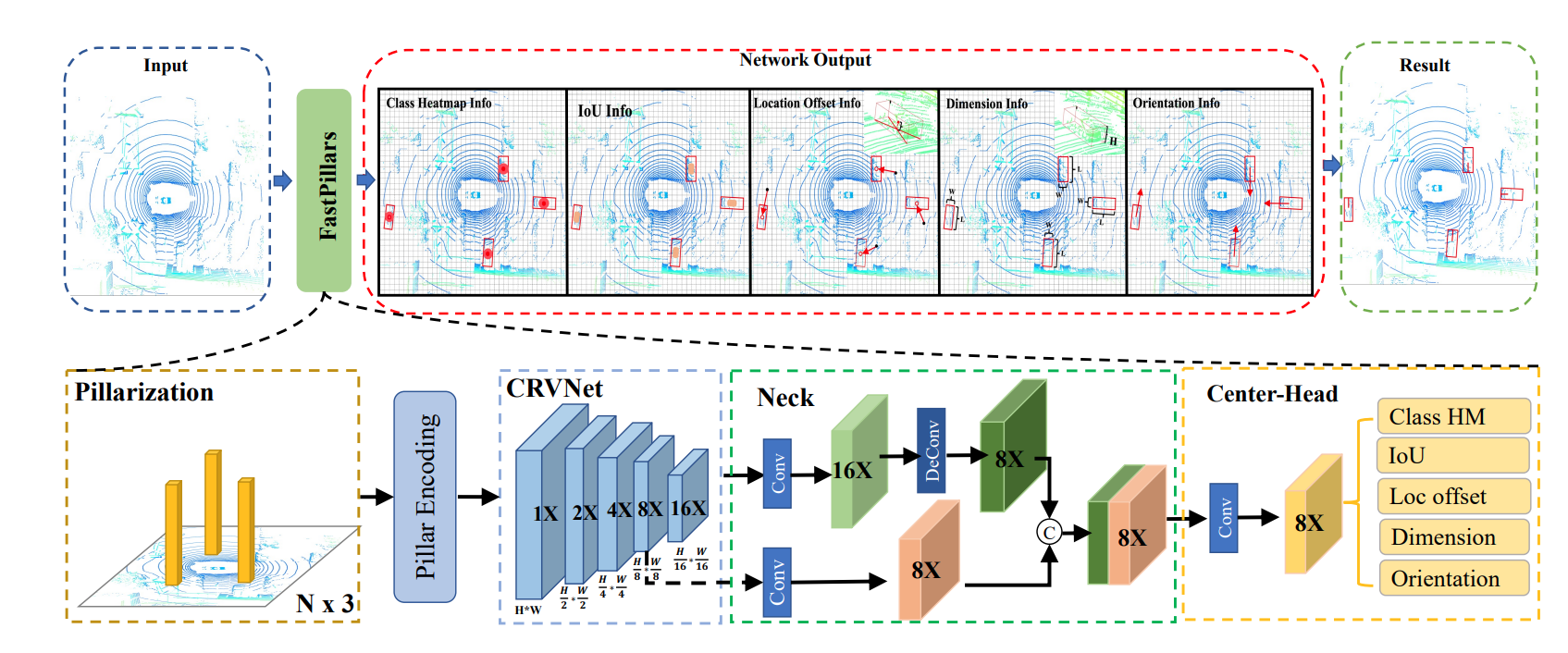

二、主干网络CRVNet

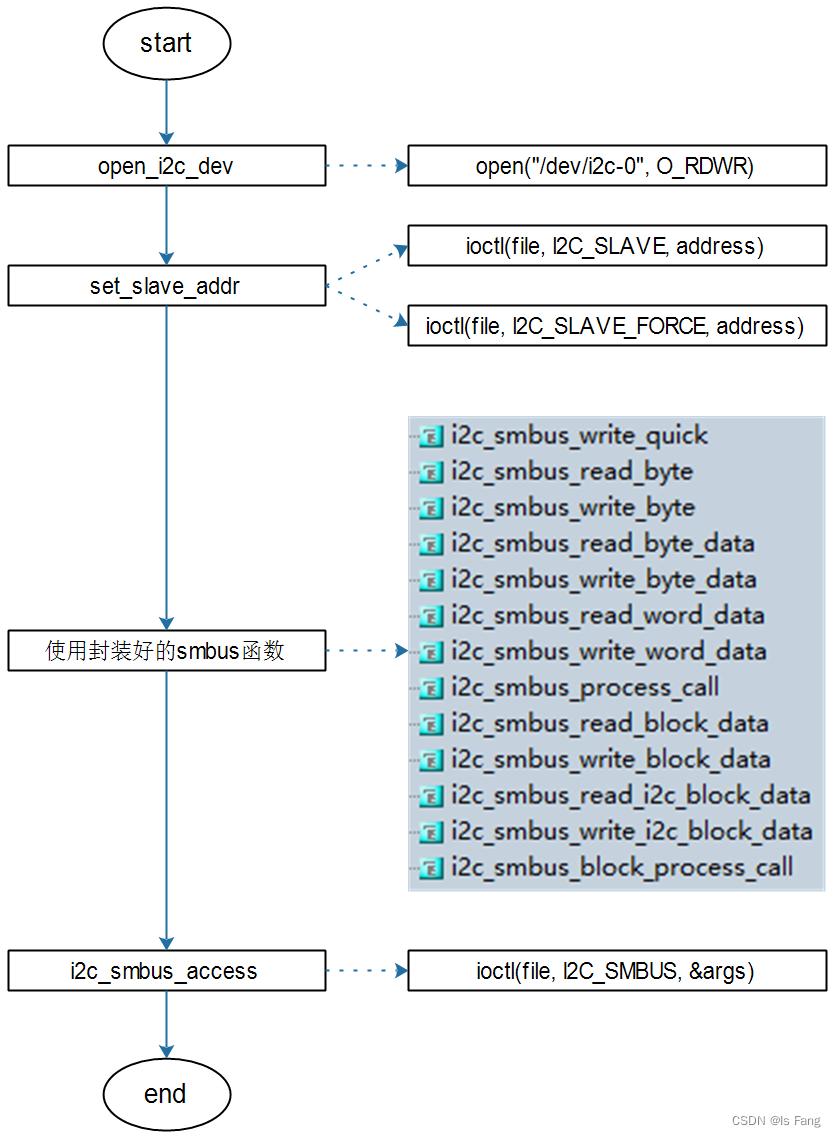

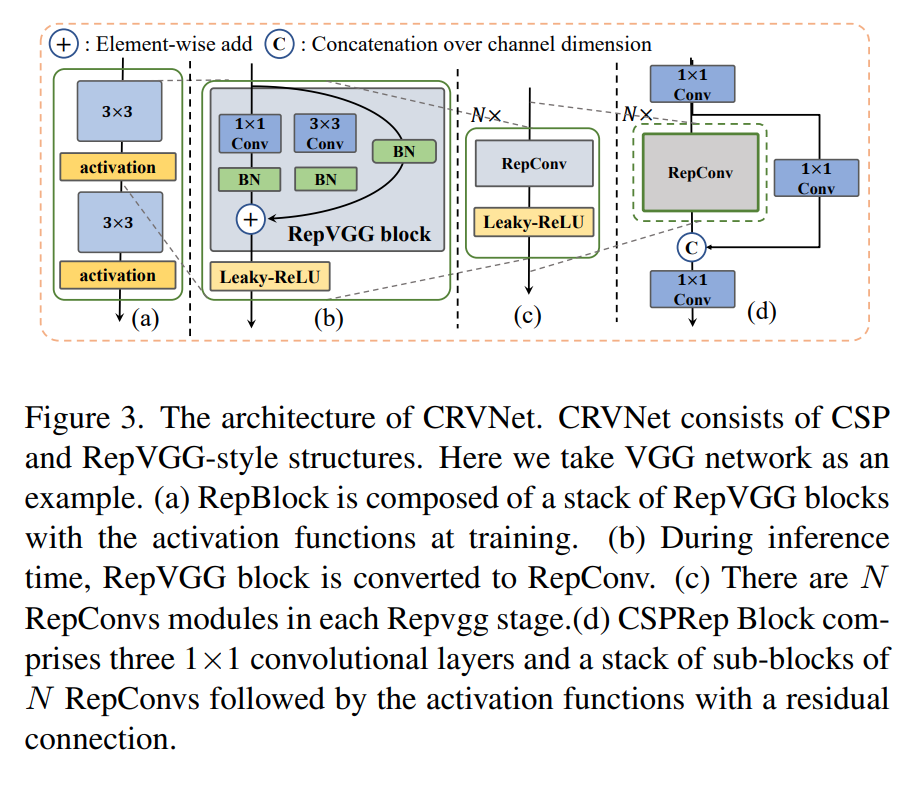

主干网络采用RepVGG+CSPNet的结构。关于RepVGG的理论后续补上。这里主要讲一下CSPNet的优点。

CSPNet可以获取更丰富的梯度流,同时减少计算量。通过分割梯度流,使梯度流通过不同的网络路径传播。通过切换串联和过渡步骤,传播的梯度信息可以具有较大的相关性差异。此外,CSPNet可以大大减少计算量,并提高推理速度和准确性。

在Neck中,论文采用了PillarNet中的增强neck设计。neck将特征与来自主干的8x和16x特征图融合,以实现不同空间语义特征的有效交互。论文发现,在这种neck设计中,级联操作之前的卷积层的数量显著影响最终性能。因此,论文将FastPillers-s中VGG的四个阶段的块数从(4,6,16,1)更改为(6,16,1,1),将FastPillars-m中ResNet-34的四个级别的块数分别从(3,4,6,3)和(6,6,3,2),同时都删除了第一阶段的第一个2x下采样。