ChatGPT,也称为生成式预训练Transformer(GPT),是一种基于Transformer架构的自然语言处理模型。虽然在实际应用中,它主要用于有监督学习任务,但在训练初期,它会经历无监督学习阶段。以下是一个简化的例子,说明了ChatGPT是如何进行无监督学习的:

1. 预训练阶段:首先,在大规模的文本数据集(例如互联网上收集的文本)上进行预训练。这些数据没有标签,因此这个阶段属于无监督学习。GPT使用自回归语言模型,即预测给定上下文中下一个词的概率分布。

2. 为了进行预训练,首先要对数据集进行分词处理。例如,将一段文本切成一个个的单词或子词。

3. 然后,在处理过的文本上应用掩码。例如,文本为 "今天天气很好。",可以将其处理为 "今天天气[掩码]好。"。这里的目标是让模型学会预测掩码处的词。

4. GPT模型会逐步学习上下文信息。它会利用Transformer架构,通过自注意力机制捕捉与预测词相关的词汇。

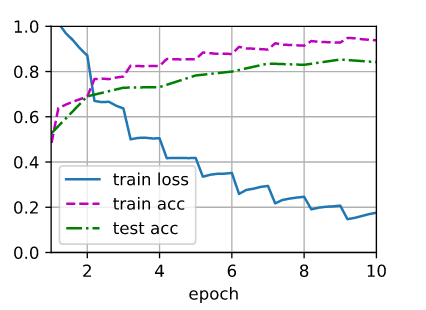

5. 通过无数次迭代和预测,模型会学习到词汇、语法、句子结构等知识。这个过程会不断调整模型的权重,使其能更好地预测文本中的下一个词。

6. 预训练完成后,模型将具备较强的语言生成能力。然后,可以将预训练好的模型用于具体任务,如问答、摘要等,这通常需要通过有监督学习进行微调。

总之,在无监督学习阶段,ChatGPT通过预训练,学习大量无标签文本数据中的语言特征。这为后续有监督学习任务提供了一个强大的基础。