刚刚在敲vit模型代码,突然一个疑问,就是multi-head输出结果进行concat,得到x,x的维度是预期维度,然后再乘以一个WO矩阵,为啥要乘上一个WO矩阵,x的维度已经是预期的了???,其实这里WO就是参数,我们是把提取的特征再乘以一个WO,然后得到的结果输出,然后与GT进行比较,算loss,然后反向梯度更新参数,这里的参数就包含WO,WO的存在就是为了更好的提取x特征,这样x乘以WO输出结果就更接近GT。那如果没有WO,那反向梯度更新啥?只有x,梯度更新不了x,因为x是特征,要更新的是模型的参数,而WO就是模型的参数,WO其实就是一个全连接。

虽然写出来了,但是自己感觉还是有点不是完全理解。只要记住,为了让模型能提取图像特征更准确,提取图像特征靠的就是模型中的参数,只有有了可以更新的参数才可以训练好模型,特征x的维度虽然跟预期一样,但是没用,它只是一个计算结果,更新不了,不更新,下次提取还是跟这次一样,与GT差多少还是多少,没啥效果!

chatgpt解释:

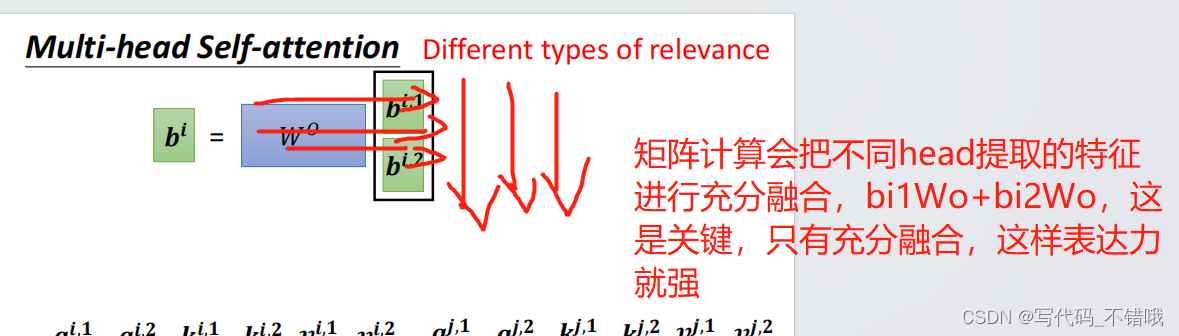

在Transformer的Encoder部分,经过MultiHead Attention 结束后,每个Head计算得到的Attention输出结果会进行拼接操作,通过将各个Head的结果在最后一个维度上进行拼接,得到最终的Attention输出张量。

接着,将拼接后的张量进行线性变换(全连接层),通过将每个位置的特征乘以一个权重矩阵W,并加上一个偏置向量b,最终得到一个新的特征表示。这个线性变换的目的是引入非线性变换和特征融合,以进一步丰富和提取特征表示。

通过拼接和线性变换操作,可以让各个Head提取的不同信息得到充分的整合,并且引入非线性变换来增加模型的表达能力。这样可以提升Transformer模型对输入序列的建模能力和特征提取能力。

总结来说,拼接操作和线性变换的组合能够在保持多头自注意力的并行计算和特征提取优点的同时,增加模型的灵活性和表示能力,更好地捕捉序列中的相关信息和特征。