目录

chatglm+langchain

1.1. 主要功能:

1.2. Langchain中提供的模块

1.3. Langchain应用场景

2.1. chatglm应用:

1.1. 基于单一文档问答的实现原理

chatglm+langchain

GitHub - imClumsyPanda/langchain-ChatGLM: langchain-ChatGLM, local knowledge based ChatGLM with langchain | 基于本地知识库的 ChatGLM 问答

- langchain介绍

Langchain是一个用于开发由语言模型驱动的应用程序的框架

1.1. 主要功能:

- 调用语言模型

- 将不同数据源接入到语言模型的交互中

- 允许语言模型与运行环境交互

1.2. Langchain中提供的模块

- Modules: 支持的模型类型和集成

- Prompt:提示词管理、优化和序列化

- Memory:内存是只在链/代理调用之间持续存在的状态。

- Indexes:当语言模型与特定于应用程序的数据相结合时,会变得更加强大-此模型包含用于加载、查询、更新外部数据的接口和集成。

- Chain:链是结构化的调用序列【对LLM或其他使用程序】

- Agents:代理是一个链,其中LLM在给定高级指令和一组工具的情况下,反复决定操作,执行操作并观察结果,直到高级指令完成。

- Callbacks:回调允许您记录和流式传输任何链的中间步骤,从而轻松观察、调试、评估应用程序的内部

1.3. Langchain应用场景

- 文档问答:常见的Langchain用例。在特定文档上回答问题,仅利用这些文档中的信息来构建答案。

- 个人助理:主要用例之一。个人助理采取行动,记住互动,并了解您的数据

- 查询表格数据:使用语言模型查询表类型结构化数据【csv,SQL,DataFrame】

- 与API交互:使用语言模型与API交互非常强大。它允许他们访问最新信息,并允许他们采取行动

- 信息提取:从文本中提取结构化数据

- 文档总结:压缩较长文档,一种数据增强生成。

- chatglm-6B简介

ChatGLM-6B 是⼀个开源的、⽀持中英双语的对话语⾔模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。

2.1. chatglm应用:

大语言模型通常基于通识知识训练,因此面向以下场景,常常需要借助模型微调或提示词工程提升语言模型应用效果:

- 垂直领域知识

- 基于私有数据的问答

| 是什么 | 能干什么 | |

| 微调 | 针对 预先训练的语言模型,在特定任务的少量数据集上对其进一步训练 | 当任务或域定义明确,并且有足够的标记数据可供训练时,通常使用微调过程 |

| 提示词工程 | 涉及设计自然语言提示或指令,可以指导语言模型执行特定任务 | 最适合需要高精度和明确输出的任务。提示工程可用于制作引发所需输出的查询 |

- 如何实现基于本地知识的问答

知识库中有:QA对{'Langchain能够接入哪些数据类型啊?':'Langchain能够加载文本、PPT、图片、HTML、pdf等非结构化文件并转换为文本信息。'}

案例:

user_question:Langchain能够接入哪些数据类型啊?

agent_answer:Langchain能够加载文本、PPT、图片、HTML、pdf等非结构化文件并转换为文本信息。

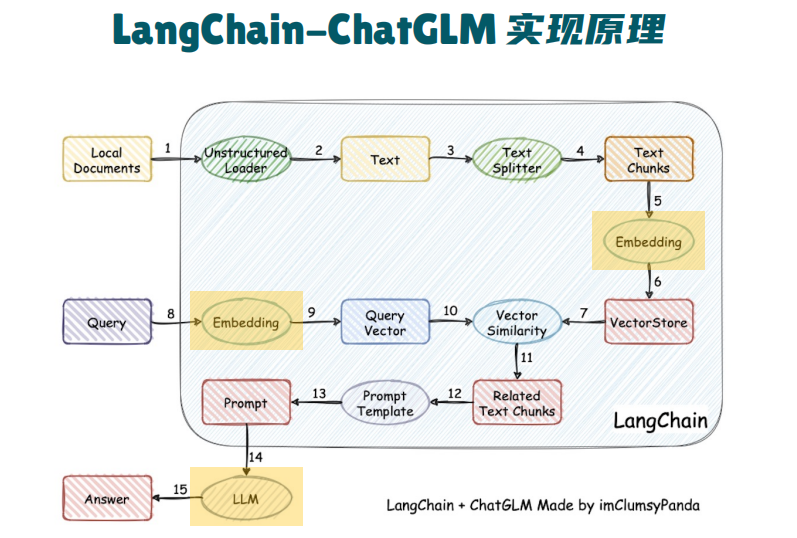

1.1. 基于单一文档问答的实现原理

step1:加载本地文档【读取本地文档,加载为文本】

step2:文本拆分【按照字符如('。','!')、长度或语义拆分】,大语言模型有长度限制

step3:根据提问匹配文体【根据用户提问对文本进行字符匹配或语义检索】

step4:构建Prompt【将匹配文本、用户提问加入Prompt模板】

step5:LLM生成回答【将Prompt发送给LLM获取基于文档内容的回答】