大语言模型微调和PEFT高效微调

news2026/2/13 0:30:16

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/706527.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

深入乳腺癌谜团:无监督学习与R语言的勘探之旅

一、引言 乳腺癌作为全球常见的恶性肿瘤,给患者和医学界带来了巨大的挑战。据世界卫生组织的数据显示,乳腺癌是妇女中最常见的癌症之一,并且是全球癌症相关死亡的主要原因之一[1]。因此,研究乳腺癌,并努力提高其早期检…

【Java】直接return 会触发try-catch 里面的finally的方法么

🐱🚀/背景

try-catch 主要的作用是捕获异常,那么程序没有异常,finally里面代码能否执行? 特别是如果我们前面进行了加锁等操作,没有释放锁,那不是会造成业务逻辑问题,

先说结论:…

Eclipse成立新工作组,华为和谷歌等是初始成员

日前一个供应商中立,并由社区支持的Visual Studio第三方开源市场Open VSX Registry迎来新工作组的成立。根据了解,开发者可以在Open VSX Registry当中的市场中自由上架、下载安装Visual Studio的各种第三方扩展。

随即Eclipse基金会宣告成立了Open VSX工…

前缀迷宫:解密力扣统计包含给定前缀的字符串

本篇博客会讲解力扣“2185. 统计包含给定前缀的字符串”的解题思路,这是题目链接。 本题的思路是:遍历字符串数组,判断遍历到的字符串是否包含给定前缀。

判断的方法是:使用strncmp函数,比较该字符串的前strlen(pref)…

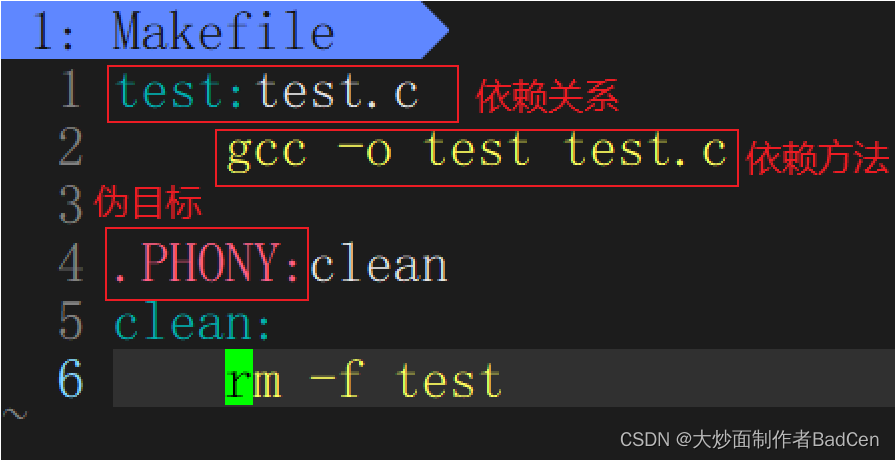

【Linux】工具介绍——vim及gcc

前言

在Linux操作系统之中有很多使用的工具,我们可以用vim来进行程序的编写,然后用gcc来生成可执行文件,最终运行程序。本文来带大家了解vim和gcc,以及自动化构建工具Makefile,这三个工具的使用方法。

一、vim

1.vi…

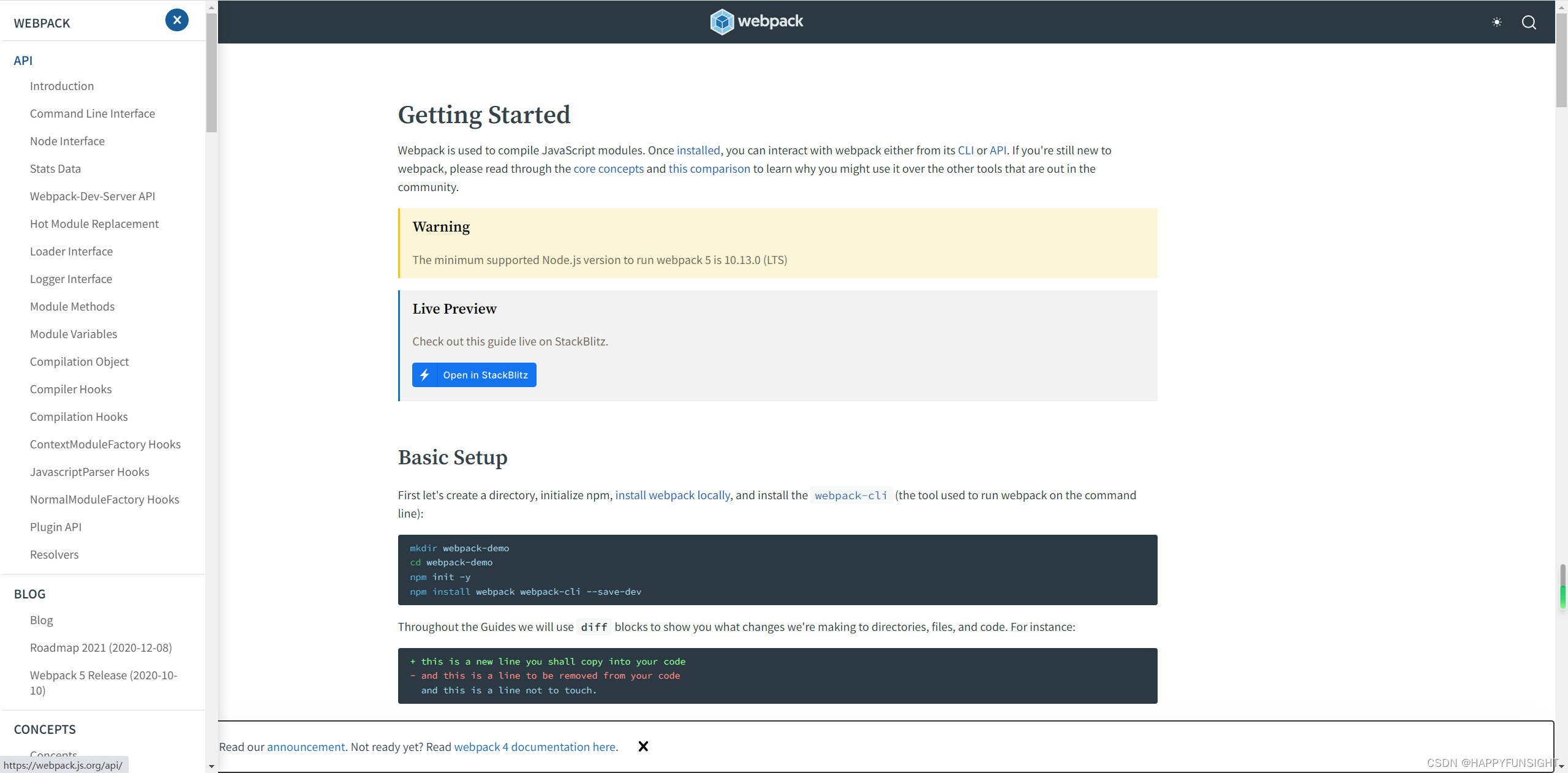

Webpack打包arcgis js api 3.x纯html+JS+CSS项目

需求

小项目。纯HTMLJSCSS已经部署上线,但是没有做混淆加密,需要进行混淆加密

分析

目前代码里面需要混淆加密的有main.js,其他的不用混淆加密。所以只需要对main.js进行混淆加密就可,但是要保证混淆加密之后能够访问方法。由于…

C#中的自定义组件(单一组件和复杂组件)

简单的应用程序开发可能不必要制作组件,C#中丰富的组件足以应对绝大多数的开发设想。 稍微复杂一些的应用开发,或者平台开发,或者团队开发,不可避免地要涉及到基础库的搭建,其中会有很多用户组件的设计与开发。 组件分…

计算机视觉 - 理论 - 从卷积到识别

计算机视觉 - 理论入门 前言一,导论:二,卷积:图像去噪:常值卷积:高斯卷积:椒盐去噪:锐化程度: 三,边缘检测:图像信号导数:求导算子:图…

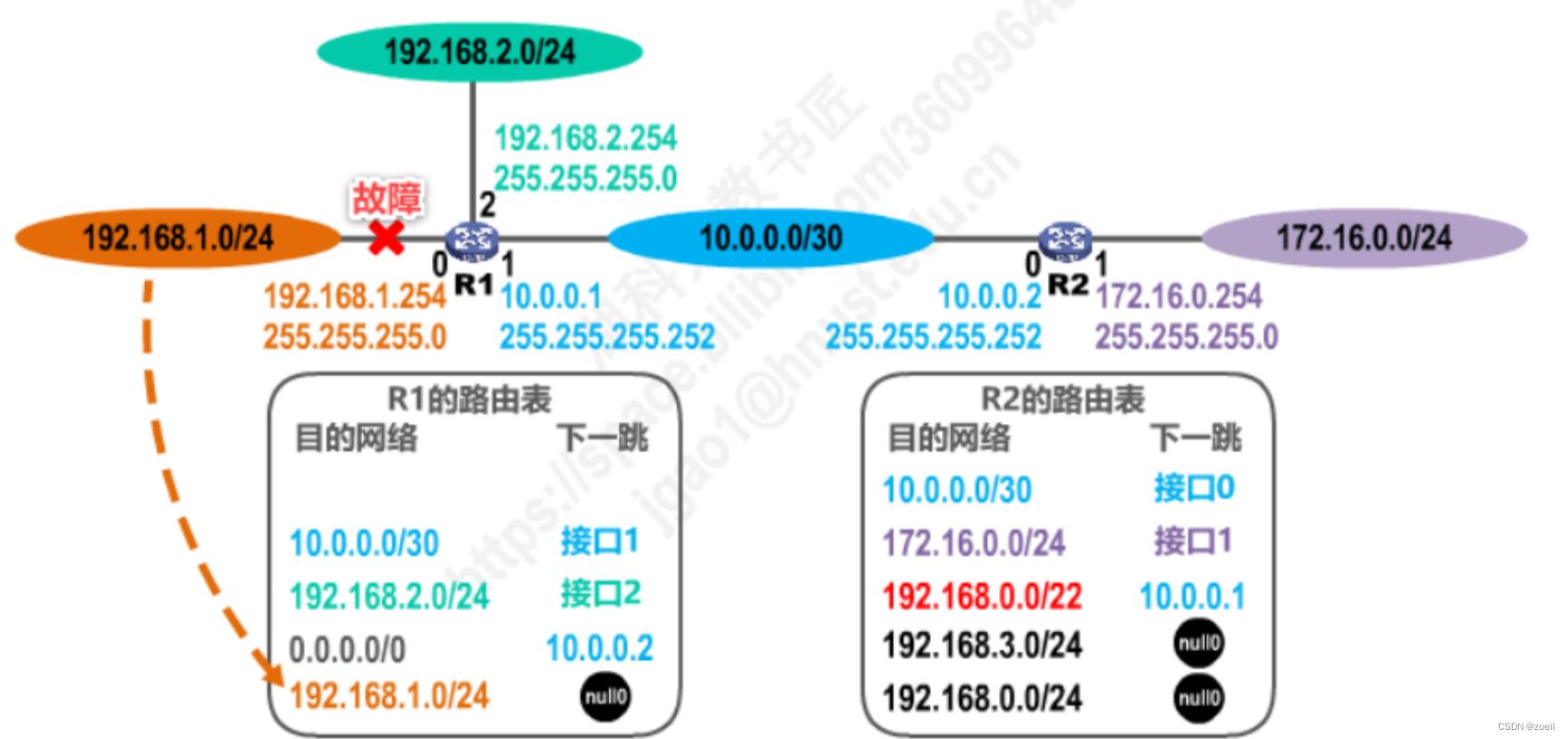

计算机网络-网络层上篇

目录

一、网络层概述

二、网络层提供的两种服务

(一)面向连接的虚电路服务

(二)无连接的数据报服务

(三)虚电路服务与数据报服务的比较

三、IPv4地址及其应用

(一)IPv4地址概…

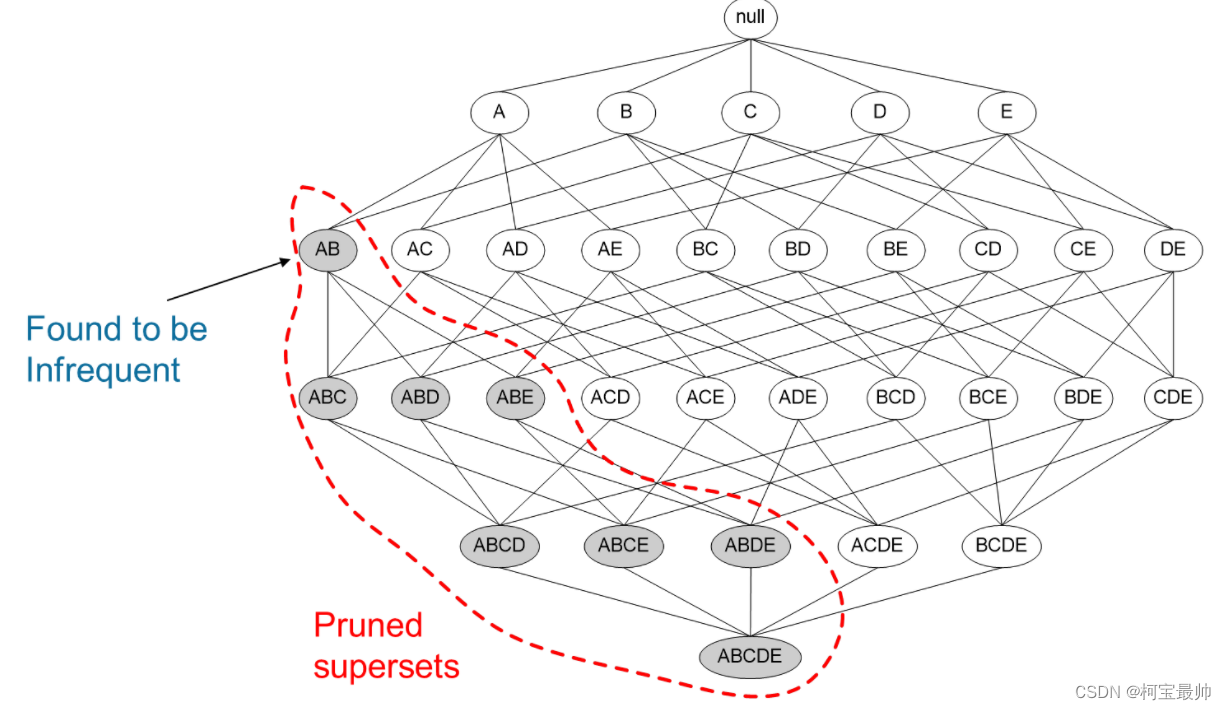

【AI底层逻辑】——篇章4:大数据处理与挖掘

目录

引入

一、大数据概述

二、数据处理的流程&方法

1、数据收集——“从无到有”

2、数据加工——“从有到能用”

3、数据分析

三、大数据改变了什么 往期精彩: 引入

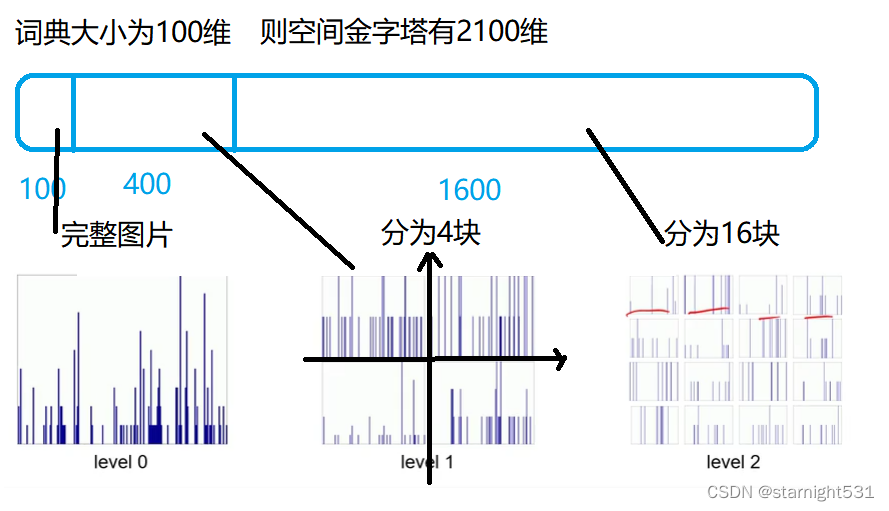

AI的表现依赖大数据。曾经一段时间,对于图像识别的准确率只能达到60%~70…

BUUCTF 还原大师 1

题目描述:

我们得到了一串神秘字符串:TASC?O3RJMV?WDJKX?ZM,问号部分是未知大写字母,为了确定这个神秘字符串,我们通过了其他途径获得了这个字串的32位MD5码。但是我们获得它的32位MD5码也是残缺不全,E903???4D…

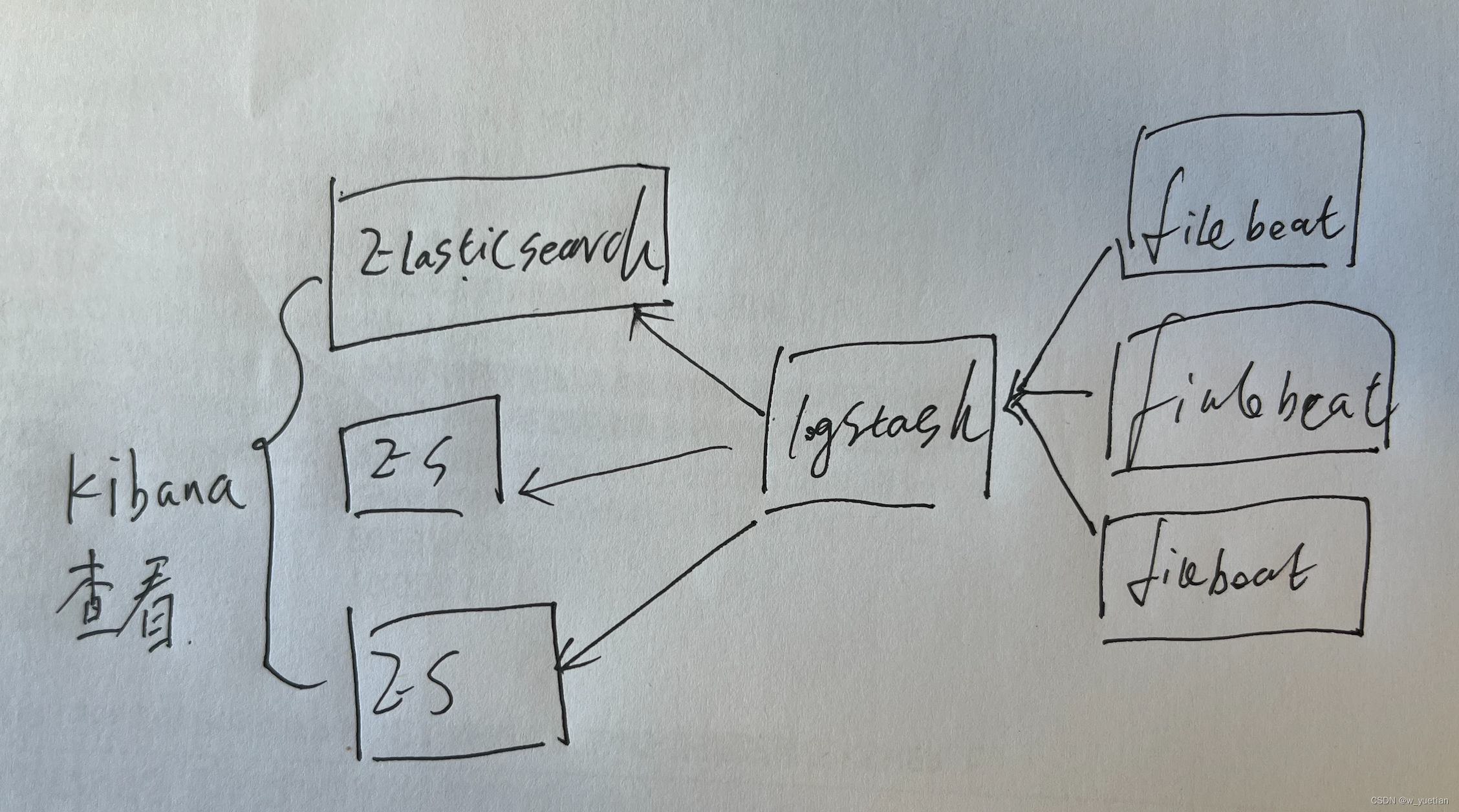

Elasticsearch 集群日志收集搭建

Elasticsearch-7.2.0Logstash-7.2.0Kibana-7.2.0-Filebeat-7.6.0 第一台集群内网ip:10.0.0.223

ES配置文件:/es_data/es/elasticsearch-7.2.0/config/elasticsearch.yml

ES启动命令:/es_data/es/elasticsearch-7.2.0/bin/elasticsearch

cl…

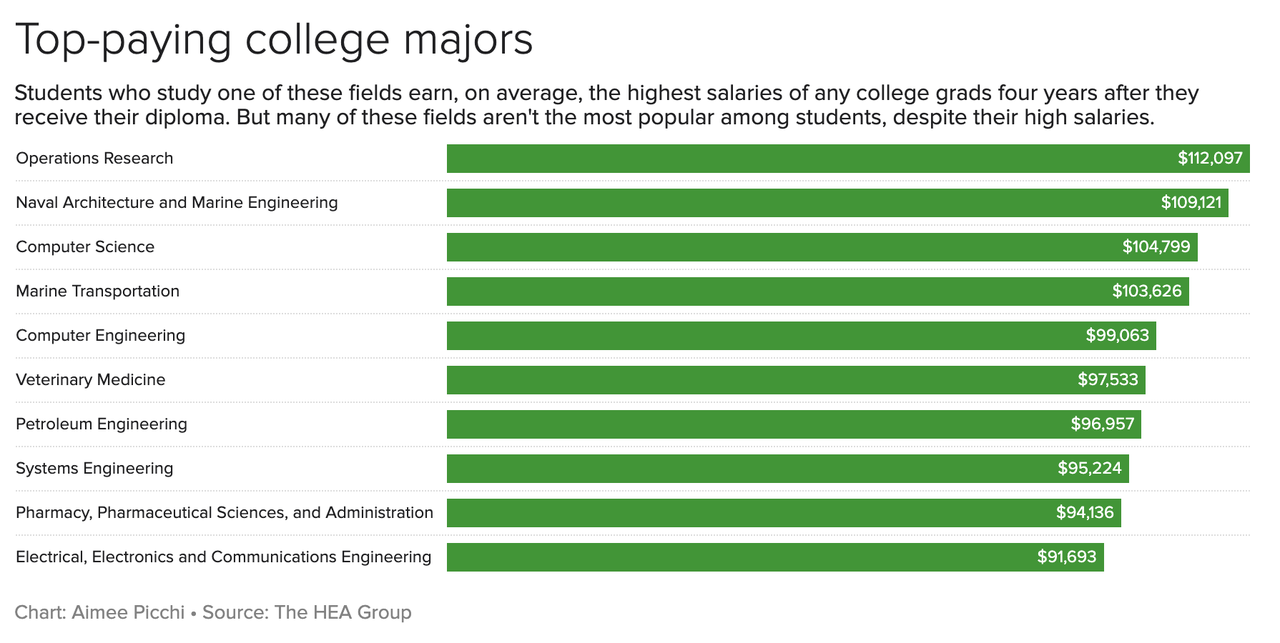

报道|本科专业对收入影响巨大!最高以及最低收入的专业有这些

作者:Aimee Picchi 编者按 本文引用并翻译了发表在美国CBS的最新研究,希望能给刚高考完正在挑选大学以及专业的准大学生们一点帮助哦。 最新的研究发现,一个学生的专业和母校能明显地影响ta毕业四年后的收入水平。HEA Group的调查显示&#x…

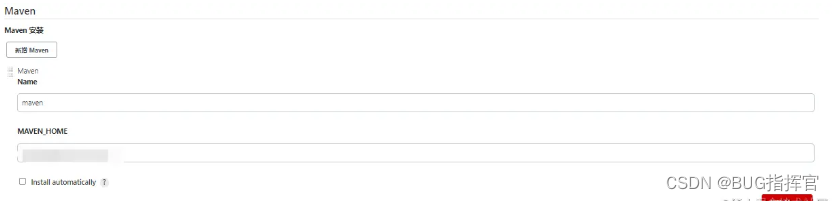

Jenkins + gitlab 自动部署

1. 背景

作为后台开发,每次我们开发完或者修改一个bug后都要手动合并,打包或者连接服务器执行打包部署命令,每次手动操作,极大的影响了我们的开发效率,那么有没有一款工具能让我们只需要推送/合并代码到远端就能实现服…

【小沐学Python】Python实现Web服务器(Flask框架扩展:Flask-SQLAlchemy)

文章目录 1、简介2、安装3、开发3.1 数据库连接字符串3.2 SQLAlchemy参数设置3.3 SQLAlchemy字段类型3.4 SQLAlchemy列选项3.5 SQLAlchemy关系选项3.6 SQLAlchemy操作接口 4、代码测试4.1 用户管理4.2 用户角色管理4.3 学生管理4.4 图书管理 结语 1、简介

SQLAlchemy SQLALche…

windows下安装Visual Studio + CMake+OpenCV + OpenCV contrib+TensorRT

目录

1 安装visual studio

2 安装CMake

3 OpenCV源码安装

3.1 OpenCV源码下载

3.2 OpenCV contrib源码下载

3.3 安装OpenCV

3.4 安装OpenCV-crontrib

3.5 VS生成代码

4 环境配置

5 TensorRT安装

5.1 TensorRT安装

5.2 Python下安装TensorRT库 最近在研究windows系统…

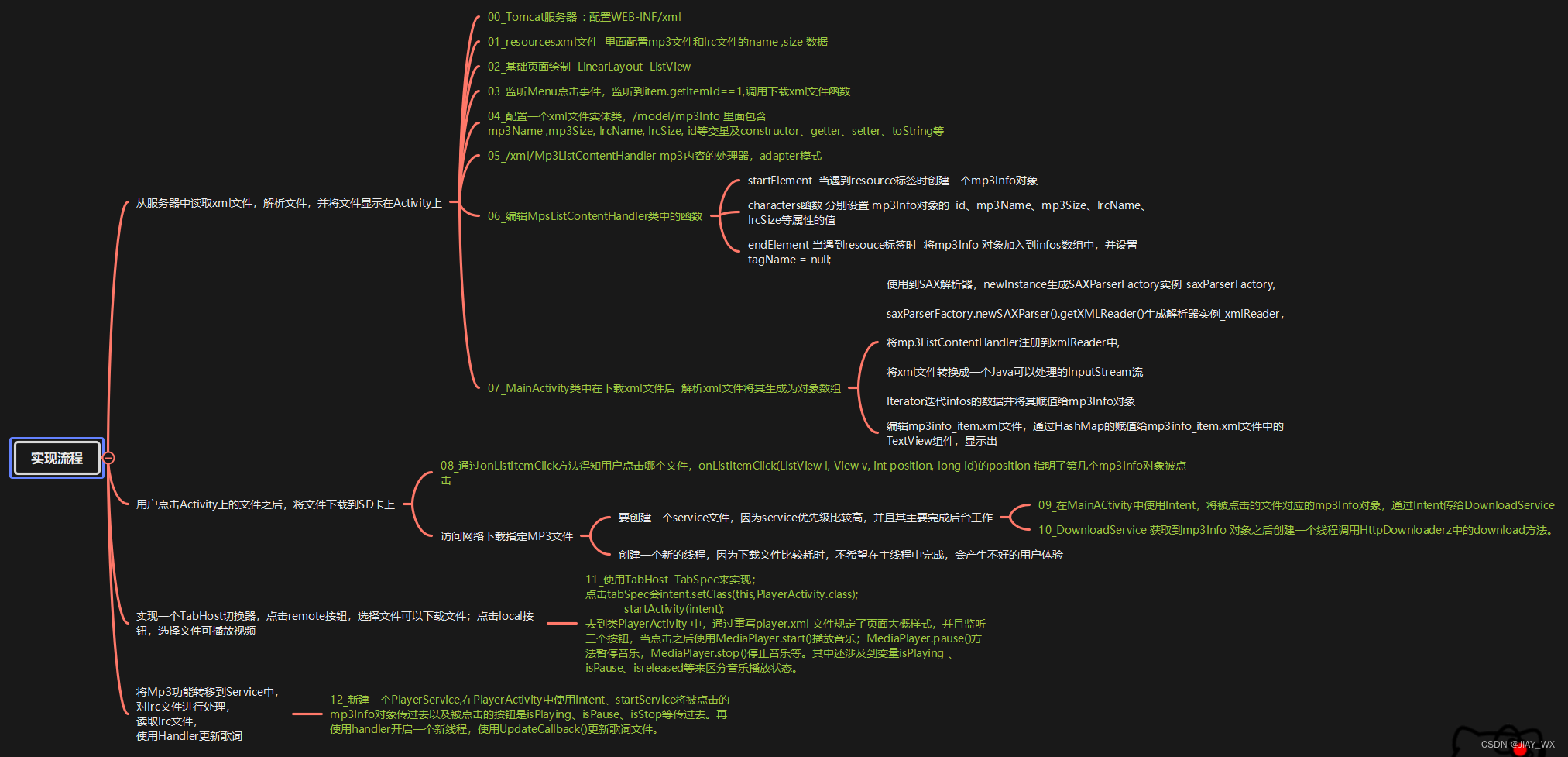

Android学习_Mars老师之Mp3视频开发

实现的功能:开发一个可以播放音乐并同步显示歌词文件的APP.

成果展示: 总体设计图: 实现流程图 代码展示:

AndroidManifest.xml

<?xml version"1.0" encoding"utf-8"?>

<manifest xmlns:androi…

信道编码:MATLAB使用卷积编译码函数

信道编码:MATLAB 使用Conv函数

1. 相关函数

在进行卷积编码的过程中,使用的函数是convenc()函数和vitdec()函数,同时需要poly2trellis()函数。

1.1 poly2trellis()函数

先看poly2trellis()函数,用来生成卷积编码所需要的网表。

trellis …