文章目录

- 前言

- 多线程与多进程

- 多线程

- 多进程

- 多线程和多进程的选择

- 使用Scrapy框架实现分布式爬虫

- 1. 创建Scrapy项目

- 2. 配置Scrapy-Redis

- 3. 创建爬虫

- 4. 启动爬虫节点

- 5. 添加任务到队列

- 并发控制与限制请求频率

- 并发控制

- 限制请求频率

- 未完待续...

前言

在进行爬虫任务时,我们常常会面临两个重要问题:如何提高爬取效率以及如何合理控制请求的并发量,以避免对目标网站造成过大的压力。针对这些问题,本文将介绍分布式爬虫与并发控制的相关知识点,并演示使用Scrapy框架实现分布式爬虫,并对并发控制进行限制请求频率。

多线程与多进程

当涉及到并发处理时,多线程和多进程是两种常用的技术。它们可以同时执行多个任务,提高程序的效率和性能。下面我将详细讲解多线程和多进程的概念、特点以及使用方法。

多线程

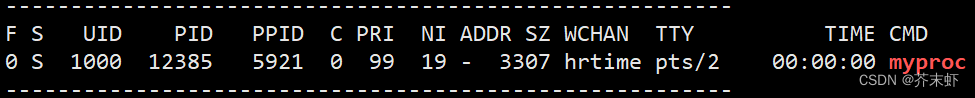

多线程是指在一个进程内创建多个线程来执行任务。线程是程序执行中的最小单元,多个线程共享同一个进程的资源。多线程有以下几个特点:

- 资源共享:多个线程可以共享同一个进程的地址空间、文件描述符等资源,因此可以方便地进行数据交换和通信。

- 轻量级:相对于多进程而言,多线程的创建和切换成本更低,占用的系统资源更少。

- 异步编程:多线程可以实现异步操作,使得程序可以同时执行多个任务,提高程序的响应速度。

在Python中,可以使用标准库中的threading模块实现多线程编程。具体步骤如下:

- 导入

threading模块:import threading - 定义线程函数:编写需要在每个线程中执行的任务。

- 创建线程对象:使用

threading.Thread(target=函数名)创建线程对象,并设置线程的目标函数。 - 启动线程:使用

start()方法启动线程,开始执行线程中的任务。 - 等待线程结束:使用

join()方法等待线程执行完毕。

示例代码:

import threading

def task():

# 线程执行的任务

print("Thread ID: {} - Hello, World!".format(threading.get_ident()))

# 创建4个线程并启动

for _ in range(4):

thread = threading.Thread(target=task) # 创建线程对象,设置目标函数为task

thread.start() # 启动线程

thread.join() # 等待线程结束

代码使用threading模块创建了4个线程,并在每个线程中执行task()函数。每个线程将打印出当前线程的ID,然后输出"Hello, World!"。通过循环创建和启动线程,并使用join()方法等待线程结束,确保每个线程都执行完毕。

多进程

多进程是指在操作系统中同时运行多个进程,每个进程独立执行任务。不同进程之间有自己独立的内存空间和资源环境,彼此之间不会相互影响。多进程有以下几个特点:

- 数据隔离:每个进程拥有独立的地址空间和资源环境,数据之间相互隔离,保证了程序的安全性。

- 并发处理:多个进程可以同时执行不同的任务,提高程序的并发处理能力。

- 稳定性:由于进程之间相互独立,一个进程崩溃不会影响其他进程,提高了程序的稳定性。

在Python中,可以使用标准库中的multiprocessing模块实现多进程编程。具体步骤如下:

- 导入

multiprocessing模块:import multiprocessing - 定义进程函数:编写需要在每个进程中执行的任务。

- 创建进程对象:使用

multiprocessing.Process(target=函数名)创建进程对象,并设置进程的目标函数。 - 启动进程:使用

start()方法启动进程,开始执行进程中的任务。 - 等待进程结束:使用

join()方法等待进程执行完毕。

示例代码:

import multiprocessing

def task():

# 进程执行的任务

print("Process ID: {} - Hello, World!".format(multiprocessing.current_process().pid))

# 创建4个进程并启动

processes = []

for _ in range(4):

process = multiprocessing.Process(target=task) # 创建进程对象,设置目标函数为task

process.start() # 启动进程

processes.append(process)

# 等待所有进程结束

for process in processes:

process.join()

代码使用multiprocessing模块创建了4个进程,并在每个进程中执行task()函数。每个进程将打印出当前进程的ID,然后输出"Hello, World!"。通过循环创建和启动进程,并使用join()方法等待所有进程结束,确保每个进程都执行完毕。

注意,在多进程示例中,我们使用了一个列表来保存所有的进程对象,然后在最后使用循环和join()方法等待所有进程结束。

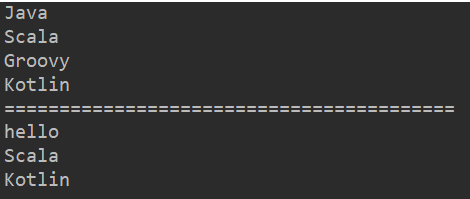

多线程和多进程的选择

在实际开发中,选择多线程还是多进程需要根据具体的需求和情况进行权衡。一般来说:

- 如果任务涉及到I/O密集型操作(如网络请求、文件读写等),多线程通常是一个不错的选择,因为线程之间可以很好地共享资源和交互。

- 如果任务涉及到CPU密集型操作(如复杂的计算、图像处理等),多进程可能更适合,因为每个进程有独立的计算资源,可以充分利用多核处理器。

此外,需要注意的是,多线程和多进程的并发操作涉及到共享资源的访问,可能引发一些并发控制和同步机制的问题,例如线程安全性、锁、信号量等,开发者需要注意处理这些问题,保证程序的正确执行。

使用Scrapy框架实现分布式爬虫

Scrapy是一个强大的Python爬虫框架,提供了分布式爬虫的支持。通过使用Scrapy的分布式架构,我们可以将爬取任务分发到多个节点上,以提高爬取效率。

- 当使用Scrapy框架实现分布式爬虫时,可以利用Scrapy-Redis扩展来实现任务队列的管理和分布式爬取。Scrapy-Redis扩展通过使用Redis作为任务队列实现多个爬虫节点之间的任务调度和数据共享。下

首先安装好Scrapy和Scrapy-Redis扩展。

命令如下:

pip install scrapy scrapy-redis

接下来,创建一个Scrapy项目,并在该项目中进行相应的配置。

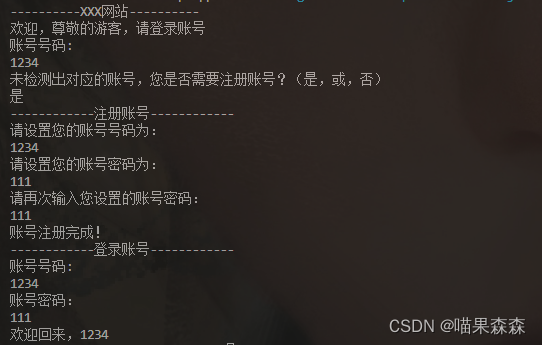

1. 创建Scrapy项目

scrapy startproject myproject

这会生成一个名为

myproject的Scrapy项目。

2. 配置Scrapy-Redis

进入项目目录,打开settings.py文件,添加以下内容:

# 开启Scrapy-Redis扩展

import scrapy_redis

# 将默认的Scheduler替换为Scrapy-Redis提供的Scheduler

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# 使用Redis的去重器

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

# 设置Redis为队列的存储方式

SCHEDULER_QUEUE_CLASS = "scrapy_redis.queue.SpiderPriorityQueue"

# 允许暂停后,恢复之前的爬取进度

SCHEDULER_PERSIST = True

# 在Redis中保留请求队列和去重集合的时间,单位为秒

SCHEDULER_IDLE_BEFORE_CLOSE = 10

# 设置Redis连接参数

REDIS_HOST = 'localhost' # Redis服务器地址

REDIS_PORT = 6379 # Redis端口号

# 启用RedisPipeline将数据存储到Redis中

ITEM_PIPELINES = {

'scrapy_redis.pipelines.RedisPipeline': 300,

}

以上配置启用了Scrapy-Redis扩展并设置了Redis的连接参数,指定了使用Redis作为队列的存储方式,并使用RedisPipeline将数据存储到Redis中。

3. 创建爬虫

进入项目目录,在命令行中运行以下命令创建一个Spider:

cd myproject

scrapy genspider example example.com

这将在spiders目录下生成一个名为example.py的Spider文件。

打开example.py文件,将其内容修改为以下代码:

import scrapy

from scrapy_redis.spiders import RedisSpider

class ExampleSpider(RedisSpider):

name = 'example'

allowed_domains = ['example.com']

def parse(self, response):

self.logger.info('Crawled (%d) %s' % (response.status, response.url))

# 在这里编写你的解析逻辑

# ...

yield {

'url': response.url,

# ...

}

这个Spider继承自RedisSpider,使得它能够与Scrapy-Redis扩展配合工作。在parse函数中,你可以编写你的解析逻辑,解析页面中的数据。

4. 启动爬虫节点

在命令行中运行以下命令启动爬虫节点:

scrapy crawl example

此时,爬虫节点会连接到Redis队列,并开始从队列中获取任务并执行。

5. 添加任务到队列

最后,可以通过将任务添加到Redis队列来分发给爬虫节点。可以使用以下代码将任务添加到队列中:

import redis

import json

# 连接到Redis

redis_client = redis.Redis(host='localhost', port=6379)

# 添加任务到队列

task = {

'url': 'http://www.example.com',

# ...

}

redis_client.lpush('example:start_urls', json.dumps(task))

代码通过Redis的连接客户端redis.Redis连接到Redis服务器,并将任务封装为JSON格式的字符串,然后使用lpush()方法将任务添加到名为example:start_urls的队列中。

通过以上步骤,你就可以实现使用Scrapy框架和Scrapy-Redis扩展来实现分布式爬虫。每个爬虫节点都可以从Redis队列中获取任务,并将结果存储到Redis中,实现数据的共享和分布式爬取。

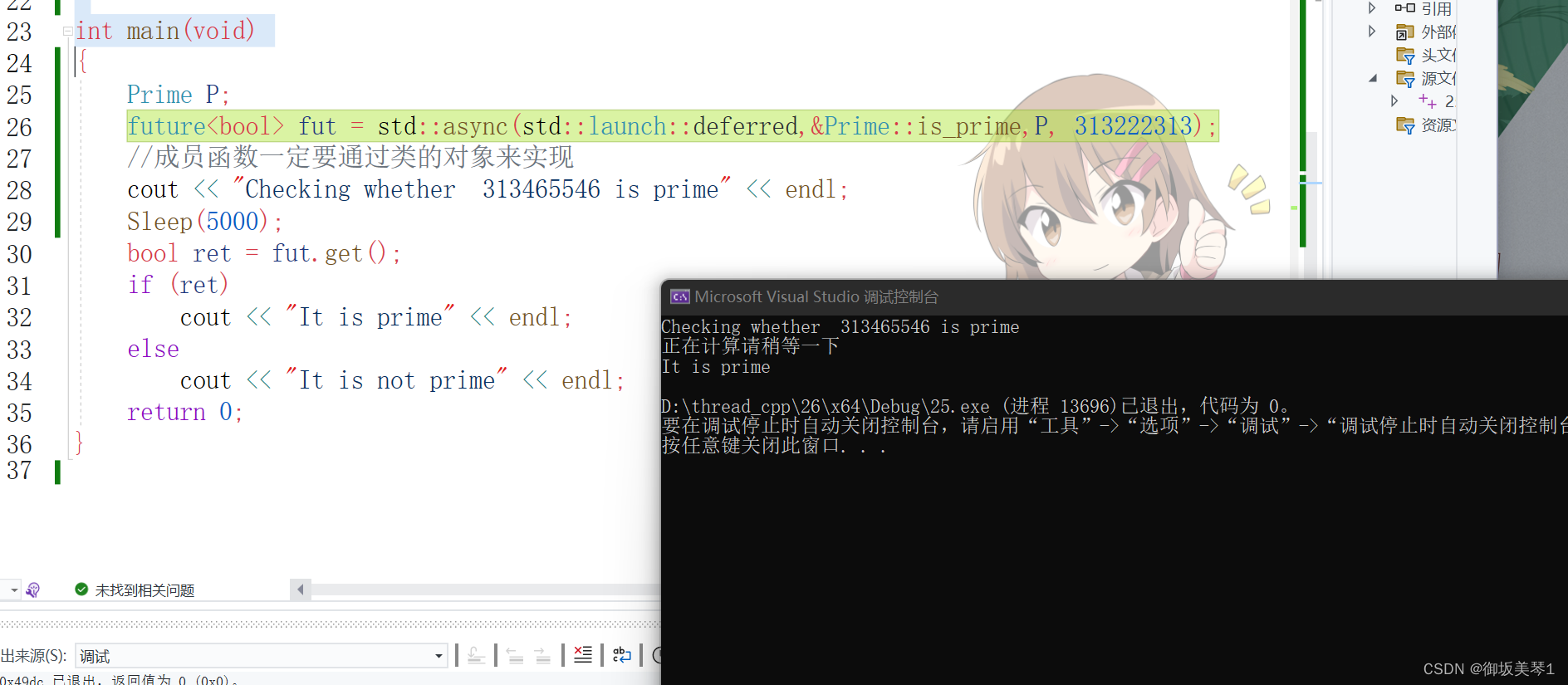

并发控制与限制请求频率

当进行爬虫开发时,为了避免对目标网站造成过大的压力或触发反爬措施,我们通常需要对并发请求数量进行控制,并限制请求频率。

并发控制

并发控制是指控制同时发送给目标网站的请求数量,以避免对其服务器造成过大的负载。Scrapy提供了几种方式来实现并发控制:

-

在

settings.py中设置CONCURRENT_REQUESTS参数来控制同时发送的请求数量。例如,可以将其设置为CONCURRENT_REQUESTS = 16。CONCURRENT_REQUESTS = 16 -

可以使用

CONCURRENT_REQUESTS_PER_DOMAIN参数来限制每个域名同时发送的请求数量。例如,可以将其设置为CONCURRENT_REQUESTS_PER_DOMAIN = 8。CONCURRENT_REQUESTS_PER_DOMAIN = 8 -

还可以使用

CONCURRENT_REQUESTS_PER_IP参数来限制每个IP地址同时发送的请求数量。例如,可以将其设置为CONCURRENT_REQUESTS_PER_IP = 4。CONCURRENT_REQUESTS_PER_IP = 4

注意:在设置并发控制参数时,要根据目标网站的承受能力和自身的网络带宽来合理调整,避免给目标网站和自己带来不必要的困扰。

限制请求频率

限制请求频率是指控制发送请求的时间间隔,以避免短时间内发送过多的请求。Scrapy提供了几种方式来实现请求频率限制:

-

可以在Spider中使用

download_delay属性来设置每个请求之间的时间间隔(单位为秒)。class MySpider(scrapy.Spider): name = 'example' allowed_domains = ['example.com'] start_urls = ['http://www.example.com'] download_delay = 3 # 设置下载延迟为3秒 def parse(self, response): # 解析页面数据 pass -

还可以在Spider中重写

start_requests()方法,在方法中使用time.sleep()方法来控制请求的时间间隔。import time class MySpider(scrapy.Spider): name = 'example' allowed_domains = ['example.com'] start_urls = ['http://www.example.com'] def start_requests(self): for url in self.start_urls: time.sleep(3) # 每个请求之间等待3秒 yield scrapy.Request(url=url, callback=self.parse) def parse(self, response): # 解析页面数据 pass -

可以使用

AUTOTHROTTLE_ENABLED参数启用自动限速扩展。AUTOTHROTTLE_ENABLED = True

以上是实现并发控制和请求频率限制的几种方式

未完待续…