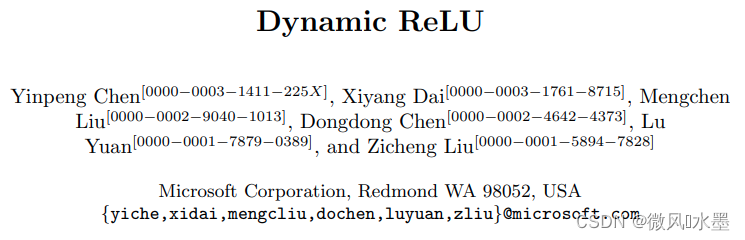

- 论文地址:https://arxiv.org/abs/2003.10027

- 论文代码:https://github.com/Islanna/DynamicReLU

- 三方复现:Dynamic ReLU: 与输入相关的动态激活函数 - 知乎

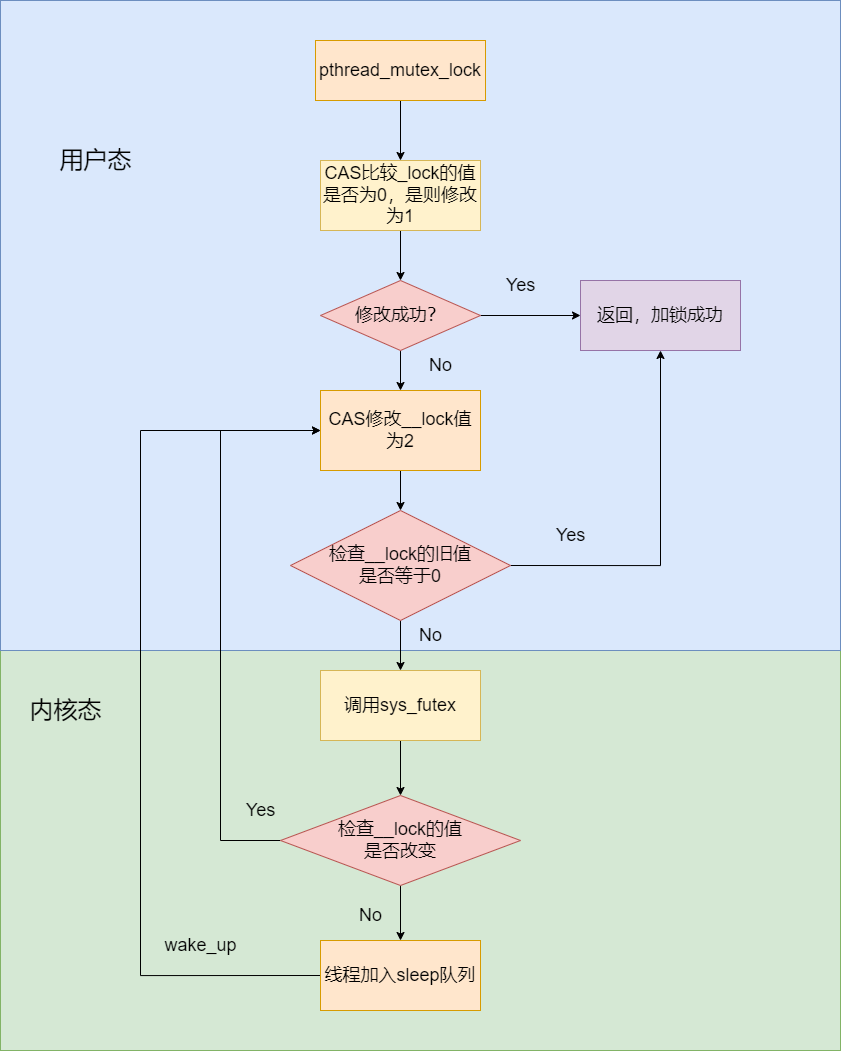

ReLU是深度学习中很重要的里程碑,简单但强大。目前有很多ReLU的改进版,比如Leaky ReLU和 PReLU,而这些改进版和原版的最终参数都是固定的。所以论文自然而然地想到,如果能够根据输入特征来调整ReLU的参数可能会更好。

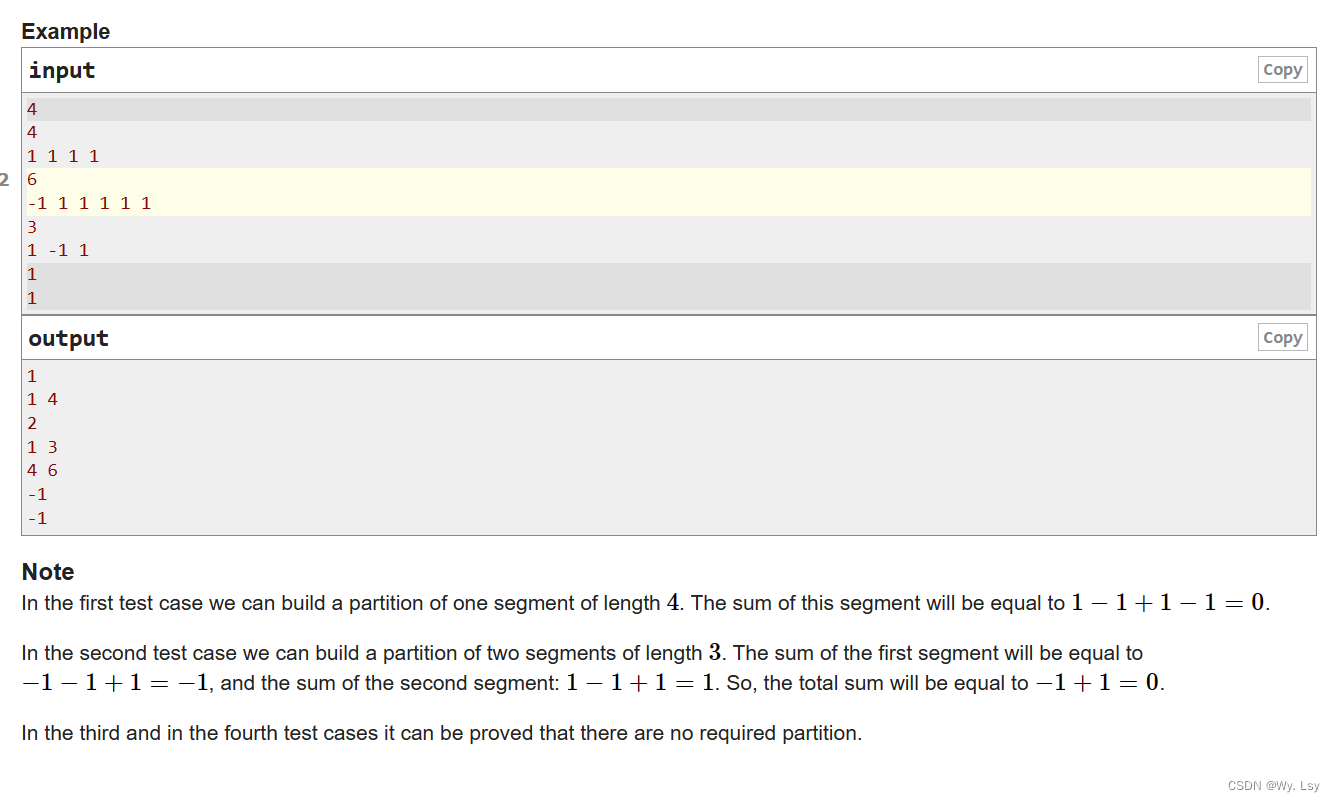

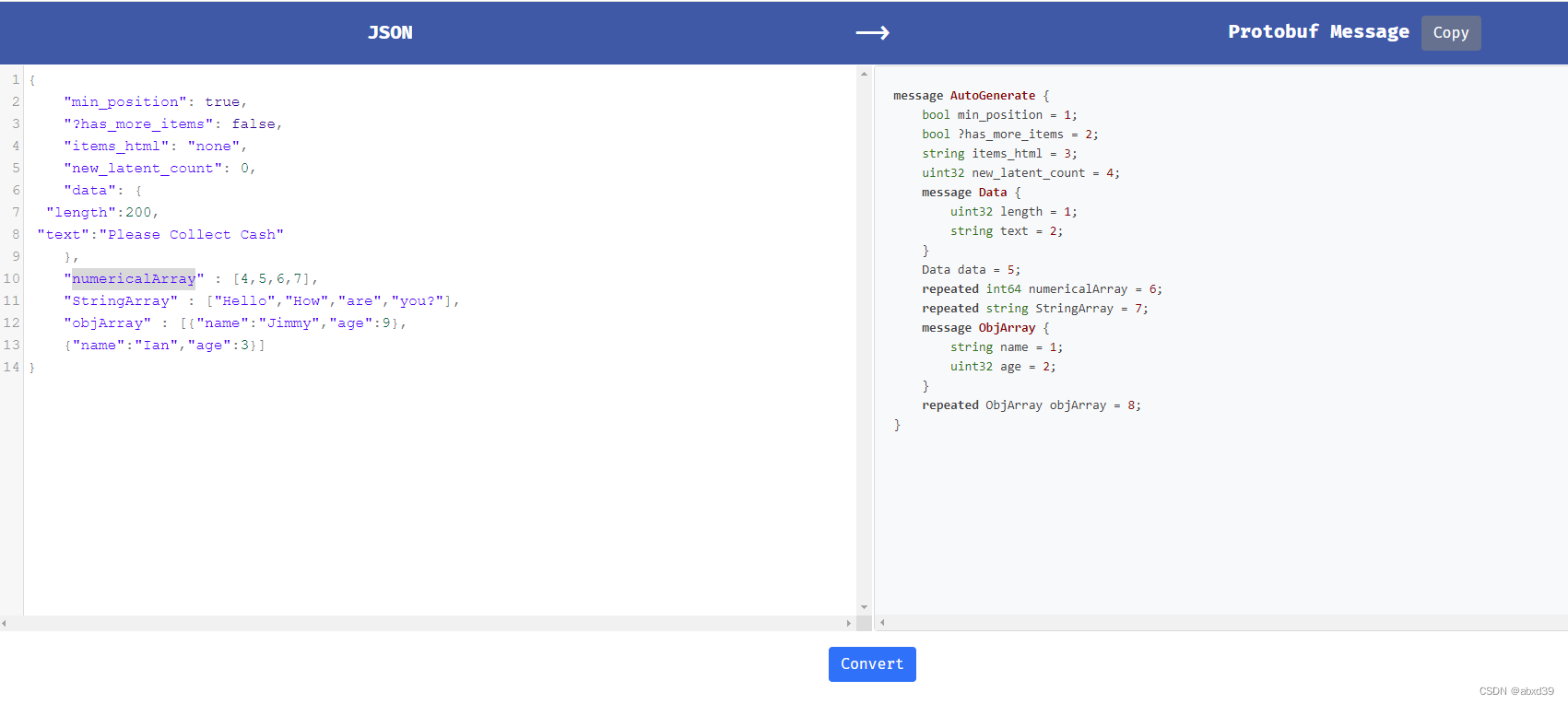

基于上面的想法,论文提出了动态ReLU(DY-ReLU)。如上图所示,DY-ReLU是一个分段函数,参数由超函数根据输入得到。在带来少量额外计算的情况下,显著地提高网络的表达能力。论文提供了三种形态的DY-ReLU,在空间位置和维度上有不同的共享机制。不同形态的DY-ReLU适用于不同的任务。

分类任务:建议使用DY-ReLU-B和DY-ReLU-C

关键点任务:backbone建议使用DY-ReLU-B和DY-ReLU-C,head建议使用DY-ReLU-C

实验结果:

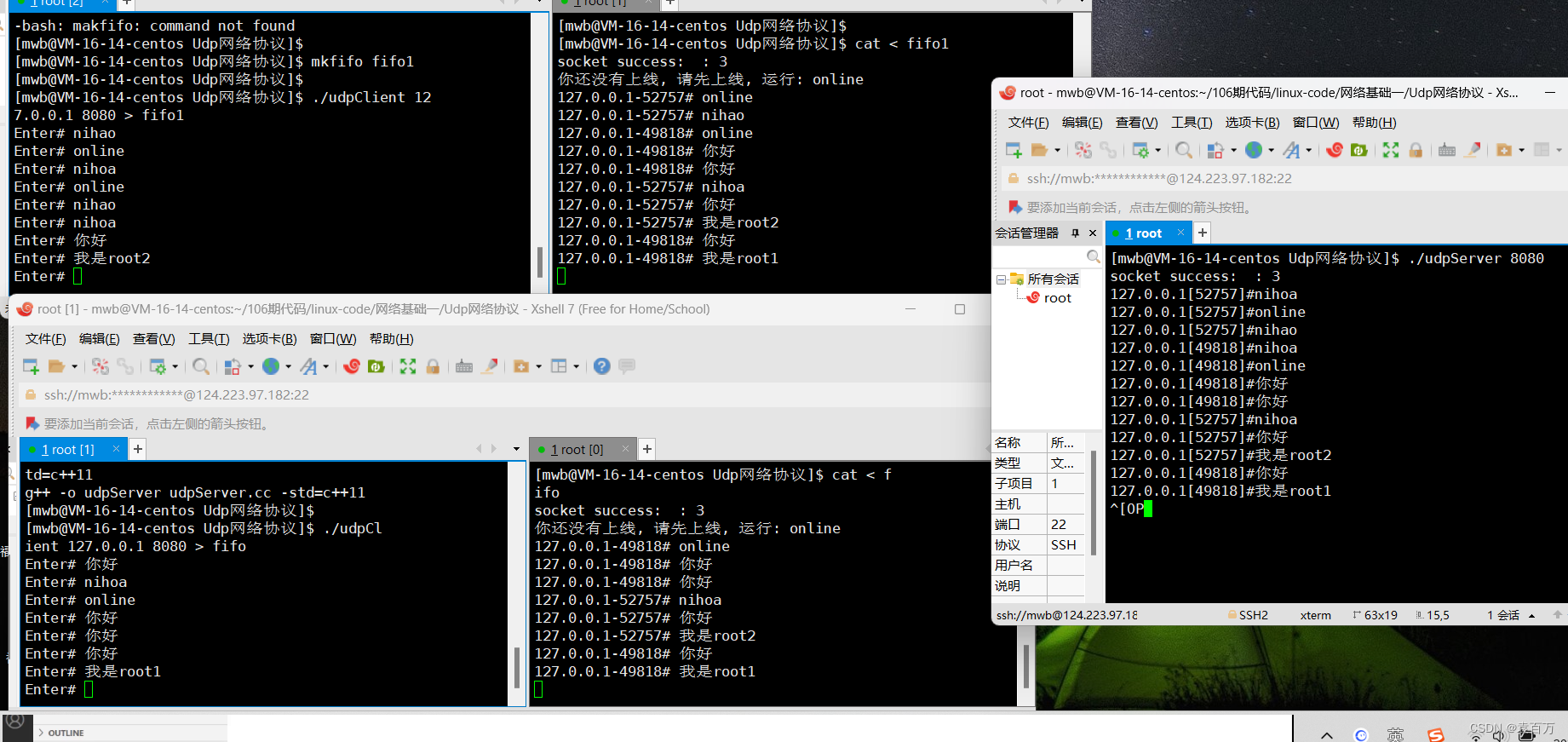

图像分类:前后顺序实验:放在backbone提升更明显

下面的实验:个人觉得DY-RELU更适合轻量小网络

优点:提升精度

缺点:速度变慢

参考:

1:Dynamic ReLU:微软推出提点神器,可能是最好的ReLU改进 | ECCV 2020 - 知乎