一、背景

当在对redis进行刷数操作时,大部分的redis框架对于单次执行的效率差不多,但我们有时需要一次性写入大量的redis key时,一次一次的操作速度就很慢。尤其是处于跨region的环境,一次的redis io就高达数十毫秒, 速度很慢,跑数千万的缓存时会面临执行一天的情形。

在这种场景下,redis的pipline模式能够极大的提高刷数效率, 有时需要一天完成的redis刷数任务, 在一次性执行2W条redis命令时可以达到极快的速度。

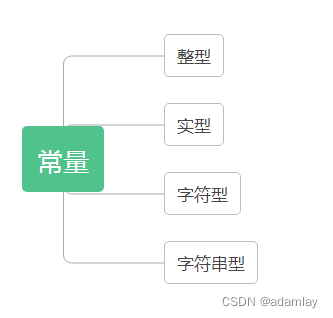

二、Pipline在各个SDK的支持情况

不涉及原理, 简单的对各个包对pipline的支持情况:

| SDK名称 | 可使说明 |

|---|

| Jedis | 支持单节点redis或master-slave部署的redis管道, 不支持redis-cluster |

| Jedis-Cluster | 不支持redis-cluster的管道, 需要自己封装,github上有别人封装好的: GitHub - youaremoon/jedis-ext: 扩展jedis功能,目前实现了redis集群在特定场景下的管道操作:JedisClusterPipeline |

Lettuce | 支持,暂时未在业务中使用pipline |

| Redisson | 支持,有在业务中使用,经过验证很稳定,以下拿redisson demo 示例 |

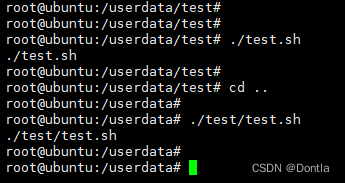

三、Api使用

初始化RedissonClient (简略描述)

| public class RedissonHolder {

private static RedissonClient redissonClient;

public static void init(EnvironmentEnum env) throws IOException {

Config config = Config.fromYAML(RedissonHolder.class.getClassLoader().getResourceAsStream("redisson/redisson-" + env.getEnv() + ".yml"));

config.setCodec(new org.redisson.client.codec.StringCodec());

redissonClient = Redisson.create(config);

}

public static RedissonClient getInstance() {

return redissonClient;

}

}

|

创建Redisson Batch,以Scala Spark任务说明,Scala中可以调用Java对象

| def writeBatchToRedis(redissonClient: RedissonClient, dataList: ListBuffer[(String, util.HashMap[String, String])]): Unit = {

// 创建Redission Batch

val batch = redissonClient.createBatch(BatchOptions.defaults())

for (data <- dataList) {

// 创建异步的Redis Hash

val map = batch.getMap[String, String](data._1)

// 先清除老Key

map.deleteAsync() // delete if already exists

// 将HashMap加入到redis异步hash

map.putAllAsync(data._2)

}

// 提交命令: 同步阻塞

batch.execute()

// // batch.executeAsync() // 提交命令,异步非阻塞

}

|

使用完关闭redisson

| finally {

redissonClient.shutdown()

}

|

四、结论验证

在刷1000万Redis Hash的Spark Job中, 通过使用Redisson Batch方式, 一次执行2万个hash的情况下,跑完1000万Redis Hash在本地启动的模式下,只用了10分钟就执行完毕,平均1次Batch(2万个Hash)用时1.2s。

![[JVM]再聊 CMS 收集器](https://img-blog.csdnimg.cn/a4fe8c81a83745e8bf7d9c1cf60639d9.png)