序:

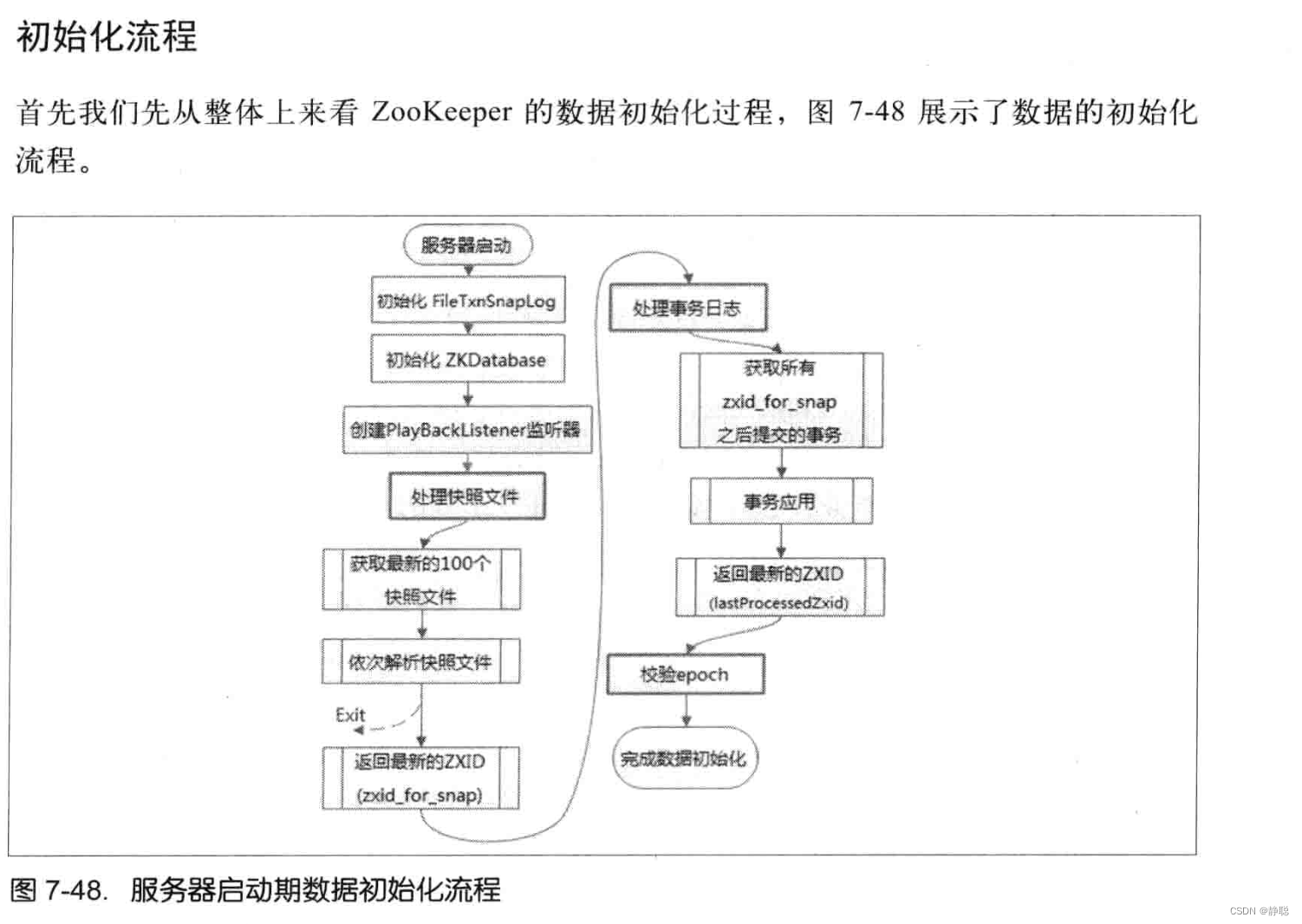

Zookeeper最早起源于雅虎研究院的一个研究小组, 在当时, 研究人员发现,在雅虎内部有很大大型的系统都是需要一个依赖一个类似的系统来进行分布式协调,但是在系统往往都存在分布式单点问题,所以雅虎的开发人员就试图开发一个通用的无单点问题的分布式协调框架 , 以便让开发人员将精力集中在处理业务问题上。

关于Zookeeper这个项目的名字,其实也是一段趣闻,在立项之初, 考虑到之前内部很多的项目都在使用动物的名字来命名的(例如著名的Pig项目),雅虎的工程师希望给这个项目也取一个动物的名字,时任研究院的首席科学家Raghu Ramakrishnan开玩笑的说,在这样下去,我们这儿就变成了动物园了, 此话一出, 大家纷纷表示就动物园管理员吧, 因为各种以动物命名的分布式组件放在一起,雅虎的整个分布式系统看上去就像一个大型的动物园了,而Zookeeper正好要用来进行分布式环境的协调,于是ZooKeeper 的名字就由此诞生了。

随着分布式架构的出现,越来越多的分布式应用会面临数据一致性问题,很遗憾的是, 在解决分布式数据一致性上,除了Zookeeper之外,目前还没有一个稳定且被大规模应用的解决方案, Zookeeper无论是从性能,易用性,还是稳定性上来说,都已经达到了一个工业级的标准 , 其次,Zookeeper是开放的源码,所有的人都在关注它的发展 , 都有权利贡献自己的力量, 你可以和全世界成千上万Zookeeper开发者交流使用经验, 共同解决问题,另外,Zookeeper是免费的, 你无须为它支付任何费用,这一点对于小型公司来说, 尤其是初创团队来说, 无疑是非常重要的,。

最后, ZooKeeper 已经得到了广泛的应用,诸如Hadoop , HBase ,Storm 和Solr 等,越多的大型分布式项目都已经将Zookeeper 作为其核心组件,用于分布式协调 。 这也是我为什么研究Zookeeper 源码的原因 。

Zookeeper的启动与关闭脚本

在读取Zookeeper启动也关闭脚本之前,先来了解Zookeeper 的启动脚本 ,在查看启动脚本之前,先来看看脚本中的一些常用的命令。

- -a : 如果 file 存在则为真。

- -b : 如果 file 存在且是一个块特殊文件则为真。

- -c : 如果 file 存在且是一个字特殊文件则为真。

- -d : filename 如果filename为目录,则为真

- -e : filename 如果filename存在,则为真

- -f : filename 如果filename为常规文件,则为真

- -g : 如果 file 存在且已经设置了SGID则为真。

- -h : filename 如果文件是软链接,则为真

- -k : 如果 file 存在且已经设置了粘制位则为真。

- -n : “STRING” 的长度为非零

- -p : 如果 file 存在且是一个名字管道(F如果O)则为真。

- -o OPTIONNAME : 如果 shell选项 “OPTIONNAME” 开启则为真。

- -r : filename 如果 filename 可读,则为真

- -s : filename r如果文件长度不为0,则为真

- -t : 如果文件描述符 FD 打开且指向一个终端则为真。

- -u : 如果 file 存在且设置了SUID (set user ID)则为真。

- -w : filename 如果 filename 可写,则为真

- -x : filename 如果 filename 可执行,则为真

- -z : “STRING” 的长度为零则为真。

- -L : filename 如果 filename 为符号链接 ,则为真

- -O : 如果 file 存在且属有效用户ID则为真。

- -G : 如果 file 存在且属有效用户组则为真。

- -N : 如果 file 存在 and has been mod如果ied since it was last read则为真。

- -S : 如果 FILE 存在且是一个套接字则为真。

- -eq 等于

- -ne 不等于

- -gt 大于

- -ge 大于等于

- -lt 小于

- -le 小于等于

- [ FILE1 -nt FILE2 ] : filename1 -nt filename2 如果filename1 比filename2 新,则为真

- [ FILE1 -ot FILE2 ] : filename1 -ot filename2 如果filename1 比filename2 旧,则为真

- [ FILE1 -ef FILE2 ]: 如果 FILE1 和 FILE2 指向相同的设备和节点号则为真。

- [ -n STRING ] or [ STRING ] “STRING” 的长度为非零 non-zero则为真。

- [ STRING1 == STRING2 ] 如果2个字符串相同。 “=” may be used instead of “==” for strict POSIX compliance则为真。

- [ STRING1 != STRING2 ] 如果字符串不相等则为真。

- [ STRING1 < STRING2 ] 如果 “STRING1” sorts before “STRING2” lexicographically in the current locale则为真。

- [ STRING1 > STRING2 ] 如果 “STRING1” sorts after “STRING2” lexicographically in the current locale则为真。

- $$ : Shell本身的PID(ProcessID),对于 Shell 脚本,就是这些脚本所在的进程 ID。

- $!:Shell最后运行的后台Process的PID

- $?:最后运行的命令的结束代码(返回值),上个命令的退出状态,或函数的返回值

- $-:使用Set命令设定的Flag一览

- $:所有参数列表。如"$“用「”」括起来的情况、以"$1 $2 … $n"的形式输出所有参数。

- $@:所有参数列表。如"$@“用「”」括起来的情况、以"$1" “ 2 " … " 2" … " 2"…"n” 的形式输出所有参数。传给脚本的所有参数的列表

- $#:是传给脚本的参数个数

- $0:脚本本身的名字

- $0~$n:添加到Shell的各参数值。$1是第1参数、$2是第2参数…。

先来看zkServer.sh 脚本

接下来,我们将一行一行的来分析Zookeeper启动脚本的内容 。

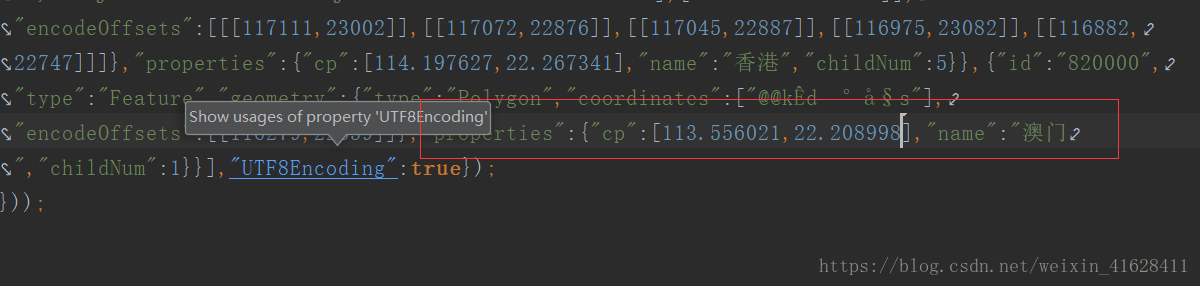

# 获取当前脚本的名字

ZOOBIN="${BASH_SOURCE-$0}"

# dirname命令, 获取目录部分,剥掉文件名 ,因此这里ZOOBIN得到的是zkServer.sh文件所在的目录

ZOOBIN="$(dirname "${ZOOBIN}")"

# zkServer.sh文件的绝对路径,如 /Users/xxx/Documents/software/apache-zookeeper-3.5.8/bin

ZOOBINDIR="$(cd "${ZOOBIN}"; pwd)"

# 判断 /Users/xxx/Documents/software/apache-zookeeper-3.5.8/libexec/zkEnv.sh文件是否存在,如果存在,则执行它

if [ -e "$ZOOBIN/../libexec/zkEnv.sh" ]; then

. "$ZOOBINDIR"/../libexec/zkEnv.sh

else

# 如果 /Users/xxx/Documents/software/apache-zookeeper-3.5.8/libexec/zkEnv.sh文件不存在,则执行/Users/xxx/Documents/software/apache-zookeeper-3.5.8/bin/zkEnv.sh 文件。

. "$ZOOBINDIR"/zkEnv.sh

fi

从上面的分析中得知,如果/Users/xxx/Documents/software/apache-zookeeper-3.5.8/libexec/zkEnv.sh的文件不存在,则执行/Users/xxx/Documents/software/apache-zookeeper-3.5.8/bin/zkEnv.sh ,这里需要注意,我的电脑是mac ,而Zookeeper所放置在/Users/xxx/Documents/software/apache-zookeeper-3.5.8/目录下,接下来看zkEnv.sh 内部又做了哪些事情呢? 进入zkEnv.sh 文件 。

// 得到ZOOBINDIR的目录为 /Users/xxx/Documents/software/apache-zookeeper-3.5.8/bin

ZOOBINDIR="${ZOOBINDIR:-/usr/bin}"

// 而ZOOKEEPER_PREFIX为Users/xxx/Documents/software/apache-zookeeper-3.5.8

ZOOKEEPER_PREFIX="${ZOOBINDIR}/.."

// check to see if the conf dir is given as an optional argument

// 如果启动脚本的参数大于1个

if [ $# -gt 1 ]

then

# 如果第一个参数是--config

if [ "--config" = "$1" ]

then

# 将第一个参数--config移除掉

shift

# 并且将--config 之后的第一个参数赋值给confdir

confdir=$1

shift

// 再将第一个参数移除掉 ,后面的元素顶替掉之前的参数 。

// 假如传入的参数是 --config aaa bbb ccc

// 第一次shift 移除掉--config,第二次shift移除掉aaa , 则此时 ZOOCFGDIR = confdir = aaa

// 剩下的参数了 bbb ccc

ZOOCFGDIR=$confdir

fi

fi

# 如果在启动zkServer.sh时没有指定--config 参数,

# 此时就需要找默认conf的配置文件路径

if [ "x$ZOOCFGDIR" = "x" ]

then

# 如果Users/xxx/Documents/software/apache-zookeeper-3.5.8/conf目录存在,则指定配置文件ZOOCFGDIR 路径

# 为Users/xxx/Documents/software/apache-zookeeper-3.5.8/conf

if [ -e "${ZOOKEEPER_PREFIX}/conf" ]; then

ZOOCFGDIR="$ZOOBINDIR/../conf"

else

# 否则指定配置文件路径为Users/xxx/Documents/software/apache-zookeeper-3.5.8/etc/zookeeper

ZOOCFGDIR="$ZOOBINDIR/../etc/zookeeper"

fi

fi

# 如果ZOOCFGDIR/zookeeper-env.sh存在,则执行它

if [ -f "${ZOOCFGDIR}/zookeeper-env.sh" ]; then

. "${ZOOCFGDIR}/zookeeper-env.sh"

fi

# 如果没有指定zookeeper的配置文件名,则使用默认的文件名为 zoo.cfg

if [ "x$ZOOCFG" = "x" ]

then

ZOOCFG="zoo.cfg"

fi

# 默认情况下 ZOOCFG 为 Users/xxx/Documents/software/apache-zookeeper-3.5.8/conf/zoo.cfg

ZOOCFG="$ZOOCFGDIR/$ZOOCFG"

# 如果ZOOCFGDIR/java.env文件存在,则执行它

if [ -f "$ZOOCFGDIR/java.env" ]

then

. "$ZOOCFGDIR/java.env"

fi

# 如果/Users/xxx/Documents/software/apache-zookeeper-3.5.8/logs不存在,

# 则以/Users/xxx/Documents/software/apache-zookeeper-3.5.8/logs作为日志目录

if [ "x${ZOO_LOG_DIR}" = "x" ]

then

ZOO_LOG_DIR="$ZOOKEEPER_PREFIX/logs"

fi

# 如果没有指定日志级别,则默认为INFO 级别

if [ "x${ZOO_LOG4J_PROP}" = "x" ]

then

ZOO_LOG4J_PROP="INFO,CONSOLE"

fi

# 如果$JAVA_HOME存在,并且$JAVA_HOME/bin/java是一个可执行文件,则JAVA目录为

# $JAVA_HOME/bin/java

if [[ -n "$JAVA_HOME" ]] && [[ -x "$JAVA_HOME/bin/java" ]]; then

JAVA="$JAVA_HOME/bin/java"

# type -p 外部命令名称 , 可以只显示外部命令的绝对路径

# 获取java 命令的路径

elif type -p java; then

JAVA=java

else

# 如果不存在java命令,则抛出异常

echo "Error: JAVA_HOME is not set and java could not be found in PATH." 1>&2

exit 1

fi

CLASSPATH="$ZOOCFGDIR:$CLASSPATH"

# 将 /Users/xxx/Documents/software/apache-zookeeper-3.5.8/zookeeper-server//src/main/resources/lib/下的所有jar 包加入到环境变量中

for i in "$ZOOBINDIR"/../zookeeper-server/src/main/resources/lib/*.jar

do

CLASSPATH="$i:$CLASSPATH"

done

#make it work in the binary package

#(use array for LIBPATH to account for spaces within wildcard expansion)

# 如果/Users/xxx/Documents/software/apache-zookeeper-3.5.8/share/zookeeper/下存在zookeeper-开头的包,则LIBPATH 为

# /Users/xxx/Documents/software/apache-zookeeper-3.5.8/share/zookeeper/ 下所有的包加入到CLASSPATH中

if ls "${ZOOKEEPER_PREFIX}"/share/zookeeper/zookeeper-*.jar > /dev/null 2>&1; then

LIBPATH=("${ZOOKEEPER_PREFIX}"/share/zookeeper/*.jar)

else

#release tarball format

# 将 /Users/xxx/Documents/software/apache-zookeeper-3.5.8 下所有以zookeeper- 开头的包

for i in "$ZOOBINDIR"/../zookeeper-*.jar

do

CLASSPATH="$i:$CLASSPATH"

done

# 并且指定/Users/xxx/Documents/software/apache-zookeeper-3.5.8/lib下所有的jar包为LIBPATH

LIBPATH=("${ZOOBINDIR}"/../lib/*.jar)

fi

# 对LIBPATH进行遍历,并加入到CLASSPATH环境变量中

for i in "${LIBPATH[@]}"

do

CLASSPATH="$i:$CLASSPATH"

done

#make it work for developers

# 如果/Users/xxx/Documents/software/apache-zookeeper-3.5.8/build/lib/ 目录下也存在jar 包,也添加到环境变量中

for d in "$ZOOBINDIR"/../build/lib/*.jar

do

CLASSPATH="$d:$CLASSPATH"

done

# 如果/Users/xxx/Documents/software/apache-zookeeper-3.5.8/zookeeper-server/target/lib 下存在jar包,则也添加到环境变量中

for d in "$ZOOBINDIR"/../zookeeper-server/target/lib/*.jar

do

CLASSPATH="$d:$CLASSPATH"

done

#make it work for developers

# 并且将/Users/xxx/Documents/software/apache-zookeeper-3.5.8/build/classes 添加到环境变量中

CLASSPATH="$ZOOBINDIR/../build/classes:$CLASSPATH"

#make it work for developers

# 将/Users/xxx/Documents/software/apache-zookeeper-3.5.8/zookeeper-server/target/classes 添加到环境变量中

CLASSPATH="$ZOOBINDIR/../zookeeper-server/target/classes:$CLASSPATH"

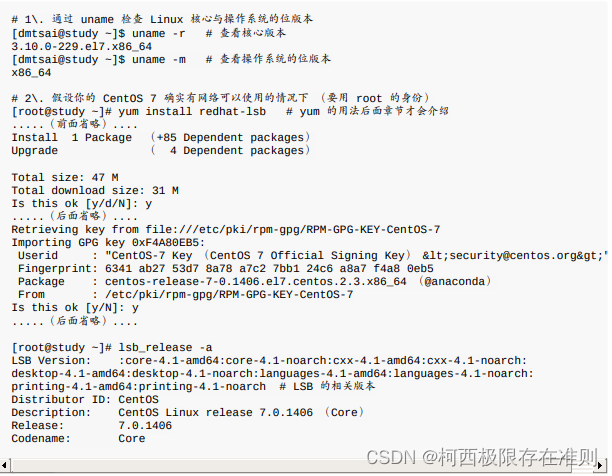

# 获取操作系统及操作系统相关的信息

case "`uname`" in

CYGWIN*|MINGW*) cygwin=true ;;

*) cygwin=false ;;

esac

if $cygwin

then

CLASSPATH=`cygpath -wp "$CLASSPATH"`

fi

#echo "CLASSPATH=$CLASSPATH"

# default heap for zookeeper server

# 指定ZK_SERVER_HEAP ,默认是1000

ZK_SERVER_HEAP="${ZK_SERVER_HEAP:-1000}"

export SERVER_JVMFLAGS="-Xmx${ZK_SERVER_HEAP}m $SERVER_JVMFLAGS"

# default heap for zookeeper client

# 指定ZK_CLIENT_HEAP 默认是256

ZK_CLIENT_HEAP="${ZK_CLIENT_HEAP:-256}"

export CLIENT_JVMFLAGS="-Xmx${ZK_CLIENT_HEAP}m $CLIENT_JVMFLAGS"

细细来看, 发布zkEnv.sh并不难,只是设置了环境变量,指定了配置文件路径,以及日志目录,加载jar包等。接下来继续看zkServer.sh的实现。

if [ "x$JMXLOCALONLY" = "x" ]

then

JMXLOCALONLY=false

fi

if [ "x$JMXDISABLE" = "x" ] || [ "$JMXDISABLE" = 'false' ]

then

echo "ZooKeeper JMX enabled by default" >&2

if [ "x$JMXPORT" = "x" ]

then

# for some reason these two options are necessary on jdk6 on Ubuntu

# accord to the docs they are not necessary, but otw jconsole cannot

# do a local attach

ZOOMAIN="-Dcom.sun.management.jmxremote -Dcom.sun.management.jmxremote.local.only=$JMXLOCALONLY org.apache.zookeeper.server.quorum.QuorumPeerMain"

else

if [ "x$JMXAUTH" = "x" ]

then

JMXAUTH=false

fi

if [ "x$JMXSSL" = "x" ]

then

JMXSSL=false

fi

if [ "x$JMXLOG4J" = "x" ]

then

JMXLOG4J=true

fi

echo "ZooKeeper remote JMX Port set to $JMXPORT" >&2

echo "ZooKeeper remote JMX authenticate set to $JMXAUTH" >&2

echo "ZooKeeper remote JMX ssl set to $JMXSSL" >&2

echo "ZooKeeper remote JMX log4j set to $JMXLOG4J" >&2

ZOOMAIN="-Dcom.sun.management.jmxremote -Dcom.sun.management.jmxremote.port=$JMXPORT -Dcom.sun.management.jmxremote.authenticate=$JMXAUTH -Dcom.sun.management.jmxremote.ssl=$JMXSSL -Dzookeeper.jmx.log4j.disable=$JMXLOG4J org.apache.zookeeper.server.quorum.QuorumPeerMain"

fi

else

echo "JMX disabled by user request" >&2

ZOOMAIN="org.apache.zookeeper.server.quorum.QuorumPeerMain"

fi

if [ "x$SERVER_JVMFLAGS" != "x" ]

then

JVMFLAGS="$SERVER_JVMFLAGS $JVMFLAGS"

fi

# 上面代码写了那么多,主要是对jmx参数的设置,当然,我们也看到了比较重要的一点,

# 关于jmx可以看看https://blog.csdn.net/DH719491759/article/details/116585911这篇博客,

# 最简单的应用,我们可以在控制台打开JConsole,而JConsole能对Zookeeper的类,堆这些进行监控,而JMX默认是开启的

# 就是脚本最终调用了QuorumPeerMain的main方法进行启动

# 如果第二个参数不为空,则ZOOCFG为ZOOCFGDIR和$2的拼接,当然,之前

// 分析过,ZOOCFGDIR的默认路径为/Users/xxx/Documents/software/apache-zookeeper-3.5.8/conf

if [ "x$2" != "x" ]

then

ZOOCFG="$ZOOCFGDIR/$2"

fi

# if we give a more complicated path to the config, don't screw around in $ZOOCFGDIR

# 如果Zookeeper启动时指定了conf文件目录,和默认的配置文件目录/Users/xxx/Documents/software/apache-zookeeper-3.5.8/conf/

# 不是同一个文件,则使用项目启动时指定的文件

if [ "x$(dirname "$ZOOCFG")" != "x$ZOOCFGDIR" ]

then

ZOOCFG="$2"

fi

# win环境系统特殊处理

if $cygwin

then

ZOOCFG=`cygpath -wp "$ZOOCFG"`

# cygwin has a "kill" in the shell itself, gets confused

KILL=/bin/kill

else

KILL=kill

fi

echo "Using config: $ZOOCFG" >&2

# solaris系统特殊grep 命令特殊处理处理

case "$OSTYPE" in

*solaris*)

GREP=/usr/xpg4/bin/grep

;;

*)

GREP=grep

;;

esac

# 从ZOOCFG文件中匹配所有去空格以dataDir开头的行,并且获取dataDir等号后面的内容

ZOO_DATADIR="$($GREP "^[[:space:]]*dataDir" "$ZOOCFG" | sed -e 's/.*=//')"

# 去掉ZOO_DATADIR 字符串的前后空格

ZOO_DATADIR="$(echo -e "${ZOO_DATADIR}" | sed -e 's/^[[:space:]]*//' -e 's/[[:space:]]*$//')"

# 以同样的方式,拿到dataLogDir等号后面的内容

ZOO_DATALOGDIR="$($GREP "^[[:space:]]*dataLogDir" "$ZOOCFG" | sed -e 's/.*=//')"

# iff autocreate is turned off and the datadirs don't exist fail

# immediately as we can't create the PID file, etc..., anyway.

# 如果ZOO_DATADIR_AUTOCREATE_DISABLE字符串长度为非空

if [ -n "$ZOO_DATADIR_AUTOCREATE_DISABLE" ]; then

#

# 如果ZOO_DATADIR_AUTOCREATE_DISABLE字符串存在

// 且ZOO_DATADIR/version-2目录不存在,则打印异常信息, 退出脚本

if [ ! -d "$ZOO_DATADIR/version-2" ]; then

echo "ZooKeeper data directory is missing at $ZOO_DATADIR fix the path or run initialize"

exit 1

fi

# 如果ZOO_DATALOGDIR字符串为空,且$ZOO_DATALOGDIR/version-2目录不存在,则抛出异常,退出脚本

if [ -n "$ZOO_DATALOGDIR" ] && [ ! -d "$ZOO_DATALOGDIR/version-2" ]; then

echo "ZooKeeper txnlog directory is missing at $ZOO_DATALOGDIR fix the path or run initialize"

exit 1

fi

# 如果ZOO_DATADIR_AUTOCREATE_DISABLE字符串为不为空,且指定了ZOO_DATADIR 和 ZOO_DATALOGDIR目录,

# 则设置ZOO_DATADIR_AUTOCREATE 为false

ZOO_DATADIR_AUTOCREATE="-Dzookeeper.datadir.autocreate=false"

fi

# 如果ZOOPIDFILE 字符串长度为0

if [ -z "$ZOOPIDFILE" ]; then

# ZOO_DATADIR 目录不存在

if [ ! -d "$ZOO_DATADIR" ]; then

# 递归创建ZOO_DATADIR目录

mkdir -p "$ZOO_DATADIR"

fi

# 初始化zookeeper_server.pid 的路径

ZOOPIDFILE="$ZOO_DATADIR/zookeeper_server.pid"

else

# ensure it exists, otw stop will fail

# 如果ZOOPIDFILE 路径不为空,则递归创建ZOOPIDFILE文件

mkdir -p "$(dirname "$ZOOPIDFILE")"

fi

# 如果ZOO_LOG_DIR 目录不可写,则递归创建ZOO_LOG_DIR目录

if [ ! -w "$ZOO_LOG_DIR" ] ; then

mkdir -p "$ZOO_LOG_DIR"

fi

# 初始化ZOO_LOG_FILE 和 _ZOO_DAEMON_OUT 文件路径

ZOO_LOG_FILE=zookeeper-$USER-server-$HOSTNAME.log

_ZOO_DAEMON_OUT="$ZOO_LOG_DIR/zookeeper-$USER-server-$HOSTNAME.out"

# 接下来看Zookeeper启动做了哪些事情

case $1 in

start)

# 打印启动信息

echo -n "Starting zookeeper ... "

# 如果ZOOPIDFILE为常规文件

if [ -f "$ZOOPIDFILE" ]; then

# kill -0 pid 不发送任何信号,但是系统会进行错误检查。

# 所以经常用来检查一个进程是否存在,存在则echo $?返回0;不存在返回1

# 如果返回0则进程、服务在运行中;反之是其他值,则进程死了或者服务已停止。

if kill -0 `cat "$ZOOPIDFILE"` > /dev/null 2>&1; then

echo $command already running as process `cat "$ZOOPIDFILE"`.

exit 1

fi

fi

# 调用jar 命令,调用org.apache.zookeeper.server.quorum.QuorumPeerMain的main

# 方法启动Zookeeper, 传递了日志目录 , 指定了$CLASSPATH 以及 $ZOOCFG 路径

nohup "$JAVA" $ZOO_DATADIR_AUTOCREATE "-Dzookeeper.log.dir=${ZOO_LOG_DIR}" \

"-Dzookeeper.log.file=${ZOO_LOG_FILE}" "-Dzookeeper.root.logger=${ZOO_LOG4J_PROP}" \

-XX:+HeapDumpOnOutOfMemoryError -XX:OnOutOfMemoryError='kill -9 %p' \

-cp "$CLASSPATH" $JVMFLAGS $ZOOMAIN "$ZOOCFG" > "$_ZOO_DAEMON_OUT" 2>&1 < /dev/null &

# 如果调用上述命令,并没有报错,返回0 ,则证明启动成功

if [ $? -eq 0 ]

then

# 如果操作系统类型是solaris

case "$OSTYPE" in

*solaris*)

/bin/echo "${!}\\c" > "$ZOOPIDFILE"

;;

*)

# $!很多人解释为后台运行的最后一个进程的id号(我觉得解释为最近一次后台运行的id号更容易理

# 将Zookeeper的进程id 写入到ZOOPIDFILE 文件中

/bin/echo -n $! > "$ZOOPIDFILE"

;;

esac

# 如果启动QuorumPeerMain成功

if [ $? -eq 0 ];

then

sleep 1

# 获取pid

pid=$(cat "${ZOOPIDFILE}")

# 如果ps -p pid 进程id存在,则打印Zookeeper已经启动

if ps -p "${pid}" > /dev/null 2>&1; then

echo STARTED

else

# 否则打印启动失败

echo FAILED TO START

exit 1

fi

else

# 如果执行echo -n $! > "$ZOOPIDFILE" 返回值大于0 ,则表明写PID文件失败

echo FAILED TO WRITE PID

exit 1

fi

else

# 当然,如果java 启动 QuorumPeerMain 类本身就已经失败 ,则SERVER的并没有启动

echo SERVER DID NOT START

exit 1

fi

;;

start-foreground)

ZOO_CMD=(exec "$JAVA")

if [ "${ZOO_NOEXEC}" != "" ]; then

ZOO_CMD=("$JAVA")

fi

"${ZOO_CMD[@]}" $ZOO_DATADIR_AUTOCREATE "-Dzookeeper.log.dir=${ZOO_LOG_DIR}" \

"-Dzookeeper.log.file=${ZOO_LOG_FILE}" "-Dzookeeper.root.logger=${ZOO_LOG4J_PROP}" \

-XX:+HeapDumpOnOutOfMemoryError -XX:OnOutOfMemoryError='kill -9 %p' \

-cp "$CLASSPATH" $JVMFLAGS $ZOOMAIN "$ZOOCFG"

;;

print-cmd)

echo "\"$JAVA\" $ZOO_DATADIR_AUTOCREATE -Dzookeeper.log.dir=\"${ZOO_LOG_DIR}\" \

-Dzookeeper.log.file=\"${ZOO_LOG_FILE}\" -Dzookeeper.root.logger=\"${ZOO_LOG4J_PROP}\" \

-XX:+HeapDumpOnOutOfMemoryError -XX:OnOutOfMemoryError='kill -9 %p' \

-cp \"$CLASSPATH\" $JVMFLAGS $ZOOMAIN \"$ZOOCFG\" > \"$_ZOO_DAEMON_OUT\" 2>&1 < /dev/null"

;;

stop)

echo -n "Stopping zookeeper ... "

# 如果ZOOPIDFILE 不是一个常规文件

if [ ! -f "$ZOOPIDFILE" ]

then

echo "no zookeeper to stop (could not find file $ZOOPIDFILE)"

else

# 直接kill 杀死之前启动时存储在ZOOPIDFILE文件中的pid

$KILL $(cat "$ZOOPIDFILE")

# 删除掉ZOOPIDFILE文件

rm "$ZOOPIDFILE"

sleep 1

# 打印STOPPED消息

echo STOPPED

fi

exit 0

;;

restart)

shift

"$0" stop ${@}

sleep 3

"$0" start ${@}

;;

status)

# -q is necessary on some versions of linux where nc returns too quickly, and no stat result is output

# 获取ZOOCFG中配置的clientPortAddress地址,如果没有,则设置clientPortAddress为localhost

clientPortAddress=`$GREP "^[[:space:]]*clientPortAddress[^[:alpha:]]" "$ZOOCFG" | sed -e 's/.*=//'`

if ! [ $clientPortAddress ]

then

clientPortAddress="localhost"

fi

# 获取ZOOCFG配置文件中clientPort配置的地址

clientPort=`$GREP "^[[:space:]]*clientPort[^[:alpha:]]" "$ZOOCFG" | sed -e 's/.*=//'`

# 如果clientPort非数字,则证明是zookeeper集群

if ! [[ "$clientPort" =~ ^[0-9]+$ ]]

then

# 获取ZOOCFG文件中dataDir配置的内容

dataDir=`$GREP "^[[:space:]]*dataDir" "$ZOOCFG" | sed -e 's/.*=//'`

# 获取dataDir目录下myid文件内容

myid=`cat "$dataDir/myid"`

# 如果myid非数字,打印提示信息,退出脚本

if ! [[ "$myid" =~ ^[0-9]+$ ]] ; then

echo "clientPort not found and myid could not be determined. Terminating."

exit 1

fi

# 如 server.1= 192.168.1.148;2888;3888

# 则获取到clientPortAndAddress 为 3888

clientPortAndAddress=`$GREP "^[[:space:]]*server.$myid=.*;.*" "$ZOOCFG" | sed -e 's/.*=//' | sed -e 's/.*;//'`

if [ ! "$clientPortAndAddress" ] ; then

# 如果clientPortAndAddress不存在,则从$ZOOCFG 中配置的dynamicConfigFile文件中取

echo "Client port not found in static config file. Looking in dynamic config file."

dynamicConfigFile=`$GREP "^[[:space:]]*dynamicConfigFile" "$ZOOCFG" | sed -e 's/.*=//'`

clientPortAndAddress=`$GREP "^[[:space:]]*server.$myid=.*;.*" "$dynamicConfigFile" | sed -e 's/.*=//' | sed -e 's/.*;//'`

fi

# 如果clientPortAndAddress为空,则打印异常信息,并退出脚本

if [ ! "$clientPortAndAddress" ] ; then

echo "Client port not found. Terminating."

exit 1

fi

if [[ "$clientPortAndAddress" =~ ^.*:[0-9]+ ]] ; then

# 如果clientPortAndAddress为192.168.1.148:2888:3888

# 则 echo "192.168.1.148:2888:3888" | sed -e 's/:.*//' 为

# 192.168.1.148

clientPortAddress=`echo "$clientPortAndAddress" | sed -e 's/:.*//'`

fi

# 如果clientPortAndAddress为 192.168.1.148:2888:3888,则

# clientPort 为3888

clientPort=`echo "$clientPortAndAddress" | sed -e 's/.*://'`

# 如果clientPort 为空,则打印异常信息并且退出

if [ ! "$clientPort" ] ; then

echo "Client port not found. Terminating."

exit 1

fi

fi

# 最终调用FourLetterWordMain类的main方法获取到Zookeeper 的状态信息

echo "Client port found: $clientPort. Client address: $clientPortAddress."

STAT=`"$JAVA" "-Dzookeeper.log.dir=${ZOO_LOG_DIR}" "-Dzookeeper.root.logger=${ZOO_LOG4J_PROP}" "-Dzookeeper.log.file=${ZOO_LOG_FILE}" \

-cp "$CLASSPATH" $JVMFLAGS org.apache.zookeeper.client.FourLetterWordMain \

$clientPortAddress $clientPort srvr 2> /dev/null \

| $GREP Mode`

if [ "x$STAT" = "x" ]

then

echo "Error contacting service. It is probably not running."

exit 1

else

echo $STAT

exit 0

fi

;;

*)

echo "Usage: $0 [--config ] {start|start-foreground|stop|restart|status|print-cmd}" >&2

esac

从脚本中来看,ZooKeeper 的启动和Tomcat的启动类似,都是先准备环境信息,然后启动QuorumPeerMain的main方法,其中最重要的当然是下面这一行方法 。 而查看Zookeeper状态,则以同样的方式调用org.apache.zookeeper.client.FourLetterWordMain类的main方法 。

nohup "$JAVA" $ZOO_DATADIR_AUTOCREATE "-Dzookeeper.log.dir=${ZOO_LOG_DIR}" \

"-Dzookeeper.log.file=${ZOO_LOG_FILE}" "-Dzookeeper.root.logger=${ZOO_LOG4J_PROP}" \

-XX:+HeapDumpOnOutOfMemoryError -XX:OnOutOfMemoryError='kill -9 %p' \

-cp "$CLASSPATH" $JVMFLAGS $ZOOMAIN "$ZOOCFG" > "$_ZOO_DAEMON_OUT" 2>&1 < /dev/null &

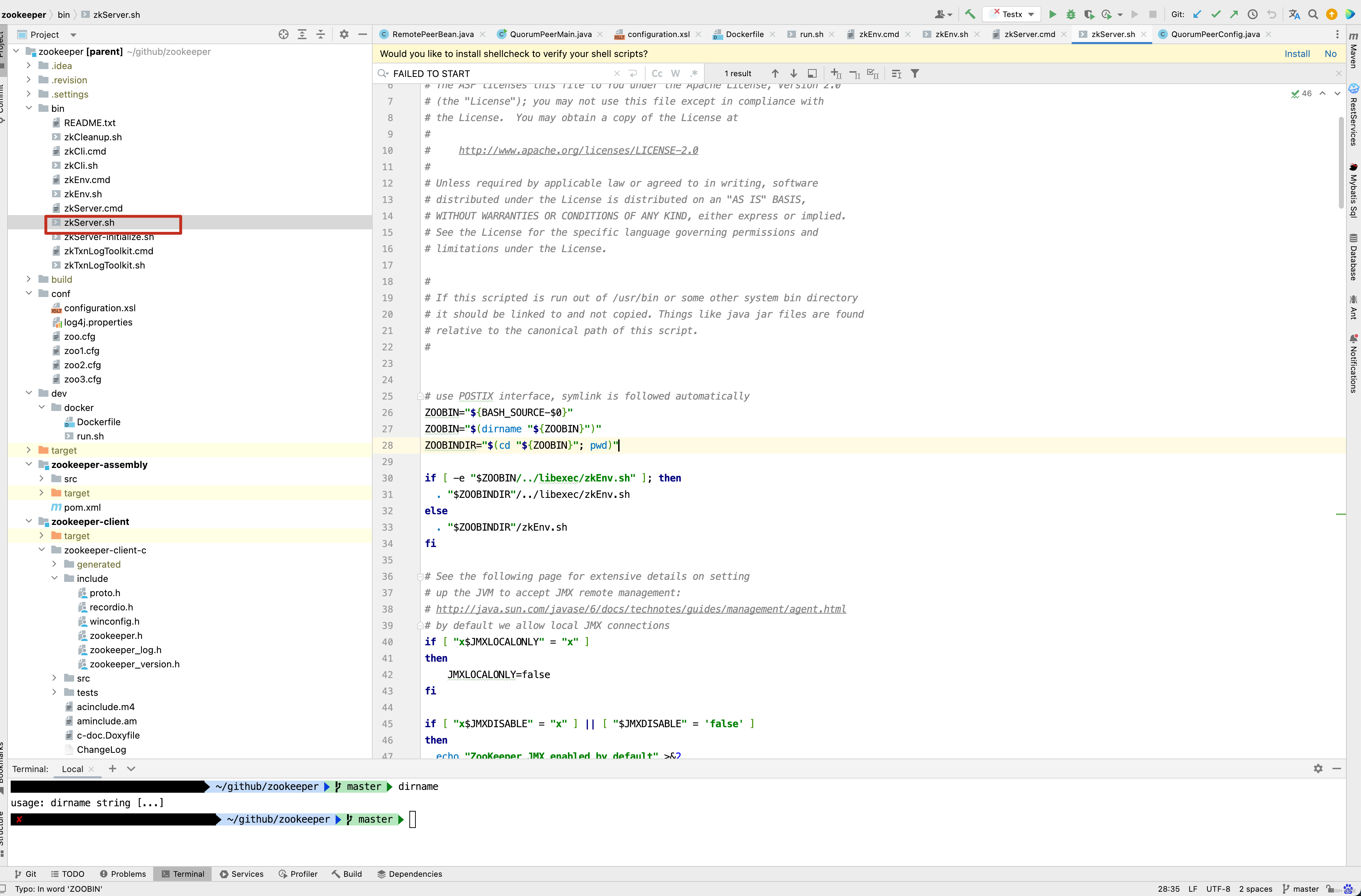

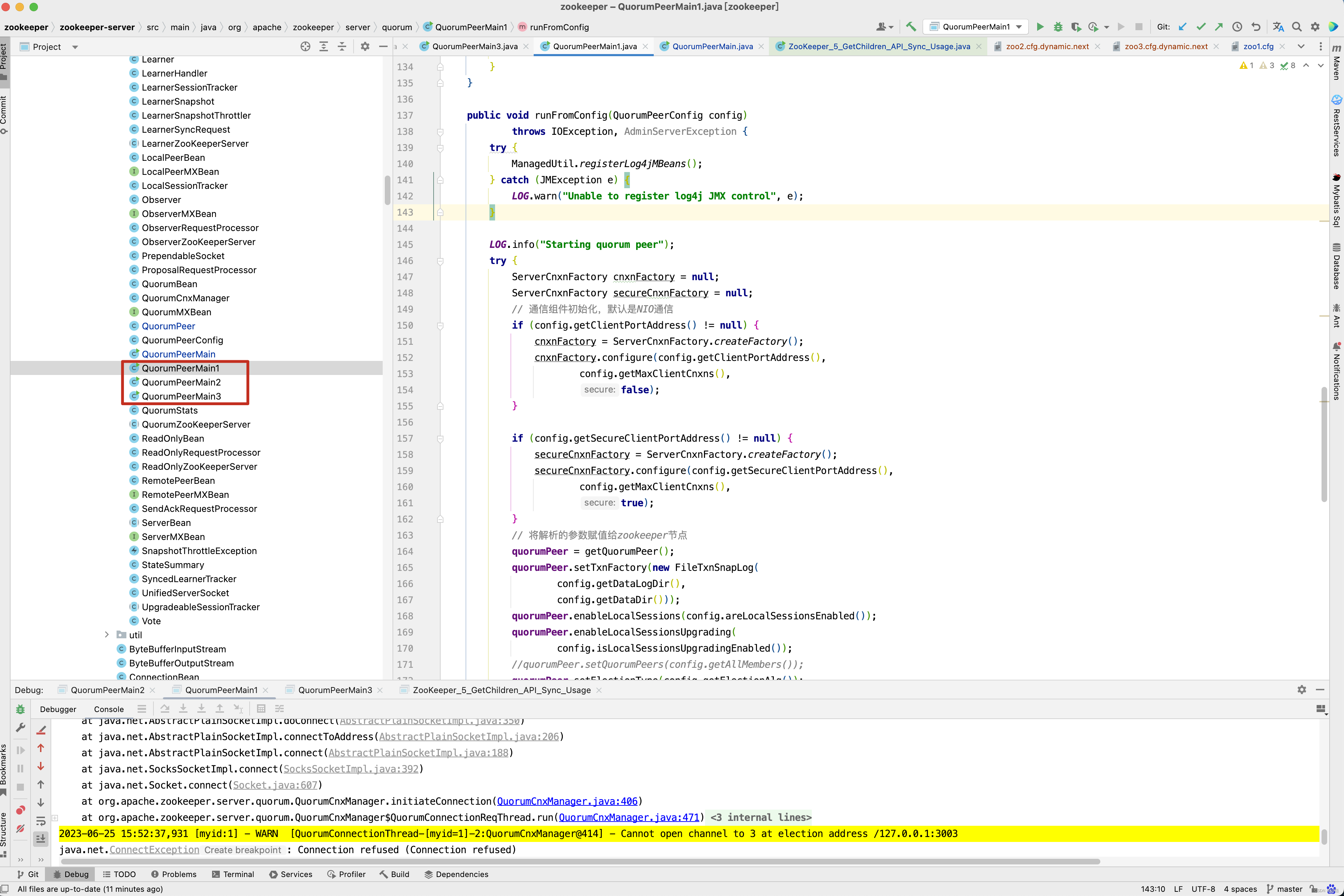

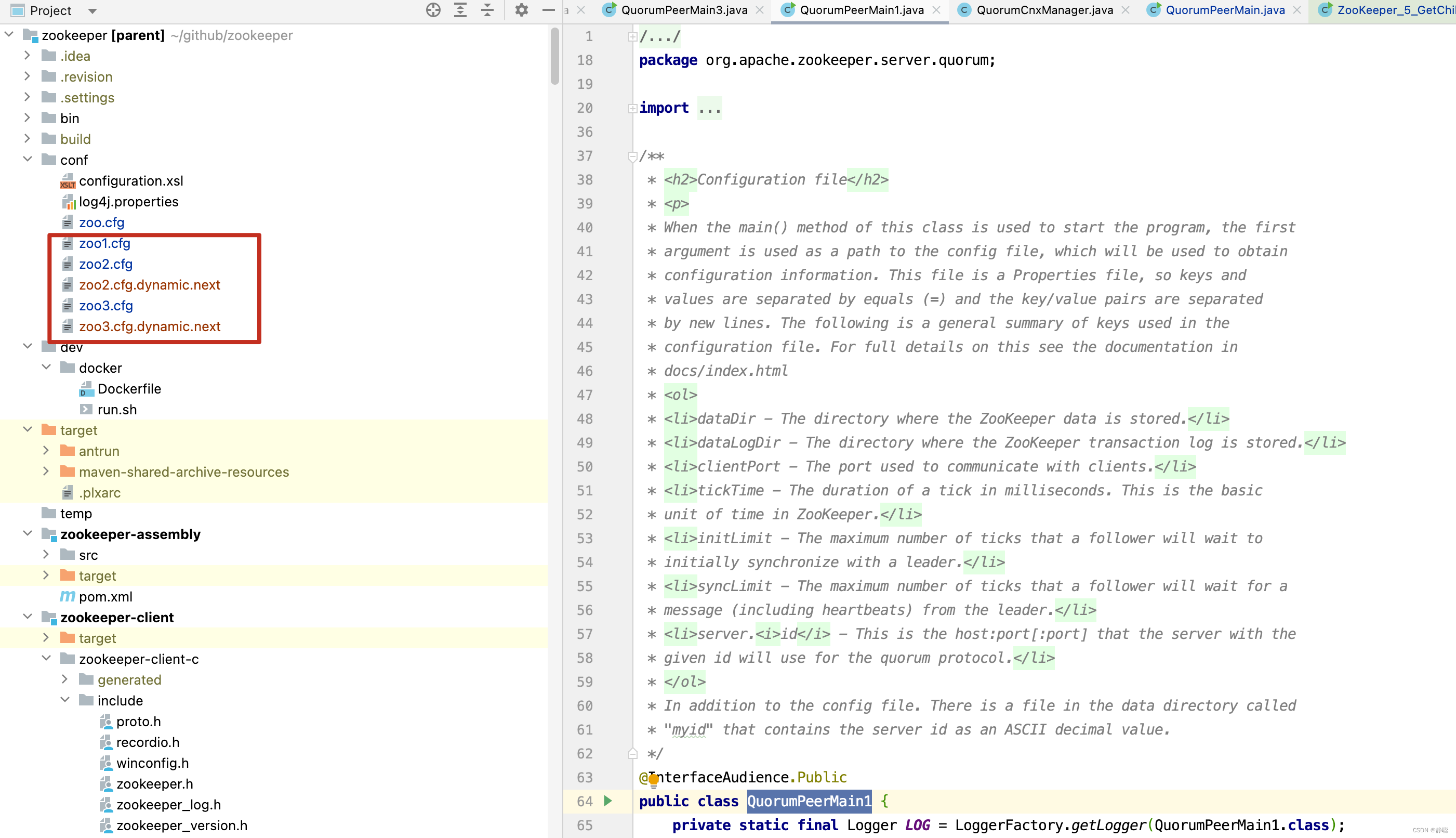

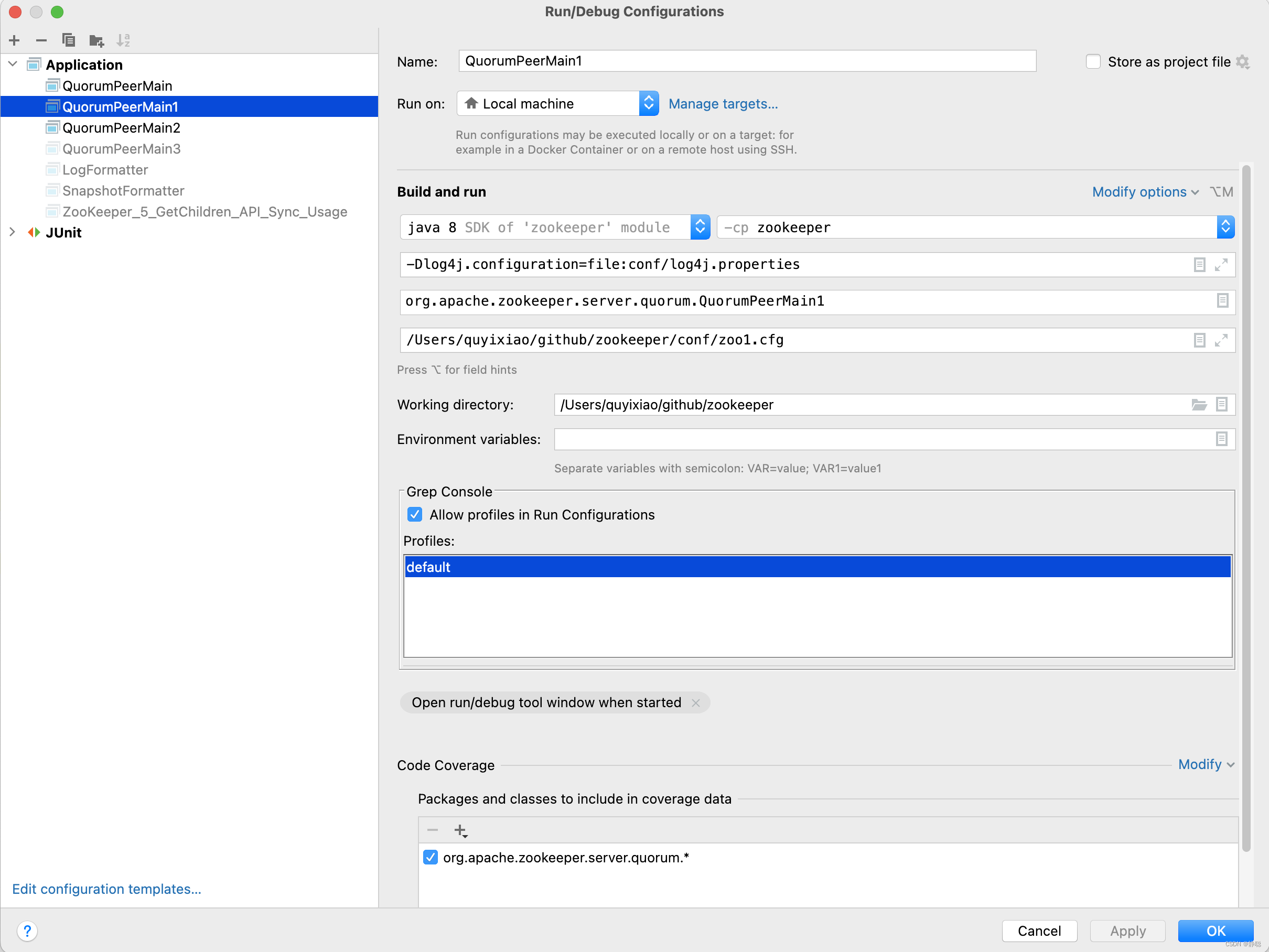

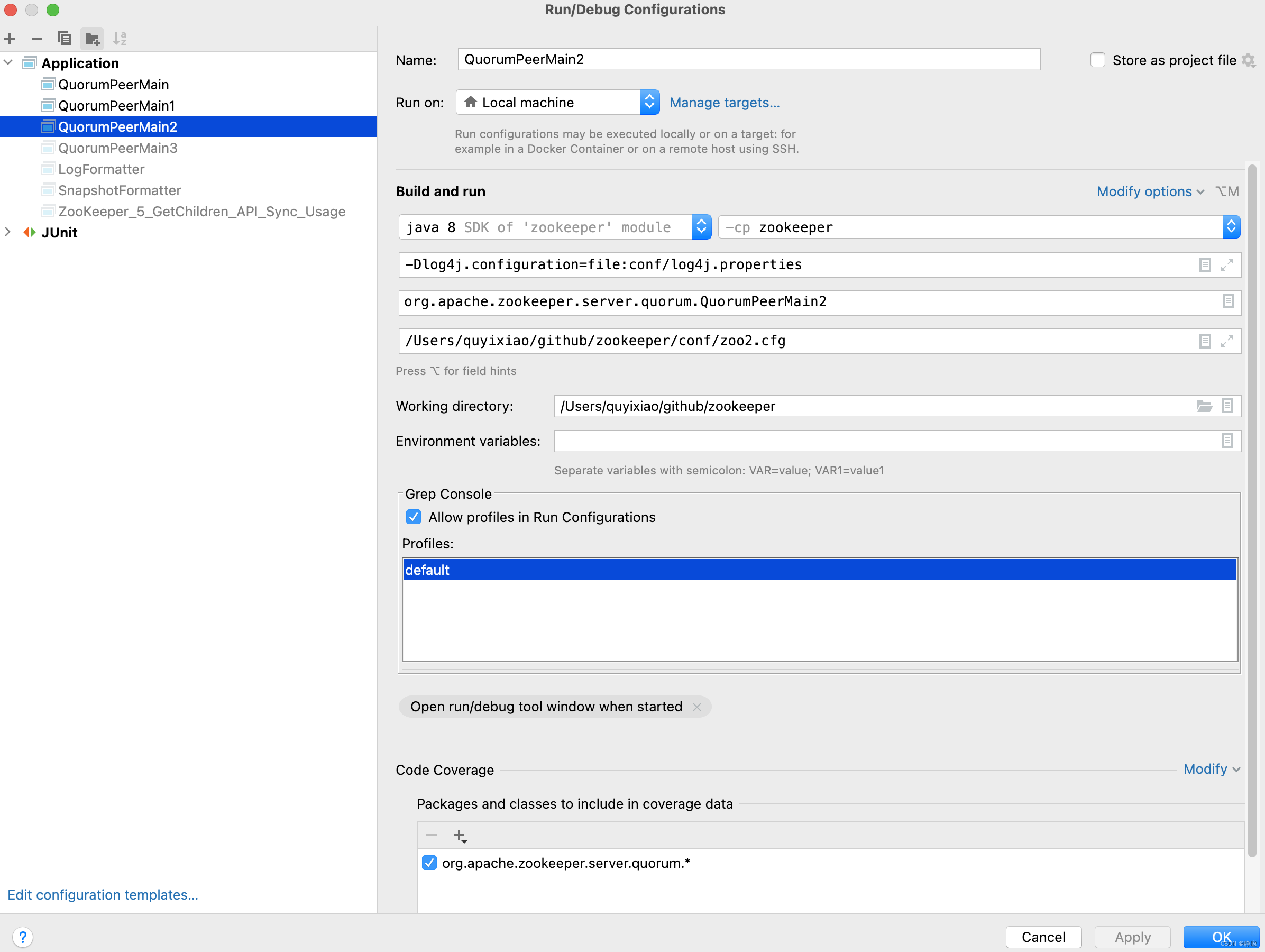

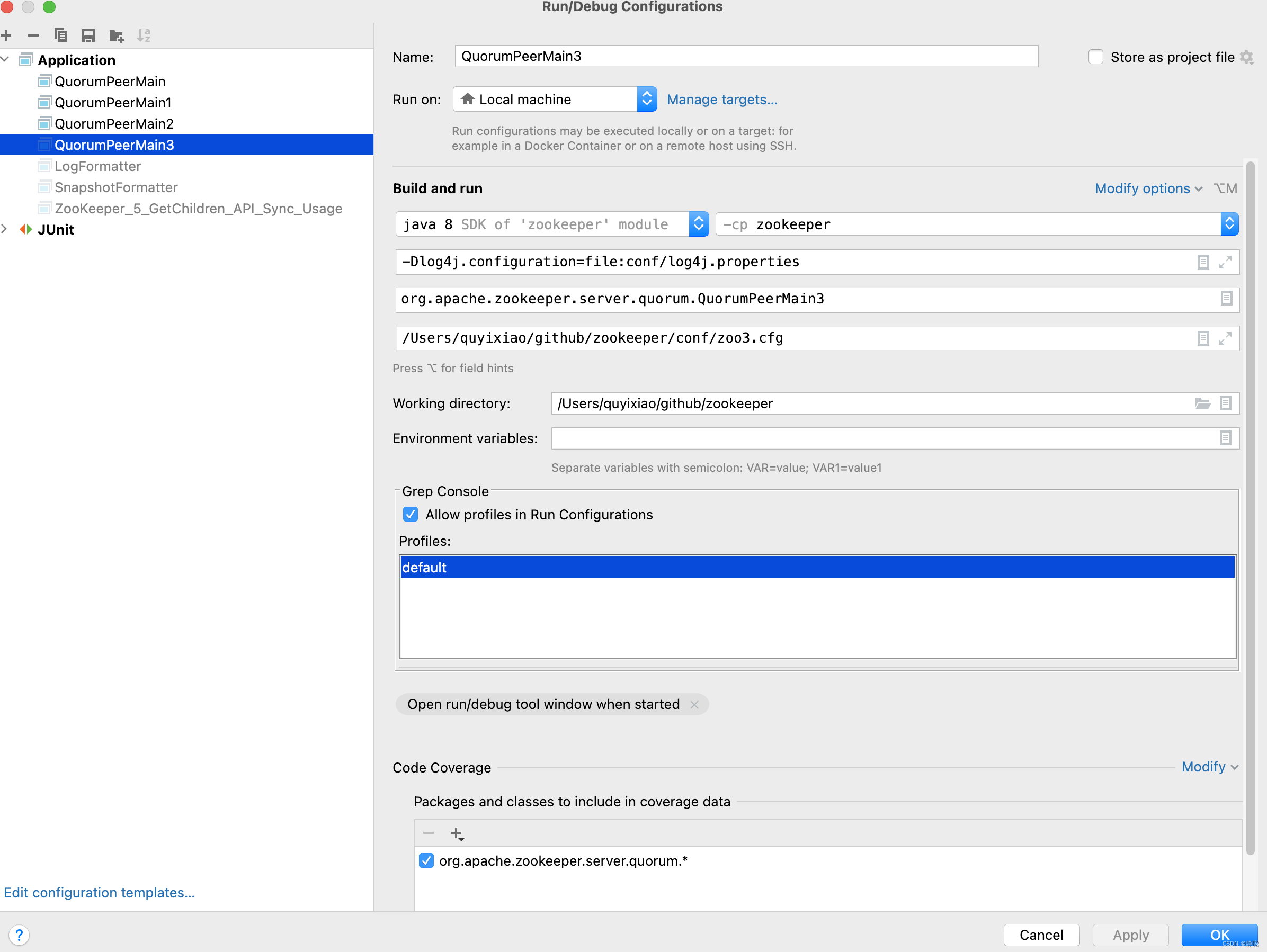

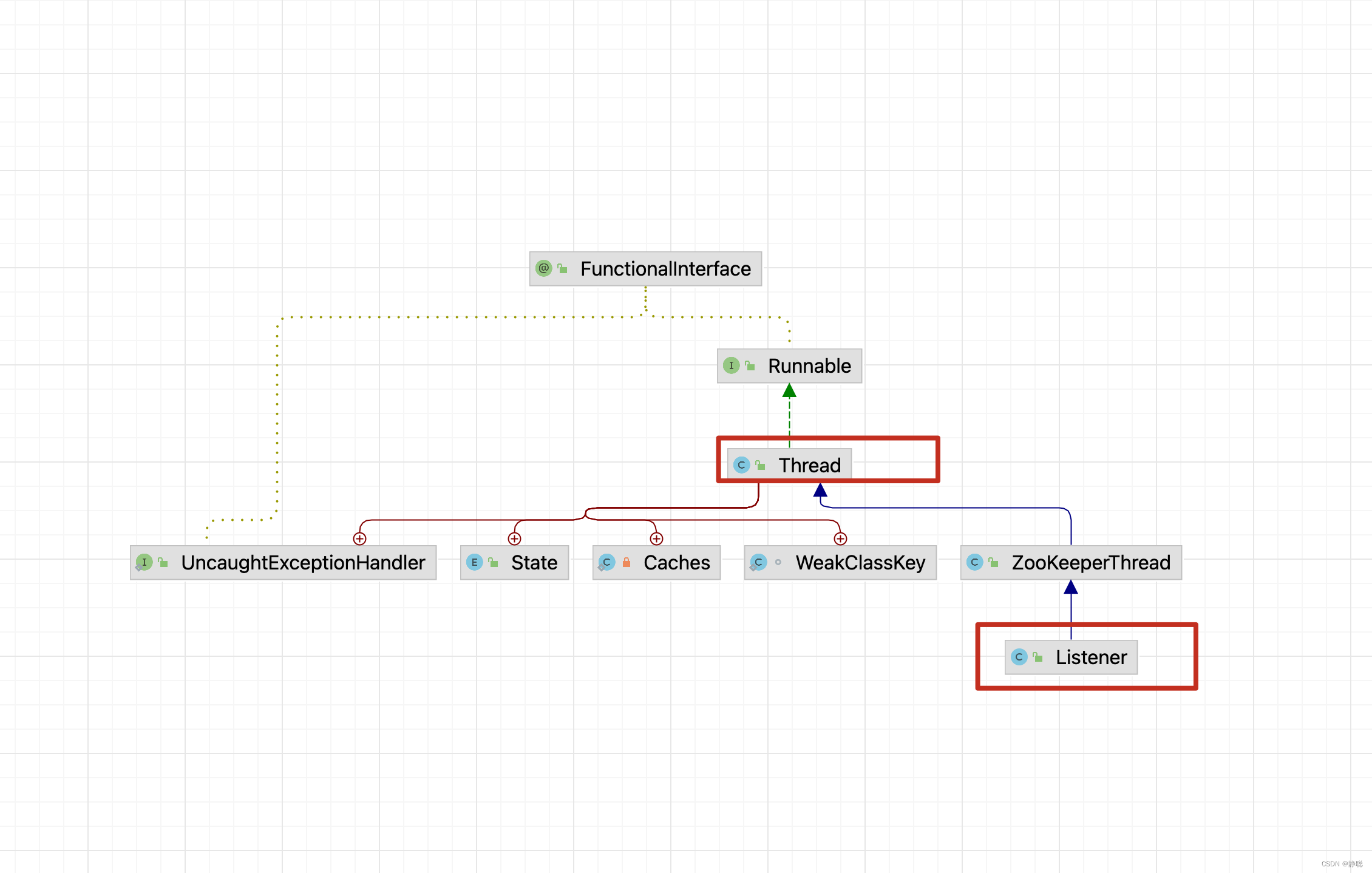

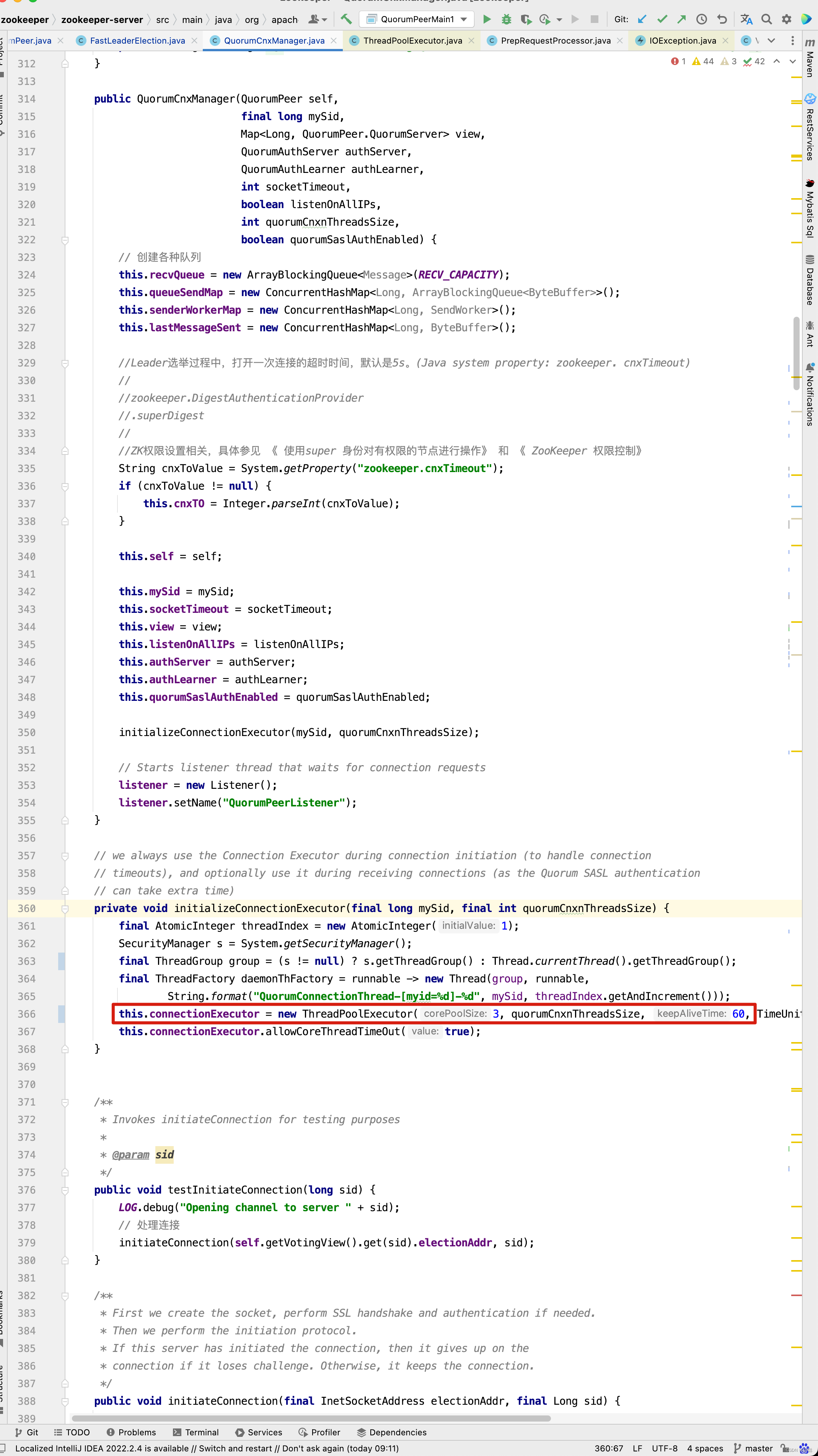

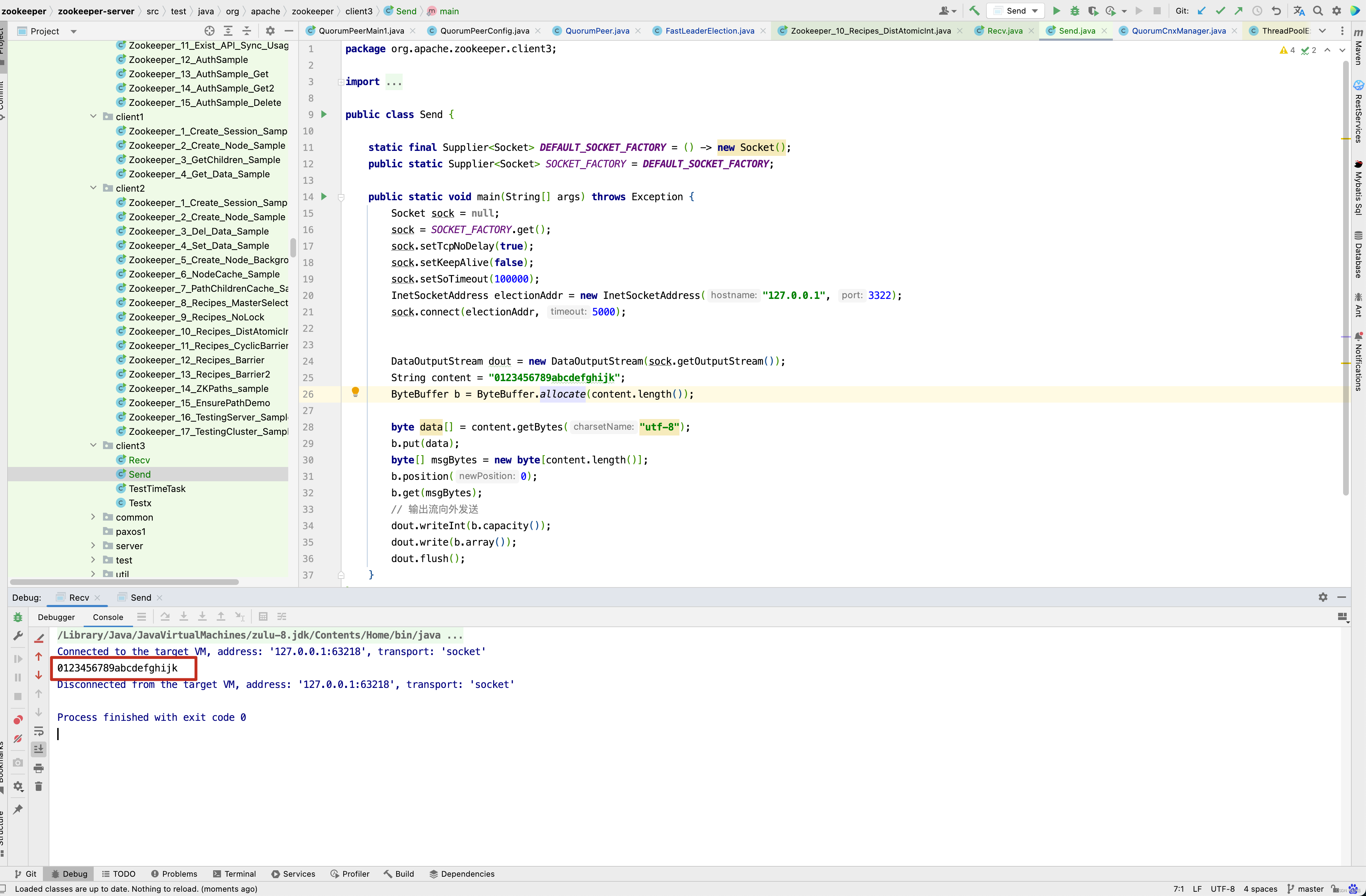

接下来,我们就来启动QuorumPeerMain方法,看做了哪些事情 ,在启动QuorumPeerMain类之前,先来看一下我的配置。 当然,zookeeper 代码的git地址为 : https://gitee.com/quyixiao/zookeeper-3.5.8.git 。

当然,上面两个红框内的内容为-Dlog4j.configuration=file:conf/log4j.properties 和 /Users/xxx/github/zookeeper/conf/zoo.cfg ,大家自行配置即可。 进入QuorumPeerMain的main方法 。

当然,上面两个红框内的内容为-Dlog4j.configuration=file:conf/log4j.properties 和 /Users/xxx/github/zookeeper/conf/zoo.cfg ,大家自行配置即可。 进入QuorumPeerMain的main方法 。

QuorumPeerMain

public static void main(String[] args) {

// 创建了一个zk节点

QuorumPeerMain main = new QuorumPeerMain();

try {

// 初始化节点并运行,args相当于提交参数中的zoo.cfg

main.initializeAndRun(args);

} catch (IllegalArgumentException e) {

LOG.error("Invalid arguments, exiting abnormally", e);

LOG.info(USAGE);

System.err.println(USAGE);

System.exit(2);

} catch (ConfigException e) {

LOG.error("Invalid config, exiting abnormally", e);

System.err.println("Invalid config, exiting abnormally");

System.exit(2);

} catch (DatadirException e) {

LOG.error("Unable to access datadir, exiting abnormally", e);

System.err.println("Unable to access datadir, exiting abnormally");

System.exit(3);

} catch (AdminServerException e) {

LOG.error("Unable to start AdminServer, exiting abnormally", e);

System.err.println("Unable to start AdminServer, exiting abnormally");

System.exit(4);

} catch (Exception e) {

LOG.error("Unexpected exception, exiting abnormally", e);

System.exit(1);

}

LOG.info("Exiting normally");

System.exit(0);

}

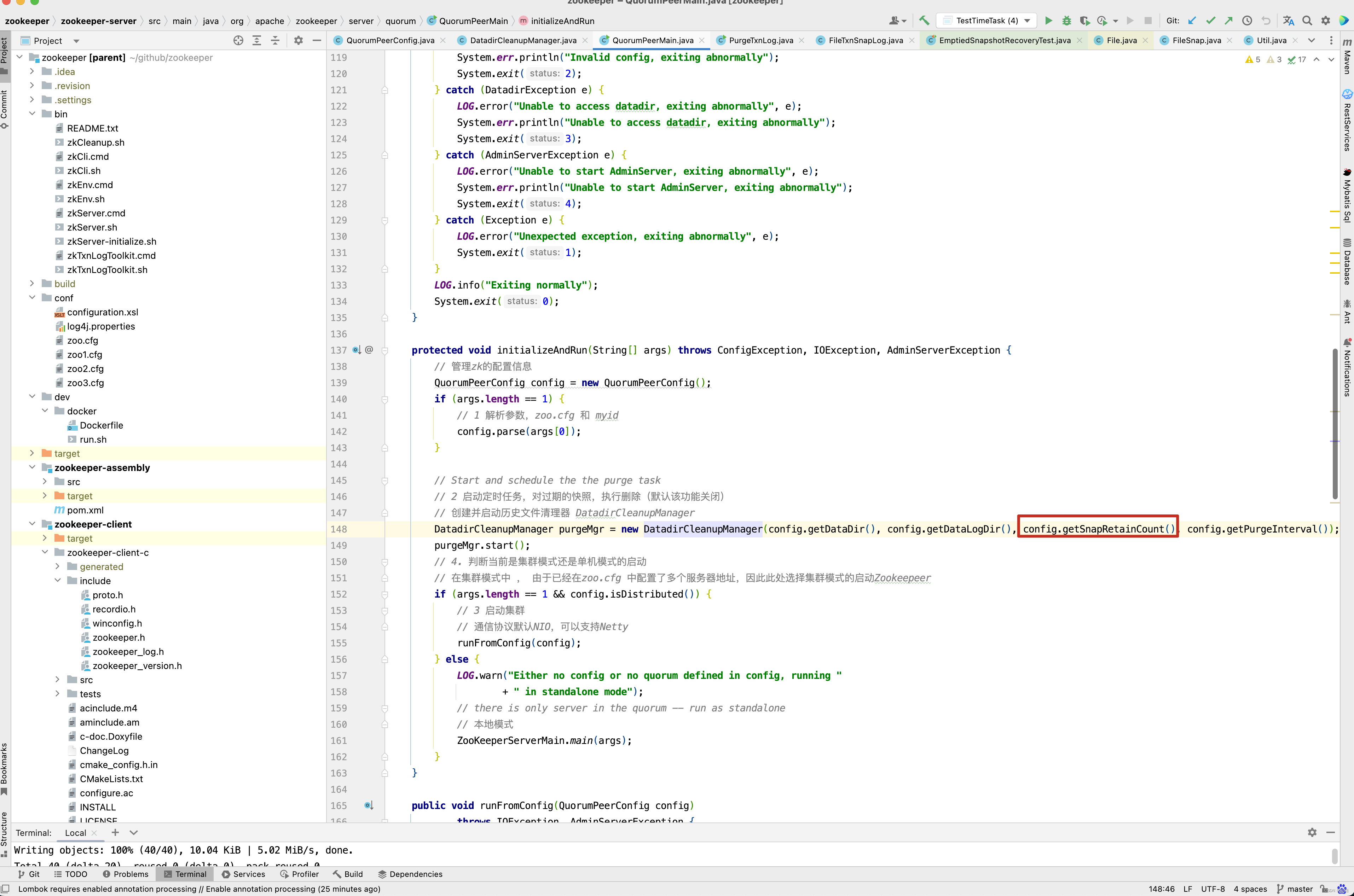

当然,QuorumPeerMain并没有重写构造方法,因此重点就进入了initializeAndRun()方法的分析 。

protected void initializeAndRun(String[] args) throws ConfigException, IOException, AdminServerException {

// 管理zk的配置信息

QuorumPeerConfig config = new QuorumPeerConfig();

if (args.length == 1) {

// 1 解析参数,zoo.cfg 和 myid

config.parse(args[0]);

}

// Start and schedule the the purge task

// 2 启动定时任务,对过期的快照,执行删除(默认该功能关闭)

// 创建并启动历史文件清理器DatadirCleanupManager

DatadirCleanupManager purgeMgr = new DatadirCleanupManager(config.getDataDir(), config.getDataLogDir(), config.getSnapRetainCount(), config.getPurgeInterval());

purgeMgr.start();

// 4. 判断当前是集群模式还是单机模式的启动

// 在集群模式中 , 由于已经在zoo.cfg 中配置了多个服务器地址,因此此处选择集群模式的启动Zookeepeer

if (args.length == 1 && config.isDistributed()) {

// 3 启动集群

// 通信协议默认NIO,可以支持Netty

runFromConfig(config);

} else {

LOG.warn("Either no config or no quorum defined in config, running "

+ " in standalone mode");

// there is only server in the quorum -- run as standalone

// 本地模式

ZooKeeperServerMain.main(args);

}

}

单机启动

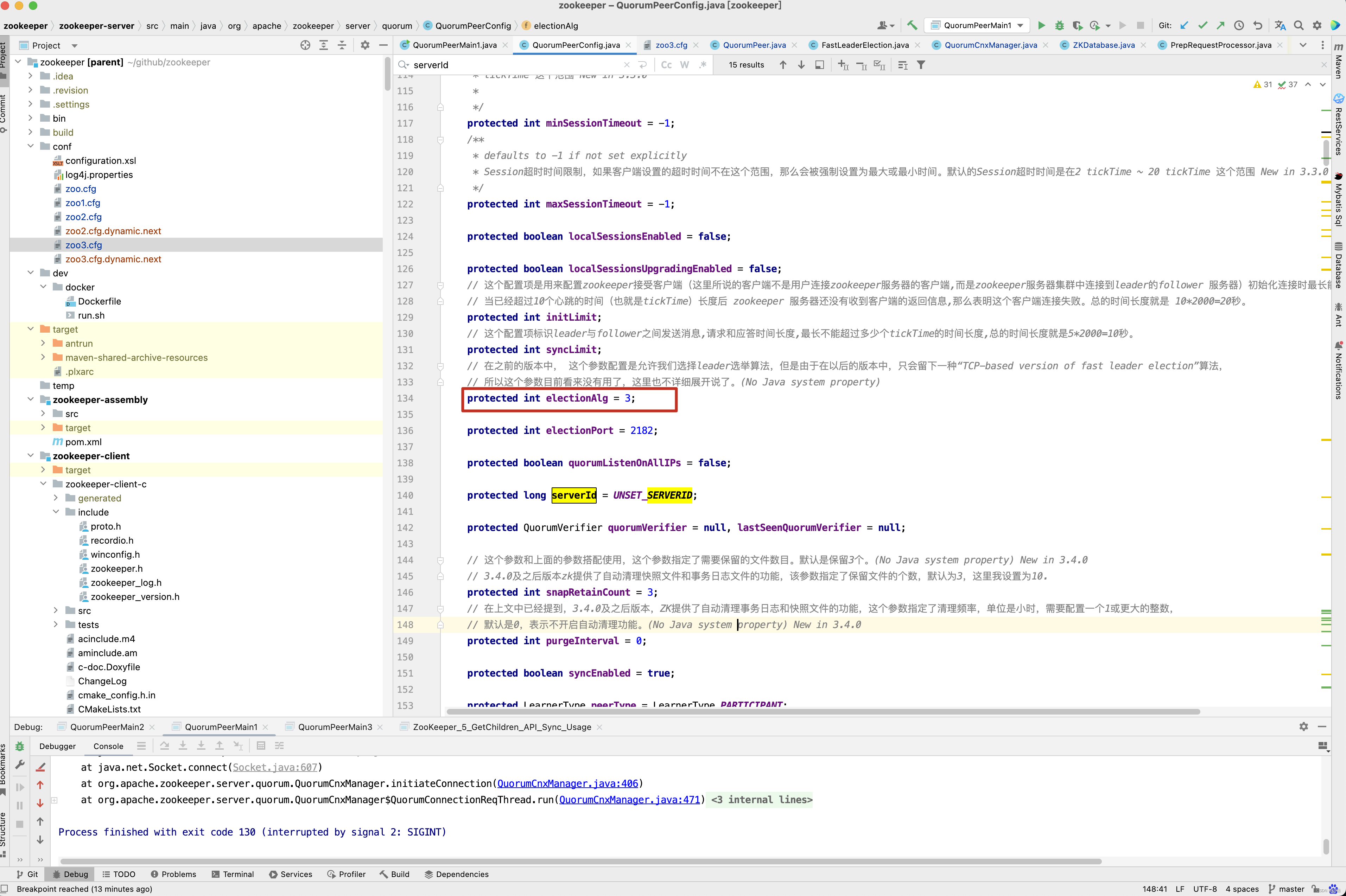

从initializeAndRun()方法中即可看出,所有的配置信息存储在QuorumPeerConfig中,而QuorumPeerConfig结构信息如下,从QuorumPeerConfig中我们看到了zoo.cfg中熟悉的配置。 tickTime,initLimit,syncLimit,dataDir,clientPort 等 。

public class QuorumPeerConfig {

private static final Logger LOG = LoggerFactory.getLogger(QuorumPeerConfig.class);

private static final int UNSET_SERVERID = -1;

public static final String nextDynamicConfigFileSuffix = ".dynamic.next";

private static boolean standaloneEnabled = true;

private static boolean reconfigEnabled = false;

protected InetSocketAddress clientPortAddress;

protected InetSocketAddress secureClientPortAddress;

protected boolean sslQuorum = false;

protected boolean shouldUsePortUnification = false;

protected boolean sslQuorumReloadCertFiles = false;

// 顾名思义就是zookeeper保存数据的目录,默认情况下zookeeper将写数据的日志文件也保存在这个目录里;

protected File dataDir;

// 这个端口就是客户端连接Zookeeper服务器的端口,Zookeeper会监听这个端口接受客户端的访问请求;

protected File dataLogDir;

protected String dynamicConfigFileStr = null;

protected String configFileStr = null;

// 这个时间是作为zookeeper服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是说每个tickTime时间就会发送一个心跳。

protected int tickTime = ZooKeeperServer.DEFAULT_TICK_TIME;

protected int maxClientCnxns = 60;

/**

* defaults to -1 if not set explicitly

*/

protected int minSessionTimeout = -1;

/**

* defaults to -1 if not set explicitly

*/

protected int maxSessionTimeout = -1;

protected boolean localSessionsEnabled = false;

protected boolean localSessionsUpgradingEnabled = false;

// 这个配置项是用来配置zookeeper接受客户端(这里所说的客户端不是用户连接zookeeper服务器的客户端,而是zookeeper服务器集群中连接到leader的follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。

protected int initLimit;

// 这个配置项标识leader与follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime的时间长度,总的时间长度就是5*2000=10秒。

protected int syncLimit;

protected int electionAlg = 3;

protected int electionPort = 2182;

protected boolean quorumListenOnAllIPs = false;

protected long serverId = UNSET_SERVERID;

protected QuorumVerifier quorumVerifier = null, lastSeenQuorumVerifier = null;

protected int snapRetainCount = 3;

protected int purgeInterval = 0;

protected boolean syncEnabled = true;

protected LearnerType peerType = LearnerType.PARTICIPANT;

/**

* Configurations for the quorumpeer-to-quorumpeer sasl authentication

*/

protected boolean quorumServerRequireSasl = false;

protected boolean quorumLearnerRequireSasl = false;

protected boolean quorumEnableSasl = false;

protected String quorumServicePrincipal = QuorumAuth.QUORUM_KERBEROS_SERVICE_PRINCIPAL_DEFAULT_VALUE;

protected String quorumLearnerLoginContext = QuorumAuth.QUORUM_LEARNER_SASL_LOGIN_CONTEXT_DFAULT_VALUE;

protected String quorumServerLoginContext = QuorumAuth.QUORUM_SERVER_SASL_LOGIN_CONTEXT_DFAULT_VALUE;

protected int quorumCnxnThreadsSize;

}

接下来看QuorumPeerConfig的parse()方法 。

public void parse(String path) throws ConfigException {

LOG.info("Reading configuration from: " + path);

try {

// 校验文件路径及是否存在

File configFile = (new VerifyingFileFactory.Builder(LOG)

.warnForRelativePath()

.failForNonExistingPath()

.build()).create(path);

Properties cfg = new Properties();

FileInputStream in = new FileInputStream(configFile);

try {

// 加载配置文件

cfg.load(in);

configFileStr = path;

} finally {

in.close();

}

// 解析配置文件

parseProperties(cfg);

} catch (IOException e) {

throw new ConfigException("Error processing " + path, e);

} catch (IllegalArgumentException e) {

throw new ConfigException("Error processing " + path, e);

}

if (dynamicConfigFileStr != null) {

try {

Properties dynamicCfg = new Properties();

FileInputStream inConfig = new FileInputStream(dynamicConfigFileStr);

try {

dynamicCfg.load(inConfig);

if (dynamicCfg.getProperty("version") != null) {

throw new ConfigException("dynamic file shouldn't have version inside");

}

String version = getVersionFromFilename(dynamicConfigFileStr);

// If there isn't any version associated with the filename,

// the default version is 0.

if (version != null) {

dynamicCfg.setProperty("version", version);

}

} finally {

inConfig.close();

}

setupQuorumPeerConfig(dynamicCfg, false);

} catch (IOException e) {

throw new ConfigException("Error processing " + dynamicConfigFileStr, e);

} catch (IllegalArgumentException e) {

throw new ConfigException("Error processing " + dynamicConfigFileStr, e);

}

File nextDynamicConfigFile = new File(configFileStr + nextDynamicConfigFileSuffix);

if (nextDynamicConfigFile.exists()) {

try {

Properties dynamicConfigNextCfg = new Properties();

FileInputStream inConfigNext = new FileInputStream(nextDynamicConfigFile);

try {

dynamicConfigNextCfg.load(inConfigNext);

} finally {

inConfigNext.close();

}

boolean isHierarchical = false;

for (Entry<Object, Object> entry : dynamicConfigNextCfg.entrySet()) {

String key = entry.getKey().toString().trim();

if (key.startsWith("group") || key.startsWith("weight")) {

isHierarchical = true;

break;

}

}

lastSeenQuorumVerifier = createQuorumVerifier(dynamicConfigNextCfg, isHierarchical);

} catch (IOException e) {

LOG.warn("NextQuorumVerifier is initiated to null");

}

}

}

}

上述中有一行dynamicConfigNextCfg.load(inConfigNext);代码,这一行代码如何配置的呢?

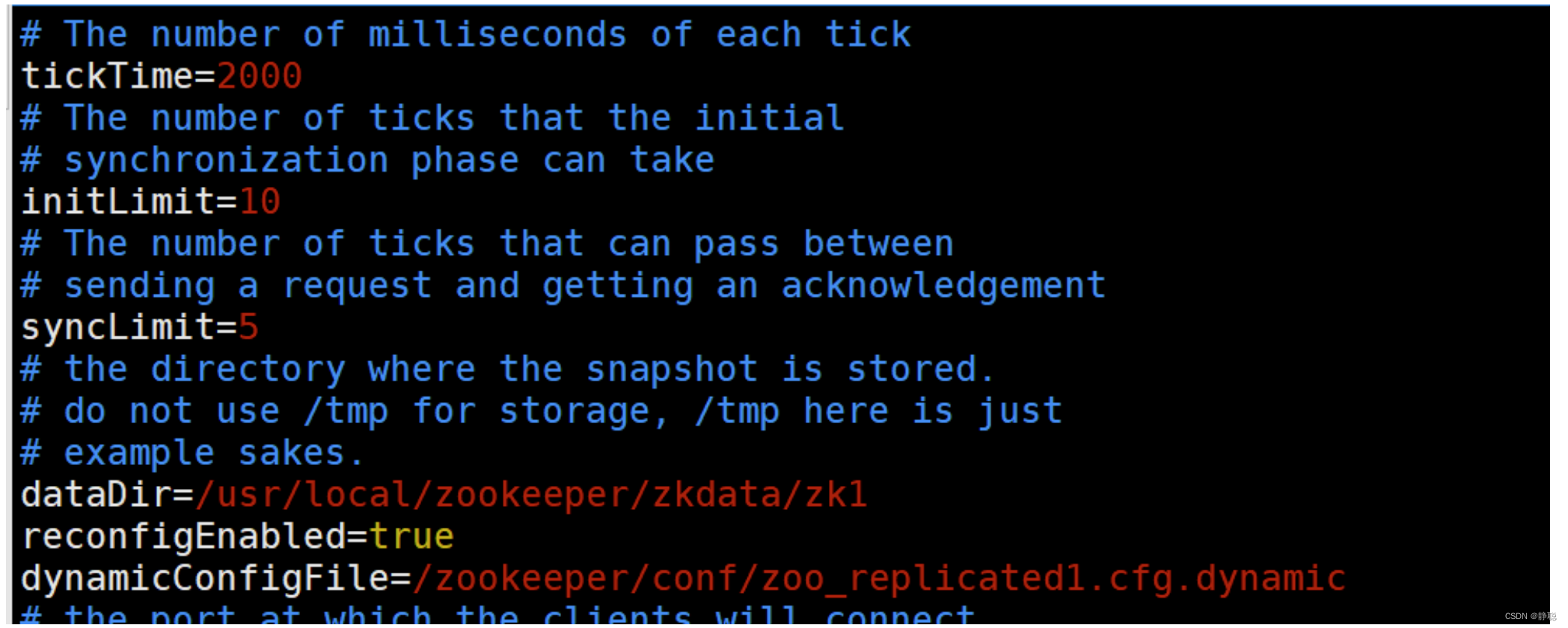

修改配置 zoo1.cfg 注意这里去除了端口号,添加了 reconfigEnabled : 设置为true 开启动态配置

dynamicConfigFile : 指定动态配置文件的路径

创建文件 zoo_replicated1.cfg.dynamic

动态配置文件,加入集群信息 server.A=B.C.D.E;F

- A: 服务的唯一标识

- B: 服务对应的IP地址,

- C: 集群通信端口

- D: 集群选举端口

- E: 角色, 默认是 participant,即参与过半机制的角色,选举,事务请求过半提交,还有一个是 observer, 观察者,不参与选举以及过半机制。

之后是一个分号,一定是分号, - F:服务IP:端口

server.1=192.168.109.200:2001:3001:participant;192.168.109.200:2181 server.2=192.168.109.200:2002:3002:participant;192.168.109.200:2182 server.3=192.168.109.200:2003:3003:participant;192.168.109.200:2183

依次配置其他服务 zoo2.cfg ,zoo3.cfg注意数据文件的路径

依次启动所有服务 如: ./bin/zkServer.sh start conf/zoo1.cfg 查看集群状态:

./bin/zkServer.sh status conf/zoo1.cfg

连上任意一台服务器:

查看集群配置

config // 将会把动态配置打印出来

也可以直接查看目录

/zookeeper/config 该节点存储了集群信息

如果要修改集群状态,需要授权登录

addauth digest gj:123

reconfig ‐remove 3 // 移除serverId为 3 的机器

// 把对应的机器加进来

reconfig ‐add server.3=192.168.109.200:2003:3003:participant;192.168.109.200:2183

先来看zoo.cfg文件的解析,而zoo.cfg先是通过读取configFile文件,然后再调用cfg.load(in) 方法,将文件中如clientPort=2181加载为键值对的形式,就像HashMap一样,在Spring,Tomcat 都有类似的手法,接下来调用parseProperties()方法,对zoo.cfg配置文件进行解析与校验 。

如果要变更/或者添加新的服务需要将服务加到配置文件 zoo_replicated1.cfg.dynamic 中,启动服务

然后通过reconfig 命令进行添加或者变更服务角色,但是需要保证服务列表中 participant 角色 能够形成集群(过半机制)。

客户端可以通过监听 /zookeeper/confg 节点,来感知集群的变化。从而实现集群的动态变更. Zookeeper 类提供了对应的API 用来更新服务列表 : updateServerList。

public class ReconfigApp {

private final static String connectString = "127.0.0.1:2181";

private static int SESSION_TIMEOUT = 5 * 1000;

private static CountDownLatch countDownLatch = new CountDownLatch(1);

private static ZooKeeper zookeeper = null;

private static Watcher watcher = new Watcher() {

@Override

public void process(WatchedEvent event) {

if (event.getType() == Event.EventType.None && event.getState() == Event.KeeperState.SyncConnected) {

countDownLatch.countDown();

log.info(" 连接建立");

// start to watch config

try {

log.info(" 开始监听:{}", ZooDefs.CONFIG_NODE);

zookeeper.getConfig(true, null);

} catch (KeeperException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

}

} else if (event.getPath() != null && event.getPath().equals(ZooDefs.CONFIG_NODE)) {

try {

byte[] config = zookeeper.getConfig(this, null);

String clientConfigStr = ConfigUtils.getClientConfigStr(new String(config));

log.info(" 配置发生变更: {}", clientConfigStr);

zookeeper.updateServerList(clientConfigStr.split(" ")[1]);

} catch (KeeperException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

}

}

};

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

zookeeper = new ZooKeeper(connectString, SESSION_TIMEOUT, watcher);

countDownLatch.await();

Scanner scanner = new Scanner(System.in);

while (true) {

byte[] data = zookeeper.getData("/zookeeper/config", true, null);

scanner.next();

log.info("DATA: {}", new String(data));

}

}

}

Curator 也自带了动态配置的监听,不需要额外的配置和代码实现监听更新;

public void parseProperties(Properties zkProp)

throws IOException, ConfigException {

int clientPort = 0;

int secureClientPort = 0;

String clientPortAddress = null;

String secureClientPortAddress = null;

VerifyingFileFactory vff = new VerifyingFileFactory.Builder(LOG).warnForRelativePath().build();

// 读取zoo.cfg 文件中的属性值,并赋值给QuorumPeerConfig的类对象

for (Entry<Object, Object> entry : zkProp.entrySet()) {

String key = entry.getKey().toString().trim();

String value = entry.getValue().toString().trim();

// 存储快照文件snapshot的目录。默认情况下,事务日志也会存储在这里。建议同时配置参数dataLogDir,

// 事务日志的写性能直接影响zk性能。

if (key.equals("dataDir")) {

dataDir = vff.create(value);

// 事务日志输出目录。尽量给事务日志的输出配置单独的磁盘或是挂载点,这将极大的提升ZK性能。

// (No Java system property)

} else if (key.equals("dataLogDir")) {

dataLogDir = vff.create(value);

// 客户端连接server的端口,即对外服务端口,一般设置为2181吧。

} else if (key.equals("clientPort")) {

clientPort = Integer.parseInt(value);

} else if (key.equals("localSessionsEnabled")) {

localSessionsEnabled = Boolean.parseBoolean(value);

} else if (key.equals("localSessionsUpgradingEnabled")) {

localSessionsUpgradingEnabled = Boolean.parseBoolean(value);

// 对于多网卡的机器,可以为每个IP指定不同的监听端口。默认情况是所有IP都监听 clientPort指定的端口。 New in 3.3.0

} else if (key.equals("clientPortAddress")) {

clientPortAddress = value.trim();

} else if (key.equals("secureClientPort")) {

secureClientPort = Integer.parseInt(value);

} else if (key.equals("secureClientPortAddress")) {

secureClientPortAddress = value.trim();

// ZK中的一个时间单元。ZK中所有时间都是以这个时间单元为基础,进行整数倍配置的。

// 例如,session的最小超时时间是2*tickTime。

} else if (key.equals("tickTime")) {

tickTime = Integer.parseInt(value);

// 限制由IP地址标识的单个客户机可以对ZooKeeper集合的单个成员进行的并发连接数。默认值是60。如果设置为0,表示不限制。

} else if (key.equals("maxClientCnxns")) {

maxClientCnxns = Integer.parseInt(value);

// zookeeper 3.3.0版本后启动,服务器允许客户端协商的最小会话超时(毫秒)。默认是2个 tickTime 时间。

} else if (key.equals("minSessionTimeout")) {

minSessionTimeout = Integer.parseInt(value);

// zookeeper 3.3.0版本后启动,服务器允许客户端协商的最大会话超时(毫秒)。默认是20个 tickTime 时间。

} else if (key.equals("maxSessionTimeout")) {

maxSessionTimeout = Integer.parseInt(value);

// 这个配置项是用来配置zookeeper接受客户端(这里所说的客户端不是用户连接zookeeper服务器的客户端,而是zookeeper服务器集群中连接到leader的follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。

// 当已经超过10个心跳的时间(也就是tickTime)长度后 zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 10*2000=20秒。

} else if (key.equals("initLimit")) {

initLimit = Integer.parseInt(value);

// 这个配置项标识leader与follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime的时间长度,总的时间长度就是5*2000=10秒。

} else if (key.equals("syncLimit")) {

syncLimit = Integer.parseInt(value);

// 在之前的版本中, 这个参数配置是允许我们选择leader选举算法,但是由于在以后的版本中,只会留下一种“TCP-based version of fast leader election”算法,

// 所以这个参数目前看来没有用了,这里也不详细展开说了。(No Java system property)

} else if (key.equals("electionAlg")) {

electionAlg = Integer.parseInt(value);

} else if (key.equals("quorumListenOnAllIPs")) {

quorumListenOnAllIPs = Boolean.parseBoolean(value);

} else if (key.equals("peerType")) {

if (value.toLowerCase().equals("observer")) {

peerType = LearnerType.OBSERVER;

} else if (value.toLowerCase().equals("participant")) {

peerType = LearnerType.PARTICIPANT;

} else {

throw new ConfigException("Unrecognised peertype: " + value);

}

} else if (key.equals("syncEnabled")) {

syncEnabled = Boolean.parseBoolean(value);

} else if (key.equals("dynamicConfigFile")) {

dynamicConfigFileStr = value;

// 这个参数和上面的参数搭配使用,这个参数指定了需要保留的文件数目。默认是保留3个。(No Java system property) New in 3.4.0

} else if (key.equals("autopurge.snapRetainCount")) {

snapRetainCount = Integer.parseInt(value);

// 在上文中已经提到,3.4.0及之后版本,ZK提供了自动清理事务日志和快照文件的功能,这个参数指定了清理频率,单位是小时,需要配置一个1或更大的整数,

// 默认是0,表示不开启自动清理功能。(No Java system property) New in 3.4.0

} else if (key.equals("autopurge.purgeInterval")) {

purgeInterval = Integer.parseInt(value);

// 3.5.0版本新增。当设置为false时,单个服务器可以在复制模式下启动,单个参与者可以与观察者一起运行,集群可以向下配置到一个节点,然后从一个节点向上配置。对于向后兼容性,默认值为true。

} else if (key.equals("standaloneEnabled")) {

if (value.toLowerCase().equals("true")) {

setStandaloneEnabled(true);

} else if (value.toLowerCase().equals("false")) {

setStandaloneEnabled(false);

} else {

throw new ConfigException("Invalid option " + value + " for standalone mode. Choose 'true' or 'false.'");

}

// 3.5.3版本新增。这控制动态重新配置功能的启用或禁用。启用该功能后,用户可以通过ZooKeeper客户端API或ZooKeeper命令行工具执行重新配置操作,

// 前提是用户有权执行此类操作。当功能被禁用时,任何用户(包括超级用户)都不能执行重新配置。任何重新配置的尝试都将返回错误。默认值为false。

} else if (key.equals("reconfigEnabled")) {

if (value.toLowerCase().equals("true")) {

setReconfigEnabled(true);

} else if (value.toLowerCase().equals("false")) {

setReconfigEnabled(false);

} else {

throw new ConfigException("Invalid option " + value + " for reconfigEnabled flag. Choose 'true' or 'false.'");

}

} else if (key.equals("sslQuorum")) {

sslQuorum = Boolean.parseBoolean(value);

} else if (key.equals("portUnification")) {

shouldUsePortUnification = Boolean.parseBoolean(value);

} else if (key.equals("sslQuorumReloadCertFiles")) {

sslQuorumReloadCertFiles = Boolean.parseBoolean(value);

// 这里的x是一个数字,与myid文件中的id是一致的。右边可以配置两个端口,第一个端口用于F和L之间的数据同步和其它通信,第二个端口用于Leader选举过程中投票通信。

// (No Java system property)

} else if ((key.startsWith("server.") || key.startsWith("group") || key.startsWith("weight")) && zkProp.containsKey("dynamicConfigFile")) {

throw new ConfigException("parameter: " + key + " must be in a separate dynamic config file");

} else if (key.equals(QuorumAuth.QUORUM_SASL_AUTH_ENABLED)) {

quorumEnableSasl = Boolean.parseBoolean(value);

} else if (key.equals(QuorumAuth.QUORUM_SERVER_SASL_AUTH_REQUIRED)) {

quorumServerRequireSasl = Boolean.parseBoolean(value);

} else if (key.equals(QuorumAuth.QUORUM_LEARNER_SASL_AUTH_REQUIRED)) {

quorumLearnerRequireSasl = Boolean.parseBoolean(value);

} else if (key.equals(QuorumAuth.QUORUM_LEARNER_SASL_LOGIN_CONTEXT)) {

quorumLearnerLoginContext = value;

} else if (key.equals(QuorumAuth.QUORUM_SERVER_SASL_LOGIN_CONTEXT)) {

quorumServerLoginContext = value;

} else if (key.equals(QuorumAuth.QUORUM_KERBEROS_SERVICE_PRINCIPAL)) {

quorumServicePrincipal = value;

} else if (key.equals("quorum.cnxn.threads.size")) {

quorumCnxnThreadsSize = Integer.parseInt(value);

} else {

System.setProperty("zookeeper." + key, value);

}

}

if (!quorumEnableSasl && quorumServerRequireSasl) {

throw new IllegalArgumentException(

QuorumAuth.QUORUM_SASL_AUTH_ENABLED

+ " is disabled, so cannot enable "

+ QuorumAuth.QUORUM_SERVER_SASL_AUTH_REQUIRED);

}

if (!quorumEnableSasl && quorumLearnerRequireSasl) {

throw new IllegalArgumentException(

QuorumAuth.QUORUM_SASL_AUTH_ENABLED

+ " is disabled, so cannot enable "

+ QuorumAuth.QUORUM_LEARNER_SASL_AUTH_REQUIRED);

}

// If quorumpeer learner is not auth enabled then self won't be able to

// join quorum. So this condition is ensuring that the quorumpeer learner

// is also auth enabled while enabling quorum server require sasl.

if (!quorumLearnerRequireSasl && quorumServerRequireSasl) {

throw new IllegalArgumentException(

QuorumAuth.QUORUM_LEARNER_SASL_AUTH_REQUIRED

+ " is disabled, so cannot enable "

+ QuorumAuth.QUORUM_SERVER_SASL_AUTH_REQUIRED);

}

// Reset to MIN_SNAP_RETAIN_COUNT if invalid (less than 3)

// PurgeTxnLog.purge(File, File, int) will not allow to purge less

// than 3.

// 这个参数和上面的参数搭配使用,这个参数指定了需要保留的文件数目。默认是保留3个。(No Java system property) New in 3.4.0

if (snapRetainCount < MIN_SNAP_RETAIN_COUNT) {

LOG.warn("Invalid autopurge.snapRetainCount: " + snapRetainCount

+ ". Defaulting to " + MIN_SNAP_RETAIN_COUNT);

snapRetainCount = MIN_SNAP_RETAIN_COUNT;

}

if (dataDir == null) {

throw new IllegalArgumentException("dataDir is not set");

}

if (dataLogDir == null) {

// 这个端口就是客户端连接Zookeeper服务器的端口,Zookeeper会监听这个端口接受客户端的访问请求;

dataLogDir = dataDir;

}

if (clientPort == 0) {

LOG.info("clientPort is not set");

// 对于多网卡的机器,可以为每个IP指定不同的监听端口。默认情况是所有IP都监听 clientPort指定的端口。 New in 3.3.0

if (clientPortAddress != null) {

throw new IllegalArgumentException("clientPortAddress is set but clientPort is not set");

}

// 对于多网卡的机器,可以为每个IP指定不同的监听端口。默认情况是所有IP都监听 clientPort指定的端口。 New in 3.3.0

} else if (clientPortAddress != null) {

this.clientPortAddress = new InetSocketAddress(

InetAddress.getByName(clientPortAddress), clientPort);

LOG.info("clientPortAddress is {}", formatInetAddr(this.clientPortAddress));

} else {

this.clientPortAddress = new InetSocketAddress(clientPort);

LOG.info("clientPortAddress is {}", formatInetAddr(this.clientPortAddress));

}

if (secureClientPort == 0) {

LOG.info("secureClientPort is not set");

if (secureClientPortAddress != null) {

throw new IllegalArgumentException("secureClientPortAddress is set but secureClientPort is not set");

}

} else if (secureClientPortAddress != null) {

this.secureClientPortAddress = new InetSocketAddress(

InetAddress.getByName(secureClientPortAddress), secureClientPort);

LOG.info("secureClientPortAddress is {}", formatInetAddr(this.secureClientPortAddress));

} else {

this.secureClientPortAddress = new InetSocketAddress(secureClientPort);

LOG.info("secureClientPortAddress is {}", formatInetAddr(this.secureClientPortAddress));

}

if (this.secureClientPortAddress != null) {

configureSSLAuth();

}

// 这个时间是作为zookeeper服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是说每个tickTime时间就会发送一个心跳。

if (tickTime == 0) {

throw new IllegalArgumentException("tickTime is not set");

}

// Session超时时间限制,如果客户端设置的超时时间不在这个范围,那么会被强制设置为最大或最小时间。

// 默认的Session超时时间是在2 tickTime ~ 20 tickTime 这个范围 New in 3.3.0

minSessionTimeout = minSessionTimeout == -1 ? tickTime * 2 : minSessionTimeout;

maxSessionTimeout = maxSessionTimeout == -1 ? tickTime * 20 : maxSessionTimeout;

if (minSessionTimeout > maxSessionTimeout) {

throw new IllegalArgumentException(

"minSessionTimeout must not be larger than maxSessionTimeout");

}

// backward compatibility - dynamic configuration in the same file as

// static configuration params see writeDynamicConfig()

if (dynamicConfigFileStr == null) {

setupQuorumPeerConfig(zkProp, true);

if (isDistributed() && isReconfigEnabled()) {

// we don't backup static config for standalone mode.

// we also don't backup if reconfig feature is disabled.

backupOldConfig();

}

}

}

先来对ZooKeeper配置文件有一个大概的了解 。

| 参数名 | 说明 |

|---|---|

| dataLogDir | 该参数有默认值:dataDir,可以不配置,不支持系统属性方式配置。参数datalogDir用于配置Zookeeper服务器存储事务日志文件的目录。默认情况下,ZooKeeper会将事务日志文件和快照数据存儲在同一个目录中,读者应尽量將这两者的目录区分开来。另外,如果条件允许,可以将事务日志的存储配置在一个单独的磁盘上。事务日志记最对于磁盘的性能要求非常高,为了保证dataLogDir数据的一致性,Zookeeper在返回客户端事务请求响应之前,必须将本次请求对应的事务日志写人到磁盘中。因此,事务日志写入的性能直接决定了Zookeeper在处理事务请求时的吞吐。针对同一块磁盘的共他并发读写操作(例如Zookeeper运行时日志输出和操作系统自身的读写等),尤共是上文中提到的数据快照操作,会极大地影响事务日志的写性能。因此尽量给事务日志的输出配置一个单独的磁盘或是挂载点,將級大地提升Zookeeper的整体性能。 |

| initLimit | 该参数有默认值:10,即表示是参数tickTime值的10倍,必须配置,且需要配置一个正整数,不支特系统属性方式配置。该参数用于配置Leader服务器等待Follower启动,并完成数据同步的时间。Follower服务器在启动过程中,会与Leader建立连接并完成对数据的同步,从而确定自己对外提供服务的起始状态。Lcader服务器九许Follower在initLimit时间内完成这个工作。通常情况下,运维人员不用太在意这个参数的配置,使用共默认值即可。但如果随着Zookceper集群管理的数据量增大,Follower服务器在启动的时候,从Leader上进行同步数据的时间也会相应变长,于是无法在较短的时间完成数据同步。因此,在这种情况下,有必要适当调大这个参数。 |

| syncLimit | 该参数有跌认位:5,即表示是参数tickTime值的5倍,必须配置,且需要配置一个正整数,不支持系统属性方式配置。该参数用于配置Leader服务器和Follower之间进行心跳检測的最大廷时时间。在Zookeeper集群运行过程中,Leader服务器会与所有的Follower进行心跳检測来确定该服务器是否存活。如果Leader服务器在syncLimit时间内无法获取到Follower的心跳检测响应,那么Leader就会认为该Follower已经脱离了和自己的同步。通常情况下,运维人员使用该参数的默认值即可,但如果部署zookeeper集群的网络环境质量较低(倒如网络延时较大或丢包严重),那么可以适当调大这个参数。 |

| snapCount | 该参数有默认值:100000,可以不配置,仅支特系统属性方式配置:zookeeper.snapcount.参数snapcount用于配置相邻两次数据快照之间的事务操作次数,即Zookeeper会在snapCount次事务操作之后进行一次数据快照 |

| preAllocSize | 该参数有跃认值:65536,单位是KB,即64MB,可以不配置,仅支持系统属性方式配置:zookeeper.preAllocsize。参数preAllocsize用于配蛋Zookeeper事务日志文件预分配的磁盘空间大小。通常情况下,我们使用Zookceper的默认配置65536KB即可,但是如果我们将参数snapCount设置得比默认值更小或更大,那么preAllocsize参数也要随之做出变更。举个倒子来说:如果我们将snapcount的值设置为500,同时預估每次事务操作的数据量大小至多1KB,那么参数preAllocsize设置为500就足够了。 |

| minSessionTimeout,maxSessionTimeout | 这两个参数有默认值,分別是参数tickTime值的2倍和20倍,即默认的会话超时时间在2tickTime~20tickTime范国内,单位毫秒,可以不配置,不支持系统属性方式配置。这两个参数用于服务端对客户端会话的超时时间进行限制,如果容户端设置的超时时问不在该范固内,那么会被服务端强制设置为最大或最小超时时间。 |

| maxClientCnxns | 该参数有默认值:60,可以不配置,不支持系统為性万式配置。从Socket层面限制单个客户端与单台服务器之间的并发连接数,即以IP地址粒度来进行连接数的限制。如果将该参数设置为0。则表示对连接数不作任何限制。读者需要注意该连接数限制选项的使用范国,其仅仅是对单台客户端机器与单台ZooKeeper服务器之问的连接限制,并不能控制所有客户端的连接数总和。如米读者有类似需求的话,可以尝试阿里中间件团队提供的一个简单的补丁:http:/jm-blog.aliapp.lcom/?p=1334。另外,在3.4.0版本以前该参数的默认值都是10,从3.4.0版本开始变成了60,因此运维人员尤其需要注意这个变化,以防ZooKeeper版本变化带未服务端连接数限制变化的隐患。 |

| jute.maxbuffer | 该参数有默认值:1048575,单位是字节,可以不配置,仅支特系统属性方式配置:jute.maxbuffer。该参数用于配置单个数据节点(ZNode)上可以存储的最大数据量大小。通常情况下,远维人员不需要改动该参数,同时考虑到Zookeeper上不适宜存储太多的数据,往往还需要将该参数设置的更小,需要注意的是,在变更该参数的时候,需要在Zookeeper集群的所有机器以及所有的客户端上均设置才能生效 |

| clientPortAddress | 该参数没有默认值:可以不配置,不支特系统属性方式配置。针对那些多网卡的机器,该参数允许为每个IP地址指定不同的监听端口。 |

| server.id=host: port:port | 该参数没有狀认值,在单机模式下可以不配置,不支特系统属性方式配置。该参数用于配置组成Zookeeper集群的机器列表,其中id即ServerID,与每合服务器myid文件中的数宇相对应。同时,在该参数中,会配置两个端口:第一个端又用于指定Follower服务器与Leader进行运行时通信和数据同步时所使用的端口,第二个端口则专门用于进行Leader选举过程中的投票通信。在ZooKeeper服务器启动的时候,其会根据myid文件中配置的ServerID宋确定自己是哪台服务器,并使用对应配置的端又未进行启动。如果在实际使用过程中,需要在同一台服务器上部署多个ZooKeeper实例来构成伪集群的话,那么这些端又都需要配置成不同,例如:jute.maxbuffer clientPortAddress server.id=host:port:port server.1=192.168.0.1:2777:3777 server.2=192.168.0.1:2888:3888 server.3=192.168.0.1:2999:3999 |

| autopurge.snapRetainCount | 该参数有默认值:3,可以不配置,不支村承统属性方式配置。从3.4.0版本开始,ZooKeeper提供了对历史事务日志和快照数据自动清理的支持。参数autopurge.snapRetaincount用于配置Zookeeper在自动清理的时候需妥保留的快照数据文件数量和对应autopurge.snapRetainCount的事务日志文件。需要注意的是,并不是磁盘上的所有事务日志和快照数据文件都可以被清理掉–那样的话将无法恢复数据。因此参数autopurge.snapRetaincount的最小值是了,如果配置autopurge.snapRetaincount值比了小的话,那么会被自动调整到3,即至少需要保留了个快照数据文件和对应的事务日志文件。 |

| autopurge.purgeInterval | 该参数有狀认值:0,单位是小时,可以不配置,不支持系统属性方式配置。参数autopurge.purgeInterval和参数autopurge.snapRetaincount配套使用,用于配置Zookeeper进行历史文件自动清理的频率。如果配置该位为0或负数,那么就表明不需要开启定时清理功能。Zookeeper款认不开启这项功能。关于Zookeeper数据文件和事务日志文件的自动清理, |

| fsync.warningthresholdms | 该参数有跃认值:1000,单位是毫秒,可以不配置,仅支持系统属性方式配置:fsync.warningthresholdms。参数fsync.warningthresholdms用于配置Zookeeper进行事务日志fsync操作时消耗时间的报警阈值。一旦进行一个fsync操作消耗的时间大于参数fsync.warningthresholdms指定的值,那么就在日志中打印出报警日志。 |

| forceSync | 该参数有默认值:yes,可以不配置,可选配置项为“yes”和“no”,仅支持系统属性方式配置:zookecper.forceSync。该参数用于配置ZooKeeper服务器是否在事务提交的时候,将日志写人操作强制刷人磁盘(即调用java.nio.channels.FileChannel.force接又),默认情况下是“yes”,即每次事务日志写入操作都会入磁盘。如果将其设置为“no”,則能一定程度的提高Zokceper的写性能,但同时也会存在类似于机器断电这样的安全风险。 |

| globalOutstandingLimit | 该参数有默认值:1000,可以不配置,仅支持系统属性方式配置:zookeeperglobalOutstandingLimit.参数globalOutstandingLimit用于配置Zookeeper服务器最大请求堆积数量。在Zookeeper服务器运行的过程中,客户端会源源不断的将请求发送到服务端,为了防业服务端资源(包括CPU、内存和网络等)耗尽,服务端必领限制同时处理的请求数,即最大请求堆积数量。 |

| leaderServes | 该参数有默认值:yes,可以不配置,可选配置项为“yes”和“no’仅支特系统属性方式配置:zookeeper.eaderServes.该参数用于配置Leader服务器是否能够接受客户端的连接,即是否允许Leader向客户端提供服务,默认情况下,Leader服务器能够接受并处理客户端的所有读写请求。在ZooKeeper的架构设计中,Leader服务器主要用来进行对事务更新请求的协调以及集群本身的运行时协调,因此,可以设置让Leader服务器不接受客户端的连接,以使其专注于进行分布式协调。 |

| SkipAcl | 该参数有默认值:no,可以不配置,可选配置项为“yes”和“no” 仅支持系統属性方式配置:zookceper.skipACL,该参数用于配置ZooKeeper服务器是否跳过ACL权限检查,默认情况下是“no”,即会对每一个客户端请求进行权限检查。如果将共设置为“yes”,则能一定程度的提高ZooKeeper的读写性能,但同时也将向所有客户端开放ZooKeeper的数据,包括那些之前设置过ACL权限的数据节点,也将不再接受权限限制。 |

| cnxTimeout | 也将不再接受权限限制。该参数有默认值:5000,单位是毫秒,可以不配置,仅支特系统属性方式配置:zookeeper.cnxTimeout。该参数用于配置在Leader选举过程中,各服务器之间进行TCP连接创建的超时时间。 |

| electionAlg | 在之前的版本中,可以使用该参数来配置选择Zookeeper进行Leader选举时所使用的算法,但从3.4.0版本开始,Zookceper废弃了其它选举算法,只留下了FastLeaderElection算法,因此该参数目/前看未没有用了,这里也不详细展开说了 |

parseProperties()方法的主要目的是将zoo.cfg配置文件中的属性解析并保存到QuorumPeerConfig的属性中,以备后用,在方法的后续部分主要是对参数的较验,而参数具体如何使用,在后续的源码分析中再来回顾 。 在parse()方法中还有一分部没有分析,就是dynamicConfigFile配置文件的解析,而dynamicConfigFile有什么用呢?

在zookeeper 3.5.0版本之前,其配置不支持动态加载,只能通过重启加载新配置。因此在老版本中如果要对zk集群进行扩缩容,需要滚动重启集群中所有节点,以使新的配置生效。而在zookeeper 3.5.0版本之后(包含3.5.0),引入了动态配置的特性,即zk节点运行时可动态加载zk成员配置,这样可在保持数据一致性的同时不会中断业务。

总结起来,zk动态配置可解决之前zk集群日常扩缩容过程中的如下痛点:

- zk集群短时间内不可用:zk节点滚动重启导致重新选举,选举周期内zk集群对外不可用;

- 依赖zk client端重连:zk节点滚动重启导致已建立的客户端连接被断开,客户端需主动重连其他节点;

- 扩缩容过程繁琐易出错:在静态配置版本下,扩容操作包括:配置新节点、启动新节点、配置老节点、滚动重启老节点。操作繁琐,步骤冗长,依赖人工容易出错。

这里就不对dynamicConfigFile的使用做更深入的介绍,在真正的解析这一部分源码时再来做分析,如果有兴趣,可以去看看这篇博客 zookeeper动态配置应用 。

接下来看启动定时任务,对过期的快照,执行删除(默认该功能关闭),创建并启动历史文件清理器 DatadirCleanupManager。

DatadirCleanupManager purgeMgr = new DatadirCleanupManager(config.getDataDir(), config.getDataLogDir(), config.getSnapRetainCount(), config.getPurgeInterval());

purgeMgr.start();

先来看DatadirCleanupManager的构造方法 。

public DatadirCleanupManager(File snapDir, File dataLogDir, int snapRetainCount,

int purgeInterval) {

// 顾名思义就是zookeeper保存数据的目录,默认情况下zookeeper将写数据的日志文件也保存在这个目录里;

// zk用于保存内存数据库的快照的目录,除非设置了dataLogDir,否则这个目录也用来保存更新数据库的事务日志。在生产环境使用的zk集群,强烈建议设置dataLogDir,

// 让dataDir只存放快照,因为写快照的开销很低,这样dataDir就可以和其他日志目录的挂载点放在一起。

this.snapDir = snapDir;

// zk的事务日志路径

this.dataLogDir = dataLogDir;

// 3.4.0及之后版本zk提供了自动清理快照文件和事务日志文件的功能,该参数指定了保留文件的个数,默认为3,这里我设置为10.

this.snapRetainCount = snapRetainCount;

// 和上一个参数配合使用,设置自动清理的频率,单位为小时,默认为0表示不清理,建议设为6或12之类的值。如果设置了48,意思是48小时自动清理一次。

this.purgeInterval = purgeInterval;

LOG.info("autopurge.snapRetainCount set to " + snapRetainCount);

LOG.info("autopurge.purgeInterval set to " + purgeInterval);

}

注意snapDir,dataLogDir,snapRetainCount,purgeInterval四个参数的含义,接下来看DatadirCleanupManager的start()方法的实现逻辑 。

public void start() {

// 如果purgeTaskStatus被设置为STARTED,则打印Purge 任务已经启动,并返回

if (PurgeTaskStatus.STARTED == purgeTaskStatus) {

LOG.warn("Purge task is already running.");

return;

}

// Don't schedule the purge task with zero or negative purge interval.

// 默认情况下purgeInterval=0 ,该任务关闭, 直接返回

if (purgeInterval = 0) {

LOG.info("Purge task is not scheduled.");

return;

}

// 创建一个定时器

timer = new Timer("PurgeTask", true);

// 创建一个清理快照任务

TimerTask task = new PurgeTask(dataLogDir, snapDir, snapRetainCount);

// 如果purgeInterval设置的值是1 , 表示1小时检查一次,判断是否有过期快照,有则删除

timer.scheduleAtFixedRate(task, 0, TimeUnit.HOURS.toMillis(purgeInterval));

purgeTaskStatus = PurgeTaskStatus.STARTED;

}

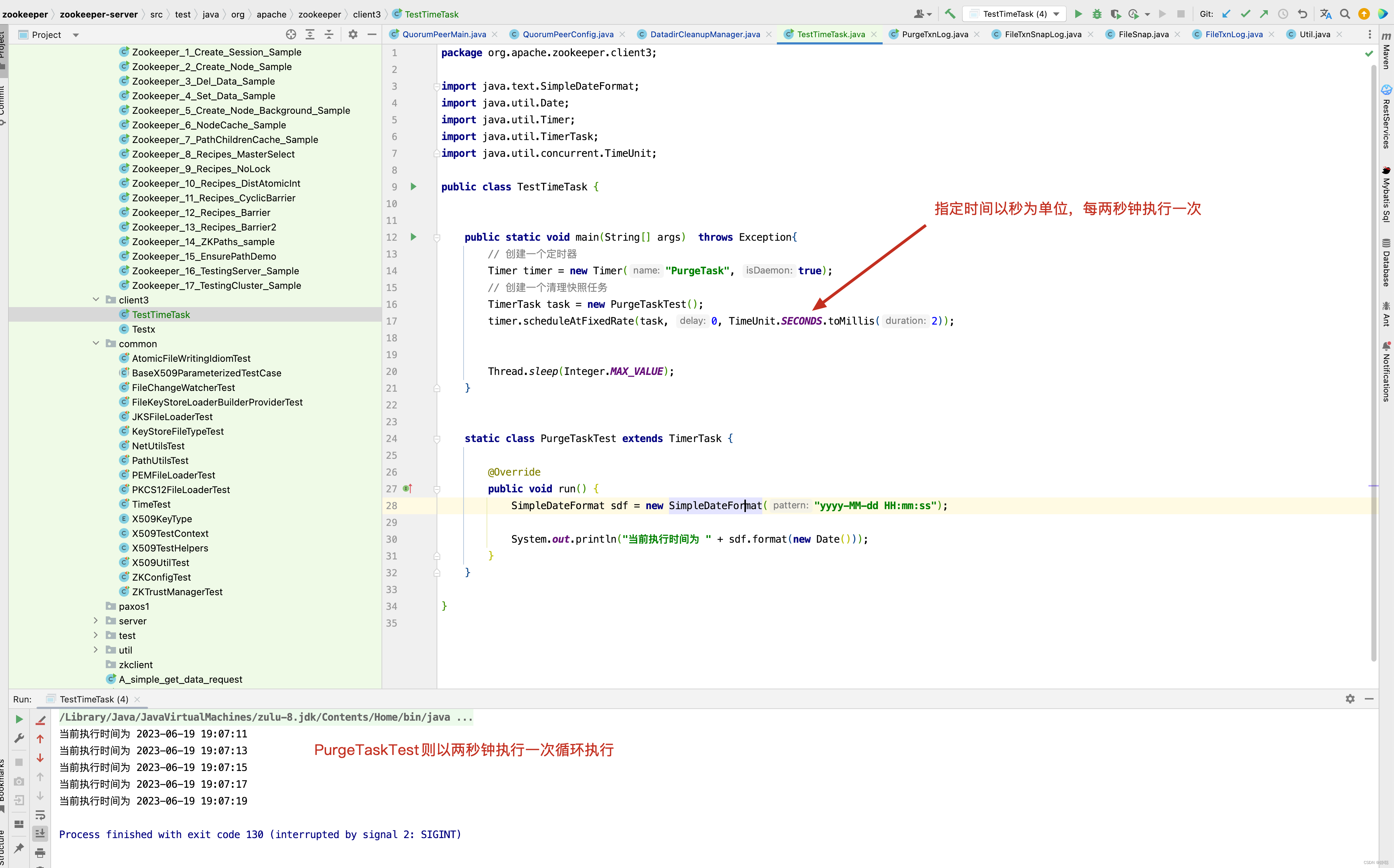

对于创建一个定时器的使用,如果有小伙伴比较迷惑,请看一个例子。

从上面的例子中,我们知道,如果在zoo.cfg文件中指定了autopurge.purgeInterval,则以purgeInterval小时为单位执行PurgeTask的run()方法,接下来进入PurgeTask的run()方法,看它做了哪些事情 。

static class PurgeTask extends TimerTask {

private File logsDir;

private File snapsDir;

private int snapRetainCount;

public PurgeTask(File dataDir, File snapDir, int count) {

logsDir = dataDir;

snapsDir = snapDir;

snapRetainCount = count;

}

@Override

public void run() {

LOG.info("Purge task started.");

try {

// 清理过期的数据

PurgeTxnLog.purge(logsDir, snapsDir, snapRetainCount);

} catch (Exception e) {

LOG.error("Error occurred while purging.", e);

}

LOG.info("Purge task completed.");

}

}

接下来看清理过期数据的具体实现。

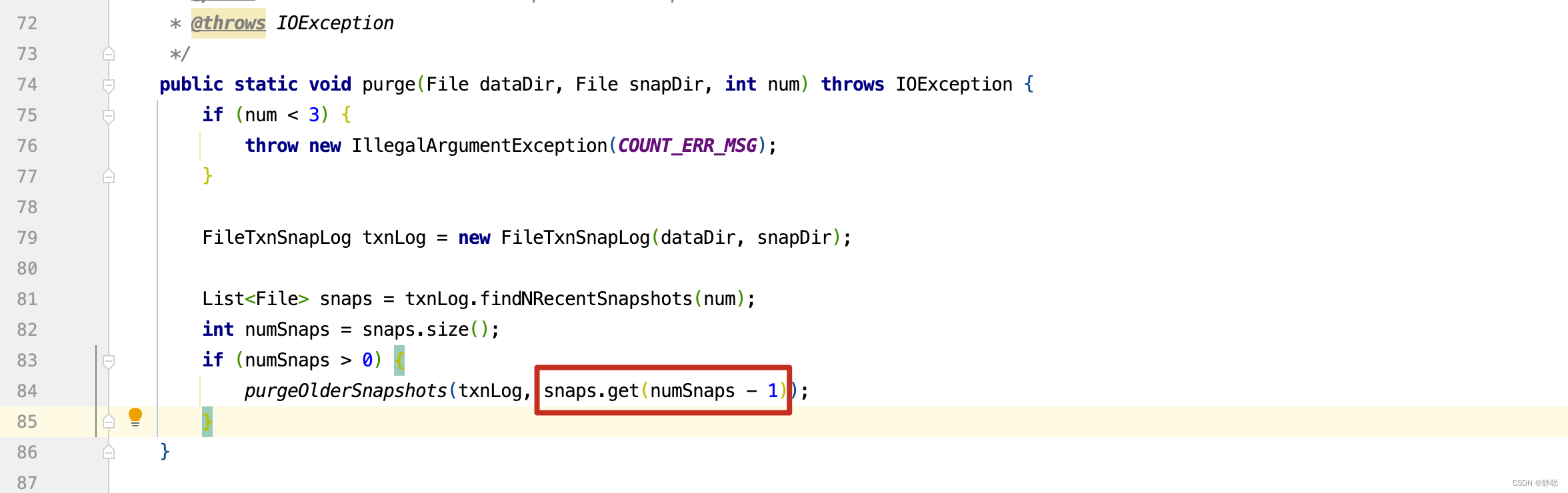

public static void purge(File dataDir, File snapDir, int num) throws IOException {

if (num < 3) {

throw new IllegalArgumentException(COUNT_ERR_MSG);

}

FileTxnSnapLog txnLog = new FileTxnSnapLog(dataDir, snapDir);

ListFile> snaps = txnLog.findNRecentSnapshots(num);

int numSnaps = snaps.size();

if (numSnaps > 0) {

purgeOlderSnapshots(txnLog, snaps.get(numSnaps - 1));

}

}

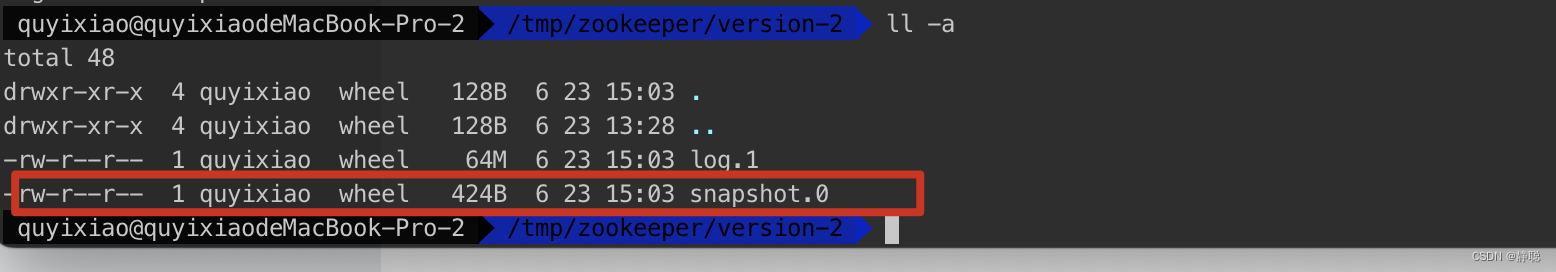

先看FileTxnSnapLog的构造函数。

public FileTxnSnapLog(File dataDir, File snapDir) throws IOException {

LOG.debug("Opening datadir:{} snapDir:{}", dataDir, snapDir);

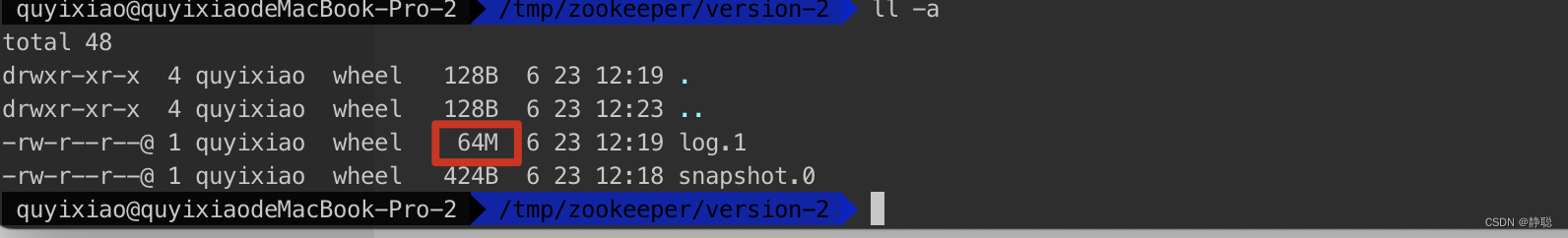

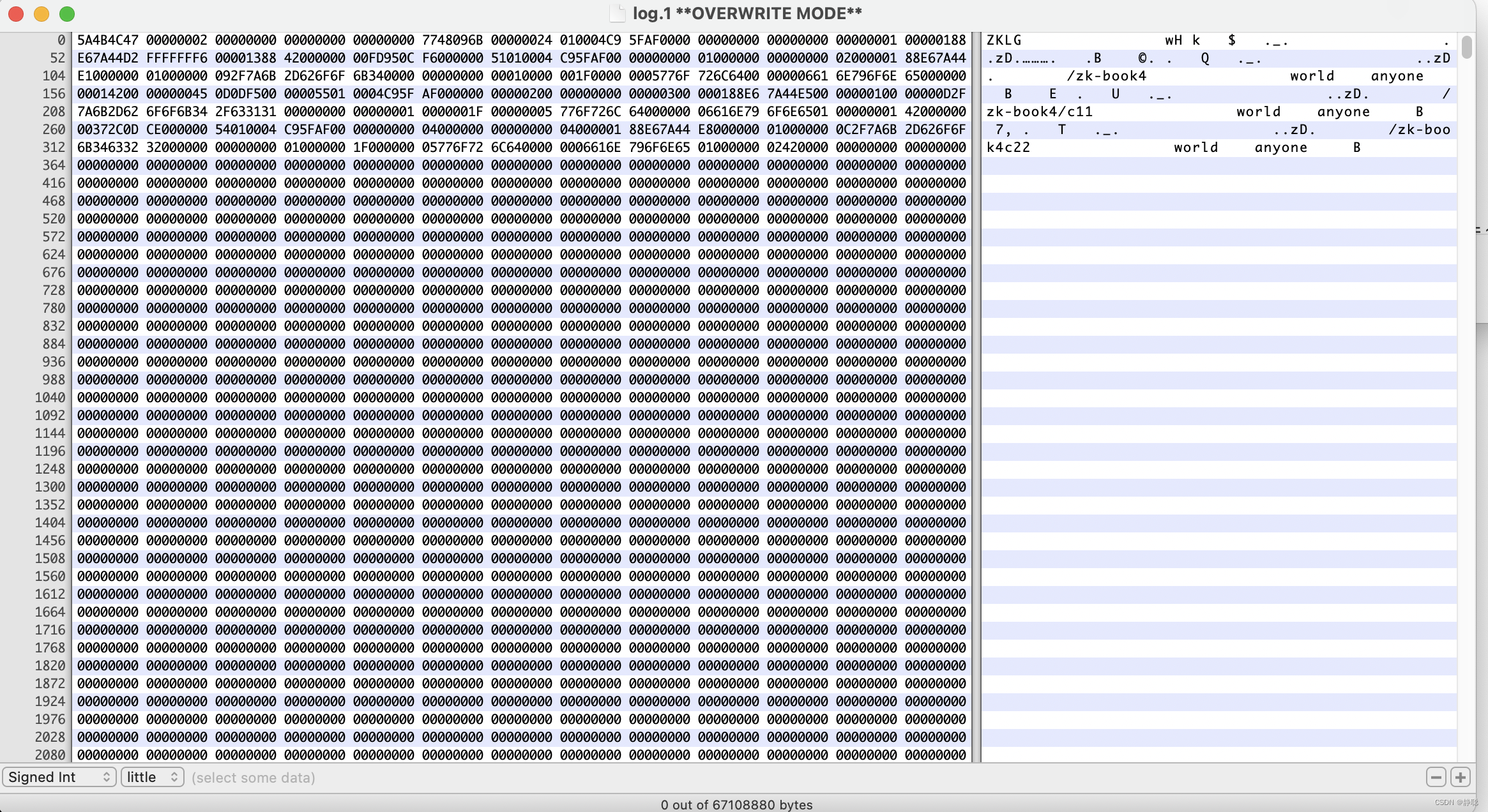

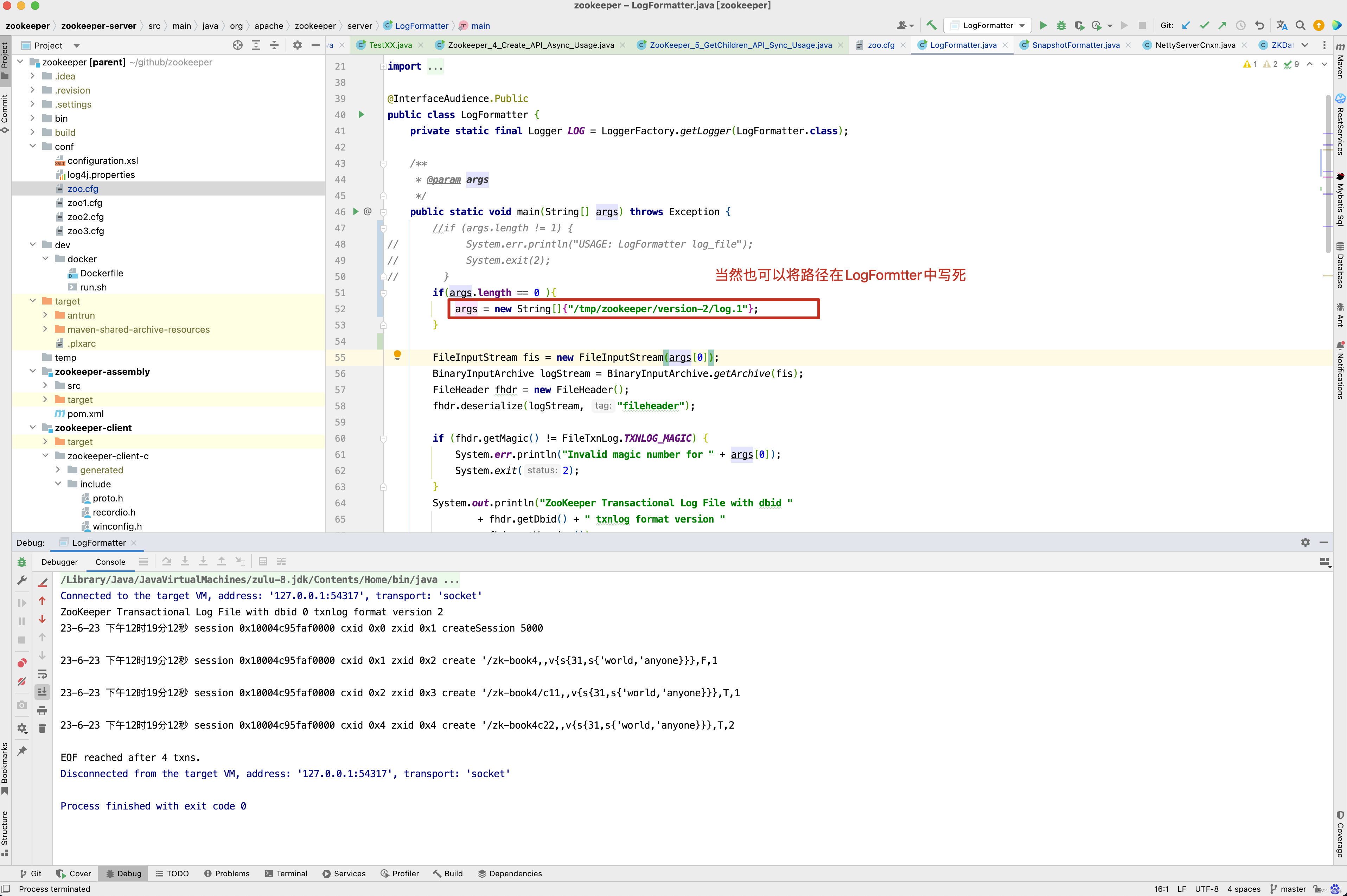

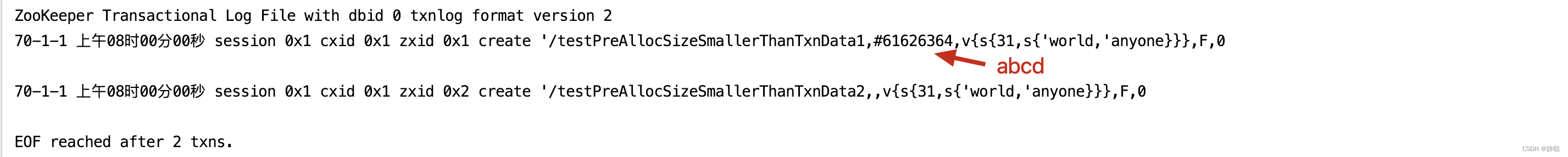

this.dataDir = new File(dataDir, "version-2");

this.snapDir = new File(snapDir, "version-2");

// by default create snap/log dirs, but otherwise complain instead

// See ZOOKEEPER-1161 for more details

boolean enableAutocreate = Boolean.valueOf(

System.getProperty("zookeeper.datadir.autocreate", true));

trustEmptySnapshot = Boolean.getBoolean("zookeeper.snapshot.trust.empty");

LOG.info( "zookeeper.snapshot.trust.empty : " + trustEmptySnapshot);

// 如果dataDir不存在,并且不能够自动创建目录,则抛出异常

if (!this.dataDir.exists()) {

if (!enableAutocreate) {

throw new DatadirException("Missing data directory "

+ this.dataDir

+ ", automatic data directory creation is disabled ("

+ ZOOKEEPER_DATADIR_AUTOCREATE

+ " is false). Please create this directory manually.");

}

// 如果创建目录失败,或者创建目录之后,但目录不存在

if (!this.dataDir.mkdirs() && !this.dataDir.exists()) {

throw new DatadirException("Unable to create data directory "

+ this.dataDir);

}

}

// 如果目录不能写,则抛出异常

if (!this.dataDir.canWrite()) {

throw new DatadirException("Cannot write to data directory " + this.dataDir);

}

// 如果snapDir目录不存在并且不能创建新的目录 ,则抛出异常

if (!this.snapDir.exists()) {

// by default create this directory, but otherwise complain instead

// See ZOOKEEPER-1161 for more details

if (!enableAutocreate) {

throw new DatadirException("Missing snap directory "

+ this.snapDir

+ ", automatic data directory creation is disabled ("

+ ZOOKEEPER_DATADIR_AUTOCREATE

+ " is false). Please create this directory manually.");

}

// 如果snapDir目录创建失败,并且 snapDir 目录不存在,则抛出异常

if (!this.snapDir.mkdirs() && !this.snapDir.exists()) {

throw new DatadirException("Unable to create snap directory "

+ this.snapDir);

}

}

// 如果snap目录不能写,则抛出异常

if (!this.snapDir.canWrite()) {

throw new DatadirException("Cannot write to snap directory " + this.snapDir);

}

// check content of transaction log and snapshot dirs if they are two different directories

// See ZOOKEEPER-2967 for more details

// 如果dataDir 目录和 snapDir 的路径不相等

if (!this.dataDir.getPath().equals(this.snapDir.getPath())) {

// 如果dataDir目录下包含以snapshot开头的文件,则抛出异常

checkLogDir();

// 如果snapDir目录中包含以log开头的文件,则抛出异常

checkSnapDir();

}

txnLog = new FileTxnLog(this.dataDir);

snapLog = new FileSnap(this.snapDir);

}

private void checkLogDir() throws LogDirContentCheckException {

File[] files = this.dataDir.listFiles(new FilenameFilter() {

@Override

public boolean accept(File dir, String name) {

return Util.isSnapshotFileName(name);

}

});

if (files != null && files.length > 0) {

throw new LogDirContentCheckException("Log directory has snapshot files. Check if dataLogDir and dataDir configuration is correct.");

}

}

public static boolean isLogFileName(String fileName) {

return fileName.startsWith( "log.");

}

接下来看构造函数FileTxnLog和FileSnap的实现。

public FileTxnLog(File logDir) {

this.logDir = logDir;

}

public FileSnap(File snapDir) {

this.snapDir = snapDir;

}

接下来看快照查询方法findNRecentSnapshots()。

public List<File> findNRecentSnapshots(int n) throws IOException {

FileSnap snaplog = new FileSnap(snapDir);

return snaplog.findNRecentSnapshots(n);

}

public List<File> findNRecentSnapshots(int n) throws IOException {

List<File> files = Util.sortDataDir(snapDir.listFiles(), "snapshot", false);

int count = 0;

List<File> list = new ArrayList<File>();

for (File f : files) {

if (count == n)

break;

if (Util.getZxidFromName(f.getName(), "snapshot") != -1) {

count++;

list.add(f);

}

}

return list;

}

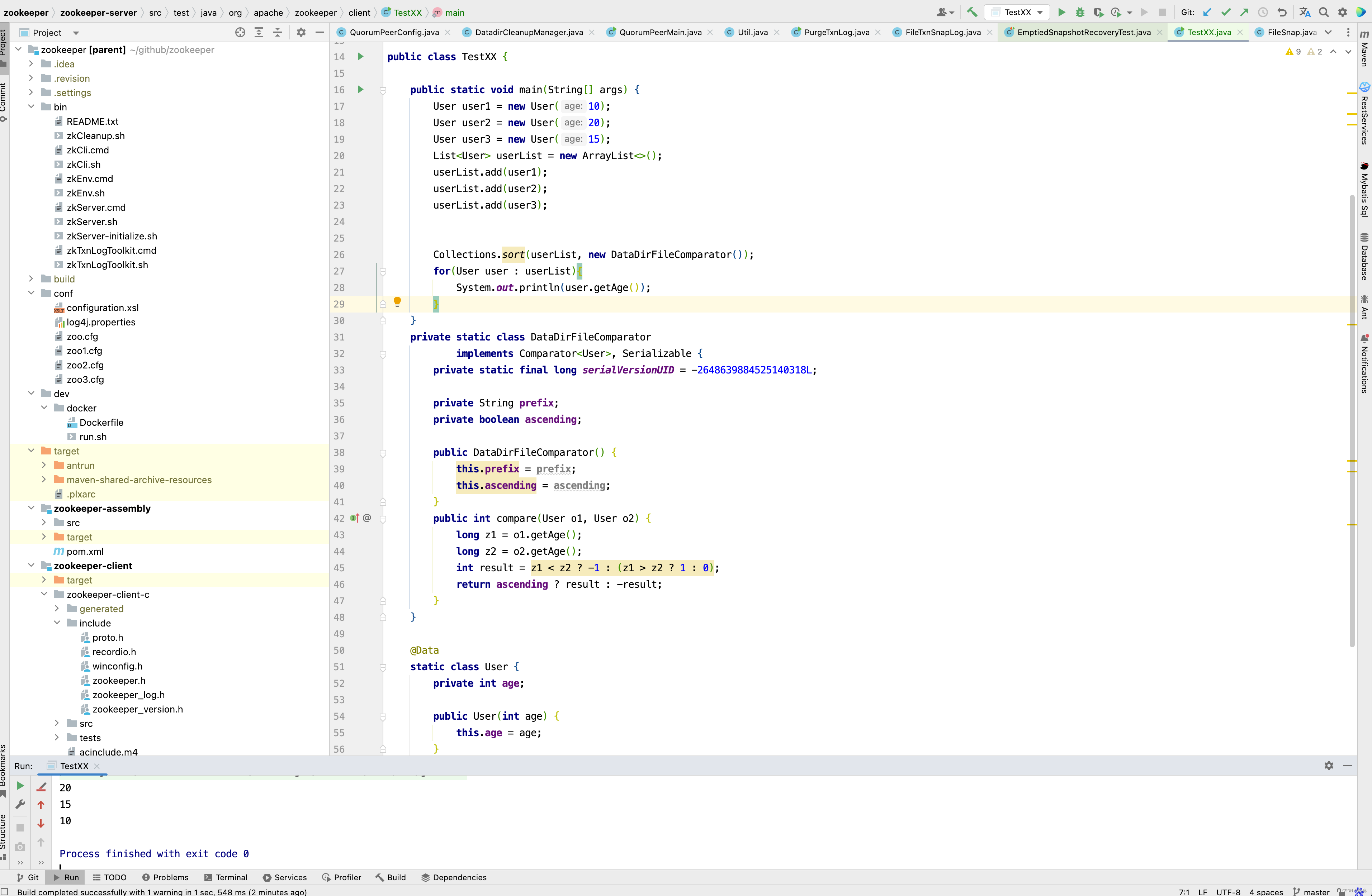

首先排序获取snapDir目录下所有的文件,并且只取前面n个。 而n个又是从哪里来的呢?

来源于QuorumPeerConfig中的snapRetainCount字段,而snapRetainCount我们又可以在zoo.cfg中的autopurge.snapRetainCount这个参数配置,接下来看sortDataDir()方法的内部实现。

public static List<File> sortDataDir(File[] files, String prefix, boolean ascending) {

if (files == null)

return new ArrayList<File>(0);

List<File> filelist = Arrays.asList(files);

Collections.sort(filelist, new DataDirFileComparator(prefix, ascending));

return filelist;

}

在sortDataDir()方法中,有一个很重要的方法就是sort(),而sort()方法又是通过DataDirFileComparator比较器来进行比对的。

private static class DataDirFileComparator

implements Comparator<File>, Serializable {

private static final long serialVersionUID = -2648639884525140318L;

private String prefix;

private boolean ascending;

public DataDirFileComparator(String prefix, boolean ascending) {

this.prefix = prefix;

this.ascending = ascending;

}

public int compare(File o1, File o2) {

long z1 = Util.getZxidFromName(o1.getName(), prefix);

long z2 = Util.getZxidFromName(o2.getName(), prefix);

int result = z1 < z2 ? -1 : (z1 > z2 ? 1 : 0);

return ascending ? result : -result;

}

}

public static long getZxidFromName(String name, String prefix) {

long zxid = -1;

String nameParts[] = name.split("\\.");

if (nameParts.length == 2 && nameParts[0].equals(prefix)) {

try {

zxid = Long.parseLong(nameParts[1], 16);

} catch (NumberFormatException e) {

}

}

return zxid;

}

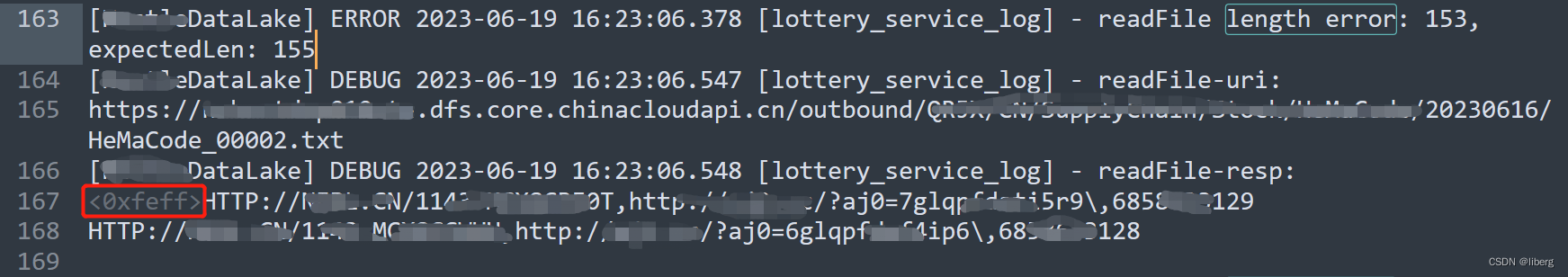

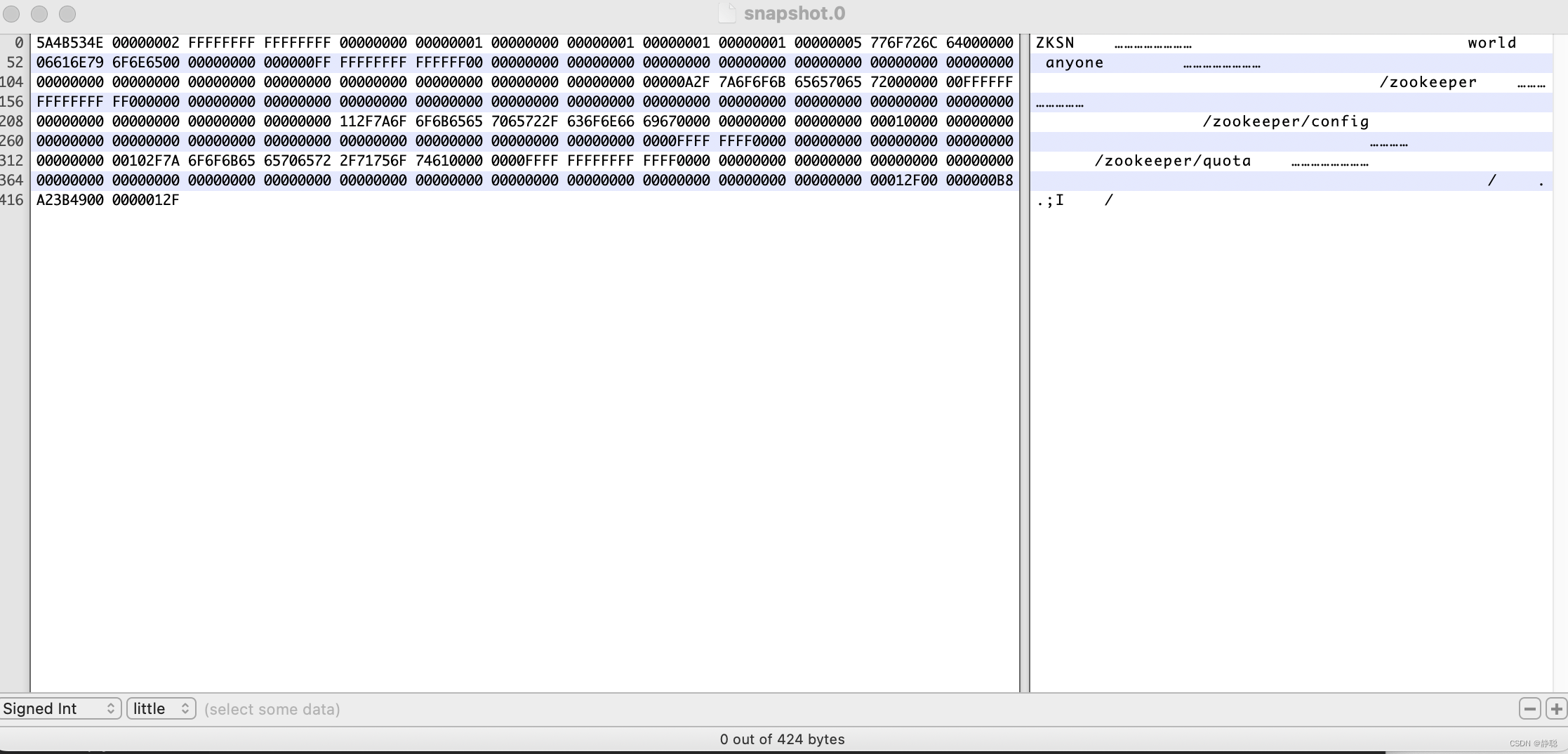

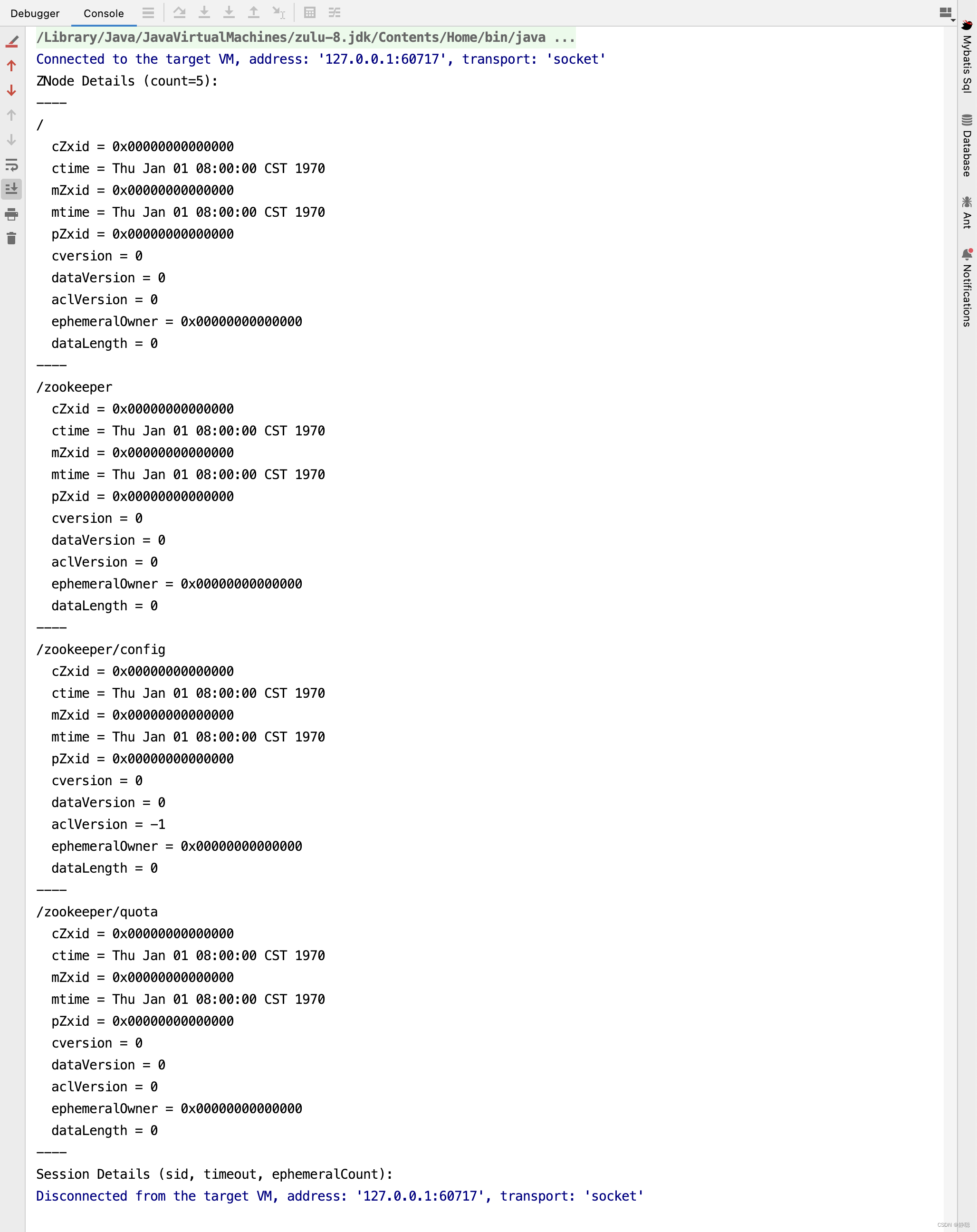

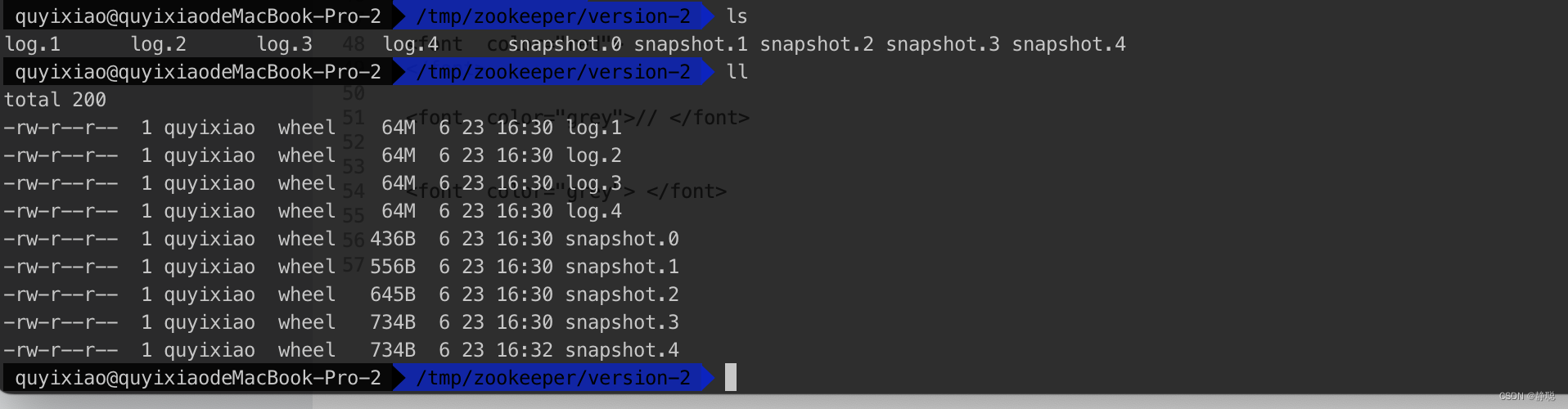

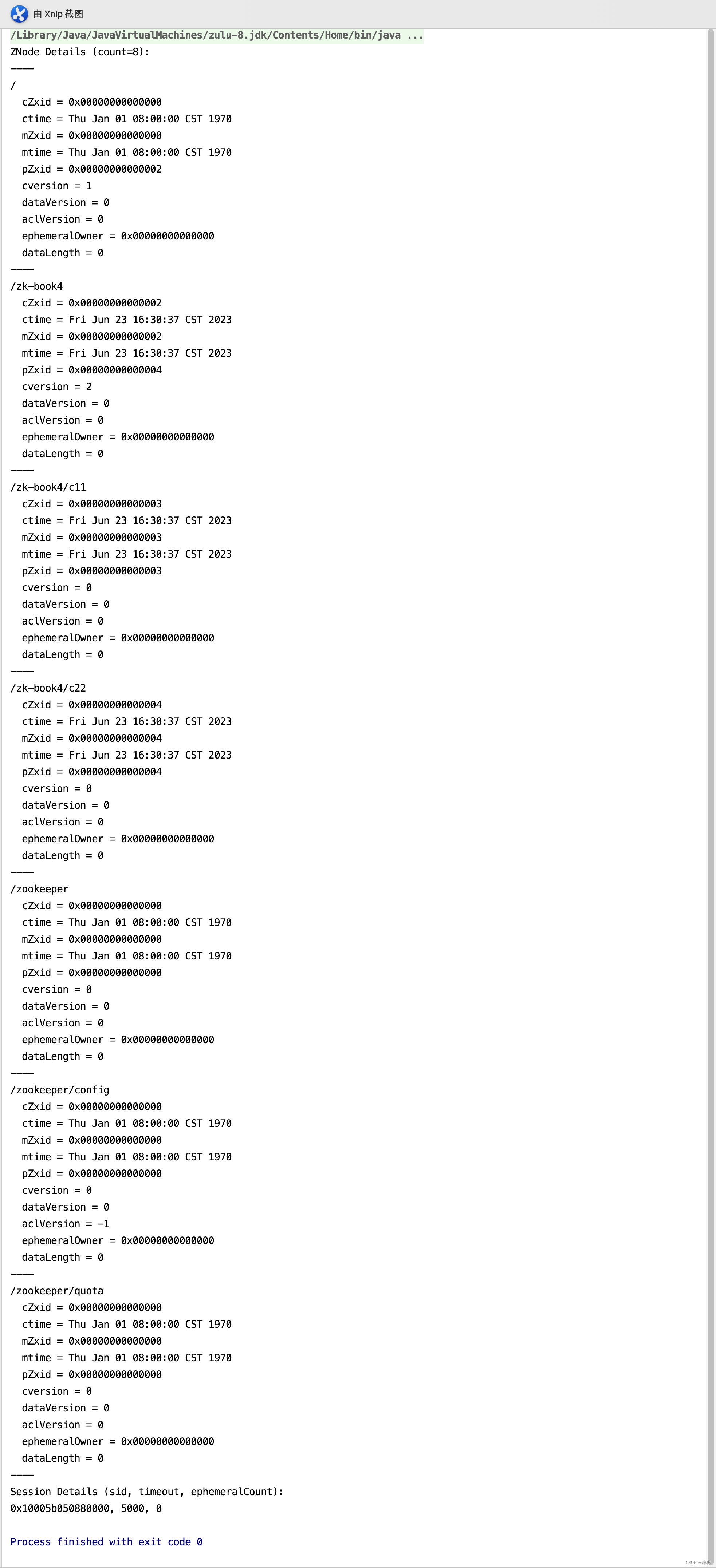

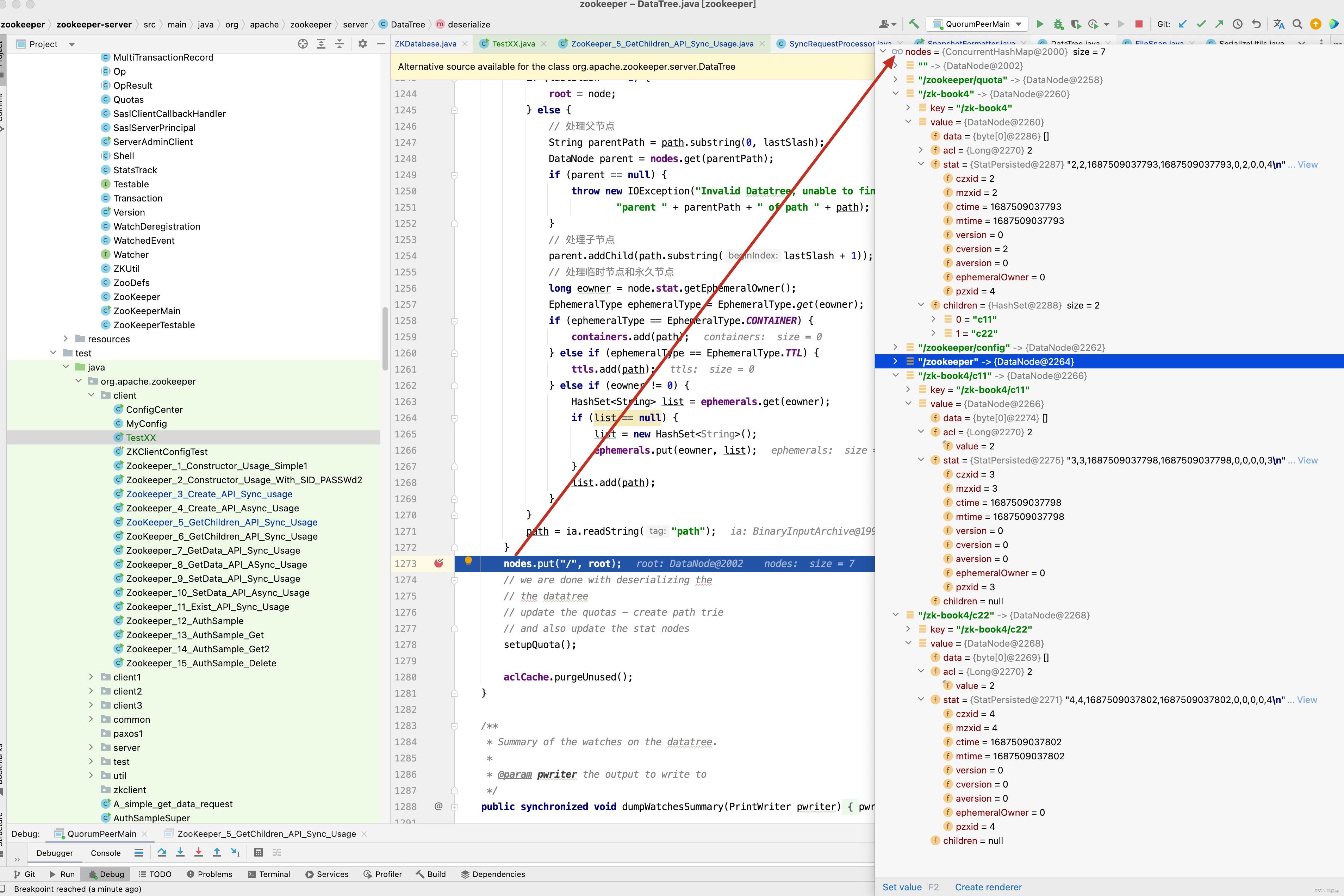

从 DataDirFileComparator 排序可以看出,snapDir目录下的文件以 snapshot开头,后面拼接的是一个 . 加一个long类型的时间戳,最终zxid下的文件格式如下 : snapshot.1687340670178 这种数据结构,而有人可能还是对DataDirFileComparator排序的使用有所迷惑,先来看一个例子。

这个例子的意图也很简单,创建一个User 对象,有一个年龄字段,使用DataDirFileComparator比较器,最终排序得到的list结果是以年龄降序排序。 通过这个例子我们知道了findNRecentSnapshots()方法的意图,就是获取snapDir下以时间降序的最新的几个文件 。 如果获取的文件数大于0,则会调用purgeOlderSnapshots()方法进行处理,接下来进入purgeOlderSnapshots()方法 。

static void purgeOlderSnapshots(FileTxnSnapLog txnLog, File snapShot) {

final long leastZxidToBeRetain = Util.getZxidFromName( snapShot.getName(), "snapshot");

final Set<File> retainedTxnLogs = new HashSet<File>();

retainedTxnLogs.addAll(Arrays.asList(txnLog.getSnapshotLogs(leastZxidToBeRetain)));

/**

* Finds all candidates for deletion, which are files with a zxid in their name that is less

* than leastZxidToBeRetain. There's an exception to this rule, as noted above.

*/

class MyFileFilter implements FileFilter {

private final String prefix;

MyFileFilter(String prefix) {

this.prefix = prefix;

}

public boolean accept(File f) {

if (!f.getName().startsWith(prefix + "."))

return false;

if (retainedTxnLogs.contains(f)) {

return false;

}

long fZxid = Util.getZxidFromName(f.getName(), prefix);

if (fZxid >= leastZxidToBeRetain) {

return false;

}

return true;

}

}

// add all non-excluded log files

File[] logs = txnLog.getDataDir().listFiles(new MyFileFilter(PREFIX_LOG));

List<File> files = new ArrayList<>();

if (logs != null) {

files.addAll(Arrays.asList(logs));

}

// add all non-excluded snapshot files to the deletion list

File[] snapshots = txnLog.getSnapDir().listFiles(new MyFileFilter(PREFIX_SNAPSHOT));

if (snapshots != null) {

files.addAll(Arrays.asList(snapshots));

}

// remove the old files

for (File f : files) {

final String msg = "Removing file: " +

DateFormat.getDateTimeInstance().format(f.lastModified()) +

"\t" + f.getPath();

LOG.info(msg);

System.out.println(msg);

if (!f.delete()) {

System.err.println("Failed to remove " + f.getPath());

}

}

}

要弄清楚purgeOlderSnapshots()方法的含义,先弄明白leastZxidToBeRetain这个值的含义,首先来源于purge()方法,snaps的值取的是snapDir目录下,时间降序排序,且前n个文件。

因此snaps.get(numSnaps - 1) 获取的文件为前n个中,创建时间最早的snap文件,因此leastZxidToBeRetain的值为最新的n个snap文件中创建时间最早的那个文件的时间戳,再来看getSnapshotLogs() 。

public File[] getSnapshotLogs(long zxid) {

return FileTxnLog.getLogFiles(dataDir.listFiles(), zxid);

}

public static File[] getLogFiles(File[] logDirList, long snapshotZxid) {

List<File> files = Util.sortDataDir(logDirList, "log", true);

long logZxid = 0;

// Find the log file that starts before or at the same time as the

// zxid of the snapshot

for (File f : files) {

long fzxid = Util.getZxidFromName(f.getName(), "log");

if (fzxid > snapshotZxid) {

continue;

}

// the files

// are sorted with zxid's

if (fzxid > logZxid) {

logZxid = fzxid;

}

}

List<File> v = new ArrayList<File>(5);

for (File f : files) {

long fzxid = Util.getZxidFromName(f.getName(), "log");

if (fzxid < logZxid) {

continue;

}

v.add(f);

}

return v.toArray(new File[0]);

}

getLogFiles()方法 ,细心的读者看看也很简单,首先logZxid值为在log目录下小于snapshotZxid的最新创建的log文件。 getLogFiles()这个方法的最终目的是将大于snapshotZxid的所有文件以及小于snapshotZxid的最新的一个文件保存到File[]中。 如snapshotZxid文件为11点创建的。 而log 下在 11:01 ,11:02 ,11:03 以及10:59 ,10:58 ,10:57 创始的6个log文件,此时返回的是11:01 ,11:02 ,11:03 ,10:59 这4个文件 。 看懂了getLogFiles()方法,再来看 purgeOlderSnapshots()方法,原理就很简单了,将dataDir和snapDir目录下, 所有的非刚刚筛选出来的文件全部删除掉。 此时再来看snapRetainCount的参数含义就很简单了。 snapRetainCount参数为3.4.0及之后版本zk提供了自动清理快照文件和事务日志文件的功能,该参数指定了保留文件的个数,默认为3,是吧,先筛选出创建时间最近的snapRetainCount个文件,然后将非这些文件全部删除掉。 当然啦。 TimerTask 是一个以小时为单位的定时任务,会定期的执行删除操作。

接下来分两种情况,一种是集群方式的启动,另外一种是单机模式的启动,显然单机模式比集群模式要简单得多,因此我们先来看单机模式,后面再来分析集群模式 。如果分析单机模式,先进入ZooKeeperServerMain的main()方法 。

public static void main(String[] args) {

//InitLog4jConfig();

ZooKeeperServerMain main = new ZooKeeperServerMain();

try {

main.initializeAndRun(args);

} catch (IllegalArgumentException e) {

LOG.error("Invalid arguments, exiting abnormally", e);

LOG.info(USAGE);

System.err.println(USAGE);

System.exit(2);

} catch (ConfigException e) {

LOG.error("Invalid config, exiting abnormally", e);

System.err.println("Invalid config, exiting abnormally");

System.exit(2);

} catch (DatadirException e) {

LOG.error("Unable to access datadir, exiting abnormally", e);

System.err.println("Unable to access datadir, exiting abnormally");

System.exit(3);

} catch (AdminServerException e) {

LOG.error("Unable to start AdminServer, exiting abnormally", e);

System.err.println("Unable to start AdminServer, exiting abnormally");

System.exit(4);

} catch (Exception e) {

LOG.error("Unexpected exception, exiting abnormally", e);

System.exit(1);

}

LOG.info("Exiting normally");

System.exit(0);

}

大家看到没有,ZooKeeperServerMain的main()方法和QuorumPeerMain的main()方法很像,都是调用initializeAndRun()初始化参数并运行。

protected void initializeAndRun(String[] args)

throws ConfigException, IOException, AdminServerException {

try {

// 注册jmx

ManagedUtil.registerLog4jMBeans();

} catch (JMException e) {

LOG.warn("Unable to register log4j JMX control", e);

}

ServerConfig config = new ServerConfig();

// 和之前的解析方法类似,这里就不深入分析,无非就是

// dataDir,dataLogDir,maxClientCnxns等参数的解析与设置

if (args.length == 1) {

config.parse(args[0]);

} else {

config.parse(args);

}

runFromConfig(config);

}

接下来进入runFromConfig()方法 ,看其内部实现。

public void runFromConfig(ServerConfig config) throws IOException, AdminServerException {

LOG.info("Starting server");

FileTxnSnapLog txnLog = null;

try {

// Note that this thread isn't going to be doing anything else,

// so rather than spawning another thread, we will just call

// run() in this thread.

// create a file logger url from the command line args

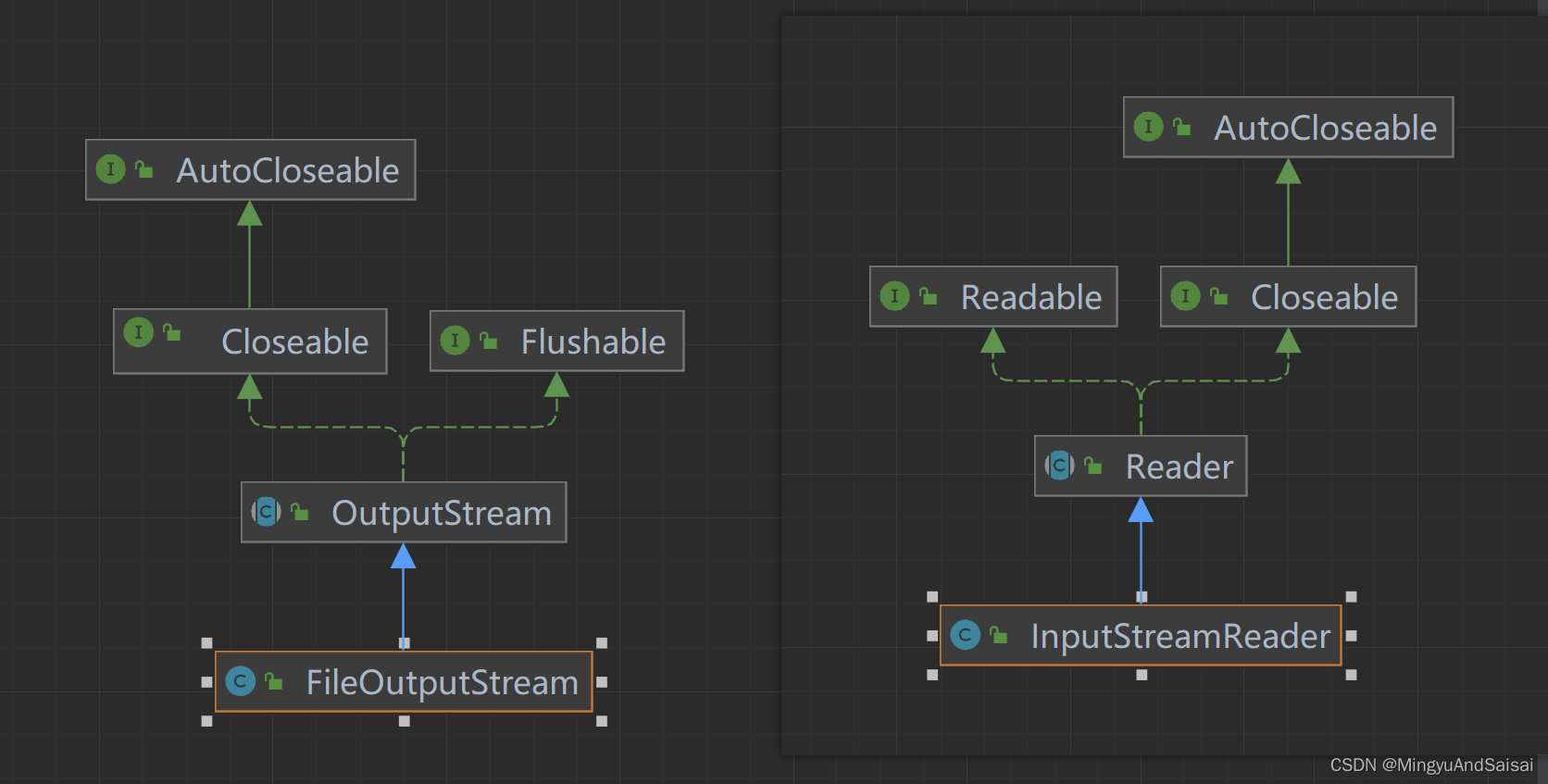

// 创建Zookeeper数据管理器FileTxnSnapLog

// FileTxnSnapLog 是Zookeeper上层服务器和底层数据存储之间的对接层,提供了一系列的操作数据文件的接口,包括事务日志文件和快照数据文件 ,

// Zookeeper根据zoo.cfg文件中的解析出的快照数据目录dataDir和事务日志目录dataLogDir来创建FileTxnSnapLog

// 1. 初始化 FileTxnSnapLog

// FileTxnSnapLog是Zookeeper事务日志和快照数据访问层,用于衔接上层业务与底层数据存储,底层数据包含了事务日志和快照数据两部分

// 因此 , FileTxnSnapLog 内部又分为FileTxnLog和FileSnap的初始化,分别代表事务日志管理器和快照数据管理器的初始化。

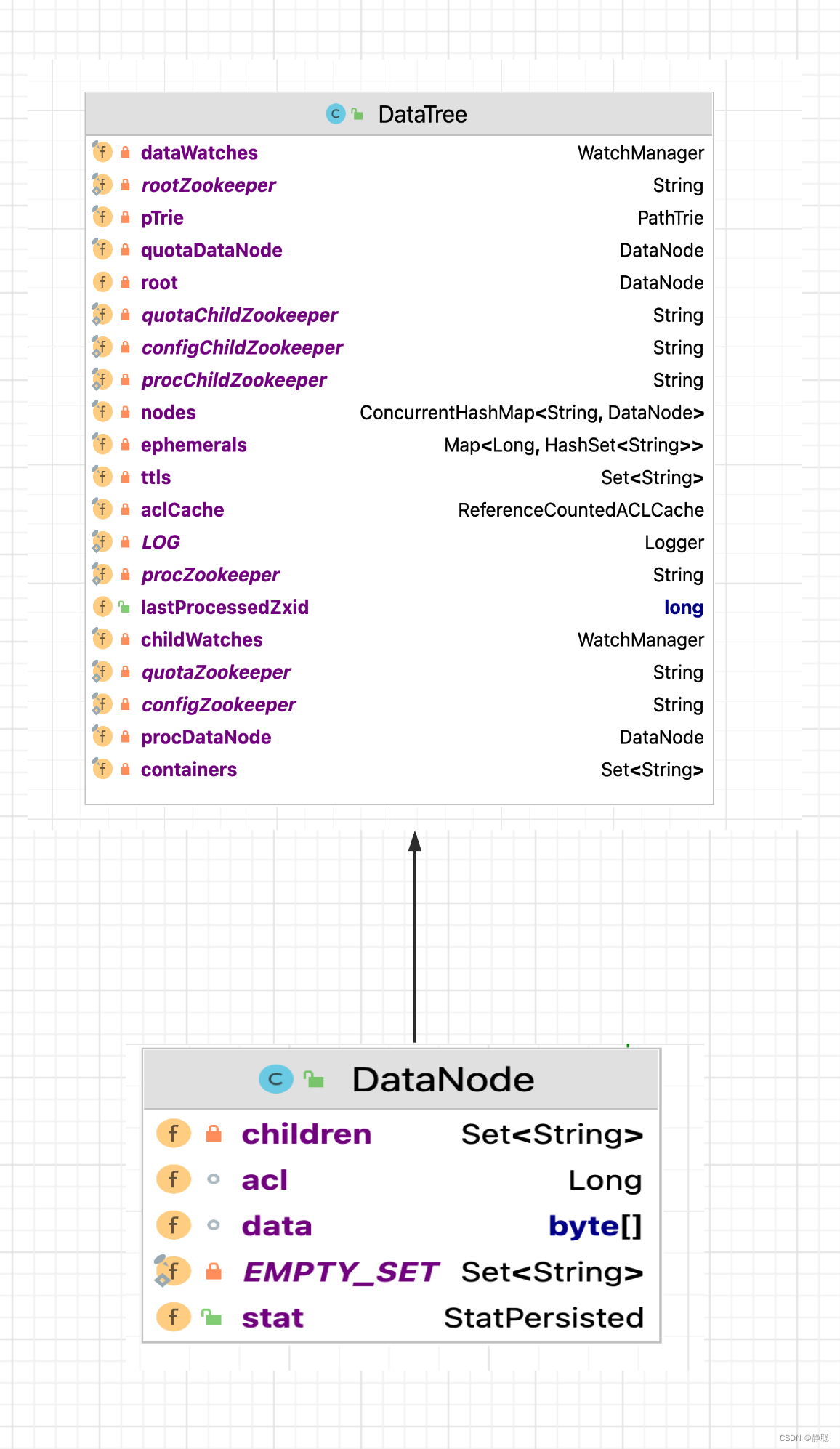

txnLog = new FileTxnSnapLog(config.dataLogDir, config.dataDir);

// ZooKeeperServer 是单机版本Zookeeper服务器最为核心的实体类,Zookeeper服务器首先会进行实例的创建,接下去的步骤

// 则都是对该服务器实例的初始化工作,包括连接器,内存数据库的请求处理等组件的初始化

final ZooKeeperServer zkServer = new ZooKeeperServer(txnLog,

// 3. 设置服务器tickTime 和会话超时限制

config.tickTime, config.minSessionTimeout, config.maxSessionTimeout, null);

// 1. 创建服务器统计器 ServerStats

// ServerStats 是Zookeeper服务器运行时统计器,包含了最基本的运行时信息,如表7-8所示 。

txnLog.setServerStats(zkServer.serverStats());

// Registers shutdown handler which will be used to know the

// server error or shutdown state changes.

final CountDownLatch shutdownLatch = new CountDownLatch(1);

zkServer.registerServerShutdownHandler(new ZooKeeperServerShutdownHandler(shutdownLatch));

// Start Admin server

adminServer = AdminServerFactory.createAdminServer();

adminServer.setZooKeeperServer(zkServer);

adminServer.start();

boolean needStartZKServer = true;

if (config.getClientPortAddress() != null) {

// 4. 创建ServerCnxnFactory

cnxnFactory = ServerCnxnFactory.createFactory();

// 5. Zookeeper首先会初始化一个Thread ,作为整个ServerCnxnFactory的主线程然后再初始化NIO服务器。

cnxnFactory.configure(config.getClientPortAddress(), config.getMaxClientCnxns(), false);

// 6. 启动ServerCnxnFactory

// 启动步骤5中已经初始化的主线程ServerCnxnFactory的主逻辑run()方法 ,需要注意的一点是,虽然这里Zookeeper的NIO

// 服务器已经对外开放端口,客户端能够访问到Zookeeper的客户端服务端2181 , 但此时Zookeeper服务器是无法正常处理客户端请求的。

// 恢复本地数据库 。

cnxnFactory.startup(zkServer);

// zkServer has been started. So we don't need to start it again in secureCnxnFactory.

needStartZKServer = false;

}

if (config.getSecureClientPortAddress() != null) {

secureCnxnFactory = ServerCnxnFactory.createFactory();

secureCnxnFactory.configure(config.getSecureClientPortAddress(), config.getMaxClientCnxns(), true);

// 在步骤6中,Zookeeper已经将ServerCnxnFactory 主线程启动,但是同时我们提出到此时Zookeeper依旧无法处理客户端的请求

// 原因就是此时网络尚不能够访问Zookeeper服务器实例, 在经过后续的步骤的初始化之后,Zookeeper服务器实例已经初始化完毕

// 只需要注册给ServerCnxnFactory 即可, 之后,Zookeeper就可以对外提供正常的服务了。

secureCnxnFactory.startup(zkServer, needStartZKServer);

}

containerManager = new ContainerManager(zkServer.getZKDatabase(), zkServer.firstProcessor,

Integer.getInteger("znode.container.checkIntervalMs", (int) TimeUnit.MINUTES.toMillis(1)),

Integer.getInteger("znode.container.maxPerMinute", 10000)

);

containerManager.start();

// Watch status of ZooKeeper server. It will do a graceful shutdown

// if the server is not running or hits an internal error.

shutdownLatch.await();

shutdown();

if (cnxnFactory != null) {

cnxnFactory.join();

}

if (secureCnxnFactory != null) {

secureCnxnFactory.join();

}

if (zkServer.canShutdown()) {

zkServer.shutdown(true);

}

} catch (InterruptedException e) {

// warn, but generally this is ok

LOG.warn("Server interrupted", e);

} finally {

if (txnLog != null) {

txnLog.close();

}

}

}

这个方法很复杂,但我们可以一个一个来分析,首先来看AdminServer 的启动。

public static AdminServer createAdminServer() {

if (!"false".equals(System.getProperty("zookeeper.admin.enableServer"))) {

try {

Class<?> jettyAdminServerC = Class.forName("org.apache.zookeeper.server.admin.JettyAdminServer");

Object adminServer = jettyAdminServerC.getConstructor().newInstance();

return (AdminServer) adminServer;

} catch (ClassNotFoundException e) {

LOG.warn("Unable to start JettyAdminServer", e);

} catch (InstantiationException e) {

LOG.warn("Unable to start JettyAdminServer", e);

} catch (IllegalAccessException e) {

LOG.warn("Unable to start JettyAdminServer", e);

} catch (InvocationTargetException e) {

LOG.warn("Unable to start JettyAdminServer", e);

} catch (NoSuchMethodException e) {

LOG.warn("Unable to start JettyAdminServer", e);

} catch (NoClassDefFoundError e) {

LOG.warn("Unable to load jetty, not starting JettyAdminServer", e);

}

}

return new DummyAdminServer();

}

在这里,可以看出,ZooKeeper启动时,默认会调用JettyAdminServer的构造函数 。

public static final int DEFAULT_PORT = 8080;

public static final int DEFAULT_IDLE_TIMEOUT = 30000;

public static final String DEFAULT_COMMAND_URL = "/commands";

private static final String DEFAULT_ADDRESS = "0.0.0.0";

public JettyAdminServer() {

this(System.getProperty("zookeeper.admin.serverAddress", DEFAULT_ADDRESS),

Integer.getInteger("zookeeper.admin.serverPort", DEFAULT_PORT),

Integer.getInteger("zookeeper.admin.idleTimeout", DEFAULT_IDLE_TIMEOUT),

System.getProperty("zookeeper.admin.commandURL", DEFAULT_COMMAND_URL));

}

public JettyAdminServer(String address, int port, int timeout, String commandUrl) {

this.port = port;

this.idleTimeout = timeout;

this.commandUrl = commandUrl;

this.address = address;

server = new Server();

ServerConnector connector = new ServerConnector(server);

connector.setHost(address);

connector.setPort(port);

connector.setIdleTimeout(idleTimeout);

server.addConnector(connector);

ServletContextHandler context = new ServletContextHandler(ServletContextHandler.SESSIONS);

context.setContextPath("/*");

server.setHandler(context);

context.addServlet(new ServletHolder(new CommandServlet()), commandUrl + "/*");

}

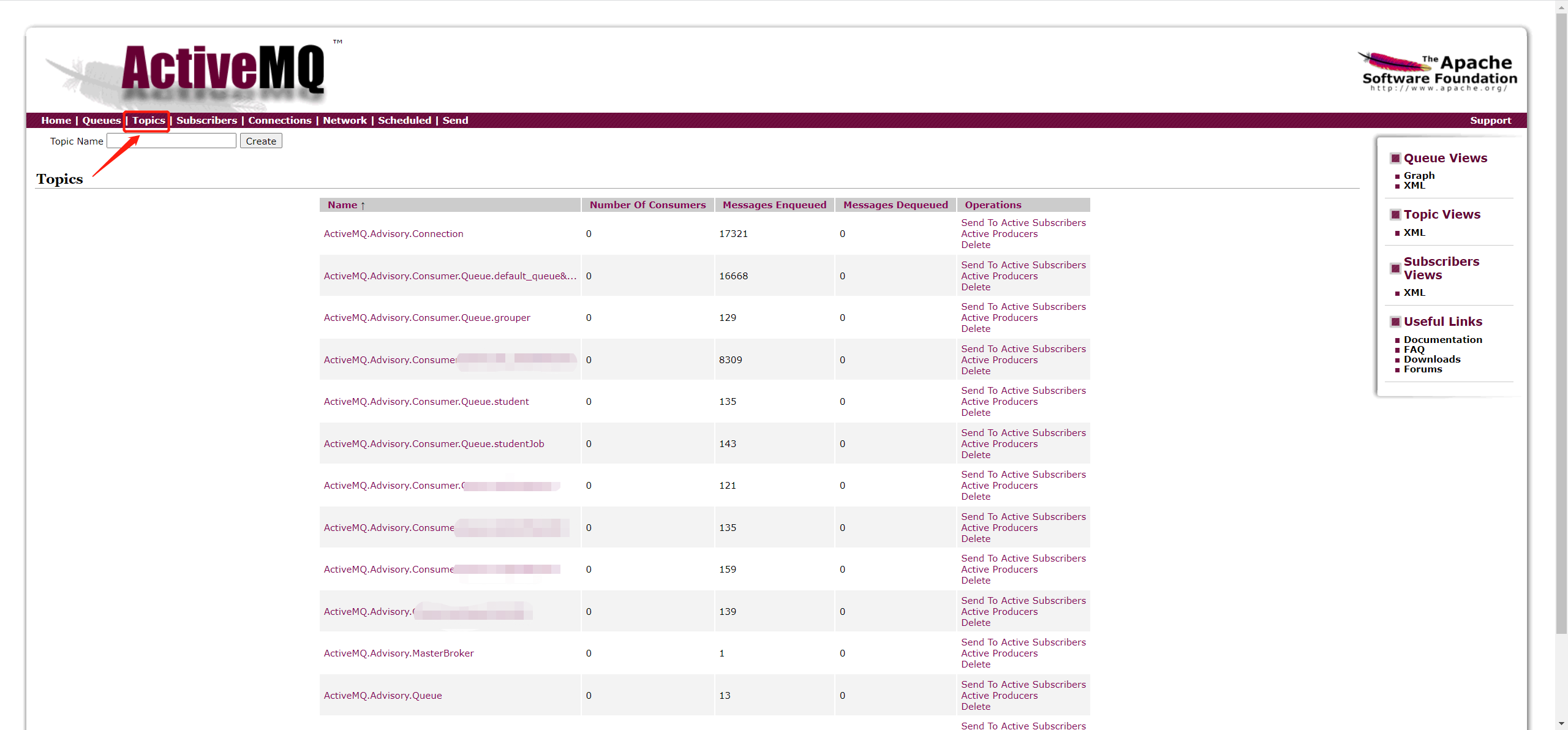

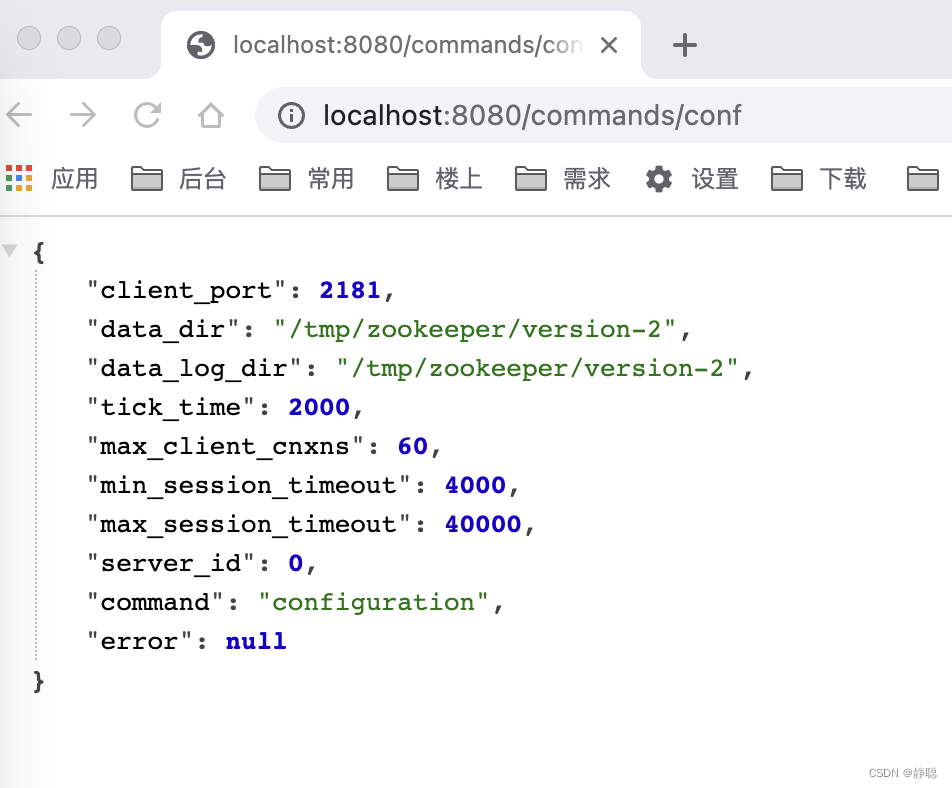

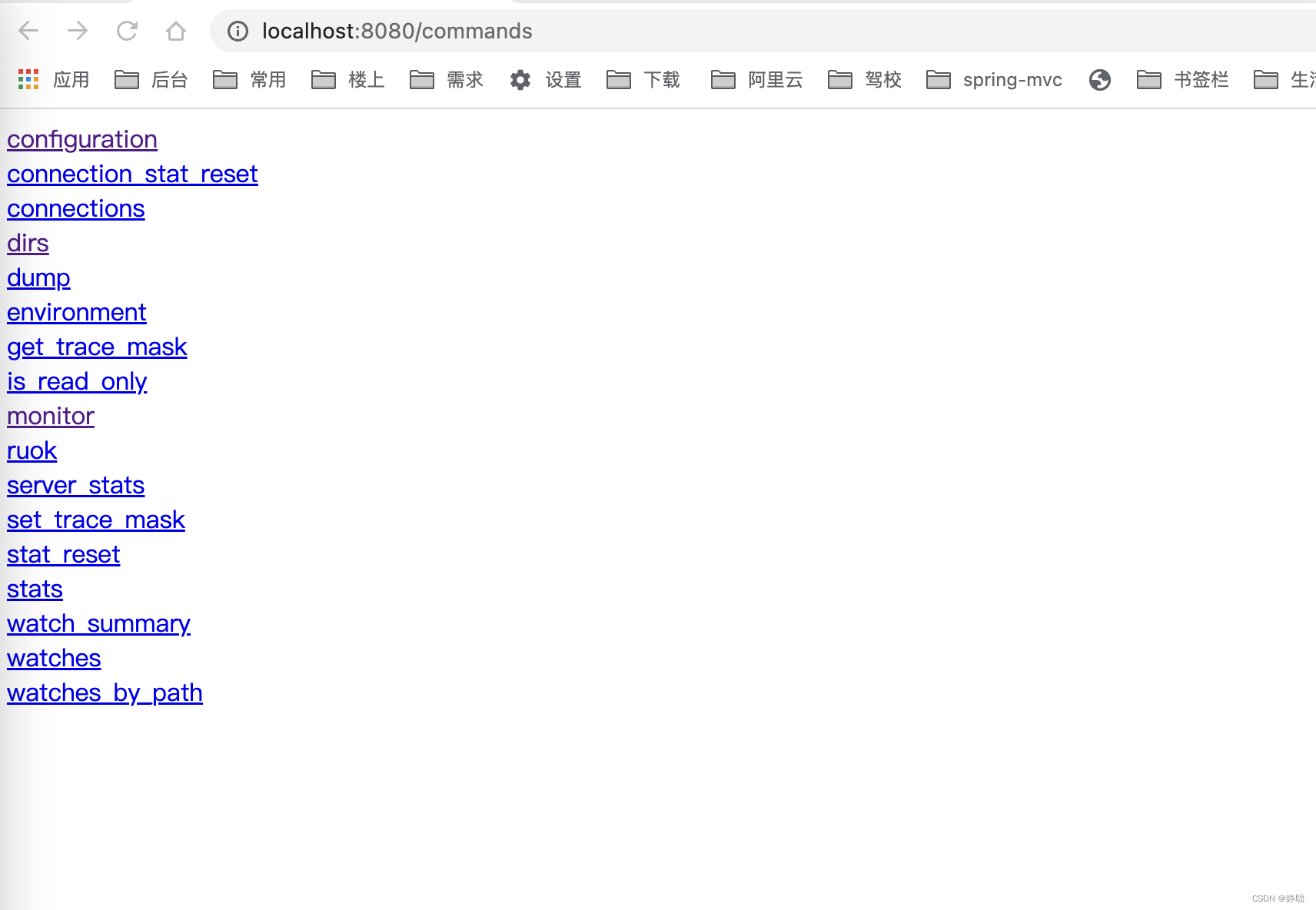

从上面的代码来看,会启动一个ServerConnector,默认监听8080端口,对所有http://localhost:8080/commands/*请求由 CommandServlet 来处理。

private class CommandServlet extends HttpServlet {

private static final long serialVersionUID = 1L;

protected void doGet(HttpServletRequest request, HttpServletResponse response) throws ServletException, IOException {

// Capture the command name from the URL

String cmd = request.getPathInfo();

if (cmd == null || cmd.equals("/")) {

// No command specified, print links to all commands instead

for (String link : commandLinks()) {

response.getWriter().println(link);

response.getWriter().println("<br/>");

}

return;

}

// Strip leading "/"

cmd = cmd.substring(1);

// Extract keyword arguments to command from request parameters

@SuppressWarnings("unchecked")

Map<String, String[]> parameterMap = request.getParameterMap();

Map<String, String> kwargs = new HashMap<String, String>();

for (Map.Entry<String, String[]> entry : parameterMap.entrySet()) {

kwargs.put(entry.getKey(), entry.getValue()[0]);

}

// Run the command

CommandResponse cmdResponse = Commands.runCommand(cmd, zkServer, kwargs);

// Format and print the output of the command

CommandOutputter outputter = new JsonOutputter();

response.setStatus(HttpServletResponse.SC_OK);

response.setContentType(outputter.getContentType());

outputter.output(cmdResponse, response.getWriter());

}

}

在doGet()处理方法中,从get请求中获取到path,然后再调用Commands的runCommand()方法进行处理。

public static CommandResponse runCommand(String cmdName, ZooKeeperServer zkServer, Map<String, String> kwargs) {

if (!commands.containsKey(cmdName)) {

return new CommandResponse(cmdName, "Unknown command: " + cmdName);

}

if (zkServer == null || !zkServer.isRunning()) {

return new CommandResponse(cmdName, "This ZooKeeper instance is not currently serving requests");

}

return commands.get(cmdName).run(zkServer, kwargs);

}

而最终调用了根据浏览器输入的path从commands中获取到Command,然后再调用他的run()方法即可,而commands又是从哪里来的呢? 请看Commands中有一个静态代码块。

static {

registerCommand(new CnxnStatResetCommand());

registerCommand(new ConfCommand());

registerCommand(new ConsCommand());

registerCommand(new DirsCommand());

registerCommand(new DumpCommand());

registerCommand(new EnvCommand());

registerCommand(new GetTraceMaskCommand());

registerCommand(new IsroCommand());

registerCommand(new MonitorCommand());

registerCommand(new RuokCommand());

registerCommand(new SetTraceMaskCommand());

registerCommand(new SrvrCommand());

registerCommand(new StatCommand());

registerCommand(new StatResetCommand());

registerCommand(new WatchCommand());

registerCommand(new WatchesByPathCommand());

registerCommand(new WatchSummaryCommand());

}

而最终调用了registerCommand()方法注册到commands中。

public static void registerCommand(Command command) {

for (String name : command.getNames()) {

Command prev = commands.put(name, command);

if (prev != null) {

LOG.warn("Re-registering command %s (primary name = %s)", name, command.getPrimaryName());

}

}

primaryNames.add(command.getPrimaryName());

}

每一个command类中都有一个getNames()方法,而getNames()方法返回的是一个集合,为什么呢? 以ConfCommand命令为例子。

public static class ConfCommand extends CommandBase {

public ConfCommand() {

super(Arrays.asList("configuration", "conf", "config"));

}

@Override

public CommandResponse run(ZooKeeperServer zkServer, Map<String, String> kwargs) {

CommandResponse response = initializeResponse();

response.putAll(zkServer.getConf().toMap());

return response;

}

}

protected CommandBase(List<String> names) {

this(names, null);

}

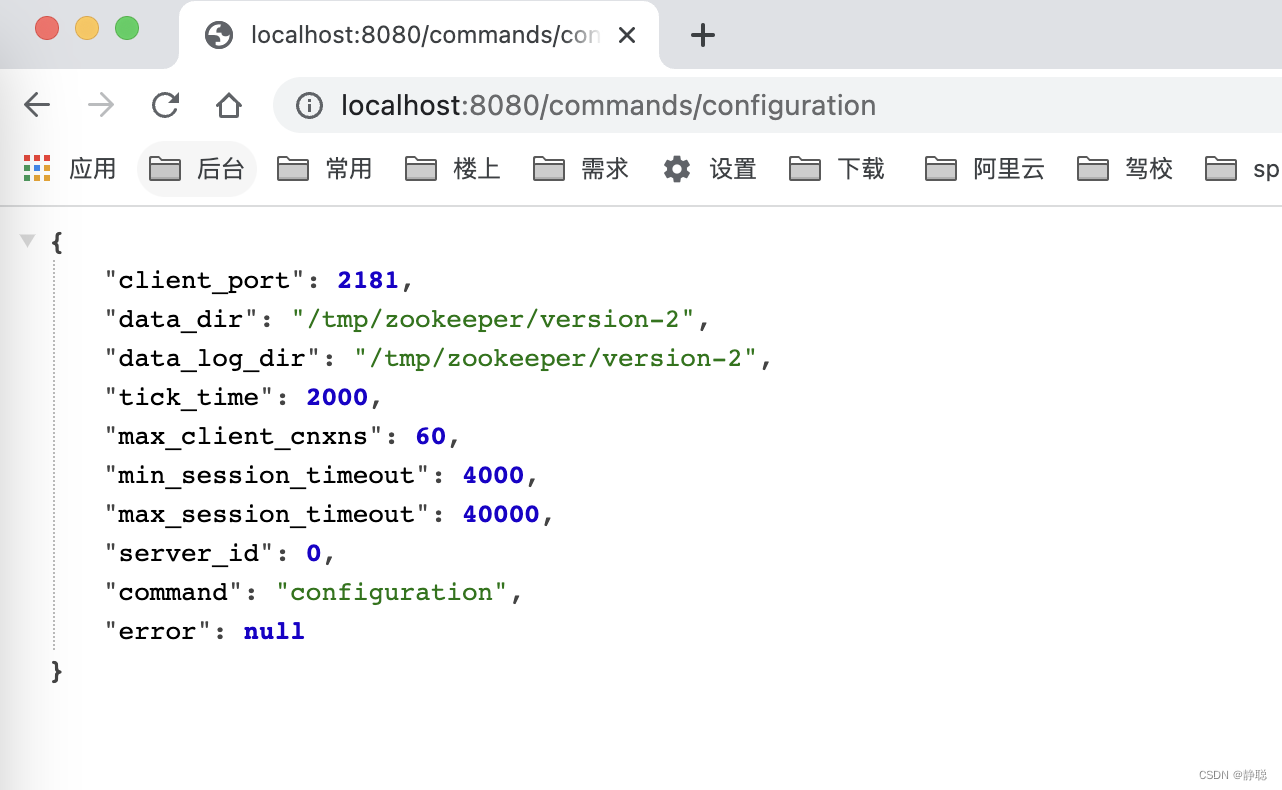

他的names 就是configuration,conf,config,因此在浏览器路径中输入http://localhost:8080/commands/config,http://localhost:8080/commands/configuration,http://localhost:8080/commands/conf都是执行ConfCommand的run()方法 。

大家好奇,为什么ConfCommand的run()方法返回值是上述内容呢?请看getConf()方法的实现逻辑 。

public ZooKeeperServerConf getConf() {

return new ZooKeeperServerConf

(getClientPort(),

zkDb.snapLog.getSnapDir().getAbsolutePath(),

zkDb.snapLog.getDataDir().getAbsolutePath(),

getTickTime(),

getMaxClientCnxnsPerHost(),

getMinSessionTimeout(),

getMaxSessionTimeout(),

getServerId());

}

这不就是zoo.cfg中配置的内容不。

而如果我们直接输入http://localhost:8080/commands,则显示我们可以查看的命令 。

对于AdminServer的源码我们就分析到这里,有兴趣可以自行点开一个一个命令去看里面的源码。接下来重中之重看下面代码块。

if (config.getClientPortAddress() != null) {

// 4. 创建ServerCnxnFactory

cnxnFactory = ServerCnxnFactory.createFactory();

// 5. Zookeeper首先会初始化一个Thread ,作为整个ServerCnxnFactory的主线程然后再初始化NIO服务器。

cnxnFactory.configure(config.getClientPortAddress(), config.getMaxClientCnxns(), false);

// 6. 启动ServerCnxnFactory

// 启动步骤5中已经初始化的主线程ServerCnxnFactory的主逻辑run()方法 ,需要注意的一点是,虽然这里Zookeeper的NIO

// 服务器已经对外开放端口,客户端能够访问到Zookeeper的客户端服务端2181 , 但此时Zookeeper服务器是无法正常处理客户端请求的。

// 恢复本地数据库 。

cnxnFactory.startup(zkServer);

// zkServer has been started. So we don't need to start it again in secureCnxnFactory.

needStartZKServer = false;

}

首先看createFactory()方法 。

static public ServerCnxnFactory createFactory() throws IOException {

String serverCnxnFactoryName = System.getProperty("zookeeper.serverCnxnFactory");

if (serverCnxnFactoryName == null) {

serverCnxnFactoryName = NIOServerCnxnFactory.class.getName();

}

try {

ServerCnxnFactory serverCnxnFactory = (ServerCnxnFactory) Class.forName(serverCnxnFactoryName)

.getDeclaredConstructor().newInstance();

LOG.info("Using {} as server connection factory", serverCnxnFactoryName);

return serverCnxnFactory;

} catch (Exception e) {

IOException ioe = new IOException("Couldn't instantiate "

+ serverCnxnFactoryName);

ioe.initCause(e);

throw ioe;

}

}

如果我们没有指定zookeeper.serverCnxnFactory,则默认使用NIOServerCnxnFactory作为ServerCnxnFactory,高版本可能会使用NettyServerCnxnFactory作为默认的ServerCnxnFactory,但当前研究的zookeeper版本是3.5.8 ,因此还是以NIOServerCnxnFactory作为默认的ServerCnxnFactory。 然后通过反射调用NIOServerCnxnFactory的构造方法,初始化NIOServerCnxnFactory,接下来看NIOServerCnxnFactory的构造方法中做了哪些事情 。 突然发现NIOServerCnxnFactory的构造方法是一个空实现,什么事情都没有做,而将初始化工作交给了configure()方法,接下来看configure()方法的具体实现。

public void configure(InetSocketAddress addr, int maxcc, boolean secure) throws IOException {

if (secure) {

throw new UnsupportedOperationException("SSL isn't supported in NIOServerCnxn");

}

configureSaslLogin();

maxClientCnxns = maxcc;

sessionlessCnxnTimeout = Integer.getInteger("zookeeper.nio.sessionlessCnxnTimeout", 10000);

// We also use the sessionlessCnxnTimeout as expiring interval for

// cnxnExpiryQueue. These don't need to be the same, but the expiring

// interval passed into the ExpiryQueue() constructor below should be

// less than or equal to the timeout.

cnxnExpiryQueue = new ExpiryQueue<NIOServerCnxn>(sessionlessCnxnTimeout);

expirerThread = new ConnectionExpirerThread();

int numCores = Runtime.getRuntime().availableProcessors();

// 32 cores sweet spot seems to be 4 selector threads

numSelectorThreads = Integer.getInteger("zookeeper.nio.numSelectorThreads", Math.max((int) Math.sqrt((float) numCores / 2), 1));

if (numSelectorThreads < 1) {

throw new IOException("numSelectorThreads must be at least 1");

}

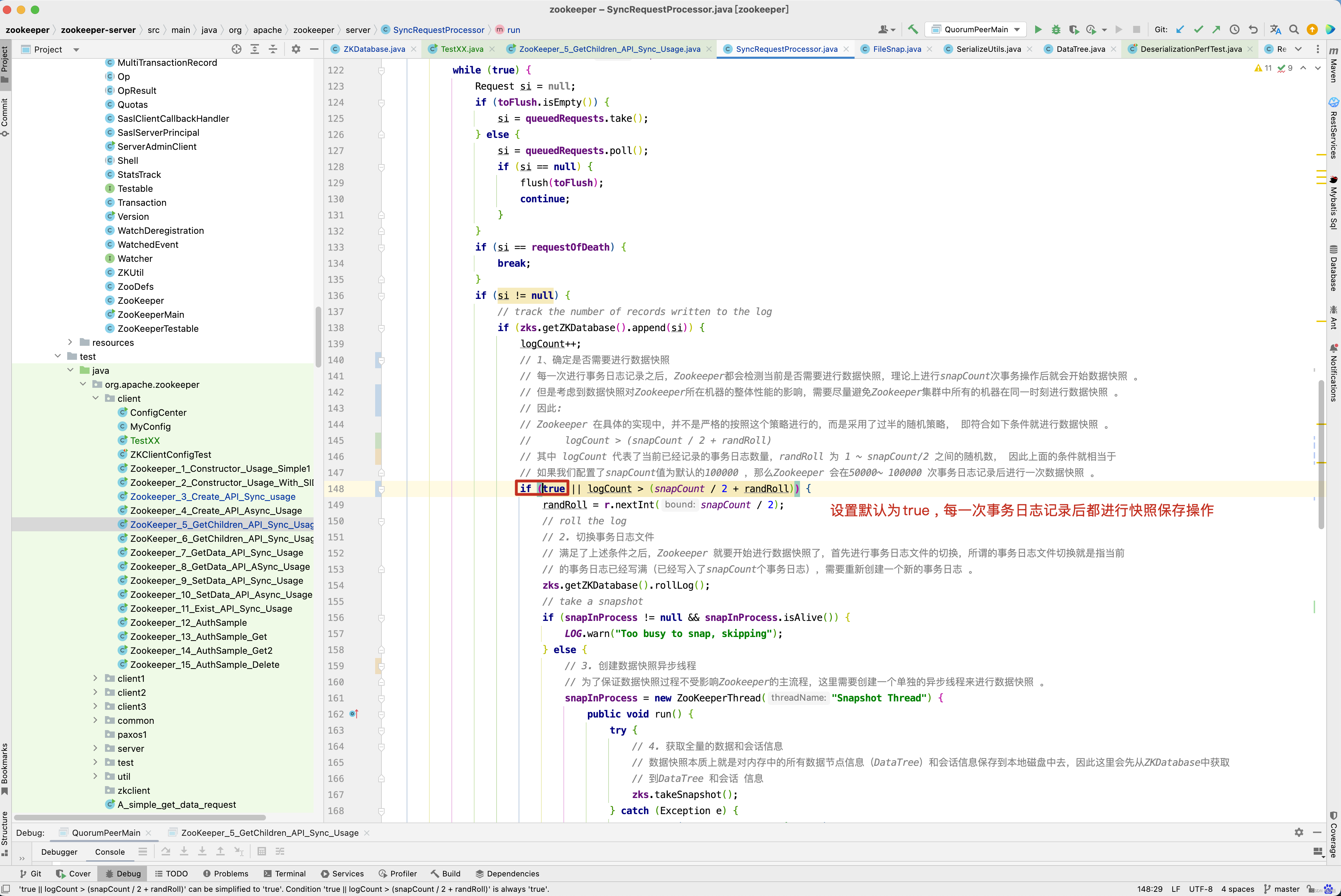

numWorkerThreads = Integer.getInteger("zookeeper.nio.numSelectorThreads", 2 * numCores);