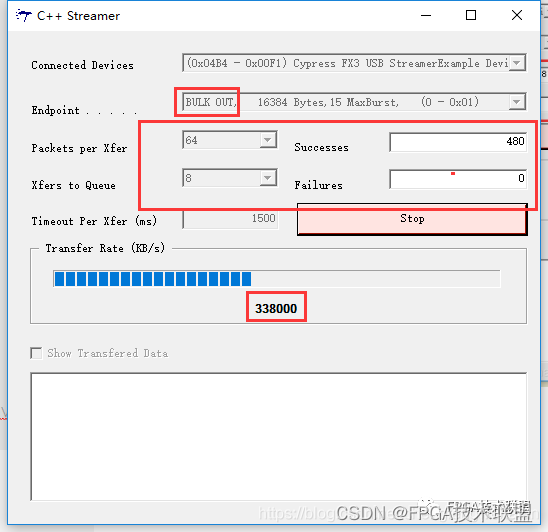

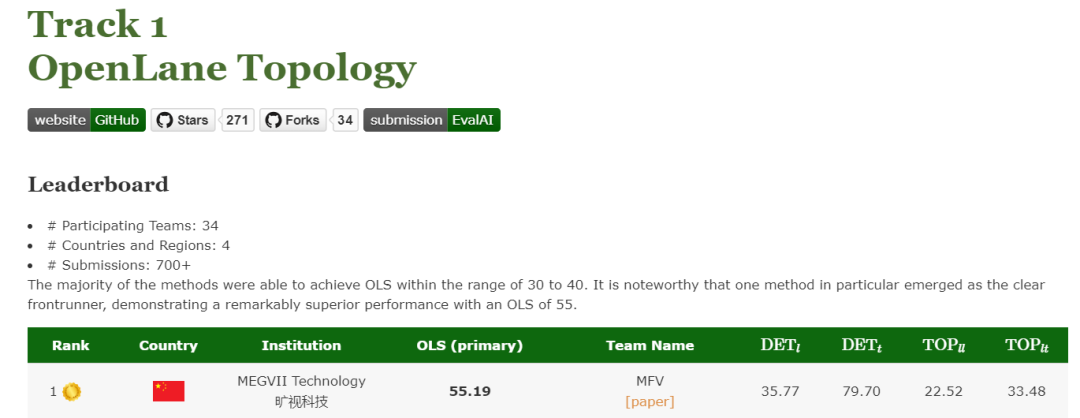

近日,为期三个月的 CVPR 2023 自动驾驶国际挑战赛比赛结果揭晓。旷视研究院在OpenLane Topology 赛道中击败 30 余支国内外队伍,夺得冠军。

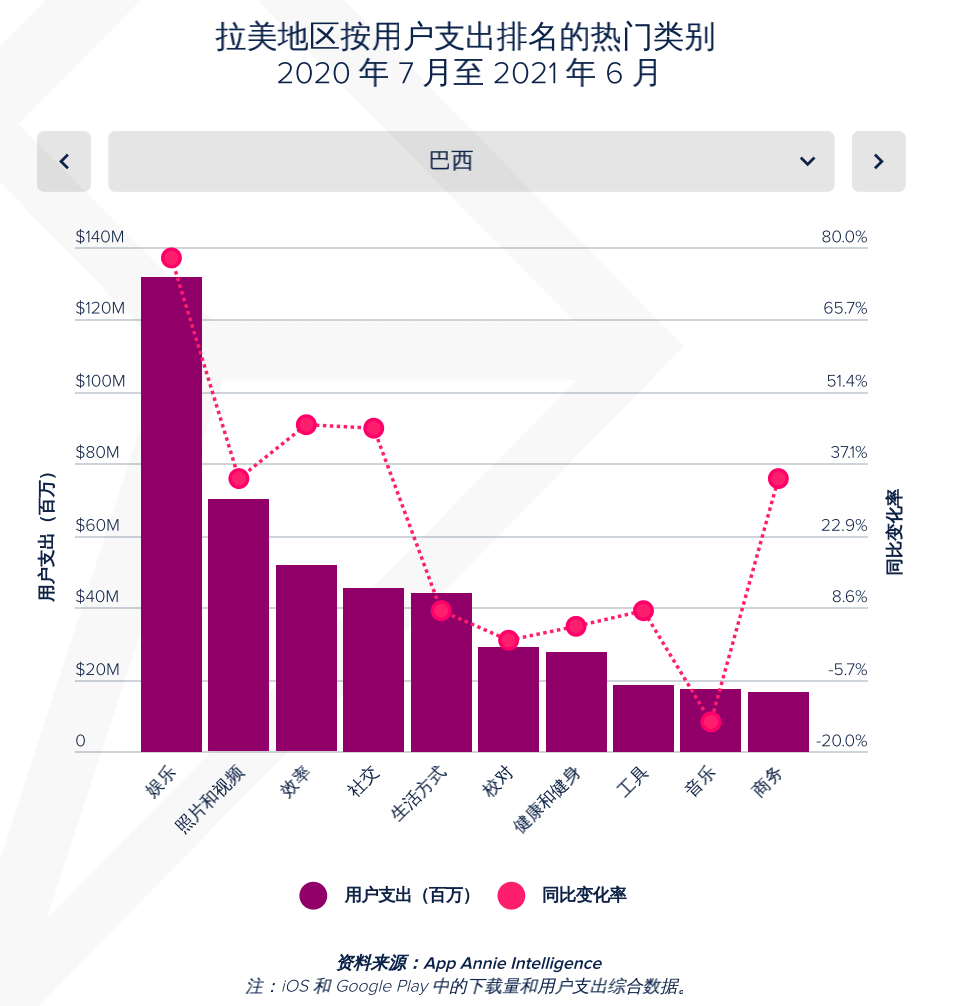

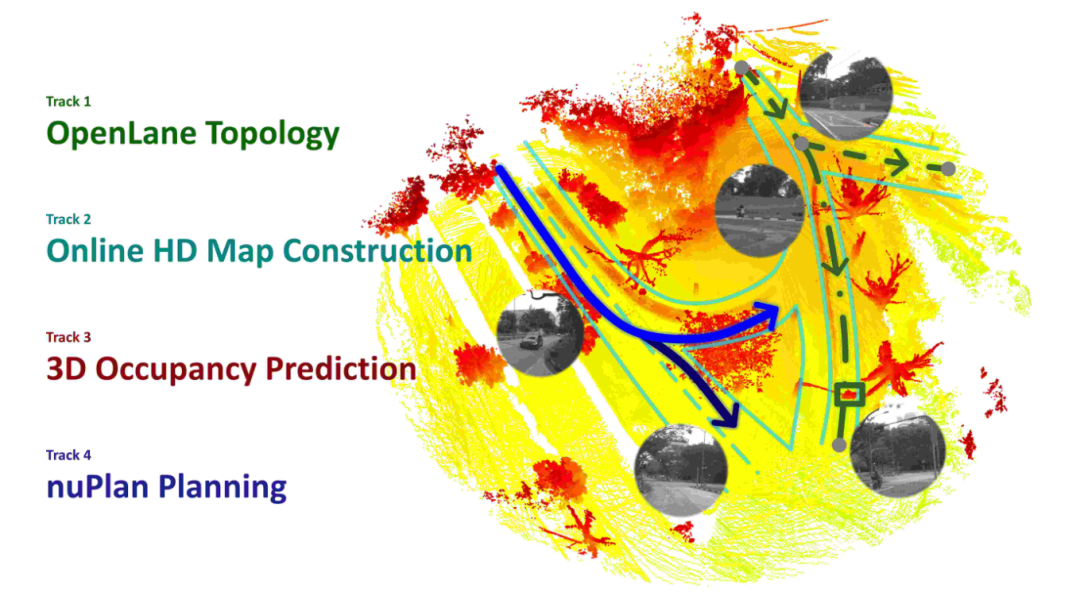

自动驾驶技术已经渗透到人们的日常生活中,但是传统的感知方法仍不能满足大家对 L5 级自动驾驶的追逐。CVPR 2023 自动驾驶国际挑战赛将自动驾驶技术分为对背景场景的理解、对前景物体的感知和对未来运动的规划三方面,并举办了四个不同赛道的竞赛,希望选手们通过深入探讨自动驾驶感知决策系统面临的任务和挑战,提升自动驾驶的性能表现。

图片来源:Challenge at CVPR 2023 Autonomous Driving Workshop | OpenDriveLab

OpenLane Topology赛道赛题介绍

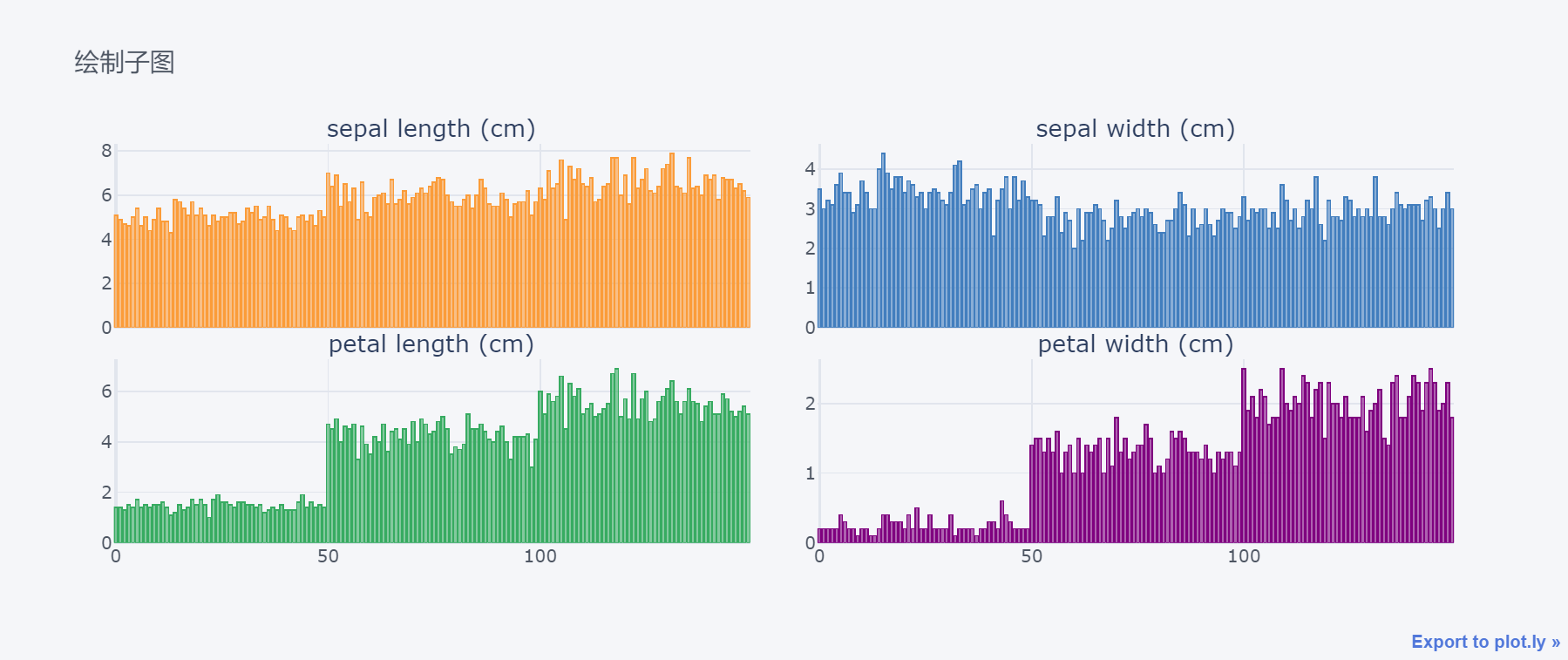

为了更好的实现自动驾驶场景理解,现有场景感知任务从车道线分割、检测发展到车道中心线检测,但是车道线和车道线之间、车道线和交通标志之间的逻辑关系仍然没有得到合理的建模。OpenLane Topology 比赛[1]要求以车道中心线取代以往数据集中的车道边缘线,结合车道间的拓扑关系,直接得到车辆行驶的轨迹。

此外,本次比赛用到的数据集——OpenLane-Huawei 数据集首次对交通标识和其对车道的对应关系进行了标注,使每条车道都拥有实时的交通属性,来指引车辆在当前车道上对未来的自车行为有合理的倾向。本次比赛以给定环视相机图片作为输入,参赛者需要同时给出车道中线和交通元素的感知结果及拓扑关系的认知结果。主办方将根据各参赛队伍提交算法的 OLS(感知结果和拓扑关系预测 mAP 的平均)进行排名。

旷视夺冠算法介绍

拓扑关系的预测依赖于车道中心线和交通元素的感知结果,因此对于车道中心线和交通元素的感知非常重要,我们分别采用了不同的模型来完成这两个感知任务。

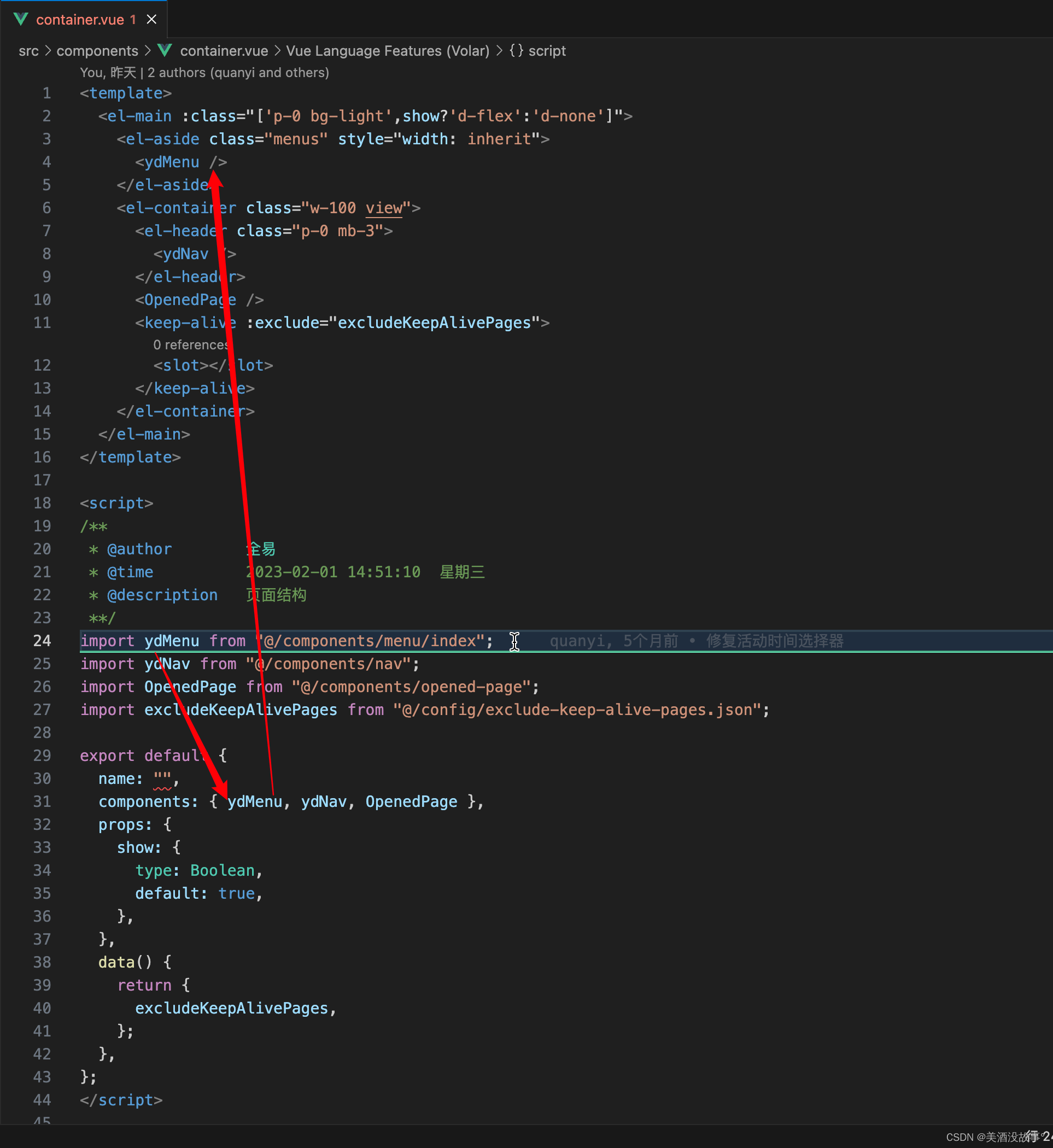

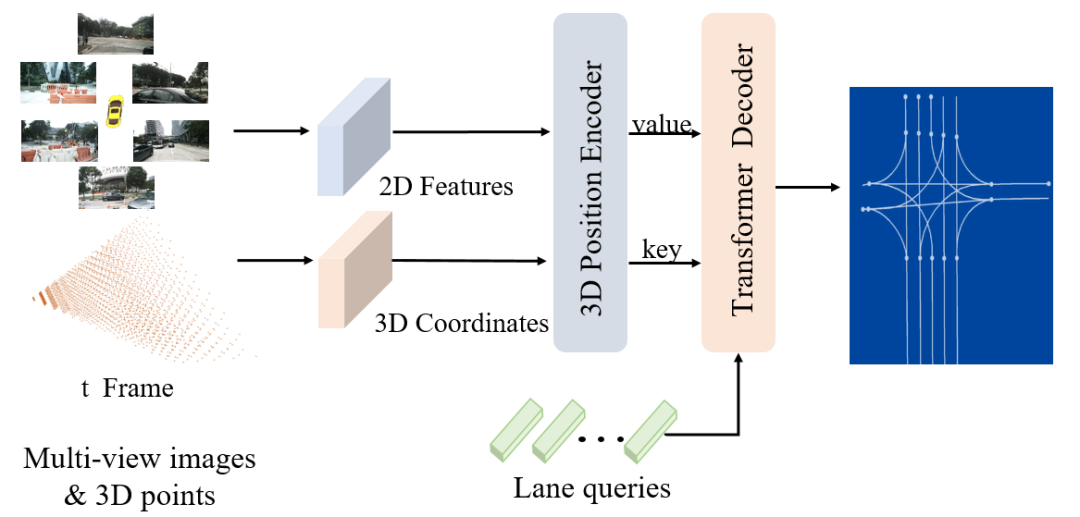

对于车道中心线检测任务来说,不同于以往的 3D 车道线检测任务,3D 车道中心线在图像中往往没有明显的几何特征。3D 车道中心线的检测往往需要根据周边的 3D 车道线的位置关系进行判断,因此 3D 车道中心线的检测需要较大的感受野。我们对比了现有的 3D 车道线检测框架,最终选择了旷视自研的 PETRv2 框架[2]作为 baseline。在 PETRv2 中,lane queries 会通过全局注意力机制和图像特征进行交互,具有全局的感受野。这种交互方式可以兼顾局部的细节特征和整体的结构特征,有利于对 3D 车道中心线的预测。

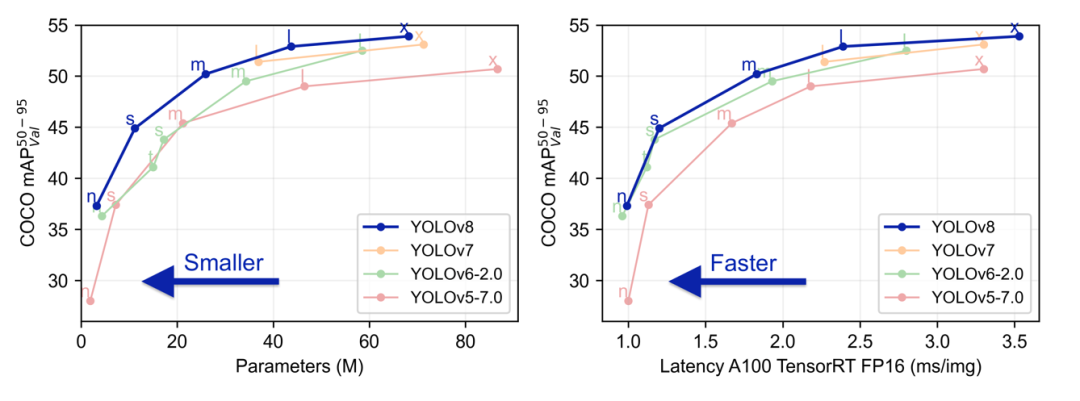

对于交通元素的检测任务,考虑到以往比赛的经验,我们选取了 YOLO 系列最新的模型 YOLOv8 模型[3]作为我们的 baseline。相比其他 2D 检测方法,它拥有更快的速度,更准确的性能。

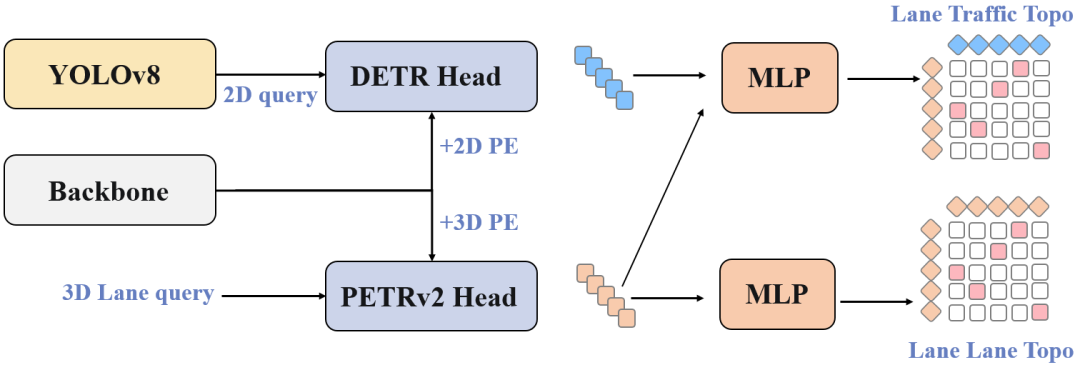

结合 YOLOv8 和 PETRv2,我们进一步搭建了一个多阶段的网络框架,并将其拓展到拓扑关系的预测中。首先,我们使用一个预先训练好的 YOLOv8 模型,通过和前向视角图像交互来进行交通元素的检测任务,并生成对应的交通元素特征。PETRv2 模型通过和多视角图像特征交互来生成 3D 车道中心线检测结果和对应的车道中心线特征。这样设计是为了尽最大限度保证 2D 检测的性能,同时实现交通元素特征与车道中心线特征的特征对齐。基于两个任务的特征,我们将对应的特征进行拼接,然后分别使用了两组多层感知机预测对应的拓扑关系矩阵。

最终,我们的团队MFV(Megvii-Foundation model-Video)在 OpenLane Topology 挑战赛中凭借 OLS 指标的显著优势取得了第一名。

https://opendrivelab.com/AD23Challenge.html#Track1

[1] Wang, Huijie, et al. "Road Genome: A Topology Reasoning Benchmark for Scene Understanding in Autonomous Driving." arXiv preprint arXiv:2304.10440 (2023).

[2] Liu, Yingfei, et al. "Petrv2: A unified framework for 3d perception from multi-camera images." arXiv preprint arXiv:2206.01256 (2022).

[3] https://github.com/ultralytics/ultralytics.