Selenium作为一个强大的自动化工具,可用于编写爬虫程序,尽管Selenium在处理动态网页上非常强大,但对于静态网页爬简单数据提取,使用轻量级库或工具可能更加上所述,Selenium作为一个灵活可定动化工具,在需要模拟用户行为、处理动态网页内容,并进行复杂交互的爬虫任务中是一种价值的选择。

那么爬虫越来越慢是因为什么原因呢?下面我们一起来仔细分析下。

当使用Selenium进行爬虫时,有几个因素可能导致运行速度变慢:

1、网络延迟:如果网络连接不稳定或网站响应缓慢,Selenium会等待页面加载完成才继续执行下一步操作,这可能导致爬取速度减慢。

2、页面加载时间:有些网站在加载页面时可能包含大量的元素和资源,例如图片、脚本和样式表。等待页面完全加载完成可能需要更多的时间,从而使爬取过程变慢。

3、选择器性能:使用复杂的CSS选择器或XPath表达式可能会导致查询元素的过程变慢。尽量使用简单的选择器来提高执行速度时间:一些网页可能使用JavaScript来动态生成内容或实现交互功能。在爬虫中执行JavaScript可能需要更多的时间,尤其是对于复杂的网页。

解决这些问题的方法包括:

1、优化网络连接:确保网络连接稳定,并考虑使用更快速度的网络环境。

2、使用显式等待:合理设置等待时间,根据页面加载情况等待必要的时间,同时避免不必要的等待。

3、减少资源加载:如果网页包含大量的资源文件,可以通过禁用加载不必要的资源(如图片)或使用广告拦截插件等方式减少加载时间。

4、使用更简单的选择器:尽量使用简单的CSS选择器或XPath表达式来定位元素,避免复杂的查询。

5、避免执行不必要的JavaScript:在某些情况下,可以通过禁止执行网页中的JavaScript来提高爬取速度,但请注意,这可能会导致部分内容无法获取。

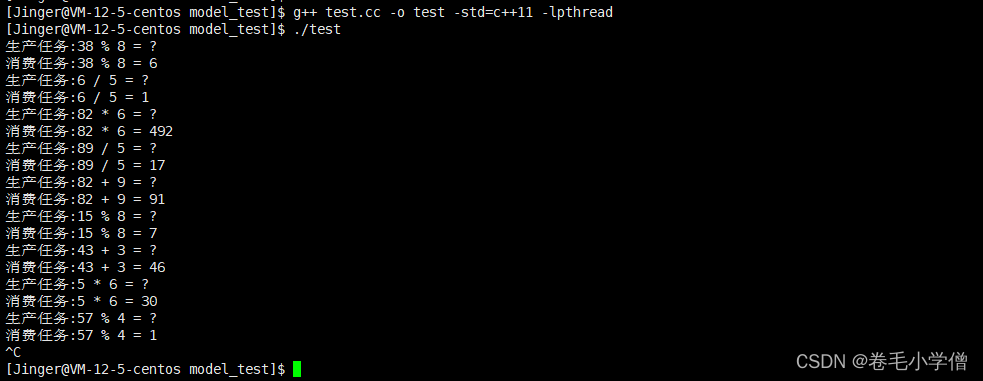

6、考虑并发执行:如果允许,可以考虑使用并发执行的方式,同时处理多个页面,从而提高爬虫的效率。

需要注意的是,Selenium本身作为一个自动化工具,在执行自动化操作的过程中较为重量级,它更适合于需要模拟用户操作和解析JavaScript生成内容的场景。如果爬取的目标仅为静态的HTML内容,而无需与页面进行交互,考虑使用其他轻量级的库或工具可能更加高效。

直接上代码

当涉及到编写一个完整的Selenium爬虫时,代码会有很大的变化和复杂度,因为它需要考虑多个页面、数据提取和存储等方面。以下是一个示例代码框架,演示了使用Selenium和Python进行爬虫的流程:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

# 创建Chrome浏览器对象

driver = webdriver.Chrome()

# 设置隐式等待时间(可选)

driver.implicitly_wait(10)

# 打

driver.get("http://example.com")

try:

# 使用显式等待等待特定元素加载完成

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "my_element_id"))

)

# 定位并提取数据

data = element.text

print("提取到的数据:", data)

# 进行其他操作和翻页逻辑

# ...

finally:

# 关闭浏览器窗口

driver.quit()

这个示例代码演示了以下关键步骤:

创建浏览器驱动:在这里使用Chrome浏览器作为示例。

1、访问目标网页:通过get()方法打开目标网页 使用显式等待:通过WebDriverWait和expected_conditions模块实现显式等待,等待特定元素加载完成。这有助于确保页面完全加载后再进行后续操作。

2、定位并提取数据:通过定位元素的方法(如ID、CSS选择器、XPath等)找到需要的元素,然后使用text属性提取文本数据或其他属性值。

3、其他操作和翻页逻辑:根据你爬取需求,在此处可以添加其他操作,例如填写表单、点击按钮或处理翻页。

4、最后,务必使用quit()方法关闭浏览器窗口,释放资源。

5、根据实际需求,你可以进一步扩展代码以满足更复杂的爬虫任务,例如使用循环处理多个页面或将提取到的数据保存到文件或数据库中。