文章目录

- Core NLP ethics concepts

- bias

- privacy

- Group discussion

- Automatic Prison Term Prediction

- Automatic CV Processing

- Language Community Classification

Core NLP ethics concepts

自然语言处理(NLP)的伦理问题是一个日益重要的领域,涉及到很多与公平性、透明度、隐私和偏见等问题相关的议题。以下是一些主要的伦理问题:

-

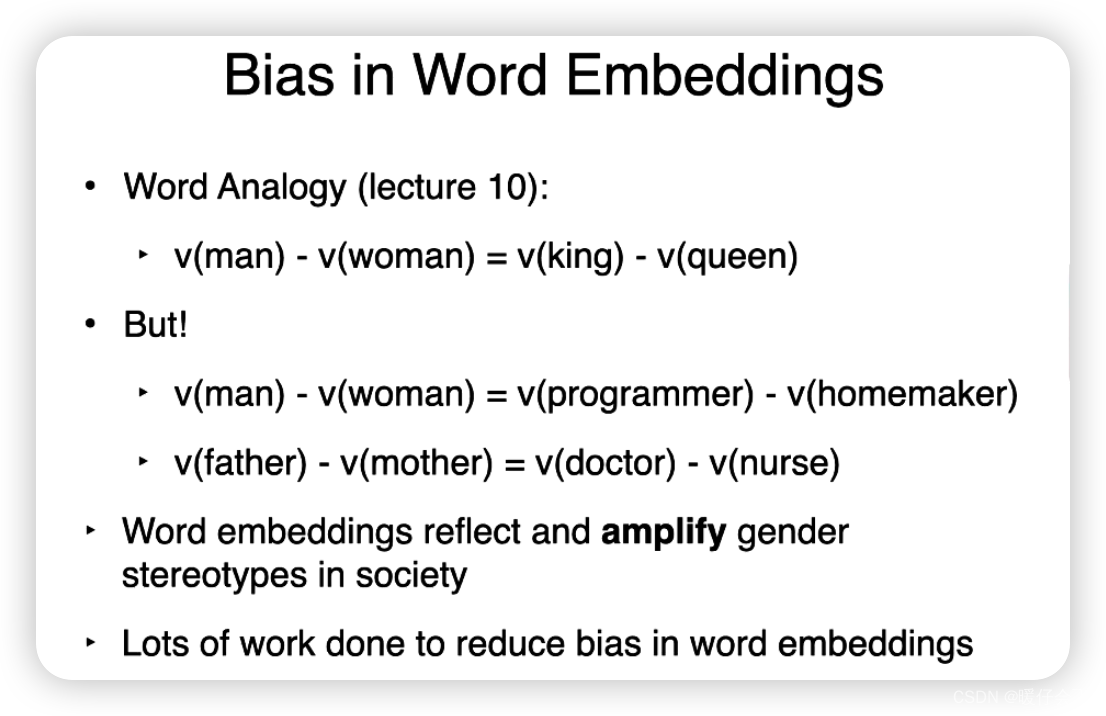

数据偏见:NLP系统通常通过学习大量的语言数据来训练,如果这些数据包含偏见,如性别、种族、年龄、宗教等方面的偏见,那么这些偏见可能会被NLP系统学习并放大,从而影响系统的决策和推荐。

-

隐私保护:在NLP中,用户的语言数据通常被用来训练模型,如果没有得到适当的处理和保护,可能会泄露用户的隐私信息。

-

透明度和可解释性:NLP模型,尤其是深度学习模型,通常被视为“黑箱”,很难理解它们的工作原理和决策过程。这可能会导致无法对模型的决策进行有效的审核和监管。

-

生成内容的道德责任:随着GPT等生成模型的发展,NLP系统现在可以生成非常逼真的文本。这可能会被用于制造假新闻、虚假信息等,对社会产生负面影响。

-

公平性:NLP系统需要确保对所有用户的公平对待,不同的文化、语言和方言应该得到相等的重视和处理。

bias

privacy

Group discussion

Automatic Prison Term Prediction

- 偏差:根据不同的训练数据,对人的刑期可能会有不同的判定

- 透明性:模型不能提供具体的原因来解释为什么设置这样的判决标准

Automatic CV Processing

- bias:这东西可能存在种族偏见

- 透明性:同样需要解释为什么淘汰某个候选人

- privacy:设计模型的公司会获得这些以往候选人的数据,这有损他人隐私

Language Community Classification

隐私和标签:个人的性取向属于敏感信息,不应该被公开或被他人无需知道的情况下就被暴露。尽管这个工具的目标可能是为了理解这两个社区的语言如何不同,但可能存在滥用的风险,导致某些人的性取向被暴露。

偏见和歧视:对于语言的标签可能引发和加强偏见和歧视。如果一个工具将特定的语言习惯或表达方式标记为LGBTQ或异性恋的,这可能导致人们对使用这些语言的人产生不准确或偏见的认识。

过度简化和刻板印象:性取向并不是唯一影响个人语言使用的因素。将语言归类为"LGBTQ"或"异性恋"可能过度简化了语言的复杂性和多样性,忽视了个体之间的差异,以及文化、地域、年龄、教育等其他因素的影响。

误解和误分类:工具可能无法完全准确地理解和分类语言,这可能导致误解和误分类,从而引发一系列的问题,如误导研究,引发误会,或者伤害到被误分类的人。