本文重点

我们前面学习了梯度下降算法,其中有一个重要的参数就是学习率。在使用梯度下降算法时,学习率是一个非常重要的参数。学习率的大小会直接影响梯度下降算法的收敛速度和精度。如果学习率太大或太小,都会对梯度下降算法的表现产生负面影响。

学习率太大的影响

学习率是梯度下降算法中的一个重要参数,它决定了每次迭代中模型参数更新的步长。学习率太大会导致模型参数在训练过程中不断震荡,甚至无法收敛。下面我们将详细讨论学习率太大的影响。

1. 收敛速度慢

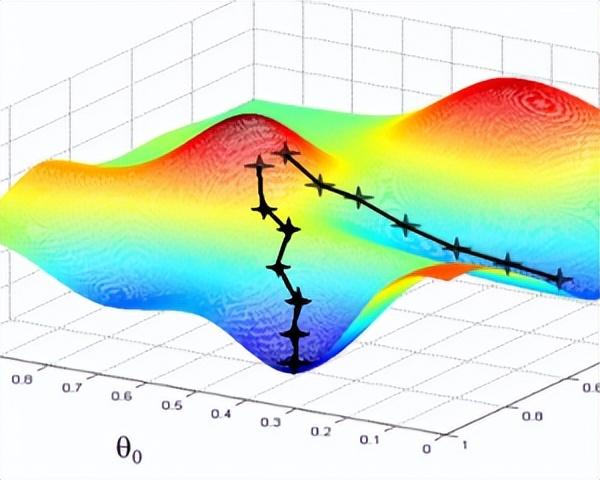

学习率太大会导致模型参数在更新过程中跳过最优解,从而无法收敛。这是因为学习率太大会使参数更新步长过大,导致算法无法找到最优解。此时,算法会一直在最优解附近震荡,收敛速度非常慢。

2. 梯度爆炸

学习率太大会导致梯度爆炸的问题。梯度爆炸是指在模型训练过程中,梯度的值变得非常大,甚至超出了计算机的表示范围。这会导致模型参数更新的步长非常大,使算法无法收敛。此时,我们需要采取一些措施来缓解梯度爆炸的问题,例如使用梯度剪裁(Gradient Clipping)等技术。

3. 振荡

学习率太大会导致模型参数在训练过程中不断振荡。这是因为学习率太大会使模型参数更新的步长过大,导致模型参数在更新过程中跳过最优解。此时,模型参数会不断在最优解附近振荡,导致算法无法收敛。

![[C国演义] 第二章](https://img-blog.csdnimg.cn/cd2f2d76d5594d2ebce6085f314bc6d7.png)