文章目录

- 一. 问题描述

- 二. 解决方案

- 2.1 增加节点

- 2.2 rebalance

- 2.3 rebalance引发的问题

一. 问题描述

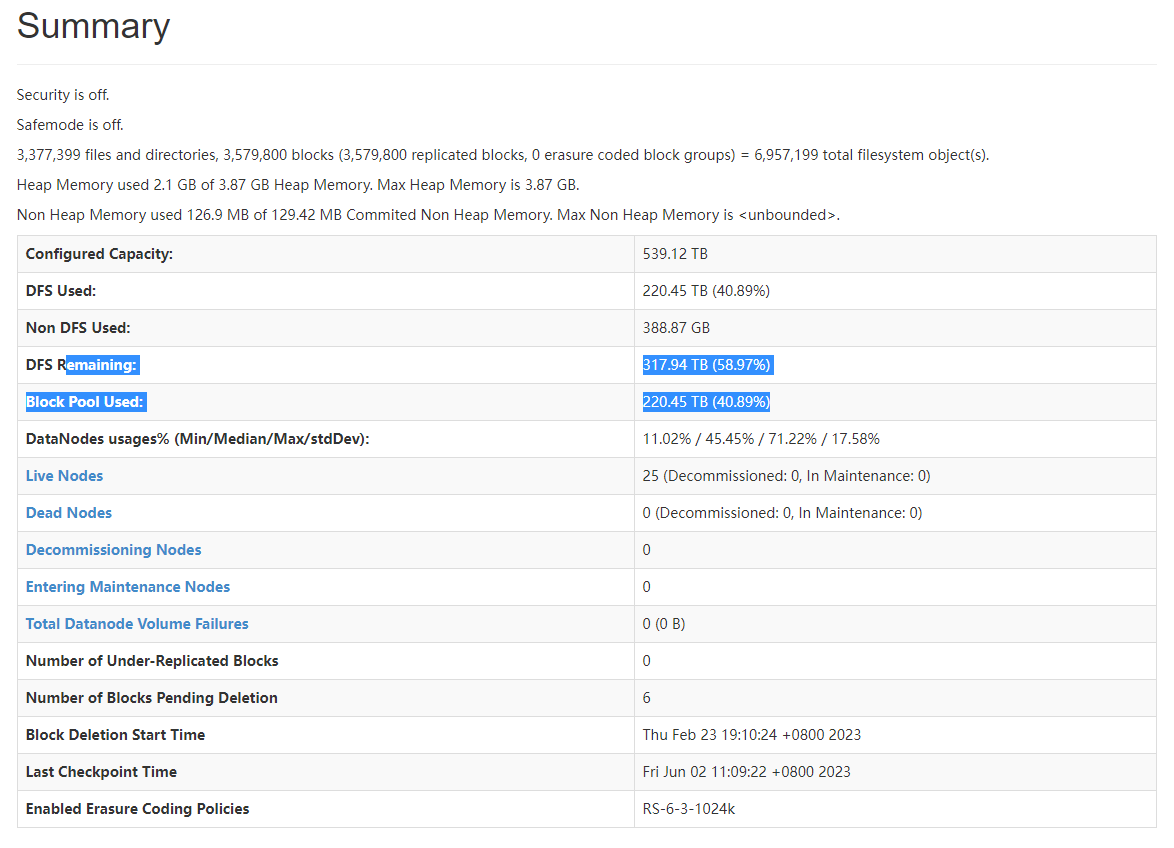

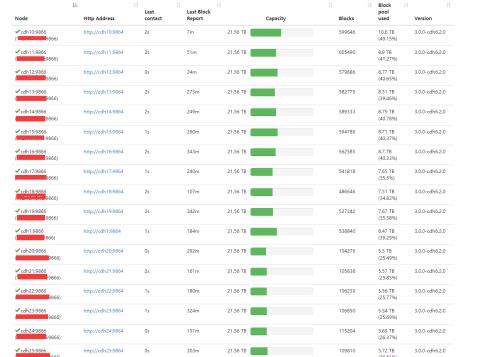

公司的离线数仓是CDH集群,19个节点,HDFS存储空间大约400TB左右,使用量在200TB左右。

由于历史遗留的问题,数据仓库需要重构,新旧数仓在一段时间内需要并存,此时HDFS空间救不够了。

于是申请增加6个节点,每个节点挂20T的存储,累积给HDFS增加120TB左右空间。

二. 解决方案

2.1 增加节点

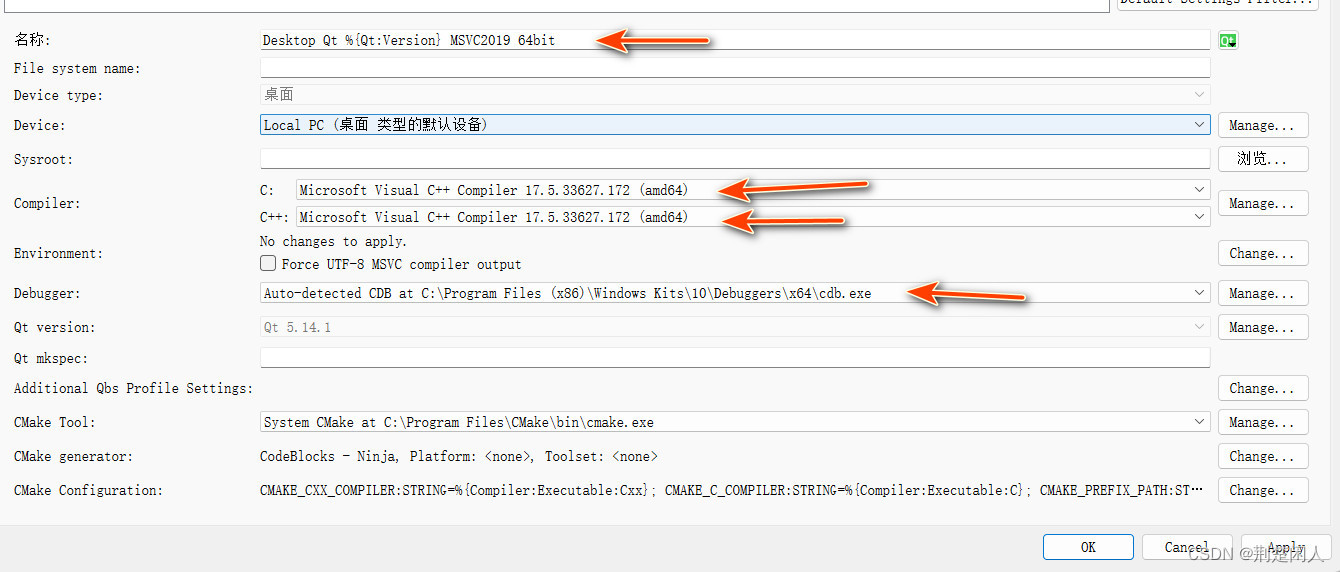

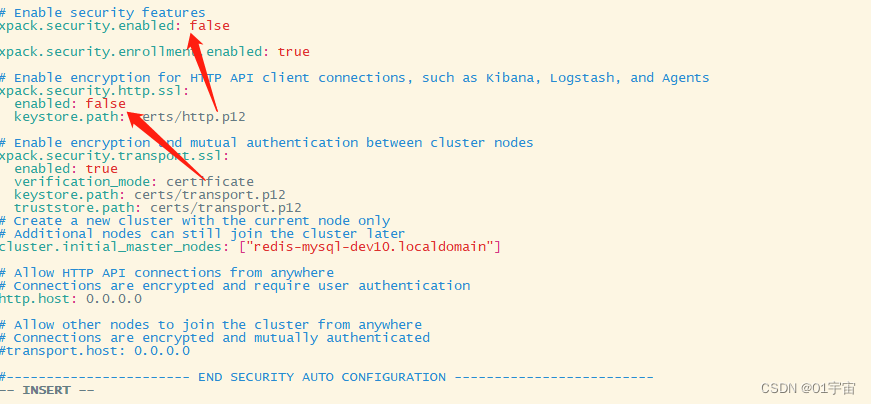

通过Cloudera Manager 将新增加的6台机器加入到集群。

增加完节点后

2.2 rebalance

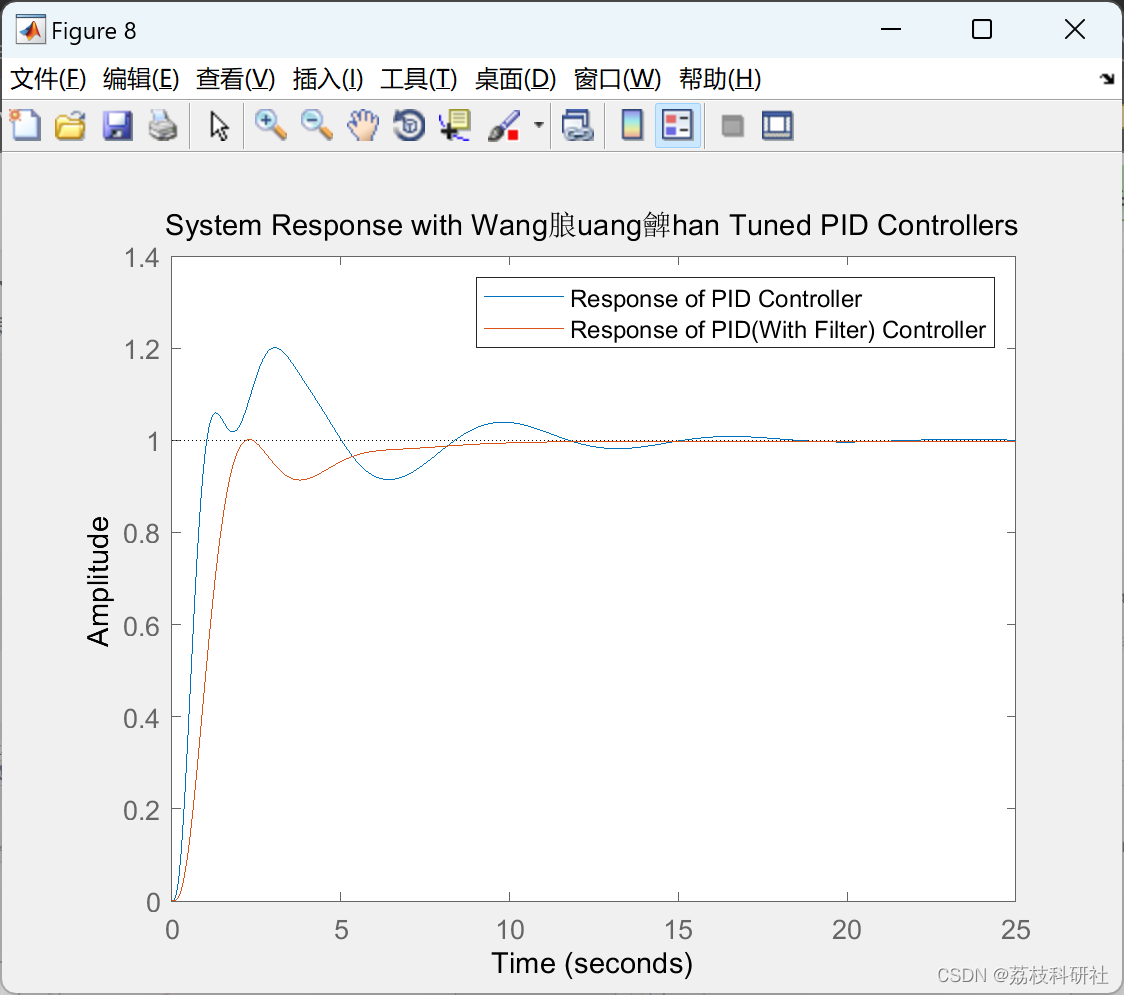

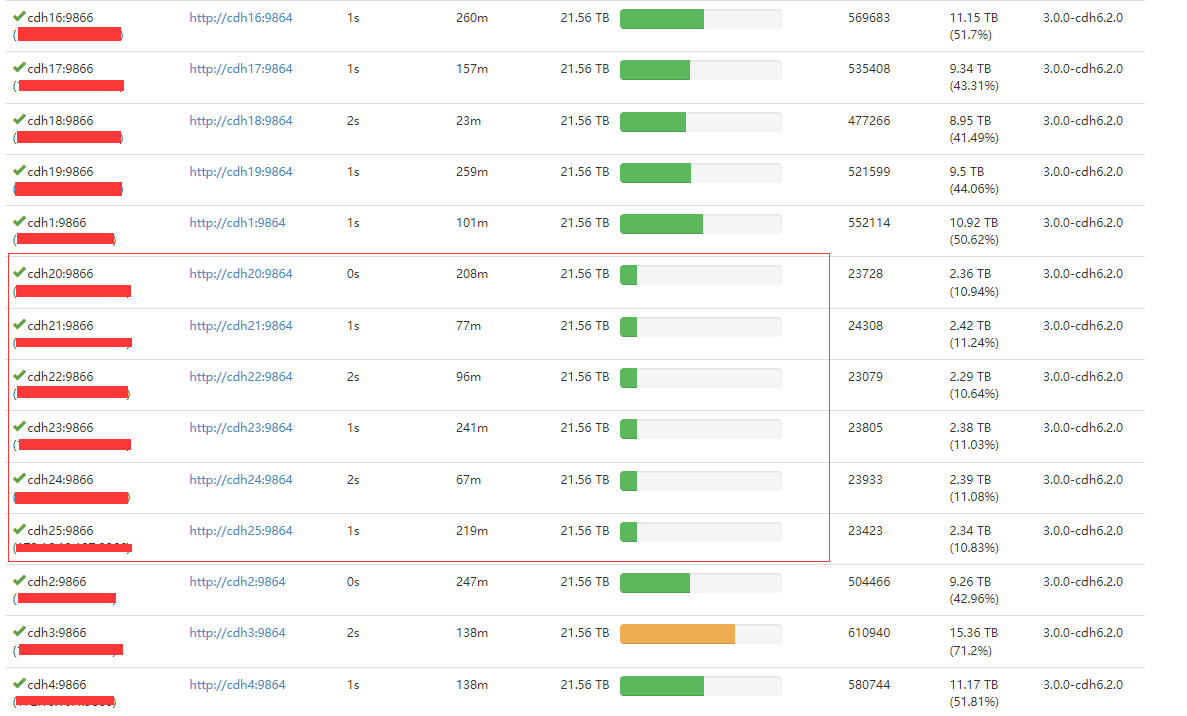

节点间数据分布不均匀:

新增加节点与旧节点之间数据分布不均匀

(这还是HDFS rebalance执行了一天多的时候的截图)

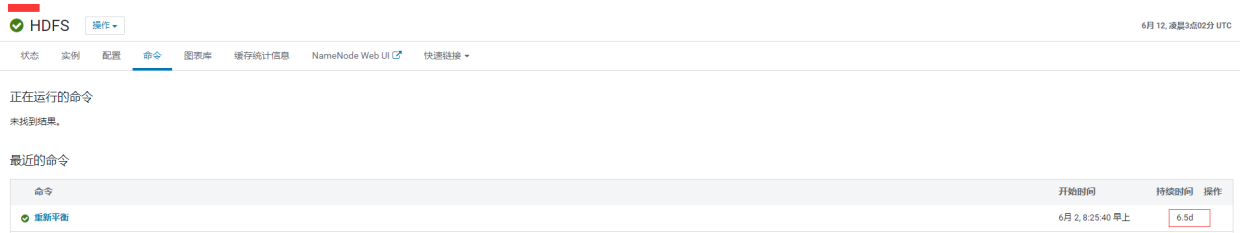

rebalance耗时:

rebalance后节点数据分布情况:

2.3 rebalance引发的问题

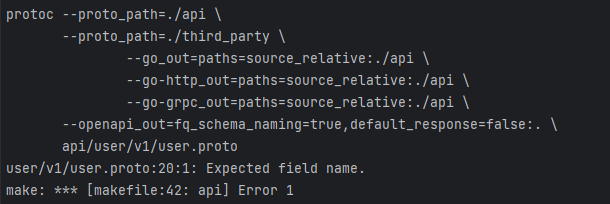

rebalance引发的问题:

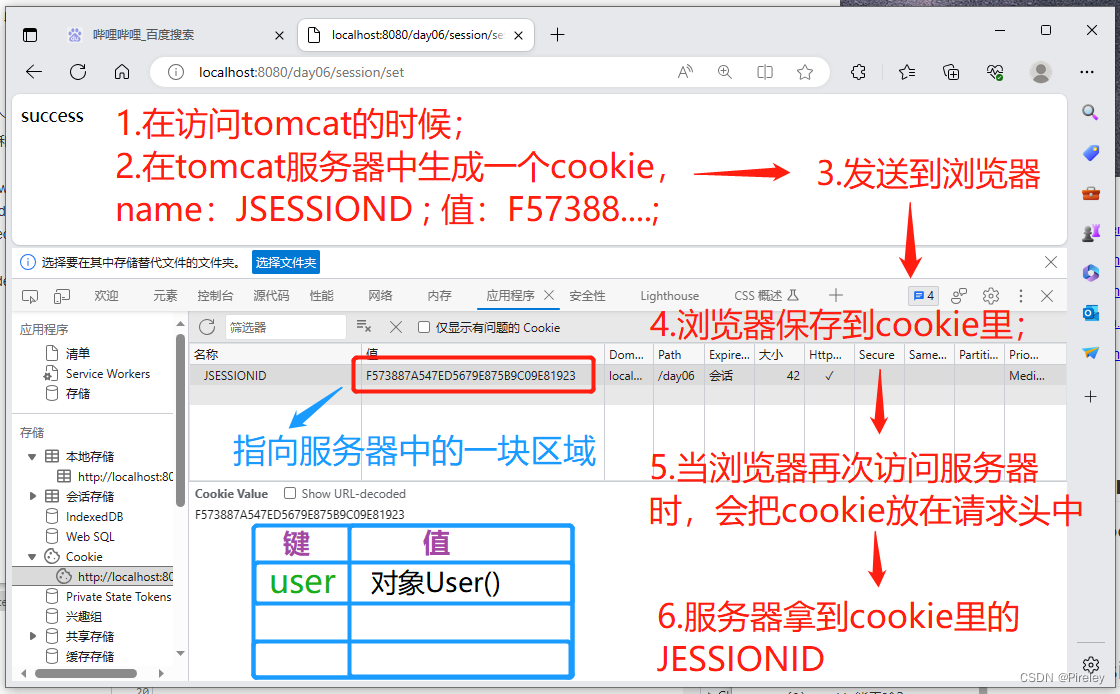

retrying (13 attempts left). Error: <class 'kafka.errors.NotLeaderForPartitionError'>

Kafka出了问题,选主过程受到ZK的影响,导致生产者写的时候找不到主节点,进而导致数据丢失